DeepSeek setzt Ollama in Brand, ist Ihr lokaler Einsatz sicher? Hüten Sie sich vor "gestohlener" Arithmetik!

In den letzten Jahren hat die Large Language Modelling (LLM)-Technologie ein beispielloses Wachstum erlebt und ist allmählich in verschiedene Branchen vorgedrungen. Gleichzeitig steigt auch die Nachfrage nach der lokalen Bereitstellung von LLMs. ollama ist als praktisches Tool für die lokale Bereitstellung großer Modelle bekannt für seine Benutzerfreundlichkeit und seine Fähigkeit DeepSeek und andere fortschrittliche Modelle werden von Entwicklern und Technikbegeisterten bevorzugt.

Beim Streben nach technologischem Komfort werden die Sicherheitsrisiken jedoch oft leicht übersehen. Einige Benutzer setzen lokal Ollama Nach der Bereitstellung des Dienstes kann der Port des Ollama-Dienstes aufgrund einer unsachgemäßen Konfiguration oder eines schwachen Sicherheitsbewusstseins dem Internet ausgesetzt sein, wodurch die Grundlage für potenzielle Sicherheitsrisiken geschaffen wird. In diesem Papier werden wir dieses Sicherheitsrisiko von Anfang bis Ende analysieren und entsprechende Präventivmaßnahmen anbieten.

1. die Bequemlichkeit und die potenziellen Sicherheitsrisiken von Ollama

Mit dem Aufkommen von Ollama wurden die Hürden für den lokalen Einsatz und die Nutzung großer Sprachmodelle gesenkt, so dass die Nutzer hochleistungsfähige Modelle wie DeepSeek problemlos auf ihren PCs oder Servern ausführen können. Diese Bequemlichkeit hat eine große Zahl von Nutzern angezogen, aber sie hat auch ein Problem geschaffen, das nicht ignoriert werden kann:Der Ollama-Dienst kann in seiner Standardkonfiguration dem Risiko eines unbefugten Zugriffs über das Internet ausgesetzt sein.

Wenn ein Benutzer den Ollama-Dienst einsetzt, ohne die notwendigen Sicherheitskonfigurationen vorzunehmen, wie z. B. die Einschränkung von Abhöradressen oder die Einrichtung von Firewall-Regeln, dann kann der Port 11434, auf dem Ollama standardmäßig lauscht, für die Öffentlichkeit zugänglich sein. Das bedeutet, dass jeder Internetnutzer über das Netzwerk auf Ihren Ollama-Dienst zugreifen kann undDie kostenlose Nutzung Ihrer Computerressourcen kann sogar noch ernstere Sicherheitsprobleme verursachen.

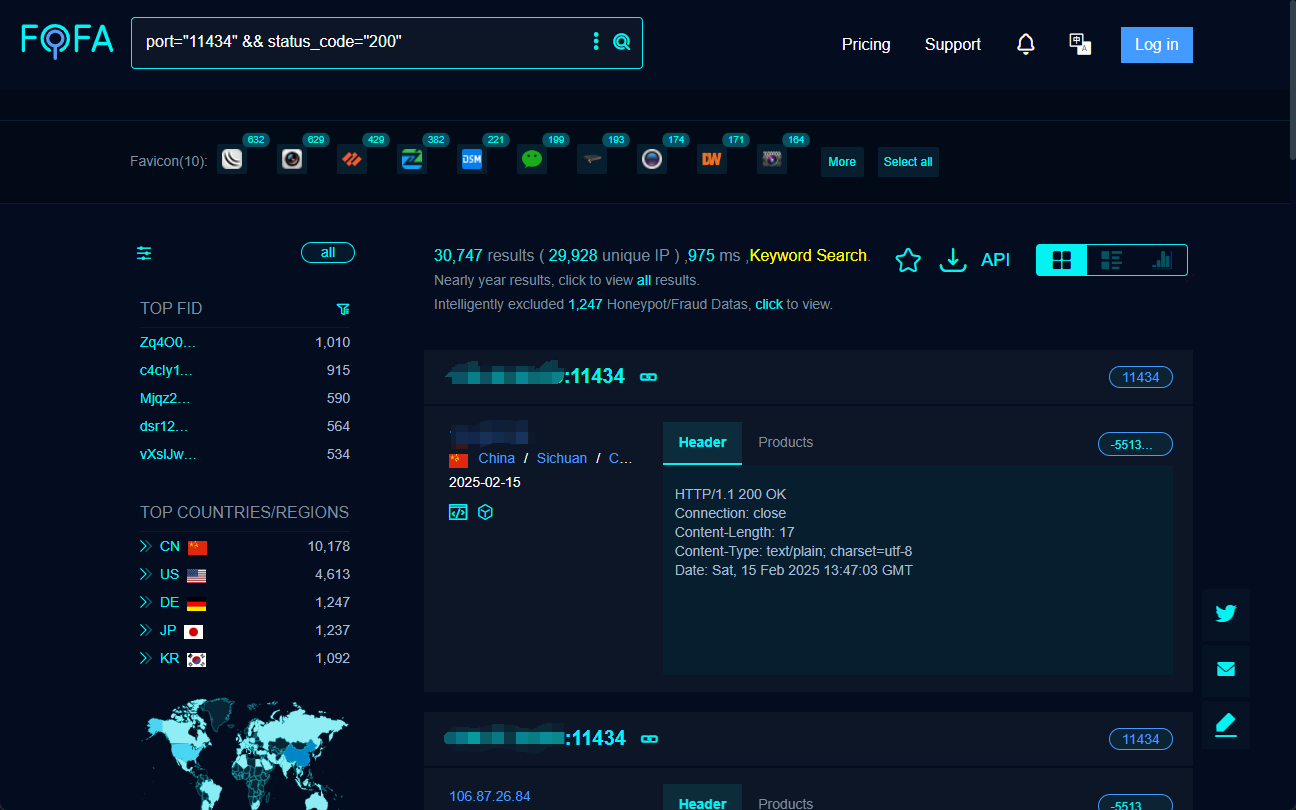

2) Wie kann man exponierte Ollama-Dienste im Internet finden? -- FOFA-Suchmaschine

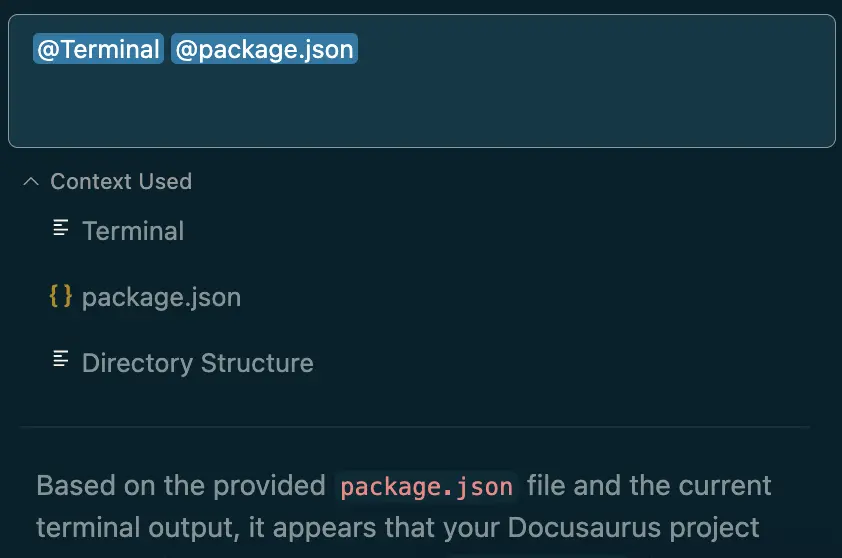

Um zu verstehen, inwieweit die Ollama-Dienste im Internet präsent sind und welche Risiken bestehen, benötigen wir die Hilfe einer Suchmaschine im Cyberspace.FOFA Es ist ein sehr leistungsfähiges Tool, das uns hilft, weltweit öffentlich zugängliche Webdienste schnell zu finden.

Durch sorgfältiges Konstruieren von FOFA-Suchanweisungen können wir effektiv Hosts finden, die Ollama-Service-Ports für das Internet freigeben. Die folgende FOFA-Suchanweisung kann zum Beispiel verwendet werden, um Ziele mit offenem Port 11434 und Statuscode 200 zu finden:

port="11434" && status_code="200"

Bei der Durchführung der oben genannten Suche listet FOFA qualifizierte Ziel-IP-Adressen auf, auf denen wahrscheinlich öffentlich zugängliche Ollama-Dienste laufen.

3) Wie kann man den offenen Ollama-Dienst verbinden und "huren"? -- ChatBox und Cherry Studio

Sobald die offene Ollama-Dienstschnittstelle über FOFA gefunden wurde, besteht der nächste Schritt darin, eine Verbindung herzustellen und mit ihr über clientseitige Tools zu interagieren.ChatBox im Gesang antworten Studio Kirsche sind zwei weit verbreitete KI-Client-Programme, die beide eine Verbindung zum Ollama-Dienst mit Modellaufrufen und Dialogen unterstützen.

3.1 ChatBox zur Verbindung mit dem Open Ollama-Dienst verwenden

ChatBox Bekannt für seine Einfachheit und Benutzerfreundlichkeit, sind die Schritte zur Verbindung mit dem Open Ollama-Dienst sehr einfach:

- Downloaden und installieren Sie den ChatBox-Client.

- Konfigurieren Sie die API-Adresse: existieren ChatBox Einstellungen, setzen Sie die API-Adresse auf die IP-Adresse und den Port des Zielservers, zum Beispiel

http://目标IP:11434/. - Wählen Sie das Modell aus und starten Sie den Dialog: Sobald die Konfiguration abgeschlossen ist, können Sie das Modell auswählen und einen Dialog mit dem Ollama-Ferndienst starten.

3.2 Verbindung mit dem Open Ollama Service mit Cherry Studio

Studio Kirsche Sie ist umfangreicher und unterstützt neben den Dialogfunktionen auch fortgeschrittene Funktionen wie die Verwaltung von Wissensdatenbanken. Die Schritte zur Verbindung sind wie folgt:

- Laden Sie den Cherry Studio-Client herunter und installieren Sie ihn.

- Konfigurieren Sie die Ollama-Schnittstelle: existieren Studio Kirsche Stellen Sie unter "Einstellungen" → "Modelldienste" → "Ollama" die API-Adresse auf

http://目标IP:11434. - Hinzufügen und Validieren des Modells: Fügen Sie das Zielmodell auf der Modellverwaltungsseite hinzu, z. B. "deepseek-r1:1.5b", und testen Sie die Verbindung, damit Sie sie nach Erfolg verwenden können.

Mit Hilfe von Clients wie ChatBox oder Cherry Studio können sich die Nutzer ganz einfach mit den im Internet angebotenen Ollama-Diensten verbinden undKostenlose unbefugte Nutzung der Computerressourcen und Modellierungsmöglichkeiten anderer.

Nachdem Sie eine zufällige Adresse erhalten haben, versuchen Sie es mit dem Web-Plugin, das das Lesen von Ollama-Modellen von Haus aus unterstützt Seite Assist Dialog in der Mitte:

4. die Sicherheitsrisiken hinter dem "kostenlosen Mittagessen": Stromdiebstahl, Datenlecks und rechtliche Fallstricke

Hinter dem scheinbar "kostenlosen Mittagessen" verbergen sich viele Sicherheitsrisiken und potenzielle rechtliche Probleme:

- Rechendiebstahl (Missbrauch von Ressourcen). Das unmittelbarste Risiko besteht darin, dass die GPU-Rechenleistung eines Ollama-Dienstanbieters von anderen ohne Entschädigung genutzt wird, was zu Ressourcenverschwendung und Leistungseinbußen führt. Angreifer können automatisierte Skripte verwenden, um Massen-Scans durchzuführen und eine Verbindung zu offenen Ollama-Diensten herzustellen, wodurch deren GPUs zu "Ausbeuterbetrieben" für das Training bösartiger Modelle werden.

- Datenpanne. Wenn sensible Daten im Ollama-Dienst gespeichert oder verarbeitet werden, besteht die Gefahr, dass diese Daten in einer offenen Netzwerkumgebung nach außen dringen. Die Dialogprotokolle der Nutzer, Trainingsdaten usw. könnten über unverschlüsselte Kanäle übertragen und böswillig abgehört oder gestohlen werden.

- Modelle zu verkaufen. Unverschlüsselte Modelldateien können leicht heruntergeladen und kopiert werden, und wenn große Modelle kommerziell wertvoller Branchen in den Diensten von Ollama verwendet werden, besteht die Gefahr, dass die Modelle gestohlen und verkauft werden, was zu erheblichen finanziellen Verlusten führen kann.

- Eindringen in das System. Der Ollama-Dienst selbst weist möglicherweise eine Sicherheitslücke auf, die, wenn sie von einem Hacker ausgenutzt wird, zu einer Remotecodeausführung führen kann, die es einem Angreifer ermöglicht, die vollständige Kontrolle über den Server eines Opfers zu erlangen und ihn in eineumwandeln inTeil eines Botnetzes, das zur Durchführung größerer Cyberangriffe verwendet wird.

- Rechtliche Risiken. Der unbefugte Zugriff auf und die Nutzung von Ollama-Diensten anderer Personen oder sogar deren böswillige Nutzung kann gegen einschlägige Gesetze und Vorschriften verstoßen und rechtliche Konsequenzen nach sich ziehen.

5. sind chinesische Nutzer sicherer? -- Dynamische IP ist kein absolutes Hindernis

Es wurde argumentiert, dass "chinesische Nutzer aufgrund ihres geringen unabhängigen Besitzes an geistigem Eigentum relativ sicher vor diesem 'White Whoring'-Risiko sind". Diese Ansicht ist etwas einseitig.

Es stimmt, dass ein höherer Prozentsatz der chinesischen Breitbandnutzer zu Hause dynamische IPs verwendet als in westlichen Ländern, was das Gefährdungsrisiko bis zu einem gewissen Grad verringert. Die Unsicherheit dynamischer IPs erschwert es Angreifern, bestimmte Nutzer über einen längeren Zeitraum zu verfolgen und zu lokalisieren.

Dies bedeutet jedoch keineswegs, dass die chinesischen Nutzer beruhigt sein können. Erstens gibt es immer noch eine große Anzahl von Ollama-Servern in der chinesischen Internetumgebung, darunter viele mit festen IPs. Zweitens können selbst dynamische IPs für eine gewisse Zeit unverändert bleiben, und es ist für einen Angreifer immer noch möglich, einen Angriff in dem Zeitfenster durchzuführen, in dem die IP-Adresse nicht geändert wurde. Noch wichtiger ist.Sicherheit kann nicht dem "Glück" oder "natürlichen Barrieren" überlassen werden, sondern sollte auf proaktiven Sicherheitsmaßnahmen beruhen.

6. lokale Ollama Service Sicherheitsrichtlinien: Vermeiden Sie es, ein "Broiler" zu werden

Um lokal eingesetzte Ollama-Dienste vor dem Missbrauch durch andere zu schützen, müssen die Nutzer proaktive und effektive Sicherheitsmaßnahmen ergreifen. Im Folgenden finden Sie einige Richtlinien für unerfahrene Benutzer:

6.1 Einschränkung der Ollama-Service-Listening-Adressen

Ändern Sie die Abhöradresse des Ollama-Dienstes von der Standardadresse 0.0.0.0 ändern in 127.0.0.1Sie können.Erzwingt, dass der Ollama-Dienst nur auf Anfragen vom lokalen Rechner hört und den direkten Zugriff von externen Netzen verweigert. Die Schritte sind wie folgt:

- Suchen Sie die Konfigurationsdatei: Die Konfigurationsdateien von Ollama befinden sich normalerweise im Verzeichnis

/etc/ollama/config.conf.. Öffnen Sie die Datei (oder erstellen Sie sie, falls sie nicht existiert), suchen Sie diebind_addressKonfigurationselement. - Ändern Sie die verbindliche Adresse: Oberbefehlshaber (Militär)

bind_addresswird auf den Wert von127.0.0.1und sicherzustellen, dassporteingestellt auf11434. Ein vollständiges Konfigurationsbeispiel ist unten abgebildet:bind_address = 127.0.0.1 port = 11434 - Speichern Sie und starten Sie den Dienst neu: Nachdem Sie die Konfigurationsdatei gespeichert haben, führen Sie den Befehl

sudo systemctl restart ollamaBefehl, um den Ollama-Dienst neu zu starten, damit die Konfiguration wirksam wird.

6.2 Konfigurieren von Firewall-Regeln

Durch die Konfiguration von Firewall-Regeln können SieGenaue Kontrolle über den Bereich der IP-Adressen und Ports, die für den Zugriff auf den Ollama-Dienst zugelassen sind. Sie können zum Beispiel nur IP-Adressen in Ihrem LAN den Zugriff auf Port 11434 erlauben und alle Zugriffsanfragen aus dem öffentlichen Netz blockieren. Im Folgenden wird beschrieben, wie Sie die Firewall in Windows- bzw. Linux-Umgebungen konfigurieren:

Schritte zur Konfiguration der Windows-Umgebung:

- Aktivieren Sie die erweiterte Sicherheit der Windows Defender Firewall: Suchen Sie in der "Systemsteuerung" nach "System und Sicherheit", klicken Sie auf "Windows Defender Firewall" und wählen Sie "Erweiterte Einstellungen". Erweiterte Einstellungen".

- Erstellen Sie eine neue eingehende Regel: Klicken Sie unter "Eingehende Regeln" auf "Neue Regel...", wählen Sie den Regeltyp "Port" und klicken Sie auf "Weiter". Weiter".

- Gibt den Anschluss und das Protokoll an: Als Protokoll wird "TCP" gewählt und der spezifische lokale Port wird auf

11434und klicken Sie auf "Weiter". - Wählen Sie den Vorgang aus: Wählen Sie "Verbindung zulassen" und klicken Sie auf "Weiter".

- Konfigurieren Sie den Bereich (optional): Sie können die Regelbereiche nach Bedarf konfigurieren, im Allgemeinen behalten Sie die Standardeinstellungen bei und klicken auf Weiter.

- Geben Sie den Namen und die Beschreibung an: Geben Sie der Regel einen leicht erkennbaren Namen (z. B. "Ollama Service Port Restriction"), fügen Sie eine Beschreibung hinzu (optional) und klicken Sie auf "Finish", um die Erstellung der Regel abzuschließen.

Linux-Umgebung (z. B. ufw-Firewall) Konfigurationsschritte:

- Aktivieren Sie die ufw-Firewall: Wenn ufw nicht bereits aktiviert ist, führen Sie Folgendes im Terminal aus

sudo ufw enableum die Firewall zu aktivieren. - LAN-Zugang zulassen: vollziehen

sudo ufw allow from 192.168.1.0/24 to any port 11434Befehl, der es ermöglicht, die192.168.1.0/24Die IP-Adresse des LAN-Segments greift auf Port 11434 zu. Bitte ändern Sie den IP-Adressbereich entsprechend dem tatsächlichen LAN-Segment. - Anderen Zugang verweigern (optional): Wenn die Standardrichtlinie den gesamten externen Zugriff zulässt, können Sie den Befehl

sudo ufw deny 11434um den Zugriff auf Port 11434 für IP-Adressen aus allen anderen Quellen zu verweigern. - Zeigen Sie den Status der Firewall an: vollziehen

sudo ufw status verboseum den Status der Firewall-Regel zu prüfen und zu bestätigen, dass die Konfiguration wirksam geworden ist.

6.3 Aktivieren von Authentifizierung und Zugriffskontrolle

Für Szenarien, in denen Sie Ollama-Dienste extern anbieten müssen, sollten Sie Folgendes beachtenAktivieren von Authentifizierungsmechanismen. um unbefugten Zugriff zu verhindern. Im Folgenden finden Sie einige gängige Authentifizierungsmethoden:

- HTTP-Basis-Authentifizierung: Die HTTP-Basisauthentifizierung kann über einen Webserver wie Apache oder Nginx konfiguriert werden. Diese Methode ist einfach und leicht zu verwenden, aber die Sicherheit ist relativ gering, geeignet für Szenarien, die keine hohe Sicherheit erfordern. Nach der Konfiguration der Basisauthentifizierung müssen die Benutzer beim Zugriff auf die Ollama-Dienste einen Benutzernamen und ein Passwort eingeben.

- API-Schlüssel: Hinzufügen eines API-Schlüssel-Verifizierungsmechanismus zum Ollama Service Front-End. Wenn ein Client einen Ollama-Dienst anfordert, muss er einen vordefinierten API-Schlüssel in den Request-Header oder die Request-Parameter aufnehmen. Die Serverseite überprüft die Gültigkeit des Schlüssels und nur Anfragen mit dem richtigen Schlüssel werden verarbeitet. Dieser Ansatz ist sicherer als die einfache Authentifizierung und lässt sich leicht in Anwendungen integrieren.

- Fortschrittlichere Authentifizierungs- und Autorisierungsmechanismen wie OAuth 2.0: Für Szenarien mit höheren Sicherheitsanforderungen können komplexere Authentifizierungs- und Autorisierungs-Frameworks wie OAuth 2.0 in Betracht gezogen werden. OAuth 2.0 bietet einen perfekten Autorisierungs- und Authentifizierungsprozess, unterstützt mehrere Autorisierungsmodi und kann eine feinkörnige Zugriffskontrolle erreichen. Allerdings ist die Konfiguration und Integration von OAuth 2.0 relativ komplex und erfordert einen gewissen Entwicklungsaufwand.

Die Wahl der Authentifizierungsmethode muss auf einer Kombination von Faktoren wie den Anwendungsszenarien, den Sicherheitsanforderungen und den Kosten der technischen Implementierung des Ollama-Dienstes beruhen.

6.4 Verwendung eines Reverse-Proxys

Mit einem Reverse-Proxy-Server (z. B. Nginx) können Siefungiert als Front-End für den Ollama-Dienst, verbirgt die echte IP-Adresse und den Port des Ollama-Dienstes und bietet zusätzliche SicherheitsfunktionenZum Beispiel:

- Verstecken Sie den Back-End-Server: Der Reverse-Proxy-Server fungiert als "Fassade" für den Ollama-Dienst: Externe Nutzer sehen nur die IP-Adresse des Reverse-Proxy-Servers und können nicht direkt auf den echten Server zugreifen, auf dem sich der Ollama-Dienst befindet, was die Sicherheit erhöht.

- Lastausgleich: Wenn der Ollama-Dienst auf mehreren Servern bereitgestellt wird, kann der Reverse-Proxy-Server einen Lastausgleich implementieren, um die Benutzeranfragen auf verschiedene Server zu verteilen und so die Verfügbarkeit und Leistung des Dienstes zu verbessern.

- SSL/TLS-Verschlüsselung: Reverse-Proxy-Server können mit SSL/TLS-Zertifikaten konfiguriert werden, um einen HTTPS-verschlüsselten Zugang zu ermöglichen und die Sicherheit der Datenübertragung zu gewährleisten.

- Web Application Firewall (WAF): Einige Reverse-Proxy-Server verfügen über WAF-Funktionen zur Erkennung und Abwehr gängiger Webangriffe wie SQL-Injection, Cross-Site-Scripting-Attacken (XSS) usw., wodurch die Sicherheit des Ollama-Dienstes weiter erhöht wird.

- Zugangskontrolle: Reverse-Proxy-Server können mit flexibleren Zugriffskontrollrichtlinien konfiguriert werden, z. B. Zugriffskontrolle auf der Grundlage der IP-Adresse, der Benutzeridentität und des Inhalts der Anfrage.

7. schlussfolgerung: Sicherheitsbewusstsein und Verantwortung in der Praxis

Die Popularität lokal eingesetzter Big-Model-Tools wie Ollama hat technologische Innovationen und Anwendungen erleichtert, aber auch neue Herausforderungen für die Cybersicherheit mit sich gebracht. Der Ollama-Dienst, der im Internet als "kostenlos zu nutzen" angepriesen wird, mag verlockend erscheinen, birgt aber versteckte Risiken. Ein solches Verhalten kann nicht nur gegen Gesetze und Vorschriften sowie die Cyber-Ethik verstoßen, sondern auch eine Bedrohung für Ihre eigene Cybersicherheit und die anderer darstellen.

Für die Betreiber von Ollama-Diensten liegt es in ihrer Verantwortung, das Sicherheitsbewusstsein zu schärfen und die notwendigen Sicherheitsmaßnahmen zu ergreifen, um ihre eigenen Computerressourcen und die Datensicherheit zu schützen sowie eine gesunde Netzwerkumgebung aufrechtzuerhalten. Machen Sie Ihre Server nicht zu "Rechenknechten" oder gar zu Komplizen von Cyberangriffen aufgrund einer momentanen Nachlässigkeit.

Jeder Internetnutzer, der die Vorteile der Technologie nutzt, sollte stets wachsam sein, die richtige Einstellung zur Netzsicherheit entwickeln und gemeinsam am Aufbau eines sicheren, vertrauenswürdigen und nachhaltigen Ökosystems für KI-Anwendungen arbeiten.

RISK ALERT AGAIN: Bitte überprüfen und härten Sie Ihren Ollama-Dienst sofort! Sicherheit ist keine Kleinigkeit!

Die Popularität des DeepSeek-Modells und des Ollama-Tools ist zweifellos ein Beispiel für die Entwicklung der KI-Technologie. Die Sicherheit ist jedoch immer der Eckpfeiler des technologischen Fortschritts, der nicht ignoriert werden darf. Bitte Ollama-NutzerÜberprüfen Sie umgehend Ihre lokale Bereitstellungskonfiguration, bewerten Sie potenzielle Sicherheitsrisiken und ergreifen Sie die erforderlichen Schutzmaßnahmen. Es ist noch nicht zu spät, sich zu bessern.

Diejenigen, die Ollama noch nicht installiert haben oder den Einsatz von Ollama in Erwägung ziehen, sollten unbedingt auchErkennen Sie die Sicherheitsrisiken, die mit dem lokalen Einsatz von Big-Model-Tools verbunden sind, und schätzen Sie Ihre eigenen technischen Fähigkeiten und Ihr Sicherheitsniveau umsichtig ein, um sie unter der Prämisse der Gewährleistung der Sicherheit angemessen einzusetzen. Denken Sie daran, dass jeder für die Cybersicherheit verantwortlich ist, und dass die beste Strategie darin besteht, einen Schaden zu verhindern, bevor er eintritt.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...