DeepClaude: Eine Chat-Schnittstelle, die DeepSeek R1 Chain Reasoning mit Claude-Kreativität verbindet

Allgemeine Einführung

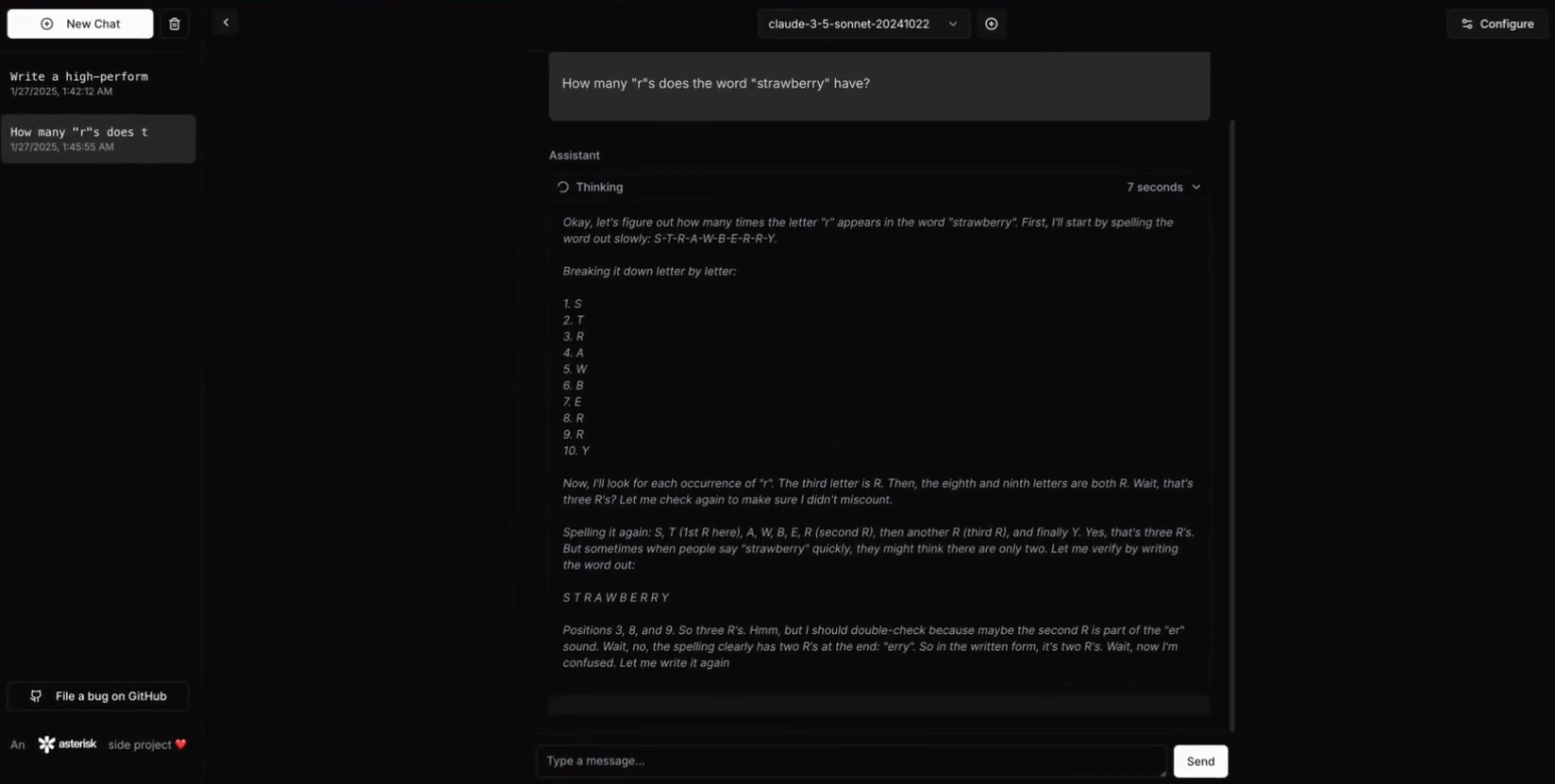

DeepClaude ist eine leistungsstarke Large Language Model (LLM) Inferenz-API und Chat-Schnittstelle, die die Chained Reasoning (CoT) Fähigkeiten von DeepSeek R1 mit der AnthropischClaude Modellkreativität und Fähigkeiten zur Codegenerierung. Dieses Projekt übertrifft die Leistung von OpenAI o1 deutlich, DeepSeek R1 und Claude Sonnet 3.5, bietet eine einheitliche Schnittstelle, die die Stärken beider Modelle nutzt und gleichzeitig die volle Kontrolle über API-Schlüssel und Daten behält. Zu den Merkmalen von DeepClaude gehören eine Antwort mit Null-Latenzzeit, End-to-End-Sicherheit, hohe Konfigurierbarkeit und eine Open-Source-Codebasis. Benutzer können ihre API-Schlüssel mit ihren eigenen verwalten und so den Datenschutz und die Sicherheit ihrer Daten gewährleisten. Und das Beste ist, dass DeepClaude völlig kostenlos und quelloffen ist.

DeepClaude verwendet R1 für die Inferenz und lässt Claude dann die Ergebnisse ausgeben

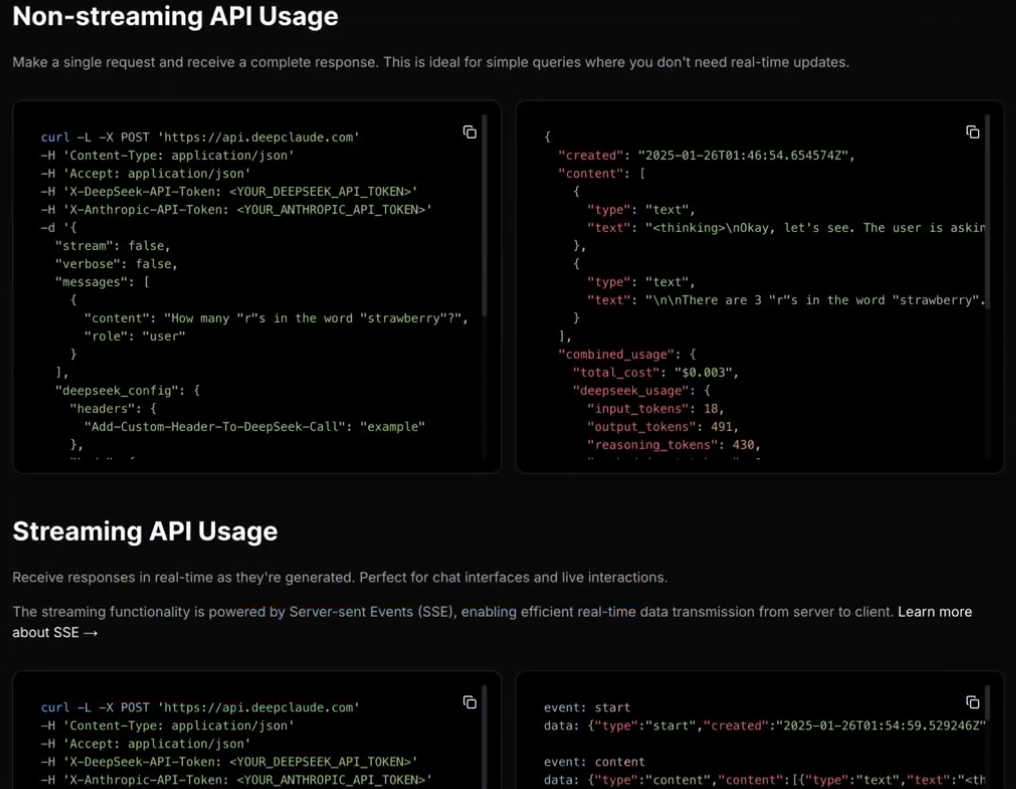

DeepClaude bietet auch eine leistungsstarke LLM-Inferenz-API

Funktionsliste

- Antwort ohne LatenzzeitSofortige Antwort durch eine leistungsstarke Rust-API.

- privat und sicherLokale API-Schlüsselverwaltung zur Gewährleistung des Datenschutzes.

- Hochgradig konfigurierbarBenutzer können Aspekte der API und der Schnittstelle an ihre Bedürfnisse anpassen.

- offene QuelleFreie und quelloffene Code-Basis, Benutzer können frei beitragen, ändern und einsetzen.

- Duale AI-FähigkeitenKombinieren Sie die Kreativität und die Code-Generierungsleistung von Claude Sonnet 3.5 mit der Denkleistung von DeepSeek R1.

- Gehostete BYOK-APIVerwaltet mit dem eigenen API-Schlüssel des Nutzers, um eine vollständige Kontrolle zu gewährleisten.

Hilfe verwenden

Einbauverfahren

- Vorbedingungen::

- Rust 1.75 oder höher

- DeepSeek API-Schlüssel

- Anthropischer API-Schlüssel

- Klon-Lager::

git clone https://github.com/getAsterisk/deepclaude.git

cd deepclaude

- Erstellen Sie das Projekt::

cargo build --release

- KonfigurationsdateiAnlegen im Stammverzeichnis des Projekts

config.tomlDokumentation:

[server]

host = "127.0.0.1"

port = 3000

[pricing]

# 配置定价选项

- Operative Dienste::

cargo run --release

Leitlinien für die Verwendung

- API-Verwendung::

- grundlegendes Beispiel::

import requests url = "http://127.0.0.1:3000/api" payload = { "model": "claude", "prompt": "Hello, how can I help you today?" } response = requests.post(url, json=payload) print(response.json())- Beispiel für eine Streaming-Antwort::

import requests url = "http://127.0.0.1:3000/api/stream" payload = { "model": "claude", "prompt": "Tell me a story." } response = requests.post(url, json=payload, stream=True) for line in response.iter_lines(): if line: print(line.decode('utf-8')) - selbst gehostet::

- Optionen zur KonfigurationBenutzer können die

config.tomlKonfigurationsoptionen in der Dokumentation, um Aspekte der API und der Schnittstelle anzupassen.

- Optionen zur KonfigurationBenutzer können die

- Sicherheit::

- Lokale API-SchlüsselverwaltungGewährleistung des Datenschutzes für API-Schlüssel und Daten.

- End-to-End-VerschlüsselungSchützt die Sicherheit der Datenübertragung.

- einweihen::

- Leitlinien für BeiträgeBenutzer können Code beitragen und das Projekt verbessern, indem sie Pull Requests einreichen oder Probleme melden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...