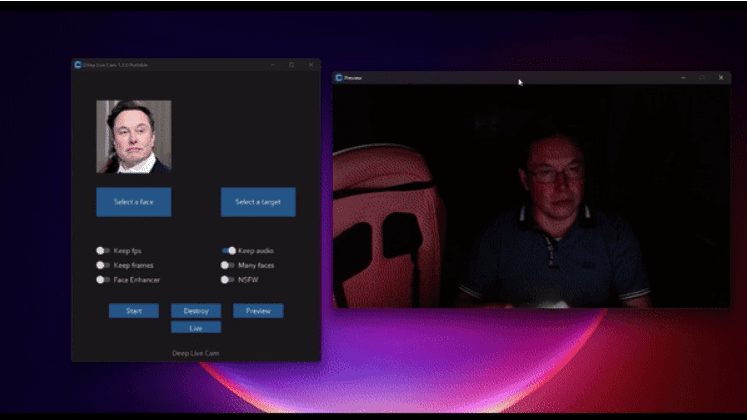

Deep Live Cam: Open-Source-Echtzeit-KI-Gesichtstausch-Tool, ein Foto für Live-Gesichtstausch in Echtzeit

Allgemeine Einführung

Deep Live Cam ist ein Open-Source-KI-Tool, das die Ersetzung von Gesichtern in Echtzeit und die Erstellung von Deep-Fake-Videos aus einem einzigen Foto ermöglicht. Deep Live Cam unterstützt mehrere Plattformen, einschließlich CPU, NVIDIA CUDA, Apple Silicon usw., und eignet sich für eine breite Palette von Bereichen wie Unterhaltung, Bildung, Kunst und Werbung.

Funktionsliste

- Gesichtsersetzung in Echtzeit: Gesichtsersetzung in Echtzeit im Video durch ein einziges Foto.

- Multiplattform-Unterstützung: Kompatibel mit den gängigen Betriebssystemen und Hardware-Plattformen.

- GPU-Beschleunigung: Unterstützt NVIDIA CUDA-Beschleunigung zur Erhöhung der Verarbeitungsgeschwindigkeit.

- Mechanismus zur Inhaltskontrolle: Integrierter Mechanismus zum Schutz vor Missbrauch, um zu verhindern, dass die Technologie in unangemessenen Szenarien eingesetzt wird.

- Offener Quellcode: Der Projektcode wird auf GitHub gehostet und kann von den Benutzern frei heruntergeladen und verändert werden.

Hilfe verwenden

Einbauverfahren

- Vorbereitung der Umwelt::

- Stellen Sie sicher, dass Python 3.10 oder höher installiert ist.

- Installieren Sie pip, git, ffmpeg und andere Entwicklungswerkzeuge.

- Windows-Benutzer müssen außerdem die Visual Studio 2022-Runtime installieren.

- Klonen und Konfiguration::

- Klonen Sie das GitHub-Repository von Deep-Live-Cam in Ihre lokale Umgebung:

git clone https://github.com/hacksider/Deep-Live-Cam.git - Laden Sie die erforderlichen Modelldateien herunter und legen Sie sie gemäß den Dokumentationsrichtlinien in dem angegebenen Verzeichnis ab:

- GFPGANv1.4

- inswapper_128_fp16.onnx

- Klonen Sie das GitHub-Repository von Deep-Live-Cam in Ihre lokale Umgebung:

- Abhängige Installation::

- Verwenden Sie pip, um die für das Projekt erforderlichen Bibliotheken zu installieren. Es wird empfohlen, eine virtuelle Umgebung zu verwenden, um potenzielle Konflikte mit Abhängigkeiten zu vermeiden:

pip install -r requirements.txt

- Verwenden Sie pip, um die für das Projekt erforderlichen Bibliotheken zu installieren. Es wird empfohlen, eine virtuelle Umgebung zu verwenden, um potenzielle Konflikte mit Abhängigkeiten zu vermeiden:

- laufendes Programm::

- Starten Sie Deep-Live-Cam über die Befehlszeile:

python run.py - Wählen Sie das Quellbild und das Zielvideo aus, um den Face-Swapping-Effekt in Echtzeit zu beobachten.

- Starten Sie Deep-Live-Cam über die Befehlszeile:

- GPU-Beschleunigung::

- Wenn Sie einen NVIDIA-Grafikprozessor haben, können Sie den Face-Swapping-Prozess beschleunigen, indem Sie das CUDA Toolkit installieren und die entsprechenden Umgebungsvariablen konfigurieren:

pip uninstall onnxruntime onnxruntime-gpu pip install onnxruntime-gpu==1.16.3 python run.py --execution-provider cuda

- Wenn Sie einen NVIDIA-Grafikprozessor haben, können Sie den Face-Swapping-Prozess beschleunigen, indem Sie das CUDA Toolkit installieren und die entsprechenden Umgebungsvariablen konfigurieren:

Verwendungsprozess

- Quellbild und Zielvideo auswählen::

- Wählen Sie nach dem Programmstart ein Bild, das das gewünschte Gesicht enthält, und ein Zielbild oder -video aus.

- Beginn der Bearbeitung::

- Klicken Sie auf die Schaltfläche "Start". Das Programm beginnt mit der Verarbeitung und zeigt den Effekt der Gesichtsveränderung in Echtzeit an.

- Ansicht Ausgabe::

- Sobald die Verarbeitung abgeschlossen ist, öffnen Sie den Datei-Explorer und navigieren Sie zum ausgewählten Ausgabeverzeichnis, um das erzeugte Face-Swap-Video anzusehen.

- Kamera-Modus::

- Wählen Sie ein Gesicht aus, klicken Sie auf die Schaltfläche "Live" und warten Sie ein paar Sekunden, bis die Vorschau angezeigt wird.

- Streaming mit einem Tool zur Bildschirmaufzeichnung, wie z. B. OBS.

caveat

- Wenn Sie das Programm zum ersten Mal ausführen, müssen Sie je nach Geschwindigkeit Ihrer Internetverbindung eine Modelldatei von etwa 300 MB herunterladen.

- Wenn Sie die Gesichter wechseln möchten, wählen Sie einfach ein anderes Bild aus und der Vorschaumodus wird neu gestartet.

Ressource (z. B. Arbeitskräfte oder Tourismus)

https://github.com/hacksider/Deep-Live-Cam

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...