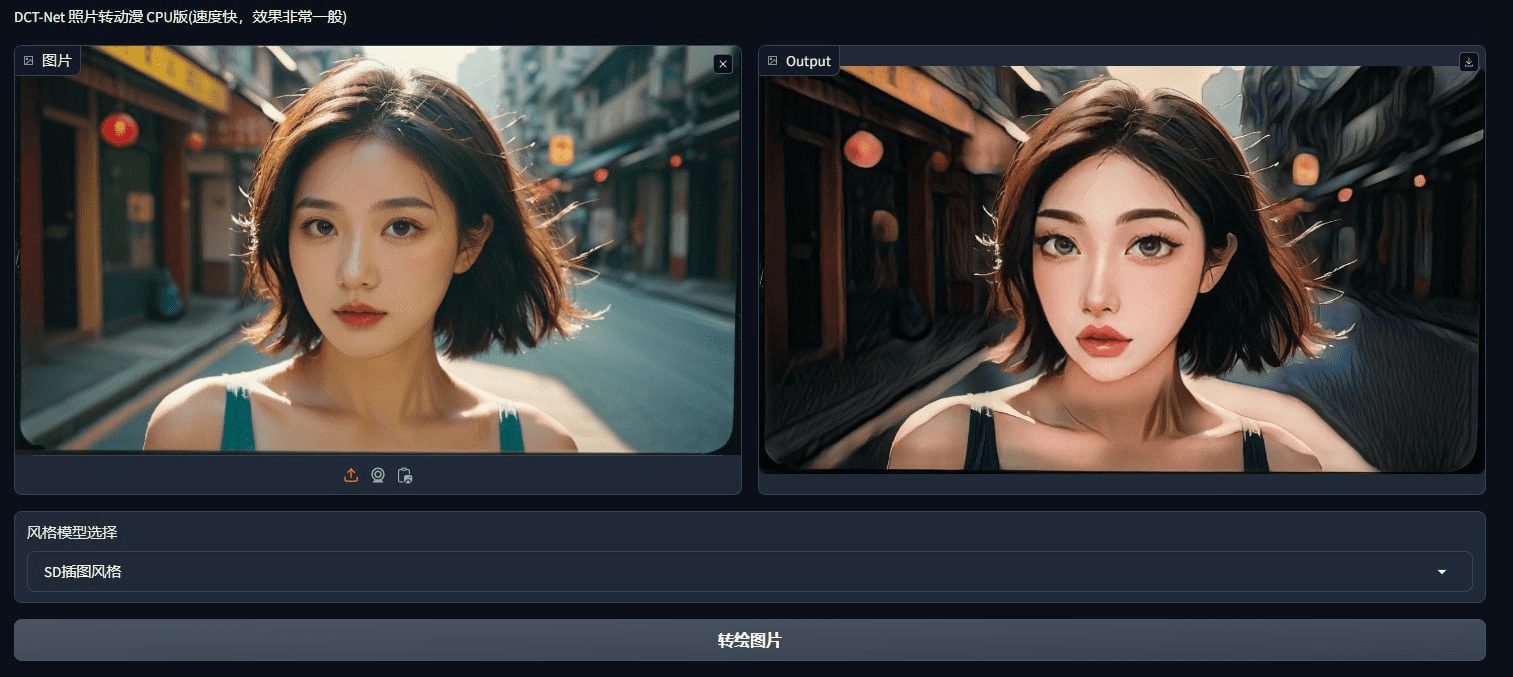

DCT-Net: Ein Open-Source-Tool zur Umsetzung von Fotos und Videos in Anime-Stilistik

Allgemeine Einführung

DCT-Net ist ein Open-Source-Projekt, das von der DAMO Academy und dem Wang Xuan Institute of Computer Technology der Universität Peking entwickelt wurde und die stilisierte Umwandlung von Bildern für Animationen zum Ziel hat. Das Projekt nutzt Deep-Learning-Techniken, um natürliche Fotos nahtlos in verschiedene Kunststile wie Animation, 3D, handgemalte Bilder, Skizzen usw. umzuwandeln, indem es Domain-Calibrated Translation einsetzt. DCT-Net bietet eine Vielzahl von Pre-Trainingsmodellen und unterstützt das Training von maßgeschneiderten Stildaten, die für die persönliche Unterhaltung, kreatives Design sowie die Film- und Spieleindustrie geeignet sind. Film- und Spieleindustrie.

Funktionsliste

- Bietet eine breite Palette an vortrainierten Modellen, die ein breites Spektrum an künstlerischen Stilen abdecken

- Unterstützung für Training mit benutzerdefinierten Stildaten

- Online-Testversion, keine Konfiguration der lokalen Umgebung erforderlich

- Effiziente Leistung, die sowohl CPU- als auch GPU-Umgebungen unterstützt

- Stilkonvertierung für Bilder und Videos

Hilfe verwenden

Installation und Konfiguration

- Installation von Abhängigkeiten: Zuerst müssen Sie das Programm

modelscopeBibliothek, die mit dem folgenden Befehl installiert werden kann:pip install "modelscope[cv]" -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html - Herunterladen des vortrainierten ModellsBeim ersten Durchlauf des Codes lädt das Modell automatisch die Pre-Training-Datei herunter.

Bildstil-Konvertierung

- Definieren Sie das ModellDefinition von fünf Arten von Gesichtern, die durch das DCT-Net-Modell umgewandelt werden sollen:

model_dict = { "anime": "damo/cv_unet_person-image-cartoon_compound-models", "3d": "damo/cv_unet_person-image-cartoon-3d_compound-models", "handdrawn": "damo/cv_unet_person-image-cartoon-handdrawn_compound-models", "sketch": "damo/cv_unet_person-image-cartoon-sketch_compound-models", "art": "damo/cv_unet_person-image-cartoon-artstyle_compound-models" } - Bilder laden und konvertieren::

import os import cv2 from IPython.display import Image, display, clear_output from modelscope.pipelines import pipeline from modelscope.utils.constant import Tasks from modelscope.outputs import OutputKeys style = "anime" # 可选 "anime", "3d", "handdrawn", "sketch", "art" filename = "4.jpg" img_path = 'picture/' + filename img_anime = pipeline(Tasks.image_portrait_stylization, model=model_dict["anime"]) result = img_anime(img_path) save_name = 'picture/images/' + os.path.splitext(filename)[0] + '_' + style + '.jpg' cv2.imwrite(save_name, result[OutputKeys.OUTPUT_IMG]) clear_output() display(Image(save_name))

Video-Stil-Konvertierung

- Videobilder extrahieren::

video = 'sample_video.mp4' video_file = 'movie/' + video image_dir = 'movie/images/' vc = cv2.VideoCapture(video_file) i = 0 if vc.isOpened(): rval, frame = vc.read() while rval: cv2.imwrite(image_dir + str(i) + '.jpg', frame) i += 1 rval, frame = vc.read() vc.release() - Konvertierung von VideobildernStilisieren Sie jedes Bild mit der gleichen Methode wie bei der Bildkonvertierung und fügen Sie die konvertierten Bilder zu einem Video zusammen.

Ein-Klick-Installer herunterladen

Lite (CPU-Version, nur Manga-Stil beibehalten)

https://drive.uc.cn/s/eab2a6fad2dd4 Kennwort: XTQi

Vollständige Version:

thunderbolt downloadQuark DownloadBaidu herunterladen (6666)

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...