CogVLM2: ein quelloffenes multimodales Modell zur Unterstützung des Videoverstehens und mehrerer Dialogrunden

Allgemeine Einführung

CogVLM2 ist ein quelloffenes multimodales Modell, das von der Tsinghua University Data Mining Research Group (THUDM) entwickelt wurde. Es basiert auf der Llama3-8B-Architektur und soll eine vergleichbare oder sogar bessere Leistung als GPT-4V bieten. Das Modell unterstützt das Verstehen von Bildern, den Dialog über mehrere Runden und das Verstehen von Videos und ist in der Lage, Inhalte mit einer Länge von bis zu 8K zu verarbeiten und Bildauflösungen von bis zu 1344x1344 zu unterstützen. Die CogVLM2-Familie besteht aus mehreren Untermodellen, die für verschiedene Aufgaben optimiert sind, wie z.B. Text-Q&A, Dokumenten-Q&A und Video-Q&A. Die Modelle sind nicht nur zweisprachig, sondern bieten auch eine Vielzahl von Online-Erfahrungen und Einsatzmethoden für Benutzer zum Testen und Anwenden.

Weitere Informationen:Wie lange kann ein Video von einem großen Modell verstanden werden? Smart Spectrum GLM-4V-Plus: 2 Stunden

Funktionsliste

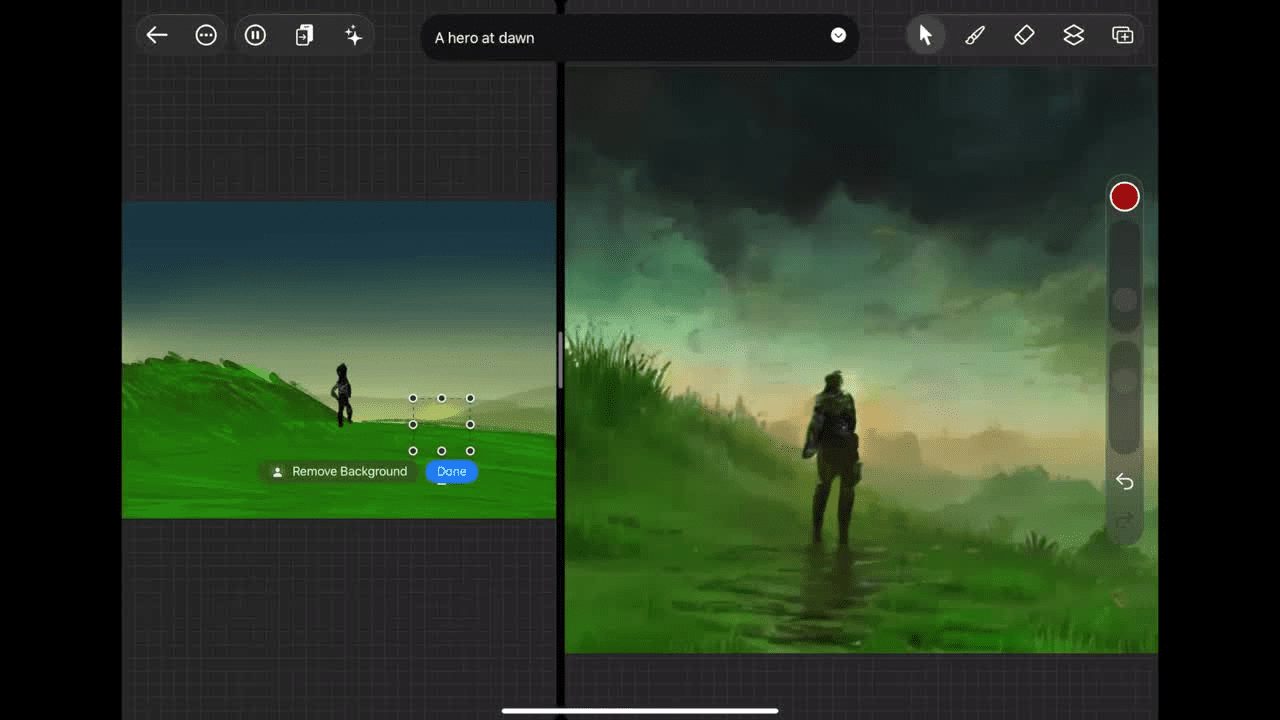

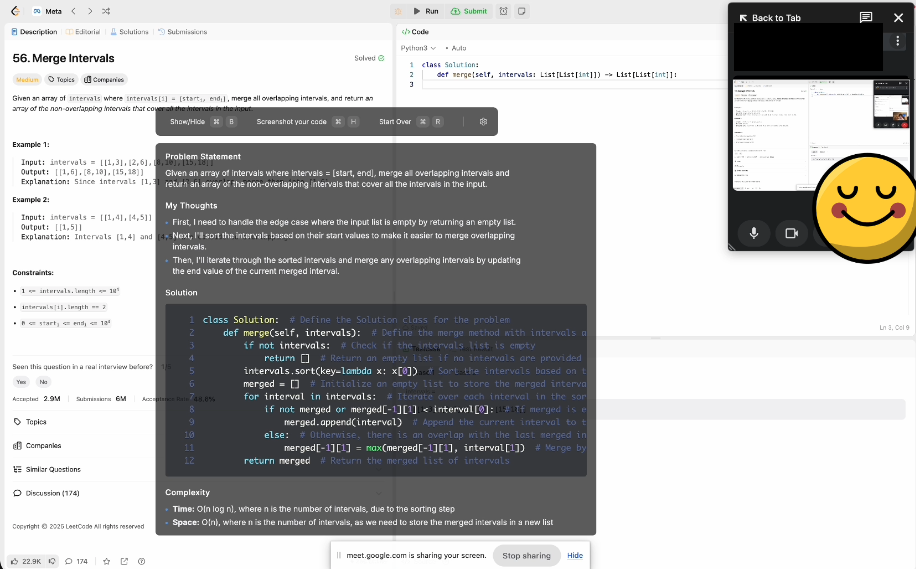

- grafisches VerständnisUnterstützt das Verständnis und die Verarbeitung von hochauflösenden Bildern.

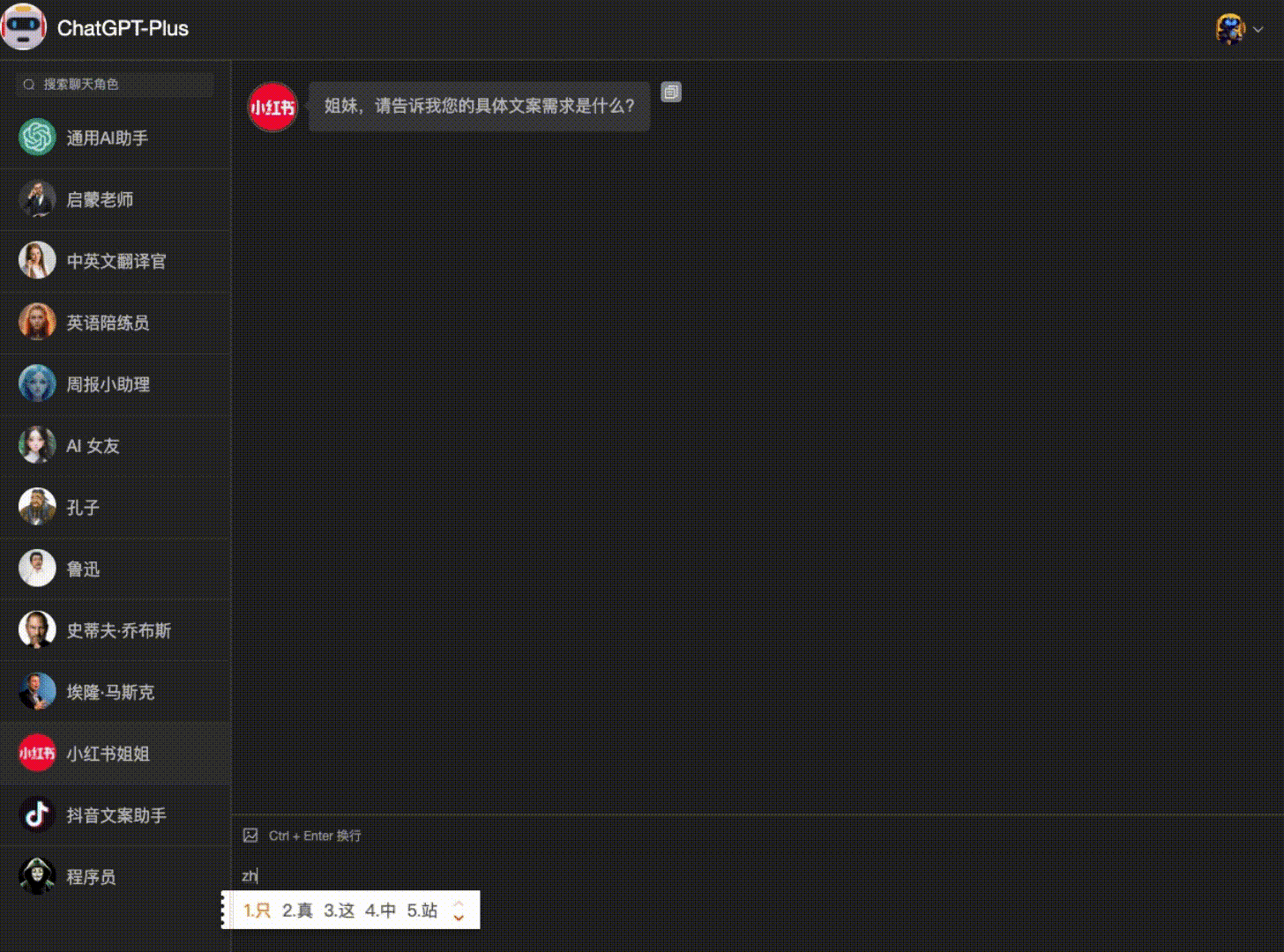

- vielschichtiger DialogFähigkeit zu mehreren Dialogrunden, geeignet für komplexe Interaktionsszenarien.

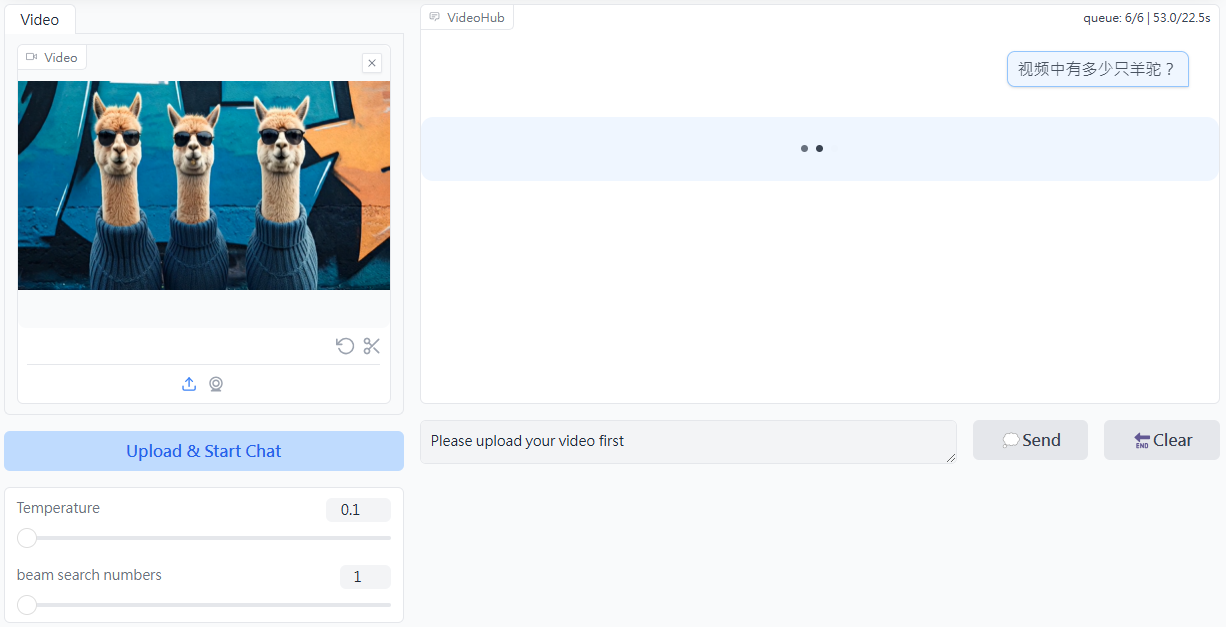

- Video-VerständnisUnterstützt das Verstehen von Videoinhalten mit einer Länge von bis zu 1 Minute durch Extraktion von Keyframes.

- Unterstützung mehrerer SprachenChinesische und englische Zweisprachigkeit unterstützen, um sich an unterschiedliche Sprachumgebungen anzupassen.

- Open Source (Datenverarbeitung)Der vollständige Quellcode und die Modellgewichte werden zur Verfügung gestellt, um die Sekundärentwicklung zu erleichtern.

- Online-ErfahrungBietet eine Online-Demoplattform, auf der die Benutzer die Funktionalität des Modells direkt erleben können.

- Mehrere EinsatzoptionenUnterstützt Huggingface, ModelScope und andere Plattformen.

Hilfe verwenden

Installation und Einsatz

- Klon-Lager::

git clone https://github.com/THUDM/CogVLM2.git

cd CogVLM2

- Installation von Abhängigkeiten::

pip install -r requirements.txt

- Download ModellgewichteDownloaden Sie die entsprechenden Modellgewichte und legen Sie sie im angegebenen Verzeichnis ab.

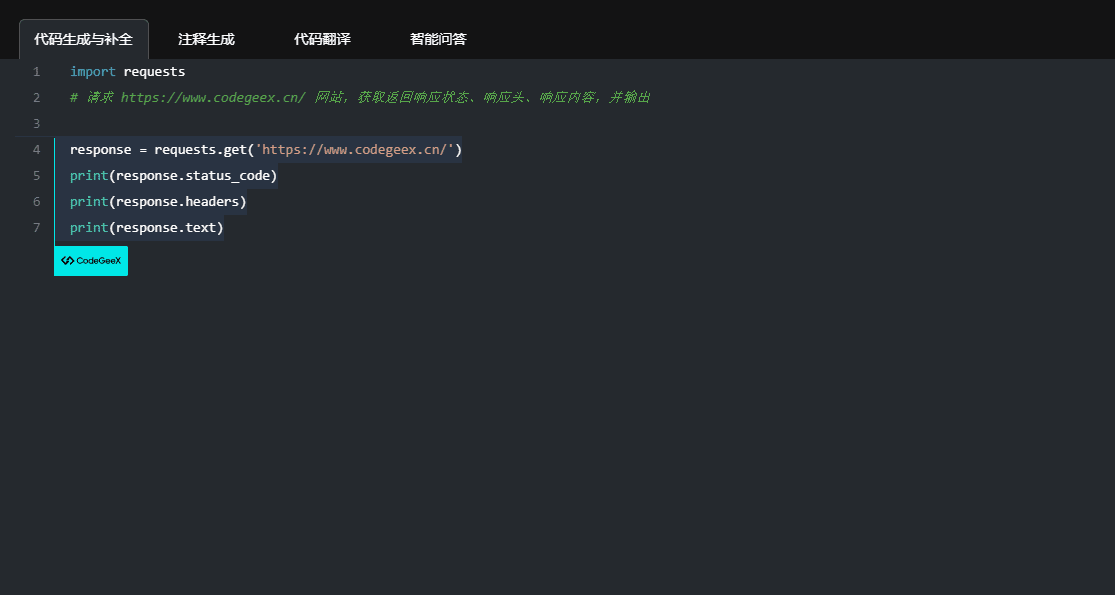

Anwendungsbeispiel

grafisches Verständnis

- Modelle laden::

from cogvlm2 import CogVLM2

model = CogVLM2.load('path_to_model_weights')

- Prozessabbild::

image = load_image('path_to_image')

result = model.predict(image)

print(result)

vielschichtiger Dialog

- Initialisierung des Dialogs::

conversation = model.start_conversation()

- einen Dialog führen::

response = conversation.ask('你的问题')

print(response)

Video-Verständnis

- Video laden::

video = load_video('path_to_video')

result = model.predict(video)

print(result)

Online-Erfahrung

Benutzer können auf die Online-Demoplattform von CogVLM2 zugreifen, um die Funktionalität des Modells online und ohne lokalen Einsatz zu testen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...