Mistral AI veröffentlicht Codestral 25.01 Modelle: größere, schnellere und stärkere programmierspezifische Modelle

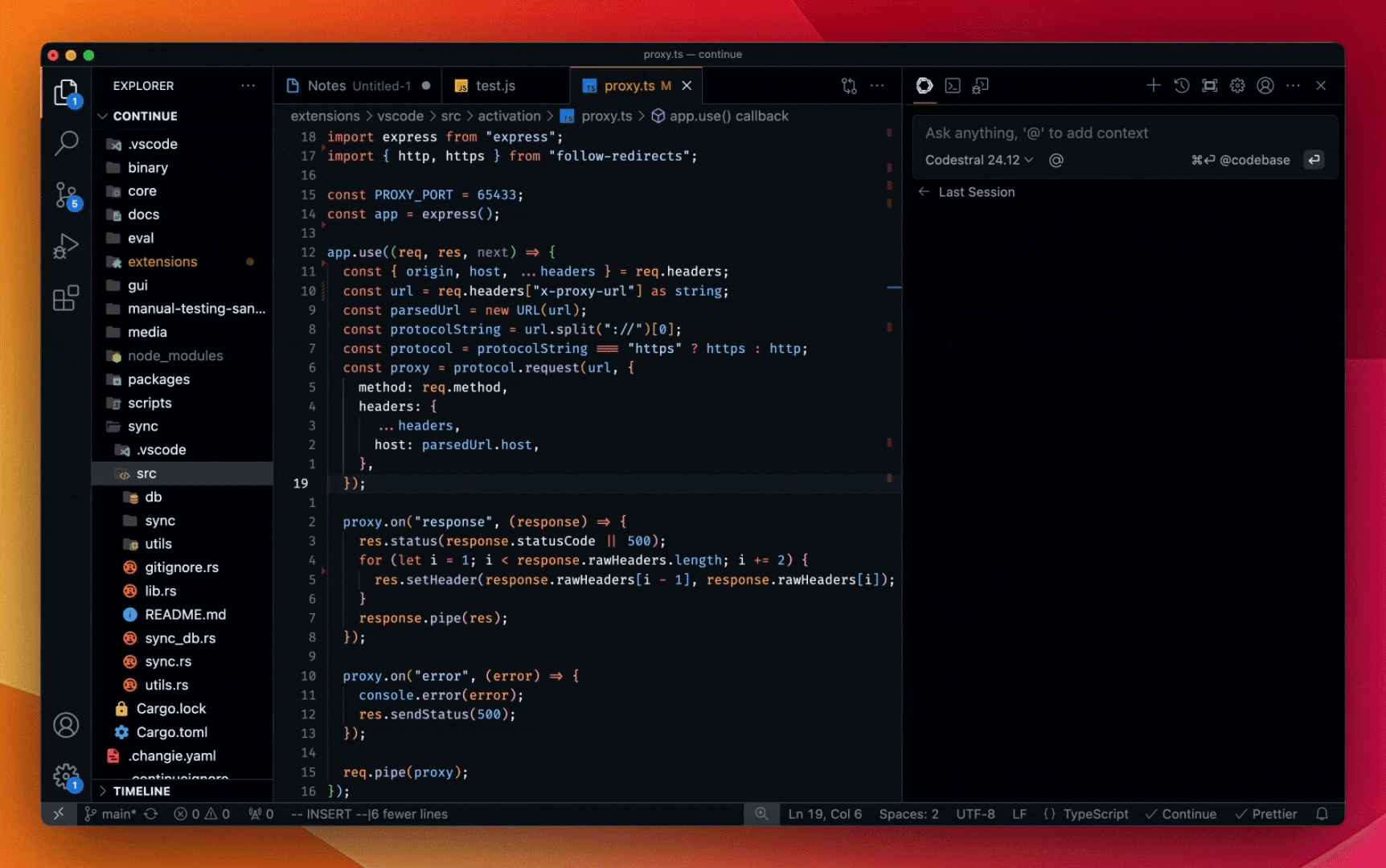

Code mit der Geschwindigkeit der Tabulatortaste. Heute im Weiter.dev und wird bald auch für andere führende KI-Code-Assistenten verfügbar sein.

Von allen Innovationen im Bereich der künstlichen Intelligenz im vergangenen Jahr war die Codegenerierung wohl die wichtigste. Ähnlich wie Fließbänder die Fertigung vereinfachten und Taschenrechner die Mathematik veränderten, stellen Codierungsmodelle eine bedeutende Veränderung in der Softwareentwicklung dar.

Mistral AI hat mit der Einführung von Codestral, einem hochmodernen (SOTA) Codierungsmodell, das Anfang des Jahres auf den Markt kam, eine Vorreiterrolle übernommen. Codestral ist leichtgewichtig, schnell und beherrscht mehr als 80 Programmiersprachen. Es ist für Anwendungsfälle mit niedriger Latenz und hoher Frequenz optimiert und unterstützt Aufgaben wie Fill-in-the-Middle (FIM), Codekorrektur und Testerstellung. codestral Codestral wird von Tausenden von Entwicklern als leistungsfähiger Programmierassistent eingesetzt und steigert die Produktivität oft um ein Vielfaches. Heute wird Codestral einem großen Upgrade unterzogen.

Codestral 25.01 Mit einer effizienteren Architektur und einem verbesserten Tokeniser als in der ursprünglichen Version wird der Code etwa 2x schneller generiert und fertiggestellt. Das Modell ist jetzt der klare Marktführer beim Schreiben von Code in seiner Gewichtsklasse und ist SOTA in allen FIM-Anwendungsfällen.

Benchmarking

Wir haben das neue Codestral mit dem führenden Codierungsmodell mit Parametern unter 100B verglichen, das allgemein als das beste für die FIM-Aufgabe angesehen wird.

skizziert.

| Python | SQL | Mehrsprachige Durchschnittswerte | |||

|---|---|---|---|---|---|

| Modellierung | Länge des Kontexts | HumanEval | MBPP | CruxEval | LiveCodeBench |

| Codestral-2501 | 256k | 86.6% | 80.2% | 55.5% | 37.9% |

| Codestral-2405 22B | 32k | 81.1% | 78.2% | 51.3% | 31.5% |

| Codellama 70B instruieren | 4k | 67.1% | 70.8% | 47.3% | 20.0% |

| DeepSeek Coder 33B instruieren | 16k | 77.4% | 80.2% | 49.5% | 27.0% |

| DeepSeek Coder V2 lite | 128k | 83.5% | 83.2% | 49.7% | 28.1% |

Nach Sprache

| Modellierung | HumanEval Python | HumanEval C++ | HumanEval Java | HumanEval Javascript | HumanEval Bash | HumanEval Typenskript | HumanEval C# | HumanEval (Durchschnitt) |

|---|---|---|---|---|---|---|---|---|

| Codestral-2501 | 86.6% | 78.9% | 72.8% | 82.6% | 43.0% | 82.4% | 53.2% | 71.4% |

| Codestral-2405 22B | 81.1% | 68.9% | 78.5% | 71.4% | 40.5% | 74.8% | 43.7% | 65.6% |

| Codellama 70B instruieren | 67.1% | 56.5% | 60.8% | 62.7% | 32.3% | 61.0% | 46.8% | 55.3% |

| DeepSeek Coder 33B instruieren | 77.4% | 65.8% | 73.4% | 73.3% | 39.2% | 77.4% | 49.4% | 65.1% |

| DeepSeek Coder V2 lite | 83.5% | 68.3% | 65.2% | 80.8% | 34.2% | 82.4% | 46.8% | 65.9% |

FIM (einzeilige exakte Übereinstimmung)

| Modellierung | HumanEvalFIM Python | HumanEvalFIM Java | HumanEvalFIM JS | HumanEvalFIM (Durchschnitt) |

|---|---|---|---|---|

| Codestral-2501 | 80.2% | 89.6% | 87.96% | 85.89% |

| Codestral-2405 22B | 77.0% | 83.2% | 86.08% | 82.07% |

| OpenAI FIM API* | 80.0% | 84.8% | 86.5% | 83.7% |

| DeepSeek Chat API | 78.8% | 89.2% | 85.78% | 84.63% |

| DeepSeek Coder V2 lite | 78.7% | 87.8% | 85.90% | 84.13% |

| DeepSeek Coder 33B instruieren | 80.1% | 89.0% | 86.80% | 85.3% |

FIM-Pass@1.

| Modellierung | HumanEvalFIM Python | HumanEvalFIM Java | HumanEvalFIM JS | HumanEvalFIM (Durchschnitt) |

|---|---|---|---|---|

| Codestral-2501 | 92.5% | 97.1% | 96.1% | 95.3% |

| Codestral-2405 22B | 90.2% | 90.1% | 95.0% | 91.8% |

| OpenAI FIM API* | 91.1% | 91.8% | 95.2% | 92.7% |

| DeepSeek Chat API | 91.7% | 96.1% | 95.3% | 94.4% |

- GPT 3.5 Turbo ist die neueste FIM-API von OpenAI.

Ab heute verfügbar

Codestral 25.01 wird über unsere IDE- und IDE-Plugin-Partner weltweit an Entwickler ausgeliefert. Sie können den Unterschied in der Reaktionsqualität und Geschwindigkeit der Code-Vervollständigung spüren, indem Sie Codestral 25.01 in Ihrem jeweiligen Modellselektor auswählen.

Für Unternehmensanwendungen, insbesondere solche, die eine Daten- und Modellresidenz erfordern, kann Codestral 25.01 lokal in Ihren Räumlichkeiten oder innerhalb einer VPC bereitgestellt werden.

Sehen Sie sich die Demo unten an, und fügen Sie die Weiter für eine kostenlose Testversion in VS Code oder JetBrains.

* :: Codestral 25.01 Chat-Demo

Ty Dunn, Mitbegründer von Continue, sagte: "Für KI-Code-Assistenten macht die Code-Vervollständigung den Großteil der Arbeit aus, was Modelle erfordert, die sich durch Fill-in-the-Middle (FIM) auszeichnen.Codestral 25.01 markiert einen bedeutenden Fortschritt in diesem Bereich. -- eine Schlüsselkomponente für eine genaue und effiziente Softwareentwicklung. Deshalb ist Codestral das Autocomplete-Modell, das wir Entwicklern empfehlen."

Um Ihre eigene Integration mit der Codestral-API zu erstellen, gehen Sie zu Die Plattform und mit codestral-latestDie API ist auch auf Vertex AI von Google Cloud verfügbar. Die API ist auch auf Vertex AI für Google Cloud verfügbar, in einer privaten Vorschau auf Azure AI Foundry und demnächst auf Amazon Bedrock. Codestral-Dokumentation.

Codestral 25.01 in LMsysKopilot Der Song landete auf Platz 1 der Arena-Charts. Wir können es kaum erwarten, von Ihren Erfahrungen zu hören!

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...