Claude 3.7 Sonnet Full Experience: Freie Kanäle, API-Details, Einschalten von Reasoning

Vor kurzem hat Anthropic Inc. Claude Ein Update für das Modell 3.5 Sonnet - Claude 3.7 Sonnet. Obwohl die Versionsnummer nur um 0,2 erhöht wurde, bringt dieses Update eine Reihe von Änderungen in Bezug auf Leistung und Funktionalität. Seit dem letzten Modell-Update von Claude sind mehr als vier Monate vergangen, was in dem sich schnell entwickelnden Bereich der künstlichen Intelligenz eine lange Zeit ist.

Es ist in der Branche allgemein anerkannt, dass Modelle in der Regel nicht direkt auf Version 4.0 aktualisiert werden, ohne dass ein architektonischer Durchbruch erfolgt.

Freier Zugang

| Name der Website | Adressen (einige erfordern einen wissenschaftlichen Internetzugang) | Modellversion | Inferenz-Modus | Kontextfenster (Token) | Maximaler Output (Token) | Netzwerkfunktion | Tägliche Obergrenzen/Kosten | Besonderheiten |

|---|---|---|---|---|---|---|---|---|

| Claude Offizielle Website | https://claude.ai/ | 3.7 Sonett | Inferenz | Ca. 32K | Ca. 8K | nicht unterstützt | Kostenlose Benutzer sind begrenzt, bezahlte Benutzer sind durch Token (Normal/Erweitert) begrenzt. | Die offizielle Plattform, mit einem kleinen Betrag für kostenlose Nutzer und einem Limit für bezahlte Nutzer. |

| lmarena | https://lmarena.ai/ | 3.7 Sonett/32k Denken | Nicht-Begründung/Begründung | 8K / 32K | 2K (max. 4K) | nicht unterstützt | Scheint unbegrenzt zu sein | Bietet sowohl einen Nicht-Inferenz- als auch einen 32k-Inferenz-Modus mit einstellbarer maximaler Token-Ausgabe. |

| Genspark | https://www.genspark.ai/ | 3.7 Sonett | Inferenz | nicht schlüssig | nicht schlüssig | etw. unterstützen | 5 kostenlose Sitzungen pro Tag | Unterstützt vernetzte Suchen für Szenarien, in denen Sie die aktuellsten Informationen benötigen. |

| Poe | https://poe.com/ | 3.7 Sonett/Denken | Nicht-Begründung/Begründung | 16K / 32K (max. 64K) | abstimmbar | nicht unterstützt | Tägliche Bonuspunkte, 3,7 Sonnet 333 Punkte pro Sitzung, Thinking 2367 Punkte pro Sitzung | Flexible Anpassung des Kontextfensters und der Ausgabelänge durch die Verwendung einer integrierten Systemsteuerung. Denkmodelle unterstützen größere Kontexte. |

| Cursor (auf Probe) | https://www.cursor.com/cn | 3.7 Sonett | nicht schlüssig | nicht schlüssig | nicht schlüssig | nicht unterstützt | nicht schlüssig | Integriert in den Code-Editor für die Bequemlichkeit der Entwickler. |

| OpenRouter | https://openrouter.ai/ | 3.7 Sonett/Denken/Online | Nicht-begründend / Begründend / Online | 200K | Einstellbar (bis zu 128K) | Unterstützung/Gebühren | drücken. Token Abrechnung, gleicher Preis bei verschiedenen Anbietern, Aufpreis für Online-Modelle | Es werden mehrere Modelle und Argumentationsmodi unterstützt, mit einer parametrisierten Maximalleistung von 128K. Denkmodelle unterstützen "full-blooded reasoning". Online-Modelle unterstützen die Vernetzung gegen zusätzliche Kosten. |

| OAIPro | (API-Schlüssel erforderlich) | 3.7 Sonett/Denken | Nicht-Begründung/Begründung | 64K / 200K | 4K (einstellbar) | nicht unterstützt | Abrechnung nach Token | Das Thinking-Modell schaltet automatisch die Inferenz ein, und das Inferenz-Token wird für max_tokens auf 80% gesetzt. |

| Studio Kirsche | (API-Schlüssel erforderlich) | 3.7 Sonett | Nicht-Begründung/Begründung | 200K | Einstellbar (bis zu 128K) | Unterstützung (erfordert Tavily Key) | Abrechnung nach Token + Tavily Anzahl der Anfragen (1000 kostenlose Anfragen pro Monat) | In Kombination mit der Tavily-API ermöglicht sie die vernetzte Suche. |

| NächsterChat | (API-Schlüssel erforderlich) | 3.7 Sonett | nicht schlüssig | nicht schlüssig | nicht schlüssig | Unterstützung (WebPilot-Plugin) | Freeware | Kombination WebPilot Das Plugin ermöglicht eine vernetzte Suche. |

Um Claude 3.7 Sonnet kostenlos zu testen, gibt es mehrere Möglichkeiten:

- Claude Offizielle Website::

- Zugangsadresse: (wissenschaftlicher Zugang erforderlich) https://claude.ai/

- FunktionalitätKostenlose Mitglieder haben Zugang zur Nicht-Inferenz-Version des Modells, die keine Netzwerkfunktionen unterstützt.

- lmarena::

- Zugangsadresse:: https://lmarena.ai/

- FunktionalitätBei der Option "direkter Chat" können Sie entweder die Nicht-Inferenz-Version oder die 32k-Inferenz-Version des Modells auswählen, die beide keine Vernetzung unterstützen. Die Eingabegrenze liegt bei 8k Token, die Standardausgabe bei 2k Token und die maximale Ausgabe kann durch Anpassung der Parameter 4k Token betragen.

- Einführung in lmarenaEine Plattform, die mehrere Large Language Modelling (LLM)-Arenen und direkte Chat-Funktionen bietet, mit denen Benutzer verschiedene Modelle vergleichen und testen können.

- Nicht-Inferenz-Version

- 32k Reasoning Edition

- Parameter für die maximale Ausgabe von Token (bis zu 4k)

- Max output tokens ErläuterungDieser Parameter wird verwendet, um die maximale Anzahl von Token festzulegen, die vom Modell in einem einzigen Durchgang erzeugt werden können.

- Genspark::

- Zugangsadresse: (wissenschaftlicher Zugang erforderlich) https://www.genspark.ai/

- FunktionalitätDie Reasoning-Version des Modells wird zur Verfügung gestellt, Networking wird unterstützt (überprüfen Sie "Search Web") und es gibt 5 kostenlose Konversationen pro Tag.

- Einführung in GensparkEine Plattform, die KI-Dienste anbietet, bei denen Benutzer mit einer Vielzahl von umfangreichen Sprachmodellen arbeiten können und die vernetzte Suchfunktionen unterstützen.

- Reasoning-Version, mit Internetzugang, 5 Mal pro Tag

- Poe::

- Zugangsadresse: (wissenschaftlicher Zugang erforderlich) https://poe.com/

- Funktionalität: 3000 Bonuspunkte pro Tag.

- Einführung in PoeEine von Quora ins Leben gerufene Plattform, die es den Nutzern ermöglicht, mit mehreren groß angelegten Sprachmodellen zu interagieren und eigene Bots zu erstellen.

- Modell Claude 3.7Verbraucht 333 Punkte, einstellbar über Schieberegler, unterstützt bis zu 16k Kontexte, keine Vernetzung.

- Klausel 3.7 Denkmodelle2367 Punkte verbraucht, einstellbar über Schieberegler, Standard 32k Kontext, max 64k.

- Standard 32k::

- Maximal 64k::

Es ist erwähnenswert, dass Poe's

Global per-message budgetEinstellung.

Diese Einstellung gibt an, wie viele Credits pro Gespräch maximal verbraucht werden dürfen. Der Standardwert ist 700; Poe warnt Sie, wenn eine Nachricht diesen Betrag überschreitet. Diese Einstellung gilt für alle Chats, oder Sie können das Budget für einen bestimmten Chat in den Chat-Einstellungen bearbeiten. Wenn das Budget zu niedrig eingestellt ist, können KI-Unterhaltungen fehlschlagen, da einige Modelle einen höheren Punkteverbrauch benötigen, um richtig zu funktionieren.

- Cursor (Probezeit)::

- Zugangsadresse:: https://www.cursor.com/cn

- FunktionalitätNetworking wird nicht unterstützt.

- Einführung in den CursorEin Code-Editor mit integrierter künstlicher Intelligenz, der Entwicklern hilft, Code effizienter zu schreiben und zu debuggen.

API-Verwendung

Für Entwickler bietet die Verwendung von Claude 3.7 Sonnet über die API mehr Flexibilität und Kontrolle.

- PreisePreise: Die Preise für die Sonnet-API Claude 3.7 sind die gleichen wie in Version 3.5, nämlich $3/Millionen Token für die Eingabe und $15/Millionen Token für die Ausgabe, sowie $0,3/Millionen Token für Cache-Lesevorgänge und $3,75/Millionen Token für Cache-Schreibvorgänge. Der Inferenzprozess zählt auch die Ausgabe-Token, so dass die tatsächliche Anzahl der Token und der Gesamtpreis höher sind als ohne Inferenz. Die Anzahl der Token und der Gesamtpreis sind höher als ohne Inferenz.

- KontextfensterWie bei Claude 3.5 Sonnet beträgt das gesamte Kontextfenster für die Claude 3.7 Sonnet API 200k Token.

- Erklärung des Kontextfensters: bezieht sich auf die Länge des Textes, den das Modell bei der Verarbeitung der Eingabe berücksichtigen kann.

- Token ErläuterungDie Grundeinheit eines Textes, die ein Wort, ein Zeichen oder ein Teilwort sein kann.

- maximale LeistungClaude 3.5 Sonnet API hat eine maximale Ausgabe von 8k Token, während Claude 3.7 Sonnet durch Setzen eines Parameters eine maximale Ausgabe von 128k Token hat.

Die API-Version des Big Model hat in der Regel ein größeres Kontextfenster und einen größeren maximalen Output als die Chat-Version, denn API-Nutzer zahlen für die tatsächliche Nutzung, und je mehr Input und Output, desto höher die Einnahmen des Dienstanbieters. Die Chat-Version hat in der Regel einen monatlichen Festpreis, d. h. je mehr Output Sie haben, desto mehr kostet es den Dienstanbieter.

hybrides Argumentationsmodell

Jetzt gibt es nur noch 3.7 seinhybrides ArgumentationsmodellSam sagte GPT4.5 ist die letzte Generation von nicht-inferentiellen Modellen, dieGPT5.0 zusammen mit o Die Serien wurden dann zusammengeführt, vermutlich ebenfalls mit einem hybriden Inferenzmodell.

Hybrid ist Inferenz und Nicht-Inferenz, unter Verwendung desselben Modells, wobei die API Parameter verwendet und die Chat-Version den Inferenz-Token-Verbrauch/Aufwand mit Schiebereglern oder Dropdown-Menüs usw. steuert.

Korrespondenz, die Argumentation Leistung ist direkt proportional zu den zugrunde liegenden Modell Leistung X Argumentation Zeit, das zugrunde liegende Modell Leistung ist anders zunächst nicht im Vergleich zu den Argumentation Zeit kann Benchmarking zur Messung der GPT, um die Weisheit der häufig verwendeten japanischen Gedichte und andere Themen als ein Beispiel für eine persönliche Prüfung.

Bei den folgenden Angaben handelt es sich um eine persönliche Schätzung, bei der nur das Verhältnis zwischen Zeit und Intelligenz berücksichtigt wurde. Nur zur Information

Bei R1 muss man sich weniger Gedanken über Token machen, da R1 kostenlos ist und die Leistung berücksichtigt werden muss, während die Kosten im Rahmen bleiben.

vorhanden. DeepSeek halten R1-niedrig Zusammenarbeit mit o3mini-med Das Warten auf einen Kampf sollte in der Tat eine stärkere Leistung sein, wenn ein größeres Inferenz-Token eröffnet wird

Ein weiterer Grund für die DeepSeek-Karte, der eindeutig nicht ausreicht, ist, dass die bisherige "System besetzt." Nach einem Monat ist es unwahrscheinlich, dass wir in naher Zukunft in der Lage sein werden, die Leistung wie o3mini und Claude zu steigern, indem wir die Zeit deutlich verlängern und die Anzahl der Token erhöhen, so dass die Kraft groß genug ist, um zu fliegen und die Rechenleistung gewaltig zu steigern.

aus demselben Grund Zwillinge Wie R1 ist es auch eine kostenlose Strategie, zuerst die Kosten zu kontrollieren, so dass die Denkmarke von Gemini 2.0 Flash Thinking auch die o3mini-niedrig Das Getriebe.

So stellen Sie die maximale Leistung von 128K ein

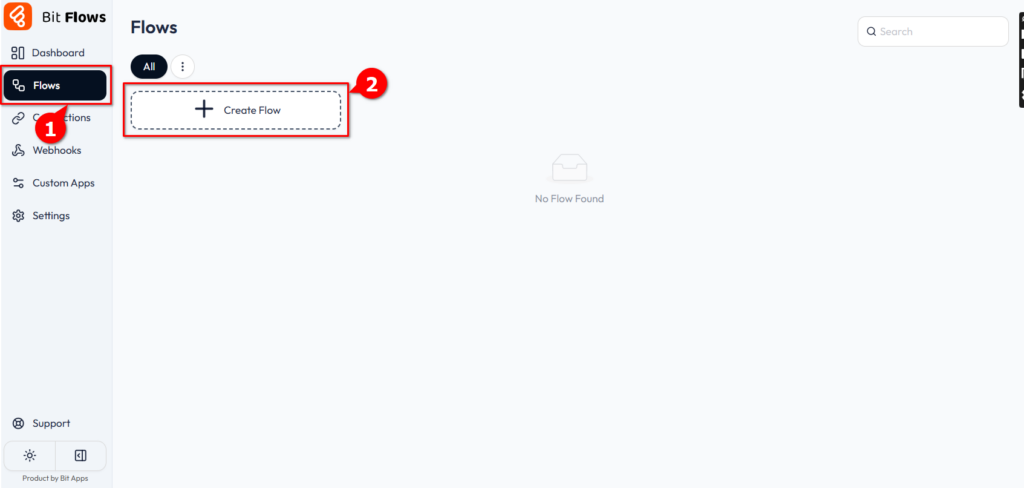

Cherry Studio + OpenRouter Einrichtungsmethode (nicht-referenziell)

Diese Methode ist für die Verwendung der Claude 3.7 Sonnet API über OpenRouter.

- Einführung in OpenRouterEine Plattform, die mehrere groß angelegte Sprachmodell-API-Aggregationsdienste bereitstellt.

- Über Cherry StudioEin clientseitiges Tool, das eine breite Palette von APIs für große Sprachmodelle unterstützt.

- Öffnen Sie Cherry Studio und fügen Sie einen Helfer hinzu oder bearbeiten Sie ihn.

- Fügen Sie unter "Modelleinstellungen" Folgendes hinzu

betaswählen Sie JSON als Datentyp für den Parameter:

["output-128k-2025-02-19"]

- erhöhen.

max_tokenswählen Sie für den Parametertyp Numerisch und setzen Sie den Wert auf 128000:

betasausmachenParameter, die zur Aktivierung bestimmter experimenteller Funktionen verwendet werden.max_tokensausmachenToken: Dient zur Festlegung der maximalen Anzahl von Token, die das Modell in einem einzigen Durchgang erzeugen kann.

Tests haben gezeigt, dass mit OpenRouter Ausgaben von mehr als 64K erreicht werden können, allerdings mit einer gewissen Wahrscheinlichkeit von Abbrüchen. Dies kann auf eine Instabilität des Netzwerks oder auf Einschränkungen des Modells selbst zurückzuführen sein.

OpenRouter-Setup-Methode (120K vollmundige Begründungen)

Diese Methode funktioniert nur mit dem Modell Claude-3.7-Sonnet:Thinking für OpenRouter.

- Öffnen Sie Cherry Studio und fügen Sie einen Helfer hinzu oder bearbeiten Sie ihn.

- Fügen Sie unter "Modelleinstellungen" Folgendes hinzu

betaswählen Sie JSON als Datentyp für den Parameter:["output-128k-2025-02-19"] - erhöhen.

thinkingParameter, wählen Sie JSON als Parametertyp und setzen Sie den Wert auf:{"type": "enabled", "budget_tokens": 1200000}thinkingausmachenParameter, mit denen der Inferenzmodus aktiviert und das Inferenzbudget festgelegt wird.

- Setzen Sie die Modelltemperatur auf 1. Andere Temperaturwerte können zu ungültigen Schlussfolgerungen führen.

- erhöhen.

max_tokensmit einem Wert von 128000 (der Mindestwert ist 1024, der um einige K größer sein muss als das Inferenzbudget, das für die endgültige Ausgabe übrig bleibt):

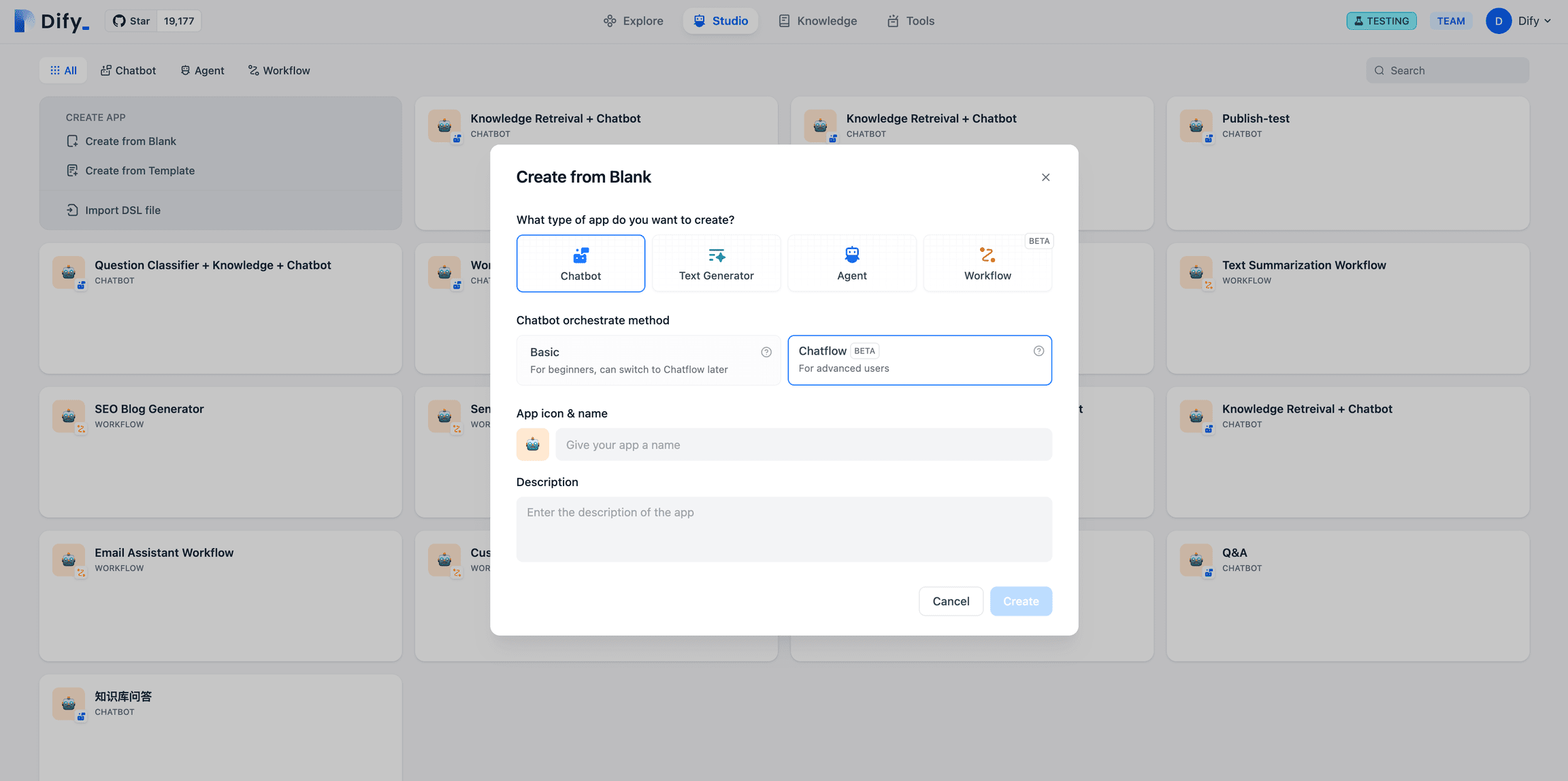

Offene WebUI + offizielle API oder oaipro Setup-Methode (120K+ vollmundige Begründungen)

- Einführung in Open WebUIEine quelloffene, selbst gehostete Weboberfläche für die Sprachmodellierung in großem Maßstab.

- Einführung in oaiproEine Plattform, die Claude API Proxy-Dienste anbietet.

passieren (eine Rechnung oder Inspektion etc.) WebUI öffnen (in Form eines Nominalausdrucks) pipe Funktionelle Änderungen headerDie Ausgabe von Claude 3.7 128K kann von jedem API-Standort aus erreicht werden.

pipeausmachenOpen WebUI: Eine Funktion von Open WebUI, die es Benutzern ermöglicht, Anfrage-Header zu ändern.headerausmachenHTTP-Request-Header, der Metadaten über die Anfrage enthält.

Die Inferenz kann auf maximal 127999 eingestellt werden, weil:

Gesamtkontext 200K (fest) - Maximale Ausgabe 128K (einstellbar) = Maximale verbleibende Eingabe 72K

Maximale Ausgabe 128K (konfigurierbar) - Gedankenkette 120K (konfigurierbar) = Endausgabe Rest 8K

So überprüfen Sie, ob der Argumentationsmodus aktiviert ist

Es ist möglich, komplexere Fragen zu stellen. Wenn der Denkmodus eingeschaltet ist, denkt Cherry Studio einige Sekunden bis Minuten lang nach, ohne dass eine Ausgabe erfolgt. Derzeit ist Cherry Studio noch nicht für die Anzeige des Denkprozesses angepasst.

Probieren Sie zum Beispiel die folgenden Fragen aus (die ohne Nachdenken in der Regel nicht zur richtigen Antwort führen, mit Nachdenken ein paar Minuten dauern und in den meisten Fällen richtig sind):

richtige Antwort:

Vor- und Nachteile eines großen Outputs

Blickwinkel::

- Es ist möglich, einen Teil der Arbeit der Intelligenzen zu ersetzen. Während zum Beispiel bei der Übersetzung eines Buches früher ein intelligenter Körper die Kapitel aufteilen musste, kann er jetzt direkt das ganze Buch bearbeiten.

- Mögliche Kosteneinsparungen. Wenn Sie die Kapitel nicht aufteilen und den gesamten Text direkt eingeben, können Sie jedes Mal 8K ausgeben und 16 Mal wiederholen, um eine Ausgabe von 128K zu erreichen. Obwohl die Ausgabekosten die gleichen sind, muss der Originaltext nur einmal eingegeben werden, was die Kosten von 15 Eingaben spart.

- Mit einer vernünftigen Eingabestrategie können Sie die Kosten drastisch senken, die Effizienz verbessern und sogar die Verarbeitungsgeschwindigkeit erhöhen.

- Über 100.000 Wörter +, kann ein ganzes Buch Übersetzung, ein Buch schreiben, um einen Web-Artikel zu schreiben, vor und nach der Konsistenz ist gut, wird nicht auf der Rückseite zu schreiben, um die Front zu vergessen, kann theoretisch eine einmalige Ausgabe von 3,5 16-mal die Menge an Code, die stark verbessert die Rechenleistung und Effizienz.

Nachteile::

- Die Leistung aller großen Modelle nimmt mit zunehmendem Kontext ab, wobei das genaue Ausmaß des Abfalls noch zu bewerten ist.

- 128K-Einzelausgaben sind kostspielig. Testen Sie daher das Cue-Wort sorgfältig, bevor Sie zu einer großen Ausgabe übergehen, um Fehler zu vermeiden, die zu Abfall führen könnten.

API-Vernetzung

Die offizielle Claude-API selbst unterstützt keine Vernetzung:

- CherryStudio + Tavily API-Schlüssel: 1000 kostenlose Verbindungen pro Monat.

- Über TavilyEine Plattform, die Such-API-Dienste anbietet.

Methode: Aktualisieren Sie auf die neueste Version 1.0 von CherryStudio, registrieren Sie sich auf tavily.com und beantragen Sie einen kostenlosen API-Schlüssel:

Geben Sie den API-Schlüssel in die Einstellungen von Cheery ein und aktivieren Sie die Schaltfläche Networking in der Question Box:

- NächsterChat + WebPilot PluginFreie Vernetzung.

- Über NextChatEine Chat-Plattform, die mehrere große Sprachmodelle und Plugins unterstützt.

- Einführung in WebPilotEin Plugin, das Funktionen zur Extraktion und Zusammenfassung von Webinhalten bietet.

- OpenRouter-ChatroomEr verfügt über eine eigene Netzwerkschaltfläche. So geht's: Loggen Sie sich in Chatroom | OpenRouter ein, wählen Sie das Modell 3.7 Sonnet und markieren Sie die Netzwerkschaltfläche im Fragefeld:

- OpenRouter verfügt über NetzwerkfunktionenMethode: Manuelle Eingabe des Modellnamens beim Hinzufügen eines Modells

anthropic/claude-3.7-sonnet:onlineDie Kosten für das Programm belaufen sich auf 4 Dollar pro 1.000 Anfragen.

Andere API-bezogene Informationen

- Offizielle API::

- Eingänge:: https://www.anthropic.com/api

- Mindestaufladung von $5.

- Die Einstellung über Cherry-Parameter wird nicht unterstützt.

betasAktiviert die 128K-Ausgabe. - Tier 1 hat eine Inputgrenze von 20.000 tpm und eine Outputgrenze von 8.000 tpm.

- Eingänge:: https://www.anthropic.com/api

- OpenRouter-API::

- Eingänge:: https://openrouter.ai/anthropic/claude-3.7-sonnet

- Bietet die Modelle Claude-3.7-Sonnet, Claude-3.7-Sonnet Thinking und Claude-3.7-Sonnet Beta.

- Unterstützung für Claude-3.7-Sonnet Online oder Claude-3.7-Sonnet Thinking Online, mit Vernetzung, ist für einen Aufpreis von $4 pro tausend Abfragen erhältlich.

- Es gibt drei Anbieter: Anthropic, Amazon und Google mit demselben Preis.

- Die maximale Ausgabe für Google-Anbieter beträgt nur 64K, Anthropic und Amazon können auf 128K parametriert werden.

- Eingänge:: https://openrouter.ai/anthropic/claude-3.7-sonnet

- OAIPro API::

- Einführung in oaiproEine Plattform, die Claude API Proxy-Dienste anbietet.

- Voreingabe 64K, Gedankenkette + Endausgabe 4K.

- Die Einstellung über Cherry-Parameter wird nicht unterstützt.

betasAktiviert die 128K-Ausgabe. Wenn Sie nicht hinzufügenmax_tokensParameter ist die Standardausgabe 4K. - Claude-3-7-Sonnet-20250219-Denkmodell: Die Inferenz wird direkt eingeschaltet, es werden keine zusätzlichen Parameter benötigt, und das Inferenz-Token muss zwingend ein

max_tokens80%, scheint es nicht möglich zu sein, diethinkingParameter. - Claude-3-7-Sonnet-20250219 Modell: kann manuell angegeben werden

thinkingParameter.

- günstiges Transitzentrum::

- aicnnGewöhnlicher Ertrag: etwa 72 $/Million Token.

- aicnn EinführungEine Plattform für die Bereitstellung von KI-Diensten, einschließlich API-Relay.

- Hinweis: Einige preiswerte Transitstationen unterstützen möglicherweise nur 64K-Ausgabe, nicht 128K.

- aicnnGewöhnlicher Ertrag: etwa 72 $/Million Token.

Chat-Version

Kostenlose Mitgliedschaft

Es ist möglich, Claude 3.7 Sonnet zu verwenden, aber es gibt einige Einschränkungen bei der Verwendung. Gemäß der Anthropisch In der Vergangenheit war die Zahl der kostenlosen Nutzer vielleicht nicht sehr hoch.

Darüber hinaus ist das Modell Claude 3.5 Haiku jetzt für kostenlose Mitglieder nicht mehr verfügbar.

- KontextfensterGemessen werden etwa 32K.

- maximale LeistungGemessen werden etwa 8K.

- schlüssellose

zahlendes Mitglied

Das Kontextfenster und die maximale Ausgabe der kostenpflichtigen Chat-Version sind noch nicht sicher, ob sie mit der kostenlosen Version identisch sind.

Die kostenpflichtige Version bietet sowohl den normalen als auch den erweiterten Denkmodus. Es ist jedoch zu beachten, dass die Gefahr besteht, dass bezahlte Konten gesperrt werden. Es ist ratsam, Ihre Mitgliedschaft aufzuladen, bevor Sie sicherstellen, dass Sie eine einwandfreie IP-Adresse haben. Im Vergleich dazu ist es sicherer, die API zu verwenden.

Das Nutzungslimit für Claude-Mitglieder basiert nicht auf der Anzahl der Fragen, wie bei GPT oder Grok, sondern auf der Gesamtzahl der Token. Dies hat zur Folge, dass die Verwendung des Reasoning-Modus, insbesondere des erweiterten Modus, die Anzahl der Fragen, die pro Tag gestellt werden können, erheblich reduziert. Einige Nutzer haben verraten, dass Anthropic möglicherweise eine kostenpflichtige Rücksetzung des Nutzungslimits einführt, die es den Nutzern ermöglicht, die Bedenkzeit gegen eine einmalige Gebühr zu überspringen.

Funktionalität

- Hochladen von DateienUnterstützt bis zu 20 Dateien mit einer maximalen Größe von 30 MB pro Datei.

- multimodalUnterstützt Bilderkennung, keine Sprach- oder Videoerkennung.

- GitHubNeue Funktion, die eine Verbindung mit dem GitHub-Repository eines Benutzers herstellt, um Dateien hochzuladen.

- Claude CodeEin offizielles Kommandozeilen-Tool für Entwickler, das derzeit als begrenzte Forschungsvorschau veröffentlicht wird. Das Tool unterstützt die Codesuche, das Lesen, Bearbeiten, Ausführen von Tests, GitHub-Commits und Befehlszeilenoperationen. Es soll die Entwicklungszeit verkürzen und die Effizienz der testgetriebenen Entwicklung und der Fehlersuche bei komplexen Problemen verbessern.

- Vernetzung, Tiefe Suche, Tiefe Forschung, Sprachmodellierung, Vincennes-Graphen: Wie Claude Version 3.5, nicht unterstützt.

Modell-Review

Programmierkenntnisse

Code-Kompetenz war schon immer eine Stärke des Claude-Modells und ein wichtiges Anliegen für seine Hauptnutzergruppe, die Programmierer. Wenn die Codekompetenz abnimmt, könnte Claude vor einer ernsthaften Herausforderung stehen.

- Lmarena: webdev Rating Leader. Referenz: https://lmarena.ai/?leaderboard

- LivebenchClaude 3.7, die Version ohne Argumentation, hat kleinere Verbesserungen im Vergleich zu Version 3.5, und die Version mit Argumentation hat größere Verbesserungen, aber mit einem entsprechenden Anstieg der Kosten (gleicher Stückpreis, höherer Output Token). Referenz: https://livebench.ai/

- Einführung in Livebench:: Eine Plattform zur kontinuierlichen Bewertung der Leistung großer Sprachmodelle.

- AiderClaude 3.7: Der Inferenzmodus kostet etwa 2,5 Mal so viel wie die Version 3.5.

- Einführung in AiderEin KI-Programmierassistent, der Entwicklern bei der Codegenerierung und beim Debugging hilft.

Referenz: https://aider.chat/docs/leaderboards/

- CodeParrot AIClaude 3.7 schneidet im HumanEval Coding Benchmark mit 92,1 Punkten gut ab, eine Verbesserung gegenüber Claude 3.5 (89,4).

- Einführung in CodeParrot AIEine Plattform, die eine Reihe von Kodierwerkzeugen zur Optimierung des Entwicklungsprozesses bietet.

Intelligenter Einsatz von Körperwerkzeugen

Anthropic behauptet offiziell, dass Claude 3.7 sich durch die Verwendung von intelligenten Körperwerkzeugen auszeichnet.

mathematische Fähigkeiten

Claude 3,7 Normal ist durchschnittlich in Mathematik, Reasoning schneidet besser ab.

logisches Denkvermögen

Marktleistung

Google Suche Hitze::

Google PlayClaude App ist auf Platz #107 der US-Charts.

App-Store: Nicht in die Top 200 gekommen.

Zusammenfassung und Ausblick

Die Veröffentlichung von Claude 3.7 Sonnet markiert eine weitere Iteration von Anthropic im Bereich der großen Modelle. Trotz der geringfügigen Änderung der Versionsnummer bietet sie Verbesserungen bei der Codegenerierung, den Inferenzmöglichkeiten und der umfangreichen kontextbezogenen Ausgabe. Claude steht jedoch immer noch vor Herausforderungen in Bezug auf den begrenzten Zugang für freie Nutzer, fehlende Netzwerkfunktionen und die Marktleistung.

Ausgehend von der bisherigen Aktualisierungsrate von Anthropic könnte es noch einige Zeit dauern, bis Claude 4.0 veröffentlicht wird.Claudes allgemeine Wachstumsrate, insbesondere auf der C-Suite (Verbraucherseite), liegt deutlich hinter der seiner Konkurrenten zurück. Seine Bewertung wurde von xAI übertroffen.

Dem derzeitigen Trend zufolge könnte Claude von GPT, DeepSeek und Gemini aus der ersten Reihe der großen globalen Modelle verdrängt werden. In Zukunft könnte Claude mit Modellen wie Grok und Beanbag um die Position in der zweiten Reihe konkurrieren oder sich ganz vom C-End-Markt verabschieden und sich auf vertikale Bereiche wie Programmierung, Intelligenz und Schreiben konzentrieren.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...