Chinesischer Vollblut-DeepSeek-R1-Destillationsdatensatz, unterstützt chinesischen R1-Destillations-SFT-Datensatz

Allgemeine Einführung

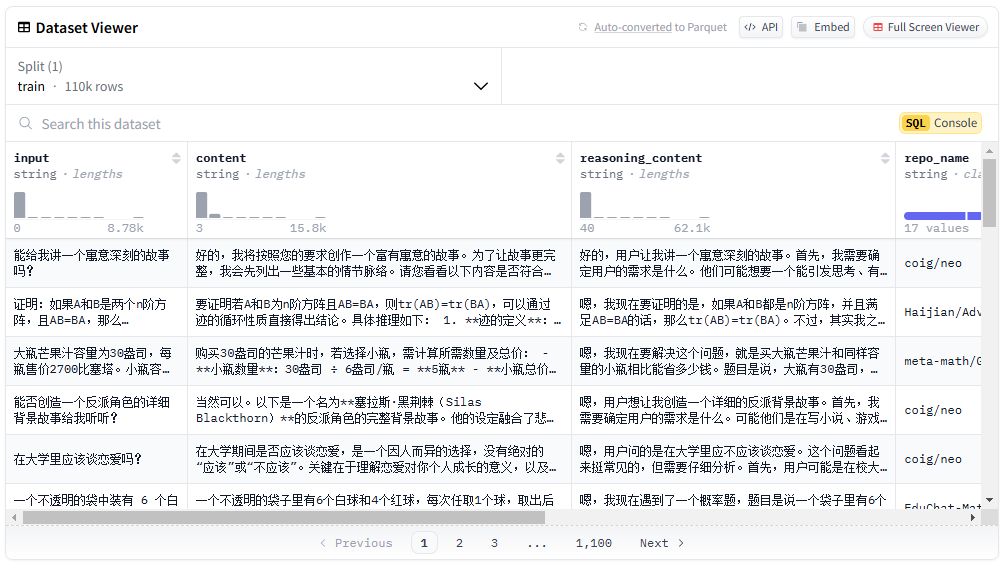

Der chinesische DeepSeek-R1-Destillationsdatensatz ist ein chinesischer Open-Source-Datensatz mit 110.000 Daten, der zur Unterstützung der Forschung im Bereich des maschinellen Lernens und der Verarbeitung natürlicher Sprache entwickelt wurde. Der Datensatz wird vom Liu Cong NLP-Team veröffentlicht und enthält nicht nur mathematische Daten, sondern auch eine große Anzahl allgemeiner Datentypen wie logische Schlussfolgerungen, Xiaohongshu, Zhihu usw. Der Destillationsprozess des Datensatzes wird streng nach den Angaben des offiziellen DeepSeek-R1 durchgeführt, um die hohe Qualität und Vielfalt der Daten zu gewährleisten. Die Nutzer können den Datensatz auf den Plattformen Hugging Face und ModelScope kostenlos herunterladen und nutzen.

Funktionsliste

- Vielfältige Datentypen: Enthält Mathematik, logisches Denken, allgemeine Datentypen usw.

- Hochwertige Daten: Destilliert in strikter Übereinstimmung mit den offiziellen Angaben von DeepSeek-R1.

- frei und quelloffenBenutzer können es kostenlos auf den Plattformen Hugging Face und ModelScope herunterladen.

- Unterstützt mehrere AnwendungenAnwendbar auf ein breites Spektrum von Forschungsbereichen wie maschinelles Lernen und natürliche Sprachverarbeitung.

- Detaillierte DatenverteilungDetaillierte Kategorisierung der Daten und quantitative Informationen.

Hilfe verwenden

Einbauverfahren

- Besuchen Sie die Plattformen Hugging Face oder ModelScope.

- Suchen Sie nach "Chinese-DeepSeek-R1-Distill-data-110k".

- Klicken Sie auf den Download-Link und wählen Sie das entsprechende Format zum Herunterladen.

Verwendung

- Laden von Datensätzen: in der Python-Umgebung

datasetsDie Bibliothek lädt den Datensatz.

from datasets import load_dataset

dataset = load_dataset("Congliu/Chinese-DeepSeek-R1-Distill-data-110k")

- Daten anzeigen: Verwendung

datasetObjekte zeigen grundlegende Informationen und Muster des Datensatzes an.

print(dataset)

print(dataset['train'][0])

- Vorverarbeitung der DatenVorverarbeitung der Daten entsprechend dem Forschungsbedarf, z. B. Worttrennung und Entdopplung.

from transformers import BertTokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

tokenized_data = dataset.map(lambda x: tokenizer(x['text'], padding='max_length', truncation=True))

- ModellschulungModelltraining unter Verwendung vorverarbeiteter Daten.

from transformers import BertForSequenceClassification, Trainer, TrainingArguments

model = BertForSequenceClassification.from_pretrained('bert-base-chinese')

training_args = TrainingArguments(output_dir='./results', num_train_epochs=3, per_device_train_batch_size=16)

trainer = Trainer(model=model, args=training_args, train_dataset=tokenized_data['train'])

trainer.train()

Ausgewählte Funktionen Bedienung Ablauf

- Mathematische DatenverarbeitungFür mathematische Daten fügen Sie die Aufforderung "Bitte begründen Sie Schritt für Schritt und tragen Sie die endgültige Antwort in den Kasten {} ein" ein.

def add_math_prompt(example):

example['text'] = "请一步步推理,并把最终答案放到 \\boxed {}。" + example['text']

return example

math_data = dataset.filter(lambda x: x['category'] == 'math').map(add_math_prompt)

- Logisches Denken DatenverarbeitungSpezielle Behandlung von Daten für logische Schlussfolgerungen, um logische und konsistente Daten zu gewährleisten.

def process_logic_data(example):

# 自定义逻辑处理代码

return example

logic_data = dataset.filter(lambda x: x['category'] == 'logic').map(process_logic_data)© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...