Der Chinchilla-Moment und der o3-Moment: Die Entwicklung des Skalengesetzes für große Sprachmodelle

Schnelles Lesen des Artikels

Dieser Artikel bietet einen umfassenden und detaillierten Einblick in die Vergangenheit und Gegenwart des Skalierungsgesetzes für große Sprachmodelle (LLMs) und die zukünftige Richtung der KI-Forschung. Mit klarer Logik und reichhaltigen Beispielen führt der Autor Cameron R. Wolfe den Leser von den grundlegenden Konzepten bis hin zur Spitzenforschung und vermittelt so ein umfassendes Bild des KI-Bereichs. Im Folgenden finden Sie eine Zusammenfassung und einen Kommentar zum Kerninhalt des Artikels und den Standpunkten des Autors:

1. die Ursprünge und die Entwicklung des Skalengesetzes: von GPT bis Chinchilla

- Die Autoren stellen einleitend fest, dass das Gesetz der Skalierung die zentrale Triebkraft für die Entwicklung großer Sprachmodelle ist. Durch die Einführung des grundlegenden Konzepts des Potenzgesetzes erklären die Autoren, wie der Testverlust eines großen Sprachmodells abnimmt, wenn die Modellparameter, die Größe des Datensatzes und der Rechenaufwand steigen.

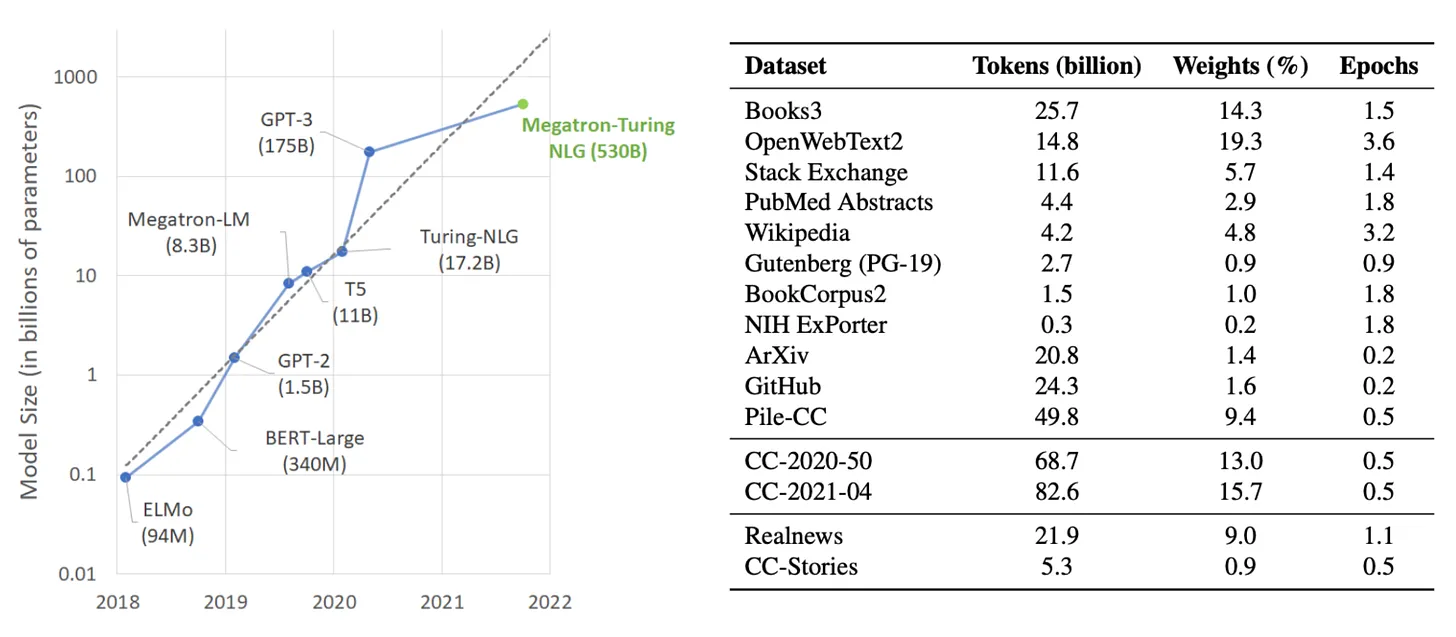

- Die Autoren werfen einen Blick auf die Entwicklung der GPT-Modellfamilie und demonstrieren anschaulich die Anwendung der Skalengesetze in der Praxis. Vom frühen GPT und GPT-2 über das bahnbrechende GPT-3 bis hin zum geheimnisvollen GPT-4 hat OpenAI stets an der Strategie festgehalten, "aus großen Anstrengungen Wunder zu machen", und hat die Obergrenze der Fähigkeiten der großen Sprachmodelle ständig aufgefrischt. Der Artikel beschreibt im Detail die wichtigsten Innovationen, Versuchsaufbauten und Leistungen der einzelnen Modelle und weist darauf hin, dass die Entwicklung von GPT-3 den Übergang von einem spezialisierten Modell zu einem Allzweck-Basismodell des großen Sprachmodells markiert und eine neue Ära der KI-Forschung einleitet.

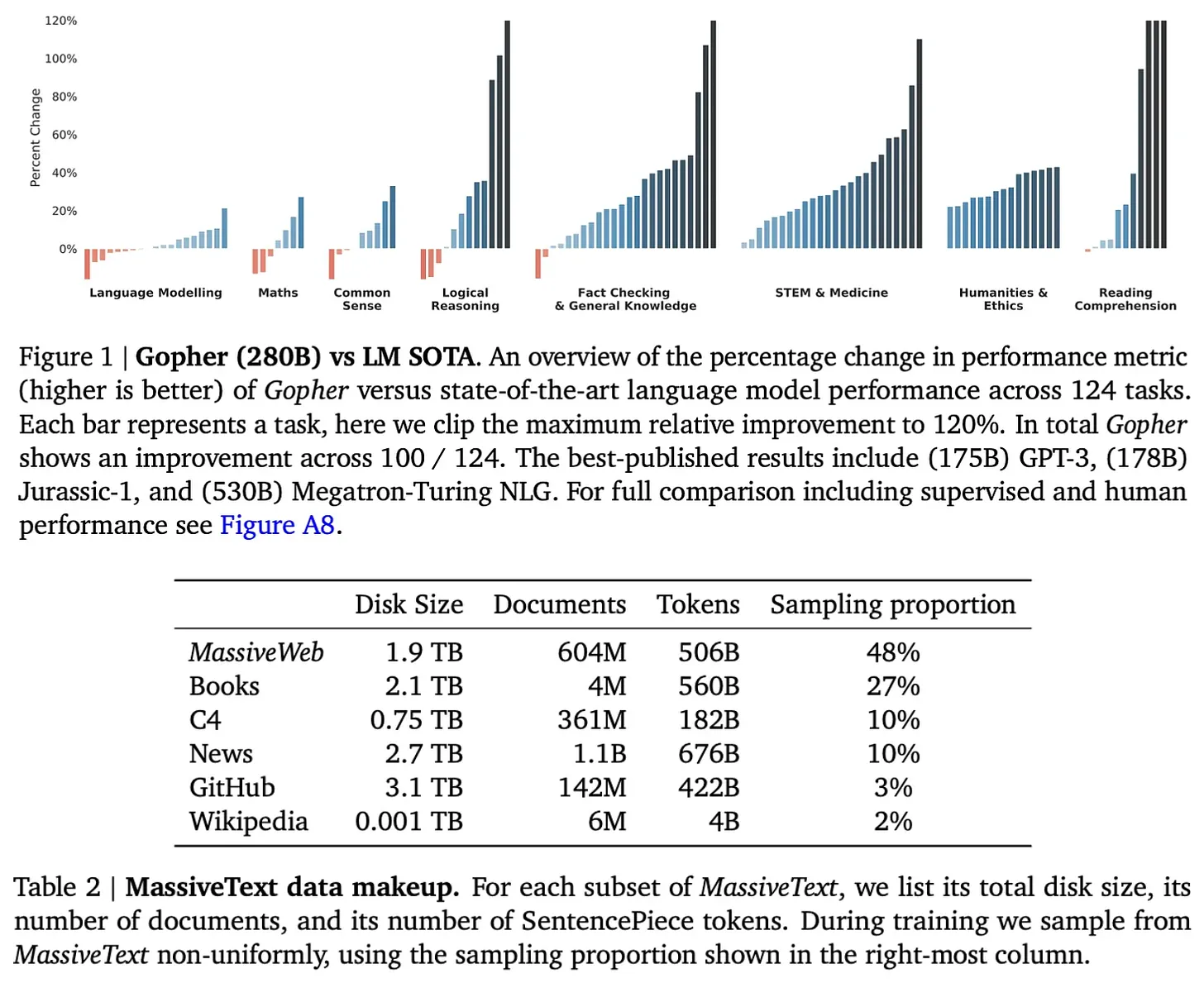

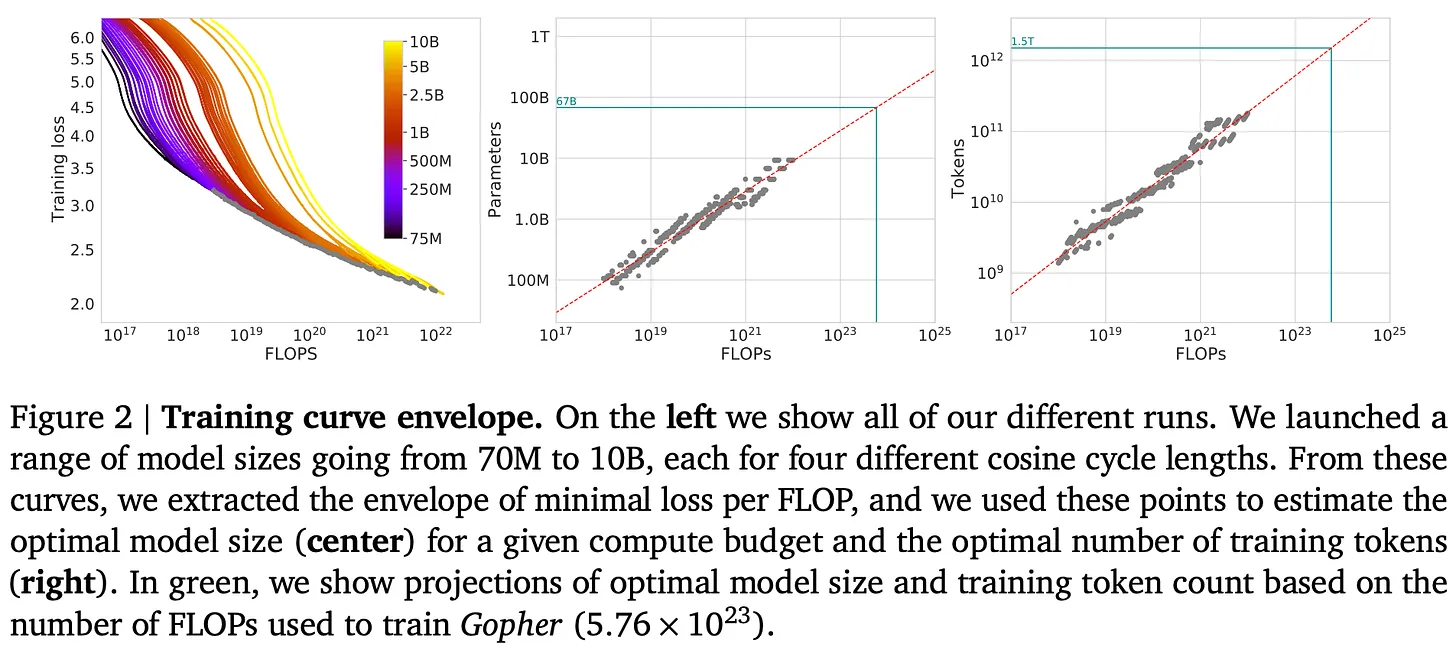

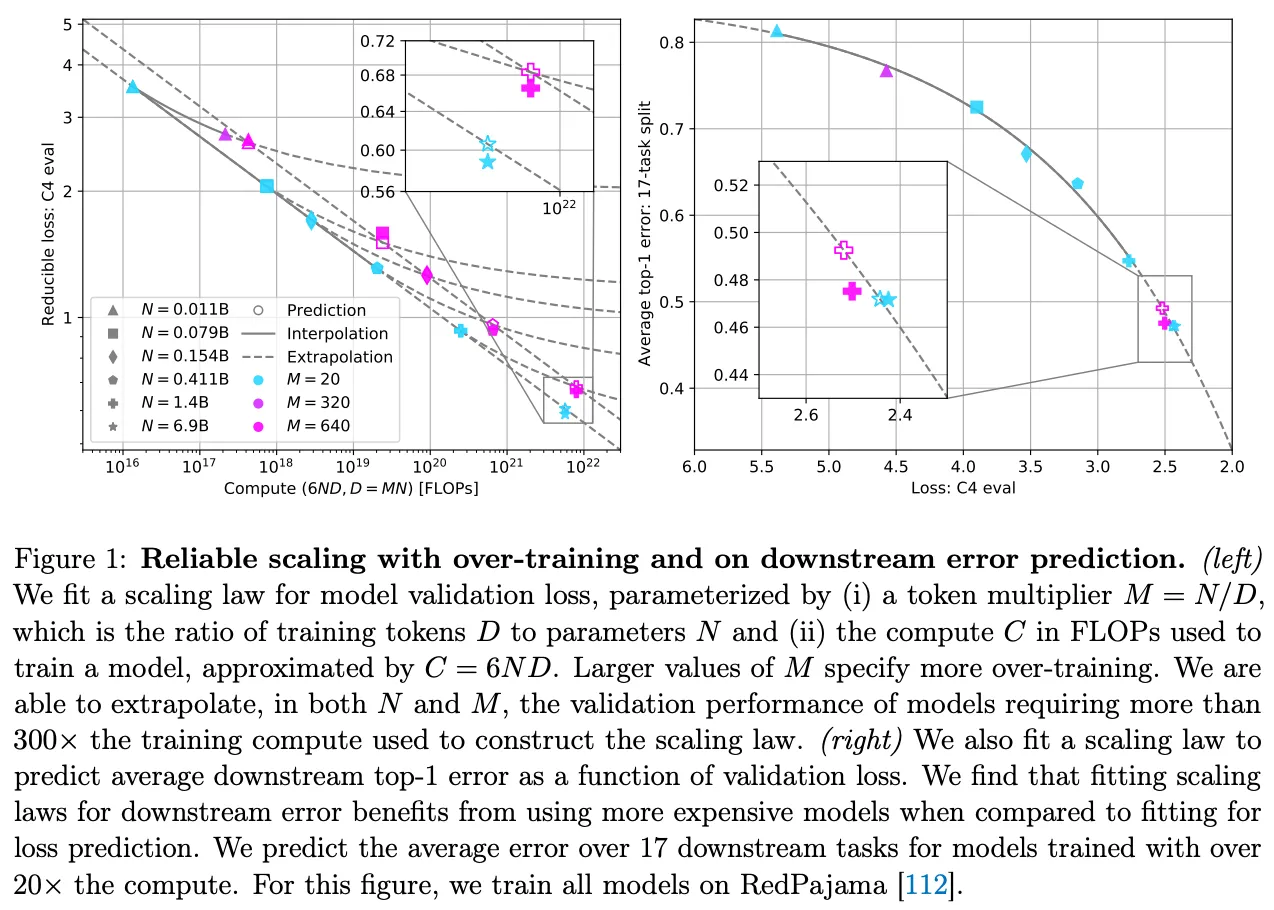

- Die Autoren plädieren nicht blind für "größer ist besser", sondern analysieren rational das vom Chinchilla-Modell vorgeschlagene Gesetz der "rechnerisch optimalen" Größe. Die Forschungen von DeepMind haben gezeigt, dass frühere Modelle in der Regel "untertrainiert" waren, d. h. der Datensatz war im Verhältnis zur Modellgröße zu klein. Der Erfolg von Chinchillas Modell hat gezeigt, dass eine angemessene Vergrößerung des Datensatzes bei gleichem Rechenaufwand effektiver sein kann als eine Vergrößerung des Modells. Diese Erkenntnis hatte tiefgreifende Auswirkungen auf das Training nachfolgender großer Sprachmodelle.

Kommentar: Die Autoren geben eine ausführliche Einführung in das Skalengesetz mit theoretischen Erklärungen und Beispielen, so dass auch Nicht-Fachleute die Kerngedanken verstehen können. Durch einen Rückblick auf die Entwicklung der GPT-Modellreihe verknüpfen die Autoren das abstrakte Skalengesetz mit der konkreten Modellentwicklung, was die Lesbarkeit und Überzeugungskraft des Artikels erhöht. Die Analyse des Chinchilla-Modells zeigt, dass der Autor nicht blind für Skalierung plädiert, sondern den Leser zum Nachdenken darüber anregen will, wie er seine Computerressourcen effizienter nutzen kann.

2. das "Ende" des Gesetzes der Größe: Fragen und Überlegungen

- Der zweite Teil des Artikels befasst sich mit der jüngsten Infragestellung des Skalenprinzips in der KI. Die Autoren zitieren mehrere Medienberichte, die darauf hindeuten, dass sich die Branche zu fragen beginnt, ob das Gesetz der Skalierung an seine Grenzen gestoßen ist, da sich die Geschwindigkeit der Modellverbesserung verlangsamt. Gleichzeitig zitieren die Autoren Brancheninsider wie Dario Amodei und Sam Altman, die das Gegenteil behaupten und darauf hinweisen, dass die Skalierung immer noch eine wichtige Triebkraft für den KI-Fortschritt ist.

- Die Autoren stellen fest, dass die "Verlangsamung" des Skalengesetzes bis zu einem gewissen Grad erwartet wurde. Das Skalengesetz selbst sagt voraus, dass mit zunehmender Größe die Schwierigkeit, die Leistung zu verbessern, exponentiell zunimmt. Darüber hinaus betonen die Autoren, wie wichtig es ist, "Leistung" zu definieren. Eine Verringerung des Testverlusts ist nicht unbedingt gleichbedeutend mit einer Steigerung der Fähigkeiten des Big Language Model, und die Erwartungen der Industrie an das Big Language Model sind sehr unterschiedlich.

- "Datenengpässe" sind eines der Themen, auf die sich die Autoren konzentrieren. Das Chinchilla-Modell und nachfolgende Studien haben die Bedeutung des Datenumfangs hervorgehoben, aber die begrenzte Verfügbarkeit von qualitativ hochwertigen Daten im Internet könnte sich als Engpass für die weitere Entwicklung von Big-Language-Modellen erweisen.

Kommentar: Dieser Abschnitt beweist das kritische Denken und den scharfen Blick des Autors für die Branche. Anstatt die Kontroverse zu vermeiden, stellen die Autoren objektiv die Ansichten verschiedener Parteien dar und analysieren die möglichen Gründe für die "Verlangsamung der Skalierung" aus technischer Sicht. Besonders wichtig ist der Hinweis des Autors auf "Datenengpässe", die nicht nur eine echte Herausforderung für die Entwicklung großer Sprachmodelle darstellen, sondern auch eine Richtung für die künftige Forschung aufzeigen.

3. die Zukunft der KI-Forschung: jenseits des Vortrainings

- Der letzte Teil des Artikels befasst sich mit zukünftigen Richtungen in der KI-Forschung, wobei der Schwerpunkt auf großen Sprachmodellsystemen/Agenten und Inferenzmodellen liegt.

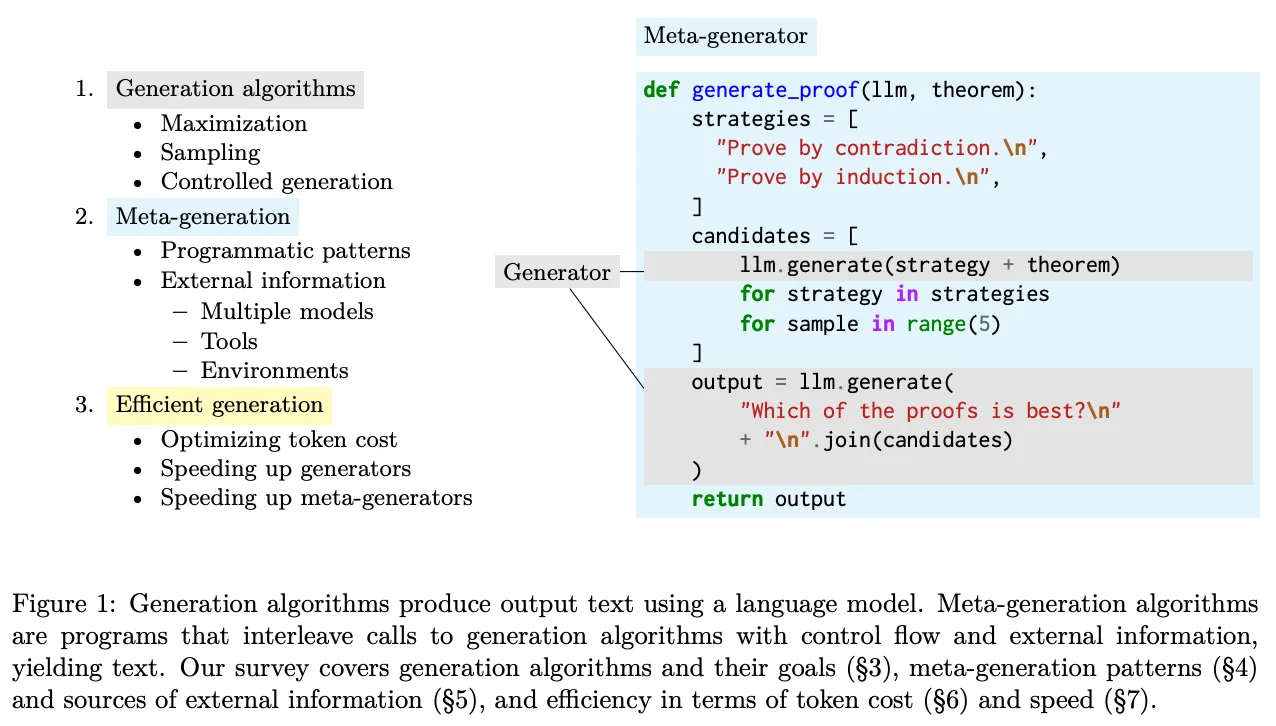

- Die Autoren argumentieren, dass wir die Fähigkeiten der KI durch den Aufbau komplexer Systeme mit großen Sprachmodellen immer noch verbessern können, selbst wenn die Zunahme der Größe der vortrainierten Modelle auf einen Engpass trifft. Der Artikel beschreibt die beiden Hauptstrategien der Aufgabenzerlegung und -verknüpfung und verwendet Buchzusammenfassungen als Beispiel dafür, wie komplexe Aufgaben in Teilaufgaben zerlegt werden können, die von großen Sprachmodellen hervorragend bewältigt werden können.

- Die Autoren erörtern auch die Aussichten für die Anwendung von Big Language Models in der Produktentwicklung und weisen darauf hin, dass die Entwicklung wirklich nützlicher Big Language Model-Produkte eine wichtige Richtung der aktuellen KI-Forschung darstellt. Der Artikel hebt insbesondere das Konzept des Agenten hervor, das die Anwendungsszenarien großer Sprachmodelle erweitert, indem es ihnen die Möglichkeit gibt, Werkzeuge zu nutzen. Die Autoren weisen jedoch auch auf die Herausforderungen hin, die sich beim Aufbau komplexer großer Sprachmodellierungssysteme in Bezug auf die Robustheit stellen, und stellen Forschungsrichtungen vor, um die Zuverlässigkeit des Systems durch verbesserte Meta-Generierungsalgorithmen zu verbessern.

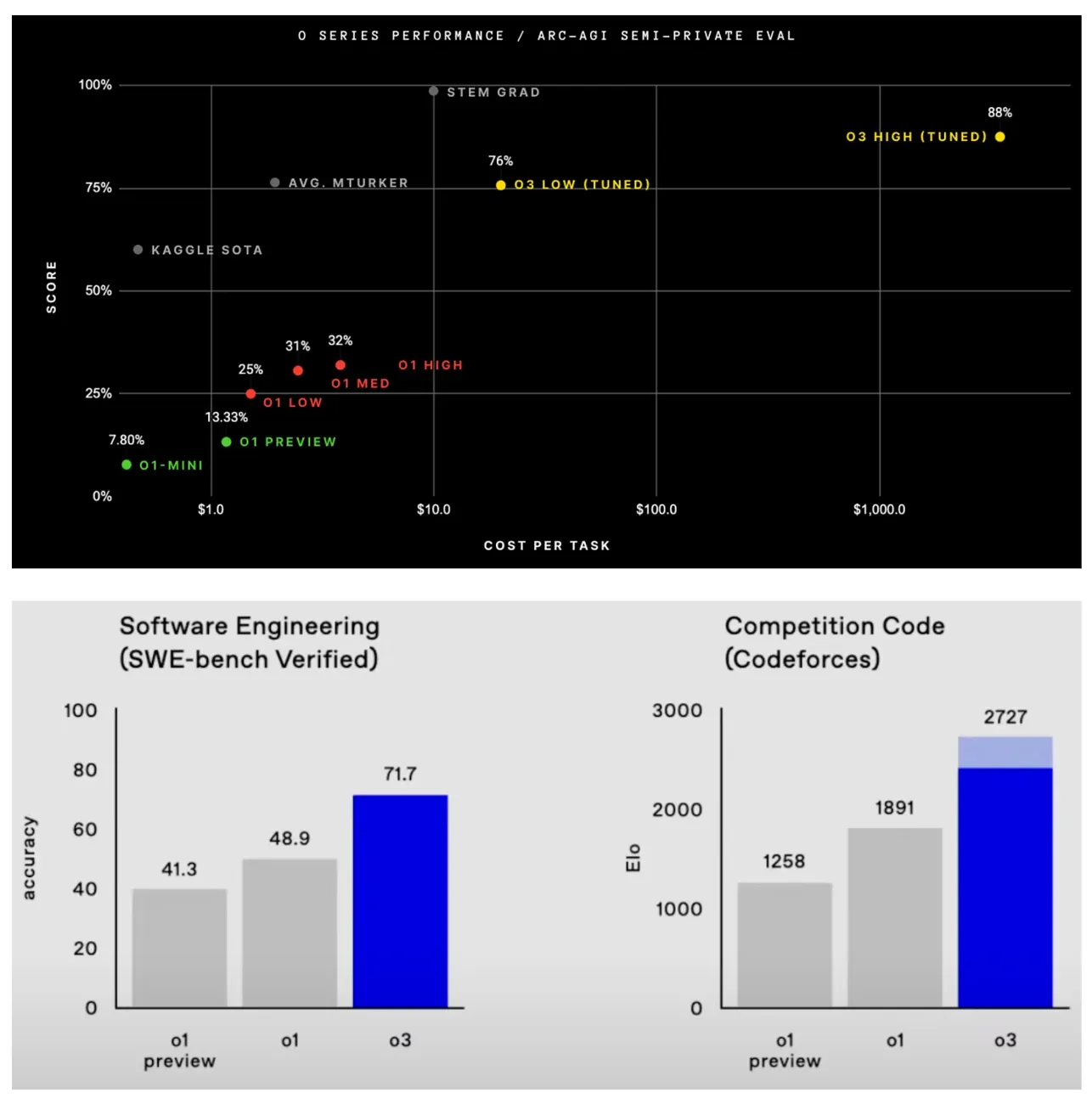

- Bei den Inferenzmodellen stellen die Autoren die Modelle o1 und o3 von OpenAI vor, die bei komplexen Inferenzaufgaben beeindruckende Ergebnisse erzielt haben. Insbesondere o3 übertraf das menschliche Niveau bei mehreren anspruchsvollen Benchmarks und übertraf bei einigen Problemen sogar die Vorhersagen von Terence Tao. Die Autoren weisen darauf hin, dass der Erfolg der o1- und o3-Modelle zeigt, dass zusätzlich zur Skalierung des Pre-Trainings die Inferenz von Modellen durch die Erhöhung des Recheninputs zur Inferenzzeit erheblich verbessert werden kann, ein neues Skalierungsparadigma.

Kommentar: Dieser Abschnitt ist sehr zukunftsorientiert, und die Einführung der Autoren in Big Language Modelling-Systeme/Agenten und Inferenzmodelle eröffnet dem Leser neue Horizonte. Die Betonung der Autoren auf dem Aufbau von Big Language Models-Produkten ist von großer praktischer Bedeutung, nicht nur für die akademische Forschung, sondern auch für die Anwendung von KI-Technologie vor Ort. Die Einführung der o1- und o3-Modelle ist ermutigend, da sie das große Potenzial der KI für komplexe Schlussfolgerungsaufgaben aufzeigen und neue Richtungen für die künftige KI-Forschung aufzeigen.

Zusammenfassen und reflektieren:

Der Artikel von Cameron R. Wolfe ist eine hervorragende Arbeit, die Breite und Tiefe vereint und nicht nur einen systematischen Überblick über die Entwicklung des Skalengesetzes für große Sprachmodelle, sondern auch einen aufschlussreichen Ausblick auf die Zukunft der KI-Forschung bietet. Der Standpunkt des Autors ist objektiv und rational und bestätigt die wichtige Rolle des Skalengesetzes, zeigt aber auch seine Grenzen und Herausforderungen auf. Die Logik des Artikels ist klar und gut argumentiert, so dass auch Leser, die mit dem Bereich der KI nicht vertraut sind, von ihm profitieren können.

Bemerkenswerte Höhepunkte:

- Eine ausführliche Erklärung: Der Autor hat ein Händchen dafür, komplexe Konzepte in leicht verständlicher Sprache zu erklären, wie z. B. die Einführung von Potenzgesetzen, Skalengesetzen und Aufgabenzerlegung.

- Unterstützt durch zahlreiche Beispiele: Der Artikel listet eine Vielzahl von Modellen und experimentellen Ergebnissen auf, wie z. B. die GPT-Serie, Chinchilla, Gopher, o1, o3 usw., um abstrakte Theorien greifbar und nachvollziehbar zu machen.

- Eine umfassende Literaturübersicht: Der Artikel zitiert eine große Anzahl von Referenzen, die sowohl klassische Arbeiten als auch aktuelle Forschungsergebnisse auf dem Gebiet der Modellierung großer Sprachen umfassen, und bietet den Lesern Ressourcen für ein vertieftes Studium.

- Unvoreingenommenes Denken: Die Autoren geben keine endgültige Antwort auf die Frage nach der Zukunft des Skalierungsgesetzes, sondern regen den Leser zu eigenständigen Überlegungen an, z. B. "Was skalieren wir als nächstes?" Diese Frage wird mehr Forscher dazu inspirieren, die Grenzen der KI zu erforschen.

Dieser Artikel verdient es, von allen, die die Entwicklung der KI verfolgen, aufmerksam gelesen zu werden. Er fasst nicht nur die Vergangenheit zusammen, sondern gibt auch Aufschluss über die Zukunft. Der Wert des Artikels liegt nicht nur in seinem Inhalt selbst, sondern auch in seinem Geist, der zum Nachdenken anregt und zu Innovationen führt. Ich glaube, dass wir in der künftigen KI-Forschung mehr Durchbrüche wie o3 sehen werden, und Ideen in großem Maßstab werden den Fortschritt der KI-Technologie in neuen Formen weiter vorantreiben.

Titel:Skalengesetze für große Sprachmodelle: Von GPT-3 bis o3.

Ursprünglicher Text:https://cameronrwolfe.substack.com/p/llm-scaling-laws

Erfahren Sie mehr über den aktuellen Stand der Sprachmodellierung im großen Maßstab und die Zukunft der KI-Forschung...

(Quellen [1, 7, 10, 21])

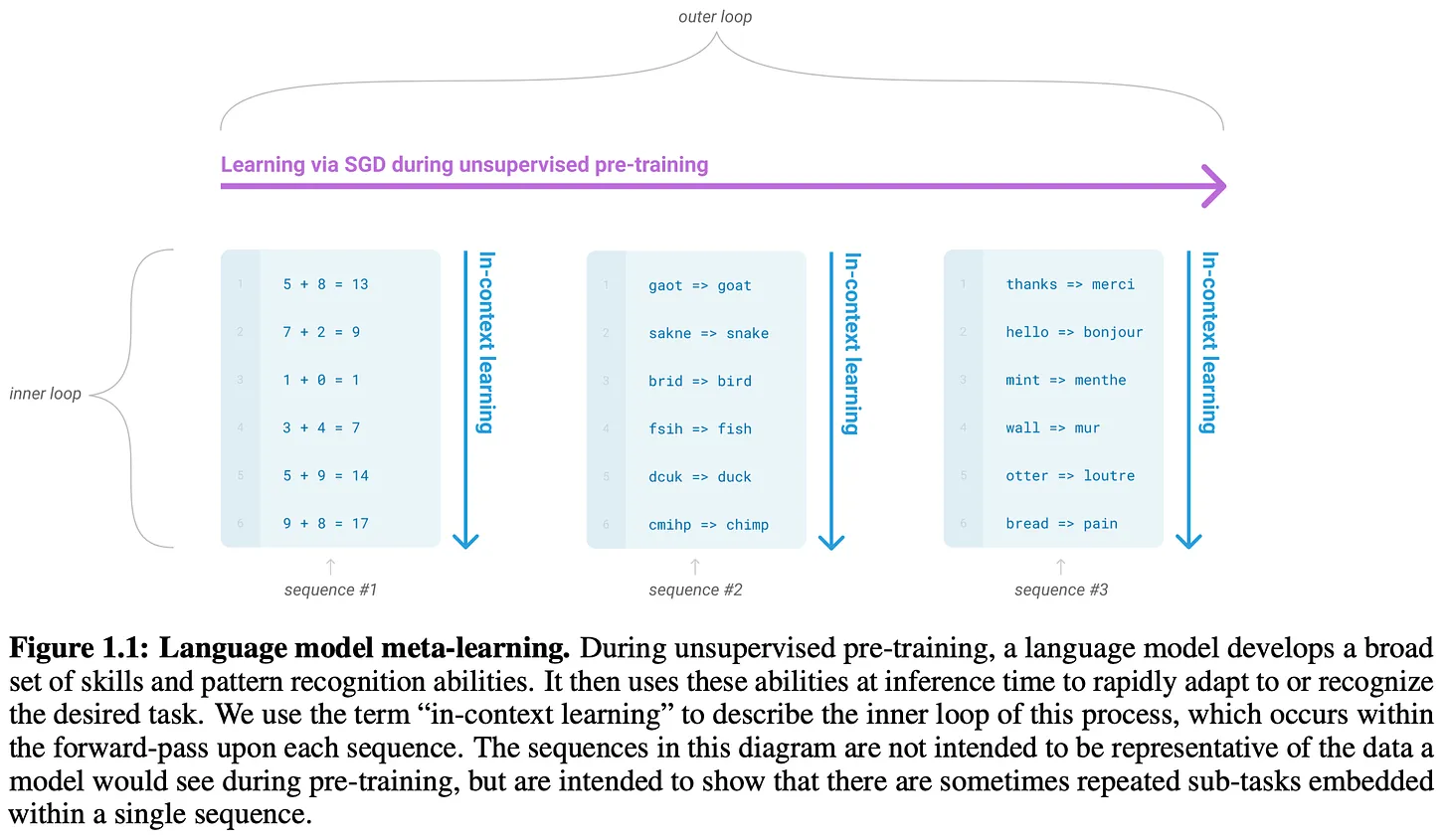

Die jüngsten Fortschritte in der KI-Forschung -Insbesondere das Large Language Model (LLM)- Es ist alles eine Frage des Umfangs. Wenn wir größere Modelle mit mehr Daten trainieren, erhalten wir bessere Ergebnisse. Diese Beziehung kann durch das Skalierungsgesetz genauer definiert werden. Es handelt sich dabei um eine Gleichung, die beschreibt, wie der Testverlust eines großen Sprachmodells abnimmt, wenn wir eine relevante Größe erhöhen (z. B. den Umfang der Trainingsberechnungen). Das Skalierungsgesetz hilft uns bei der Vorhersage der Ergebnisse größerer, teurerer Trainingsläufe und gibt uns so das nötige Vertrauen, um weiter in die Skalierung zu investieren.

"Wenn man einen großen Datensatz hat und ein sehr großes neuronales Netz trainiert, ist der Erfolg garantiert!" - Ilya Sutskever

Seit Jahren ist das Gesetz der Skala ein vorhersehbarer Nordstern für die KI-Forschung. Tatsächlich wurde der Erfolg früher Pionierlabors wie OpenAI sogar auf die Einhaltung des Skalierungsgesetzes zurückgeführt. Das Fortbestehen des Skalierungsprinzips wurde jedoch kürzlich durch Berichte1 in Frage gestellt, wonach Spitzenforschungslabors daran arbeiten, die nächste Generation besserer Modelle für große Sprachen zu entwickeln. Diese Behauptungen können uns skeptisch machen:Wird es einen Engpass in der Größenordnung geben? Wenn ja, gibt es andere Wege nach vorn?

In diesem Überblick werden diese Fragen von Grund auf beantwortet, beginnend mit einer ausführlichen Erläuterung des Big Language Model Laws of Scale und der damit verbundenen Forschung. Das Konzept der Skalengesetze ist einfach, aber in der Öffentlichkeit gibt es alle möglichen Missverständnisse über Skalierung - dieDie Wissenschaft, die hinter dieser Studie steht, ist eigentlich sehr spezifischDas Gesetz der Skalierung. Auf der Grundlage dieses detaillierten Verständnisses der Skalierung werden wir die neuesten Trends in der Big-Language-Modelling-Forschung sowie die Faktoren erörtern, die dazu geführt haben, dass das Gesetz der Skalierung "ins Stocken" geraten ist. Schließlich werden wir diese Informationen nutzen, um ein klareres Bild von der Zukunft der KI-Forschung zu zeichnen, wobei wir uns auf einige Schlüsselideen konzentrieren werden -Einschließlich Skala--Diese Ideen können den Fortschritt weiter vorantreiben.

Grundlegende Skalierungskonzepte für große Sprachmodelle

Um den Skalierungszustand großer Sprachmodelle zu verstehen, müssen wir zunächst ein allgemeines Verständnis der Skalengesetze entwickeln. Wir werden dieses Verständnis von Grund auf aufbauen, indem wir mit dem Konzept der Potenzgesetze beginnen. Dann werden wir untersuchen, wie die Potenzgesetze bei der Untersuchung großer Sprachmodelle angewandt wurden, um die Skalengesetze abzuleiten, die wir heute verwenden.

Was ist ein Potenzgesetz?

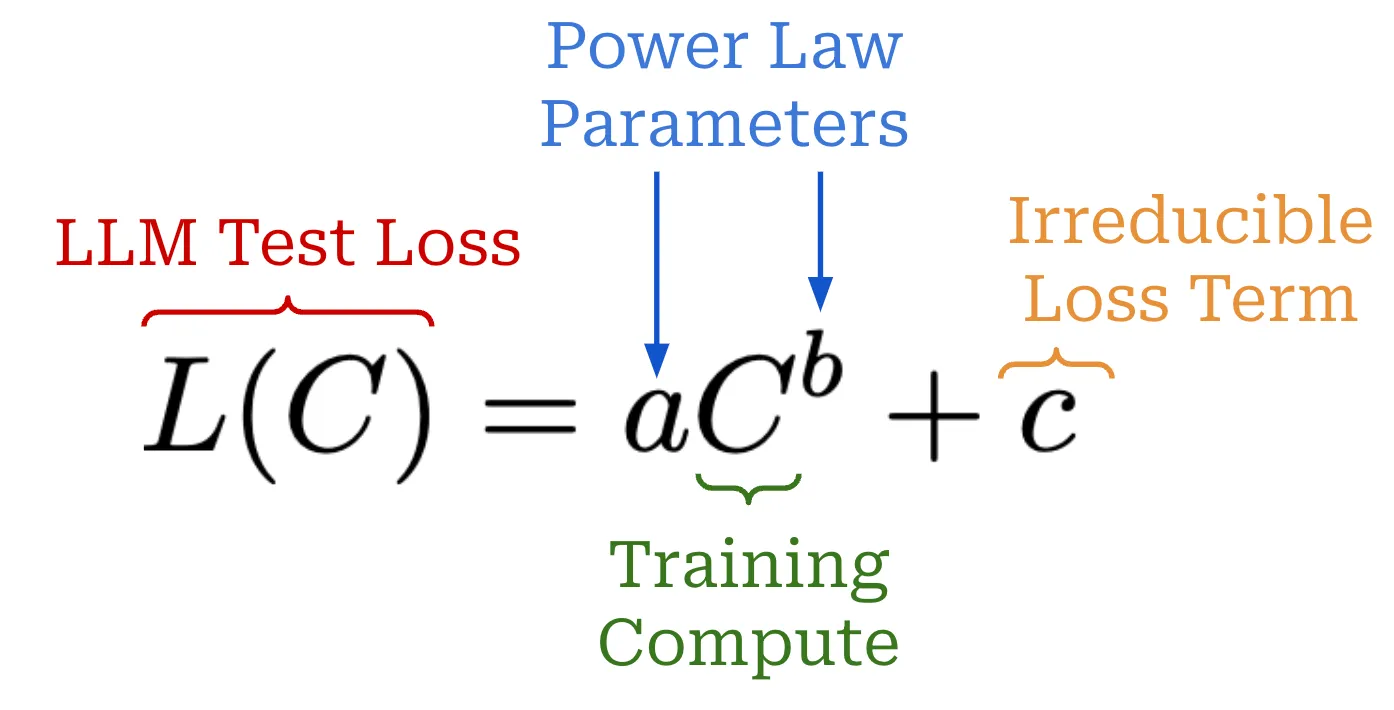

Potenzgesetze sind ein grundlegendes Konzept bei der Skalierung von großen Sprachmodellen. Kurz gesagt, ein Potenzgesetz beschreibt einfach die Beziehung zwischen zwei Größen. Im Falle eines großen Sprachmodells ist die erste Größe der Testverlust des großen Sprachmodells -oder andere relevante Leistungskennzahlen (z. B. die Genauigkeit nachgelagerter Aufgaben [7])- Zum anderen versuchen wir, bestimmte Einstellungen zu skalieren, z. B. die Anzahl der Modellparameter. Wenn wir zum Beispiel die Skalierungseigenschaften eines großen Sprachmodells untersuchen, könnten wir die folgende Aussage sehen.

"Wenn genügend Trainingsdaten vorhanden sind, sollte die Skalierung des Validierungsverlustes eine annähernd glatte Potenzgesetzfunktion der Modellgröße sein. - Quelle [4]

Eine solche Aussage besagt, dass es eine messbare Beziehung zwischen dem Testverlust des Modells und der Gesamtzahl der Modellparameter gibt. Eine Änderung einer dieser Größen führt zu einer unveränderlichen Änderung der relativen Größe der anderen. Mit anderen Worten, wir wissen aus dieser Beziehung, dass eine Erhöhung der Gesamtzahl der Modellparameter - derUnter der Voraussetzung, dass andere Bedingungen erfüllt sind (z. B. genügend Trainingsdaten vorhanden sind)--zu einer Verringerung der Prüfungsverluste um einen vorhersehbaren Faktor führen wird.

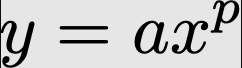

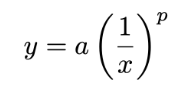

Potenzgesetz-Formel. Das grundlegende Potenzgesetz wird durch die folgende Gleichung ausgedrückt.

Die beiden hier untersuchten Größen sind x im Gesang antworten yaber (nicht) a im Gesang antworten p ist eine Konstante, die das Verhältnis zwischen diesen Größen beschreibt. Wenn wir diese Potenzgesetzfunktion2 aufzeichnen, erhalten wir die folgende Abbildung. Wir stellen die Diagramme sowohl auf normalen als auch auf logarithmischen Skalen dar, da die meisten Arbeiten, die die Skalierung großer Sprachmodelle untersuchen, logarithmische Skalen verwenden.

Graph des fundamentalen Potenzgesetzes zwischen x und y

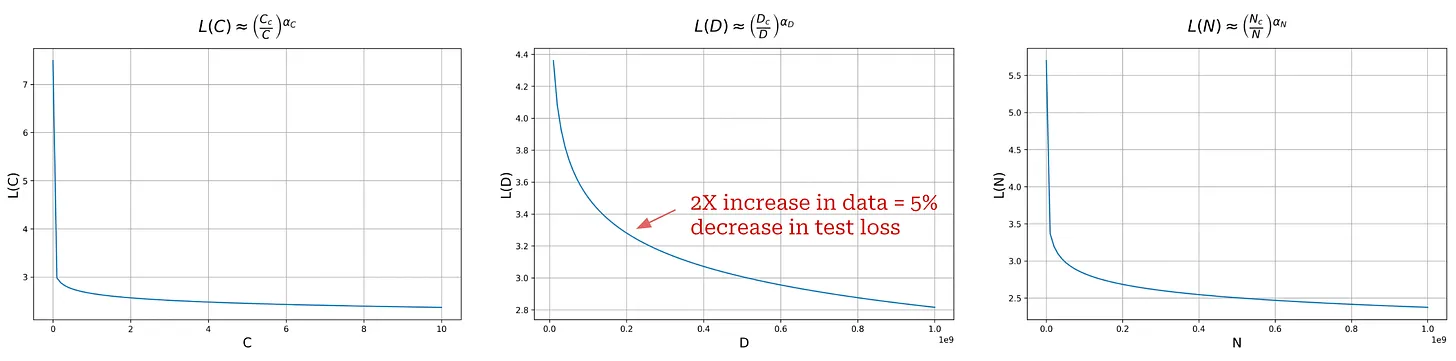

Die Diagramme, die für die Skalierung des Big Language Model bereitgestellt werden, sehen jedoch nicht wie die oben gezeigten Diagramme aus - dieNormalerweise stehen sie auf dem Kopf.Siehe das folgende Beispiel.

(Quelle [1])

Die Gleichung für das umgekehrte Potenzgesetz ist fast die gleiche wie die Gleichung für das Standard-Potenzgesetz, aber wir interessieren uns für die p Verwenden Sie negative Exponenten. Wenn der Exponent eines Potenzgesetzes negativ ist, wird das Diagramm auf den Kopf gestellt; siehe das folgende Beispiel.

Graph des umgekehrten Potenzgesetzes zwischen x und y

Wird dieses umgekehrte Potenzgesetz auf der logarithmischen Skala aufgetragen, ergibt sich die lineare Beziehung, die die Größengesetze der meisten großen Sprachmodelle kennzeichnet. In fast jeder Arbeit, die in dieser Übersicht behandelt wird, werden solche Diagramme erstellt, um zu untersuchen, wie sich die Skalierung einer Vielzahl verschiedener Faktoren (z. B. Größe, Berechnung, Daten usw.) auf die Leistung eines großen Sprachmodells auswirkt. Lassen Sie uns nun einen praktischeren Blick auf die Potenzgesetze werfen, indem wir eine der ersten Arbeiten verstehen, die sie im Zusammenhang mit der Skalierung großer Sprachmodelle untersucht [1].

Skalengesetze für die neurolinguistische Modellierung [1]

In den Anfängen der Sprachmodellierung wussten wir noch nicht, wie sich der Umfang auf die Leistung auswirkt. Die Sprachmodellierung war ein vielversprechender Forschungsbereich, aber die damalige Generation von Modellen (z. B. das ursprüngliche GPT) war nur begrenzt leistungsfähig. Wir hatten die Leistungsfähigkeit größerer Modelle noch nicht entdeckt, und der Weg zur Erstellung besserer Sprachmodelle war nicht klar.Spielt die Form des Modells (d. h. die Anzahl der Schichten und die Größe) eine Rolle? Hilft ein größeres Modell, die Leistung zu verbessern? Wie viele Daten werden benötigt, um diese größeren Modelle zu trainieren?

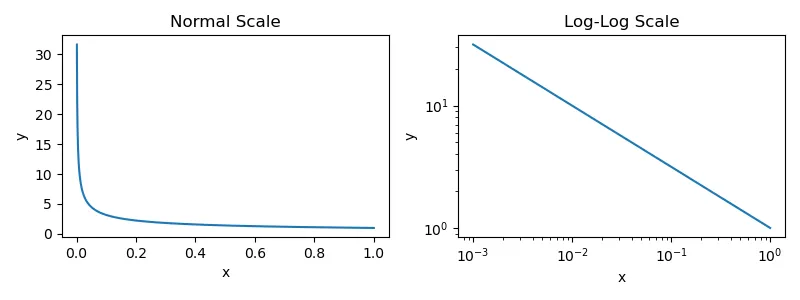

"Mit zunehmender Größe des Modells, des Datensatzes und des für das Training verwendeten Rechenaufwands skaliert der Verlust als Potenzgesetz, wobei sich einige dieser Trends über mehr als sieben Größenordnungen erstrecken. - Quelle [1]

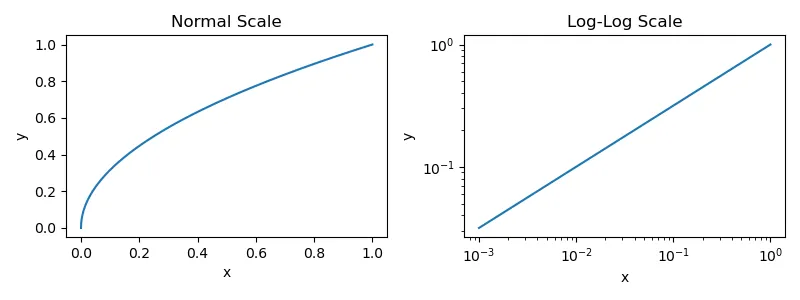

In [1] untersuchten die Autoren mehrere Faktoren, indem sie...Beispiele hierfür sind Modellgröße, Modellform, Datensatzgröße, Trainingsberechnung und Stapelgröße.- auf die Modellleistung, um diese Fragen zu beantworten. Aus dieser Analyse geht hervor, dass sich die Leistung des großen Sprachmodells gleichmäßig verbessert, wenn wir die Anzahl der

- Anzahl der Modellparameter.

- Die Größe des Datensatzes.

- Der für das Training verwendete Rechenaufwand.

Genauer gesagt.Wenn die Leistung nicht durch die beiden anderen Faktoren beeinträchtigt wird, ist eine Potenzgesetzbeziehung zwischen jedem Faktor und dem Testverlust des großen Sprachmodells zu beobachten.

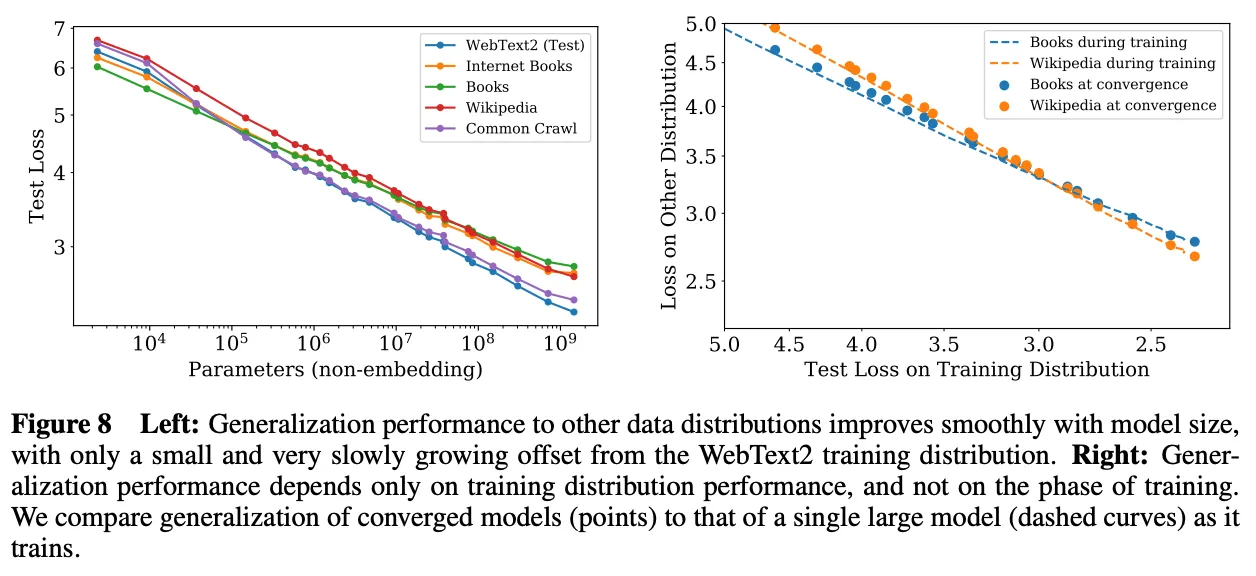

Versuchsaufbau.Zur Anpassung ihrer Potenzgesetze trainierten die Autoren große Sprachmodelle auf einer Teilmenge des WebText2-Korpus mit einer Größe von bis zu 1,5 Milliarden Parametern und 22 bis 23 Milliarden Token. Alle Modelle verwenden 1.024 Token mit fester Kontextlänge und Standardverlust bei der Vorhersage des nächsten Tokens (Kreuzentropie) für das Training. Derselbe Verlust wird auf einem reservierten Testsatz gemessen und als unsere Hauptleistungskennzahl verwendet.Diese Einstellung entspricht den standardmäßigen Pre-Training-Einstellungen für die meisten großen Sprachmodelle..

(Quelle [1])

Großsprachige Modelle Machtgesetze der Skala.Leistung des in [1] trainierten großen Sprachmodells -In Bezug auf ihre Testverluste bei WebText2- erwies sich mit mehr Parametern, Daten und Berechnungen als immer besser3 . Diese Trends erstrecken sich über acht Größenordnungen bei den Berechnungen, sechs Größenordnungen bei der Modellgröße und zwei Größenordnungen bei der Datensatzgröße. Die genauen Potenzgesetz-Beziehungen und die Gleichungen, die an jede Beziehung angepasst wurden, sind in der obigen Abbildung dargestellt. Jede dieser Gleichungen ähnelt sehr stark den Gleichungen des inversen Potenzgesetzes, die wir bereits kennen. Wir setzen jedoch a = 1 und fügen eine zusätzliche Multiplikationskonstante von 4 innerhalb der Klammern hinzu.

(Quelle [1])

Diese Potenzgesetze gelten nur, wenn die Ausbildung nicht durch andere Faktoren behindert wird. Daher müssen alle drei Komponenten - dieModellgröße, Daten und Berechnungen-sollten für eine optimale Leistung alle gleichzeitig ausgebaut werden. Wenn wir eine dieser Komponenten isoliert ausbauen, werden wir einen Punkt erreichen, an dem der Ertrag abnimmt.

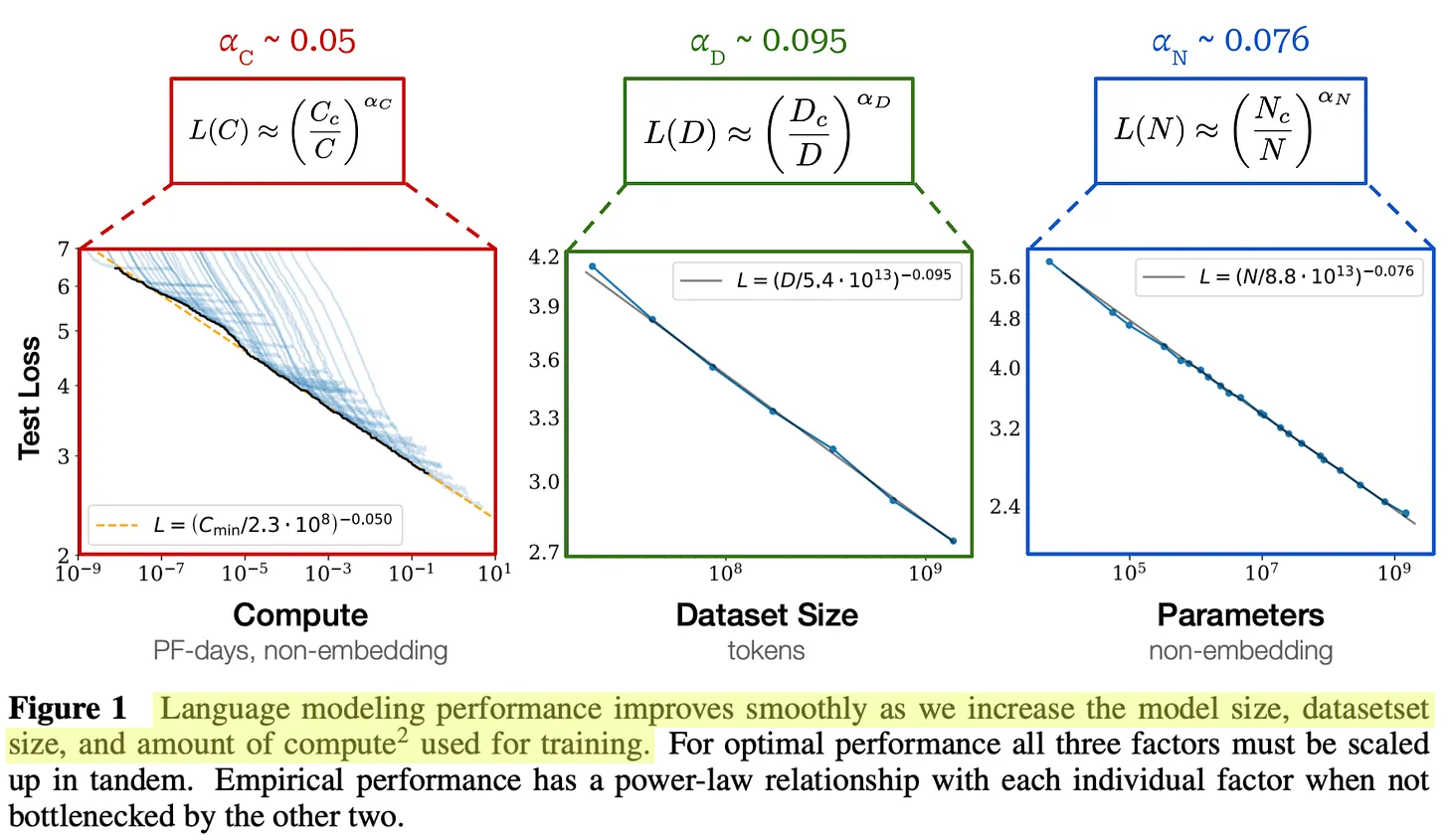

Was sagt uns das Potenzgesetz?Die in [1] dargestellten Potenzgesetzdiagramme sehen zwar vielversprechend aus, es ist jedoch zu beachten, dass diese Diagramme auf einer logarithmischen Skala erstellt wurden. Wenn wir normale Diagramme erstellen (d. h. ohne logarithmische Skala), erhalten wir die folgende Abbildung, in der wir sehen, dass die Form des Potenzgesetzes einem exponentiellen Zerfall ähnelt.

Potenzgesetzdiagramme ohne logarithmische Skalen

In Anbetracht des Online-Diskurses über Skalierung und AGI scheint eine solche Erkenntnis kontraintuitiv zu sein. In vielen Fällen wird uns suggeriert, dass die Qualität großer Sprachmodelle exponentiell mit dem logarithmischen Wachstum der Rechenleistung zunimmt, aber das ist nicht der Fall. In der Tat, dieDie Verbesserung der Qualität eines großen Sprachmodells wird mit zunehmender Größe immer schwieriger.

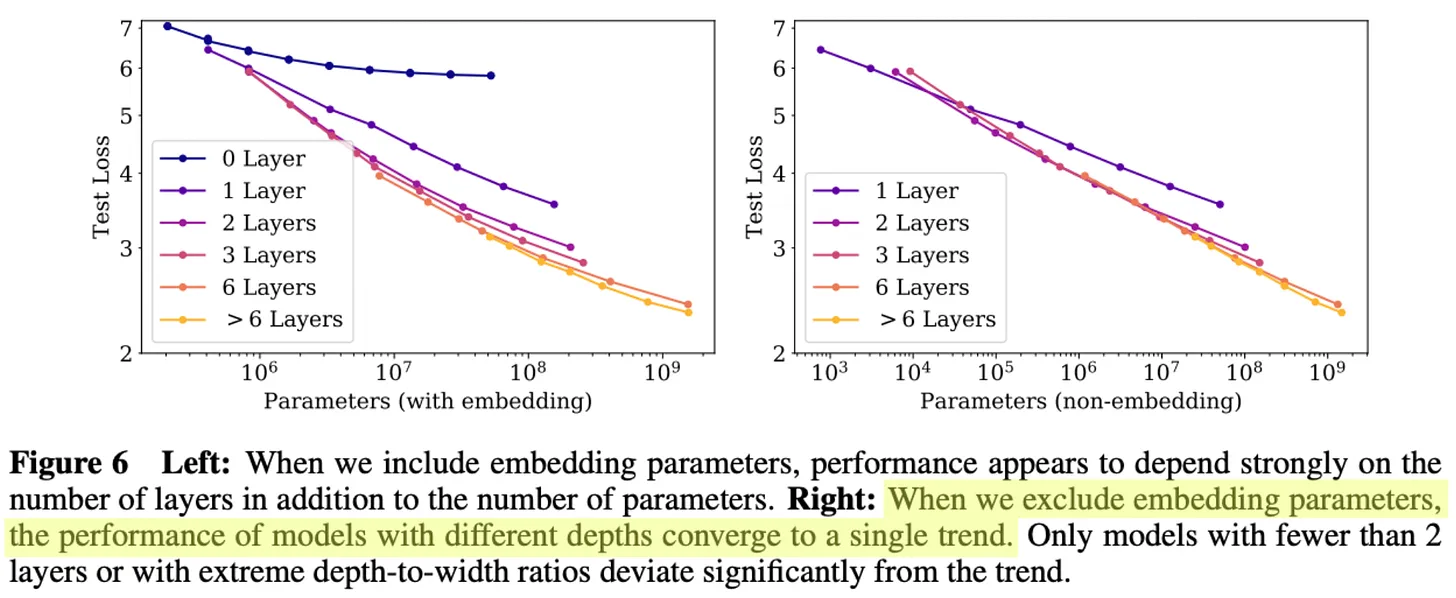

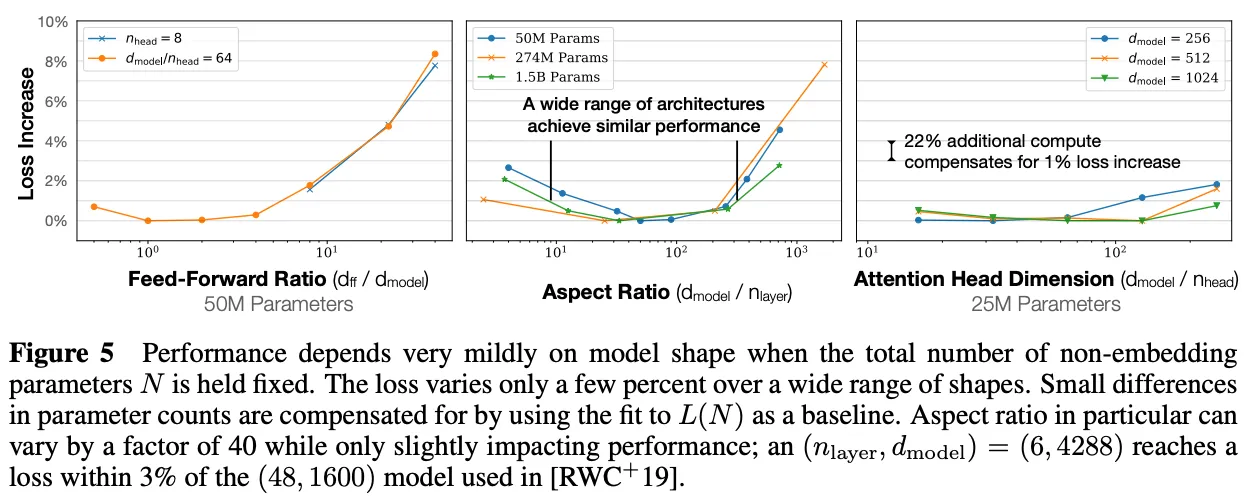

(Quelle [1])

Weitere nützliche Erkenntnisse.Zusätzlich zu dem in [1] beobachteten Potenzgesetz haben wir gesehen, dass andere Faktoren wie die Form des Modells oder architektonische Einstellungen kaum Auswirkungen auf die Modellleistung haben (siehe oben). Die Skalierung ist bei weitem der größte Faktor, der zur Erstellung besserer Modelle für große Sprachen beiträgt - dieMehr Daten, Berechnungen und Modellparameter führen zu einem gleichmäßigen Anstieg der Leistung des großen Sprachmodells.

"Größere Modelle haben eine deutlich höhere Stichprobeneffizienz, so dass ein optimales, recheneffizientes Training darin besteht, sehr große Modelle auf relativ bescheidenen Datenmengen zu trainieren und deutlich vor der Konvergenz aufzuhören. - Quelle [1]

Interessanterweise zeigen die empirischen Analysen in [1], dass größere große Sprachmodelle tendenziell eine höhere Stichprobeneffizienz aufweisen, was bedeutet, dass sie im Vergleich zu kleineren Modellen weniger Daten benötigen, um das gleiche Maß an Testverlust zu erreichen. Aus diesem Grund ist dieDas Vortraining eines großen Sprachmodells bis zur Konvergenz ist (wohl) suboptimal.. Stattdessen können wir größere Modelle auf weniger Daten trainieren und den Trainingsprozess vor der Konvergenz beenden. Dieser Ansatz ist optimal im Hinblick auf den Rechenaufwand für das Training, berücksichtigt aber nicht die Inferenzkosten. Tatsächlich trainieren wir in der Regel kleinere Modelle auf mehr Daten, weil kleinere Modelle weniger kostspielig zu hosten sind.

Die Autoren analysierten auch ausführlich die Beziehung zwischen der Modellgröße und der für das Pre-Training verwendeten Datenmenge und stellten fest, dass die Größe des Datensatzes nicht so schnell ansteigen muss wie die Modellgröße.Eine Vergrößerung des Modells um das 8-fache erfordert eine Vergrößerung der Trainingsdatenmenge um das 5-fache, um eine Überanpassung zu vermeiden..

(Quelle [1])

"Diese Ergebnisse zeigen, dass sich die Leistung von Sprachmodellen gleichmäßig und vorhersehbar verbessert, wenn wir die Modellgröße, die Daten und die Berechnungen angemessen skalieren. Wir erwarten, dass größere Sprachmodelle besser abschneiden als aktuelle Modelle und eine höhere Stichprobeneffizienz aufweisen. - Quelle [1]

Praktische Anwendung des Gesetzes der Größe

Die Tatsache, dass das Pre-Training in großem Maßstab so vorteilhaft ist, stellt uns vor ein kleines Dilemma. Die besten Ergebnisse lassen sich durch das Training großer Modelle auf großen Datenmengen erzielen. Diese Trainingsläufe sind jedoch sehr teuer undDies bedeutet, dass sie auch ein hohes Risiko eingehen.Was ist, wenn wir 10 Millionen Dollar ausgeben, um ein Modell zu entwickeln, das unsere Erwartungen nicht erfüllt? Was ist, wenn wir 10 Millionen Dollar ausgeben, um ein Modell zu trainieren, das unsere Erwartungen nicht erfüllt? Angesichts der Kosten für das Pre-Training können wir keine modellspezifische Abstimmung vornehmen, und wir müssen sicherstellen, dass die von uns trainierten Modelle gut funktionieren. Wir müssen eine Strategie entwickeln, um diese Modelle abzustimmen und ihre Leistung vorherzusagen, ohne zu viel Geld auszugeben.

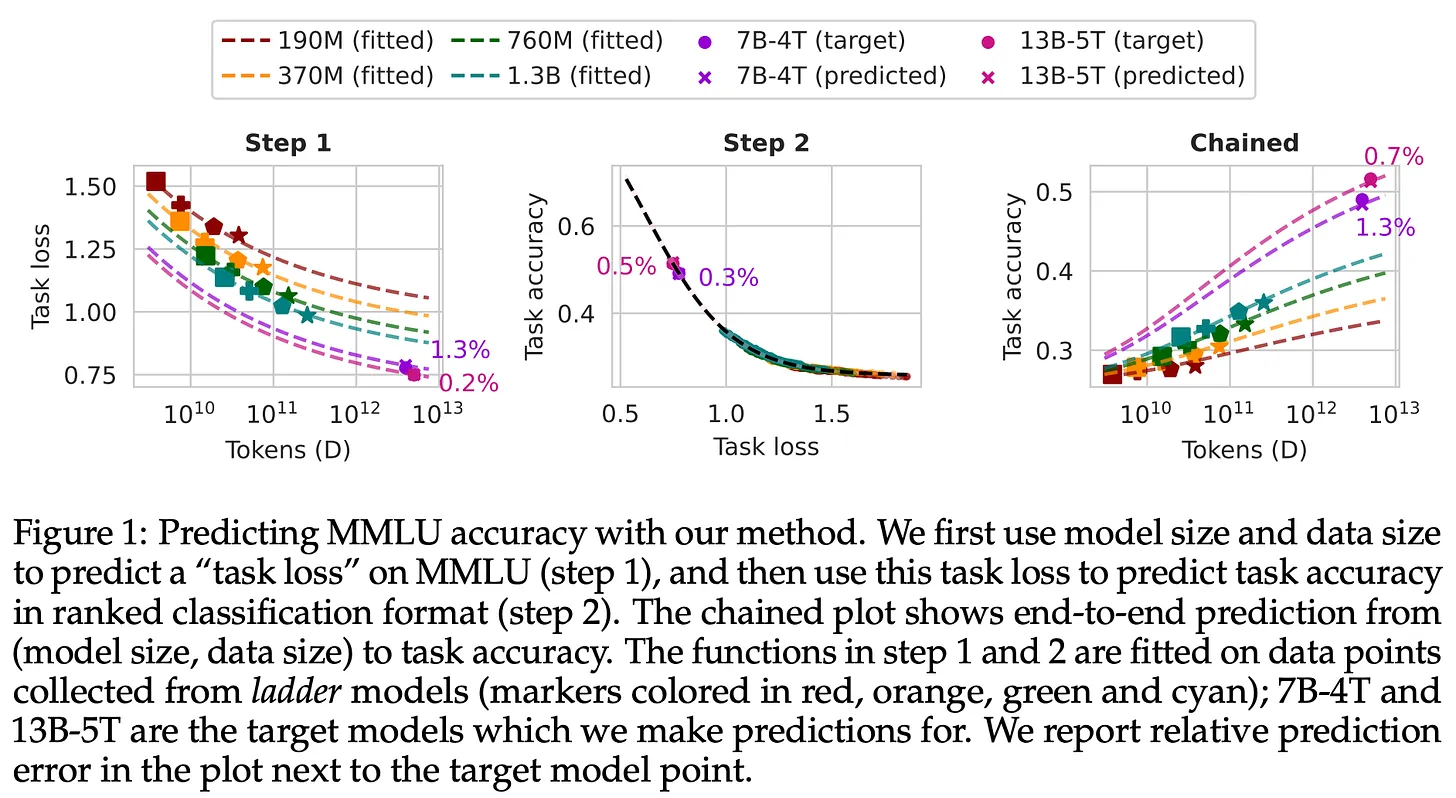

(Quelle [11])

- Trainieren Sie eine Reihe kleinerer Modelle mit verschiedenen Trainingseinstellungen.

- Passen Sie das Maßstabsgesetz an die Leistung kleinerer Modelle an.

- Ableitung der Leistung größerer Modelle anhand des Gesetzes der Größe.

Natürlich hat dieser Ansatz seine Grenzen. Die Vorhersage der Leistung größerer Modelle anhand kleinerer Modelle ist schwierig und kann ungenau sein. Modelle können sich je nach Größe unterschiedlich verhalten. Es wurden jedoch verschiedene Methoden vorgeschlagen, um dies besser zu ermöglichen, und Größengesetze werden jetzt üblicherweise für diesen Zweck verwendet. Die Möglichkeit, Größengesetze zur Vorhersage der Leistung größerer Modelle zu verwenden, gibt uns als Forschern mehr Sicherheit (und Seelenfrieden). Darüber hinaus bietet das Größengesetz eine einfache Möglichkeit, Investitionen in die KI-Forschung zu rechtfertigen.

Scale-up und Vorschulungszeit

"Das ist es, was all die Fortschritte vorantreibt, die wir heute sehen - riesige neuronale Netze, die auf riesigen Datensätzen trainiert werden. - Ilya Sutskever

Die Entdeckung des "Law of Scale" hat in jüngster Zeit viele Fortschritte bei der Untersuchung großer Sprachmodelle ermöglicht. Um bessere Ergebnisse zu erzielen, müssen wir einfach Modelle auf größeren (und besseren!) Datensätzen trainieren, um immer größere Modelle zu trainieren. Mit dieser Strategie wurden mehrere Modelle der GPT-Familie sowie die meisten der bekannten Modelle von Teams außerhalb von OpenAI entwickelt. Hier werfen wir einen tieferen Blick auf den Fortschritt dieser Skalierungsforschung - dieKürzlich von Ilya Sutskever als "das Zeitalter der Vorbildung" bezeichnet. 5.

GPT-Serie: GPT [2], GPT-2 [3], GPT-3 [4] und GPT-4 [5].

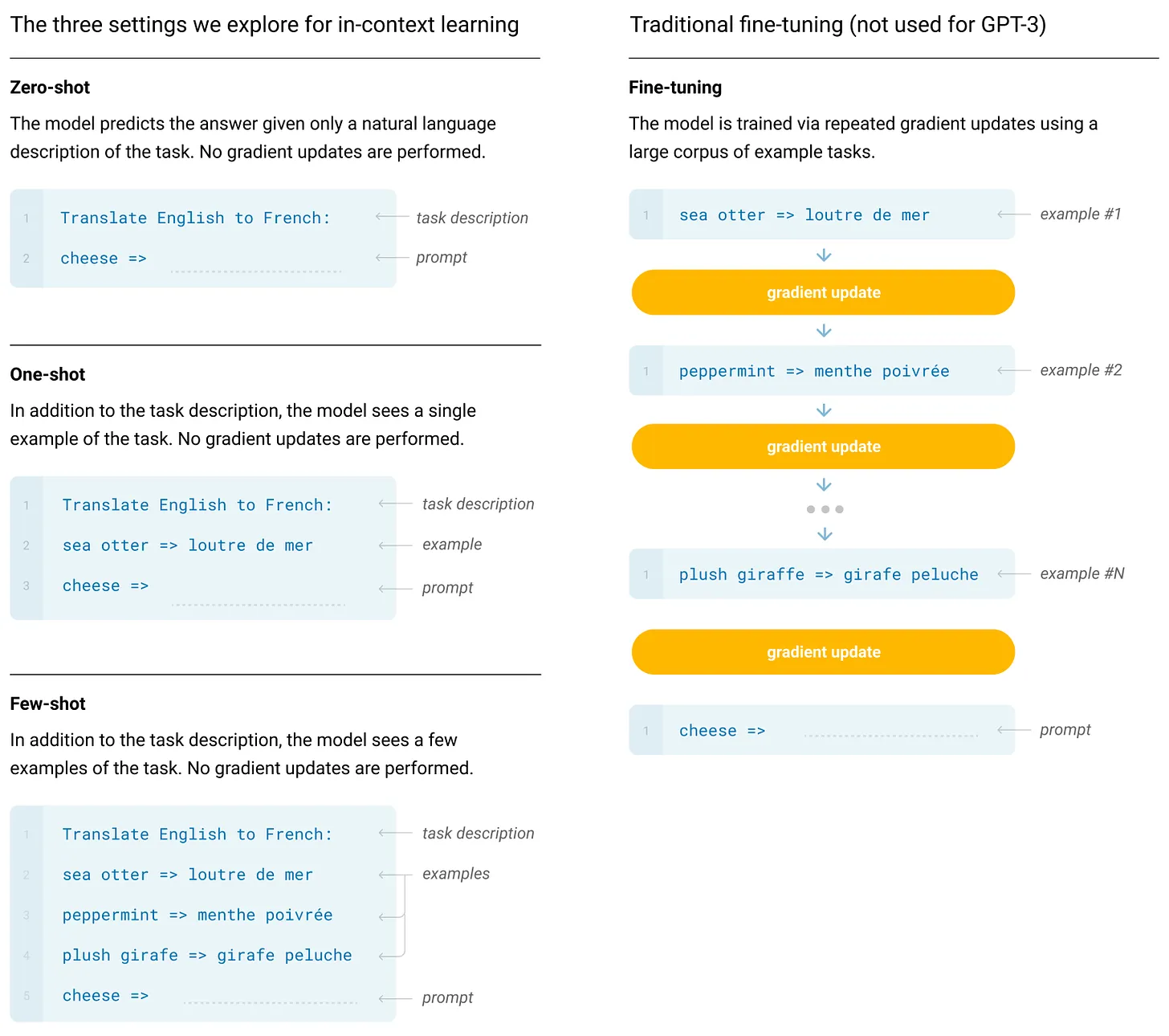

Große Sprachmodelle Die bekannteste und sichtbarste Anwendung der Skalengesetze ist die Erstellung der GPT-Modellfamilie von OpenAI. Wir werden uns in erster Linie auf die früheren offenen Modelle der Reihe konzentrieren - dieBis GPT-3-Weil:

- Die Einzelheiten dieser Modelle werden nun offener bekannt gegeben.

- Spätere Modelle haben von den Fortschritten in der Post-Training-Forschung profitiert und auch den Pre-Training-Prozess erweitert.

Wir werden auch einige bekannte Skalierungsergebnisse vorstellen, wie z.B. die Modelle von GPT-4.

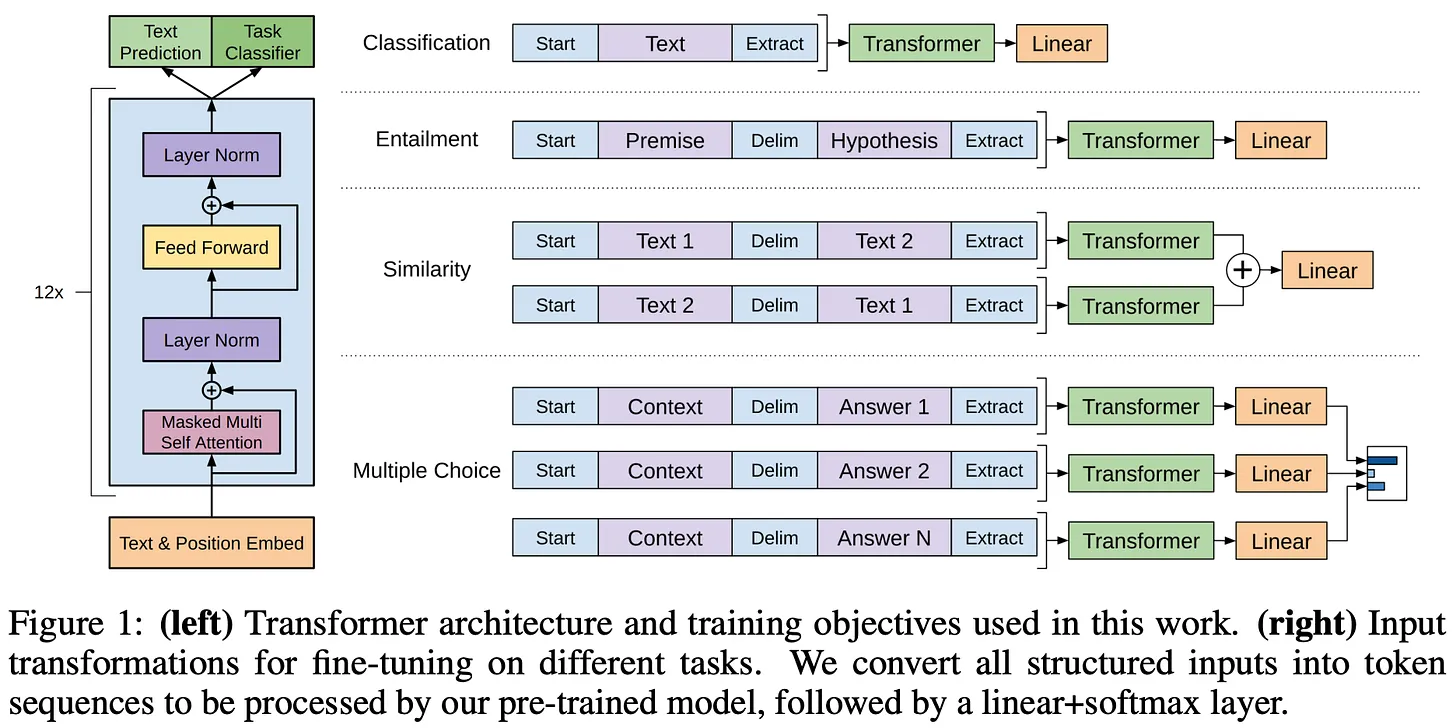

(Quelle [2])

- Selbstüberwachtes Vortraining für flachen Text ist sehr effektiv.

- Es ist wichtig, lange, zusammenhängende Textabschnitte für das Vortraining zu verwenden.

- Wenn sie auf diese Weise vortrainiert sind, können die einzelnen Modelle so fein abgestimmt werden, dass sie eine Vielzahl unterschiedlicher Aufgaben mit höchster Genauigkeit lösen6 .

Insgesamt ist GPT kein besonders bemerkenswertes Modell, aber es legte einige wichtige Grundlagen für spätere Arbeiten (z. B. den Decoder-only Transformer und das selbstüberwachte Pre-Training), die ähnliche Modelle in größerem Maßstab untersuchten.

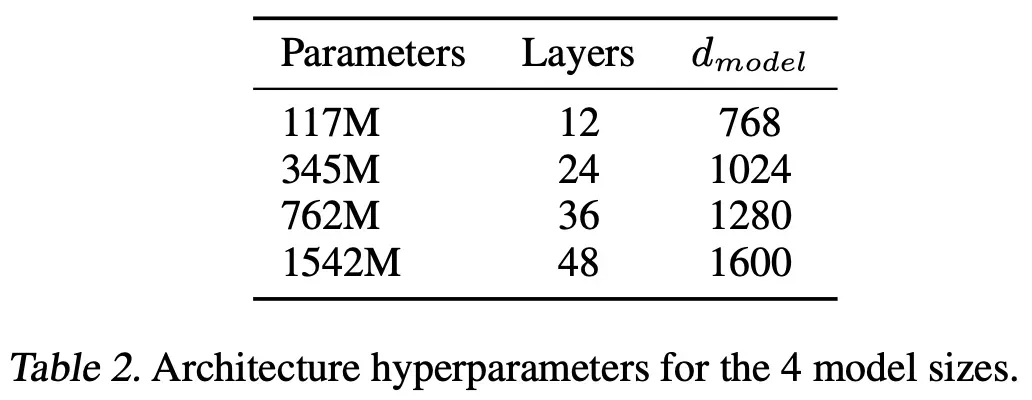

(Quelle [3])

- Diese Modelle werden auf WebText trainiert, der i) ist viel größer als BooksCorpus, und ii) Erstellt durch Abrufen von Daten aus dem Internet.

- Diese Modelle werden nicht für nachgelagerte Aufgaben fein abgestimmt. Stattdessen lösen wir die Aufgabe durch stichprobenartige Inferenz7 unter Verwendung vorab trainierter Modelle.

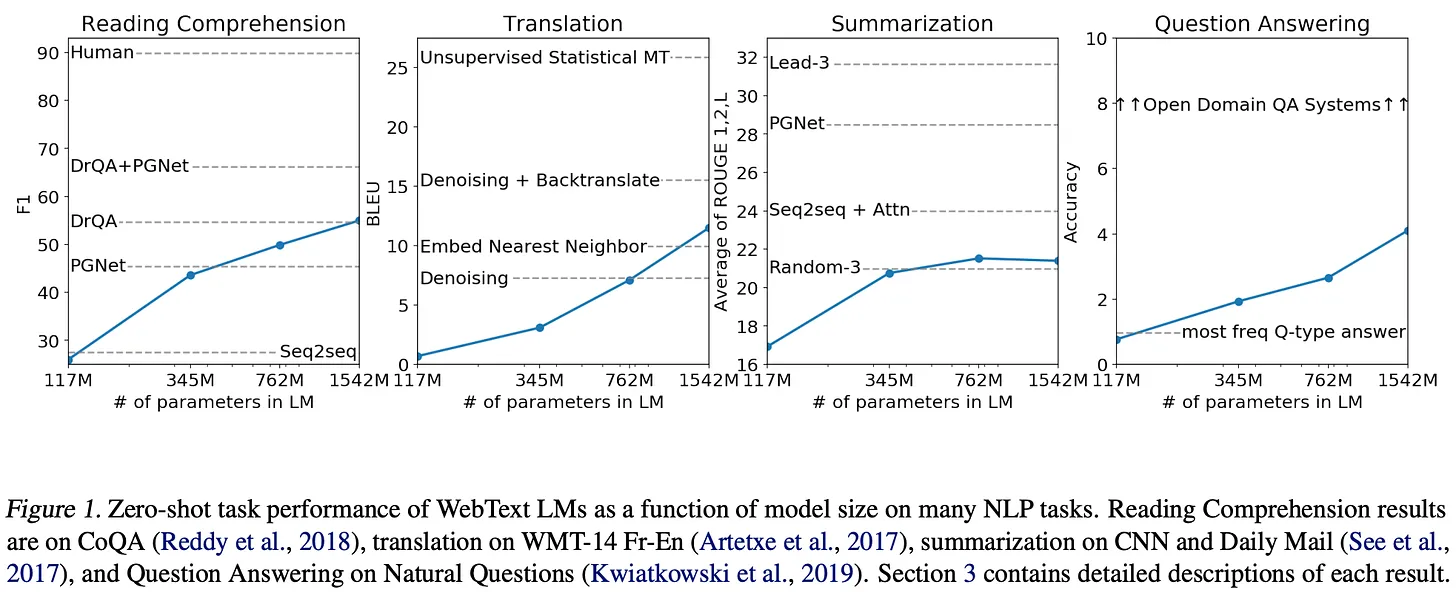

GPT-2-Modelle erreichen bei den meisten Benchmarks8 nicht den Stand der Technik, aber ihre Leistung verbessert sich durchweg mit zunehmender Modellgröße - dieDie Erweiterung der Anzahl der Modellparameter bringt deutliche Vorteile mit sichSiehe unten.

(Quelle [3])

"Sprachmodelle mit ausreichender Kapazität werden anfangen zu lernen, aus natürlichen Sprachsequenzen Aufgaben abzuleiten und auszuführen, um sie besser vorhersagen zu können, unabhängig von der Methode, mit der sie erworben wurden." - Quelle [3]

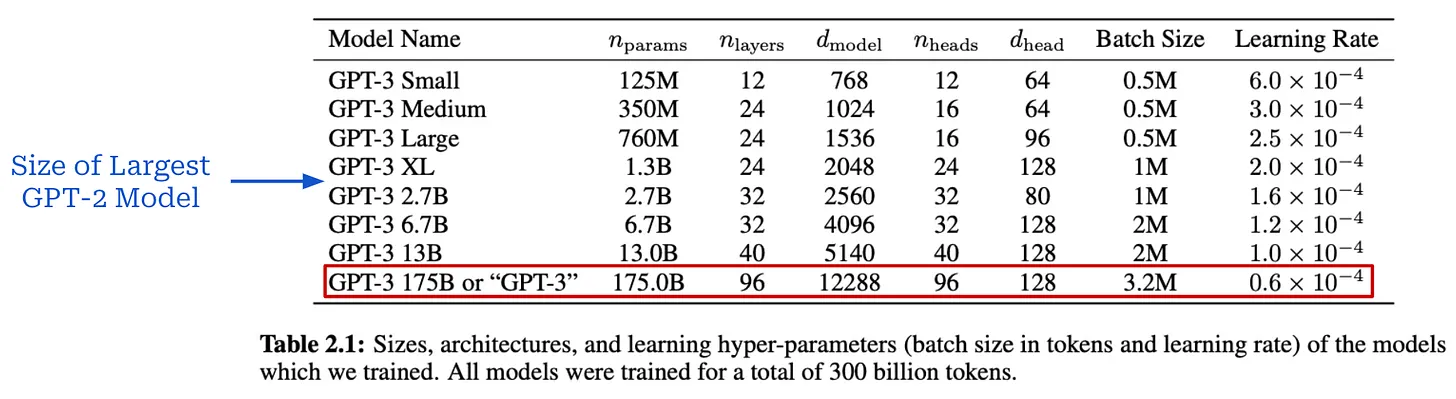

GPT-3 [4] war ein Wendepunkt in der KI-Forschung, der die Vorteile eines groß angelegten Pre-Trainings eines großen Sprachmodells deutlich machte. Mit über 175 Milliarden Parametern ist dieses Modell über 100 Mal größer als das größte GPT-2-Modell (siehe unten).

(Quelle [4])

(Quelle [4])

(Quelle [4])

(Quelle [4])

(Quelle [4])

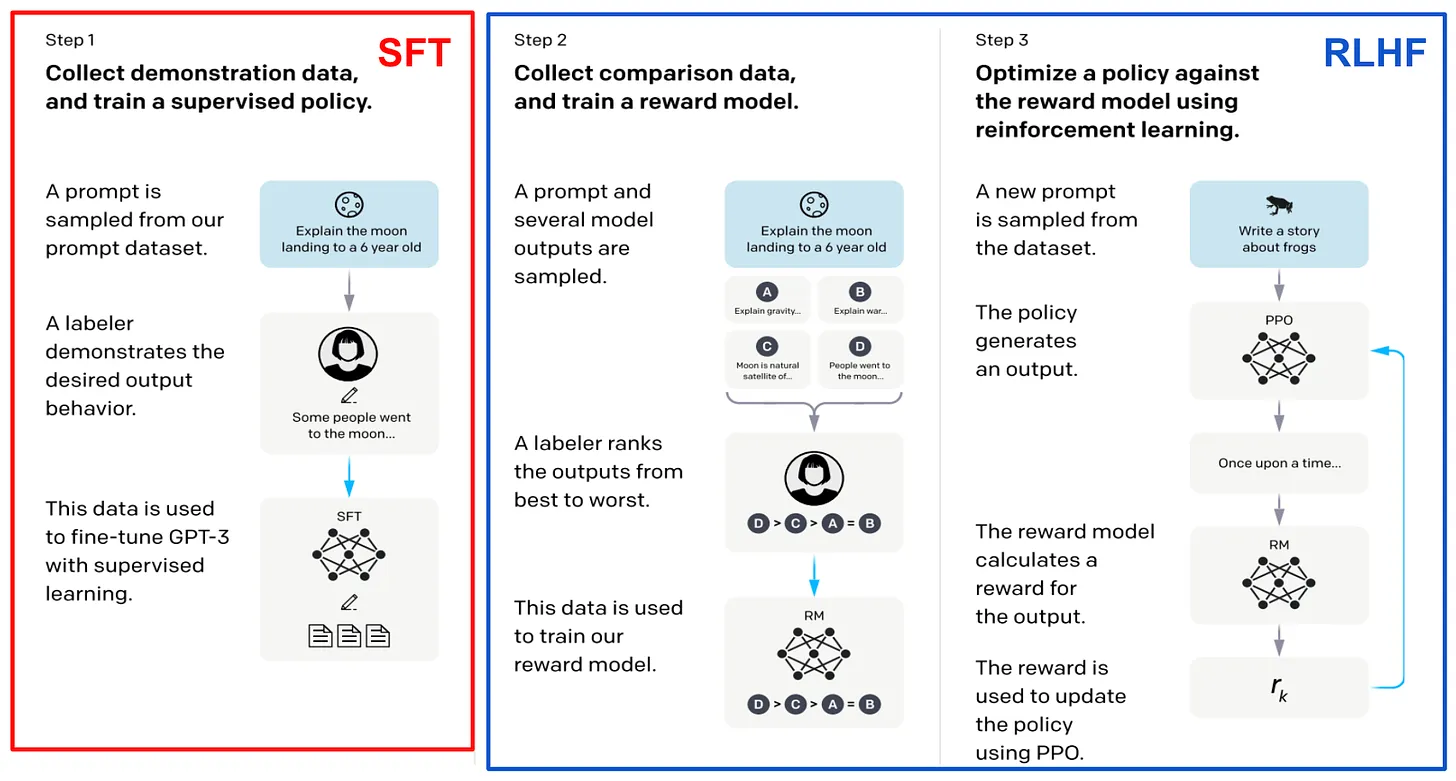

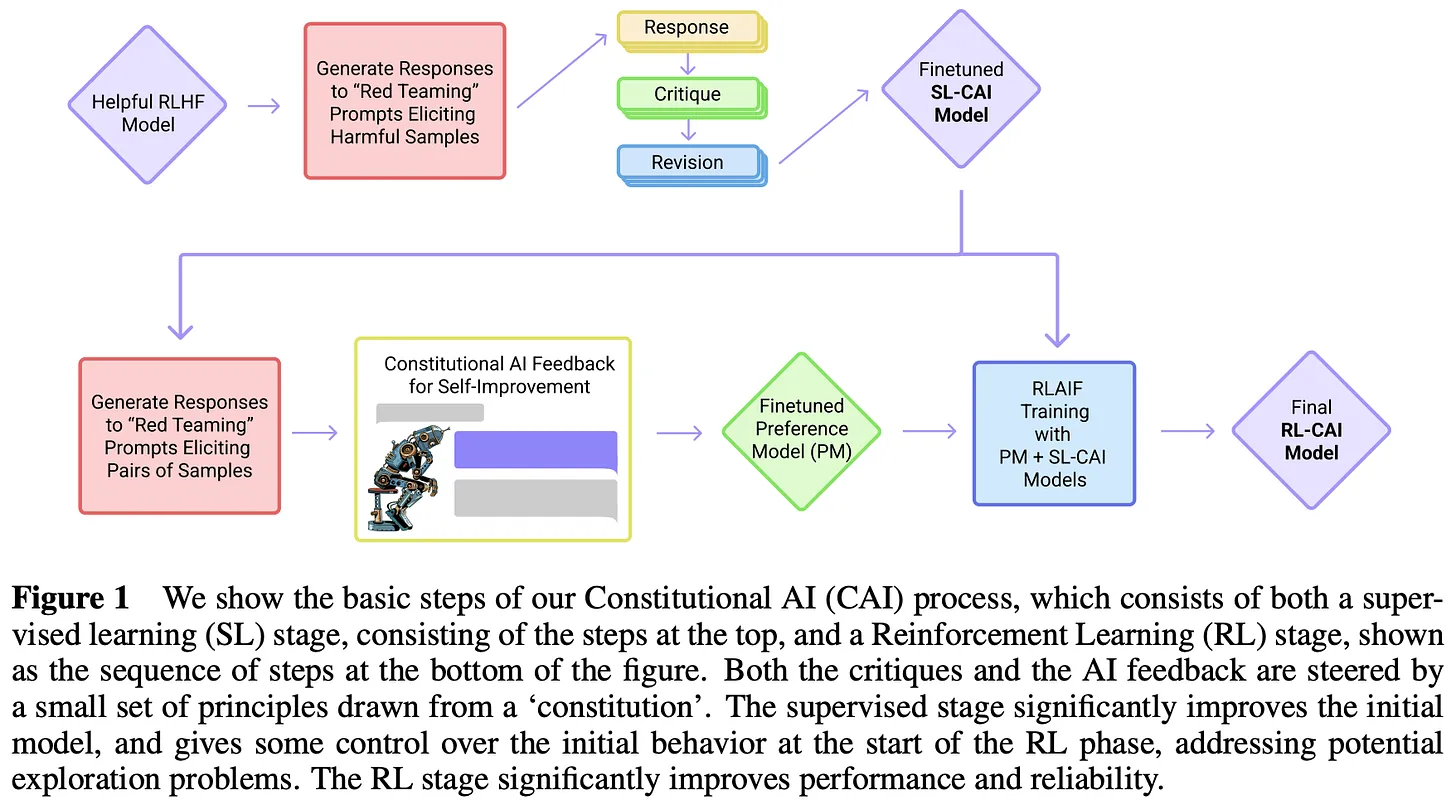

Nach GPT-3. Die beeindruckende Leistung von GPT-3 hat ein großes Interesse an der Untersuchung großer Sprachmodelle geweckt, wobei der Schwerpunkt auf groß angelegtem Pre-Training liegt. Die nächsten von OpenAI veröffentlichten Modelle - dasInstructGPT [8], ChatGPT und GPT-4 [5]--Der Einsatz einer Kombination aus groß angelegtem Pre-Training und neuen Post-Training-Techniken (d.h. überwachte Feinabstimmung und Verstärkungslernen durch menschliches Feedback) hat die Qualität großer Sprachmodelle dramatisch verbessert. Diese Modelle sind so beeindruckend, dass sie sogar zu einem Anstieg des öffentlichen Interesses an der KI-Forschung geführt haben.

"GPT-4 ist ein Transformator-basiertes Modell, das vortrainiert ist, um das nächste Token in einem Dokument vorherzusagen. Der Alignment-Prozess nach dem Training verbessert die Faktorisierungsmetrik und die Einhaltung des gewünschten Verhaltens." - Quelle [5]

Zu diesem Zeitpunkt begann OpenAI, weniger Details über ihre Forschung zu veröffentlichen. Stattdessen wurden neue Modelle nur noch über ihre API veröffentlicht, wodurch die Öffentlichkeit nicht mehr nachvollziehen konnte, wie diese Modelle erstellt wurden. Glücklicherweise lassen sich aus dem Material, das OpenAI freigibt, einige nützliche Informationen gewinnen. Zum Beispiel InstructGPT [8]-ChatGPT Vorgängerinnen-- Es gibt ein verwandtes Papier, das die Nachtrainingsstrategie des Modells im Detail dokumentiert; siehe unten. Da in diesem Papier auch steht, dass GPT-3 das Basismodell für InstructGPT ist, kann man davon ausgehen, dass die Leistungsverbesserung des Modells weitgehend unabhängig vom erweiterten Pre-Trainingsprozess ist.

(Quelle [8])

- Das GPT-4 basiert auf Transformer.

- Das Modell wird anhand der nächsten Token-Vorhersage trainiert.

- Verwendung von öffentlichen und lizenzierten Daten Dritter.

- Die Feinabstimmung des Modells erfolgt durch Verstärkungslernen anhand von menschlichem Feedback.

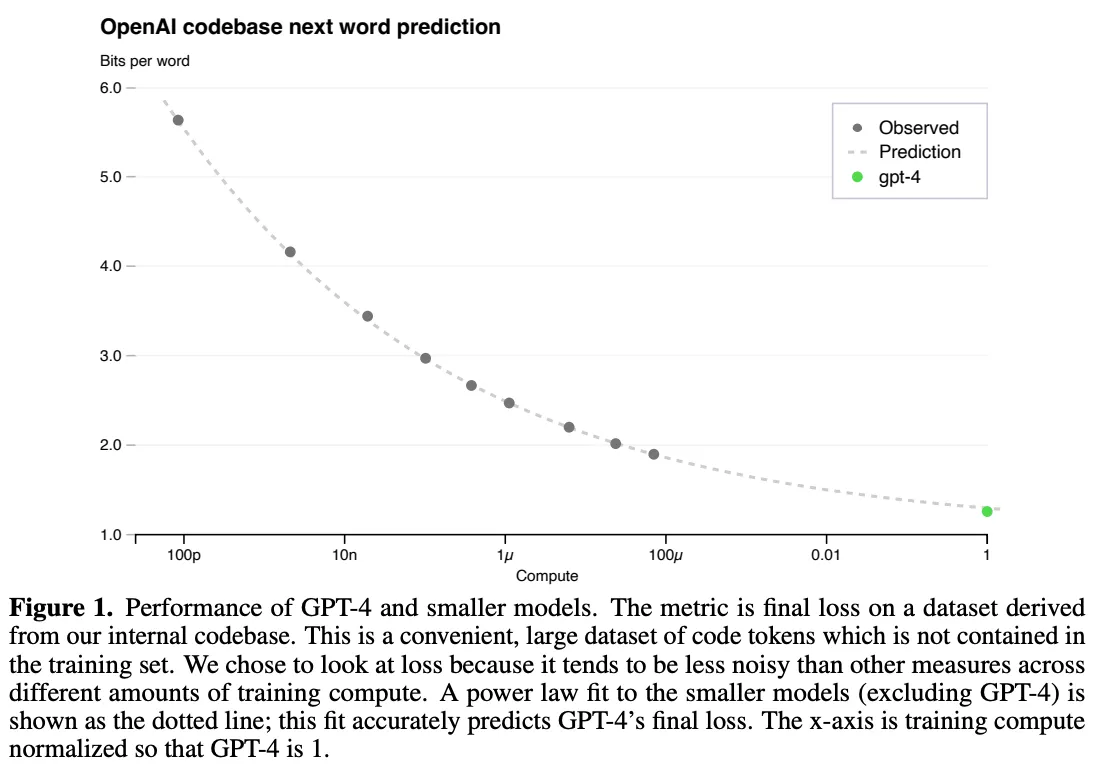

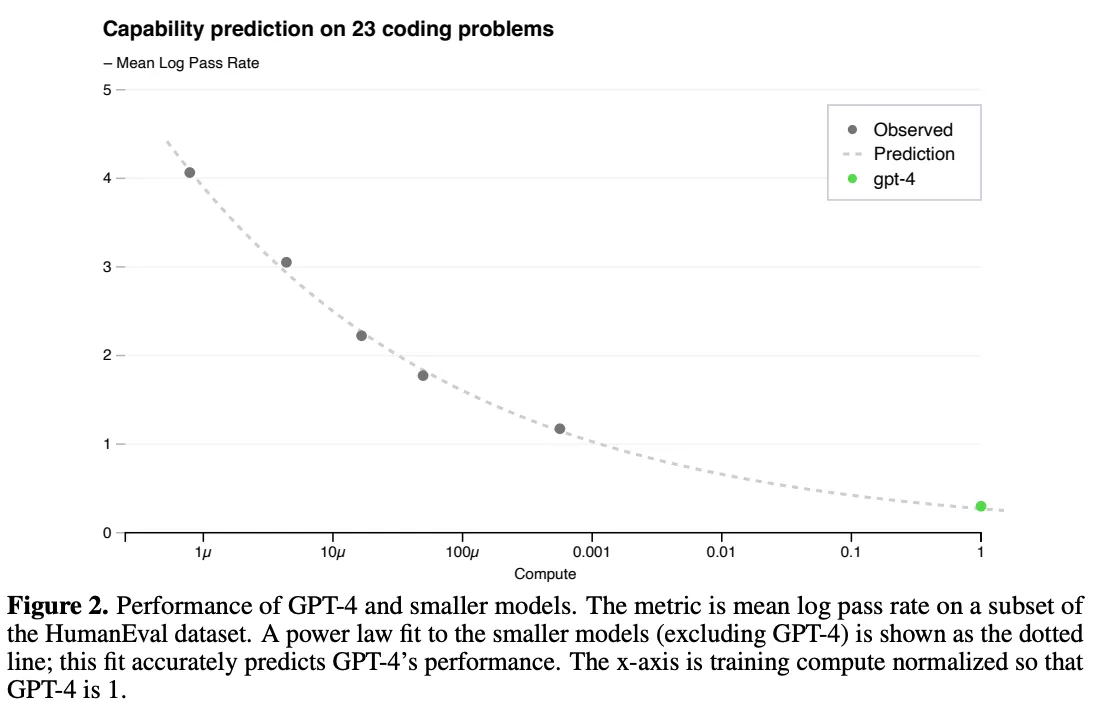

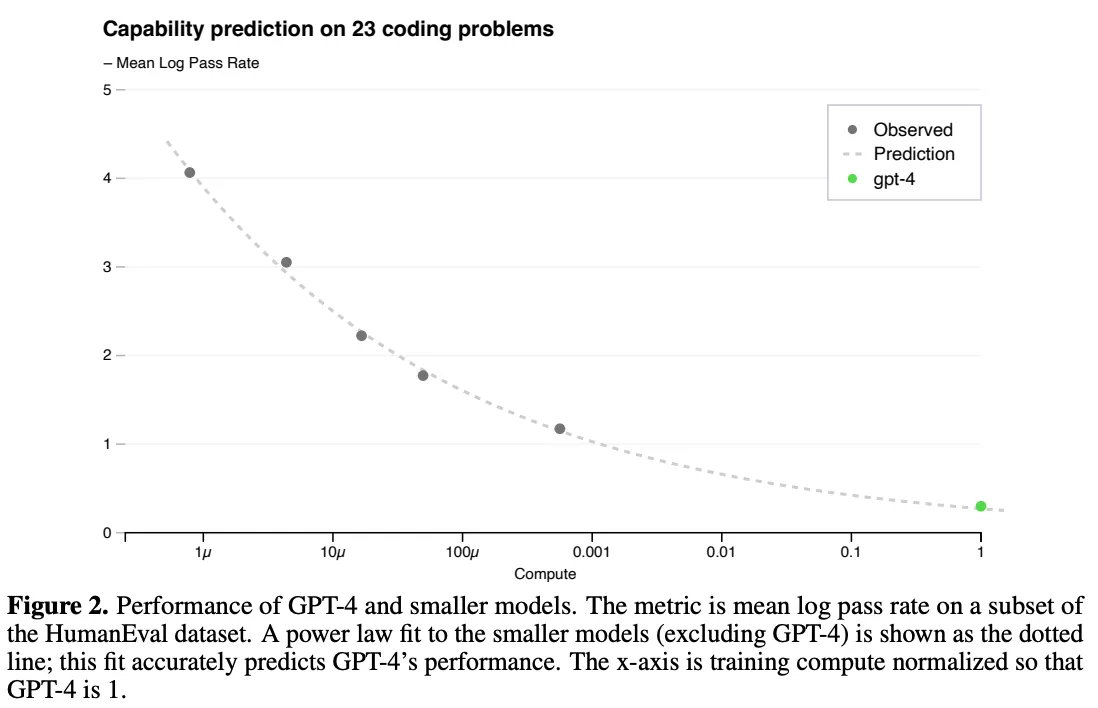

Nichtsdestotrotz wird die Bedeutung der Skalierung in diesem technischen Bericht sehr deutlich. Die Autoren weisen darauf hin, dass eine zentrale Herausforderung in dieser Arbeit darin besteht, eine skalierbare Trainingsarchitektur zu entwickeln, die in verschiedenen Maßstäben vorhersagbare Ergebnisse liefert, so dass die Ergebnisse kleinerer Läufe extrapoliert werden können und so die Zuversicht für größere (und viel teurere!) Trainingsübungen mit Zuversicht.

"Der endgültige Verlust eines richtig trainierten großen Sprachmodells ...... kann durch ein Potenzgesetz des für das Training des Modells verwendeten Rechenaufwands angenähert werden." - Quelle [5]

Umfangreiche Vorschulungen sind sehr teuer, so dass wir in der Regel nur eine Chance haben, es richtig zu machen.Kein Raum für modellspezifische Anpassungen. Das Größengesetz spielt in diesem Prozess eine Schlüsselrolle. Wir können ein Modell mit 1.000-10.000 Mal weniger Berechnungen trainieren und die Ergebnisse dieser Trainingsläufe zur Anpassung von Potenzgesetzen verwenden. Diese Potenzgesetze können dann verwendet werden, um die Leistung größerer Modelle vorherzusagen. Insbesondere haben wir in [8] gesehen, dass die Leistung von GPT-4 mit Hilfe von Potenzgesetzen vorhergesagt wurde, die das Verhältnis zwischen Berechnungs- und Testverlust messen; siehe unten.

GPT-4 Skalengesetzformel für die Ausbildung (Quelle [5])

(Quelle [5])

(Quelle [5])

Chinchilla. Training rechnerisch optimaler großer Sprachmodelle [5]

(Quelle [9])

(Quelle [10])

(Quelle [10])

"Die zu erwartende Menge an Trainingsdaten übersteigt bei weitem die Menge an Daten, die derzeit zum Trainieren großer Modelle verwendet wird. - Quelle [6]

Chinchilla.Die Analyse in [6] unterstreicht die Bedeutung der Datengröße.Große Modelle müssen mit mehr Daten trainiert werden, um eine optimale Leistung zu erzielen.Um dieses Ergebnis zu verifizieren, trainierten die Autoren ein großes Sprachmodell mit 70 Milliarden Parametern namens Chinchilla. Um dieses Ergebnis zu verifizieren, trainierten die Autoren ein großes Sprachmodell mit 70 Milliarden Parametern namens Chinchilla. Im Vergleich zu früheren Modellen ist Chinchilla kleiner, hat aber einen größeren Pre-Training-Datensatz - die1,4 Billionen Ausbildungsmünzen insgesamtChinchilla verwendet die gleichen Daten und die gleiche Bewertungsstrategie wie Gopher [10]. Obwohl viermal kleiner als Gopher, übertrifft Chinchilla durchweg größere Modelle; siehe unten.

(Quelle [6])

Der "Untergang" des Skalenprinzips

Das Gesetz der Skalierung ist in letzter Zeit ein heißes (und kontroverses) Thema in der KI-Forschung geworden. Wie wir in diesem Überblick gesehen haben, hat die Skalierung einen Großteil der Verbesserungen in der KI in der Zeit vor dem Training bewirkt. Da sich jedoch das Tempo der Modellveröffentlichungen und -verbesserungen in der zweiten Hälfte des Jahres 202411 verlangsamt, wird die Modellskalierung allmählich in Frage gestellt, was darauf hinzudeuten scheint, dass die KI-Forschung - dieInsbesondere das Gesetz der Skala-Vielleicht stoßen Sie auf eine Mauer.

- OpenAI ändert seine Produktstrategie aufgrund von Engpässen bei der Skalierung seines derzeitigen Ansatzes, so Reuters.

- Den Informationen zufolge verlangsamen sich die Verbesserungen des GPT-Modells allmählich.

- Bloomberg hebt die Schwierigkeiten hervor, mit denen mehrere Spitzenlabors bei der Entwicklung einer leistungsfähigeren KI konfrontiert sind.

- TechCrunch berichtet, dass die Skalierbarkeit immer mehr nachlässt.

- Das Time Magazine hat einen differenzierten Artikel veröffentlicht, in dem die verschiedenen Faktoren, die zu einer Verlangsamung der KI-Forschung führen, beleuchtet werden.

- Ilya Sutskever sagte in NeurIPS'24: *"Die Vorschulung, wie wir sie kennen, wird enden "*.

Gleichzeitig vertreten viele Experten die gegenteilige Auffassung. Zum Beispiel, (Anthropisch CEO) hat gesagt, dass die Skalierung *"wahrscheinlich ...... weitergehen wird".Und Sam Altman predigt weiter.die Formulierung "Es gibt keine Mauern "*. In diesem Abschnitt werden wir dieser Diskussion mehr Farbe verleihen, indem wir den aktuellen Stand der Skala und die verschiedenen Probleme, die möglicherweise bestehen, sachkundig erläutern.

Verkleinerung: Was bedeutet das? Warum geschieht das?

"Beide Aussagen sind wahrscheinlich richtig: Auf technischer Ebene funktioniert die Skalierung noch. Für die Nutzer verlangsamt sich das Tempo der Verbesserung. - Nathan Lambert

Also ......Verlangsamt sich die Vergrößerung? Die Antwort ist komplex und hängt sehr stark von unserer genauen Definition des Begriffs "Verlangsamung" ab. Bislang ist meine plausibelste Antwort auf diese Frage, dass beide Antworten richtig sind. Aus diesem Grund werden wir nicht versuchen, diese Frage zu beantworten. Stattdessen werden wir uns eingehender mit dem befassen, was zu diesem Thema gesagt wird, damit wir ein differenzierteres Verständnis des aktuellen (und zukünftigen) Stands der Skalierung großer Sprachmodelle entwickeln können.

Was sagt uns das Gesetz der Skala?Zunächst müssen wir uns die technische Definition des Größengesetzes ansehen. Das Größengesetz definiert das Verhältnis zwischen dem Trainingsaufwand (oder der Größe des Modells/Datensatzes) und dem Testverlust eines großen Sprachmodells gemäß einem Potenzgesetz. Allerdings ist dasDie Art dieser Beziehung wird oft missverstanden. Die Vorstellung, dass ein logarithmisches Wachstum der Datenverarbeitung zu exponentiellen Leistungssteigerungen führt, ist ein Mythos. Das Gesetz der Skala sieht eher nach exponentiellem Verfall aus, was bedeutet, dass wir mit der Zeit härter arbeiten müssen, um weitere Leistungssteigerungen zu erzielen; siehe unten.

(Quelle [5])

"Praktiker verwenden in der Regel die nachgelagerte Benchmark-Genauigkeit als Indikator für die Qualität des Modells und nicht den Verlust des Perplexitätsbewertungssatzes." - Quelle [7]

Definieren Sie Leistung.Wie können wir messen, ob sich das Big Language Model verbessert? Aus der Perspektive des Skalengesetzes wird die Leistung eines großen Sprachmodells in der Regel anhand des Testverlusts des Modells während des Pre-Trainings gemessen, aber die Auswirkung eines geringeren Testverlusts auf die Fähigkeit eines großen Sprachmodells ist nicht klar.Führen geringere Verluste zu einer höheren Genauigkeit bei nachgelagerten Aufgaben? Führen geringere Verluste zu neuen Möglichkeiten für große Sprachmodelle? Es besteht eine Diskrepanz zwischen dem, was uns das Skalengesetz sagt, und dem, was uns tatsächlich interessiert:

- Das Gesetz der Größe besagt, dass eine Vergrößerung des Pre-Trainings den Testverlust bei großen Sprachmodellen allmählich verringert.

- Unser Anliegen ist es, ein "besseres" Modell der größeren Sprache zu erhalten.

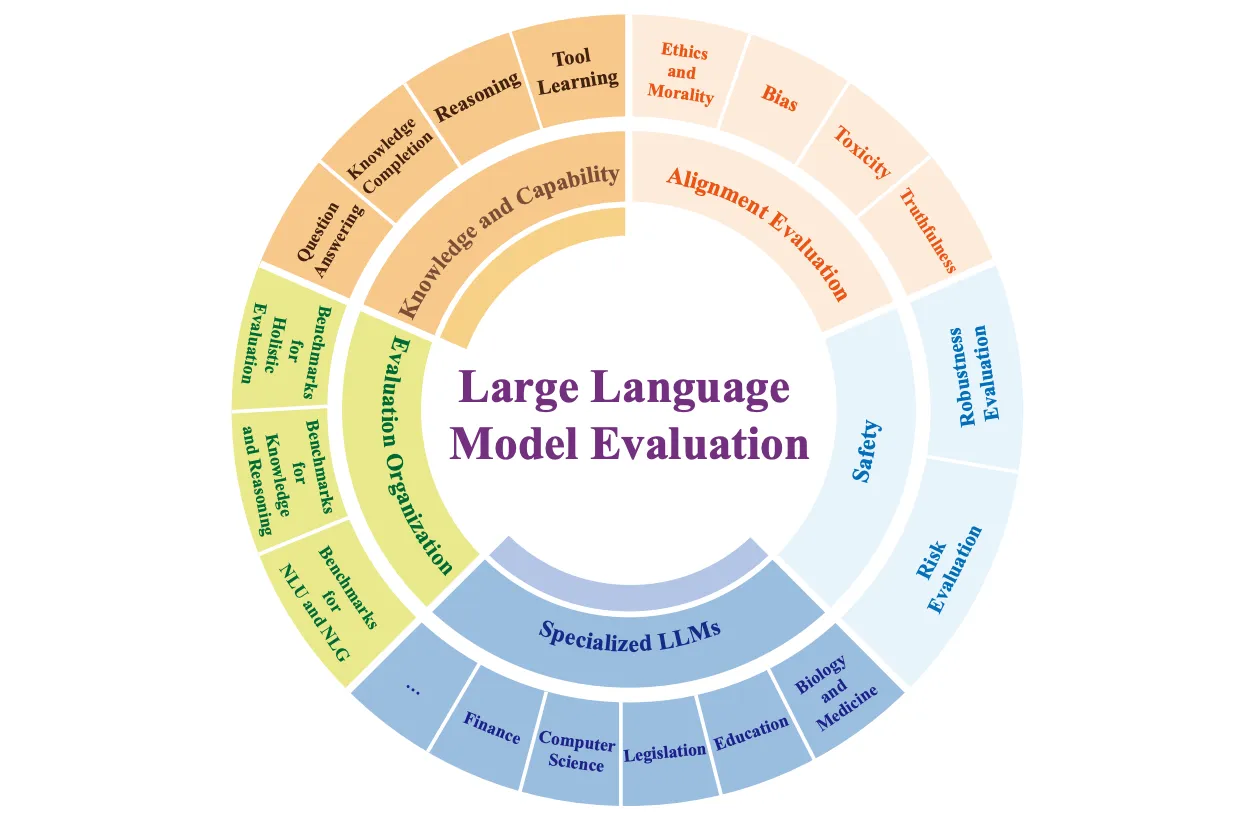

Es hängt davon ab, wer Sie sind und was Sie von einem neuen KI-System erwarten.und die Methoden, die Sie zur Bewertung dieser neuen Systeme verwendet haben-werden sehr unterschiedlich sein. Gewöhnliche KI-Benutzer konzentrieren sich in der Regel auf allgemeine Chat-Anwendungen, während Praktiker sich oft um die Leistung großer Sprachmodelle bei nachgelagerten Aufgaben kümmern. Im Gegensatz dazu scheinen Forscher in Spitzenlaboratorien hohe (und sehr spezifische) Erwartungen an KI-Systeme zu haben, z. B. das Schreiben von Doktorarbeiten oder das Lösen fortgeschrittener mathematischer Probleme. Angesichts des breiten Spektrums an Fähigkeiten, die schwer zu bewerten sind, gibt es viele Möglichkeiten, die Leistung großer Sprachmodelle zu betrachten; siehe unten.

(Quelle [15])

Datenuntergang.Um das Pretraining großer Sprachmodelle zu skalieren, müssen wir sowohl die Größe des Modells als auch die des Datensatzes erhöhen. Frühe Forschungsarbeiten [1] scheinen darauf hinzudeuten, dass die Datenmenge weniger wichtig ist als die Größe des Modells, aber wir sehen in Chinchilla [6], dass die Größe des Datensatzes ebenso wichtig ist. Darüber hinaus deuten neuere Arbeiten darauf hin, dass die meisten Forscher es vorziehen, ihre Modelle zu "übertrainieren".oder sie mit Datensätzen trainieren, deren Größe die Optimalität von Chinchilla übersteigt-um Inferenzkosten zu sparen [7].

"Scale-up-Studien konzentrieren sich oft auf die Berechnung optimaler Trainingsmechanismen ...... Da größere Modelle teurer sind, ist es heute üblich, kleinere Modelle zu übertrainieren." - Quelle [7]

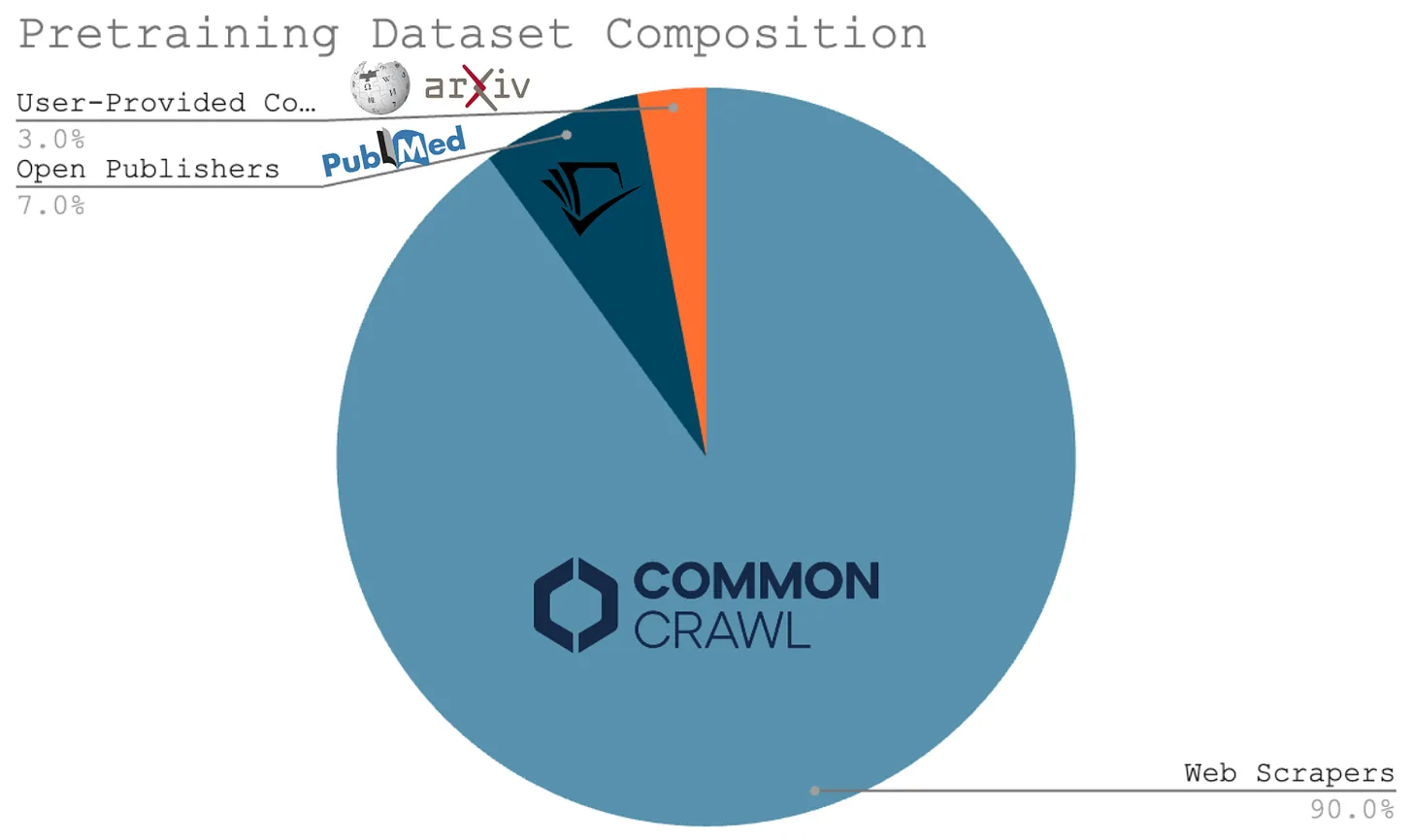

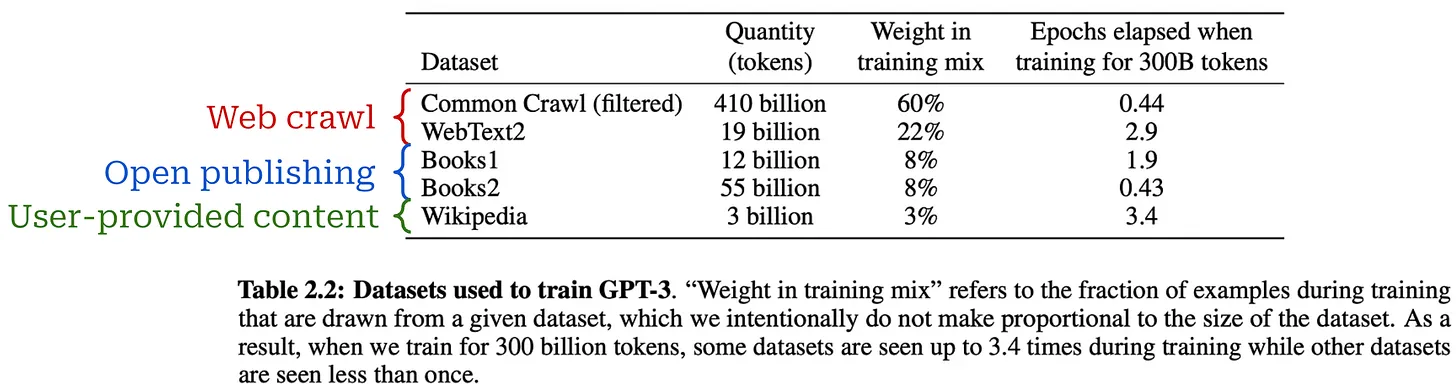

All diese Studien führen uns zu einer einfachen Schlussfolgerung - dieDie Erweiterung der Big Language Models Pre-Training erfordert die Erstellung größerer Pre-Training-DatensätzeDiese Tatsache stellt einen der Hauptkritikpunkte am Größengesetz für große Sprachmodelle dar. Diese Tatsache ist einer der Hauptkritikpunkte am Gesetz der Größe für große Sprachmodelle. Viele Forscher haben argumentiert, dass möglicherweise nicht genügend Daten vorhanden sind, um den Pre-Trainingsprozess weiter zu skalieren. Zum Hintergrund: Der größte Teil der für das aktuelle Big Language Model verwendeten Pre-Training-Daten wurde durch Web-Crawling gewonnen (siehe unten). Angesichts der Tatsache, dass wir nur ein Internet haben, könnte es schwierig sein, völlig neue Quellen für groß angelegte, qualitativ hochwertige Vorübungsdaten zu finden.

Sogar Ilya Sutskever hat kürzlich dieses Argument vorgebracht und behauptet, dass i) Die Datenverarbeitung wächst schnell, aber ii) Die Daten sind nicht gewachsen, weil wir uns auf das Crawling im Internet verlassen. Daher argumentiert er, dass wir den Pre-Training-Prozess nicht ewig weiter ausbauen können. Das Pre-Training, wie wir es kennen, wird zu Ende gehen, und wir müssen neue Wege finden, um die KI-Forschung voranzubringen. Mit anderen Worten."Wir haben den Höhepunkt der Datenmenge erreicht.".

Vorbildungsskala der nächsten Generation

Die Skalierung wird schließlich zu abnehmenden Erträgen führen, und die datenzentrierten Argumente gegen eine fortgesetzte Skalierung sind sowohl vernünftig als auch überzeugend. Es gibt jedoch noch mehrere Forschungsrichtungen, die den Pre-Trainingsprozess verbessern könnten.

Synthetische Daten.Um den Pre-Training-Prozess um mehrere Größenordnungen zu steigern, müssen wir uns möglicherweise auf synthetisch generierte Daten stützen. Trotz der Bedenken, dass ein übermäßiger Rückgriff auf synthetische Daten zu Diversitätsproblemen führen kann [14], werden große Sprachmodelle zunehmendUnd es scheint gelungen zu sein--unter Verwendung synthetischer Daten [12]. Darüber hinaus haben Kurslernen [13] und kontinuierliche Pre-Training-Strategien zu verschiedenen sinnvollen Verbesserungen geführt, indem die Pre-Training-Daten angepasst wurden, z. B. durch Änderung des Datenmixes oder Hinzufügen von Instruktionsdaten am Ende des Pre-Trainings.

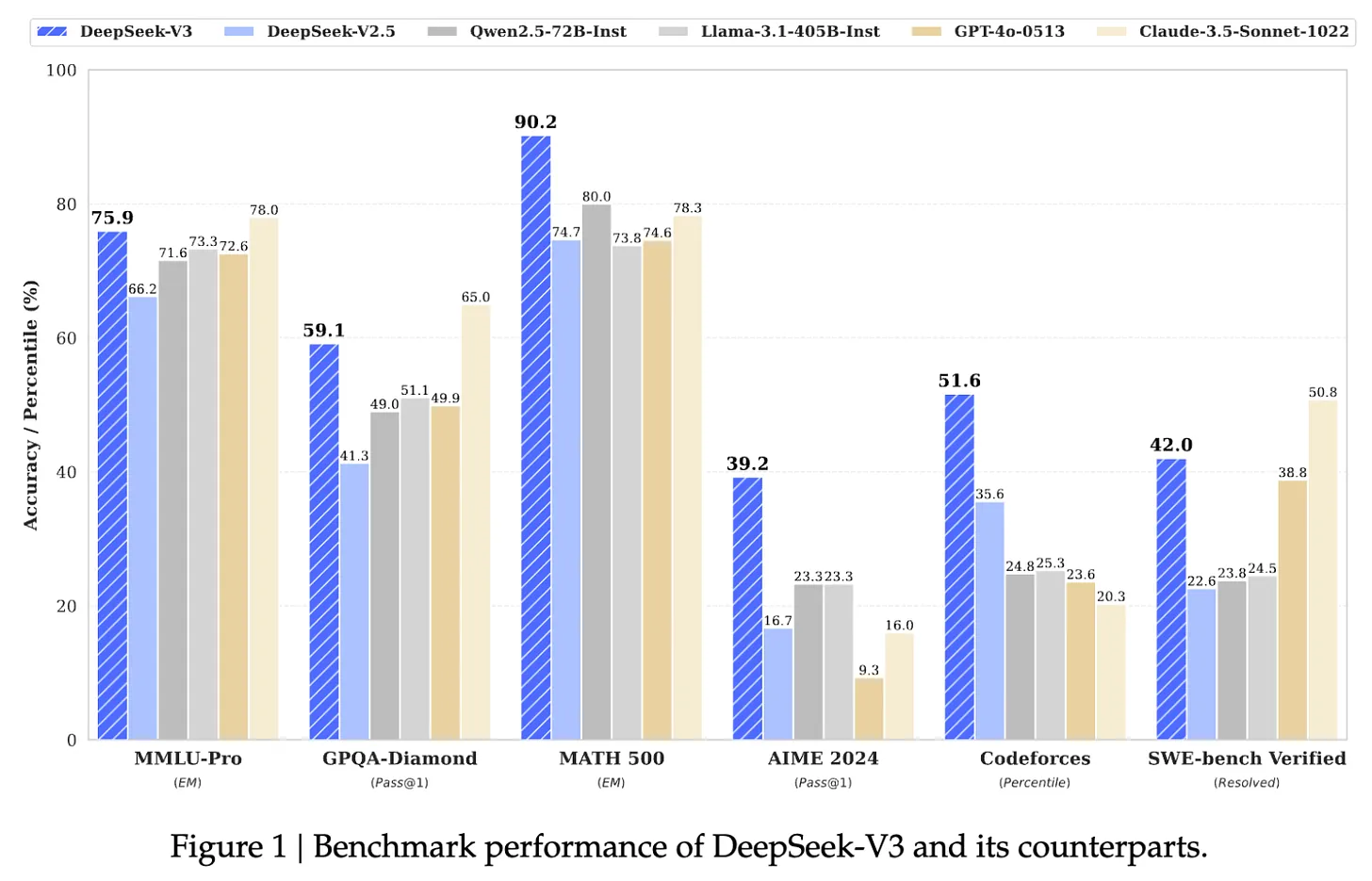

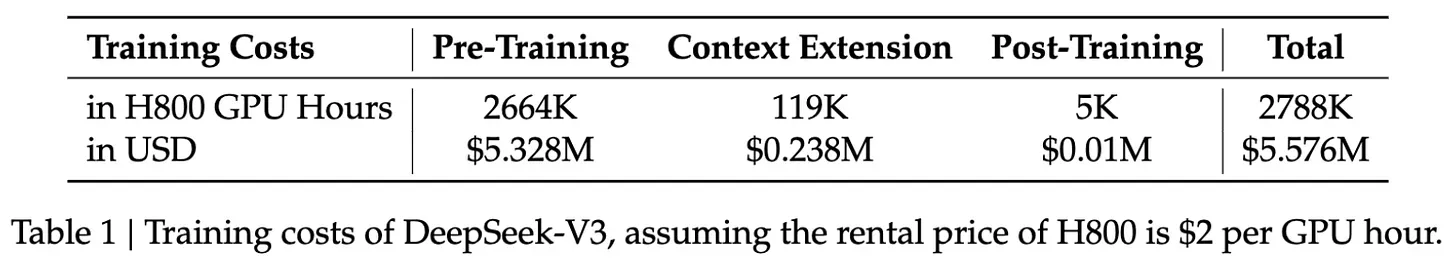

(Quelle [7])

DeepSeek-v3.Trotz der jüngsten Debatten gibt es immer wieder Fortschritte bei der Erweiterung des Pre-Training-Prozesses für große Sprachmodelle. Die jüngste Veröffentlichung von DeepSeek-v3 [18] zum Beispiel - dieA 671 Milliarden Parameter12 (MoE)-Modell. Das Modell ist nicht nur quelloffen, sondern wurde auch mit 14,8 Billionen Token-Texten trainiert und übertraf sowohl GPT-4o als auch Claude-3.5-Sonnet; siehe die Abbildung unten für die Leistung des Modells und hier für die Lizenz. Zum Vergleich: Das LLaMA-3-Modell wurde anhand von über 15 Billionen Rohtextdaten trainiert; weitere Einzelheiten finden Sie hier.

(Quelle [18])

- Optimierte MoE-Architektur von DeepSeek-v2.

- Eine neue ungestützte Verluststrategie für den Lastausgleich MoE.

- Multi-Token-Vorhersage von Trainingszielen.

- Verfeinerung der Schlussfolgerungsfähigkeiten aus langen Gedankenkettenmodellen (d.h. ähnlich wie bei OpenAIs o1).

Das Modell wurde auch nachtrainiert, einschließlich überwachter Feinabstimmung und Verstärkungslernen aus menschlichem Feedback, um es an die menschlichen Vorlieben anzupassen.

"Wir haben DeepSeek-V3 mit 14,8 Billionen hochwertigen und vielfältigen Token trainiert. Der Pre-Trainingsprozess war sehr stabil. Wir haben während des gesamten Trainingsprozesses keine unwiederbringlichen Verlustspitzen erlebt und mussten auch kein Rollback durchführen." - Quelle [8]

Der größte Schlüssel zur beeindruckenden Leistung von DeepSeek-v3 ist jedoch die Pre-Trainingsskala - dieDies ist ein großes Modell, das mit einem ebenso großen Datensatz trainiert wurde.DeepSeek-v3 hat einen erstaunlich stabilen Pre-Trainingsprozess und folgt dem Standard für große Sprachmodelle zu sehr geringen Kosten! Das Training eines so großen Modells ist aus verschiedenen Gründen schwierig (z. B. GPU-Ausfälle und Verlustspitzen). DeepSeek-v3 hat einen erstaunlich stabilen Pre-Trainingsprozess und wird zu angemessenen Kosten nach dem Large Language Model-Standard trainiert; siehe unten.Diese Ergebnisse deuten darauf hin, dass größere Vorübungen mit der Zeit überschaubarer und effizienter werden.

(Quelle [18])

- Größere Computercluster13.

- Mehr (und bessere) Hardware.

- Eine Menge Energie.

- neue Algorithmen (z. B. für verteiltes Training in größerem Umfang).

Die Ausbildung von Modellen der nächsten Generation ist nicht nur eine Frage der Finanzierung von mehr GPUs, sondern eine multidisziplinäre technische Leistung. Ein solch komplexes Unterfangen braucht Zeit. Zum Vergleich: GPT-4 wurde im März 2023 veröffentlicht, fast drei Jahre nach der Veröffentlichung von GPT-3 - demInsbesondere, 33 Monate. Eine ähnliche Zeitspanne (wenn nicht länger) kann vernünftigerweise erwartet werden, um eine weitere 10-100-fache Steigerung des Umfangs zu erreichen.

"Für jede Größenordnung des Wachstums müssen andere Innovationen gefunden werden". - Ege Erdil (Epoche AI)

Die Zukunft der KI-Forschung

Nachdem wir nun ein tieferes Verständnis für den Stand des Pre-Trainings im großen Maßstab haben, lassen Sie uns (nur für die Zwecke dieser Diskussion) annehmen, dass die Pre-Training-Forschung plötzlich gegen eine Wand stößt. Selbst wenn sich die Modellfähigkeiten in naher Zukunft überhaupt nicht verbessern, gibt es eine Reihe von Möglichkeiten, wie sich die KI-Forschung schnell weiterentwickeln kann. Einige dieser Themen haben wir bereits erörtert (z. B. synthetische Daten). In diesem Abschnitt werden wir uns auf zwei derzeit beliebte Themen konzentrieren:

- Große Sprachmodelle System/Agent.

- Modelle für die Argumentation.

Aufbau eines nützlichen Systems zur Modellierung großer Sprachen

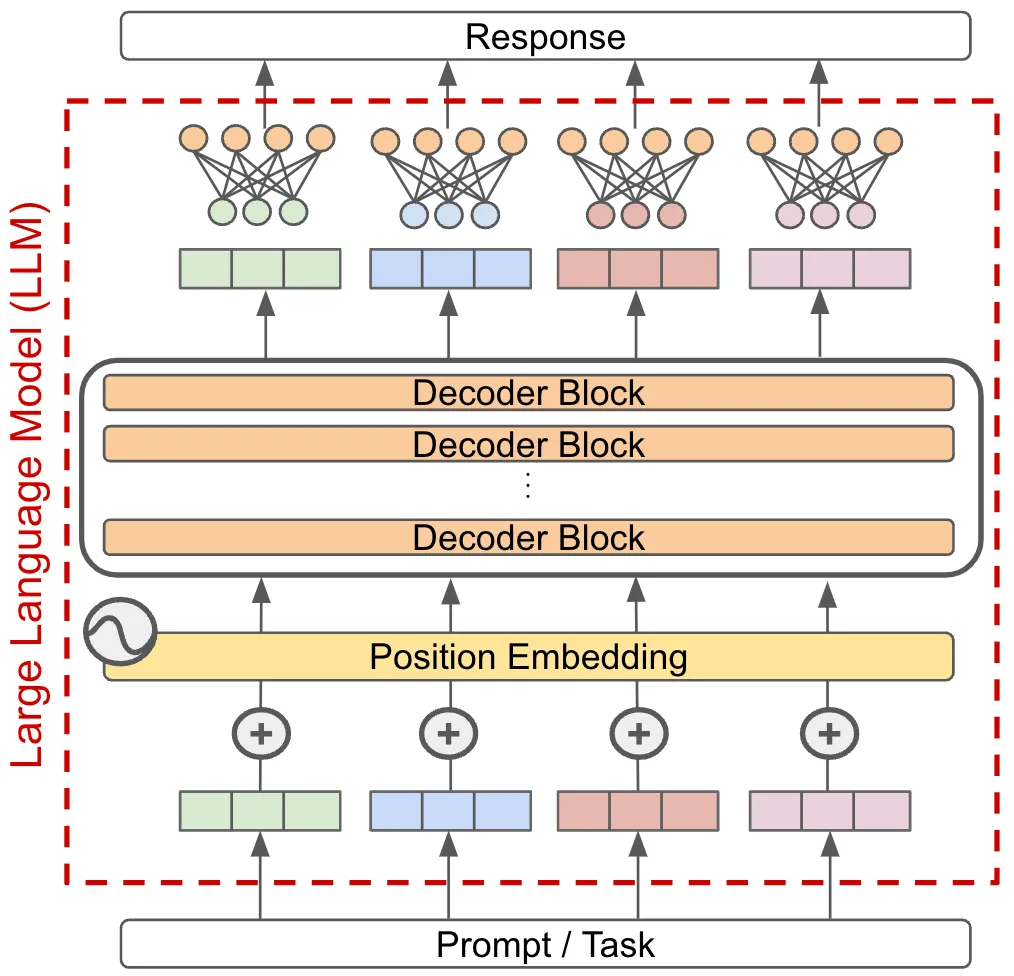

Die meisten Anwendungen, die sich auf Big Language Models stützen, arbeiten heute nach dem Ein-Modell-Paradigma. Mit anderen Worten, wir lösen eine Aufgabe, indem wir sie an ein einziges Big Language Model übergeben und die Ausgabe des Modells direkt als Antwort auf diese Aufgabe verwenden; siehe unten.

Wenn wir ein solches System verbessern wollten (d. h. schwierigere Aufgaben mit größerer Genauigkeit lösen), könnten wir einfach die Fähigkeiten des zugrunde liegenden Modells verbessern, aber dieser Ansatz beruht auf der Erstellung leistungsfähigerer Modelle. Stattdessen können wir über das Ein-Modell-Paradigma hinausgehen, indem wir ein System aufbauen, das auf einem großsprachlichen Modell basiert, das mehrere großsprachige Modelle kombiniert - dasoder andere Komponente-- zur Lösung komplexer Aufgaben.

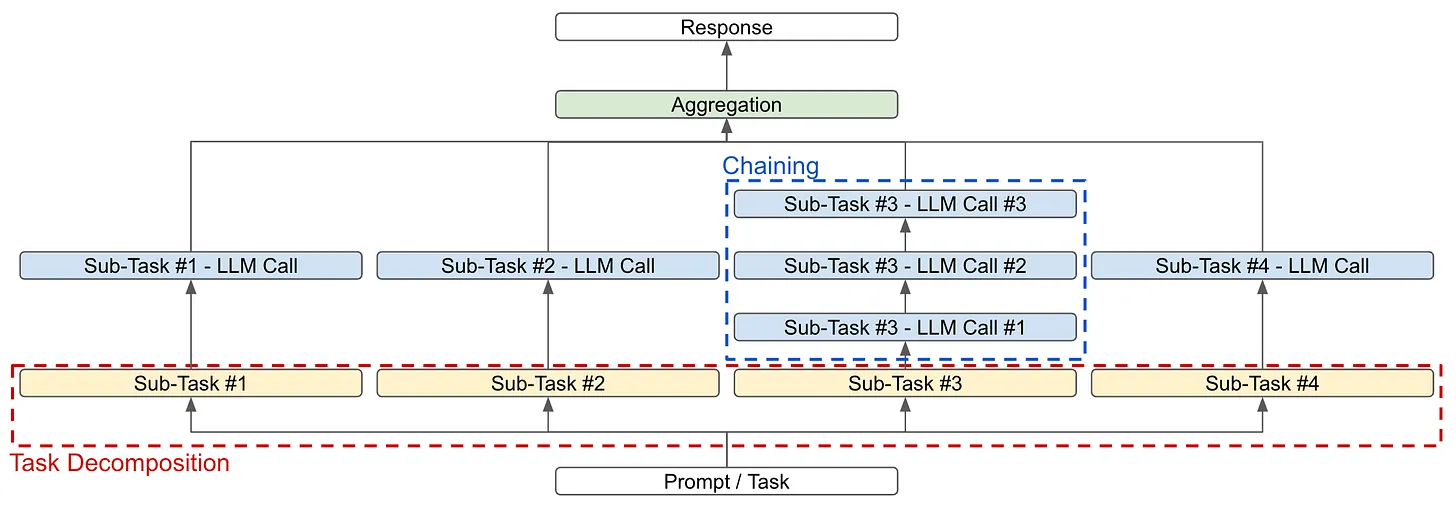

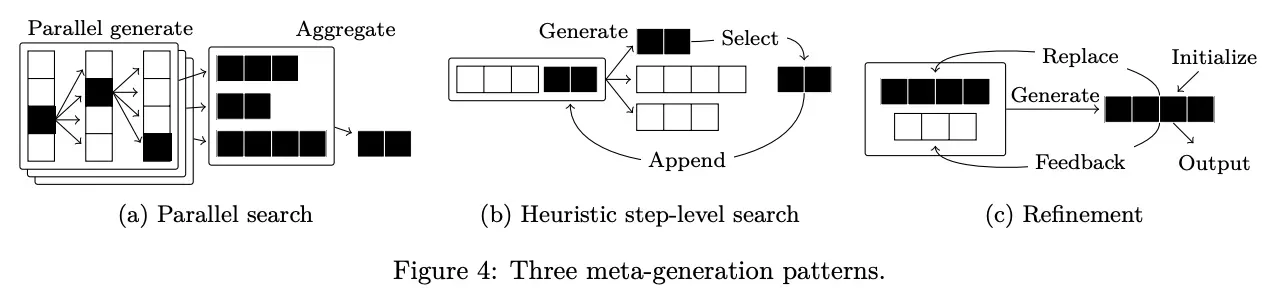

Grundlagen des Systems zur Modellierung großer Sprachen. Das Ziel eines Big Language Model-Systems besteht darin, komplexe Aufgaben in kleinere Teile zu zerlegen, die vom Big Language Model oder anderen Modulen leichter gelöst werden können. Es gibt zwei Hauptstrategien, die zur Erreichung dieses Ziels verwendet werden können (wie in der Abbildung oben dargestellt):

- Aufschlüsselung der AufgabenZerlegen Sie die eigentliche Aufgabe in kleinere Teilaufgaben, die einzeln gelöst und später14 zu einer endgültigen Antwort zusammengefügt werden können.

- Link (auf einer Website)Lösen von Aufgaben oder Teilaufgaben durch mehrere aufeinander folgende Aufrufe des großen Sprachmodells anstelle eines einzigen Aufrufs.

Diese Strategien können einzeln oder in Kombination eingesetzt werden. Nehmen wir zum Beispiel an, wir wollen ein System für die Zusammenfassung von Büchern entwickeln. Zu diesem Zweck können wir die Aufgabe aufteilen, indem wir zunächst jedes Kapitel des Buches zusammenfassen. Von hier aus können wir:

- Fassen Sie die Aufgabe zusammen, indem Sie sie weiter in kleinere Textabschnitte untergliedern (d. h. ähnlich wie bei der rekursiven/hierarchischen Zerlegung).

- Verknüpfen Sie mehrere LM-Aufrufe miteinander; lassen Sie z. B. ein LM alle wichtigen Fakten oder Informationen eines Kapitels extrahieren, und lassen Sie ein anderes LM auf der Grundlage dieser Schlüsselfakten eine Kapitelzusammenfassung erstellen.

Wir können diese Ergebnisse dann zusammenfassen, indem wir das Big Language Model die verbundenen Kapitelzusammenfassungen zu einer Zusammenfassung des gesamten Romans zusammenfassen lassen. Die Tatsache, dass die meisten komplexen Aufgaben in einfache Teile zerlegt werden können, die leicht zu lösen sind, macht solche großen Sprachmodellierungssysteme sehr leistungsfähig. Wenn wir eine umfangreichere Zerlegung und Verknüpfung vornehmen, können diese Systeme sehr komplex werden, was sie zu einem interessanten (und einflussreichen) Bereich der angewandten KI-Forschung macht.

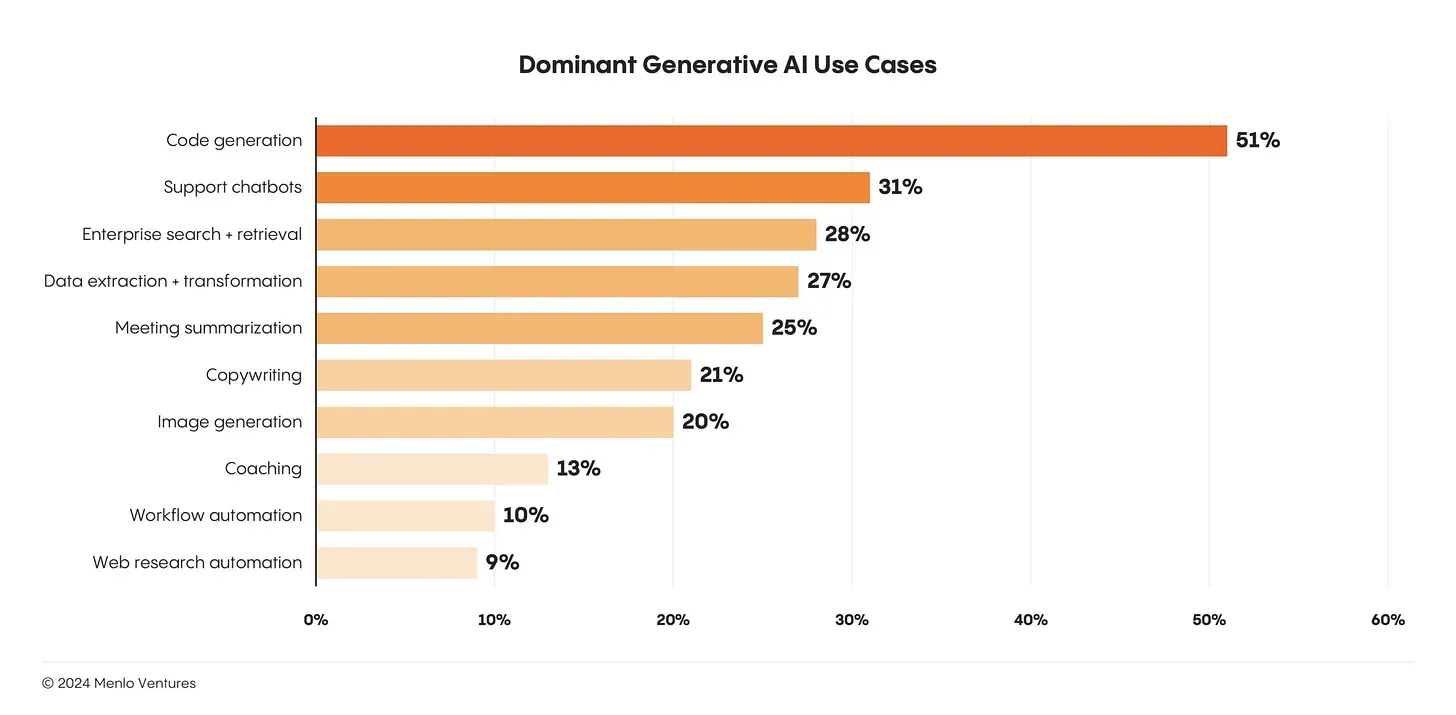

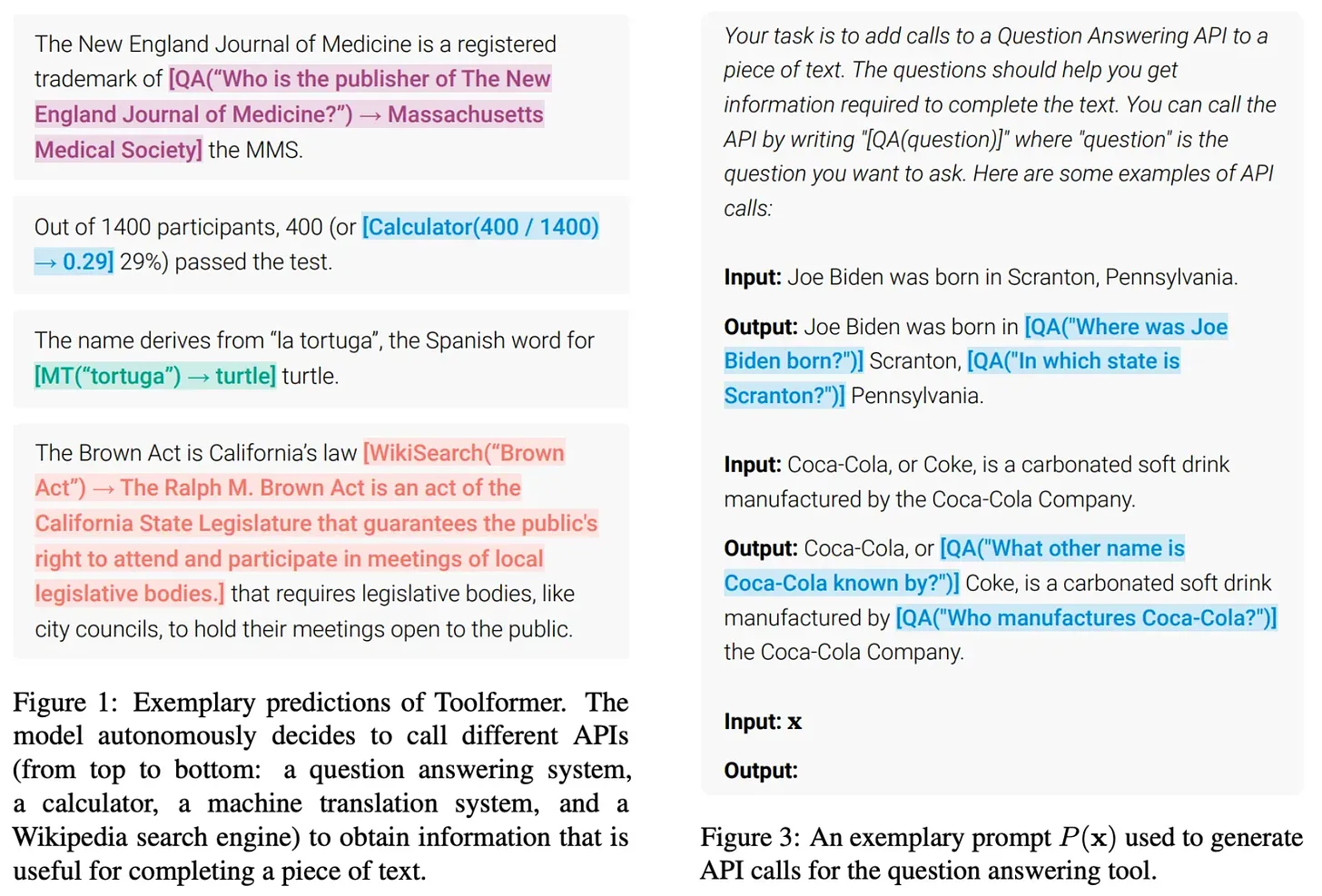

Aufbau von Produkten auf der Grundlage des Big Language Model.Trotz des Erfolgs und der Beliebtheit des Big Language Model ist die Zahl der tatsächlichen (und weit verbreiteten) Anwendungsfälle für das Big Language Model noch sehr gering. Heute sind die größten Anwendungsfälle des Big Language Model die Codegenerierung und der Chat, beides relativ offensichtliche Anwendungen des Big Language Model15 ; siehe unten.

Da es so viele Anwendungsbereiche für die Modellierung großer Sprachen gibt.Die Entwicklung wirklich nützlicher Produkte auf der Grundlage großer Sprachmodelle ist ein wichtiger Bereich der angewandten KI-Forschung. Sehr leistungsfähige Modelle stehen uns bereits zur Verfügung, aber sie für die Entwicklung von Produkten zu nutzen, die sich lohnen, ist ein ganz anderes Problem. Um dieses Problem zu lösen, muss man lernen, wie man zuverlässige und leistungsstarke Systeme zur Modellierung großer Sprachen erstellt.

(Quelle [19])

Robustheitist eines der größten Hindernisse beim Aufbau leistungsfähigerer Big Language Models/Agentensysteme. Angenommen, wir haben ein Big Language Model-System, das zehn verschiedene Aufrufe an das Big Language Model macht. Nehmen wir weiter an, dass jeder Aufruf des großen Sprachmodells eine Erfolgswahrscheinlichkeit von 95% hat und dass alle Aufrufe erfolgreich sein müssen, um die richtige Endausgabe zu erzeugen. Obwohl die einzelnen Komponenten des Systems einigermaßen genau sind, ist dieDie Erfolgsquote des gesamten Systems beträgt jedoch nur 60%!

(Quelle [20])

(Quelle [20])

Begründungsmodelle und neue Skalierungsparadigmen

Eine gängige Kritik an frühen großen Sprachmodellen lautete, dass sie lediglich Daten speichern und wenig logisch denken können. Die Behauptung, dass große Sprachmodelle nicht in der Lage sind, Schlussfolgerungen zu ziehen, wurde jedoch in den letzten Jahren weitgehend widerlegt. Aus neueren Forschungsarbeiten wissen wir, dass diese Modelle möglicherweise schon immer über eine inhärente Fähigkeit zum logischen Denken verfügten, aber wir mussten die richtigen Hinweise oder Trainingsmethoden verwenden, um diese Fähigkeit hervorzurufen.

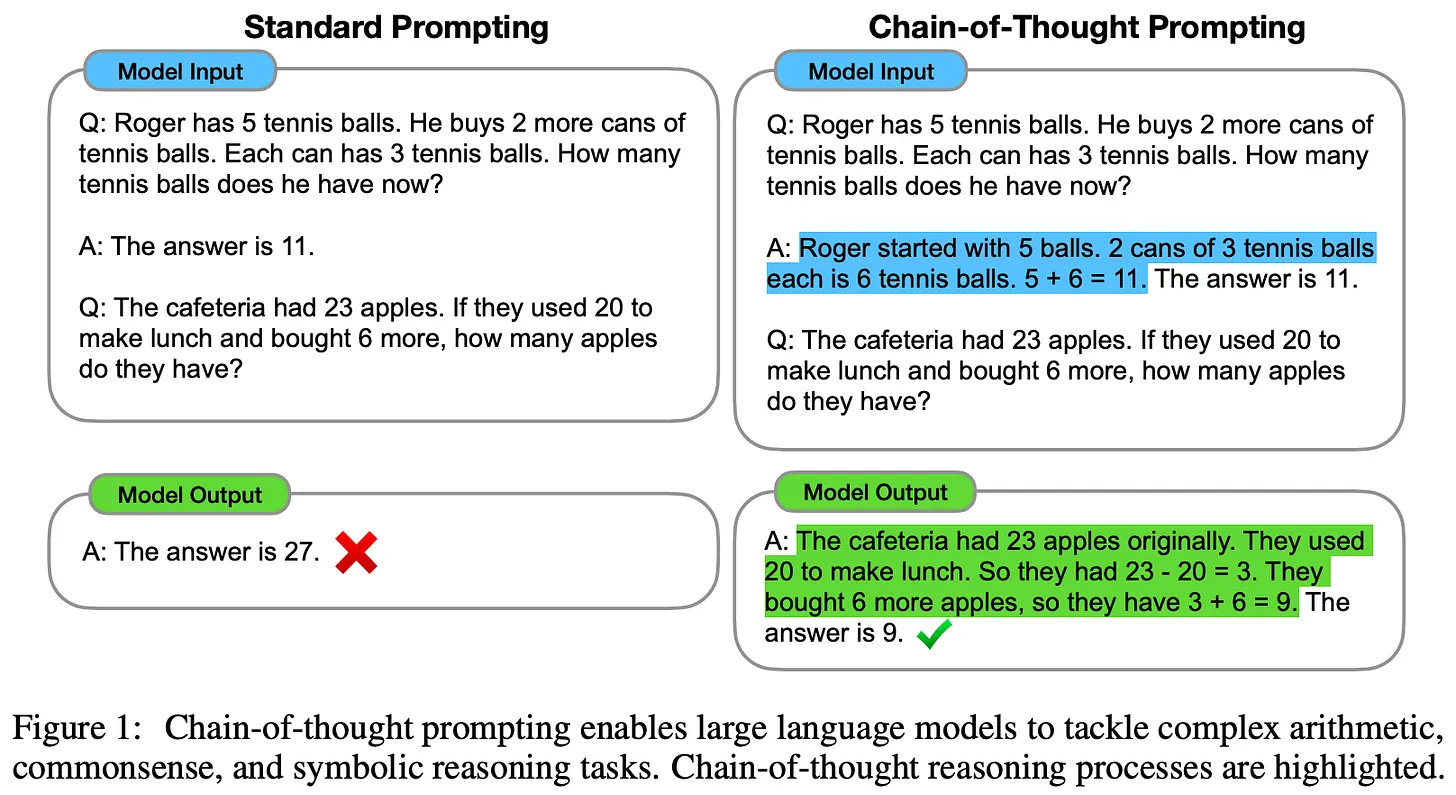

Tipps zur Gedankenkette (CoT) [22] war eine der ersten Techniken, die die Inferenzfähigkeit eines großen Sprachmodells demonstrierte. Die Methode ist einfach und basiert auf Hinweisen. Wir fordern das große Sprachmodell einfach auf, eine Erklärung für seine Antwort zu liefern, bevor wir die eigentliche Antwort generieren; weitere Einzelheiten finden Sie hier. Die Argumentationsfähigkeit des großen Sprachmodells verbessert sich erheblich, wenn es eine Begründung liefert, die den Schritt-für-Schritt-Prozess umreißt, mit dem es zu einer Antwort gelangt ist. Darüber hinaus sind solche Erklärungen für den Menschen lesbar und können die Ausgabe des Modells besser interpretierbar machen!

(Quelle [22])

- Class Large Language Models - Judge Evaluation Modelle liefern in der Regel die Grundlage für die Bewertung, bevor die endgültigen Bewertungsergebnisse erstellt werden [23, 24].

- Es wurden überwachte Feinabstimmungs- und Instruktionsabstimmungsstrategien vorgeschlagen, um kleineren/offenen großen Sprachmodellen beizubringen, bessere Gedankenketten zu schreiben [25, 26].

- Große Sprachmodelle werden häufig aufgefordert, ihre eigenen Ergebnisse zu reflektieren, zu kommentieren oder zu validieren und ihre Ergebnisse dann auf der Grundlage dieser Informationen zu ändern [12, 27].

Komplexes Reasoning ist ein aktives Forschungsthema und entwickelt sich rasch weiter. Neue Trainingsalgorithmen, die großen Sprachmodellen beibringen, (schrittweise) Verifikation [28, 29] in ihren Schlussfolgerungsprozess einzubauen, haben vielversprechende Ergebnisse gezeigt, und wir werden wahrscheinlich weiterhin Verbesserungen sehen, wenn neue und bessere Trainingsstrategien verfügbar werden.

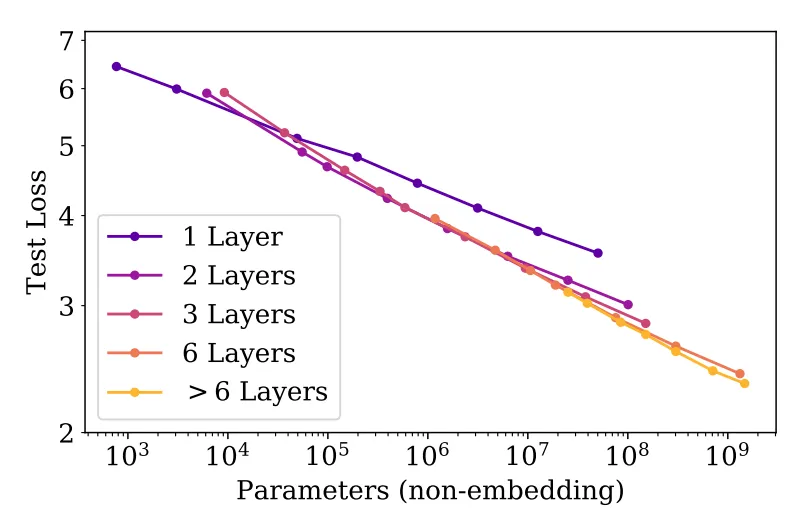

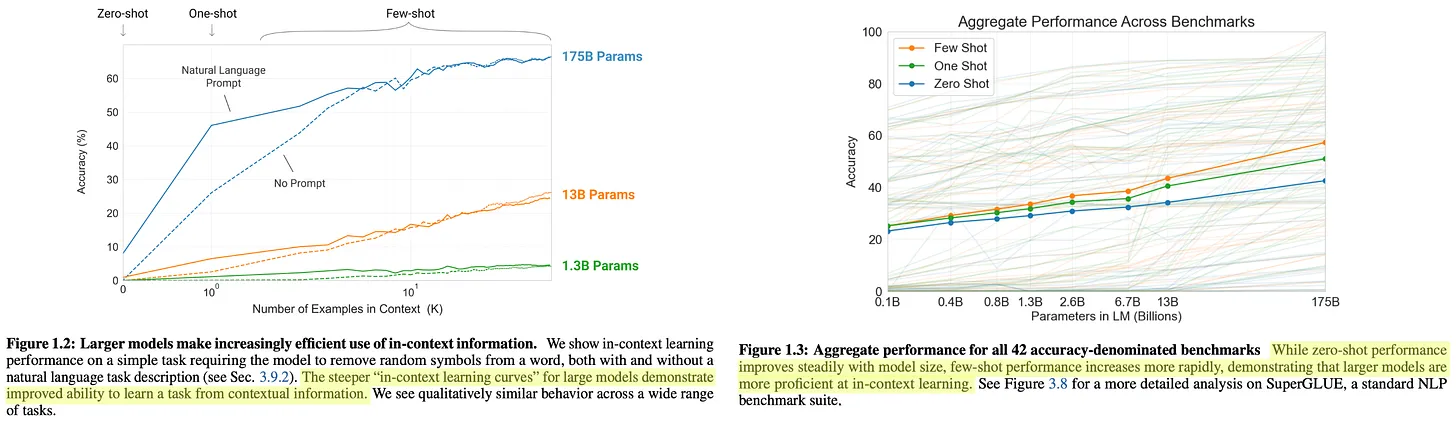

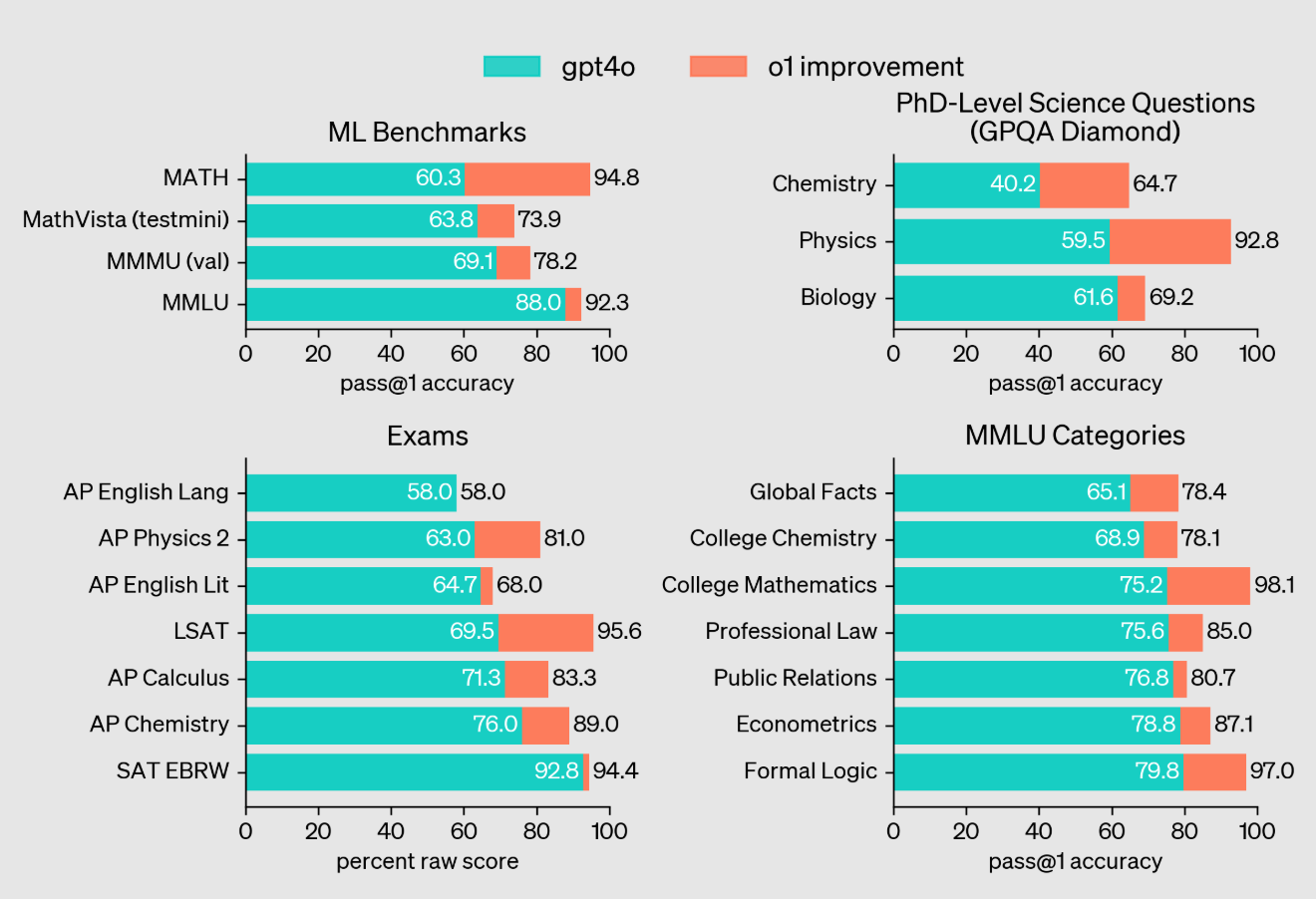

Das o1-Inferenzmodell von OpenAI [21] stellt einen bedeutenden Fortschritt in den Argumentationsfähigkeiten des Big Language Model dar. o1 verwendet Argumentationsstrategien, die stark auf Gedankenketten beruhen. Ähnlich wie der Mensch vor der Beantwortung einer Frage nachdenkt, nimmt sich o1 Zeit zum "Denken", bevor es eine Antwort gibt. Tatsächlich ist das "Denken", das o1 erzeugt, einfach eine lange Gedankenkette, die das Modell nutzt, um über das Problem nachzudenken, es in einfachere Schritte zu zerlegen, verschiedene Lösungsansätze auszuprobieren und sogar seine eigenen Fehler zu korrigieren16 .

"OpenAI o1 [ist] ein neues, groß angelegtes Sprachmodell, das darauf trainiert ist, mit Hilfe von Reinforcement Learning komplexe Schlussfolgerungen zu ziehen. o1 denkt, bevor es antwortet - es kann eine lange interne Gedankenkette erzeugen, bevor es dem Benutzer antwortet." - Quelle [21]

Einzelheiten über die genaue Trainingsstrategie von o1 wurden nicht öffentlich bekannt gegeben. Wir wissen jedoch, dass o1 mit einem "groß angelegten Verstärkungslernalgorithmus" lernt, der "die Daten sehr effizient nutzt" und sich auf die Verbesserung der Fähigkeit des Modells konzentriert, nützliche Gedankenketten zu erzeugen. Basierend auf öffentlichen Kommentaren von OpenAI-Forschern und jüngsten Aussagen über o1 scheint es, dass das Modell mit reinem Reinforcement Learning trainiert wurde, was früheren Andeutungen widerspricht, dass o1 eine Form von Baumsuche für seine Schlussfolgerungen verwendet haben könnte.

Vergleich von GPT-4o und o1 bei inferenzlastigen Aufgaben (Quelle [21])

- Top 89% in Competitive Programming Problems bei Codeforces.

- Platzierung unter den 500 besten Schülern in den Vereinigten Staaten in den Qualifikationsrunden der Amerikanischen Mathematik-Olympiade (AIME).

- Übertrifft die Genauigkeit menschlicher Doktoranden bei Fragen zu Physik, Biologie und Chemie auf Hochschulniveau (GPQA).

(Quelle [22])

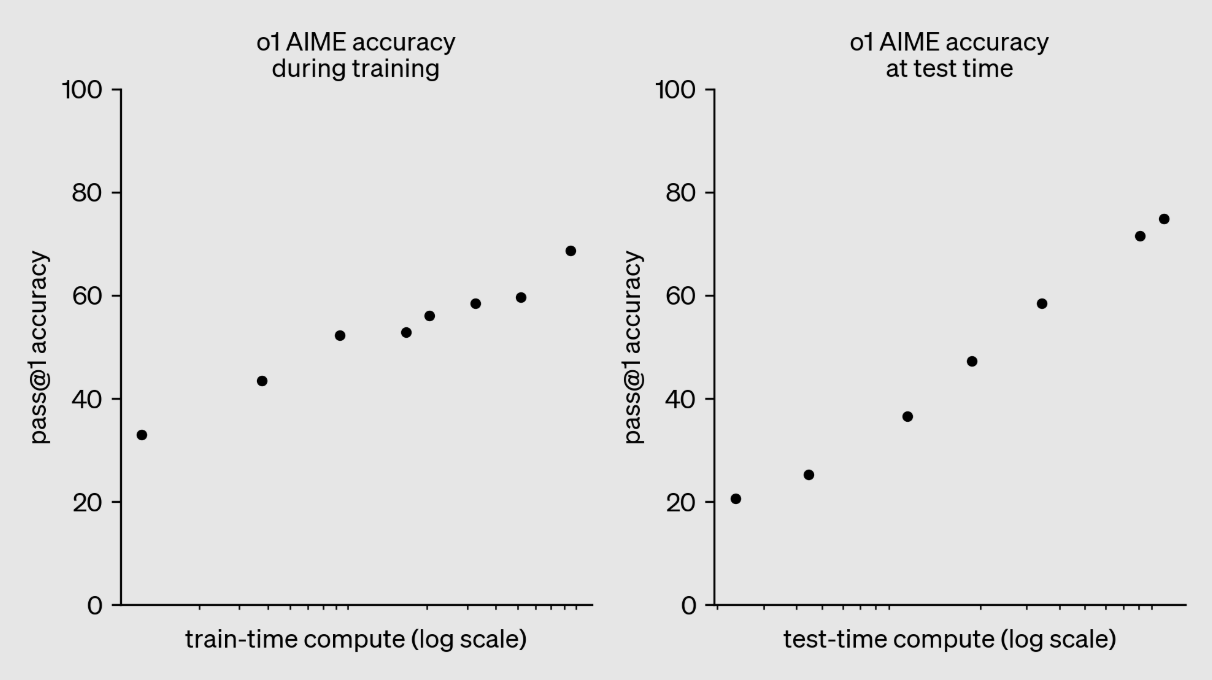

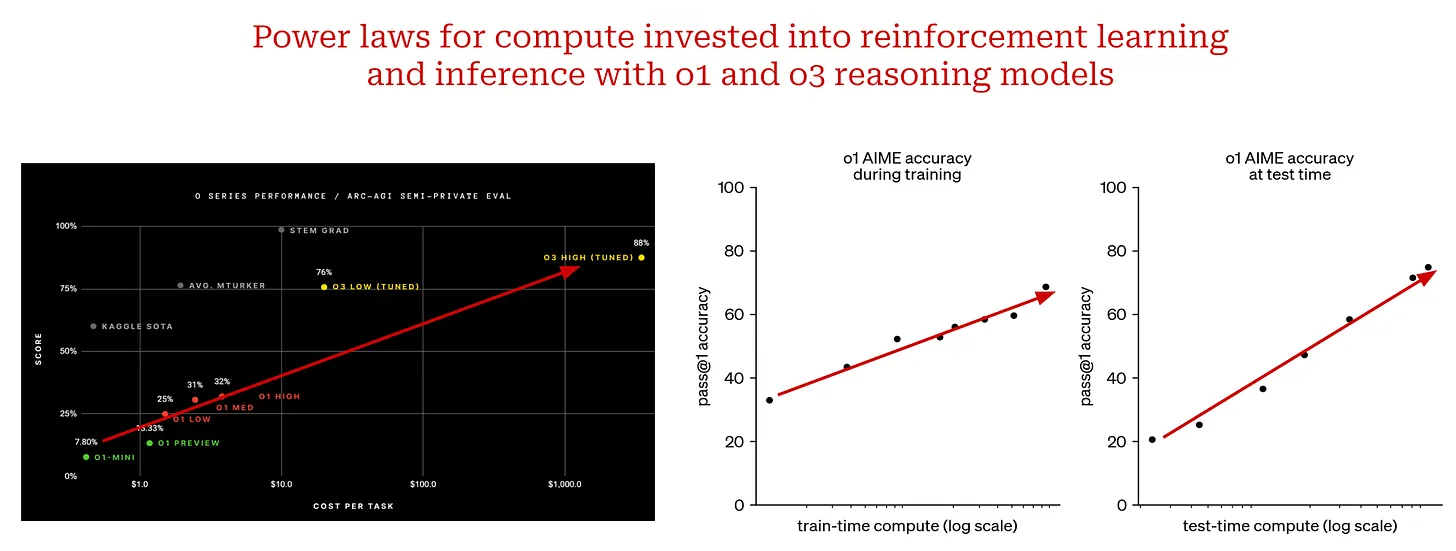

"Wir fanden heraus, dass sich die Leistung von o1 mit mehr Verstärkungslernen (berechnet während des Trainings) und mehr Denkzeit (berechnet während des Tests) weiter verbesserte." - Quelle [22]

In ähnlicher Weise sehen wir im obigen Diagramm, dass sich die Leistung von o1 gleichmäßig verbessert, wenn wir mehr Rechenleistung in das Training durch verstärkendes Lernen investieren. Dies ist genau der Ansatz, der bei der Erstellung des o3-Inferenzmodells verfolgt wurde. Das Modell wurde Ende 2024 von OpenAI evaluiert, und es wurden nur sehr wenige Details über o3 veröffentlicht. Da das Modell jedoch so schnell nach o1 veröffentlicht wurde (d. h. drei Monate später), ist es wahrscheinlich, dass es sich bei o3 um eine "aufgestockte" Version von o1 handelt, bei der mehr Rechenleistung in das Verstärkungslernen investiert wird.

Zum Zeitpunkt der Erstellung dieses Berichts ist das Modell o3 noch nicht freigegeben, aber die Ergebnisse, die durch die Erweiterung von o1 erzielt wurden, sind beeindruckend (und in einigen Fällen schockierend). Die bemerkenswertesten Errungenschaften von o3 sind im Folgenden aufgeführt:

- erzielte 87,5% beim ARC-AGI-Benchmark, verglichen mit der Genauigkeit von GPT-4o von 5%. o3 war das erste Modell, das die menschliche Leistung von 85% bei ARC-AGI übertraf. Der Benchmark wurde als der "Nordstern" der AGI bezeichnet und ist seit über fünf Jahren unbesiegt17 .

- Mit einer Genauigkeit von 71,7% auf SWE-Bench Verified und einer Elo-Punktzahl von 2727 auf Codeforces gehört o3 zu den 200 besten menschlichen Programmierern der Welt.

- mit einer Genauigkeit von 25,2% beim FrontierMath-Benchmark von EpochAI.Verbesserte Genauigkeit auf dem neuesten Stand der Technik im Vergleich zur vorherigen Version 2.0%Der Benchmark wurde von Terence Tao als "extrem schwierig" und wahrscheinlich unlösbar durch KI-Systeme "für mindestens ein paar Jahre" beschrieben. Der Benchmark wurde von Terence Tao als "extrem schwierig" beschrieben und dürfte von KI-Systemen "für mindestens einige Jahre" unlösbar sein.

Eine Lite-Version von o3, genannt o3-mini, wurde ebenfalls vorgestellt, die sehr gut funktioniert und erhebliche Verbesserungen bei der Rechenleistung bietet.

(Quelle [21] und hier sind)

- Trainingszeit (intensives Lernen) Berechnung.

- Berechnen Sie bei der Argumentation.

Die Skalierung von Modellen im Stil von o1 unterscheidet sich vom traditionellen Gesetz der Größe. Statt den Pre-Trainingsprozess zu skalieren, skalieren wir den Rechenaufwand für Post-Training und Inferenz.Es ist ein völlig neues Paradigma der SkalierungDie Ergebnisse, die durch die Erweiterung des Inferenzmodells erzielt wurden, waren bisher sehr gut. Diese Erkenntnis lässt vermuten, dass es über das Pre-Training hinaus weitere Möglichkeiten zur Erweiterung gibt. Mit dem Aufkommen von Inferenzmodellen haben wir den nächsten Berg entdeckt, den es zu erklimmen gilt. Auch wenn er in verschiedenen Formen auftreten kann, ist derSkalierung wird die Fortschritte in der KI-Forschung weiter vorantreiben.

Schlussbemerkungen

Wir haben nun ein klareres Bild von den Skalengesetzen, ihren Auswirkungen auf große Sprachmodelle und der zukünftigen Richtung der KI-Forschung. Wie wir gelernt haben, gibt es viele Faktoren, die zu der jüngsten Kritik an den Skalengesetzen beitragen:

- Der natürliche Verfall des Skalengesetzes.

- Die Erwartungen an die Kompetenz bei der Modellierung großer Sprachen waren sehr unterschiedlich.

- Verzögerungen bei groß angelegten, interdisziplinären Ingenieurarbeiten.

Dies sind berechtigte Fragen, dieKeiner von ihnen weist jedoch darauf hin, dass die Skalierung immer noch nicht wie erwartet funktioniert.. Die Investitionen in groß angelegte Vorschulungen werden (und sollten) fortgesetzt werden, aber Verbesserungen werden mit der Zeit immer schwieriger. Infolgedessen werden andere Entwicklungsrichtungen (z. B. Agenten und Inferenz) an Bedeutung gewinnen. Der Grundgedanke der Skalierung wird jedoch weiterhin eine große Rolle spielen, wenn wir in diese neuen Forschungsbereiche investieren. Ob wir weiter skalieren oder nicht, ist nicht die Frage.Die eigentliche Frage ist, worauf wir als Nächstes eingehen werden.

bibliographie

[1] Kaplan, Jared, et al. "Skalierungsgesetze für neuronale Sprachmodelle". arXiv-Vorabdruck arXiv:2001.08361 (2020).[2] Radford, Alec: "Improving language understanding by generative pre-training" (2018).[3] Radford, Alec, et al. "Language models are unsupervised multitask learners". OpenAI-Blog 1.8 (2019): 9.[4] Brown, Tom, et al. "Language models are few-shot learners". Fortschritte bei neuronalen Informationsverarbeitungssystemen 33 (2020): 1877-1901.[5] Achiam, Josh, et al. "Gpt-4 technischer Bericht". arXiv-Vorabdruck arXiv:2303.08774 (2023).[6] Hoffmann, Jordan, et al. "Training compute-optimaler großer Sprachmodelle". arXiv-Vorabdruck arXiv:2203.15556 (2022).[7] Gadre, Samir Yitzhak, et al. "Sprachmodelle skalieren zuverlässig mit Übertraining und bei nachgelagerten Aufgaben". arXiv-Vorabdruck arXiv:2403.08540 (2024).[8] Ouyang, Long, et al. "Training language models to follow instructions with human feedback". Fortschritte bei neuronalen Informationsverarbeitungssystemen 35 (2022): 27730-27744.[9] Smith, Shaden, et al. "Using deepspeed and megatron to train megatron-turing nlg 530b, a large-scale generative language model". arXiv-Vorabdruck arXiv:2201.11990 (2022).[10] Rae, Jack W., et al. "Scaling language models: methods, analysis & insights from training gopher". arXiv-Vorabdruck arXiv:2112.11446 (2021).[11] Bhagia, Akshita, et al. "Establishing Task Scaling Laws via Compute-Efficient Model Ladders". arXiv-Vorabdruck arXiv:2412.04403 (2024).[12] Bai, Yuntao, et al. "Constitutional ai: Harmlessness from ai feedback". arXiv-Vorabdruck arXiv:2212.08073 (2022).[13] Blakeney. Cody., et al. "Does your data spark joy? Performance gains from domain upsampling at the end of training". arXiv-Vorabdruck arXiv:2406.03476 (2024).[14] Chen, Hao, et al. "On the Diversity of Synthetic Data and its Impact on Training Large Language Models". arXiv-Vorabdruck arXiv:2410.15226 (2024).[15] Guo, Zishan, et al. "Evaluating large language models: A comprehensive survey". arXiv-Vorabdruck arXiv:2310.19736 (2023).[16] Xu, Zifei, et al. "Scaling laws for post-training quantized large language models". arXiv-Vorabdruck arXiv:2410.12119 (2024).[17] Xiong, Yizhe, et al. "Temporal scaling law for large language models". arXiv-Vorabdruck arXiv:2404.17785 (2024).[18] DeepSeek-AI et al. "DeepSeek-v3 Technical Report". https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf (2024).[19] Schick, Timo, et al. "Toolformer: Sprachmodelle können sich selbst beibringen, Werkzeuge zu benutzen." arXiv preprint arXiv:2302.04761 (2023).[20] Welleck, Sean, et al. "From decoding to meta-generation: reference-time algorithms for large language models". arXiv-Vorabdruck arXiv:2406.16838 (2024).[21] OpenAI et al. "Learning to Reason with LLMs". https://openai.com/index/learning-to-reason-with-llms/ (2024).[22] Wei, Jason, et al. "Chain-of-thought prompting elicits reasoning in large language models". Fortschritte bei neuronalen Informationsverarbeitungssystemen 35 (2022): 24824-24837.[23] Liu, Yang, et al. "G-eval: Nlg evaluation using gpt-4 with better human alignment". arXiv-Vorabdruck arXiv:2303.16634 (2023).[24] Kim, Seungone, et al. "Prometheus: Inducing fine-grained evaluation capability in language models". Die zwölfte internationale Konferenz über lernende Darstellungen . 2023.[25] Ho, Namgyu, Laura Schmid und Se-Young Yun: "Large language models are reasoning teachers". arXiv-Vorabdruck arXiv:2212.10071 (2022).[26] Kim, Seungone, et al. "The cot collection: improving zero-shot and few-shot learning of language models via chain-of-thought fine-tuning". arXiv-Vorabdruck arXiv:2305.14045 (2023).[27] Weng, Yixuan, et al. "Large language models are better reasoners with self-verification". arXiv-Vorabdruck arXiv:2212.09561 (2022).[28] Lightman, Hunter, et al. "Let's verify step by step". arXiv-Vorabdruck arXiv:2305.20050 (2023).[29] Zhang, Lunjun, et al. "Generative verifiers: reward modelling as next-token prediction". arXiv-Vorabdruck arXiv:2408.15240 (2024).1 Die beiden wichtigsten Berichte stammen von The Information und Reuters.

2 Wir haben die Zeichnung mit den folgenden Einstellungen erstellt:a = 1(math.) Gattungp = 0.5Frieden 0 < x < 1.

3 Berechnungen sind in [1] definiert als 6NBSdie N ist die Anzahl der Modellparameter, dieB ist die beim Training verwendete Losgröße.S ist die Gesamtzahl der Trainingsschritte.

4 Diese zusätzliche multiplikative Konstante ändert das Verhalten des Potenzgesetzes nicht. Um zu verstehen, warum dies so ist, müssen wir die Definition der Skaleninvarianz verstehen. Da Potenzgesetze skaleninvariant sind, bleiben die grundlegenden Eigenschaften eines Potenzgesetzes gleich, auch wenn wir es um einen bestimmten Faktor vergrößern oder verkleinern. Das beobachtete Verhalten ist bei jeder Skalierung dasselbe!

5 Diese Beschreibung stammt aus dem Test of Time Award, den Ilya für diese Arbeit bei NeurIPS'24 erhielt.

6 Auch wenn dies heute offensichtlich erscheint, sollten wir bedenken, dass damals die meisten NLP-Aufgaben (z. B. Zusammenfassungen und Fragen und Antworten) eigene Forschungsdomänen hatten! Für jede dieser Aufgaben gab es aufgabenspezifische Architekturen, die sich auf die Ausführung dieser Aufgabe konzentrierten, und das GPT war ein einziges generisches Modell, das die meisten dieser Architekturen bei mehreren verschiedenen Aufgaben übertreffen konnte.

7 Das bedeutet, dass wir jede Aufgabe einfach in den Prompts des großen Sprachmodells beschreiben und dasselbe Modell zur Lösung der verschiedenen Aufgaben verwenden - dieNur die Eingabeaufforderungen ändern sich zwischen den Aufgaben.

8 Dies ist zu erwarten, da diese Modelle mit Null-Stichproben-Inferenz arbeiten und bei keiner der nachgelagerten Aufgaben eine Feinabstimmung vorgenommen wird.

9 Unter "emergenten" Fähigkeiten verstehen wir Fähigkeiten, die großen Sprachmodellen erst ab einer bestimmten Größe zur Verfügung stehen (z. B. bei einem ausreichend großen Modell).

10 Hier definieren wir "rechnerisch optimal" als das Trainings-Setup, das die beste Leistung (in Bezug auf den Testverlust) bei einem festen Trainingsaufwand liefert.

11 Anthropic zum Beispiel verzögert seine Veröffentlichung immer wieder. Claude 3.5 Opus, Google hat nur eine Flash-Version von Gemini-2 veröffentlicht, und OpenAI hat nur GPT-4o im Jahr 2024 veröffentlicht (bis zur Veröffentlichung von o1 und o3 im Dezember), das wohl nicht viel leistungsfähiger als GPT-4 ist.

12 Nur 37 Milliarden Parameter sind während der Inferenz eines einzigen Tokens aktiv.

13 So hat xAI kürzlich ein neues Rechenzentrum in Memphis mit 100.000 NVIDIA-Grafikprozessoren gebaut, und die Leitung von Anthropic will ihre Ausgaben für Rechenleistung in den nächsten Jahren um das Hundertfache erhöhen.

14 Der Aggregationsschritt kann auf verschiedene Weise durchgeführt werden. Zum Beispiel können wir Antworten manuell aggregieren (z. B. über eine Verbindung), ein großes Sprachmodell verwenden oder irgendetwas dazwischen!

15 Das liegt nicht daran, dass diese Aufgaben einfach sind. Codegenerierung und Chat sind beide schwer zu lösen, aber sie sind (wohl) ziemlich offensichtliche Anwendungen des Big Language Model.

16OpenAI hat sich dafür entschieden, diese langen Gedankenketten vor den Benutzern von o1 zu verbergen. Das Argument hinter dieser Entscheidung ist, dass diese Grundlagen Einblicke in die Denkprozesse des Modells bieten, die zur Fehlersuche oder Überwachung des Modells verwendet werden können. Allerdings sollte es den Modellen erlaubt sein, ihre reinen Gedanken ohne die Sicherheitsfilter auszudrücken, die für die benutzerorientierte Modellausgabe notwendig sind.

17 Derzeit bleibt ARC-AGI technisch unbesiegt, da o3 die Rechenanforderungen für das Benchmarking übersteigt. Allerdings erreicht das Modell mit niedrigeren Recheneinstellungen immer noch eine Genauigkeit von 75,7%.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...