Leider verbessert der technische Bericht Kimi k1.5, der zusammen mit DeepSeek-R1 veröffentlicht wurde, den langen Kontext und die multimodale Inferenz

Kimi k1.5 Technischer Bericht Quick Reads

1. leistungsstarke multimodale Argumentation:

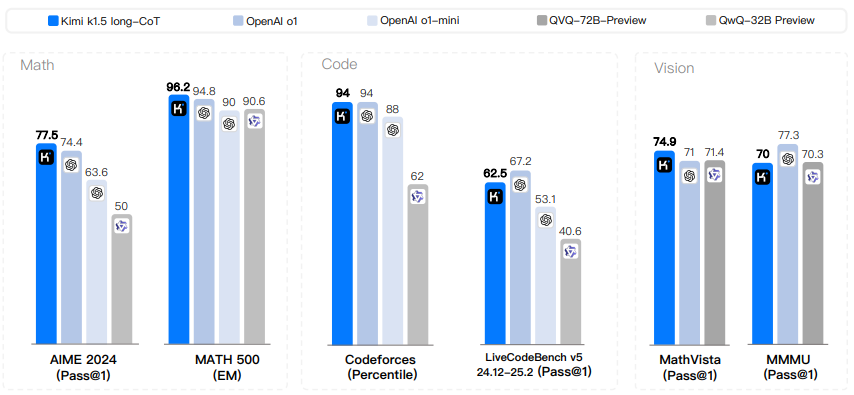

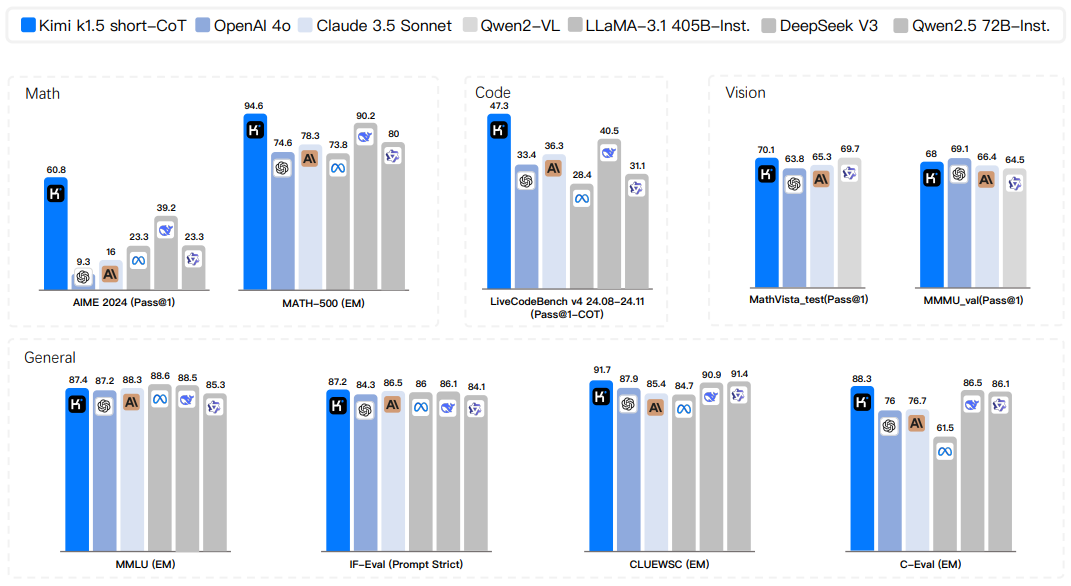

Kimi Das k1.5-Modell erreicht bei mehreren Benchmarks und Modalitäten, einschließlich mathematischer, Code-, Text- und visueller Inferenzaufgaben, die beste Inferenzleistung.

Es verarbeitet nicht nur reinen Text, sondern versteht auch Kombinationen aus Bildern und Text und ermöglicht so echte multimodale Schlussfolgerungen.

Sowohl die Lang-CoT-Version als auch die Kurz-CoT-Version zeigen starke Leistungen.

Bei Datensätzen wie AIME, MATH 500, Codeforces und anderen wurde eine Spitzenposition erreicht.

Auch bei visuellen Benchmarks wie MathVista schneidet er gut ab.

2) Durchbrüche im RL-Training mit langem Kontext:

Durch die Erweiterung des Kontextfensters auf 128k verbessert sich die Leistung des Modells weiter, was beweist, dass die Kontextlänge eine Schlüsseldimension für die Skalierung des Reinforcement Learning ist.

- Ein partielles Rollout-Verfahren wird eingesetzt, um die Effizienz des RL-Trainings für lange Kontexte erheblich zu verbessern, so dass längere und komplexere Inferenzprozesse trainiert werden können.

- Es wird gezeigt, dass lange Kontexte entscheidend für die Lösbarkeit komplexer Probleme sind.

3. gültige long2short-Methoden:

- Es wird eine effektive long2short-Methode vorgeschlagen, um das Wissen von Modellen mit langem Kontext zu nutzen, um die Leistung von Modellen mit kurzem Kontext zu verbessern und die Token Effizienz.

- Eine Leistungsverbesserung von Kurzmodellen wird durch Techniken wie Modellzusammenführung, kürzeste Ablehnungsstichproben und DPO erreicht und ist effizienter als das direkte Training von Kurzmodellen.

Es wird gezeigt, dass die Leistung kurzer Modelle verbessert werden kann, indem das Vorwissen der Denkweise langer CoT-Modelle übernommen wird.

4. optimierter RL-Trainingsrahmen:

Es werden verbesserte Methoden zur Optimierung der Politik vorgeschlagen, um eine robuste Leistung zu erzielen, ohne auf komplexe Techniken zurückgreifen zu müssen.

Um die Effizienz und Effektivität des RL-Trainings zu verbessern, werden verschiedene Sampling-Strategien, Längenstrafen und die Optimierung von Datenrezepten untersucht.

Die Wirksamkeit der vorgeschlagenen Methodik und Ausbildungstechniken wurde durch Ablationsstudien überprüft.

5. detaillierter Ausbildungsprozess und Systementwurf:

- Ein detailliertes Trainingsrezept für Kimi k1.5 wurde veröffentlicht, das Vorübungen, Feinabstimmungen und intensive Lernphasen umfasst.

- Es werden hybride Einsatzstrategien vorgestellt, um die Ressourcennutzung während des Trainings und der Inferenz zu optimieren.

- Die Datenpipeline und die Qualitätskontrollmechanismen zur Sicherstellung der Qualität der Trainingsdaten werden im Detail beschrieben.

- Entwicklung einer sicheren Code-Sandbox für die Ausführung und Bewertung des generierten Codes.

6. die Untersuchung von Modellgröße und Kontextlänge:

Die Auswirkung von Modellgröße und Kontextlänge auf die Leistung wird untersucht, und es wird festgestellt, dass größere Modelle besser abschneiden, aber kleinere Modelle, die längere Kontexte verwenden, können sich der Leistung größerer Modelle annähern oder sie sogar erreichen, was die Verbesserung der Modellleistung durch RL-Training zeigt.

Abstracts

Es hat sich gezeigt, dass das Vortraining von Sprachmodellen mit Hilfe von Vorhersagen für das nächste Token eine effektive rechnerische Skalierung ermöglicht, aber durch die Menge der verfügbaren Trainingsdaten begrenzt ist. Erweitertes Verstärkungslernen (Extended Reinforcement Learning, RL) eröffnet eine neue Dimension für kontinuierliche Verbesserungen in der KI und verspricht die Skalierung von Trainingsdaten für große Sprachmodelle (LLMs) durch das Erlernen der Erkundung von Belohnungen. Die bisher veröffentlichten Arbeiten haben jedoch keine konkurrenzfähigen Ergebnisse erbracht. Vor diesem Hintergrund berichten wir über die Trainingspraktiken von Kimi k1.5, unserem neuesten multimodalen LLM, das mit RL trainiert wird, einschließlich seiner RL-Trainingstechniken, multimodalen Datenformulierung und Infrastrukturoptimierungen. Lange Kontexterweiterungen und verbesserte Methoden zur Optimierung von Richtlinien sind Schlüsselelemente unseres Ansatzes, der einen einfachen und effektiven RL-Rahmen schafft, ohne sich auf komplexere Techniken wie Monte-Carlo-Baumsuche, Wertfunktionen und Prozessbelohnungsmodelle zu verlassen. Bemerkenswert ist, dass unser System bei mehreren Benchmarks und Modalitäten eine Inferenzleistung auf dem neuesten Stand der Technik erreicht - z. B. 77,5 bei AIME, 96,2 bei MATH 500, 94 Prozent bei Codeforces, MathVista 74,9 auf MathVista, was dem Wert von OpenAI 01 entspricht. Darüber hinaus stellen wir effektive long2short-Methoden vor, die Long-CoT-Techniken zur Verbesserung des Short-CoT-Modells verwenden und so State-of-the-Art Short-CoT-Inferenzergebnisse erzielen - z. B. 60,8 bei AIME, 94,6 bei MATH500, 47,9 bei LiveCodeBench, und 47,3 auf LiveCodeBench, und übertreffen damit deutlich bestehende Short-CoT-Modelle wie GPT-40 und Claude Sonnet 3.5 (bis zu +550%).

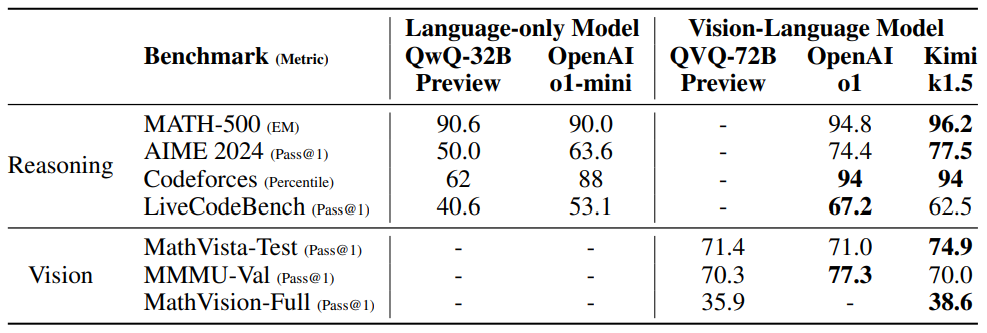

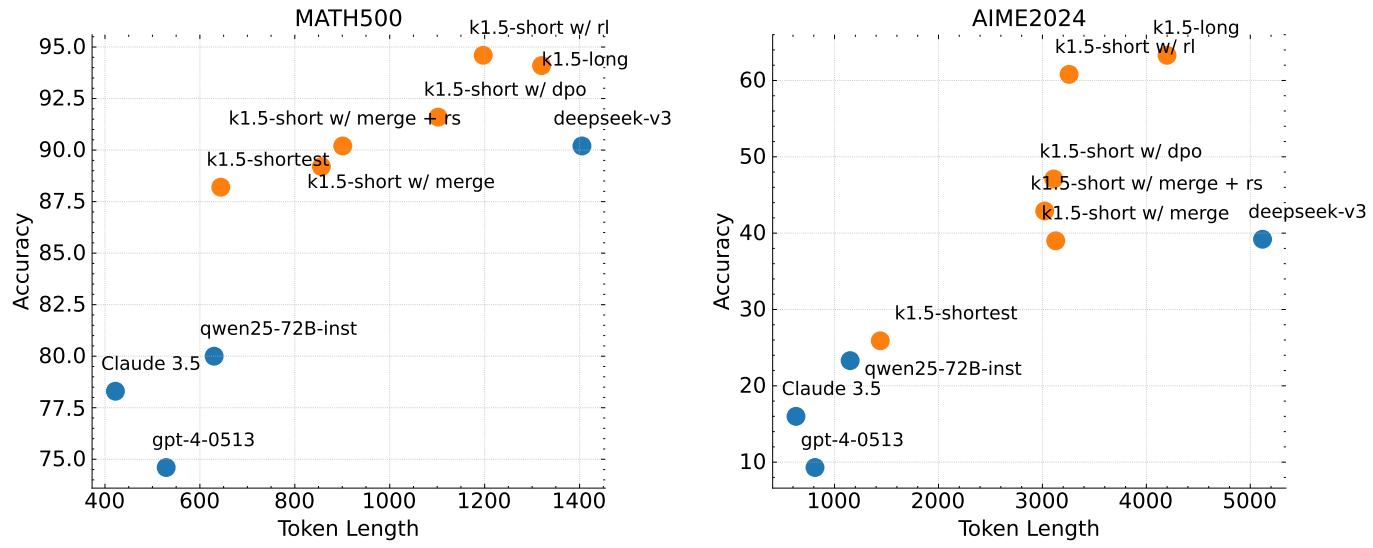

Abbildung 1: Kimi k1.5 long-CoT Ergebnisse.

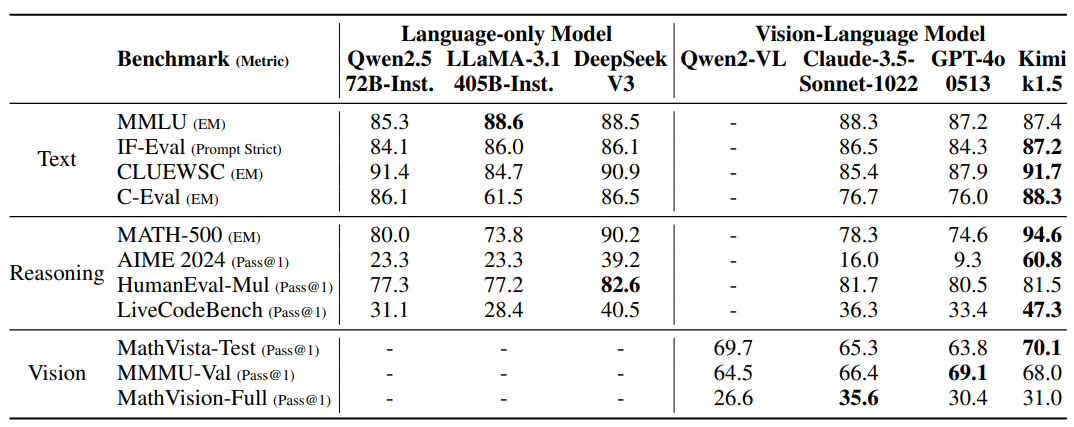

Abbildung 2: Kimi k1.5 short-CoT Ergebnisse.

1 Einleitung

Das Vortraining von Sprachmodellen unter Verwendung der Vorhersage des nächsten Tokens wurde im Zusammenhang mit dem Expansionslemma untersucht, bei dem die Skalierung von Modellparametern und Datengrößen zu einer kontinuierlichen Verbesserung der Intelligenz führt. (Kaplan et al. 2020; Hoffmann et al. 2022) Dieser Ansatz ist jedoch durch die Menge der verfügbaren hochwertigen Trainingsdaten begrenzt. (Villalobos et al. 2024; Muennighoff et al. 2023) In diesem Bericht stellen wir das Trainingsrezept für Kimi k1.5 vor, unser neuestes multimodales LLM, das mit Hilfe von Reinforcement Learning (RL) trainiert wurde, um eine mögliche neue Dimension der kontinuierlichen Expansion zu erkunden. Durch die Verwendung von RL mit LLM lernt das Modell, Belohnungen zu erforschen und ist daher nicht auf bereits vorhandene statische Datensätze beschränkt.

Es gibt mehrere Schlüsselelemente für die Gestaltung und Schulung von k1.5.

- lange KontexterweiterungWir erweiterten das Kontextfenster von RL auf 128k und beobachteten kontinuierliche Leistungsverbesserungen, als die Kontextlänge zunahm. Eine Schlüsselidee hinter unserem Ansatz ist die Verwendung von partiellem Rollout, um die Trainingseffizienz zu verbessern - d.h. um die Kosten für die Regeneration einer neuen Trajektorie von Grund auf zu vermeiden, indem ein großer Teil der vorherigen Trajektorie für die Abtastung der neuen Trajektorie wiederverwendet wird. Unsere Beobachtungen legen nahe, dass die Kontextlänge eine Schlüsseldimension für die kontinuierliche Skalierung von RL im LLM ist.

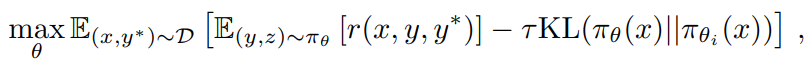

- Verbesserte StrategieoptimierungWir leiten die RL-Formulierung mit Long-CoT ab und verwenden eine Variante des Online-Spiegelabstiegs zur robusten Strategieoptimierung. Der Algorithmus wird durch unsere effiziente Stichprobenstrategie, die Längenstrafe und die Optimierung der Datenformulierung weiter verbessert.

- Vereinfachter RahmenDie Kombination aus langen Kontexterweiterungen und verbesserten Methoden zur Optimierung von Richtlinien schafft einen vereinfachten RL-Rahmen für das Lernen mit LLM. Da wir in der Lage sind, die Kontextlänge zu verlängern, weist die gelernte CoT Planungs-, Reflexions- und Korrektureigenschaften auf. Die größere Kontextlänge erhöht die Anzahl der Suchschritte. Infolgedessen zeigen wir, dass eine robuste Leistung erreicht werden kann, ohne auf anspruchsvollere Techniken zurückgreifen zu müssen (z. B. Monte-Carlo-Baumsuche, Wertfunktionen und Prozessbelohnungsmodelle).

- multimodalUnser Modell wird gemeinsam mit textuellen und visuellen Daten trainiert, wodurch es in der Lage ist, über beide Modalitäten gemeinsam nachzudenken.

Darüber hinaus schlagen wir einen effektiven long2short-Ansatz vor, der Long-CoT-Techniken zur Verbesserung von Short-CoT-Modellen einsetzt. Konkret besteht unser Ansatz in der Anwendung einer Längenstrafe mit Long-CoT-Aktivierung und Modellzusammenführung.

Unsere Version von long-CoT erreicht bei mehreren Benchmarks und Modalitäten die modernste Inferenzleistung - z.B. 77,5 bei AIME, 96,2 bei MATH 500, 94. Perzentil bei Codeforces, 74,9 bei MathVista, gleichauf mit OpenAI 01. 74,9 auf MathVista, gleichauf mit OpenAIs 01. Unser Modell erzielt auch modernste Short-CoT-Inferenzergebnisse - z. B. 60,8 bei AIME, 94,6 bei MATH500 und 47,3 bei LiveCodeBench - die bestehende Short-CoT-Modelle wie GPT-40 und Claude Sonnet 3.5 (bis zu +550%). Die Ergebnisse sind in den Abbildungen 1 und 2 dargestellt.

2 Methode: Verstärkungslernen mit LLM

Die Entwicklung von Kimi k1.5 bestand aus mehreren Phasen: Pre-Training, Vanille-überwachtes Fine-Tuning (SFT), Long-CoT-überwachtes Fine-Tuning und Reinforcement Learning (RL). Dieser Bericht konzentriert sich auf RL, beginnend mit einem Überblick über das RL-Cue-Set-Management (Abschnitt 2.1) und das Long-CoT-überwachte Fine-Tuning (Abschnitt 2.2), gefolgt von einer ausführlichen Diskussion der RL-Trainingsstrategien in Abschnitt 2.3. Detailliertere Informationen zum Pre-Training und zur vanilleüberwachten Feinabstimmung finden sich in Abschnitt 2.5.

2.1 RL Cue Set Management

In unseren vorläufigen Experimenten haben wir festgestellt, dass die Qualität und Vielfalt der RL-Cue-Sets eine entscheidende Rolle bei der Gewährleistung der Effektivität des Reinforcement Learning spielen. Sorgfältig konstruierte Cue-Sets leiten das Modell nicht nur zu robusten Schlussfolgerungen an, sondern vermindern auch das Risiko von Belohnungsangriffen und der Überanpassung von Oberflächenmustern. Insbesondere drei Schlüsseleigenschaften definieren hochwertige RL-Cue-Sets:

- Diversifizierte AbdeckungTipps sollten eine Vielzahl von Disziplinen abdecken, z. B. MINT, Codierung und allgemeines Denken, um die Anpassungsfähigkeit des Modells zu verbessern und seine breite Anwendbarkeit in verschiedenen Bereichen zu gewährleisten.

- Ausgewogene Schwierigkeit:: Die Aufforderungssätze sollten gleichmäßig verteilte leichte, mittlere und schwierige Probleme enthalten, um inkrementelles Lernen zu fördern und eine Überanpassung an bestimmte Komplexitätsstufen zu verhindern.

- Genaue Beurteilbarkeit:: Die Tipps sollten eine objektive und zuverlässige Bewertung durch den Validierer ermöglichen, um sicherzustellen, dass die Leistung des Modells auf der Grundlage fundierter Überlegungen und nicht auf der Grundlage oberflächlicher Muster oder zufälliger Vermutungen gemessen wird.

Um eine vielfältige Abdeckung des Cue-Sets zu erreichen, verwenden wir automatische Filter, um Fragen auszuwählen, die ein umfassendes logisches Denken erfordern und leicht zu bewerten sind. Unser Datensatz umfasst Fragen aus einer Vielzahl von Bereichen, wie z. B. MINT-Bereiche, Wettbewerbe und allgemeine logische Aufgaben, und enthält sowohl Klartext- als auch Bild-Text-Quizdaten. Darüber hinaus haben wir ein Kennzeichnungssystem entwickelt, um die Aufforderungen nach Bereichen und Disziplinen zu klassifizieren, um eine ausgewogene Darstellung verschiedener Themenbereiche zu gewährleisten (M. Li et al. 2023; W. Liu et al. 2023).

Wir haben einen modellbasierten Ansatz verwendet, der die Fähigkeit des Modells nutzt, die Schwierigkeit jeder Aufforderung adaptiv zu bewerten. Konkret generiert das SFT-Modell für jede Aufforderung zehn Antworten mit einer relativ hohen Stichprobentemperatur. Die Erfolgsquote wird dann berechnet und als Näherungswert für die Schwierigkeit des Hinweises verwendet - je niedriger die Erfolgsquote, desto höher die Schwierigkeit. Dieser Ansatz ermöglicht es, die Schwierigkeitsbewertung an den intrinsischen Fähigkeiten des Modells auszurichten, was ihn für das RL-Training sehr effektiv macht. Durch die Verwendung dieses Ansatzes können wir die meisten trivialen Fälle im Voraus aussortieren und während des RL-Trainings leicht verschiedene Stichprobenstrategien untersuchen.

Um potenzielle Belohnungsangriffe zu vermeiden (Everitt et al. 2021; Pan et al. 2022), müssen wir sicherstellen, dass wir den Denkprozess und die endgültige Antwort für jeden Hinweis genau verifizieren können. Empirische Beobachtungen haben gezeigt, dass einige komplexe Argumentationsprobleme relativ einfache und leicht zu erratende Antworten haben können, was zu einer falschen Vorwärtsvalidierung führt, bei der das Modell die richtige Antwort durch einen falschen Argumentationsprozess erreicht. Um dieses Problem anzugehen, schließen wir Fragen aus, die für solche Fehler anfällig sind, wie z. B. Multiple-Choice-Fragen, Richtig/Falsch-Fragen und beweisbasierte Fragen. Darüber hinaus schlagen wir für allgemeine Frage-Antwort-Aufgaben eine einfache, aber effektive Methode vor, um leicht angreifbare Hinweise zu identifizieren und zu entfernen. Konkret fordern wir das Modell auf, mögliche Antworten zu erraten, ohne einen CoT-Inferenzschritt durchzuführen. Wenn das Modell in N Versuchen die richtige Antwort vorhersagt, gilt der Hinweis als zu leicht angreifbar und wird entfernt. Wir haben herausgefunden, dass die Einstellung N = 8 die meisten leicht angreifbaren Hinweise entfernt. Die Entwicklung fortschrittlicherer Überprüfungsmodelle bleibt ein offenes Feld für zukünftige Forschung.

2.2 Überwachtes Long-CoT-Fein-Tuning

Mit einem verbesserten RL-Cue-Set verwenden wir Cue-Engineering, um einen kleinen, aber qualitativ hochwertigen Long-CoT-Warm-up-Datensatz mit genau verifizierten Inferenzpfaden für Text- und Bildeingaben zu erstellen. Dieser Ansatz ähnelt dem Rejection Sampling (RS), konzentriert sich aber auf die Generierung von Long-CoT-Inferenzpfaden durch Cue Engineering. Der resultierende Warm-up-Datensatz ist so konzipiert, dass er die wichtigsten kognitiven Prozesse umfasst, die für das logische Denken von Humanoiden wichtig sind, z. B. Planung (bei der das Modell systematisch die Schritte vor der Ausführung skizziert), Bewertung (einschließlich der kritischen Beurteilung von Zwischenschritten), Reflexion (die es dem Modell ermöglicht, seinen Ansatz zu überdenken und zu verbessern) und Erkundung (die die Erwägung alternativer Lösungen fördert). Durch die Durchführung einer leichtgewichtigen SFT auf diesem Aufwärm-Datensatz können wir das Modell effektiv dazu anleiten, diese Inferenzstrategien zu verinnerlichen. Das Ergebnis ist, dass das fein abgestimmte Long-CoT-Modell eine verbesserte Fähigkeit aufweist, detailliertere und logisch kohärentere Antworten zu generieren, was seine Leistung bei einer Vielzahl von Inferenzaufgaben verbessert.

2.3 Verbessertes Lernen

2.3.1 Problemstellung

Bei einem Trainingsdatensatz D = {(xi, yi)}^n_i=1, die die Frage xi und die entsprechende richtige Antwort y enthälti, besteht unser Ziel darin, das Strategiemodell πθ so zu trainieren, dass es das Testproblem genau löst. In einem komplexen Denkkontext ist die Abbildung von Problem x auf Lösung y keine einfache Aufgabe. Um dieser Herausforderung zu begegnen, schlägt der Chain-of-Thinking-Ansatz (CoT) vor, eine Reihe von Zwischenschritten z = (z1, z2, ... , zm) zur Überbrückung von x und y, wobei jedes zi eine kohärente Abfolge von Token ist, die als wichtiger Zwischenschritt bei der Problemlösung dienen kann (J. Wei et al., 2022). Bei der Lösung des Problems x wird die autoregressive Stichprobe zt ~ πθ(-|x, z1, ... , zt-1), und dann das Sampling der endgültigen Antwort y ~ πθ(-|x, z1,... , zm). Wir verwenden y, z ~ πθ, um diesen Stichprobenprozess zu bezeichnen. Man beachte, dass sowohl die Gedanken als auch die endgültigen Antworten als linguistische Sequenzen abgetastet werden.

Um die Inferenzfähigkeiten des Modells weiter zu verbessern, setzen wir Planungsalgorithmen ein, um verschiedene Denkprozesse zu erforschen und so verbesserte CoTs beim Argumentieren zu erzeugen (Yao et al. 2024; Y. Wu et al. 2024; Snell et al. 2024). Die zentrale Erkenntnis dieser Ansätze ist die explizite Konstruktion von Denk-Suchbäumen, die von Wertschätzungen geleitet werden. Dies ermöglicht es dem Modell, verschiedene Fortsetzungen des Denkprozesses zu erforschen oder zurückzugehen, um neue Richtungen zu untersuchen, wenn es auf eine Sackgasse stößt. Im Einzelnen sei T ein Suchbaum, bei dem jeder Knoten eine Teillösung s = (x, z1:|s|) darstellt. Dabei besteht s aus dem Problem x und einer Folge von Gedanken z1:|s| = (z1, ... , z|s|), die zu dem Knoten führen, wobei |s| die Anzahl der Gedanken in der Sequenz bezeichnet. Der Planungsalgorithmus verwendet das Kritikmodell v, um eine Rückmeldung v(x, z1:|s|) zu geben, die dabei hilft, den aktuellen Fortschritt bei der Lösung des Problems zu bewerten und etwaige Fehler in der bestehenden Teillösung zu erkennen. Wir weisen darauf hin, dass das Feedback entweder durch diskriminante Scores oder sprachliche Sequenzen erfolgen kann (L. Zhang et al. 2024). Geleitet von den Rückmeldungen aller s ∈ T , erweitert der Planungsalgorithmus den Suchbaum, indem er die Knoten auswählt, die am wahrscheinlichsten zu erweitern sind. Der obige Prozess wird iterativ wiederholt, bis eine vollständige Lösung gefunden ist.

Wir können Planungsalgorithmen auch aus einer algorithmischen Perspektive betrachten. Ausgehend von der zum Zeitpunkt der t-ten Iteration verfügbaren vergangenen Suchhistorie (s1, v(s1), ... , st-1, v(st-1)), bestimmt der Planungsalgorithmus A iterativ die nächste Suchrichtung A(st|s1, v(s1), ... , st-1, v(st-1)) und gibt Rückmeldung über den aktuellen Suchfortschritt A(v(st)|s1, v(s1), ... , st). , st), um Rückmeldung zu geben. Da sowohl das Denken als auch die Rückmeldung als Zwischenschritte des Denkens betrachtet werden können und da diese Komponenten als linguistische Token-Sequenzen dargestellt werden können, verwenden wir zur Vereinfachung der Darstellung z anstelle von s und v. Wir betrachten den Planungsalgorithmus also als direkt auf eine Folge von Inferenzschritten wirkend A(-|z1, z2, ...). ) als eine Abbildung einer Reihe von Schlussfolgerungsschritten A(-|z1, z2, ... ). In diesem Rahmen werden alle Informationen, die in dem vom Planungsalgorithmus verwendeten Suchbaum gespeichert sind, auf den gesamten dem Algorithmus zur Verfügung gestellten Kontext ausgedehnt. Dies bietet eine interessante Perspektive für die Generierung hochwertiger CoTs: Anstatt den Suchbaum explizit zu konstruieren und den Planungsalgorithmus zu implementieren, können wir ein Modell trainieren, um diesen Prozess zu approximieren. In diesem Fall ist die Menge des Denkens (d. h. der linguistischen Token) analog zum Rechenbudget, das traditionell für Planungsalgorithmen verwendet wird. Jüngste Fortschritte bei langen Kontextfenstern fördern die nahtlose Skalierbarkeit während der Trainings- und Testphasen. Wenn möglich, ermöglicht dieser Ansatz dem Modell, implizite Suchen direkt im Inferenzraum über autoregressive Vorhersagen durchzuführen. Dadurch lernt das Modell nicht nur, eine Reihe von Trainingsproblemen zu lösen, sondern entwickelt auch die Fähigkeit, einzelne Probleme effizient zu lösen, was die Generalisierung auf ungesehene Testprobleme verbessert.

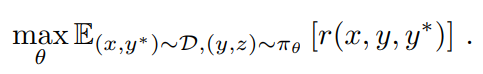

Daher betrachten wir das Training von Modellen zur Erzeugung von CoTs mit Hilfe von Reinforcement Learning (RL) (OpenAI 2024). Sei r ein Belohnungsmodell, das eine Grundlage für die Korrektheit der für eine gegebene Frage x vorgeschlagenen Antwort y auf der Basis der wahren Antwort y* bietet, indem es einen Wert r(x, y, y*) ∈ {0, 1} zuweist. Bei überprüfbaren Problemen wird die Belohnung direkt durch vordefinierte Kriterien oder Regeln bestimmt. Bei Codierungsproblemen wird zum Beispiel bewertet, ob die Antwort den Testfall besteht. Bei Fragen mit frei formulierten wahren Antworten trainieren wir das Belohnungsmodell r(x, y, y*), um vorherzusagen, ob die Antwort mit der wahren Antwort übereinstimmt. Bei einer Frage x erzeugt das Modell πθ den CoT und die endgültige Antwort durch einen Stichprobenprozess z ~ πθ(-|x), y ~ πθ(-|x, z). Die Qualität des generierten CoT hängt davon ab, ob es korrekte endgültige Antworten erzeugen kann. Zusammenfassend lässt sich sagen, dass wir die folgenden Ziele zur Optimierung der Strategie berücksichtigen

Durch die Erweiterung des RL-Trainings wollen wir ein Modell trainieren, das sowohl die Vorteile der einfachen cue-basierten CoT als auch der planungserweiterten CoT nutzt. Das Modell nimmt während der Inferenz immer noch autoregressiv linguistische Sequenzen auf und vermeidet so die komplexe Parallelisierung, die fortgeschrittene Planungsalgorithmen während der Entwicklung benötigen. Ein wesentlicher Unterschied zu einfachen, auf Stichworten basierenden Ansätzen besteht jedoch darin, dass das Modell nicht nur eine Reihe von Inferenzschritten befolgen sollte. Stattdessen sollte es auch wichtige Planungsfähigkeiten erlernen, einschließlich Fehleridentifizierung, Backtracking und Lösungsverbesserung, indem es die gesamte Menge an explorativen Gedanken als Kontextinformationen nutzt.

2.3.2 Optimierung der Strategie

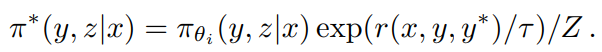

Als Trainingsalgorithmus verwenden wir eine Variante der Online-Strategie mirror descent (Abbasi-Yadkori et al. 2019; Mei et al. 2019; Tomar et al. 2020). Der Algorithmus wird iterativ ausgeführt. In der i-ten Iteration verwenden wir das aktuelle Modell πθi als Referenzmodell und optimieren das folgende Optimierungsproblem der relativen Entropie-Regularisierungspolitik, das

wobei τ > 0 ein Parameter ist, der den Grad der Regularisierung steuert. Dieses Ziel hat eine Lösung in geschlossener Form

wobei Z = Σy',z' πθi (y', z'|x) exp(r(x, y', y*)/τ) der Normalisierungsfaktor ist. Nimmt man den Logarithmus beider Seiten, so erhält man, dass für jedes (y, z) die folgenden Bedingungen erfüllt sind, was uns erlaubt, die Offline-Politikdaten während der Optimierung zu nutzen

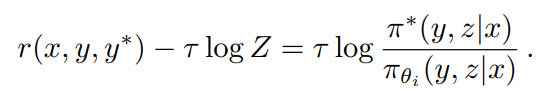

Dies führte zu den folgenden Ersatzverlusten

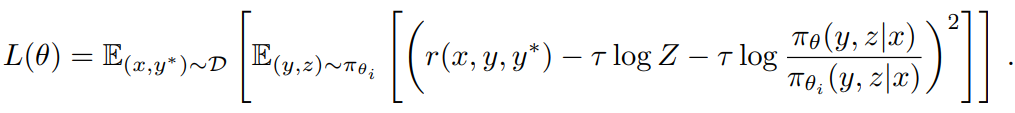

Um τ log Z zu approximieren, verwenden wir die Stichproben (y1, z1), ... , (yk, zk) ~ πθ: τ log Z ≈ log 1/k Σ^k_j=1 exp(r(x, yj, y*)/τ). Wir stellen außerdem fest, dass die Verwendung des empirischen Mittels der Stichprobenbelohnung τ = mean(r(x, y1, y*), ... , r(x, yk, y*)) gültige praktische Ergebnisse liefert. Dies ist vernünftig, denn mit τ → ∞ nähert sich τ log Z der erwarteten Belohnung unter πθi. Schließlich leiten wir unseren Lernalgorithmus ab, indem wir den Gradienten des Substitutionsverlustes nehmen. Für jedes Problem x werden k Antworten unter Verwendung der Referenzpolitik πθi abgetastet, und der Gradient ist gegeben durch

Für diejenigen, die mit Strategiegradienten-Methoden vertraut sind: Dieser Gradient ähnelt dem Strategiegradienten von (2), der den Mittelwert der abgetasteten Belohnungen als Basislinie verwendet (Kool et al. 2019; Ahmadian et al. 2024). Der Hauptunterschied besteht darin, dass die Antwort von πθi und nicht von der Online-Strategie abgetastet wird und eine l2-Regularisierung angewendet wird. Daher können wir dies als eine natürliche Erweiterung des üblichen regulierten Online-Gradientenalgorithmus für die Offline-Strategie betrachten (Nachum et al. 2017). Wir nehmen eine Stichprobe von Problemen aus D und aktualisieren den Parameter θi+1 , der anschließend als Referenzpolitik für die nächste Iteration verwendet wird. Außerdem setzen wir den Optimierer zu Beginn jeder Iteration zurück, da jede Iteration aufgrund der Änderung der Referenzstrategie ein anderes Optimierungsproblem betrachtet.

Wir haben das Wertnetzwerk aus dem Trainingssystem ausgeschlossen, das auch in einer früheren Studie verwendet wurde (Ahmadian et al. 2024). Während diese Designwahl die Trainingseffizienz erheblich verbessert, stellen wir auch die Hypothese auf, dass die traditionelle Verwendung von Wertfunktionen für die Kreditvergabe im klassischen RL für unseren Kontext möglicherweise nicht geeignet ist. Betrachten wir eine Situation, in der das Modell einen partiellen CoT (z1, z2, ... , zt) und zwei mögliche nächste Inferenzschritte hat: zt+1 und z't+1. Nehmen wir an, dass zt+1 direkt zur richtigen Antwort führt, während z't+1 einige Fehler enthält. Wäre die Orakelwertfunktion zugänglich, würde sie anzeigen, dass zt+1 einen höheren Wert behält als z't+1. Nach den üblichen Grundsätzen der Kreditvergabe würde die Wahl von z't+1 bestraft werden, da sie einen negativen Vorteil gegenüber der aktuellen Strategie hat. Die Untersuchung von z't+1 ist jedoch wertvoll für das Training des Modells, um lange CoT zu generieren. Indem die Begründung für die endgültige Antwort, die sich aus dem langen CoT ergibt, als Belohnungssignal verwendet wird, kann das Modell aus dem Versuch-und-Irrtum-Muster der Annahme von z't+1 lernen, solange es sich erfolgreich erholt und zur richtigen Antwort gelangt. Die wichtigste Schlussfolgerung aus diesem Beispiel ist, dass wir das Modell ermutigen sollten, verschiedene Argumentationspfade zu erkunden, um seine Fähigkeit zur Lösung komplexer Probleme zu verbessern. Dieser explorative Ansatz führt zu einem großen Erfahrungsschatz, der die Entwicklung kritischer Planungsfähigkeiten unterstützt. Unser Hauptziel ist es nicht, die Genauigkeit der Trainingsprobleme auf das höchste Niveau zu bringen, sondern das Modell mit effektiven Problemlösungsstrategien auszustatten, die letztendlich seine Leistung bei den Testproblemen verbessern werden.

2.3.3 Strafen für die Länge

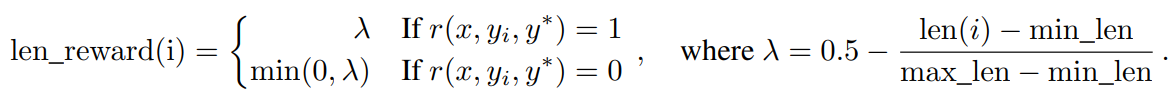

Wir beobachten ein Overthinking-Phänomen, bei dem die Länge der Modellantwort während des RL-Trainings deutlich zunimmt. Dies führt zwar zu einer besseren Leistung, aber übermäßig lange Argumentationsprozesse sind während des Trainings und der Inferenz kostspielig, und Menschen mögen es im Allgemeinen nicht, zu viel zu denken. Um dieses Problem zu lösen, führen wir einen Längenbonus ein, um das schnelle Wachstum der Token-Länge zu begrenzen und so die Token-Effizienz des Modells zu verbessern. Bei k abgetasteten Antworten (y1, z1) für Problem x, ... , (yk, zk) und der wahren Antwort y*, sei len(i) die Länge von (yi, zi), min_len = min_i len(i) und max_len = max_i len(i). Wenn max_len = min_len ist, setzen wir den Längenbonus für alle Antworten auf Null, da sie die gleiche Länge haben. Andernfalls ist der Längenbonus gegeben durch

Im Wesentlichen fördern wir kürzere Antworten und bestrafen längere Antworten bei richtigen Antworten, während wir längere Antworten bei falschen Antworten ausdrücklich bestrafen. Diese längenbasierte Belohnung mit Gewichtungsparametern wird dann zur ursprünglichen Belohnung hinzugefügt.

In unseren vorläufigen Experimenten können die Längenzuschläge die Anfangsphase des Trainings verlangsamen. Um dieses Problem zu entschärfen, schlagen wir vor, die Längenstrafe in der Anfangsphase des Trainings allmählich zu erwärmen. Konkret optimieren wir mit der Standardstrategie ohne Längenstrafe und wenden dann für den Rest des Trainings eine konstante Längenstrafe an.

2.3.4 Probenahmestrategie

Obwohl der RL-Algorithmus selbst relativ gute Sampling-Eigenschaften hat (schwierigere Probleme liefern größere Gradienten), ist seine Trainingseffizienz begrenzt. Daher können einige gut definierte A-priori-Sampling-Methoden größere Leistungsgewinne bringen. Wir nutzen mehrere Signale, um die Sampling-Strategie weiter zu verbessern. Erstens sind die RL-Trainingsdaten, die wir sammeln, natürlich mit unterschiedlichen Schwierigkeitsgraden versehen. So sind zum Beispiel Mathematik-Wettbewerbsaufgaben schwieriger als Grundschul-Matheaufgaben. Zweitens können wir, da der RL-Trainingsprozess dieselben Probleme mehrfach abfragt, auch die Erfolgsrate jedes Problems als Indikator für die Schwierigkeit verfolgen. Wir schlagen zwei Stichprobenmethoden vor, um dieses Vorwissen zu nutzen und die Trainingseffizienz zu verbessern.

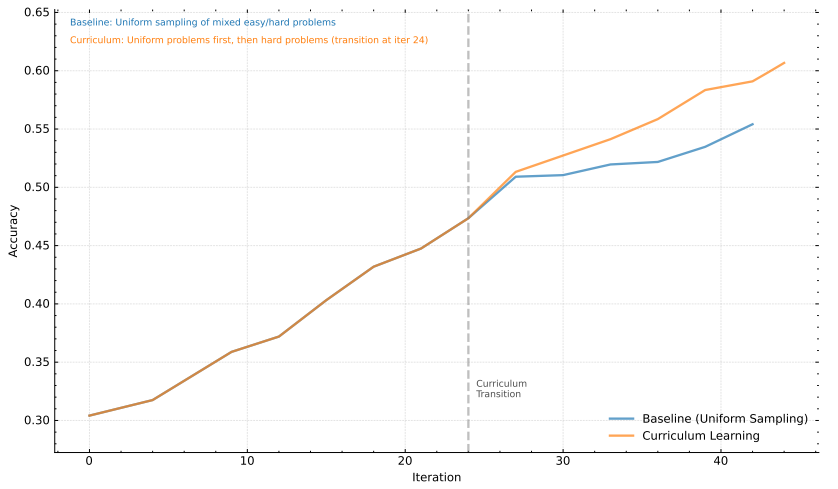

Kurs-Stichproben Wir trainieren zunächst mit einfacheren Aufgaben und gehen dann schrittweise zu schwierigeren Aufgaben über. Da das anfängliche RL-Modell eine begrenzte Leistung hat, führt die Verwendung eines begrenzten Rechenbudgets für sehr schwierige Probleme in der Regel zu wenigen korrekten Stichproben und damit zu einer geringeren Trainingseffizienz. Gleichzeitig enthalten die von uns gesammelten Daten auf natürliche Weise Noten- und Schwierigkeitsbezeichnungen, was das auf der Schwierigkeit basierende Sampling zu einer intuitiven und effektiven Methode zur Verbesserung der Trainingseffizienz macht.

vorrangige Probenahme Zusätzlich zum Kurs-Sampling verwenden wir eine Prioritäts-Sampling-Strategie, um uns auf Probleme mit schlechter Modellleistung zu konzentrieren. Wir verfolgen die Erfolgsquote si für jedes Problem i und wählen die Probleme proportional zu 1/si aus, so dass Probleme mit niedrigeren Erfolgsquoten eine höhere Wahrscheinlichkeit für die Auswahl erhalten. Auf diese Weise werden die Anstrengungen des Modells auf die schwächsten Bereiche gelenkt, was das Lernen beschleunigt und die Gesamtleistung verbessert.

2.3.5 Ausführlichere Informationen über Ausbildungsrezepte

Generierung von Testfällen für die Kodierung Da es für viele Codierungsprobleme im Internet keine Testfälle gibt, haben wir eine Möglichkeit entwickelt, automatisch Testfälle zu generieren, die als Bonus für das Training von Modellen mit RL verwendet werden können. Dabei konzentrieren wir uns vor allem auf Probleme, die keine speziellen Schiedsrichter benötigen. Wir gehen auch davon aus, dass echte Antworten auf diese Fragen verfügbar sind, so dass wir sie zur Generierung von Testfällen höherer Qualität verwenden können.

Wir erweitern unseren Ansatz mit der weithin anerkannten Testfallgenerierungsbibliothek CYaRon¹. Wir verwenden unsere Basis Kimi k1.5, um Testfälle auf der Grundlage von Problemstellungen zu generieren. Anleitungen zur Verwendung von CYaRon und Problembeschreibungen dienen als Eingabe für den Generator. Für jedes Problem verwenden wir den Generator zunächst, um 50 Testfälle zu generieren, und ziehen für jeden Testfall eine Zufallsstichprobe von 10 realen Antwortvorlagen. Wir lassen die Testfälle gegen die Einsendungen laufen. Ein Testfall wird als gültig angesehen, wenn mindestens 10 von 7 Einsendungen eine Übereinstimmung ergeben. Nach dieser Filterungsrunde haben wir einen ausgewählten Satz von Testfällen. Wenn mindestens 10 von 9 Einsendungen den Satz ausgewählter Testfälle bestehen, werden die Frage und die dazugehörigen ausgewählten Testfälle zu unserem Trainingssatz hinzugefügt.

Aus einer Stichprobe von 1.000 Online-Wettbewerbsfragen ergaben sich statistisch gesehen etwa 614 Fragen, die keinen speziellen Schiedsrichter erforderten. Wir haben 463 Testfallgeneratoren entwickelt, die mindestens 40 gültige Testfälle erzeugten, so dass unser Trainingssatz 323 Probleme enthält.

Modellierung der Belohnungen in der Mathematik Eine Herausforderung bei der Bewertung mathematischer Lösungen besteht darin, dass verschiedene Schreibweisen dieselbe grundlegende Antwort darstellen können. Zum Beispiel können a² - 4 und (a + 2)(a - 2) beide gültige Lösungen sein. Wir haben zwei Ansätze verwendet, um die Bewertungsgenauigkeit des Belohnungsmodells zu verbessern:

- Klassisches RM: In Anlehnung an den Ansatz von InstructGPT (Ouyang et al. 2022) haben wir ein wertbasiertes Kopfbelohnungsmodell implementiert und etwa 800.000 Datenpunkte zur Feinabstimmung gesammelt. Das Modell nimmt schließlich "Frage", "Referenz" und "Antwort" als Eingaben und gibt einen Skalar aus, der angibt, ob die Antwort richtig ist oder nicht.

- Chain of Thought RM: Jüngste Studien (Ankner et al. 2024; McAleese et al. 2024) haben gezeigt, dass Belohnungsmodelle, die mit Chain-of-Thinking (CoT)-Überlegungen erweitert wurden, klassische Ansätze deutlich übertreffen können, insbesondere bei Aufgaben, die feinkörnige Korrektheitskriterien erfordern (z. B. Mathematik). Daher haben wir einen gleich großen Datensatz von etwa 800.000 CoT-markierten Beispielen gesammelt, um das Kimi-Modell zu optimieren. Ausgehend von denselben Eingaben wie beim klassischen RM generiert der Chain-of-Thinking-Ansatz explizit schrittweise Inferenzprozesse im JSON-Format und liefert dann das endgültige Korrektheitsurteil, was zu einem robusteren und besser interpretierbaren Belohnungssignal führt.

Bei unseren manuellen Stichproben betrug die Genauigkeit des klassischen RM etwa 84,4, während die Genauigkeit des Gedankenketten-RM 98,5 erreichte. Während des RL-Trainings verwendeten wir das Gedankenketten-RM, um ein korrekteres Feedback zu gewährleisten.

Visuelle Daten Um die Fähigkeiten des Modells zur Inferenz von Bildern aus der realen Welt zu verbessern und einen effizienteren Abgleich zwischen visuellen Eingaben und großen Sprachmodellen (LLMs) zu erreichen, werden unsere Daten für visuelles Verstärkungslernen (Vision RL) aus drei verschiedenen Kategorien gewonnen: Daten aus der realen Welt, synthetische Daten für visuelle Inferenzen und Daten aus Text-Renderings.

- Die realen Daten decken ein breites Spektrum wissenschaftlicher Probleme aller Klassenstufen ab, die das Verstehen von Diagrammen und logisches Denken erfordern, sowie Lokalisierungsaufgaben, die visuelle Wahrnehmung und logisches Denken erfordern, und analytische Aufgaben, die das Verständnis komplexer Diagramme erfordern. Diese Datensätze verbessern die Fähigkeit des Modells, visuelle Schlussfolgerungen in realen Szenarien zu ziehen.

- Synthetische Daten zum logischen Denken werden von Menschen erzeugt und umfassen Bilder und Szenen, die von Programmen erstellt wurden, die bestimmte Fähigkeiten des logischen Denkens verbessern sollen, z. B. das Verständnis von räumlichen Beziehungen, geometrischen Mustern und Objektinteraktionen. Diese synthetischen Datensätze bieten eine kontrollierte Umgebung zum Testen der Fähigkeiten eines Modells im Bereich des visuellen Denkens und stellen einen endlosen Vorrat an Trainingsbeispielen bereit.

- Textdaten werden durch Konvertierung von Textinhalten in ein visuelles Format erstellt, wodurch das Modell die Konsistenz bei der Verarbeitung textbasierter Abfragen über verschiedene Modalitäten hinweg beibehalten kann. Durch die Umwandlung von Textdokumenten, Codeschnipseln und strukturierten Daten in Bilder wird sichergestellt, dass das Modell eine konsistente Antwort liefert, unabhängig davon, ob es sich bei der Eingabe um reinen Text oder um als Bild gerenderten Text (z. B. einen Screenshot oder ein Foto) handelt. Dies trägt auch dazu bei, die Fähigkeit des Modells zu verbessern, textlastige Bilder zu verarbeiten.

Jede Art von Daten ist entscheidend für den Aufbau eines umfassenden visuellen Sprachmodells, das eine Vielzahl von realen Anwendungen effektiv verwalten kann und gleichzeitig eine konsistente Leistung über alle Eingabemodi hinweg gewährleistet.

2.4 Long2short: Kontextkomprimierung für Short-CoT-Modelle

Obwohl das Long-CoT-Modell eine robuste Leistung erzielt, verbraucht es mehr Testzeit-Token als das standardmäßige Short-CoT-LLM. Das A-priori-Wissen über das Denken im Long-CoT-Modell kann jedoch auf das Short-CoT-Modell übertragen werden, um die Leistung selbst bei einem begrenzten Testzeit-Token-Budget zu verbessern. Wir schlagen mehrere Ansätze für dieses long2short-Problem vor, darunter Model Merging (Yang et al., 2024), Shortest Rejection Sampling, DPO (Rafailov et al., 2024) und long2short RL. Eine detaillierte Beschreibung dieser Ansätze finden Sie weiter unten:

Zusammenführung von Modellen Es hat sich gezeigt, dass das Zusammenführen von Modellen dazu beiträgt, die Generalisierungsfähigkeit zu erhalten. Wir haben auch festgestellt, dass die Token-Effizienz verbessert wird, wenn lange CoT-Modelle mit kurzen CoT-Modellen zusammengeführt werden. Bei diesem Ansatz werden lange-CoT-Modelle mit kürzeren Modellen kombiniert, um neue Modelle ohne Training zu erhalten. Konkret fügen wir die beiden Modelle zusammen, indem wir einfach ihre Gewichte mitteln.

Minimale Rückweisung Probenahme Wir stellen fest, dass unser Modell für ein und dasselbe Problem Antworten von sehr unterschiedlicher Länge erzeugt. Aus diesem Grund haben wir die Methode der kürzesten Ablehnung entwickelt. Bei dieser Methode wird dasselbe Problem n-mal abgetastet (n = 8 in unseren Experimenten) und die kürzeste richtige Antwort für die überwachte Feinabstimmung ausgewählt.

DSB Ähnlich wie bei der Stichprobenauswahl für die kürzeste Ablehnung verwenden wir das Long-CoT-Modell, um mehrere Antwortmuster zu erzeugen. Die kürzeste richtige Lösung wird als positive Stichprobe ausgewählt, während längere Antworten als negative Stichproben betrachtet werden, einschließlich der längeren falschen Antwort und der längeren richtigen Antwort (1,5 Mal länger als die ausgewählte positive Stichprobe). Diese positiven und negativen Paare bilden die gepaarten Präferenzdaten, die für das DPO-Training verwendet werden.

Long2short RL Nach der Standard-RL-Trainingsphase wählen wir ein Modell, das die beste Balance zwischen Leistung und Token-Effizienz bietet, als Basismodell aus und führen eine separate Long2Short-RL-Trainingsphase durch. In der zweiten Phase wenden wir die in Abschnitt 2.3.3 eingeführte Längenstrafe an und reduzieren die maximale Rollout-Länge erheblich, um Antworten, die länger als erforderlich, aber möglicherweise korrekt sind, weiter zu bestrafen.

2.5 Sonstige Angaben zur Ausbildung

2.5.1 Vorschulung

Das Kimi k1.5-Basismodell wird auf einem vielfältigen, hochwertigen multimodalen Korpus trainiert. Die linguistischen Daten decken fünf Bereiche ab: Englisch, Chinesisch, Code, mathematische Argumentation und Wissen. Die multimodalen Daten, einschließlich Untertiteln, Bild-Text-Interleaving, OCR, Wissen und QA-Datensätzen, ermöglichen es unserem Modell, visuelle linguistische Kompetenz zu erwerben. Eine strenge Qualitätskontrolle gewährleistet die Relevanz, Vielfalt und Ausgewogenheit des gesamten Pre-Training-Datensatzes. Unser Pre-Training wurde in drei Phasen durchgeführt: (1) visuell-linguistisches Pre-Training, in dem eine solide linguistische Grundlage geschaffen wurde, gefolgt von einer allmählichen multimodalen Integration; (2) eine Abkühlungsphase, in der ausgewählte und synthetische Daten verwendet wurden, um die Fähigkeiten zu konsolidieren, insbesondere für Inferenz- und wissensbasierte Aufgaben; und (3) lange Kontextaktivierung, in der die Sequenzverarbeitung auf 131.072 Tokens hochskaliert wurde. für weitere Einzelheiten zu unseren Pre-Training-Bemühungen für weitere Informationen siehe Anhang B.

2.5.2 Vanilleüberwachungs-Feinabstimmung

Wir haben einen Korpus von Vanilla SFT erstellt, der mehrere Bereiche abdeckt. Für Aufgaben, die nicht das Denken betreffen, wie z. B. Fragen und Antworten, Schreiben und Textverarbeitung, haben wir zunächst einen Seed-Datensatz durch manuelle Annotation erstellt. Dieser Seed-Datensatz wird zum Trainieren von Seed-Modellen verwendet. Anschließend sammeln wir verschiedene Aufforderungen und verwenden das Seed-Modell, um mehrere Antworten für jede Aufforderung zu generieren. Der Kommentator bewertet dann diese Antworten und verbessert die am höchsten bewertete Antwort, um die endgültige Version zu erstellen. Für schlussfolgernde Aufgaben wie mathematische und kodierende Probleme, bei denen eine Validierung auf der Grundlage von Regel- und Belohnungsmodellen genauer und effizienter ist als eine manuelle Beurteilung, erweitern wir den SFT-Datensatz mit Hilfe von Rejection Sampling.

Unser Vanille-SFT-Datensatz enthält etwa 1 Million Textbeispiele. Im Einzelnen handelt es sich um 500.000 Beispiele für allgemeine Fragen und Antworten, 200.000 für Codierung, 200.000 für Mathematik und Naturwissenschaften, 5.000 für kreatives Schreiben und 20.000 für Aufgaben mit langem Kontext, wie z. B. Zusammenfassen, Dokumentenquiz, Übersetzung und Schreiben. Darüber hinaus haben wir 1 Million visuelle Textbeispiele erstellt, die eine Vielzahl von Kategorien abdecken, darunter Diagramminterpretation, OCR, bildbasierte Dialoge, visuelle Kodierung, visuelles Denken und mathematisch-naturwissenschaftliche Probleme mit visuellen Hilfsmitteln.

Wir trainieren das Modell zunächst für 1 Epoche bei einer Sequenzlänge von 32k Token und dann für 1 Epoche bei einer Sequenzlänge von 128k Token. In der ersten Phase (32k) sinkt die Lernrate von 2 × 10-5 auf 2 × 10-6, um sich dann in der zweiten Phase (128k) wieder auf 1 × 10-5 zu erwärmen, bevor sie schließlich auf 1 × 10-6 sinkt. Um die Trainingseffizienz zu verbessern, haben wir mehrere Trainingsbeispiele in jede Trainingssequenz gepackt.

2.6 RL-Infrastruktur

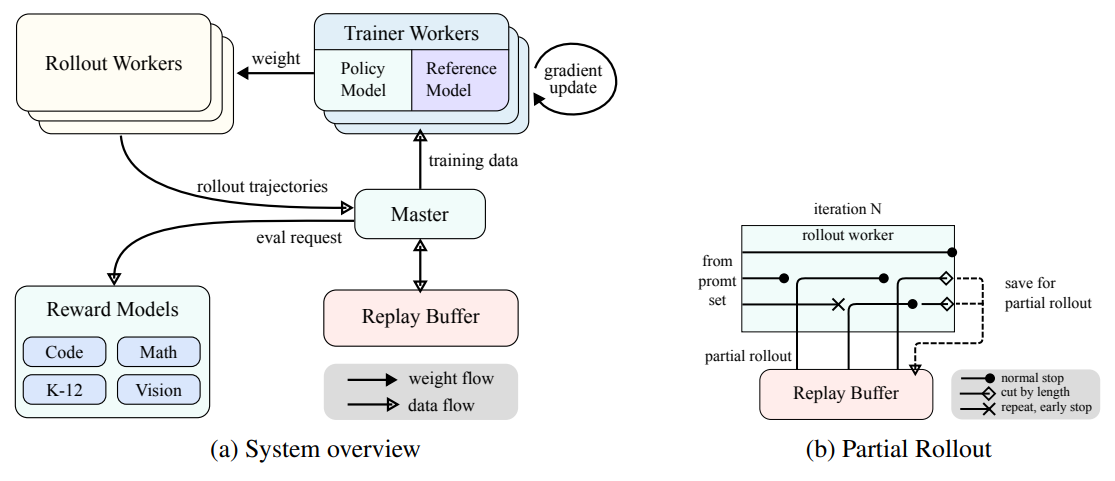

Abbildung 3: Großangelegtes Verstärkungslerntrainingssystem für LLMs

(a) Systemübersicht

(b) Teilweise Markteinführung

2.6.1 Groß angelegtes Reinforcement Learning Trainingssystem für LLMs

Im Bereich der KI hat sich das Verstärkungslernen (Reinforcement Learning, RL) zu einer wichtigen Trainingsmethode für groß angelegte Sprachmodelle (Large Scale Language Models, LLMs) entwickelt (Ouyang et al. 2022) (Jaech et al. 2024), wobei es sich von seinen Erfolgen bei der Beherrschung komplexer Spiele wie Go, Starcraft II und Dota 2 inspirieren ließ, unter anderem mit Systemen wie AlphaGo (Silver et al. 2017), AlphaStar (Vinyals et al. 2019) und OpenAI Dota Five (Berner et al. 2019), neben anderen Systemen. Dieser Tradition folgend, verwendet das Kimi k1.5-System ein iterativ synchronisiertes RL-Framework, das sorgfältig darauf ausgelegt ist, die Inferenz des Modells durch anhaltendes Lernen und Anpassung zu verbessern. Eine wichtige Neuerung in diesem System ist die Einführung der partiellen Rollout-Technik, mit der die Verarbeitung komplexer Inferenztrajektorien optimiert werden soll.

Wie in Abb. 3a dargestellt, arbeitet das RL-Trainingssystem mit einem iterativen Synchronisationsansatz, wobei jede Iteration aus einer Rollout-Phase und einer Trainingsphase besteht. Während der Rollout-Phase erzeugt ein Rollout-Worker, der von einem zentralen Master-Server koordiniert wird, Rollout-Trajektorien, indem er mit dem Modell interagiert, um eine Folge von Reaktionen auf verschiedene Eingaben zu erzeugen. Diese Trajektorien werden dann in einem Replay-Puffer gespeichert, der durch Unterbrechung der zeitlichen Korrelation einen vielfältigen und unverfälschten Trainingsdatensatz gewährleistet. In den nachfolgenden Trainingsphasen greift die Trainingsmappe auf diese Erfahrungen zurück, um die Gewichte des Modells zu aktualisieren. Dieser zyklische Prozess ermöglicht es dem Modell, kontinuierlich aus seinen Operationen zu lernen und seine Strategie im Laufe der Zeit anzupassen, um die Leistung zu verbessern.

Der zentrale Master-Server fungiert als zentraler Befehlsgeber, der den Datenfluss und die Kommunikation zwischen den Rollout-Workflows, den Trainings-Workflows, der Auswertung mit Reward-Modellen und den Replay-Puffern verwaltet. Er sorgt dafür, dass das System koordiniert arbeitet, gleicht die Last aus und ermöglicht eine effiziente Datenverarbeitung.

Die Trainingsroutine greift auf diese Rollout-Trajektorien zu, die entweder in einer einzigen Iteration abgeschlossen oder über mehrere Iterationen verteilt sind, um Gradientenaktualisierungen zu berechnen, die die Parameter des Modells verbessern und seine Leistung steigern. Dieser Prozess wird vom Reward-Modell überwacht, das die Qualität der Modellausgabe bewertet und das notwendige Feedback zur Steuerung des Trainingsprozesses liefert. Die Bewertung des Reward-Modells ist entscheidend für die Bestimmung der Wirksamkeit der Modellstrategie und die Ausrichtung des Modells auf optimale Leistung.

Darüber hinaus umfasst das System einen Code-Ausführungsdienst, der speziell für die Bewältigung von Code-Problemen entwickelt wurde und ein integraler Bestandteil des Belohnungsmodells ist. Dieser Dienst wertet die Ergebnisse des Modells in realen Codeszenarien aus und stellt so sicher, dass das Modelllernen eng mit realen Programmierherausforderungen verknüpft ist. Durch die Validierung der Lösung des Modells anhand der Ausführung von echtem Code ist diese Feedback-Schleife von wesentlicher Bedeutung für die Verbesserung der Strategie des Modells und die Steigerung seiner Leistung bei codebezogenen Aufgaben.

2.6.2 Teilweiser Rollout für lange CoT-RLs

Einer der Hauptgedanken unserer Arbeit ist die Erweiterung des RL-Trainings für langen Kontext. Partielles Rollout ist eine Schlüsseltechnik, die die Herausforderung des Umgangs mit langen CoT-Merkmalen effektiv angeht, indem sie Rollouts für lange und kurze Trajektorien verwaltet. Bei dieser Technik wird ein festes Budget an Ausgabe-Token festgelegt, das die Länge jeder Rollout-Trajektorie begrenzt. Wenn die Trajektorie während der Rollout-Phase das Token-Limit überschreitet, wird der unfertige Teil im Wiederholungspuffer gespeichert und in der nächsten Iteration fortgesetzt. So wird sichergestellt, dass keine einzelne lange Trajektorie die Ressourcen des Systems monopolisiert. Da die Rollout-Workflows asynchron ablaufen, können andere Workflows unabhängig voneinander neue, kürzere Rollout-Aufgaben abarbeiten, während einige Workflows lange Trajektorien verarbeiten. Der asynchrone Betrieb maximiert die Berechnungseffizienz, indem er sicherstellt, dass alle Rollout-Workflows aktiv zum Trainingsprozess beitragen und so die Gesamtleistung des Systems optimieren.

Wie in Abbildung 3b dargestellt, funktioniert das partielle Rollout-System durch Zerlegung langer Antworten in Fragmente über Iterationen hinweg (von Iteration n-m bis Iteration n). Der Wiedergabepuffer dient als zentraler Speichermechanismus für diese Antwortfragmente, wobei nur die aktuelle Iteration (Iteration n) online berechnet werden muss. Frühere Segmente (Iterationen n-m bis n-1) können effizient aus dem Puffer wiederverwendet werden, wodurch ein wiederholtes Ausrollen entfällt. Dieser segmentierte Ansatz reduziert den Rechenaufwand erheblich: Anstatt die gesamte Antwort auf einmal auszurollen, verarbeitet und speichert das System die Segmente inkrementell, wodurch längere Antworten generiert werden können, während die Iterationszeiten schnell bleiben. Während des Trainings können bestimmte Segmente von der Verlustberechnung ausgeschlossen werden, um den Lernprozess weiter zu optimieren, was das Gesamtsystem sowohl effizient als auch skalierbar macht.

Die Implementierung des partiellen Rollouts ermöglicht auch die Erkennung von Duplikaten. Das System erkennt doppelte Sequenzen in den generierten Inhalten und bricht sie frühzeitig ab, wodurch unnötige Berechnungen vermieden werden, während die Qualität der Ausgabe erhalten bleibt. Erkannte Duplikate können mit zusätzlichen Strafen belegt werden, um zu verhindern, dass redundante Inhalte im Cue-Set erzeugt werden.

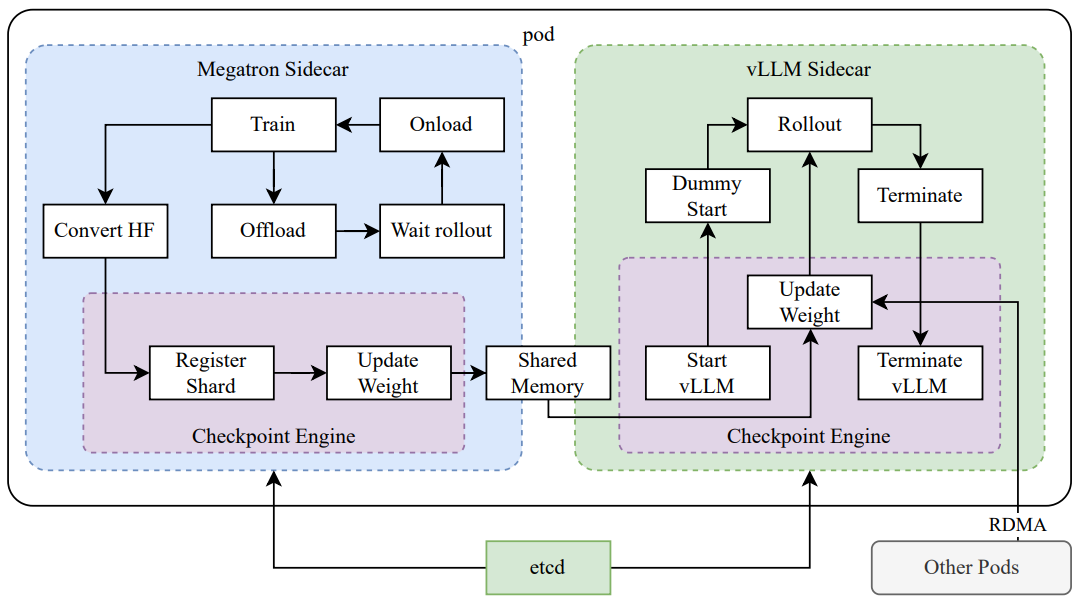

2.6.3 Hybrider Einsatz von Training und Argumentation

Der RL-Ausbildungsprozess besteht aus den folgenden Schritten:

Abbildung 4: Hybrider Bereitstellungsrahmen

- AusbildungsphaseErstens, das Megatron (Shoeybi et al. 2020) und die vLLM (Kwon et al. 2023) werden in separaten Containern ausgeführt, die von Shim-Prozessen, den sogenannten Checkpoint-Engines (Abschnitt 2.6.3), gekapselt sind. megatron beginnt mit dem Trainingsprozess. Sobald das Training abgeschlossen ist, entlädt Megatron den GPU-Speicher und bereitet die Übertragung der aktuellen Gewichte an vLLM vor.

- InferenzphaseNach dem Entladen von Megatron startet vLLM mit den virtuellen Modellgewichten und aktualisiert sie mit den neuesten Gewichten, die von Megatron über Mooncake übertragen wurden (Qin et al. 2024). Nach Abschluss des Rollouts stoppt die Checkpoint-Engine alle vLLM-Prozesse.

- Phase der NachschulungSobald der der vLLM zugewiesene Speicher freigegeben ist, entlädt Megatron den Speicher und beginnt eine neue Trainingsrunde.

Wir haben festgestellt, dass es schwierig ist, alle der folgenden Funktionen gleichzeitig mit der bestehenden Arbeit zu unterstützen.

- Komplexe parallele StrategienMegatron hat möglicherweise eine andere Parallelitätsstrategie als vLLM. Trainingsgewichte, die über mehrere Knoten in Megatron verteilt sind, lassen sich möglicherweise nur schwer mit vLLM teilen.

- Minimieren Sie ungenutzte GPU-RessourcenFür Online Policy RL können neuere Arbeiten (z.B. SGLang (L. Zheng et al. 2024) und VLLM) einige GPUs während des Trainings reservieren, was wiederum zu ungenutzten Trainings-GPUs führen kann. Es ist effizienter, die gleichen Geräte für Training und Inferenz zu nutzen.

- Dynamische SkalierbarkeitIn einigen Fällen können erhebliche Geschwindigkeitssteigerungen erreicht werden, indem die Anzahl der Inferenzknoten erhöht wird, während der Trainingsprozess konstant bleibt. Unser System kann die erforderliche Anzahl von freien GPU-Knoten effizient nutzen.

Wie in Abbildung 4 zu sehen ist, haben wir dieses hybride Deployment-Framework auf Megatron und vLLM (Abschnitt 2.6.3) implementiert, was zu einer Training-to-Reasoning-Phase in weniger als einer Minute und umgekehrt in etwa 10 Sekunden führte.

Hybride Bereitstellungsstrategie Wir schlagen eine hybride Bereitstellungsstrategie für Trainings- und Inferenzaufgaben vor, die Kubernetes-Sidecar-Container nutzt, um alle verfügbaren GPUs gemeinsam zu nutzen und so beide Arbeitslasten in einem einzigen Pod nebeneinander zu stellen. Die wichtigsten Vorteile dieser Strategie sind:

- Es erleichtert die effiziente gemeinsame Nutzung und Verwaltung von Ressourcen und verhindert, dass Trainingsknoten ungenutzt bleiben, während sie auf Inferenzknoten warten (wenn beide auf separaten Knoten eingesetzt werden).

- Durch die Verwendung verschiedener Einsatzbilder können Training und Inferenz unabhängig voneinander wiederholt werden, um eine bessere Leistung zu erzielen.

- Die Architektur ist nicht auf vLLM beschränkt und andere Frameworks können leicht integriert werden.

Checkpoint-Engine Die Checkpointing-Engine ist für die Verwaltung des Lebenszyklus des vLLM-Prozesses verantwortlich und stellt HTTP-APIs bereit, die verschiedene Operationen auf vLLM auslösen. Um die allgemeine Konsistenz und Zuverlässigkeit zu gewährleisten, verwenden wir ein globales Metadatensystem, das vom etcd-Dienst verwaltet wird, um Vorgänge und Status zu übermitteln.

Wenn vLLM deinstalliert wird, kann es schwierig sein, den GPU-Speicher vollständig freizugeben, hauptsächlich aufgrund von CUDA-Graphen, NCCL-Puffern und NVIDIA-Treibern. Um die Änderungen an vLLM zu minimieren, beenden wir sie und starten sie bei Bedarf neu, um eine bessere GPU-Auslastung und Fehlertoleranz zu erreichen.

Der Workaround in Megatron konvertiert eigene Checkpoints in das Hugging Face-Format im gemeinsamen Speicher. Diese Konvertierung berücksichtigt auch die Pipeline-Parallelität und die Experten-Parallelität, so dass nur die Tensor-Parallelität in diesen Prüfpunkten erhalten bleibt. Die Checkpoints im gemeinsamen Speicher werden dann fragmentiert und im globalen Metadatensystem registriert. Wir verwenden Mooncake, um Checkpoints zwischen Peer-Knoten über RDMA zu übertragen. Zum Laden der Gewichtungsdatei und zur Durchführung der tensorparallelen Transformation sind einige Änderungen an vLLM erforderlich.

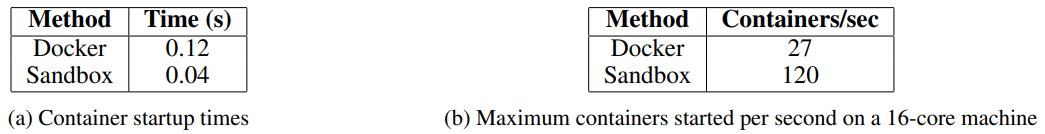

Wir haben die Sandbox als eine sichere Umgebung für die Ausführung von vom Nutzer eingereichtem Code entwickelt, die für die Codeausführung und das Code-Benchmarking optimiert ist. Durch den dynamischen Wechsel von Container-Images unterstützt die Sandbox verschiedene Anwendungsfälle durch MultiPL-E (Cassano, Gouwar, D. Nguyen, S. Nguyen, et al. 2023), DMOJ Judge Server², Lean, Jupyter Notebook und andere Images.

Für RL bei Codierungsaufgaben gewährleistet Sandbox die Zuverlässigkeit der Beurteilungen von Trainingsdaten durch die Bereitstellung eines konsistenten und wiederholbaren Evaluierungsmechanismus. Das Feedbacksystem unterstützt mehrstufige Evaluierungen, wie z. B. Feedback zur Codeausführung und Änderungen auf Repository-Ebene, wobei ein einheitlicher Kontext beibehalten wird, um faire und unvoreingenommene Benchmark-Vergleiche über Programmiersprachen hinweg zu gewährleisten.

Wir haben den Dienst auf Kubernetes implementiert, um Skalierbarkeit und Elastizität zu gewährleisten, und ihn über einen HTTP-Endpunkt für die externe Integration zugänglich gemacht.

Um die Leistung zu optimieren und RL-Umgebungen zu unterstützen, haben wir mehrere Technologien in unsere Codeausführungsdienste integriert, um die Effizienz, Geschwindigkeit und Zuverlässigkeit zu verbessern. Dazu gehören:

- Crun verwendenWir verwenden Crun als Container-Laufzeitumgebung anstelle von Docker, was die Startzeit der Container erheblich verkürzt.

- C-Gruppen-WiederverwendungWir erstellen cgroups im Voraus für die Verwendung durch Container, was in hochgradig gleichzeitigen Szenarien, in denen das Erstellen und Zerstören von cgroups für jeden Container ein Engpass sein kann, entscheidend ist.

- Optimierung der FestplattennutzungEin Hochgeschwindigkeits-Speicherplatz mit fester Größe wird durch ein Overlay-Dateisystem bereitgestellt, das als tmpfs gemountet wird, um Schreibvorgänge auf der Festplatte zu kontrollieren. Dieser Ansatz begünstigt temporäre Workloads.

Diese Optimierungen verbessern die Effizienz von RL bei der Code-Ausführung und bieten somit eine durchgängig zuverlässige Umgebung für die Evaluierung von RL-generiertem Code, was für das iterative Training und die Modellverbesserung unerlässlich ist.

3 Experimente

3.1 Bewertung

Da es sich bei k1.5 um ein multimodales Modell handelt, haben wir eine umfassende Bewertung der verschiedenen Modi in verschiedenen Benchmark-Tests durchgeführt. Der detaillierte Bewertungsaufbau ist in Anhang C zu finden. Unsere Benchmark-Tests bestehen aus den folgenden drei Hauptkategorien:

- Text-BenchmarkingMMLU (Hendrycks et al., 2020), IF-Eval (J. Zhou et al., 2023), CLUEWSC (L. Xu et al., 2020), C-EVAL (Y. Huang et al., 2023).

- Reasoning BenchmarkingHumanEval-Mul, LiveCodeBench (Jain et al. 2024), Codeforces, AIME 2024, MATH-500 (Lightman et al. 2023)

- Visuelles BenchmarkingMMMU (Yue, Ni, et al. 2024), MATH-Vision (K. Wang et al. 2024), MathVista (Lu et al. 2023).

3.2 Wichtigste Ergebnisse

K1.5 Lang-CoT-Modell Die Leistung des Kimi k1.5 long-CoT-Modells ist in Tabelle 2 dargestellt. Die langfristige Inferenzfähigkeit des Modells wird durch die überwachte Feinabstimmung des Long-CoT (beschrieben in Abschnitt 2.2) und das visuelle Text-Co-Reinforcement-Lernen (erörtert in Abschnitt 2.3) erheblich verbessert. Die Berechnungserweiterungen zur Testzeit verbessern die Leistung des Modells weiter, so dass es in einer Vielzahl von Modalitäten Spitzenergebnisse erzielen kann. Unsere Evaluierung zeigt signifikante Verbesserungen in der Fähigkeit des Modells, Informationen in erweiterten Kontexten zu verstehen und zu synthetisieren, was einen Fortschritt in den Fähigkeiten der multimodalen KI darstellt.

K1.5 Kurz-CoT-Modell Die Leistung des Kimi k1.5 short-CoT-Modells ist in Tabelle 3 dargestellt. Dieses Modell integriert eine Vielzahl von Techniken, darunter die traditionelle überwachte Feinabstimmung (erörtert in Abschnitt 2.5.2), das Verstärkungslernen (erörtert in Abschnitt 2.3) und die Lang-Kurz-Verfeinerung (erläutert in Abschnitt 2.4). Die Ergebnisse zeigen, dass das k1.5 short-CoT-Modell bei einer Reihe von Aufgaben im Vergleich zu führenden Open-Source- und proprietären Modellen eine konkurrenzfähige oder überlegene Leistung bietet. Dazu gehören textuelle, visuelle und schlussfolgernde Aufgaben, mit deutlichen Vorteilen beim Verstehen von natürlicher Sprache, Mathematik, Kodierung und logischem Schlussfolgern.

Tabelle 2: Leistung von Kimi k1.5 long-CoT und führenden Open-Source- und proprietären Modellen.

Tabelle 3: Leistung von Kimi k1.5 short-CoT und führenden Open-Source- und proprietären Modellen. Die Leistung des VLM-Modells wurde von der OpenCompass-Benchmarking-Plattform (https://opencompass.org.cn/) bezogen.

3.3 Erweiterung des langen Kontextes

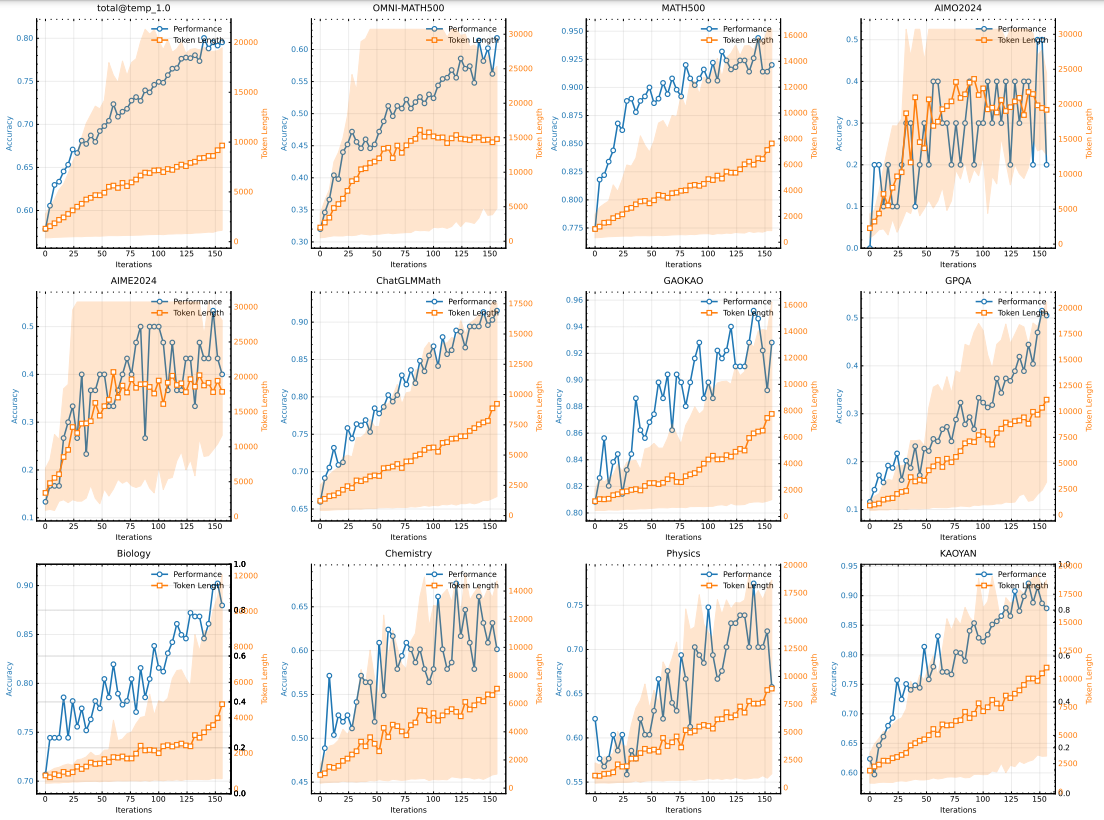

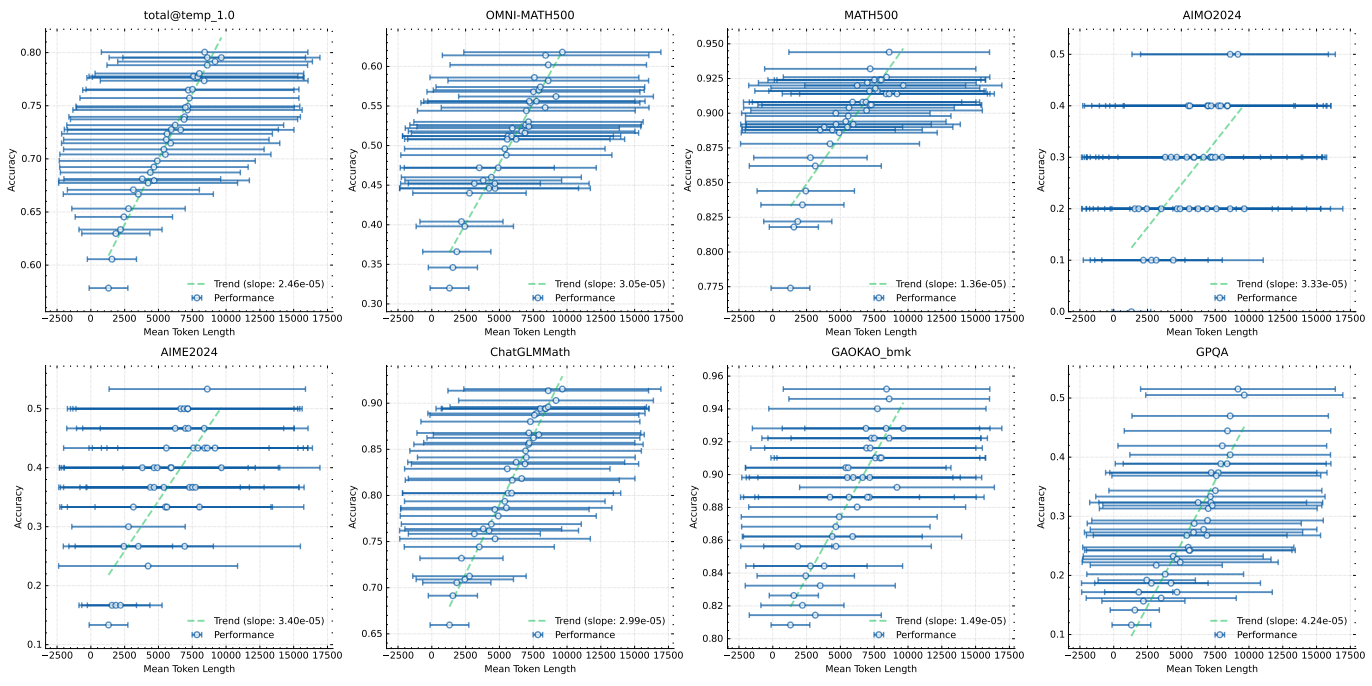

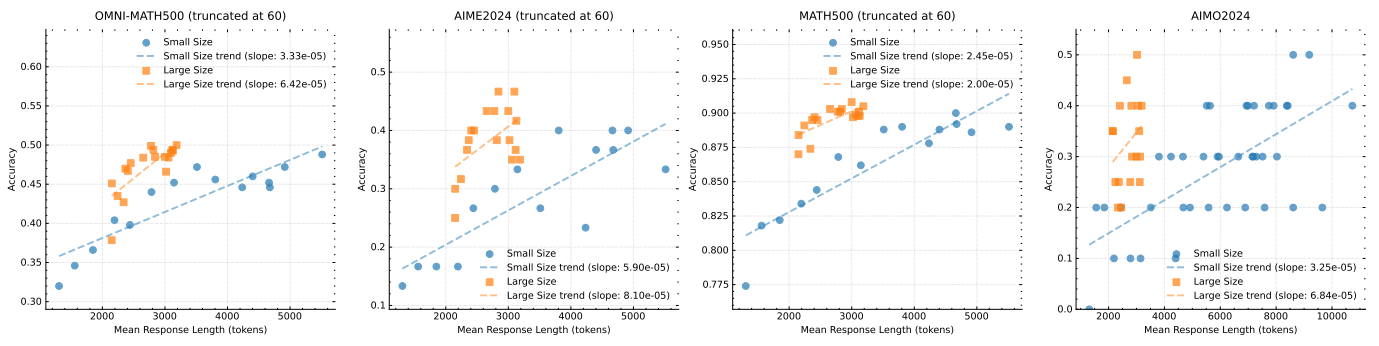

Wir verwenden ein mittelgroßes Modell, um die erweiterten Eigenschaften von RL mit LLM zu untersuchen. Abbildung 5 veranschaulicht die Entwicklung der Trainingsgenauigkeit und der Antwortlänge über die Trainingsiterationen für die kleine Modellvariante, die mit dem mathematischen Cue-Set trainiert wurde. Mit fortschreitendem Training beobachten wir eine gleichzeitige Zunahme der Antwortlänge und der Leistungsgenauigkeit. Insbesondere nimmt die Antwortlänge bei den anspruchsvolleren Benchmark-Tests schneller zu, was darauf hindeutet, dass das Modell lernt, detailliertere Lösungen für komplexe Probleme zu generieren. Abbildung 6 zeigt eine starke Korrelation zwischen der Länge des Ausgabekontexts des Modells und seiner Problemlösungsfähigkeit. Unser letzter Durchlauf mit k1.5 erweitert die Kontextlänge auf 128k und zeigt eine kontinuierliche Verbesserung bei den harten Inferenz-Benchmark-Tests.

Abbildung 5: Änderungen in der Trainingsgenauigkeit und -länge mit zunehmender Anzahl von Trainingsiterationen. Beachten Sie, dass die obigen Werte vom internen Long-Cot-Modell stammen, das eine viel kleinere Modellgröße hat als das k1.5 Long-CoT-Modell. Der schattierte Bereich zeigt das 95. Perzentil der Antwortlänge an.

3.4 Long2short

Wir vergleichen den vorgeschlagenen long2short-RL-Algorithmus mit den in Abschnitt 2.4 vorgestellten DPO-, Kürzestabweisungs- und Modellzusammenführungsmethoden und konzentrieren uns dabei auf die Token-Effizienz des long2short-Problems (X. Chen et al., 2024) und insbesondere darauf, wie die erhaltenen Long-Cot-Modelle den Short-Modellen zugutekommen können. In Abb. 7 bezeichnet k1.5-long das Long-Cot-Modell, das wir für das Long2short-Training wählen. k1.5-short w/ rl bezieht sich auf das Short-Modell, das durch Long2short-RL-Training erhalten wird. k1.5-short w/ dpo bezeichnet das Short-Modell, das zur Verbesserung der Token-Effizienz durch DPO-Training trainiert wird. k1.5-short w/ merge bezeichnet die Modellfusion. k1.5-short w/ merge bezeichnet die Modellfusion. k1.5-short w/ merge bezeichnet das Modell nach der Modellfusion, während k1.5-short w/ merge + rs das kürzeste Modell bezeichnet, das durch Anwendung des Shortest Rejection Samplings auf das fusionierte Modell erhalten wurde. k1.5-shortest bezeichnet das kürzeste Modell, das wir während des long2short Trainings erhalten haben. Wie Abb. 7 zeigt, weist der vorgeschlagene long2short RL-Algorithmus die höchste Token-Effizienz im Vergleich zu anderen Methoden wie DPO und Modellfusion auf. Es ist erwähnenswert, dass alle Modelle der k1.5-Familie (orange markiert) eine bessere Token-Effizienz aufweisen als die anderen Modelle (blau markiert). Zum Beispiel erreicht k1.5-short w/ rl einen Pass@1-Score von 60,8 auf AIME2024 (mit einem Durchschnitt von 8 Durchläufen), während es nur durchschnittlich 3.272 Token verbraucht. k1.5-shortest erreicht auf ähnliche Weise einen Pass@1-Score von 88,2 auf MATH500, während es ungefähr die gleiche Anzahl von Token verbraucht wie andere kurze Modelle.

Abbildung 6: Die Modellleistung verbessert sich mit zunehmender Antwortlänge

Abbildung 7: Long2Short-Leistung. Alle k1.5-Familien zeigen eine bessere Token-Effizienz als andere Modelle.

3.5 Studien zur Ablation

Erweiterung der Modellgröße und der Kontextlänge Unser Hauptbeitrag besteht darin, RL anzuwenden, um die Fähigkeit von Modellen zu verbessern, erweiterte CoTs zu generieren und somit ihre Schlussfolgerungen zu verbessern. Eine natürliche Frage ist: Wie verhält sich dies im Vergleich zu einer einfachen Erhöhung der Modellgröße? Um die Effektivität unseres Ansatzes zu demonstrieren, haben wir zwei Modelle unterschiedlicher Größe mit demselben Datensatz trainiert und die Evaluierungsergebnisse sowie die durchschnittliche Inferenzlänge an allen Kontrollpunkten während des RL-Trainings aufgezeichnet. Diese Ergebnisse sind in Abb. 8 dargestellt. Es ist erwähnenswert, dass, obwohl das größere Modell anfänglich das kleinere Modell übertrifft, das kleinere Modell eine vergleichbare Leistung erreichen kann, indem es die längere CoT ausnutzt, die durch RL optimiert wird. Allerdings weisen größere Modelle in der Regel eine bessere Token-Effizienz auf als kleinere Modelle. Dies deutet auch darauf hin, dass, wenn das Ziel darin besteht, die bestmögliche Leistung zu erzielen, die Erweiterung der Kontextlänge größerer Modelle eine höhere Obergrenze hat und effizienter für Token ist. Das Trainieren kleinerer Modelle mit längeren Kontextlängen kann jedoch eine praktikable Lösung sein, wenn der Rechenaufwand zum Zeitpunkt des Testens eingeplant wird.

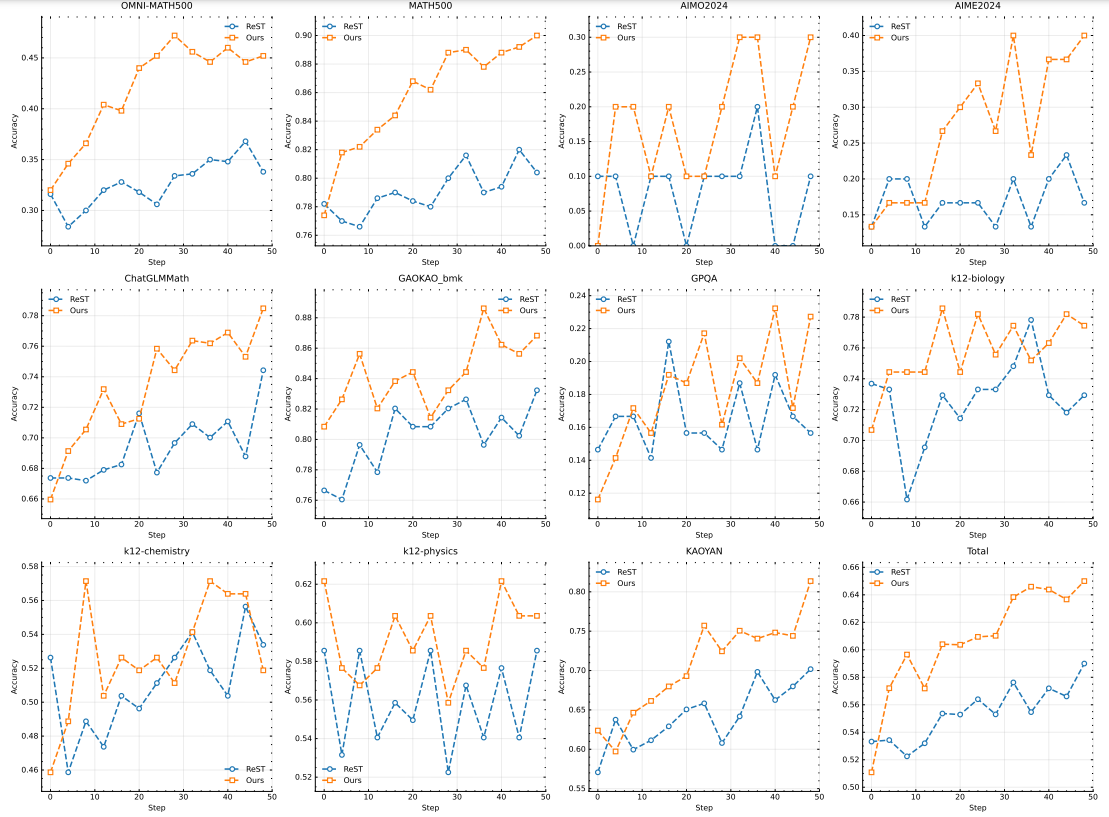

Auswirkungen der Verwendung negativer Gradienten Der Hauptunterschied zwischen ReST und anderen RL-basierten Methoden, einschließlich unserer, besteht darin, dass ReST das Modell iterativ verbessert, indem es die beste Antwort aus dem aktuellen Modell anpasst, ohne einen negativen Gradienten anzuwenden, um falsche Antworten zu bestrafen. Wie in Abb. 10 gezeigt, weist unsere Methode im Vergleich zu ReST eine höhere Komplexität der Stichproben auf, was darauf hindeutet, dass die Einbeziehung negativer Gradienten die Effizienz des Modells bei der Generierung von Long-CoTs deutlich verbessert. Unser Ansatz verbessert nicht nur die Qualität der Schlussfolgerungen, sondern optimiert auch den Trainingsprozess, was zu einer robusten Leistung mit weniger Trainingsstichproben führt. Dieses Ergebnis deutet darauf hin, dass die Wahl des Optimierungsalgorithmus in unserem Umfeld entscheidend ist, da der Leistungsunterschied zwischen ReST und anderen RL-basierten Methoden in anderen Domänen nicht so ausgeprägt ist wie in (Gulcehre et al. 2023). Somit unterstreichen unsere Ergebnisse die Bedeutung der Wahl einer geeigneten Optimierungsstrategie zur Maximierung der Effizienz bei der Generierung von Long-CoTs.

Probenahmestrategie Darüber hinaus demonstrieren wir die Wirksamkeit der in Abschnitt 2.3.4 vorgestellten Kursstichprobenstrategie. Unser Trainingsdatensatz D enthält Probleme verschiedener Schwierigkeitsgrade. Mit unserem Course-Sampling-Ansatz verwenden wir D zunächst für eine Aufwärmphase und trainieren dann das Modell, indem wir uns nur auf schwere Probleme konzentrieren. Diese Methode wird mit einer Basismethode verglichen, die eine einheitliche Sampling-Strategie ohne jegliche Kursabstimmung verwendet. Wie in Abb. 9 zu sehen ist, zeigen unsere Ergebnisse deutlich, dass das vorgeschlagene Kurs-Sampling-Verfahren die Leistung erheblich verbessert. Diese Verbesserung kann auf die Fähigkeit der Methode zurückgeführt werden, das Modell schrittweise herauszufordern, so dass es ein besseres Verständnis und die Fähigkeit entwickelt, mit komplexen Problemen umzugehen. Durch die Konzentration des Trainings auf schwierigere Probleme nach einer anfänglichen Generalisierung kann das Modell seine Argumentations- und Problemlösungsfähigkeiten besser ausbauen.

Abbildung 8: Modellleistung in Abhängigkeit von der Antwortlänge für verschiedene Modellgrößen

Abbildung 9: Analyse des Lernansatzes zur Modellierung der Leistung.

4 Schlussfolgerung

Wir präsentieren das Trainingsrezept und das Systemdesign für k1.5, unser neuestes multimodales LLM, das mit RL trainiert wird. Eine der wichtigsten Erkenntnisse, die wir aus der Praxis gewonnen haben, ist, dass die Skalierung der Kontextlänge für die kontinuierliche Verbesserung von LLMs entscheidend ist. Wir verwenden optimierte Lernalgorithmen und Optimierungen der Infrastruktur, wie z. B. partielles Rollout, um ein effizientes RL-Training für lange Kontexte zu erreichen. Die weitere Verbesserung der Effizienz und Skalierbarkeit des RL-Trainings für lange Kontexte bleibt ein wichtiger Weg in die Zukunft.

Abbildung 10: Vergleich der Richtlinienoptimierung mit ReST.

Ein weiterer Beitrag, den wir leisten, besteht darin, mehrere Techniken zu kombinieren, um die Optimierung von Strategien zu verbessern. Insbesondere haben wir Long-CoT RL mit LLM formuliert und Varianten des Online-Mirror-Descent für eine robuste Optimierung abgeleitet. Wir haben auch mit Sampling-Strategien, Längenstrafen und optimaler Datenformulierung experimentiert, um eine robuste RL-Leistung zu erreichen.

Wir zeigen, dass auch ohne den Einsatz ausgefeilterer Techniken (z. B. Monte-Carlo-Baumsuche, Wertfunktionen und Prozessbelohnungsmodelle) mit langen Kontexterweiterungen und verbesserter Strategieoptimierung eine starke Leistung erzielt werden kann. In Zukunft wäre es auch interessant zu untersuchen, wie man die Kreditvergabe verbessern und das Überdenken reduzieren kann, ohne die Explorationsfähigkeiten des Modells zu beeinträchtigen.

Wir haben auch das Potenzial der long2short-Methoden beobachtet. Diese Methoden verbessern die Leistung des Short-CoT-Modells in hohem Maße. Außerdem können die long2short-Methoden iterativ mit dem long-CoT RL kombiniert werden, um die Token-Effizienz weiter zu verbessern und die beste Leistung für ein bestimmtes Kontextlängenbudget zu erzielen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...