Audio-Reasoner: ein umfangreiches Sprachmodell zur Unterstützung von Audio-Deep-Reasoning

Allgemeine Einführung

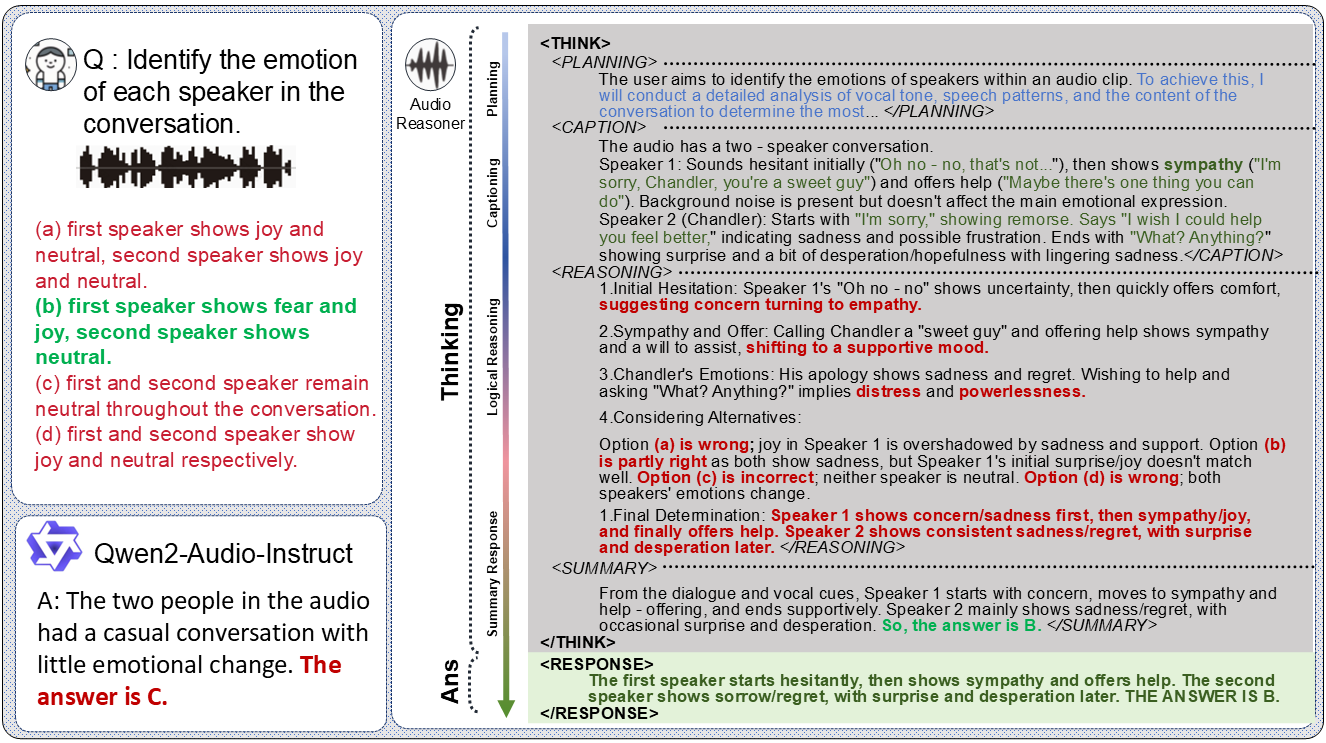

Audio-Reasoner ist ein Open-Source-Projekt, das von einem Team an der Tsinghua-Universität entwickelt und auf GitHub gehostet wird. Es konzentriert sich auf die Entwicklung von groß angelegten Sprachmodellen, die tiefgreifende Schlussfolgerungen in Audio unterstützen. Das Modell basiert auf Qwen2-Audio-Instruct, das komplexes Reasoning und multimodales Verstehen von Audioinhalten durch die Einführung einer strukturierten Chain-of-Thought (CoT) Technologie ermöglicht. Das Projekt umfasst das Audio-Reasoner-7B-Modell und den kommenden CoTA-Datensatz (mit 1,2 Millionen hochwertigen Samples), der eine führende Leistungsverbesserung von 25,42% bzw. 14,57% in den Benchmarks MMAU-mini und AIR-Bench-Chat erzielt hat.Audio-Reasoner Audio-Reasoner ist ein ideales Werkzeug für Forscher und Entwickler, da es die Verarbeitung von Ton, Musik, Sprache und anderen Audiotypen unterstützt und sich für Audioanalysen und Szenarien zum Verstehen von Inhalten eignet.

Funktionsliste

- Audio Deep ReasoningAnalyse von Audiodaten und Erarbeitung detaillierter Argumentationsprozesse und Ergebnisse durch strukturiertes Kettendenken.

- Multimodale Aufgabenunterstützung: Kombination von Audio- und Texteingaben für cross-modale Verständnis- und Argumentationsaufgaben.

- Mehrfache AudioverarbeitungUnterstützt die Erkennung und Analyse verschiedener Audiotypen wie Stimme, Musik, Sprache usw.

- Leistungsstarke vortrainierte ModelleAudio-Reasoner-7B: Bietet das Modell Audio-Reasoner-7B an, das in mehreren Benchmark-Tests hervorragend abschneidet.

- CoTA-DatensatzEnthält 1,2 Millionen Stichproben zur Unterstützung des strukturierten Inferenztrainings und der Verbesserung der Fähigkeiten von Modellen.

- Reasoning Code und DemonstrationBietet vollständigen Inferenzcode und Demo-Beispiele für Benutzertests und Entwicklung.

- Open-Source-Programm:: In Zukunft werden der Datensyntheseprozess und der Trainingscode offengelegt, um die Zusammenarbeit mit der Gemeinschaft zu erleichtern.

Hilfe verwenden

Einbauverfahren

Die Installation von Audio-Reasoner erfordert die Konfiguration der Python-Umgebung und das Herunterladen der Modellgewichte. Nachfolgend finden Sie die detaillierten Schritte, um sicherzustellen, dass die Benutzer die Erstellung erfolgreich abschließen können:

1. ein GitHub-Repository klonen

Beginnen Sie damit, das Audio-Reasoner-Projekt lokal zu klonen. Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus:

git clone https://github.com/xzf-thu/Audio-Reasoner.git

cd Audio-Reasoner

Dadurch werden die Projektdateien lokal und in das Projektverzeichnis heruntergeladen.

2. eine virtuelle Umgebung erstellen und aktivieren

Um Abhängigkeitskonflikte zu vermeiden, empfiehlt es sich, mit Conda eine separate Python-Umgebung zu erstellen:

conda create -n Audio-Reasoner python=3.10

conda activate Audio-Reasoner

Dieser Befehl erstellt und aktiviert eine auf Python 3.10 basierende Umgebung namens "Audio-Reasoner".

3. die Installation von Abhängigkeitspaketen

Das Projekt bietet requirements.txt Datei, die die notwendigen Abhängigkeiten enthält. Die Installationsschritte sind wie folgt:

pip install -r requirements.txt

pip install transformers==4.48.0

Achtung!transformers Um eine stabile Modellleistung zu gewährleisten, muss Version 4.48.0 installiert werden. Installieren Sie zuerst die anderen Abhängigkeiten und geben Sie dann die transformers Versionen, um Konflikte zu vermeiden.

4 Herunterladen von Modellgewichten

Das Audio-Reasoner-7B-Modell wurde auf HuggingFace veröffentlicht und muss manuell heruntergeladen und der Pfad konfiguriert werden:

- Interviews Umarmungsgesicht Audio-Reasoner-7Bladen Sie die Modelldatei herunter.

- Fügen Sie den heruntergeladenen Prüfpunktpfad in den Code in der

last_model_checkpointVariablen, zum Beispiel:

last_model_checkpoint = "/path/to/Audio-Reasoner-7B"

Wie zu verwenden

Nach der Installation kann der Benutzer Audio-Reasoner per Code ausführen, um Audioaufgaben zu erledigen. Im Folgenden finden Sie eine detaillierte Bedienungsanleitung:

Schnellstart: Führen Sie den Beispielcode aus

Das Projekt bietet ein Schnellstart-Beispiel, mit dem die Benutzer die Funktionalität des Modells testen können:

- Vorbereiten von Audiodateien

Standardmäßig verwendet es die projekteigeneassets/test.wavDatei, oder Sie können sie durch Ihr eigenes WAV-formatiertes Audiomaterial ersetzen. Stellen Sie sicher, dass der Pfad korrekt ist. - Audiopfade und Probleme bei der Bearbeitung von Code

zeigen (eine Eintrittskarte)inference.pyOder verwenden Sie einfach den folgenden Code, um den Audiopfad festzulegen und Fragen zu stellen:audiopath = "assets/test.wav" prompt = "这段音频的节奏感和拍子是怎样的?" audioreasoner_gen(audiopath, prompt) - laufendes Programm

Führen Sie es im Terminal aus:conda activate Audio-Reasoner cd Audio-Reasoner python inference.pyDas Modell gibt strukturierte Inferenzergebnisse aus, darunter

<THINK>(planen, beschreiben, begründen, zusammenfassen) und<RESPONSE>(Endgültige Antwort).

Kernfunktionalität: Audio Deep Reasoning

Das Herzstück von Audio-Reasoner ist das Audio-Reasoning, das auf dem Kettenprinzip basiert, und so funktioniert es:

- Audioeingang und Probleme

- ausnutzen

audioreasoner_genFunktion, wobei der Audiopfad und eine bestimmte Frage übergeben werden. Beispiel:audiopath = "your_audio.wav" prompt = "音频中是否有鸟叫声?" audioreasoner_gen(audiopath, prompt)

- ausnutzen

- Inferenzausgabe anzeigen

Das Modell liefert detaillierte Argumentationsprozesse, zum Beispiel:<THINK> <PLANNING>: 检查音频中的声音特征,识别是否有鸟叫声。 <CAPTION>: 音频包含自然环境音,可能有风声和动物叫声。 <REASONING>: 分析高频声音特征,与鸟类叫声模式匹配。 <SUMMARY>: 音频中可能存在鸟叫声。 </THINK> <RESPONSE>: 是的,音频中有鸟叫声。 - Einstellung der Ausgangsparameter (optional)

Wenn eine längere oder flexiblere Antwort erforderlich ist, kann sie geändert werdenRequestConfigParameter:request_config = RequestConfig(max_tokens=4096, temperature=0.5, stream=True)

Lokale Prüfung von voreingestellten Proben

Das Projekt verfügt über integrierte Test-Audios und Fragen zur schnellen Überprüfung:

conda activate Audio-Reasoner

cd Audio-Reasoner

python inference.py

Nach der Ausführung zeigt das Terminal eine Beschreibung der assets/test.wav Die Ergebnisse der Analysen sind für erste Erfahrungen geeignet.

Merkmal: Multimodales Verstehen

Audio-Reasoner unterstützt die gemeinsame Analyse von Audio und Text. Beispiel:

prompt = "这段音乐的情绪是否与‘悲伤’描述相符?"

audioreasoner_gen("sad_music.wav", prompt)

Das Modell kombiniert Audiomerkmale und Textsemantik, um Schlussfolgerungsergebnisse auszugeben.

Vorsichtsmaßnahmen und häufig gestellte Fragen

- AudioformatEmpfohlenes WAV-Format, Abtastrate 16kHz, mono.

- LangsamfahrendeWenn es langsam ist, prüfen Sie, ob die GPU aktiviert ist (erfordert PyTorch für CUDA).

- Modell antwortet nichtÜberprüfen Sie, ob der Modellpfad korrekt ist und ob die Abhängigkeiten vollständig installiert sind.

- AbhängigkeitskonfliktWenn die Installation fehlschlägt, versuchen Sie, eine neue Umgebung zu erstellen und die Abhängigkeiten in strikter Reihenfolge zu installieren.

Erweiterte Nutzung

- Benutzerdefinierte Argumentationslogik:: Änderungen

systemStichwortwörter zur Anpassung des Denkstils des Modells. - Stapeldatei:: Wille

max_batch_sizeSetzen Sie den Wert auf einen höheren Wert (z. B. 128), um die gleichzeitige Inferenz mehrerer Audios zu unterstützen. - Kombiniert mit CoTA-DatensatzKünftige CoTA-Datensätze können zum weiteren Training oder zur Feinabstimmung des Modells verwendet werden, wenn sie veröffentlicht werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...