Snowflake veröffentlicht Arctic Embed 2.0 Multilinguales Vektormodell für qualitativ hochwertige chinesische Suchanfragen

Snowflake freut sich, die Veröffentlichung von Arctic Embed L 2.0 im Gesang antworten Arctic Embed M 2.0 Arctic Embed 2.0, die nächste Version unseres innovativen Einbettungsmodells, unterstützt nun die mehrsprachige Suche. Während unsere früheren Versionen von Kunden, Partnern und der Open-Source-Gemeinschaft gut aufgenommen wurden und Millionen von Downloads erreicht haben, haben wir eine Anfrage erhalten: Können Sie dieses Modell mehrsprachig machen?Arctic Embed 2.0 baut auf der starken Grundlage unserer früheren Versionen auf und fügt mehrsprachige Unterstützung hinzu, ohne die englischsprachige Leistung oder Skalierbarkeit zu opfern, um die Bedürfnisse einer breiteren Benutzergemeinschaft zu erfüllen, die ein breites Spektrum an Sprachen und Anwendungen umfasst. Nutzergemeinschaft zu erfüllen, die eine Vielzahl von Sprachen und Anwendungen umfasst.

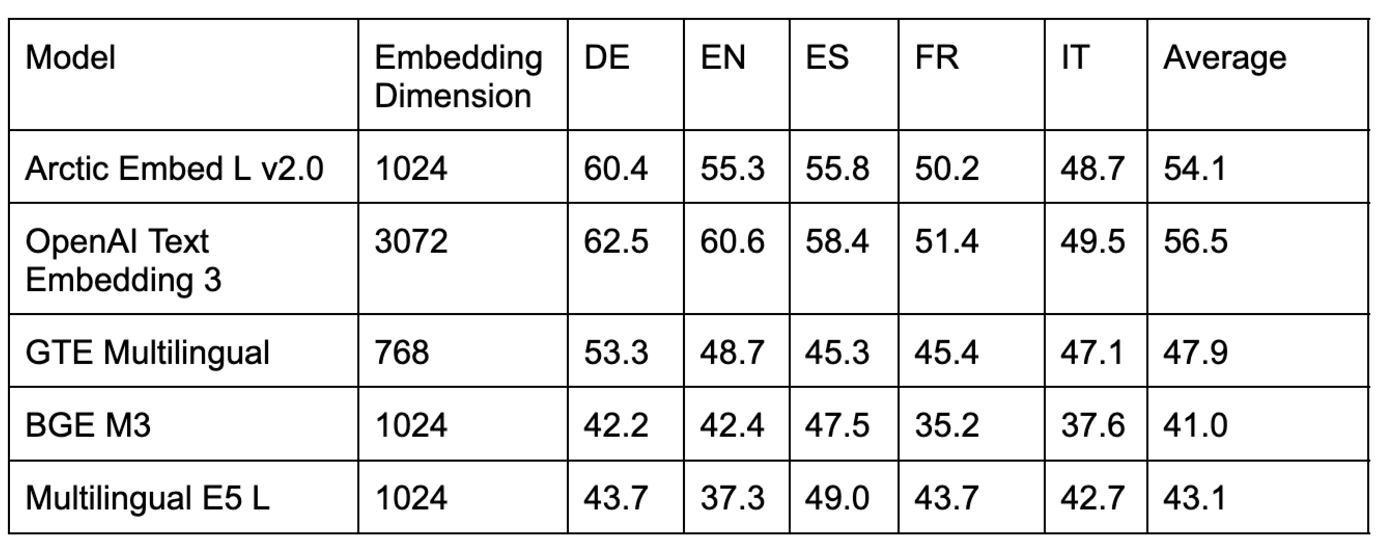

Abb. 1: Unidirektionale volumenintensive Retrievalleistung eines Open-Source-Modells für mehrsprachige Einbettung mit weniger als 1 Milliarde Parametern. Die Punktzahlen sind MTEB Abruf und die durchschnittliche nDCG@10 auf der CLEF (ELRA, 2006) Teilmenge (für Englisch, Französisch, Spanisch, Italienisch und Deutsch).

Mehrsprachigkeit ohne Kompromisse

In dieser Arctic Embed 2.0 Version veröffentlichen wir zwei verfügbare Varianten, eine mittlere Variante mit Schwerpunkt auf Inferenz-Effizienz, die auf Alibabas GTE-mehrsprachig Darüber hinaus gibt es mit 305 Millionen Parametern (von denen 113 Millionen nicht eingebettet sind) eine weitere große Variante, die sich auf die Abrufqualität konzentriert und auf Facebooks XMLR-Groß und die lange Kontextvariante mit 568 Millionen Parametern (davon 303 Millionen nicht eingebettete Parameter). Beide Größen unterstützen bis zu 8.192 Token Kontextlänge. Bei der Entwicklung von Arctic Embed 2.0 haben wir eine Herausforderung erkannt, mit der viele bestehende mehrsprachige Modelle konfrontiert sind: Die Optimierung für mehrere Sprachen führt oft dazu, dass die Qualität des englischen Retrievals geopfert wird. Dies hat dazu geführt, dass viele Modelle in diesem Bereich zwei Varianten für jede Version haben: Englisch und mehrsprachig. Die Arctic Embed 2.0 Modelle sind anders. Sie bieten Spitzenleistungen in nicht-englischen Sprachen wie Deutsch, Spanisch und Französisch und übertreffen gleichzeitig ihre rein englischsprachigen Vorgängermodelle bei der Suche auf Englisch. Arctic Embed M 1.5.

Durch die sorgfältige Abwägung zwischen dem Bedarf an Mehrsprachigkeit und Snowflakes Engagement für hervorragende Leistungen bei der Suche in englischer Sprache haben wir Arctic Embed 2.0 zu einem universellen Arbeitsmodell für eine breite Palette von globalen Anwendungsfällen gemacht. In diesem Dokument beziehen sich alle qualitativen Bewertungen auf die durchschnittlichen NDCG@10-Werte für alle Aufgaben, sofern nicht anders angegeben.

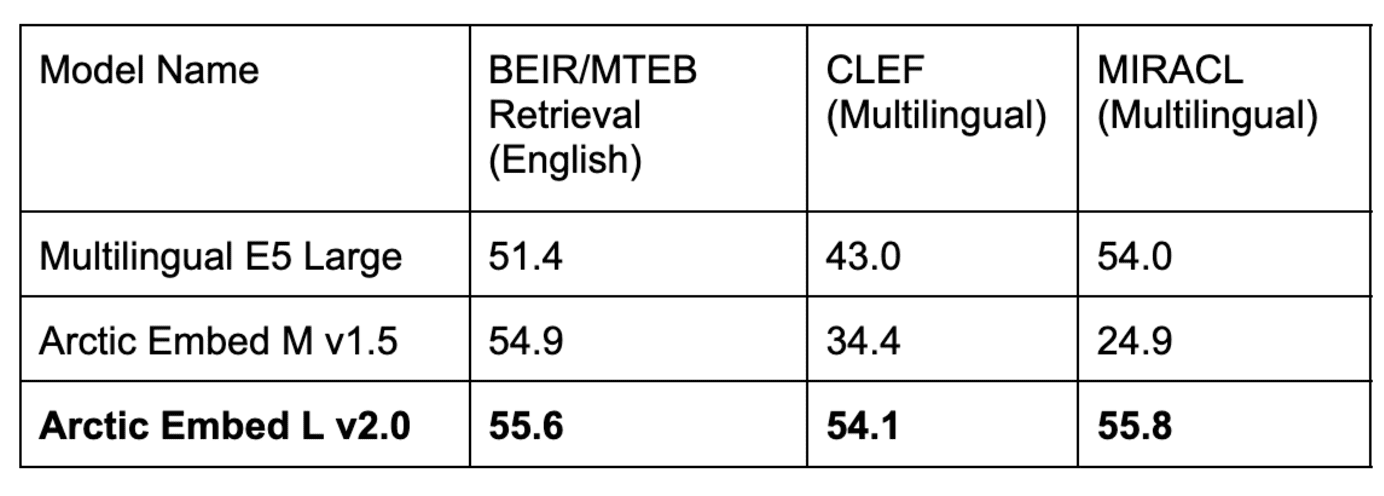

Tabelle 1. Unser Arctic Embed L v2.0 Modell erreicht hohe Werte im beliebten englischen MTEB Retrieval Benchmark sowie eine hohe Retrieval-Qualität in mehreren mehrsprachigen Benchmarks. frühere Iterationen von Arctic Embed haben gute Leistungen im Englischen, aber schlechte in der Mehrsprachigkeit erbracht, während beliebte mehrsprachige Open-Source-Modelle die englische Leistung gesunken ist. Alle Modell- und Datensatzbewertungen spiegeln den Durchschnitt der NDCG@10 wider, die CLEF- und MIRACL-Bewertungen den Durchschnitt der deutschen (DE), englischen (EN), spanischen (ES), französischen (FR) und italienischen (IT).

Der vielfältige und leistungsstarke Funktionsumfang von Arctic Embed 2.0

- Durchsatz und Effizienz der Unternehmensklasse: Das Modell Arctic Embed 2.0 ist auf die Bedürfnisse von Großunternehmen zugeschnitten. Selbst unser "großes" Modell hat Parameter von weit unter einer Milliarde und bietet eine schnelle Einbettung mit hohem Durchsatz. Auf der Grundlage interner Tests verarbeitet es problemlos über 100 Dokumente pro Sekunde (im Durchschnitt) auf NVIDIA A10 GPUs und erreicht eine Latenzzeit von weniger als 10 Millisekunden bei der Einbettung von Abfragen, was einen realen Einsatz auf kostengünstiger Hardware ermöglicht.

- Kompromisslose englische und nicht-englische Suchqualität: Trotz ihrer kompakten Größe erreichten beide Arctic Embed 2.0-Modelle beeindruckende NDCG@10-Ergebnisse auf einer Vielzahl von englischen und nicht-englischen Benchmark-Datensätzen, was ihre gute Generalisierungsfähigkeit auch für Sprachen, die nicht in der Trainingslösung enthalten sind, demonstriert. Diese beeindruckenden Benchmark-Ergebnisse machen Arctic Embed L 2.0 zu einem der führenden Retrieval-Modelle auf dem neuesten Stand der Technik.

- Skalierbares Retrieval über Matryoshka Representation Learning (MRL): Arctic Embed Version 2.0 enthält die gleiche quantisierungsfreundliche MRL-Funktionalität, die in Arctic Embed 1.5 eingeführt wurde und es den Benutzern ermöglicht, die Kosten zu reduzieren und die Größe bei der Suche in großen Datensätzen zu optimieren. Mit zwei Modellgrößen können Benutzer qualitativ hochwertige Suchen mit nur 128 Bytes pro Vektor durchführen (96-mal kleiner als die unkomprimierte Einbettung von OpenAIs beliebtem Text-Embedding-3-Large-Modell ^1^). Wie Arctic Embed 1.5 übertrifft auch das Modell Arctic Embed 2.0 mehrere MRL-fähige Konkurrenten im komprimierten Zustand, mit deutlich geringerer Qualitätsverschlechterung und höheren Benchmark-Ergebnissen.

- Wahrhaftig quelloffen: Das Arctic Embed 2.0 Modell wird unter der großzügigen Apache 2.0 Lizenz veröffentlicht.

Open Source-Flexibilität trifft auf Zuverlässigkeit der Unternehmensklasse

Wie ihre Vorgänger werden auch die Arctic Embed 2.0-Modelle unter der großzügigen Apache 2.0-Lizenz veröffentlicht, so dass Unternehmen sie unter den bekannten Lizenzen ändern, einsetzen und erweitern können. Diese Modelle sind sofort einsatzbereit, unterstützen Anwendungen in verschiedenen Branchen durch zuverlässige mehrsprachige Einbettung und verfügen über gute Verallgemeinerungsmöglichkeiten.

Clément Delangue, CEO von Hugging Face, sagte: "Mehrsprachige Einbettungsmodelle sind entscheidend, um Menschen auf der ganzen Welt, nicht nur Englischsprechende, in die Lage zu versetzen, KI zu entwickeln. Indem Snowflake diese hochmodernen Modelle als Open Source auf Hugging Face veröffentlicht, leistet es einen großen Beitrag zur KI und zur Welt."

Tatsächlich verdient die Arctic Embed 2.0-Familie, insbesondere unter den Open-Source-Optionen, besondere Aufmerksamkeit für ihre beobachteten Generalisierungsfähigkeiten in mehrsprachigen Suchbenchmarks. Durch Lizenzierung Sprachenübergreifendes Evaluierungsforum (CLEF), Testreihe 2000-2003Unser Team war in der Lage, die Qualität der Out-of-Domain-Abfrage verschiedener Open-Source-Modelle zu messen und stellte einen unglücklichen Trend bei In-Domain MIRACL schwache Leistung im Vergleich zu den Ergebnissen, die mit dem Evaluierungsset erzielt wurden. Wir stellen die Hypothese auf, dass einige der frühen Open-Source-Modellentwickler ihre Trainingsszenarien versehentlich zu stark angepasst haben, um die MIRACL-Leistung auf Kosten der MIRACL-Leistung zu verbessern, und somit die MIRACL-Trainingsdaten zu stark angepasst haben könnten. Bleiben Sie dran für einen kommenden technischen Bericht darüber, wie das Arctic Embed 2.0 Modell trainiert wurde und was wir während des Trainingsprozesses gelernt haben.

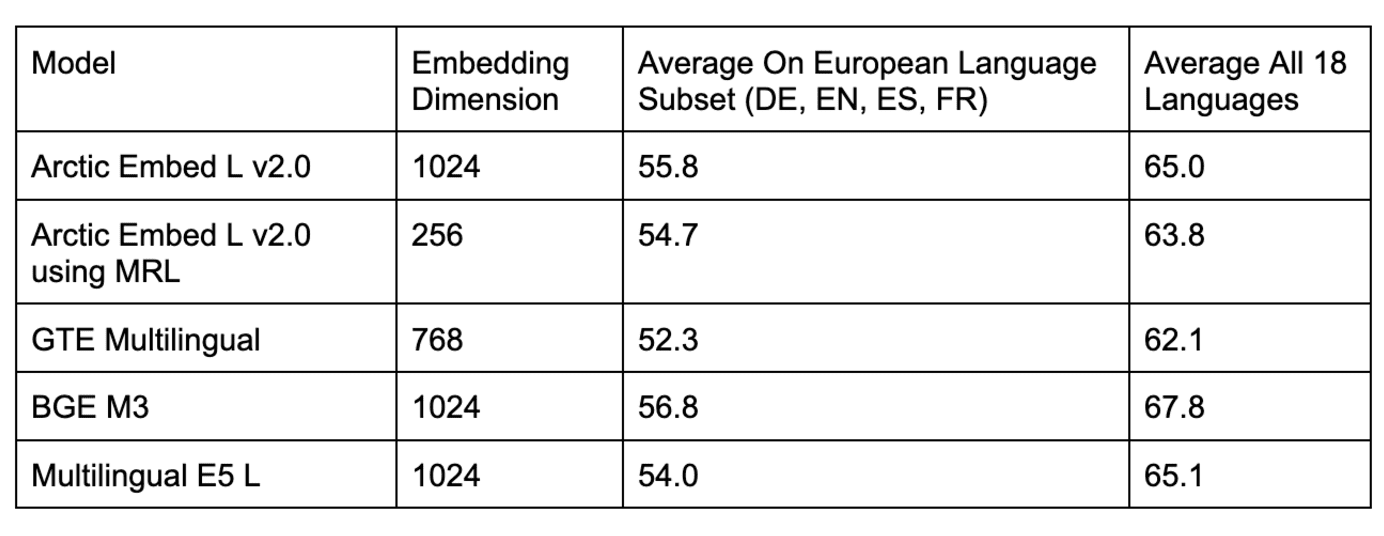

Tabelle 2: Vergleich mehrsprachiger Retrieval-Modelle mit verschiedenen Datensätzen aus dem CLEF-Benchmarking außerhalb der Domäne.

Tabelle 3: Vergleich mehrerer mehrsprachiger Open-Source-Retrieval-Modelle beim domäneninternen MIRACL-Benchmarking.

Wie aus den Tabellen 2 und 3 hervorgeht, werden mehrere beliebte Open-Source-Modelle für die domäneninterne MIRACL-Bewertung mit dem Arctic Embed L 2.0 Ergebnisse sind vergleichbar, schneiden aber bei CLEF-Evaluierungen außerhalb der Domäne schlecht ab. Wir haben auch beliebte Closed-Source-Modelle (z. B. das Text-Embedding-3-Large-Modell von OpenAI) einem Benchmarking unterzogen und festgestellt, dass Arctic L 2.0 mit den führenden proprietären Modellen mithalten kann.

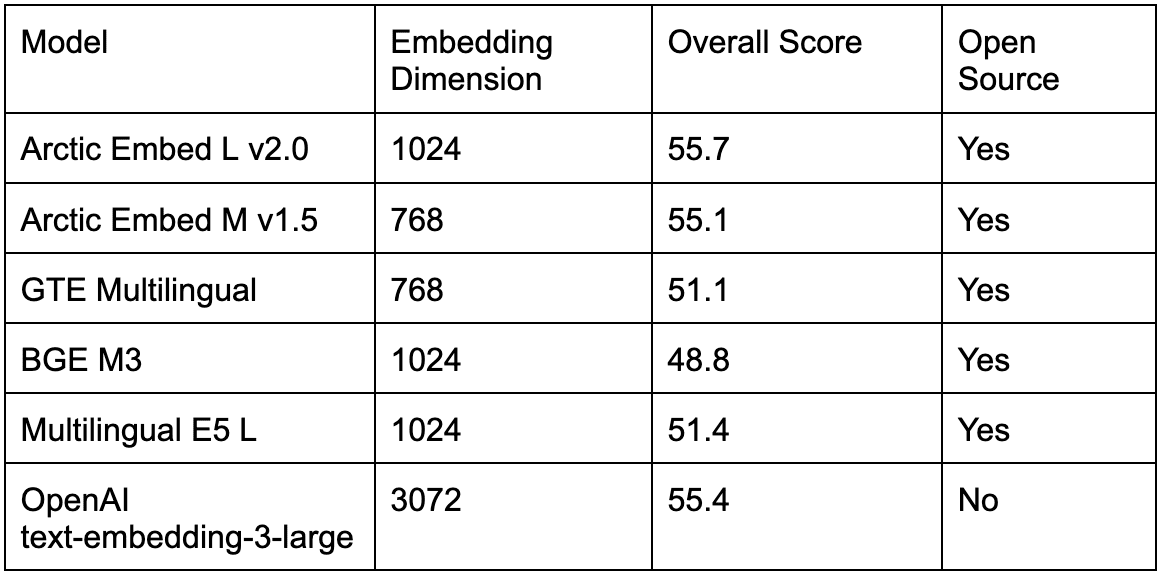

Wie aus Tabelle 4 hervorgeht, sind die vorhandenen mehrsprachigen Open-Source-Modelle auch im beliebten englischen MTEB-Retrieval-Benchmark-Test besser als die Arctic Embed L 2.0 Dies zwang Benutzer, die mehrere Sprachen unterstützen wollten, dazu, zwischen einer geringeren Qualität der englischen Suche oder der erhöhten Komplexität der Verwendung eines zweiten Modells für die rein englische Suche zu wählen. Mit der Veröffentlichung von Arctic Embed 2.0 können Praktiker nun zu einem einzigen Open-Source-Modell wechseln, ohne die englische Suchqualität zu beeinträchtigen.

Tabelle 4: Vergleich der besten Open-Source- und Closed-Source-Modelle für das mehrsprachige Retrieval im domäneninternen MTEB-Retrieval-Benchmarking.

Komprimierung und Effizienz ohne Abstriche

Snowflake legt bei der Entwicklung seines eingebetteten Modells weiterhin den Schwerpunkt auf Effizienz und Skalierbarkeit. Mit Hilfe von Arctic Embed L 2.0Dies ermöglicht es den Nutzern, die Qualitätsmerkmale großer Modelle in kompakte Einbettungen zu komprimieren, die nur 128 Byte Speicherplatz pro Vektor benötigen. Dies ermöglicht die Bereitstellung von Abrufdiensten für Millionen von Dokumenten zu geringen Kosten auf Low-End-Hardware. Wir haben auch Effizienzsteigerungen beim Einbettungsdurchsatz erreicht, indem wir die beeindruckende Abrufqualität von Arctic Embed 2.0 auf 100 Millionen bzw. 300 Millionen nicht eingebettete Parameter für die beiden Größen (mittel und groß) komprimiert haben - eine nur geringfügige Steigerung gegenüber unserer früheren, rein englischen Version.

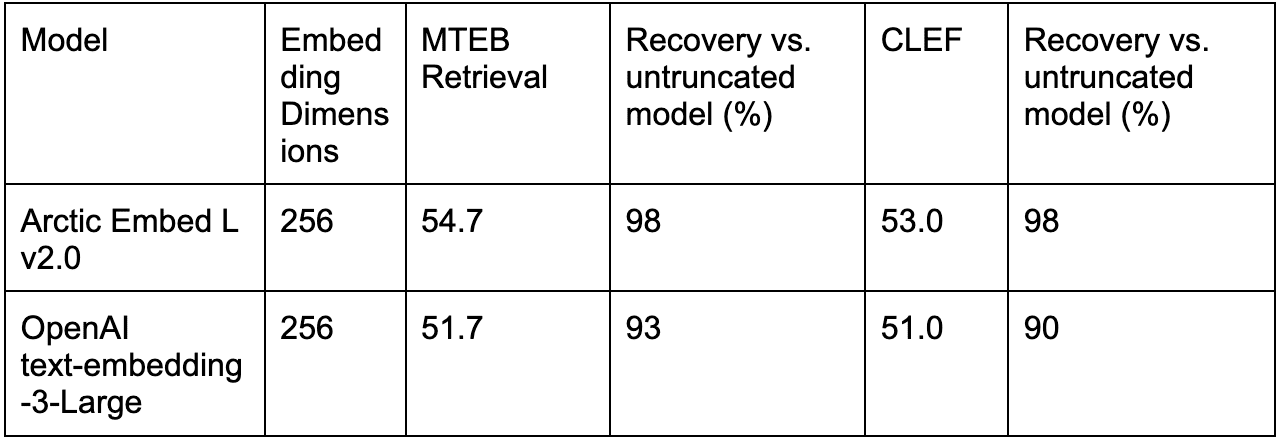

In der Tat sind skalenorientierte Mechanismen Arctic Embed L 2.0 Im Vergleich zu anderen MRL-trainierten Modellen (z.B. OpenAI's text-embedding-3-large) erreicht es eine bessere Qualität unter Kompression.

Tabelle 5 vergleicht die Leistung von OpenAI's text-embedding-3-large mit truncated embedding mit Arctic Embed L 2.0 für nur Englisch (MTEB Retrieval) und mehrsprachig (CLEF).

Schlussfolgerung: Ein neuer Standard für mehrsprachige, effiziente Suchvorgänge

Mit Arctic Embed 2.0 hat Snowflake einen neuen Standard für mehrsprachige, effiziente Einbettungsmodelle gesetzt. Darüber hinaus haben wir die Grenzen der Qualität von Texteinbettungen nicht nur effizient, sondern auch als Open Source verfügbar gemacht. Ganz gleich, ob Sie Ihre Reichweite auf mehrsprachige Benutzer ausdehnen, Speicherkosten reduzieren oder Dokumente auf barrierefreier Hardware einbetten möchten, Arctic Embed 2.0 bietet die Funktionen und die Flexibilität, um Ihre Anforderungen zu erfüllen.

Unsere kommenden technischen Berichte werden die Innovationen hinter Arctic Embed 2.0 näher beleuchten. In der Zwischenzeit laden wir Sie dazu ein, noch heute mit Snowflake einzubetten.

^1^ Bei dieser Berechnung wird das Format float32 für die unkomprimierte Basislinie verwendet, d. h. 3 072 Zahlen mit jeweils 32 Bits, insgesamt 98 304 Bits pro Vektor, was genau 96 Mal größer ist als die 1 024 Bits pro Vektor (entspricht 128 Byte pro Vektor), die bei der Speicherung von 256-dimensionalen Vektoren, die von MRL im Modell Arctic Embed 2.0 im Format int4 abgeschnitten wurden, verwendet werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...