ARC-AGI-2 Ergebnisse enthüllt: Waterloo für alle KI-Modelle - Denkfähigkeiten

Benchmarks zur Messung des Fortschritts in der allgemeinen künstlichen Intelligenz (AGI) sind von entscheidender Bedeutung. Effektive Benchmarks zeigen Fähigkeiten auf, und großartige Benchmarks sind eher geeignet, Forschungsrichtungen zu inspirieren.Die ARC Prize Foundation verpflichtet sich, eine Plattform für die Entwicklung und Verbreitung von AGI durch ihre ARC-AGI Die Reihe der Benchmarks spielt eine solche Rolle, indem sie die Forschungsanstrengungen auf eine echte Allzweckintelligenz ausrichtet. Die neueste ARC-AGI-2 Die Benchmarks und ihre vorläufigen Testergebnisse sind ein Weckruf für die aktuellen Probleme mit den Grenzen und der Effizienz von KI-Funktionen.

ARC-AGI-1 Seit seiner Einführung im Jahr 2019 hat es eine einzigartige Rolle bei der Verfolgung des Fortschritts von AGI gespielt und dazu beigetragen, den Zeitpunkt zu bestimmen, an dem KI beginnt, über das bloße Speichern von Mustern hinauszugehen. Im Anschluss daran ARC Prize 2024 Der Wettbewerb hat auch eine große Anzahl von Forschern angezogen, die neue Ideen für die Anpassung der Testzeit erforschen.

Der Weg zur AGI ist jedoch noch weit. Die derzeitigen Fortschritte, wie zum Beispiel OpenAI (in Form eines Nominalausdrucks) o3 Was die Systeme zeigen, ist vielleicht ein begrenzter Durchbruch in der Dimension der "fluiden Intelligenz". Diese Systeme sind nicht nur ineffizient, sondern erfordern auch viel menschliche Aufsicht. Es ist klar, dass mehr Innovation an der Quelle erforderlich ist, um AGI zu realisieren.

Eine neue Herausforderung: ARC-AGI-2, gebaut, um die Schwächen der KI aufzudecken

Zu diesem Zweck hat die Stiftung ARC Prize nun den ARC-AGI-2 Benchmarks. Er ist mit einem klaren Ziel vor Augen konzipiert: Er soll für KI (insbesondere für logisch denkende Systeme) deutlich schwieriger sein, während er für Menschen relativ einfach zu handhaben ist. Dies ist nicht einfach eine Erhöhung des Schwierigkeitsgrads, sondern eine gezielte Herausforderung an die Barrieren, die aktuelle KI-Methoden nur schwer überwinden können.

Designphilosophie: Konzentration auf die Intelligenzlücke, wo Menschen einfach und KI schwierig sind

Im Gegensatz zu vielen anderen KI-Benchmarks, die auf übermenschliche Fähigkeiten abzielen, ist derARC-AGI Konzentrieren Sie sich auf Aufgaben, die für Menschen relativ einfach, für die derzeitige KI aber extrem schwierig sind. Diese Strategie zielt darauf ab, Lücken in den Fähigkeiten aufzudecken, die nicht durch einfaches "Hochskalieren" geschlossen werden können. Das Herzstück der allgemeinen Intelligenz ist die Fähigkeit, Wissen aus begrenzter Erfahrung effizient zu verallgemeinern und anzuwenden, was die Schwäche der derzeitigen KI ist.

ARC-AGI-2: Eskalierender Schwierigkeitsgrad, direkte Konfrontation mit den Schwächen der KI im Denken

ARC-AGI-2 existieren ARC-AGI-1 Mit der Einführung der KI sind die Anforderungen an die KI erheblich gestiegen, wobei eine Kombination aus hoher Anpassungsfähigkeit und Effizienz im Vordergrund steht. Durch die Analyse des Scheiterns der modernsten KI bei früheren Aufgaben hat dieARC-AGI-2 Einführung weiterer Aufgaben, die die Fähigkeit testen, Symbole zu interpretieren, kombinatorisch zu denken, kontextbezogene Regeln anzuwenden und vieles mehr. Diese Aufgaben sollen die KI dazu zwingen, über den oberflächlichen Musterabgleich hinaus auf eine tiefere Ebene der Abstraktion und des Denkens zu gelangen.

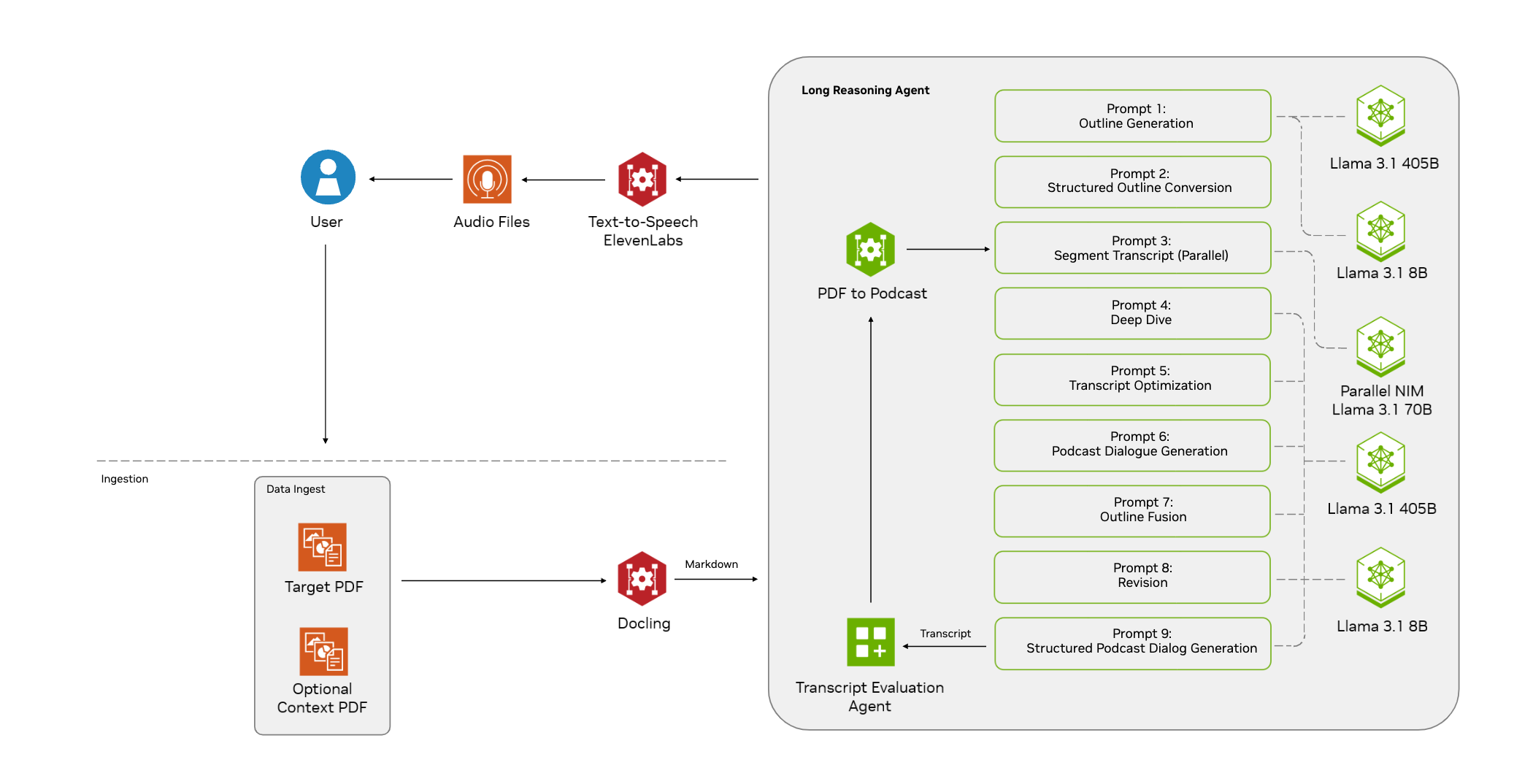

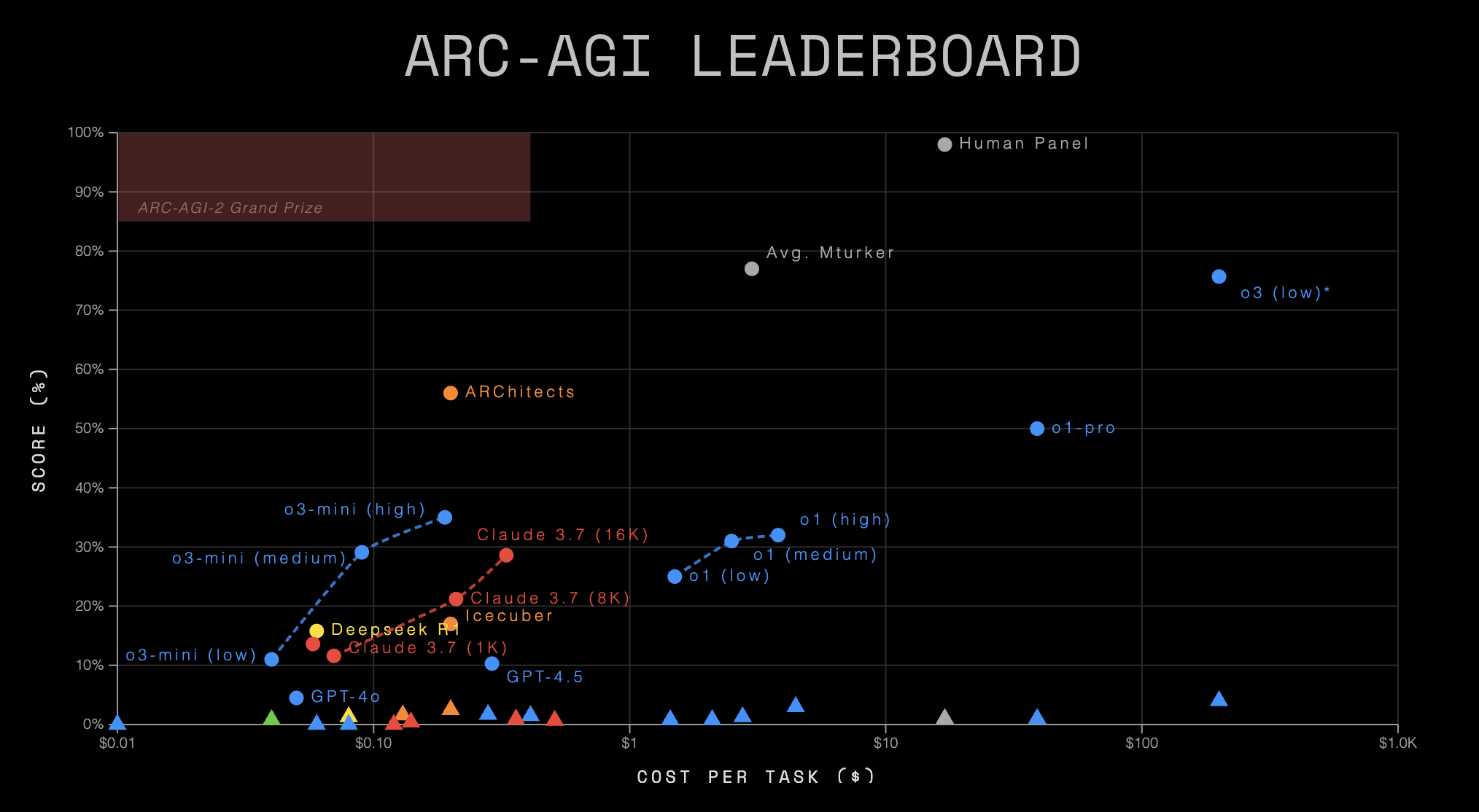

ARC-AGI-2-Bericht: ein düsteres Bild der Realität

Zuletzt veröffentlicht ARC-AGI Die Leaderboard-Daten zeichnen ein düsteres Bild der aktuellen KI-Fähigkeiten. Diese Daten bestätigen nicht nur, dass ARC-AGI-2 Das ist eine große Herausforderung und offenbart die große Kluft in der allgemeinen Denkfähigkeit und Effizienz der KI.

Übersicht der Leaderboard-Daten

| KI-System | Organisation | System Typ | ARC-AGI-1 | ARC-AGI-2 | Kosten/Aufgabe | Code / Papier |

|---|---|---|---|---|---|---|

| Menschliches Gremium | Menschen | K.A. | 98.0% | 100.0% | $17.00 | - |

| o3 (niedrig)* | OpenAI | CoT + Synthese | 75.7% | 4.0% | $200.00 | 📄 |

| o1 (hoch) | OpenAI | CoT | 32.0% | 3.0% | $4.45 | 💻 |

| ARChitects | ARC-Preis 2024 | Benutzerdefiniert | 56.0% | 2.5% | $0.200 | 📄💻 |

| o3-mini (mittel) | OpenAI | CoT | 29.1% | 1.7% | $0.280 | 💻 |

| Icecuber | ARC-Preis 2024 | Benutzerdefiniert | 17.0% | 1.6% | $0.130 | 💻 |

| o3-mini (hoch) | OpenAI | CoT | 35.0% | 1.5% | $0.410 | 💻 |

| Zwillinge 2.0 Blitzlicht | Google Internet-Unternehmen | Basis LLM | K.A. | 1.3% | $0.004 | 💻 |

| o1 (mittel) | OpenAI | CoT | 31.0% | 1.3% | $2.76 | 💻 |

| Deepseek R1 | Deepseek | CoT | 15.8% | 1.3% | $0.080 | 💻 |

| Gemini-2.5-Pro-Exp-03-25 ** | Google Internet-Unternehmen | CoT | 12.5% | 1.3% | K.A. | 💻 |

| o1-pro | OpenAI | CoT + Synthese | 50.0% | 1.0% | $39.00 | - |

| Claude 3.7 (8K) | Anthropisch | CoT | 21.2% | 0.9% | $0.360 | 💻 |

| Zwilling 1.5 Pro | Google Internet-Unternehmen | Basis LLM | K.A. | 0.8% | $0.040 | 💻 |

| GPT-4.5 | OpenAI | Basis LLM | 10.3% | 0.8% | $2.10 | 💻 |

| o1 (niedrig) | OpenAI | CoT | 25.0% | 0.8% | $1.44 | 💻 |

| Claude 3.7 (16K) | Anthropisch | CoT | 28.6% | 0.7% | $0.510 | 💻 |

| Claude 3.7 (1K) | Anthropisch | CoT | 11.6% | 0.4% | $0.140 | 💻 |

| Claude 3.7 | Anthropisch | Basis LLM | 13.6% | 0.0% | $0.120 | 💻 |

| GPT-4o | OpenAI | Basis LLM | 4.5% | 0.0% | $0.080 | 💻 |

| GPT-4o-mini | OpenAI | Basis LLM | K.A. | 0.0% | $0.010 | 💻 |

| o3-mini (niedrig) | OpenAI | CoT | 11.0% | 0.0% | $0.060 | 💻 |

(Anmerkung: * kennzeichnet vorläufige Schätzungen in der Tabelle.* kennzeichnet ein experimentelles Modell)*

Einblicke: die Warnung hinter den Daten

- Mensch und KI: eine unüberwindbare Kluft

Nichts ist auffälliger als der krasse Gegensatz zwischen menschlicher und KI-Leistung. UnterARC-AGI-2On erreichte das menschliche Team eine perfekte Punktzahl von 100%, und das beste KI-System - dieOpenAI(in Form eines Nominalausdrucks)o3 (low)mit einem Wert von nur 4,0%. Andere bekannte Modelle, wie dasGemini 2.0 FlashundDeepseek R1usw., alle mit Werten um 1,3%. Noch alarmierender ist die Tatsache, dass dieClaude 3.7undGPT-4oundGPT-4o-miniDiese Base Large Language Models (Base LLMs), die sich in anderen Bereichen bewährt haben, wurden in derARC-AGI-2Die Punktzahl für das Spiel ging direkt auf Null. Dies zeigt unerbittlich, dass die KI trotz ihrer unglaublichen Fähigkeiten bei bestimmten Aufgaben dem Menschen grundsätzlich unterlegen ist, wenn es um neuartige Probleme geht, die flexible, abstrakte und verallgemeinerte Denkfähigkeiten erfordern. - Von AGI-1 zu AGI-2: Die Klippe der KI-Fähigkeit

Fast alle KI-Systeme, die an dem Test teilnahmen, haben nach dem Start mit derARC-AGI-1ÜbergangARC-AGI-2In der Zwischenzeit ist die Leistung stark gesunken. Zum Beispiel, dieo3 (low)ist von 75,71 TP3T auf 4,01 TP3T gesunken.o1-provon etwa 50% bis 1,0%.ARChitectsvon 56,01 TP3T auf 2,51 TP3T. Dieses allgemeine Phänomen deutet stark darauf hin, dass dieARC-AGI-2Es geht erfolgreich auf die "Schmerzpunkte" der derzeitigen KI-Methoden ein, ob sie nun auf CoT, Synthese oder anderen maßgeschneiderten Ansätzen beruhen, mit denen man nur schwer zurechtkommt.ARC-AGI-2Die Argumentation Herausforderung dargestellt. - Systemtyp und Effizienz: hohe Kosten führen nicht zu hoher Intelligenz

Die Rangliste zeigt außerdem, welche Rolle die verschiedenen KI-Systemtypen bei derARC-AGI-2Leistungsunterschiede und gravierende Effizienzprobleme auf der- CoT + Synthese-System (

o3 (low),o1-pro) erzielten die relativ höchsten KI-Werte (4,0% und 1,0%), allerdings zu überraschend hohen Kosten ($200 bzw. $39 pro Aufgabe). Dies deutet darauf hin, dass komplexes Denken plus Suchstrategien zwar in der Lage sind, ein wenig Punkte "herauszuquetschen", aber extrem ineffizient sind. - Reines CoT-System Die Leistungen waren uneinheitlich, wobei die Ergebnisse im Allgemeinen zwischen 1%-3% lagen und die Kosten zwischen einigen Cents und einigen Dollar schwankten. Dies scheint darauf hinzudeuten, dass CoT allein nicht ausreicht, um die Herausforderung zu meistern.

- Basis-LLM (Großes Sprachmodell) (

GPT-4.5,Gemini 1.5 Pro,Claude 3.7,GPT-4o) war ein Debakel, mit Ergebnissen von 0% oder nahe daran, was die Idee, dass "Größe alles ist", deutlich widerlegt, zumindest im Fall vonARC-AGIDies gilt für den gemessenen Aspekt der allgemeinen fluiden Intelligenz. - Maßgeschneiderte Systeme (

ARChitects,Icecuber) alsARC Prize 2024Produkt, das vergleichbare oder sogar leicht bessere Ergebnisse (2,5%, 1,6%) als andere KI-Systeme bei sehr geringen Kosten (~$0,1-$0,2 pro Aufgabe) erzielt. Dies könnte darauf hindeuten, dass gezielte, leichtgewichtige Algorithmen oder Architekturen ein größeres Potenzial für die Lösung dieser Art von Problemen haben als große, universell einsetzbare Modelle, und unterstreicht den Wert offener Wettbewerbe und gemeinschaftlicher Innovation.

- CoT + Synthese-System (

- Krise der Effizienz: Intelligenz kann nicht nur aus Ergebnissen bestehen

ARC PrizeDie Einbeziehung von "Kosten/Aufgabe" als Schlüsselkennzahl in die Rangliste ist von Bedeutung. Die Daten zeigen, dass selbst die leistungsstärkste KI (o3 (low)erhalten 4%), seine Kosten pro Aufgabe ($200) sind auch mehr als zehnmal so hoch wie die des Menschen ($17 erhalten 100%). Während einige kostengünstige Modelle wieGemini 2.0 FlashDies steht in krassem Gegensatz zur KI, die entweder sehr schlecht abschneidet oder kostspielig ist oder beides, obwohl sie sehr geringe Kosten hat ($0,004) und nur 1,3% erreicht. Bei der Intelligenz geht es nicht darum, um jeden Preis die richtige Antwort zu erhalten; Effizienz ist eine inhärente Eigenschaft. Derzeit ist die KIARC-AGI-2Die oben dargestellte "Kapazitätskosten"-Kurve offenbart zweifellos eine tiefgreifende "Effizienzkrise".

Zusammensetzung des Datensatzes und Einzelheiten zum Wettbewerb

ARC-AGI-2 Enthält kalibrierte Trainings- und Evaluierungssets nach dem Vorbild von pass@2 Wertungsmechanismus. Zu den wichtigsten Änderungen gehören die Erhöhung der Anzahl der Aufgaben, die Entfernung von Aufgaben, die für Brute-Force anfällig sind, die Kalibrierung des Schwierigkeitsgrads auf der Grundlage menschlicher Tests und die Entwicklung gezielter neuer Aufgaben.

Wettbewerb um den ARC-Preis 2025 gestartet: Millionen Dollar Belohnung für neue Ideen

Mit diesem düsteren Zeugnis wird dieARC Prize 2025 Der Wettbewerb fand statt in Kaggle Die Plattform ist live (26. März - 3. November) und bietet ein Preisgeld von insgesamt 1 Million Dollar. Die Wettbewerbsumgebung begrenzt die API-Nutzung und die Rechenressourcen (~50 USD/Einreichung) und schreibt vor, dass die Gewinner ihre Lösungen als Open Source bereitstellen. Dies unterstreicht noch einmal die Notwendigkeit von Effizienz und Innovation.

Die wichtigsten Punkte des Wettbewerbs im Jahr 2025 im Vergleich zu 2024 werden seinÄnderungsprotokollDarunter: die Verwendung von ARC-AGI-2 Datensätze, ein neuer Berichterstattungsmechanismus für die Bestenliste, erweiterte Anforderungen an Open Source, Verdoppelung der Rechenressourcen und zusätzliche Maßnahmen gegen Überanpassung.

Fazit: Ein neues Paradigma ist dringend erforderlich, um echte Durchbrüche zu erzielen

ARC-AGI-2 Die Daten der Bestenliste dienen als Spiegel, der die Grenzen der derzeitigen KI in Bezug auf allgemeine Schlussfolgerungen und Effizienz deutlich widerspiegelt. Sie erinnern uns daran, dass der Weg zur KI bei weitem nicht geradlinig ist und dass die bloße Skalierung von Modellen oder die Erhöhung von Rechenressourcen möglicherweise nicht ausreicht, um die vor uns liegende Kluft zu überwinden. Echte Durchbrüche erfordern möglicherweise neue Ideen, andere Architekturen und vielleicht sogar Innovatoren von außerhalb der großen Labors.ARC Prize 2025 Es ist eine solche Plattform, die ein neues Paradigma erfordert.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...