AppAgent: automatisierte Smartphone-Bedienung durch multimodale Intelligenz

Allgemeine Einführung

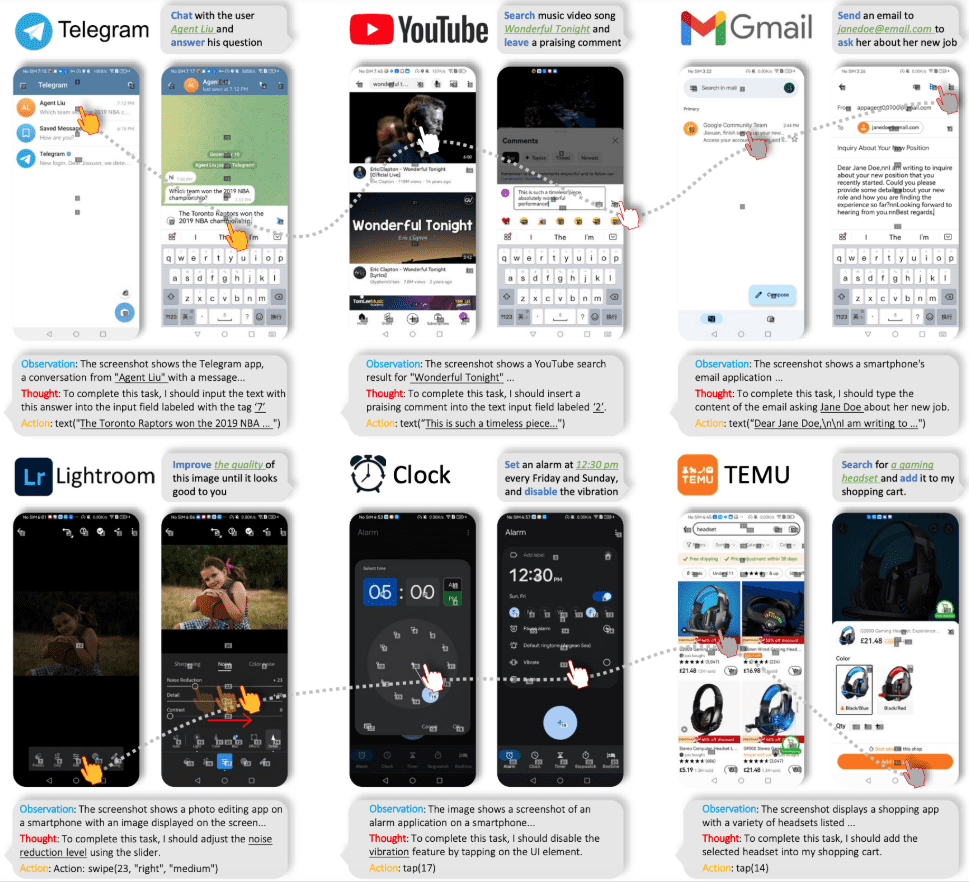

AppAgent ist ein multimodales Agenten-Framework, das auf dem Large Language Model (LLM) basiert und für die Bedienung von Smartphone-Anwendungen entwickelt wurde. Das Framework erweitert seine Anwendbarkeit über verschiedene Anwendungen hinweg durch einen vereinfachten Manipulationsraum, der menschliche Interaktionen wie Taps und Swipes nachahmt und so die Notwendigkeit eines Backend-Zugriffs auf das System eliminiert. Der AppAgent lernt, neue Anwendungen durch autonomes Erkunden oder Beobachten menschlicher Demonstrationen zu nutzen, und generiert eine Wissensbasis zur Durchführung komplexer Aufgaben.

Tencent hat AppAgent auf den Markt gebracht, einen multimodalen intelligenten Körper, der die Schnittstelle des Mobiltelefons direkt bedienen kann, indem er die aktuelle Schnittstelle des Mobiltelefons und die Befehle des Benutzers erkennt, und das Mobiltelefon wie ein echter Benutzer bedienen kann! So kann er zum Beispiel Fotobearbeitungssoftware bedienen, um Bilder zu bearbeiten, Kartenanwendungen öffnen, um zu navigieren, einkaufen und so weiter.

Projekt-Homepage: https://appagent-official.github.io

Link zum Papier: https://arxiv.org/abs/2312.13771

Zusammenfassung der Dissertation

Mit den jüngsten Fortschritten im Bereich der Large Language Models (LLMs) wurden intelligente Körper geschaffen, die komplexe Aufgaben erfüllen können. In diesem Beitrag stellen wir einen neuartigen, multimodalen Rahmen für intelligente Körper vor, der auf Large Language Models basiert und für die Bedienung von Smartphone-Anwendungen konzipiert ist. Unser Framework ermöglicht es intelligenten Körpern, Smartphone-Apps durch einen vereinfachten Manipulationsraum so zu manipulieren, dass es so ist, als ob ein Mensch Klick- und Wischoperationen durchführt. Dieser innovative Ansatz umgeht die Notwendigkeit eines direkten Zugriffs auf das Back-End des Systems und eignet sich daher für eine breite Palette unterschiedlicher Anwendungen. Das Herzstück der Funktionalität unserer Intelligenz ist ihr innovativer Lernansatz. Der Intelligente Körper lernt durch Selbsterkundung oder durch Beobachtung menschlicher Demonstrationen, wie er sich in neuen Anwendungen zurechtfindet und diese nutzt. In diesem Prozess baut er eine Wissensbasis auf, auf die er sich stützt, um komplexe Aufgaben in verschiedenen Anwendungen zu erfüllen. Um die Nützlichkeit unserer Intelligenz zu demonstrieren, haben wir sie gründlich an 50 Aufgaben in 10 verschiedenen Anwendungen getestet, darunter soziale Medien, E-Mail, Karten, Shopping und komplexe Bildbearbeitungsprogramme. Die Testergebnisse zeigen, dass unsere Intelligenz in der Lage ist, ein breites Spektrum an fortgeschrittenen Aufgaben zu bewältigen.

Funktionsliste

- selbstgesteuertes ErkundenAgenten können selbstständig Anwendungen erkunden, interaktive Elemente aufzeichnen und Dokumentationen erstellen.

- Menschliches DemonstrationslernenDer Agent lernt die Aufgabe durch Beobachtung einer menschlichen Demonstration und erstellt die entsprechende Dokumentation.

- MandatsumsetzungWährend der Einsatzphase führt der Agent komplexe Aufgaben auf der Grundlage der erstellten Dokumente aus.

- Multimodale EingängeUnterstützt sowohl textuelle als auch visuelle Eingaben, entweder mit den Modellen GPT-4V oder Qwen-VL-Max.

- CAPTCHA-Verarbeitung: Kann durch CAPTCHA authentifiziert werden.

- Erkennung von UI-ElementenRaster-Overlays zur Positionierung von unmarkierten UI-Elementen verwenden.

Hilfe verwenden

Installation und Konfiguration

- Herunterladen und Installieren: Laden Sie die Projektdateien von der GitHub-Seite herunter und installieren Sie die erforderlichen Abhängigkeiten.

- Konfigurationsdatei: Ändern Sie das Wurzelverzeichnis von

config.yamlDatei, um den API-Schlüssel für ein GPT-4V- oder Qwen-VL-Max-Modell zu konfigurieren. - angeschlossenes GerätVerbinden Sie Ihr Android-Gerät über USB und aktivieren Sie das USB-Debugging in den Entwickleroptionen.

Modell der Selbstexploration

- eine Erkundung starten: Lauf

learn.pyDatei, wählen Sie Autonomer Erkundungsmodus und geben Sie den Anwendungsnamen und die Aufgabenbeschreibung ein. - Interaktionen aufzeichnenDer Agent wird die Anwendung automatisch erkunden, Interaktionselemente aufzeichnen und eine Dokumentation erstellen.

Demonstrationsmodus für Menschen

- Startup-Demo: Lauf

learn.pyDatei, wählen Sie Human-Demo-Modus, und geben Sie den Anwendungsnamen und die Aufgabenbeschreibung ein. - Demo für FührungskräfteFolgen Sie den Anweisungen und der Agent wird alle Interaktionen aufzeichnen und eine Dokumentation erstellen.

Mandatsumsetzung

- Aufgaben einleiten: Lauf

run.pyDatei, geben Sie den Anwendungsnamen und die Aufgabenbeschreibung ein und wählen Sie die entsprechende Dokumentenbibliothek aus. - betreiben.Der Agent führt Aufgaben aus, um komplexe Vorgänge auf der Grundlage der Dokumentation abzuschließen.

Detaillierte Vorgehensweise

- Projekt herunterladen: Besuchen Sie die GitHub-Seite, laden Sie die Projektdateien herunter und entpacken Sie sie.

- Installation von Abhängigkeiten: In einem Terminal ausführen

pip install -r requirements.txtInstallieren Sie alle Abhängigkeiten. - KonfigurationsmodellÄndern nach Bedarf

config.yamlDatei, um den API-Schlüssel für ein GPT-4V- oder Qwen-VL-Max-Modell zu konfigurieren. - angeschlossenes GerätSchließen Sie Ihr Android-Gerät über USB an und aktivieren Sie den USB-Debug-Modus auf dem Gerät.

- Initiieren Sie eine Erkundung oder Demonstration: Lauf

learn.pyDatei, wählen Sie den Modus Autonome Erkundung oder Menschliche Demonstration und geben Sie den Anwendungsnamen und die Aufgabenbeschreibung ein. - Dokumentation generierenDer Agent zeichnet alle Interaktionen auf und erstellt eine Dokumentation für die spätere Aufgabenausführung.

- betreiben.: Lauf

run.pyDokument, geben Sie den Anwendungsnamen und die Aufgabenbeschreibung ein, wählen Sie die entsprechende Dokumentenbibliothek aus, und der Agent wird die Aufgabe auf der Grundlage des Dokuments ausführen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...