AI College of Engineering: 2,5 RAG-Systembewertung

kurz

Evaluation ist eine Schlüsselkomponente bei der Entwicklung und Optimierung von Retrieval Augmented Generation (RAG) Systemen. Die Evaluation beinhaltet eine Überprüfung der RAG Gemessen werden die Leistung, die Genauigkeit und die Qualität aller Aspekte des Prozesses, einschließlich der Relevanz und der Authentizität, von der Effizienz des Abrufs bis zur Generierung von Antworten.

Bedeutung der RAG-Bewertung

Eine wirksame Bewertung des RAG-Systems ist wichtig, weil sie:

- Hilft bei der Ermittlung von Stärken und Schwächen im Abruf- und Generierungsprozess.

- Leitung der Verbesserung und Optimierung des gesamten RAG-Prozesses.

- Sicherstellen, dass das System den Qualitätsstandards und den Erwartungen der Benutzer entspricht.

- Erleichtert den Vergleich verschiedener RAG-Implementierungen oder -Konfigurationen.

- Hilft, Probleme wie Halluzinationen, Vorurteile oder irrelevante Antworten zu erkennen.

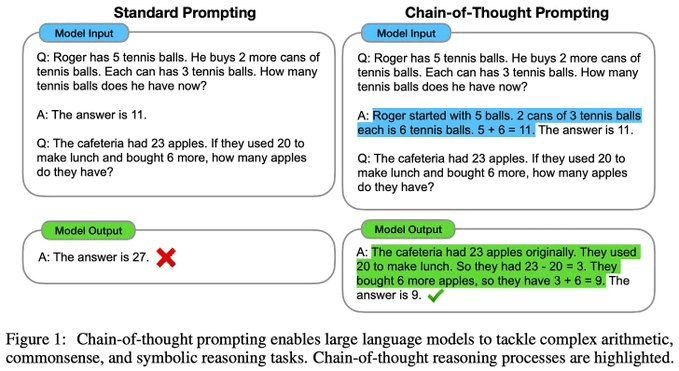

RAG-Bewertungsprozess

Die Bewertung eines RAG-Systems umfasst in der Regel die folgenden Schritte:

Zentrale Bewertungsindikatoren

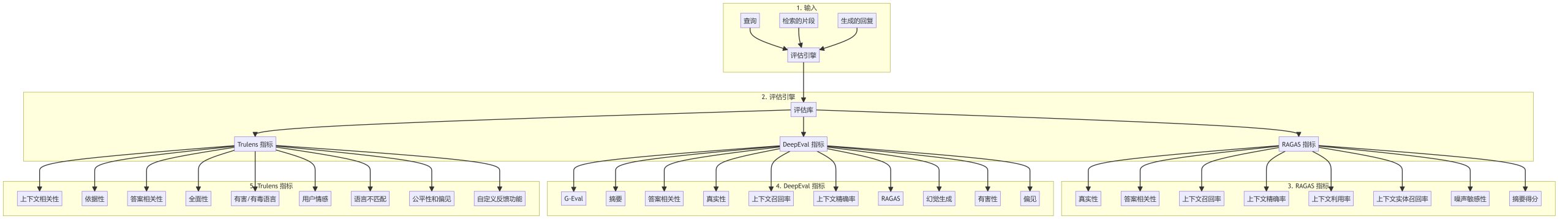

RAGAS-Indikatoren

- GültigkeitMessung der Konsistenz der generierten Antwort mit dem Abfragekontext.

- Relevanz der AntwortenBewerten Sie die Relevanz der Antwort auf die Anfrage.

- Kontextabruf (Informatik)Bewertung, ob die abgerufenen Chunks die zur Beantwortung der Anfrage erforderlichen Informationen enthalten.

- Kontextuelle GenauigkeitChunks: Ein Maß für den Anteil der relevanten Informationen in den abgerufenen Chunks.

- Nutzung des KontextesBewerten Sie die Effizienz, mit der die generierte Antwort den bereitgestellten Kontext nutzt.

- kontextbezogener Abruf von EntitätenBewertung, ob wichtige Elemente des Kontexts in der Antwort berücksichtigt werden.

- LärmempfindlichkeitRobustheit: Ein Maß für die Robustheit eines Systems gegenüber irrelevanten oder verrauschten Informationen.

- Abstrakte PunktzahlBewerten Sie die Qualität der Zusammenfassung in der Antwort.

DeepEval-Indikatoren

- G-EvalGenerische Bewertungsmetriken für Textgenerierungsaufgaben.

- AbstractsBewerten Sie die Qualität der Textzusammenfassungen.

- Relevanz der AntwortenEin Maß dafür, wie gut die Antwort die Anfrage beantwortet.

- GültigkeitBeurteilen Sie die Richtigkeit der Antwort und der Quellenangaben.

- Kontextbezogene Rückrufquote und PräzisionMessung der Effektivität des kontextuellen Abrufs.

- Erkennung von HalluzinationenIdentifizieren Sie falsche oder ungenaue Informationen in einer Antwort.

- toxikologischErkennen Sie potenziell schädliche oder beleidigende Inhalte in der Antwort.

- VorspannungIdentifizieren Sie unfaire Vorlieben oder Tendenzen in den generierten Inhalten.

Trulens-Indikatoren

- kontextuelle RelevanzBewertung, wie gut der Suchkontext mit der Anfrage übereinstimmt.

- geerdetEin Maß dafür, ob die Antwort durch die abgerufenen Informationen unterstützt wird.

- Relevanz der AntwortenBewerten Sie die Qualität der Antwort auf die Anfrage.

- AusführlichkeitVollständigkeit: Misst die Vollständigkeit der Antwort.

- Verletzende/beleidigende SpracheIdentifizieren Sie potenziell anstößige oder gefährliche Inhalte.

- AnwenderstimmungslageAnalyse des emotionalen Tons bei Benutzerinteraktionen.

- sprachliche InkongruenzErkennen von Inkonsistenzen im Sprachgebrauch zwischen Anfrage und Antwort.

- Fairness und VoreingenommenheitBewertung der gerechten Behandlung der verschiedenen Gruppen im System.

- Benutzerdefinierte Feedback-FunktionenErmöglicht die Entwicklung von maßgeschneiderten Bewertungsmaßstäben für spezifische Anwendungsfälle.

Bewährte Praktiken für die RAG-Bewertung

- GesamtbewertungKombination mehrerer Indikatoren zur Bewertung verschiedener Aspekte des RAG-Systems.

- Regelmäßiges Benchmarking: Kontinuierliche Bewertung des Systems bei sich ändernden Prozessen.

- Menschliche BeteiligungEine umfassende Analyse, die manuelle Bewertungen und automatische Indikatoren kombiniert.

- Bereichsspezifische IndikatorenEntwicklung maßgeschneiderter Metriken für bestimmte Anwendungsfälle oder Bereiche.

- FehleranalyseAnalyse von Mustern in Antworten mit niedriger Punktzahl und Ermittlung von Bereichen, die verbessert werden können.

- Vergleichende BewertungBenchmarking: Vergleichen Sie Ihr RAG-System mit Basismodellen und alternativen Implementierungen.

zu einem Urteil gelangen

Ein solider Bewertungsrahmen ist für die Entwicklung und Pflege eines qualitativ hochwertigen RAG-Systems unerlässlich. Durch die Verwendung einer breiten Palette von Metriken und die Anwendung bewährter Verfahren können Entwickler sicherstellen, dass ihr RAG-System genaue, relevante und glaubwürdige Antworten liefert und gleichzeitig die Leistung kontinuierlich verbessert.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...