ChatGPT bleibt an der Spitze vieler KI-Charts, aber die Konkurrenz ist direkt dahinter

Wie ermitteln Sie die leistungsfähigsten KI-Modelle, die derzeit verfügbar sind? Lesen Sie die Rangliste, um das herauszufinden.

Von der Community zusammengestellte Ranglisten für KI-Modelle haben in den letzten Monaten online stark an Popularität gewonnen und bieten einen Echtzeit-Einblick in das Wettrennen der großen Tech-Giganten im Bereich der KI.

Verschiedene Ranglisten dokumentieren, welche KI-Modelle bei der Ausführung bestimmter Aufgaben am weitesten fortgeschritten sind.KI-Modelle sind im Wesentlichen eine Reihe von mathematischen Formeln, die in Code verpackt sind, um einen bestimmten Zweck zu erfüllen.

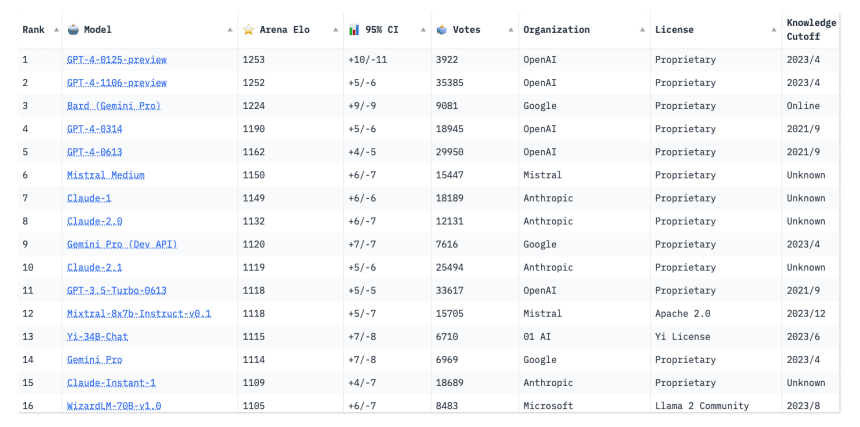

Wie Googles Gemini (früher Bard) und Pariser Start-ups Mistral AI Neue Marktteilnehmer wie Mistral-Medium haben die KI-Gemeinschaft aufgerüttelt und drängen sich an die Spitze der Rangliste.

Der GPT-4 von OpenAI dominiert jedoch weiterhin.

Die Leute interessieren sich für den neuesten Stand der Technik", sagt Ying Sheng, Doktorand der Computerwissenschaften an der Stanford University und Miterfinder der Chatbot-Arena-Rangliste. Ich glaube, die Leute mögen es, wenn sich die Charts ständig ändern. Es zeigt, dass das Spiel immer noch weitergeht und dass es noch Raum für Verbesserungen gibt."

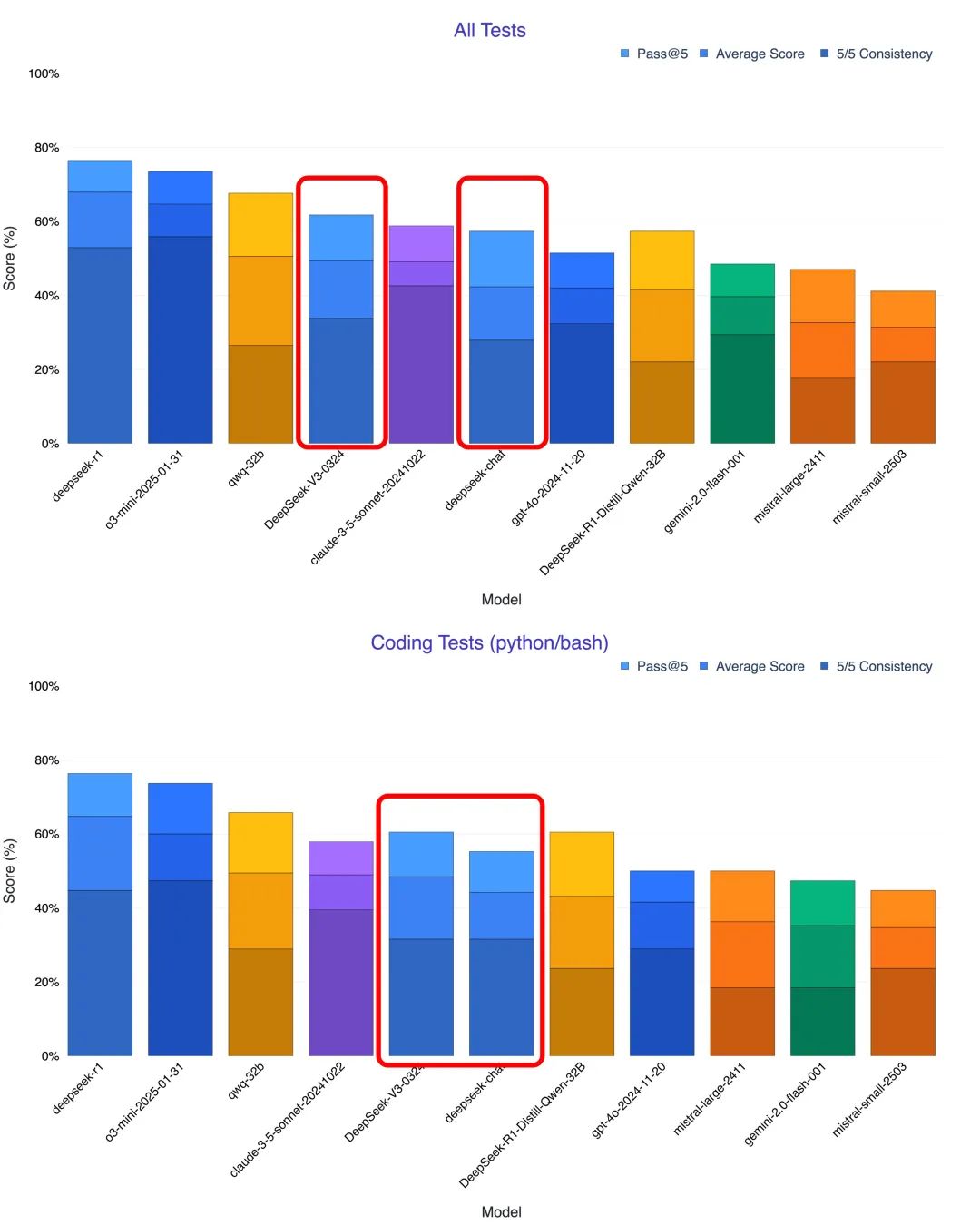

Die Rangliste basiert auf Tests der Fähigkeiten von KI-Modellen, mit denen herausgefunden werden soll, wozu KI im Allgemeinen in der Lage ist und welche Modelle sich für bestimmte Anwendungen, wie z. B. die Spracherkennung, am besten eignen. Bei diesen Tests, die manchmal auch als Benchmarking-Tests bezeichnet werden, wird die KI-Leistung anhand von Kennzahlen gemessen, z. B. daran, wie nahe die Vokalisation der KI einer menschlichen Stimme kommt oder wie menschlich ein KI-Chatbot antwortet.

Da sich die KI weiter entwickelt, ist eine kontinuierliche Verbesserung dieser Tests ebenso wichtig.

Vanessa Parli, Forschungsdirektorin am Institut für Künstliche Intelligenz am Center for the Human Dimension der Stanford University, sagte: "Diese Benchmarks sind nicht perfekt, aber im Moment ist dies die einzige Möglichkeit, das System zu bewerten."

Der jährliche Bericht des Instituts über den Stanford Artificial Intelligence Index verfolgt die technische Leistung von KI-Modellen im Laufe der Zeit anhand verschiedener Kriterien. Laut Parli wurden für den letztjährigen Bericht 50 Benchmarks untersucht, aber nur 20 einbezogen. In diesem Jahr wird der Bericht einige veraltete Benchmarks eliminieren, um sich auf neuere, umfassendere zu konzentrieren.

Das Open LLM [Large Language Model] Leaderboard, das von Hugging Face, einer Open-Source-Plattform für maschinelles Lernen, erstellt wurde, hat bis Anfang Februar mehr als 4.200 Modelle bewertet und eingestuft, die alle von Community-Mitgliedern eingereicht wurden.

Die Modelle nehmen an sieben wichtigen Benchmark-Tests teil, mit denen ihre Fähigkeiten in verschiedenen Kategorien wie Leseverständnis und mathematisches Problemlösen bewertet werden sollen. Der Bewertungsprozess umfasst auch mathematische und naturwissenschaftliche Fragen aus der Grundschule, die den gesunden Menschenverstand der Modelle testen und ihre Neigung zur Verbreitung von Fehlinformationen messen. Einige der Tests bieten ein Multiple-Choice-Format, während andere von den Modellen verlangen, dass sie ihre eigenen Antworten auf der Grundlage von Hinweisen erstellen.

ChatGPT-4 von OpenAI steht an der Spitze des LMSYS Chatbot Arena Leaderboards, dicht gefolgt von Googles Geminivia. LMSYS

Die Besucher können die spezifische Leistung jedes Modells bei einem bestimmten Benchmark-Test sowie die durchschnittliche Gesamtpunktzahl einsehen. Bislang hat noch kein Modell bei irgendeinem Benchmark eine perfekte Punktzahl von 100 erreicht. Smaug-72B, ein neu entwickeltes KI-Modell des Start-ups Abacus.AI aus San Francisco, war das erste Modell, das im Durchschnitt 80 Punkte erreichte.

Viele groß angelegte Sprachmodelle haben bei solchen Tests bereits die menschlichen Benchmarks übertroffen. Dieses Phänomen nennen Forscher "Sättigung", sagt Thomas Wolf, Mitbegründer und wissenschaftlicher Leiter von Hugging Face. Es tritt in der Regel dann auf, wenn die Fähigkeiten des Modells über einen bestimmten Test hinaus zunehmen, z. B. wenn ein Schüler von der Mittel- zur Oberstufe wechselt und allmählich über die vorherige Lernstufe hinauswächst, oder wenn das Modell sich gemerkt hat, wie bestimmte Testfragen zu beantworten sind, ein Konzept, das als "Overfitting" bekannt ist.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...