Agenten-Rangliste: Rangliste zur Leistungsbewertung von AI-Agenten

Allgemeine Einführung

Agent Leaderboard ist ein Online-Tool zur Bewertung der Leistung von KI-Agenten, das von Galileo AI auf der Plattform Hugging Face eingeführt wurde. Es testet 17 führende Large Language Models (LLMs), die Szenarien von einfachen API-Aufrufen bis hin zu komplexen Multi-Tool-Interaktionen abdecken, indem es mehrere maßgebliche Datensätze (z. B. BFCL, τ-bench, xLAM und ToolACE) kombiniert. Ziel der Website ist es, die Frage "Wie verhalten sich KI-Agenten in realen Geschäftsszenarien?" zu beantworten und Entwicklern und Unternehmen dabei zu helfen, das richtige Modell für ihre Bedürfnisse auszuwählen. Das Leaderboard wird monatlich aktualisiert und bietet Teams, die ein effizientes KI-Agenten-System aufbauen müssen, einen Überblick über die Rangfolge der Modelle, die Punktzahlen, die Kosten und andere Informationen. Benutzer können hier die Leistung von Open-Source- und privaten Modellen visuell vergleichen. Analyseberichte anzeigen:Hugging Face startet Agent Intelligence Body Rankings: Wer ist führend bei Tool Calling?

Funktionsliste

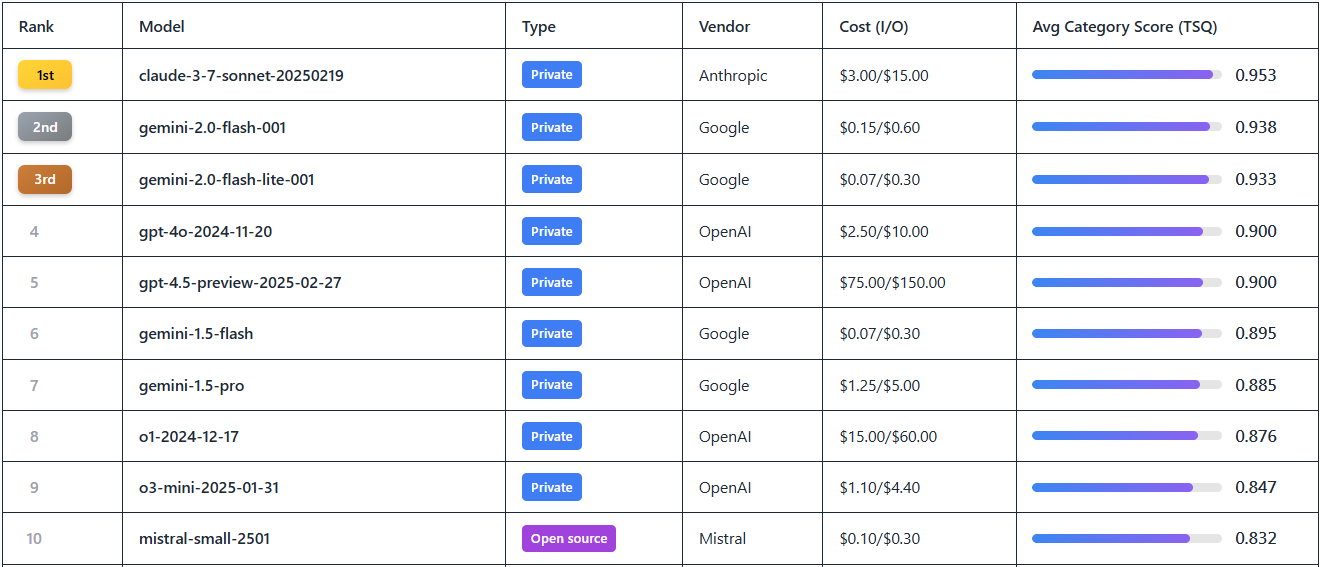

- Rangliste der ModellleistungZeigt die Rankings von 17 führenden LLMs wie Gemini-2.0 Flash, GPT-4o, etc. auf der Grundlage von Tool Selection Quality (TSQ) Scores.

- Multidimensionale BewertungsdatenBietet bereichsübergreifende Testergebnisse für mehr als 390 Szenarien wie Mathematik, Einzelhandel, Luftfahrt, API-Interaktionen und mehr.

- Kosten vs. Effizienz:: Demonstration pro Million für jedes Modell Token Kosten (z.B. Gemini-2.0 Flash $0.15 vs. GPT-4o $2.5) für Preis/Leistungs-Analyse.

- Werkzeuge zum Filtern und Anzeigen:: Unterstützung für die Filterung von Modellen nach Anbieter, Open-Source-/Privat-Status, Bewertung usw., um schnell die gewünschten Informationen zu finden.

- Quelloffener Zugang zu Datensätzen:: Bereitstellung von Download-Links zu Testdatensätzen für Entwickler zur Untersuchung und Validierung.

- Dynamischer Aktualisierungsmechanismus:: Monatliche Aktualisierung der Rangliste, um die neuesten Modellversionen und Leistungsdaten zu synchronisieren.

Hilfe verwenden

Zugang und Nutzung

Agent Leaderboard ist ein Online-Tool, das keine Installation erfordert und es den Benutzern ermöglicht, einfach einen Browser zu öffnen und die https://huggingface.co/spaces/galileo-ai/agent-leaderboard Sofort einsatzbereit. Sobald die Seite geladen ist, werden Sie mit einer intuitiven Ranglisten-Tabelle begrüßt, die es Ihnen ermöglicht, alle öffentlich verfügbaren Daten zu durchsuchen, ohne sich zu registrieren oder anzumelden. Für ein tiefergehendes Engagement (z. B. das Herunterladen von Datensätzen oder das Unterbreiten von Vorschlägen) können Sie sich für ein Hugging Face-Konto anmelden.

Arbeitsablauf

- Durchsuchen Sie die Charts

- Wenn Sie die Seite öffnen, werden auf der ersten Seite standardmäßig die 17 aktuell besten LLM-Modelle angezeigt.

- Die Tabellenspalten umfassen Rang, Modell, Anbieter, Punktzahl, Kosten und Typ (Open Source/privat). Punktzahl", "Kosten" und "Typ (Open Source/Privat)".

- Beispiel: Der Gemini-2.0-Blitz auf Platz 1 mit einer Punktzahl von 0,9+ und einem Preis von $0,15/Millionen Token.

- Screening- und Vergleichsmodelle

- Klicken Sie auf die Filterfelder am oberen Rand der Tabelle, um "Anbieter" (z. B. Google, OpenAI), "Typ" (Open Source oder privat) oder "Bewertungsbereich" auszuwählen.

- Wenn Sie z. B. "OpenAI" eingeben, filtert die Seite Modelle wie GPT-4o, o1 usw. heraus, so dass Sie deren Leistung leicht vergleichen können.

- Um das Kosten-Nutzen-Verhältnis zu sehen, sortieren Sie nach der Spalte "Kosten", um die günstigste Option zu finden.

- Detaillierte Bewertungsdaten anzeigen

- Wenn Sie auf einen Modellnamen (z. B. Gemini-1.5-Pro) klicken, wird ein spezifischer Leistungsbericht angezeigt.

- Der Bericht enthält die Leistung des Modells für verschiedene Datensätze, z. B. die Bewertung des Einzelhandelsszenarios in τ-bench, die Bewertung der API-Interaktion in ToolACE usw.

- Die Daten werden in grafischer Form dargestellt, um die Stärken und Schwächen des Modells bei Multi-Tool-Aufgaben oder Szenarien mit langem Kontext zu veranschaulichen.

- Open-Source-Datensätze herunterladen

- Unten auf der Seite gibt es einen Link "Dataset", klicken Sie darauf, um zu

https://huggingface.co/datasets/galileo-ai/agent-leaderboard. - Die Nutzer können vollständige Testdatensätze (z. B. Mathe-Fragebänke für BFCL, bereichsübergreifende Daten für xLAM) für die lokale Analyse oder Sekundärentwicklung herunterladen.

- Zum Herunterladen müssen Sie sich bei Ihrem Hugging Face-Konto anmelden. Wenn Sie noch kein Konto haben, können Sie sich anmelden, indem Sie auf "Sign Up" in der oberen rechten Ecke der Seite klicken.

- Unten auf der Seite gibt es einen Link "Dataset", klicken Sie darauf, um zu

- Updates erhalten

- Die Rangliste wird monatlich aktualisiert. Folgen Sie dem offiziellen Blog von Galileo AI (Link unten auf der Seite), um über die neuesten Modelle informiert zu werden.

- Zum Beispiel die jüngsten Anfragen von Nutzern in der Gemeinschaft, sich an Claude 3.7 Sonett und Grok 3, offizielle Antworten werden hinzugefügt, sobald die API verfügbar ist.

Ausgewählte Funktionen

- Interpretation der TSQ-Werte (Tool Selection Quality)

- TSQ ist die zentrale Bewertungskennzahl von Agent Leaderboard, die die Genauigkeit des Modells bei der Verwendung des Tools misst.

- Beispiel: Wählen Sie GPT-4o aus und sehen Sie seinen TSQ-Wert von 0,9, wobei die Einzelposten zeigen, dass er bei kollaborativen Aufgaben mit mehreren Werkzeugen gut abschneidet, aber in Szenarien mit langem Kontext etwas schwächer ist.

- Verwendungshinweis: Wenn Ihr Projekt komplexe Arbeitsabläufe umfasst, wählen Sie ein Modell mit einem TSQ von über 0,85.

- Analyse der Ergebnisse von Mehrbereichstests

- Klicken Sie auf "Bewertungsdetails", um zu sehen, wie das Modell in 14 Benchmark-Tests abgeschnitten hat.

- Beispiel: Gemini-2.0 Flash erzielte 0,92 in BFCL (Mathematik und Bildung) und 0,89 in ToolACE (API-Interaktion).

- Nutzungsszenario: Teams, die sich mit Luftfahrtdaten befassen müssen, können sich auf die Ergebnisse der τ-Bench beziehen, um Modelle auszuwählen, die auf diesen Bereich spezialisiert sind.

- Kostenoptimierte Entscheidungsfindung

- Siehe den Input/Output-Preis pro Million Token in der Spalte "Kosten" der Tabelle.

- Beispiel: Filter "Kosten < $1" und das Ergebnis zeigt Mistral-small-2501 ($0,5/Million Token), das für Projekte mit begrenztem Budget geeignet ist.

- Tipp: Bringen Sie Leistung und Kosten ins Gleichgewicht, indem Sie Punkte und Kosten kombinieren.

caveat

- Zeit der DatenaktualisierungAktuelle Daten (Stand: Februar 2025); es wird empfohlen, die Rangliste regelmäßig zu besuchen, um die aktuellsten Ergebnisse zu erhalten.

- Feedback der GemeinschaftWenn Sie ein neues Modell benötigen (z.B. Grok 3), hinterlassen Sie eine Nachricht auf der Hugging Face Seite und die offizielle Antwort wird von der Verfügbarkeit der API abhängen.

- technische VoraussetzungDie Webseite stellt nur geringe Anforderungen an das Netzwerk, aber zum Herunterladen des Datensatzes ist eine stabile Verbindung erforderlich, und es wird empfohlen, mit dem Desktop zu arbeiten.

Mit diesen Schritten können Nutzer schnell mit Agent Leaderboard beginnen, einem Tool, das praktische Unterstützung bietet, egal ob sie nach leistungsstarken Modellen suchen oder die technischen Details von KI-Agenten recherchieren.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...