2024 Chinesischer Benchmarking-Bericht für große Modelle (SuperCLUE)

Kontexte

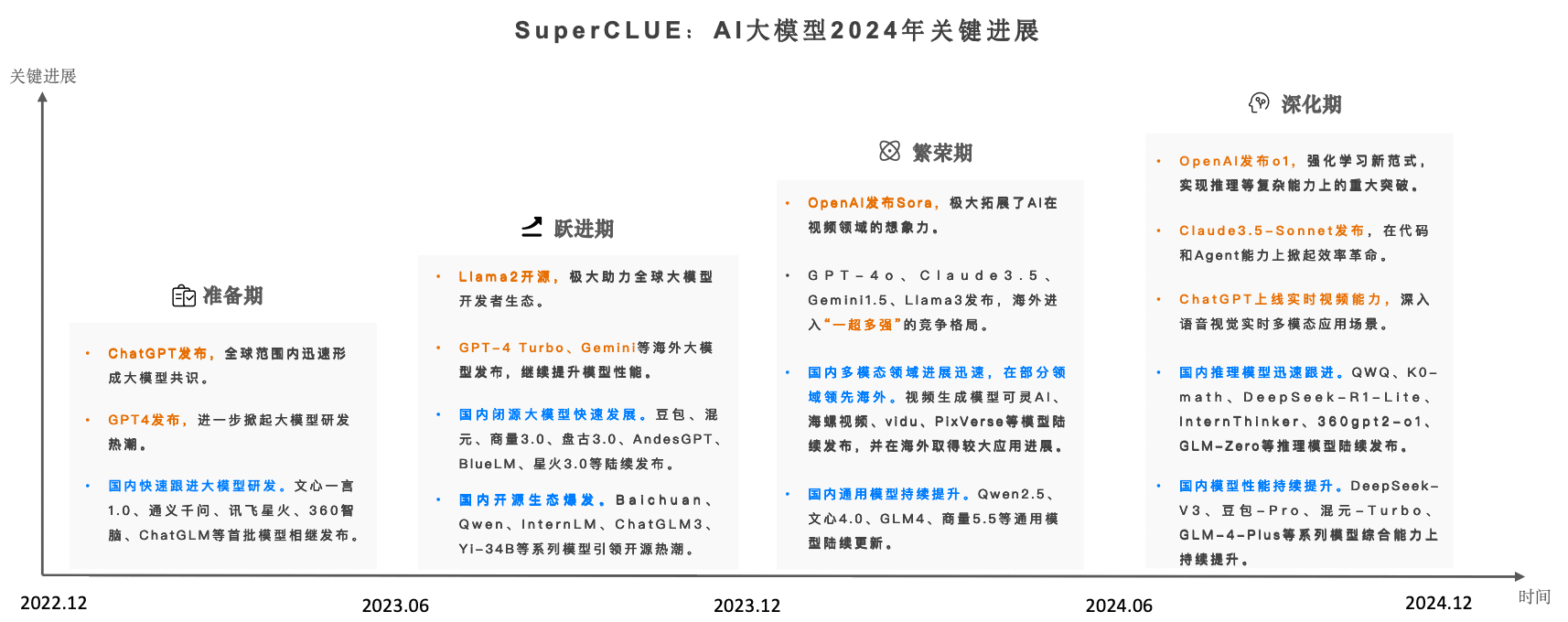

Seit 2023 haben KI-Großmodelle die größte KI-Welle aller Zeiten auf globaler Ebene ausgelöst. Mit dem Eintritt in das Jahr 2024 nimmt die Wettbewerbsdynamik des globalen Big Model zu undMit dem Erscheinen der Sora, des GPT-4o und des o1 hatten die einheimischen Großmodelle 2024 eine regelrechte Großmodelljagd.

Der chinesische Benchmark für die Bewertung von Großmodellen SuperCLUE hat den Entwicklungstrend und die umfassenden Auswirkungen von Großmodellen im In- und Ausland kontinuierlich in Echtzeit verfolgt und wurde nun offiziell veröffentlicht.Benchmarking großer chinesischer Modelle 2024 Jahresbericht.

Der vollständige Bericht umfasst 89 Seiten, in diesem Artikel werden nur die wichtigsten Inhalte des Berichts wiedergegeben, der vollständige Bericht steht online zur Verfügung (zum Herunterladen):

www.cluebenchmarks.com/superclue_2024

SuperCLUE-Rangliste Adresse:

www.superclueai.com

Schlüsselelemente des Berichts

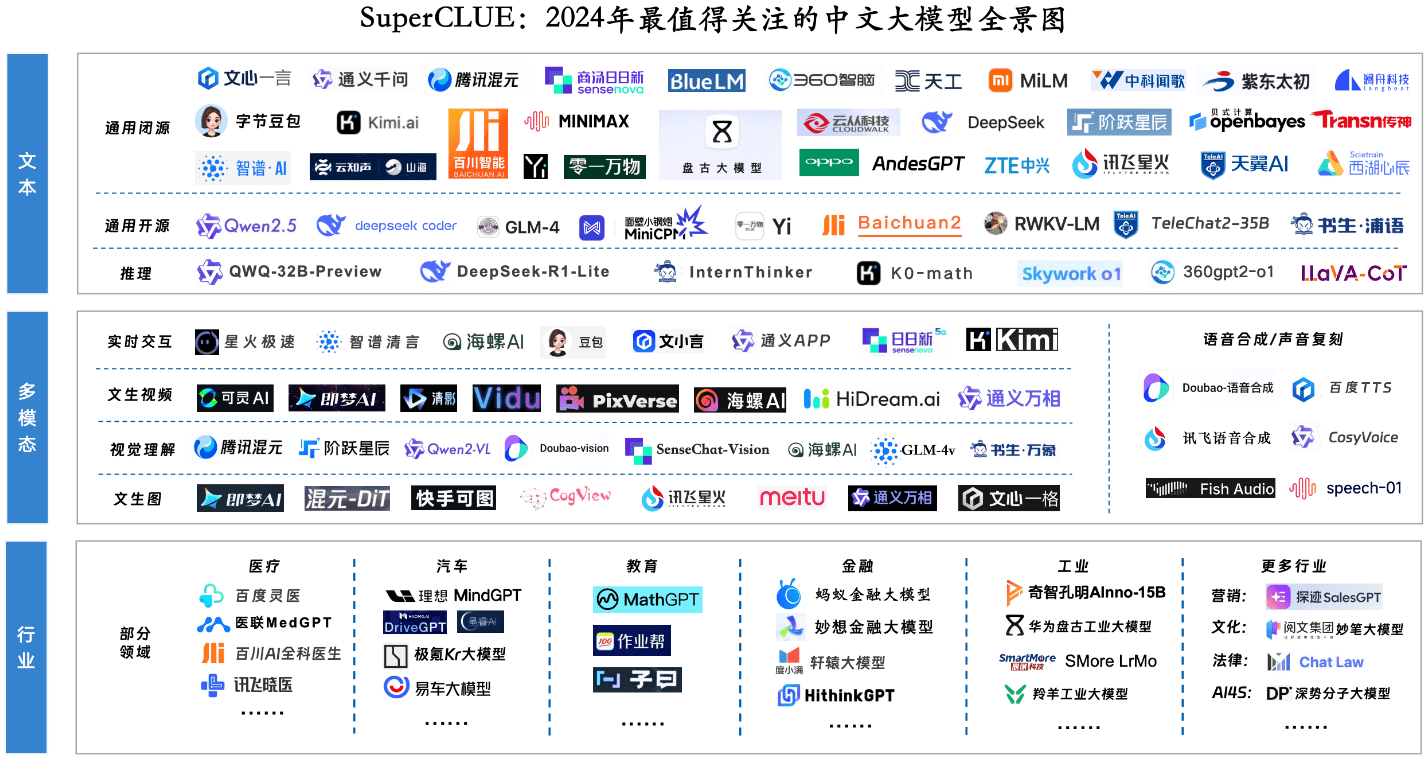

Schlüsselkomponente 1: Panorama der wichtigsten großen Modelle für 2024

Schlüsselkomponente 2: Jährliches Gesamtranking und Modellierungsquadrant

Einführung in die Bewertung

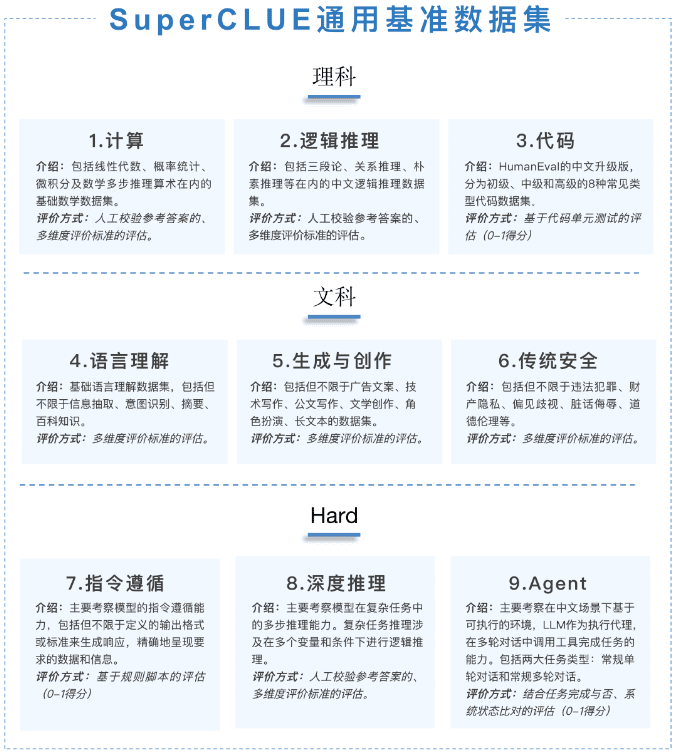

Dieser Jahresbericht konzentriert sich auf die allgemeine Kompetenzbewertung (General Competency Assessment, GCA), die aus drei Dimensionen besteht: Wissenschaft, Kunst und Kunst.Die Fragen sind allesamt neue Originalfragenmit insgesamt 1 325 Mehrrunden-Kurzantwortfragen.

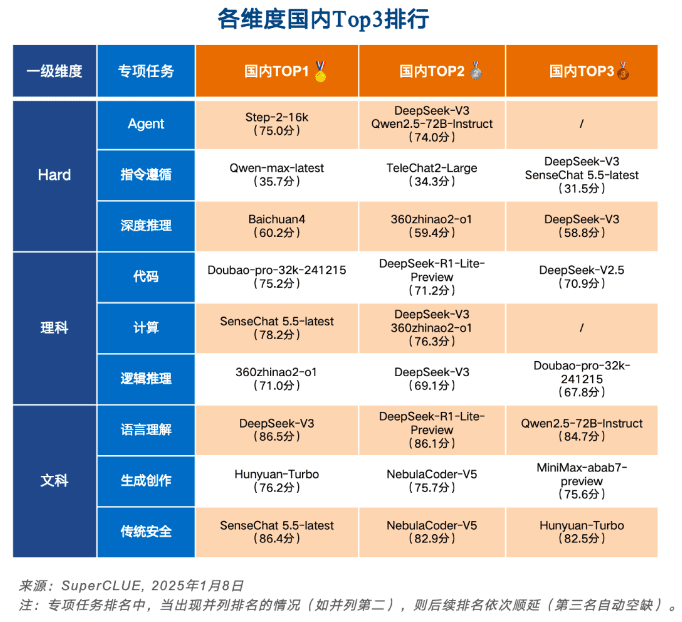

Die [Wissenschaftlichen Aufgaben] sind unterteilt in die Gruppen "Rechnen", "Logisches Denken" und "Codebewertung"; die [Künstlerischen Aufgaben] sind unterteilt in die Gruppen "Sprachverständnis", "Generatives Gestalten" und "Sicherheitsbewertung"; und die [Schwierigen Aufgaben] sind unterteilt in die Gruppen "Anweisungen folgen", "Tiefes Denken" und "Agentenbewertung".

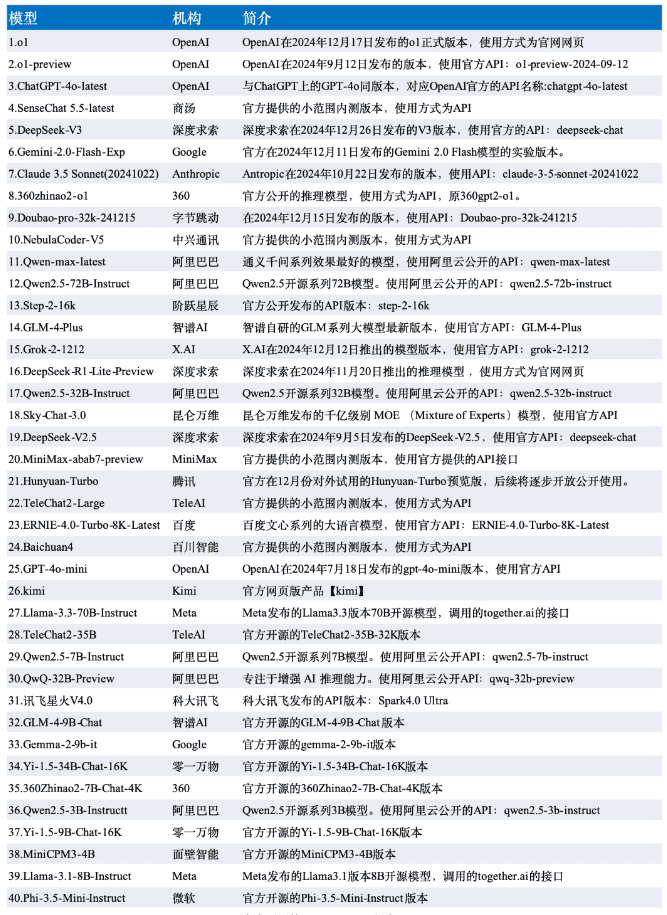

Die Daten dieser Auswertung werden aus den SuperCLUE-Evaluierungsergebnissen vom Dezember ausgewählt, und das Modell wird aus den repräsentativen 42 großen Modellen im In- und Ausland in der Dezember-Version ausgewählt.

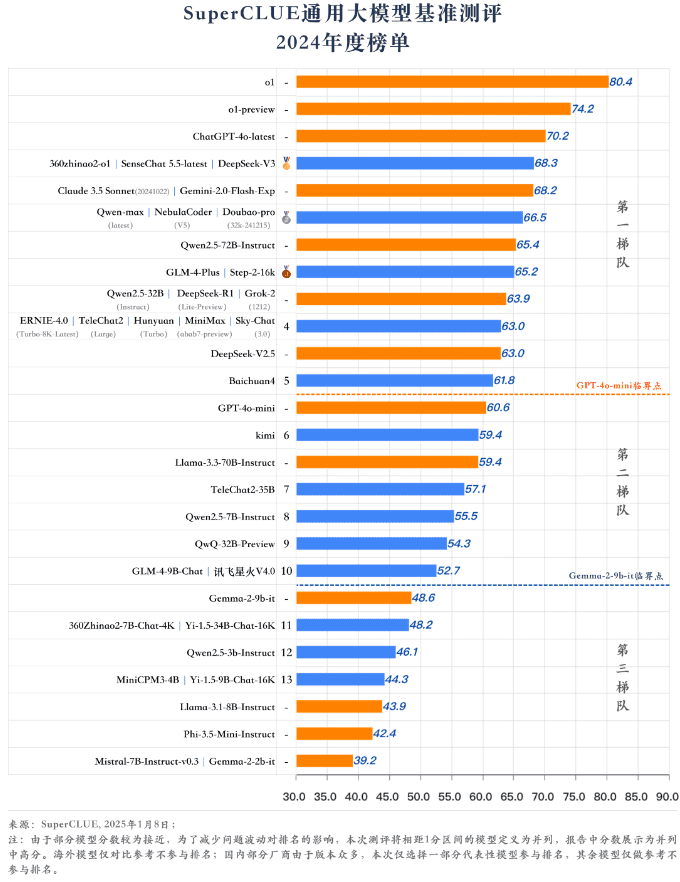

Rangliste

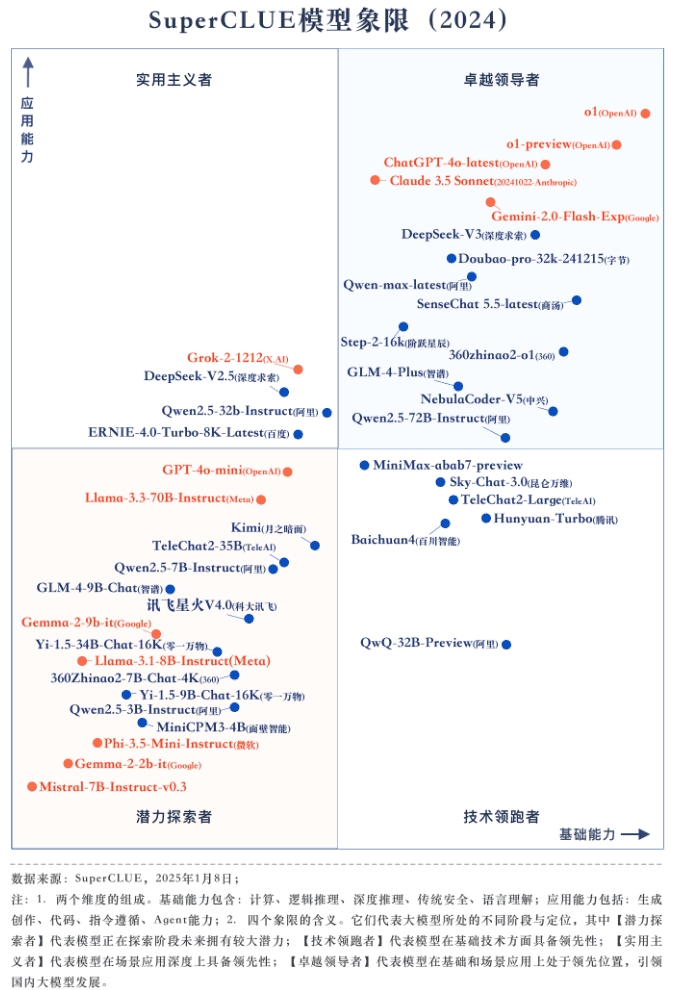

Jahresmodell Quadrant

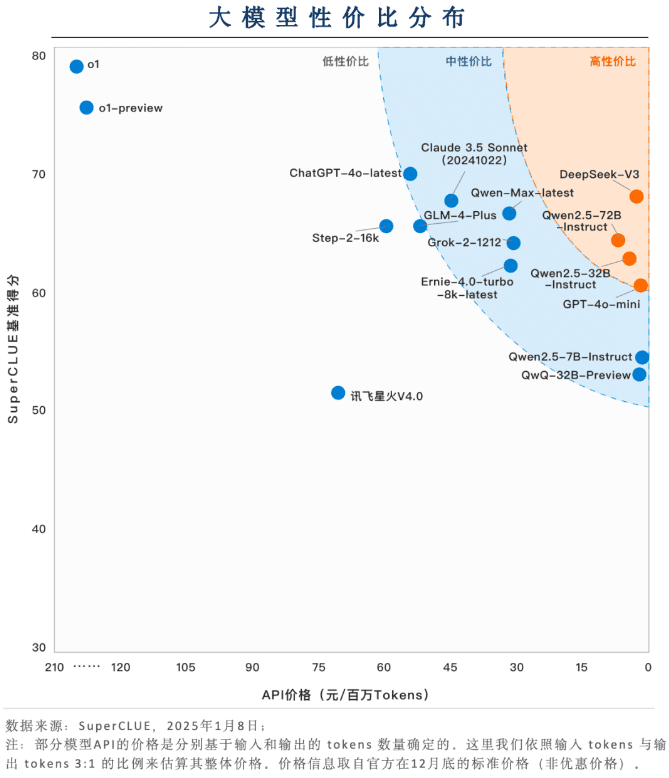

Schlüsselelement 3: Verteilung von Zonen mit gutem Preis-Leistungs-Verhältnis

Große einheimische Modelle haben einen großen Vorteil in Bezug auf das Preis-Leistungs-Verhältnis (Preis + Wirksamkeit)

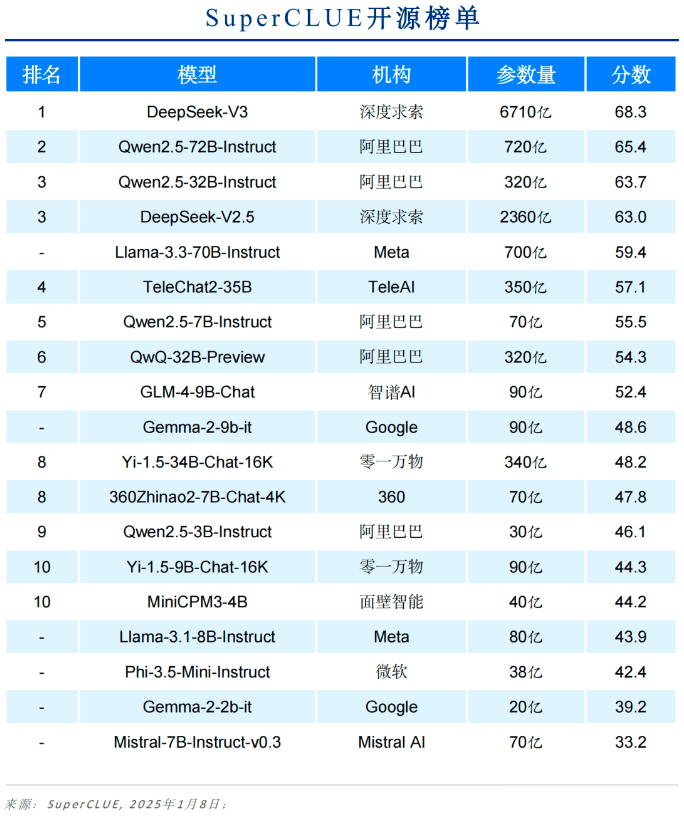

Inländische große Modelle wie DeepSeek-V3, Qwen2.5-72B-Instruct und Qwen2.5-32B-Instruct zeigen große Wettbewerbsfähigkeit in Bezug auf das Preis-/Leistungsverhältnis. Auf der Grundlage eines relativ hohen Maßes an Fähigkeit kann eine sehr niedrige Anwendung Kosten, bei der Anwendung der Landung zu zeigen, eine freundliche Benutzerfreundlichkeit zu erhalten.

Die meisten Modelle sind im mittleren Preissegment angesiedelt

Die meisten Modelle sind nach wie vor hochpreisig, um ein hohes Maß an Leistungsfähigkeit zu gewährleisten. Die Modelle GLM-4-Plus, Qwen-Max-latest, Claude 3.5 Sonnet und Grok-2-1212 kosten alle über 30 $ pro Million Token.

o1 und anderen Inferenzmodellen ist die Kostenwirksamkeit noch stark zu optimieren

Obwohl o1 und o1-preview ein hohes Maß an Leistungsfähigkeit aufweisen, sind sie preislich gesehen um ein Vielfaches teurer als andere Modelle. Die Senkung der Kosten könnte eine Voraussetzung für die breite Nutzung von Inferenzmodellen werden.

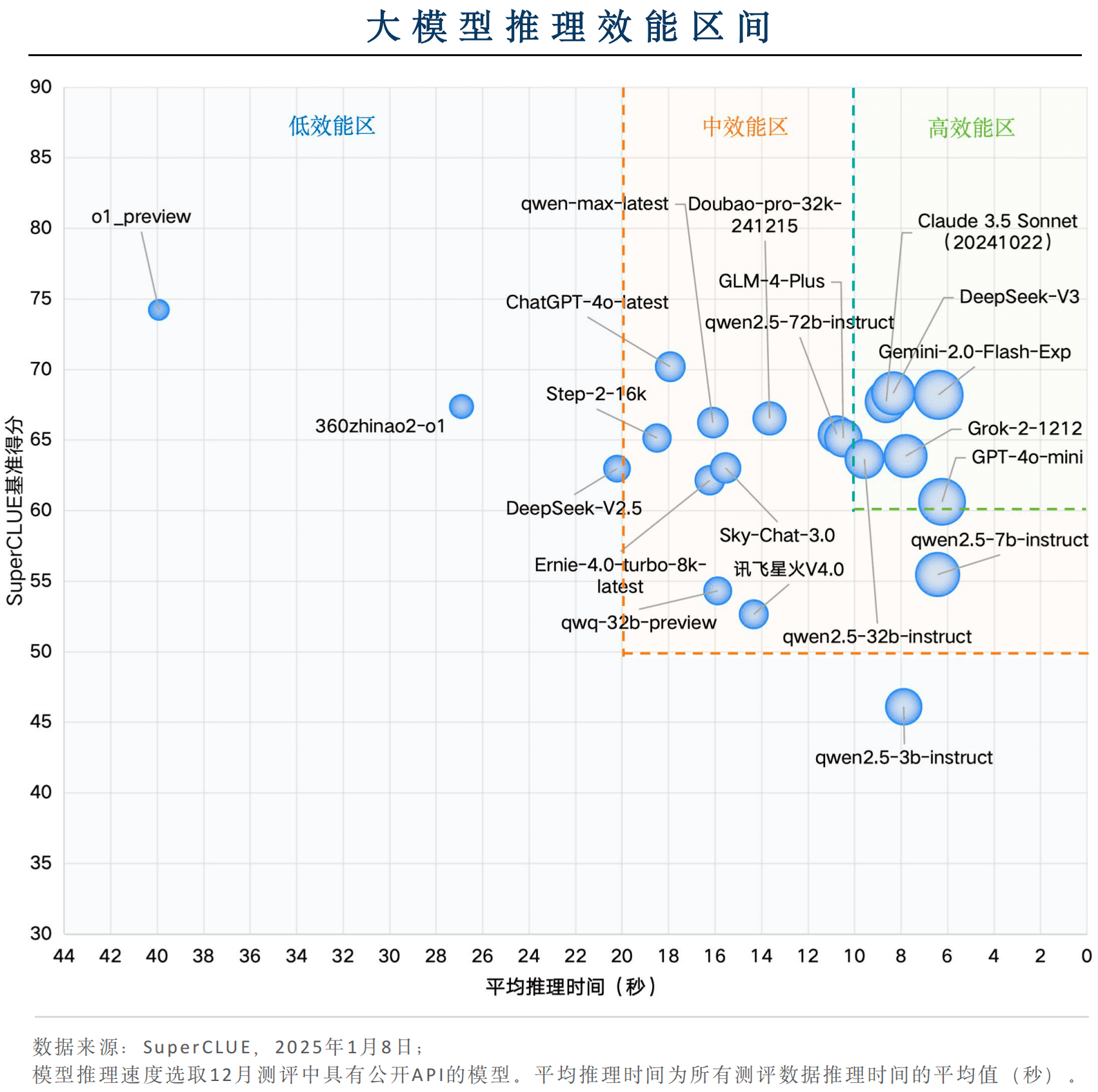

Schlüsselkomponente 4: Über die Verteilung von Effizienzintervallen nachdenken

Einige inländische Modelle sind in Bezug auf die Gesamteffizienz wettbewerbsfähig

Unter den einheimischen Modellen haben DeepSeek-V3 und Qwen2.5-32B-Instruct eine ausgezeichnete Inferenzgeschwindigkeit mit einer durchschnittlichen Inferenzzeit von weniger als 10 Sekunden pro Frage, und gleichzeitig liegen die Benchmark-Ergebnisse über 60, was im Einklang mit der "Hochleistungszone" steht und eine sehr starke Anwendungseffektivität zeigt.

Gemini-2.0-Flash-Exp ist weltweit führend bei der Leistung von Big Model-Anwendungen

Die Überseemodelle Gemini-2.0-Flash-Exp, Claude 3.5 Sonnet (20241022), Grok-2-1212 und GPT-4o-mini qualifizieren sich für die "Hochleistungszone", wobei Gemini-2.0-Flash-Exp die beste kombinierte Effektivität in Bezug auf die Inferenzzeit und die Benchmarkergebnisse aufweist. GPT-4o-mini schneidet in Bezug auf die Inferenzgeschwindigkeit am besten ab.

InferenzmodellDas Modell bietet viel Raum für Leistungsoptimierung.

Obwohl das durch o1-preview repräsentierte Schlussfolgerungsmodell im Benchmarking gut abschneidet, beträgt die durchschnittliche Schlussfolgerungszeit pro Frage etwa 40 Sekunden, und die Gesamtleistung liegt in der "Low Performance Zone". Um ein breites Spektrum an Anwendungsszenarien abzudecken, muss sich das Inferenzmodell auf die Verbesserung seiner Inferenzgeschwindigkeit konzentrieren.

Schlüsselkomponente 5: Nationale und internationale große Modellierungslücken und Trends, 2024

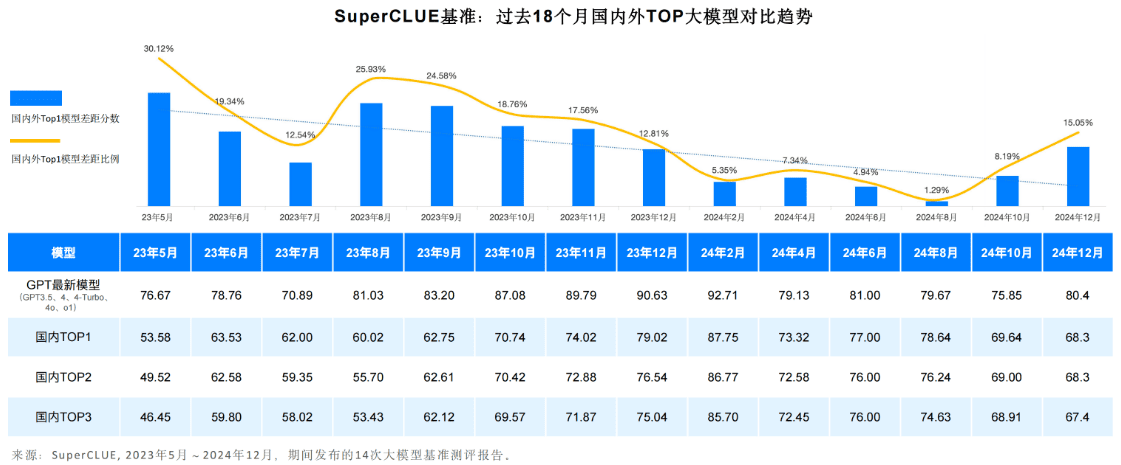

Der allgemeine Trend geht dahin, dass sich die Kluft zwischen den allgemeinen Fähigkeiten der ersten Reihe inländischer und ausländischer großer Modelle im chinesischen Bereich vergrößert.

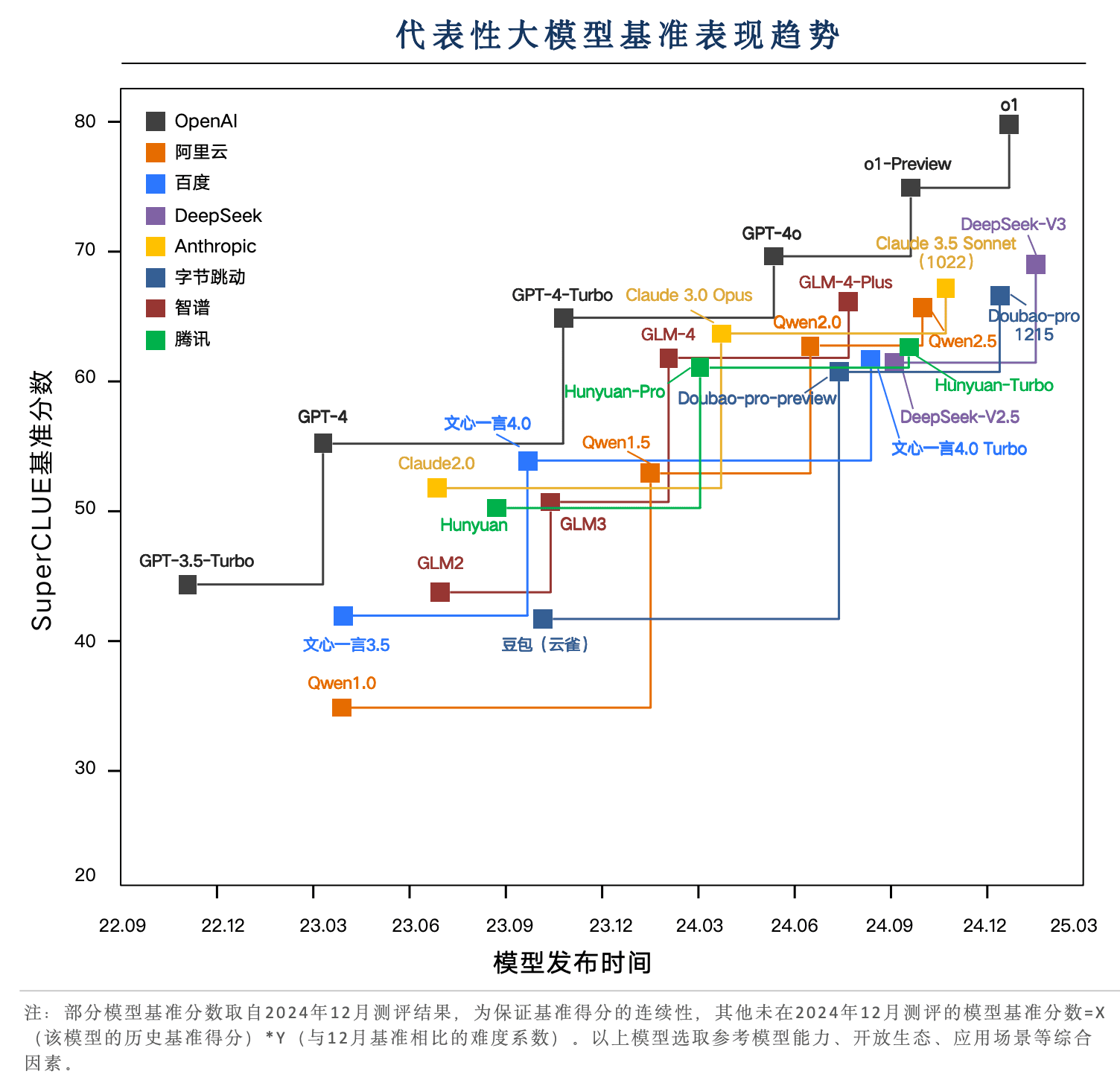

Seit Mai 2023 haben sich die Fähigkeiten von Großmodellen aus dem In- und Ausland weiter entwickelt. Unter ihnen haben die besten Überseemodelle, die durch die GPT-Modellreihe repräsentiert werden, mehrere Iterationen durchlaufen, von GPT3 . 5, GPT4, GPT4 - Turbo, GPT4o, o1 mehrere Versionen von iterativen Upgrades.

Das inländische Modell durchlief ebenfalls einen unruhigen achtmonatigen Iterationszyklus und verringerte den Abstand von 0,121 TP3T im Mai 2 0 2 3 auf 1,291 TP3T im August 2024.

Inländische Modelle, die von DeepSeek-V3 repräsentiert werden, kommen dem GPT-4o-latest sehr nahe

In den letzten zwei Jahren wurden die inländischen repräsentativen Modelle in mehreren Versionen weiterentwickelt. DeepSeek-V3, Doubao-pro, GLM-4-Plus und Qwen2.5 lagen bei chinesischen Aufgaben nahe am GPT-4o, wobei DeepSeek-V3 gut abschnitt und die Leistung von Claude 3.5 Sonnet in der Dezemberbewertung übertraf.

o1 Reasoning-Modelle, die auf dem neuen Paradigma des verstärkten Lernens basieren und 80 Punkte erreichen, um den Abstand zwischen den Spitzenmodellen im In- und Ausland zu vergrößern

In der SuperCLUE Bewertung im Dezember, den wichtigsten Kopf große Modelle im In-und Ausland in SuperCLUE Benchmark-Scores in 60-70 Punkte konzentriert. o1 und o1-Vorschau auf das neue Paradigma des Reinforcement Learning Inferenz-Modell hat sich zu einem wichtigen Technologie-Vertreter der Durchbruch durch die 70-Punkte-Engpass, vor allem die o1 formale Version des Durchbruchs der 80-Punkte-Marke, zeigt einen großen Vorsprung.

Schlüsselelement 6: Andere Subdimensionenlisten

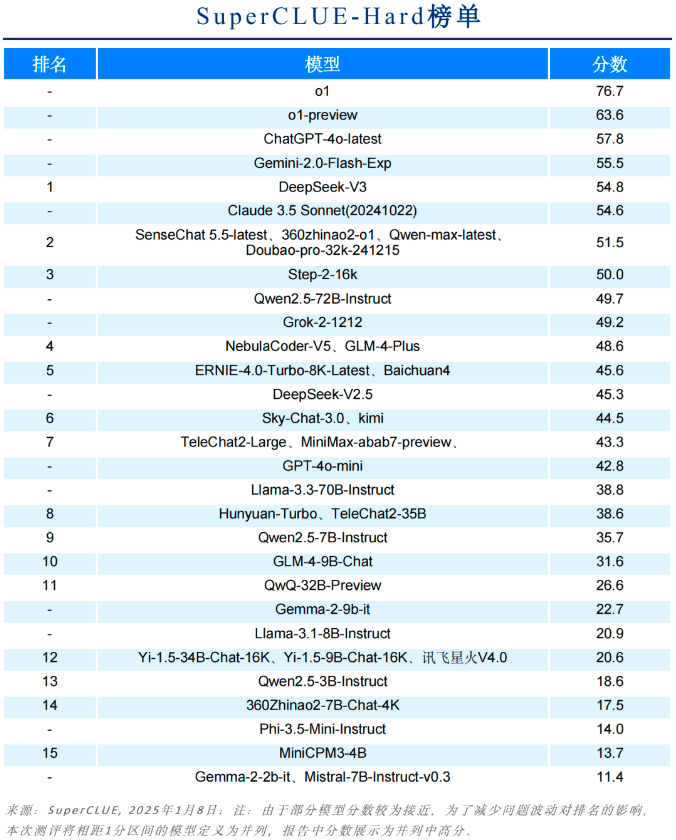

Harte Liste

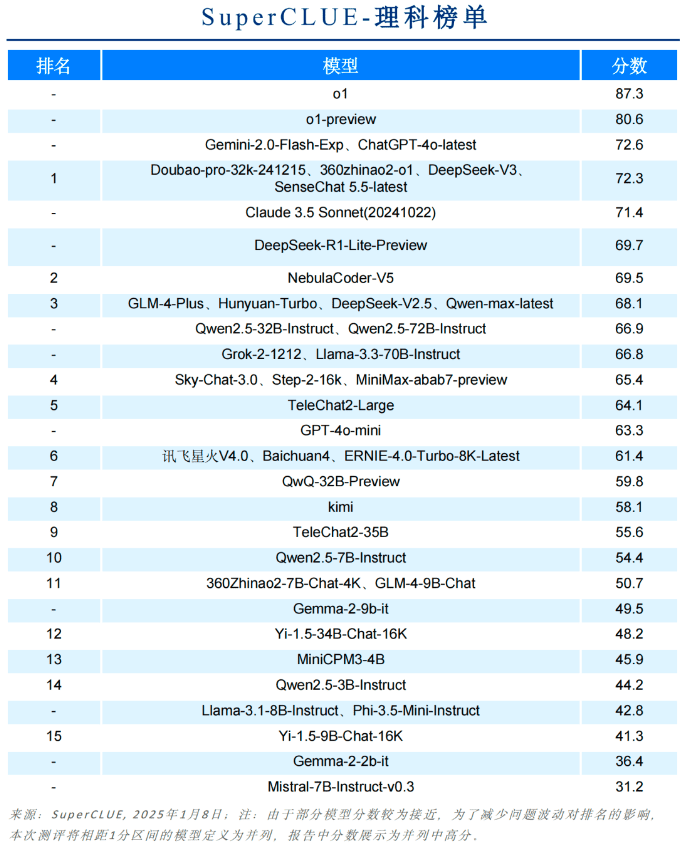

Liste der wissenschaftlichen Fächer

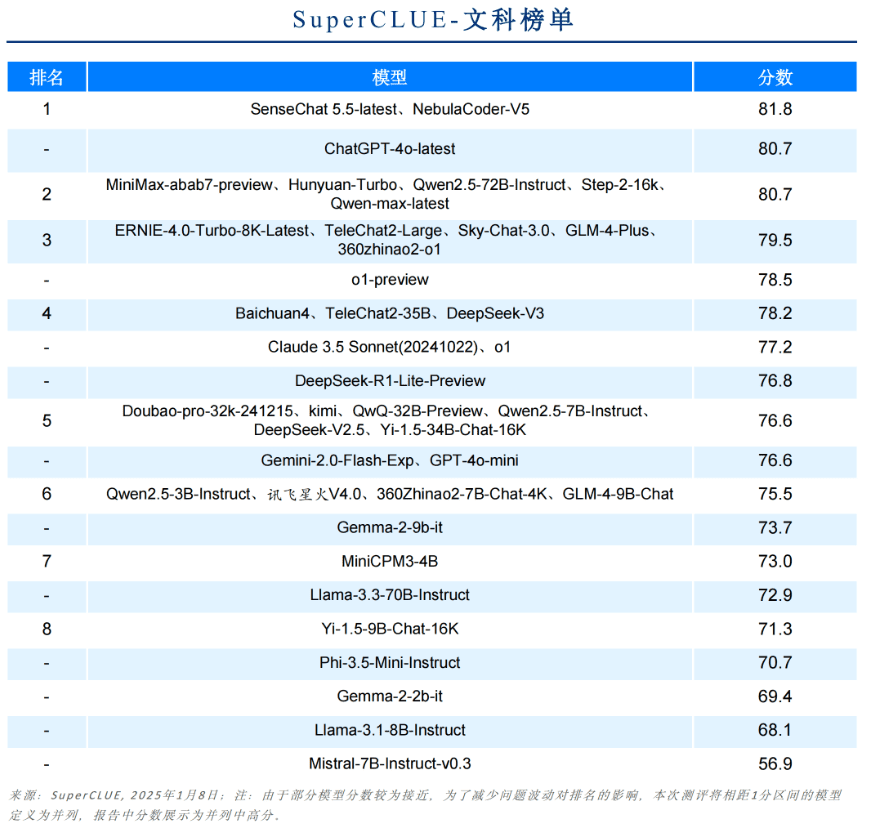

Liste der freien Künste

Top 3 in China für jede Dimension

Liste der Open-Source-Modelle

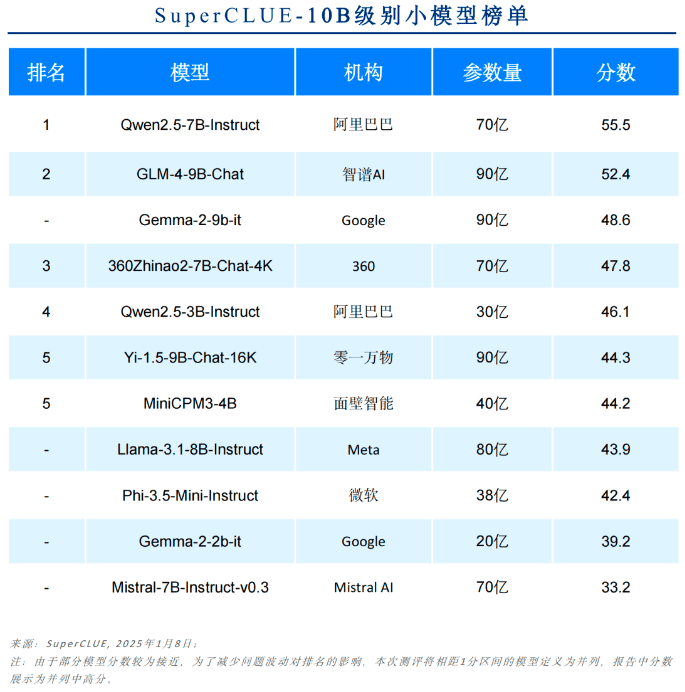

Liste der Modelle bis zu 10B

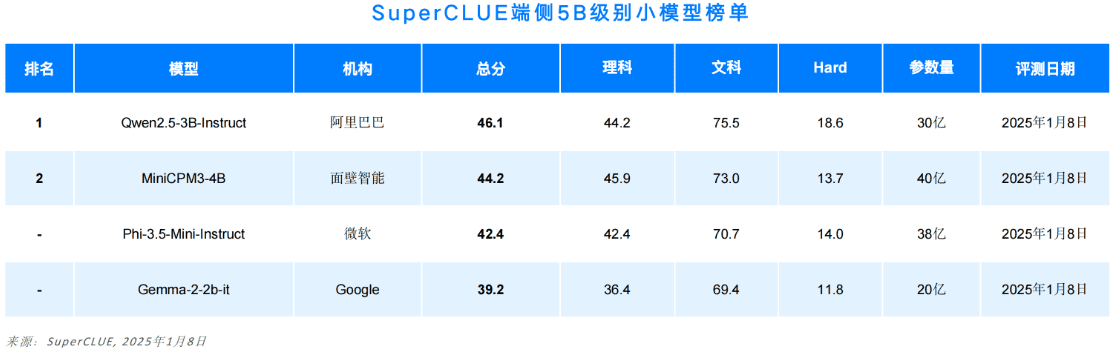

Liste der endseitigen Modelle bis zu 5B

Liste der sekundären feinkörnigen Noten

Aus Platzgründen wird in diesem Papier nur ein Teil des Berichts wiedergegeben. Der vollständige Inhalt umfasst die Bewertungsmethodik, Bewertungsbeispiele, Teilaufgabenlisten, Multimodalität, Anwendungen und eine Einführung in Inferenz-Benchmarks.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...