2024 RAG-Bestandsaufnahme, RAG-Anwendungsstrategie 100+

Im Jahr 2024 ändern sich die großen Modelle von Tag zu Tag, und Hunderte von intelligenten Einrichtungen konkurrieren miteinander. Als wichtiger Teil der KI-Anwendungen ist die RAG auch eine "Gruppe von Helden und Vasallen". Zu Beginn des Jahres heizt ModularRAG weiter ein, GraphRAG glänzt, in der Mitte des Jahres sind Open-Source-Tools in vollem Gange, Wissensgraphen schaffen neue Möglichkeiten, und am Ende des Jahres beginnen Graphenverständnis und multimodale RAG eine neue Reise, so dass es fast so ist, als ob "du singst und ich auf der Bühne stehe", und seltsame Techniken kommen heraus, und die Liste geht weiter und weiter!

Ich habe typische RAG-Systeme und -Papiere für 2024 ausgewählt (mit KI-Hinweisen, Quellen und zusammenfassenden Informationen), und ich habe eine RAG-Übersicht und Test-Benchmarking-Material am Ende des Papiers beigefügt, und ich hoffe, dass dieses Papier, das 16.000 Wörter lang ist, Ihnen helfen wird, schnell durch RAG zu kommen.

Der vollständige Text von 72 Artikeln, Monat für Monat als Übersicht, stark "RAG zweiundsiebzig Stile" genannt, um Ihnen zu bieten.

Bemerkung:

Der gesamte Inhalt dieses Artikels wurde im Open-Source-Repository Awesome-RAG gehostet. Sie können gerne PRs einreichen, um Lücken zu überprüfen.

GitHub-Adresse: https://github.com/awesome-rag/awesome-rag

(01) GraphReader [Grafikexperte]

Grafik-ExpertenSie ist wie ein Tutor, der gut darin ist, Mindmaps zu erstellen und lange Texte in ein klares Wissensnetz umzuwandeln, so dass die KI die für die Antwort benötigten Schlüsselpunkte leicht finden kann, als ob sie eine Landkarte erkunden würde, wodurch das Problem des "Verirrens" bei langen Texten effektiv überwunden wird.

- Uhrzeit: 01.20

- Dissertation: GraphReader: Aufbau eines graphenbasierten Agenten zur Verbesserung der Langkontextfähigkeiten großer Sprachmodelle

GraphReader ist ein graphenbasiertes System von Intelligenzen, das lange Texte verarbeitet, indem es sie zu einem Graphen aufbaut und Intelligenzen einsetzt, um diesen Graphen selbständig zu erkunden. Bei Erhalt eines Problems führt das intelligente System zunächst eine schrittweise Analyse durch und entwickelt einen sinnvollen Plan. Dann ruft er eine Reihe von vordefinierten Funktionen auf, um Knoteninhalte und Nachbarn zu lesen, wodurch eine grobe bis feine Erkundung des Graphen ermöglicht wird. Während des gesamten Erkundungsprozesses nimmt der intelligente Körper kontinuierlich neue Erkenntnisse auf und reflektiert die aktuelle Situation, um den Prozess zu optimieren, bis er genügend Informationen gesammelt hat, um eine Antwort zu generieren.

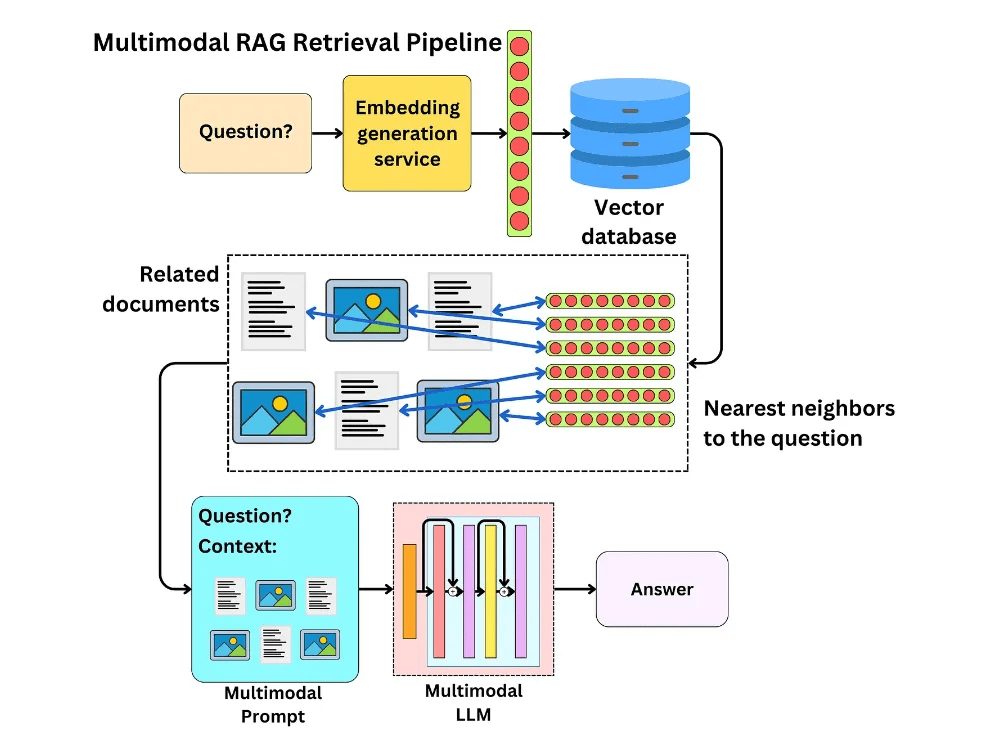

(02) MM-RAG [Vielschichtig]

vielseitiger MenschEs ist wie ein Alleskönner, der gleichzeitig sehen, hören und sprechen kann und nicht nur verschiedene Formen von Informationen versteht, sondern auch frei zwischen ihnen wechseln und sie miteinander in Beziehung setzen kann. Durch das umfassende Verständnis verschiedener Informationen kann er intelligentere und natürlichere Dienste in verschiedenen Bereichen wie Empfehlungen, Assistenten und Medien anbieten.

Es werden Entwicklungen im Bereich des multimodalen maschinellen Lernens vorgestellt, darunter vergleichendes Lernen, beliebige modale Suche durch multimodale Einbettung, multimodales Retrieval Augmented Generation (MM-RAG) und die Verwendung von Vektordatenbanken zum Aufbau multimodaler Produktionssysteme. Es werden auch zukünftige Trends in der multimodalen KI erforscht und ihre vielversprechenden Anwendungen in Bereichen wie Empfehlungssysteme, virtuelle Assistenten, Medien und E-Commerce hervorgehoben.

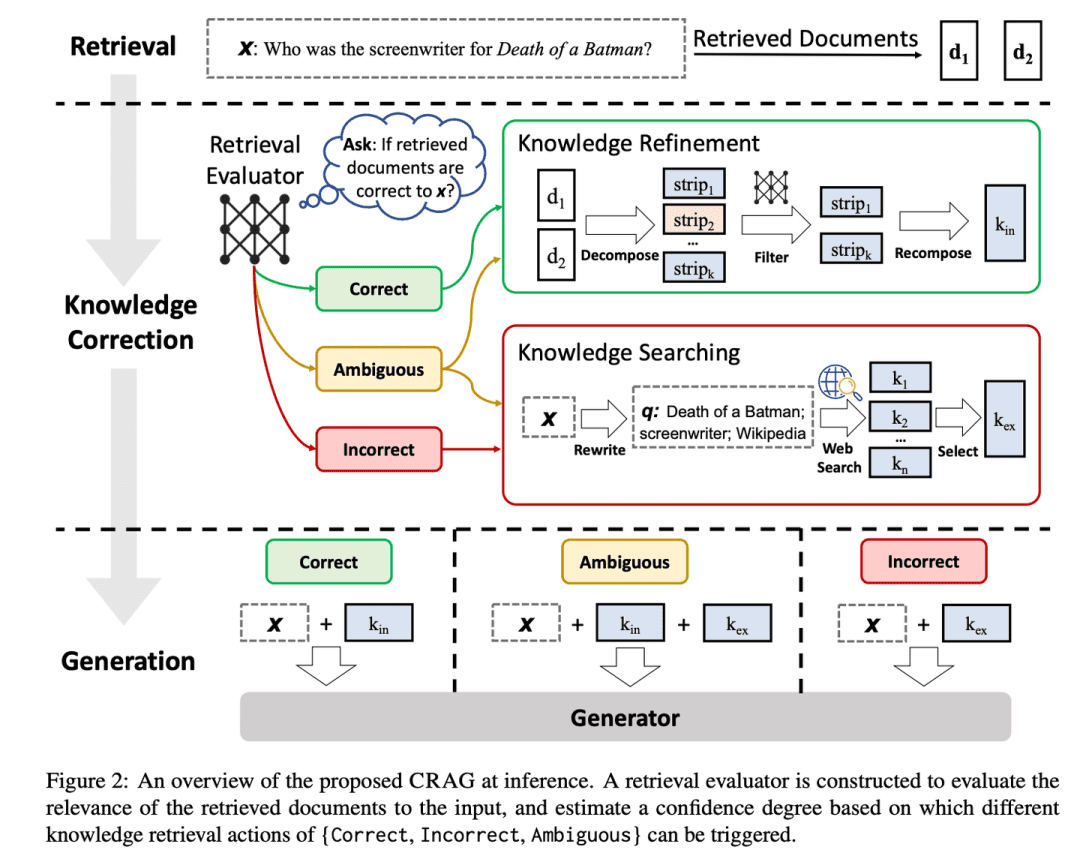

(03) CRAG [Selbstkorrektur]

SelbstkorrekturWie ein erfahrener Redakteur sichtet es auf einfache und schnelle Weise die vorläufigen Informationen, erweitert sie dann durch eine Suche im Internet und stellt schließlich sicher, dass der endgültige Inhalt sowohl korrekt als auch zuverlässig ist, indem es ihn zerlegt und neu organisiert. Es ist, als würde man ein Qualitätskontrollsystem auf die RAG anwenden, um die von ihr produzierten Inhalte vertrauenswürdiger zu machen.

- Zeit: 01.29

- Dissertation: Korrektiv Abruf Erweiterte Generation

- Projekt: https://github.com/HuskyInSalt/CRAG

CRAG verbessert die Qualität der abgerufenen Dokumente durch die Entwicklung eines leichtgewichtigen Retrieval-Evaluators und die Einführung einer groß angelegten Websuche und verfeinert die abgerufenen Informationen durch Dekompositions- und Reorganisationsalgorithmen, um die Genauigkeit und Zuverlässigkeit des generierten Textes zu erhöhen.CRAG ist eine nützliche Ergänzung und Verbesserung der bestehenden RAG-Technik, die die Robustheit des generierten Textes durch Selbstkorrektur der Retrieval-Ergebnisse erhöht.

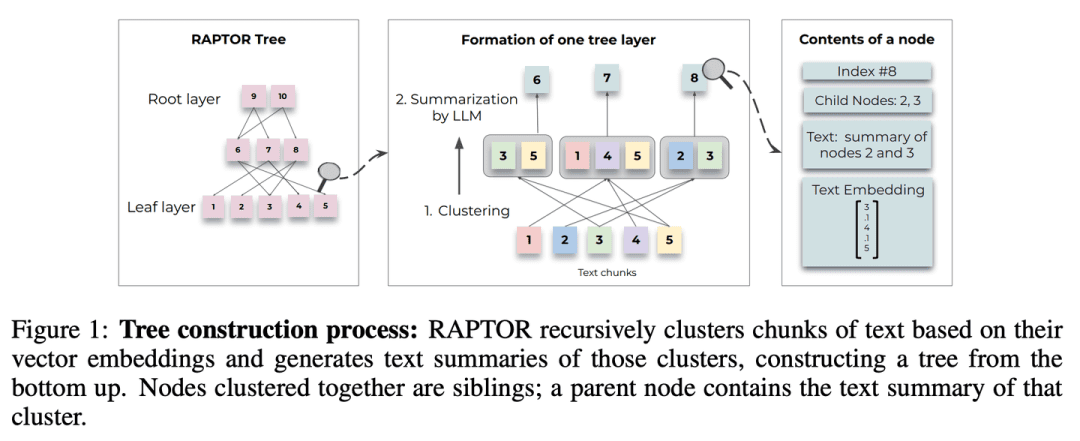

(04) RAPTOR [hierarchische Verallgemeinerung]

hierarchische ZusammenfassungWie ein gut organisierter Bibliothekar ist der Inhalt des Dokuments in einer Baumstruktur von unten nach oben gegliedert, so dass sich die Informationsabfrage flexibel zwischen den verschiedenen Ebenen bewegen kann, und zwar sowohl im Hinblick auf einen Gesamtüberblick als auch auf tiefer gehende Details.

- Uhrzeit: 01.31

- Dissertation: RAPTOR: Rekursive abstrakte Verarbeitung für baumorganisiertes Retrieval

- Projekt: https://github.com/parthsarthi03/raptor

RAPTOR (Recursive Abstractive Processing for Tree-Organised Retrieval) führt eine neue Methode zur rekursiven Einbettung, Gruppierung und Zusammenfassung von Textblöcken ein, um Bäume mit verschiedenen Zusammenfassungsebenen von unten nach oben aufzubauen. Zum Zeitpunkt der Inferenz ruft das RAPTOR-Modell Informationen aus diesem Baum ab, indem es Informationen aus langen Dokumenten mit unterschiedlichen Abstraktionsniveaus integriert.

(05) T-RAG [privater Berater]

privater BeraterWie ein interner Berater, der mit den Organisationsstrukturen vertraut ist, ist er in der Lage, Informationen anhand einer Baumstruktur zu organisieren, um lokalisierte Dienste effizient und kostengünstig bereitzustellen und gleichzeitig die Privatsphäre zu schützen.

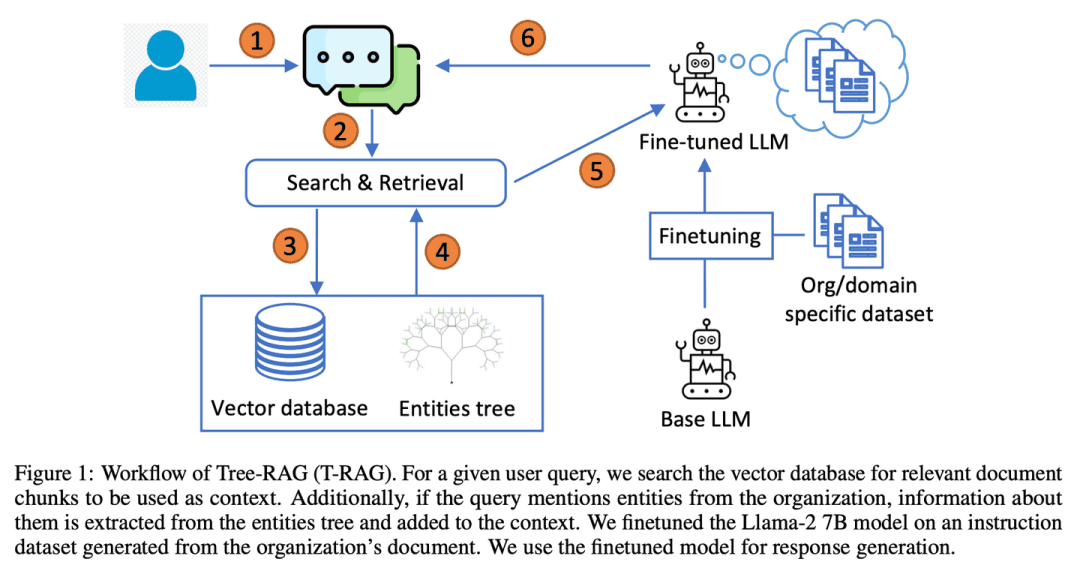

- Dissertation: T-RAG: Lektionen aus dem LLM-Graben

T-RAG (Tree Retrieval Augmentation Generation) kombiniert RAG mit fein abgestimmten Open-Source-LLMs, die Baumstrukturen verwenden, um Entitätshierarchien innerhalb von Organisationen darzustellen und Kontexte zu erweitern. Dabei werden lokal gehostete Open-Source-Modelle genutzt, um Bedenken hinsichtlich des Datenschutzes auszuräumen und gleichzeitig die Latenzzeit bei der Inferenz, die Kosten für die Token-Nutzung sowie regionale und geografische Verfügbarkeitsfragen zu berücksichtigen.

(06) RAT [Denker]

DenkerWie ein Tutor, der über seine Arbeit nachdenkt, kommen Sie nicht auf einmal zu einer Schlussfolgerung, sondern beginnen mit ersten Ideen und verwenden dann die relevanten Informationen, die Sie erhalten haben, um jeden Schritt des Denkprozesses zu überprüfen und zu verfeinern, um die Gedankenkette zu straffen und zuverlässiger zu machen.

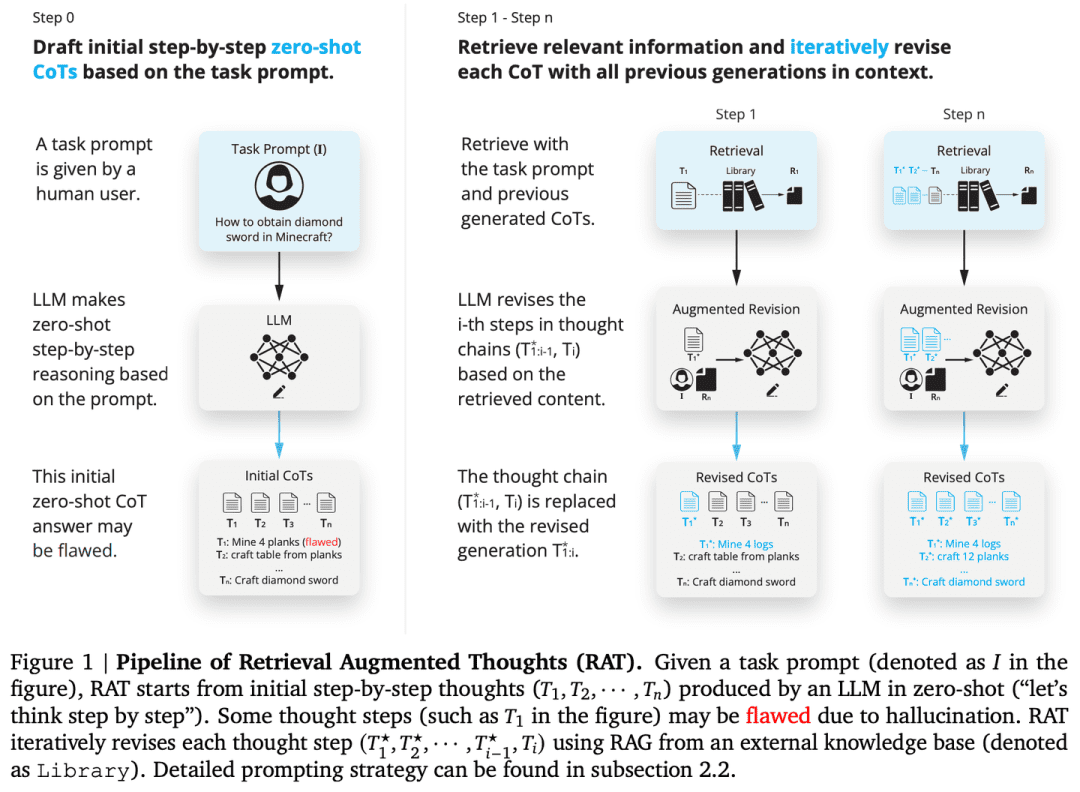

- Diplomarbeit: RAT: Retrieval Augmented Thoughts Ermitteln Sie Kontextbewusstes Reasoning bei der Generierung mit langem Zeithorizont

- Projekt: https://github.com/CraftJarvis/RAT

RAT (Retrieval Augmented Thinking) Nach der Erstellung einer anfänglichen Null-Proben-Gedankenkette (CoT) wird jeder Gedankenschritt einzeln überarbeitet, wobei die abgerufenen Informationen in Bezug auf die Aufgabenanfrage sowie die aktuellen und vergangenen Gedankenschritte verwendet werden.

(07) RAFT [Open Book Master]

Meister im Bücher öffnenWie ein guter Kandidat werden Sie nicht nur die richtigen Referenzen finden, sondern auch die wichtigsten Elemente genau zitieren und den Argumentationsprozess klar erläutern, so dass die Antwort sowohl evidenzbasiert als auch sinnvoll ist.

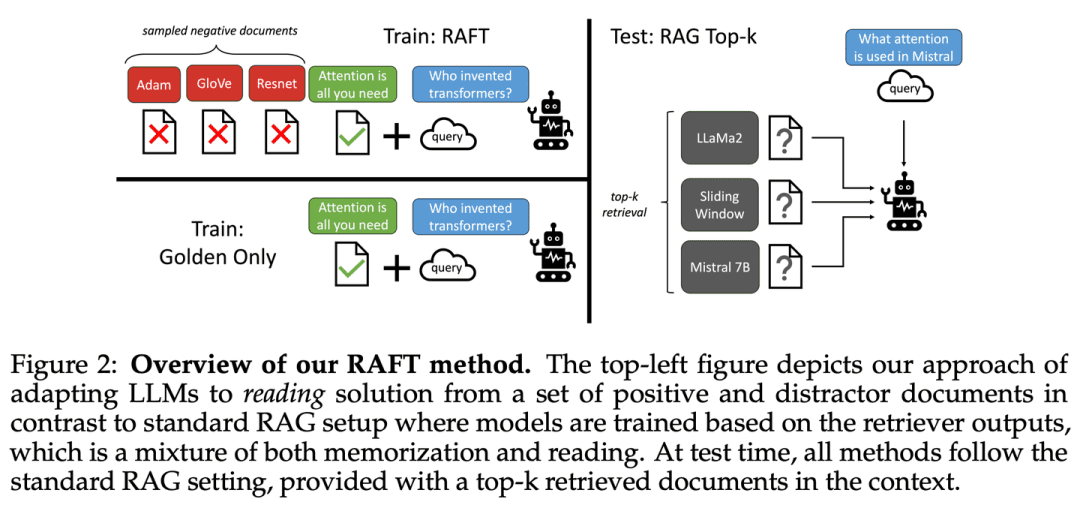

- Dissertation: RAFT: Anpassung des Sprachmodells an bereichsspezifische RAG

RAFT zielt darauf ab, die Fähigkeit eines Modells zur Beantwortung von Fragen in einer domänenspezifischen "Open-Book"-Umgebung zu verbessern, indem das Modell darauf trainiert wird, irrelevante Dokumente zu ignorieren und Fragen zu beantworten, indem es die korrekten Sequenzen aus den relevanten Dokumenten wortwörtlich zitiert, was in Kombination mit gedanklich verknüpften Antworten die Argumentationsfähigkeit des Modells erheblich verbessert.

(08) Adaptive-RAG [Reaching the Right Person for the Right Job]

(Redewendung) entsprechend den Fähigkeiten des Schülers unterrichtenBei Fragen mit unterschiedlichem Schwierigkeitsgrad wählt es auf intelligente Weise die am besten geeignete Antwort. Einfache Fragen werden direkt beantwortet, während komplexe Fragen mit mehr Informationen oder schrittweiser Argumentation beantwortet werden, genau wie ein erfahrener Lehrer, der weiß, wie er die Lehrmethode an die spezifischen Probleme der Schüler anpassen kann.

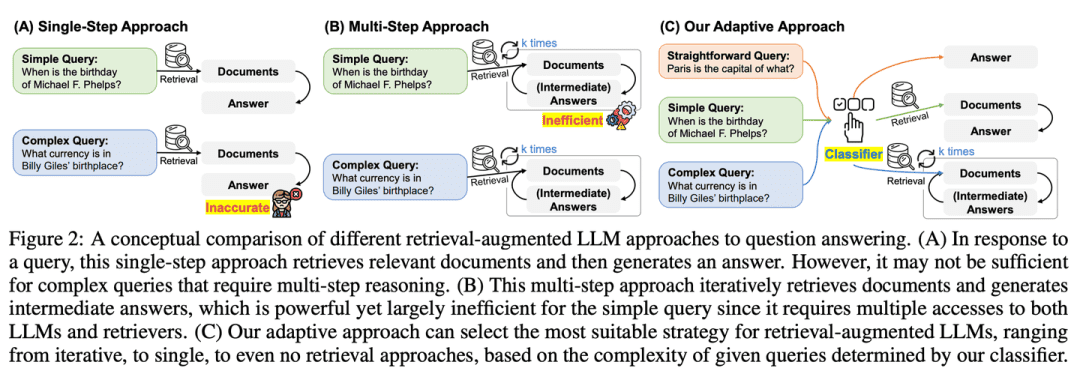

- Dissertation: Adaptive-RAG: Lernen zur Anpassung Retrieval-erweiterter großer Sprachmodelle durch Fragekomplexität

- Projekt: https://github.com/starsuzi/Adaptive-RAG

Adaptive-RAG wählt dynamisch die am besten geeignete Strategie zur Verbesserung des Abrufs für die LLM auf der Grundlage der Komplexität der Abfrage aus und wählt dynamisch die am besten geeignete Strategie für die LLM von der einfachsten bis zur komplexesten aus. Dieser Auswahlprozess wird durch einen kleinen Sprachmodell-Klassifikator implementiert, der die Komplexität der Anfrage vorhersagt und automatisch Labels sammelt, um den Auswahlprozess zu optimieren. Dieser Ansatz bietet eine ausgewogene Strategie, die sich nahtlos zwischen iterativen und einstufigen abrufgestützten LLMs sowie Methoden ohne Abruf für eine Reihe von Abfragekomplexitäten anpasst.

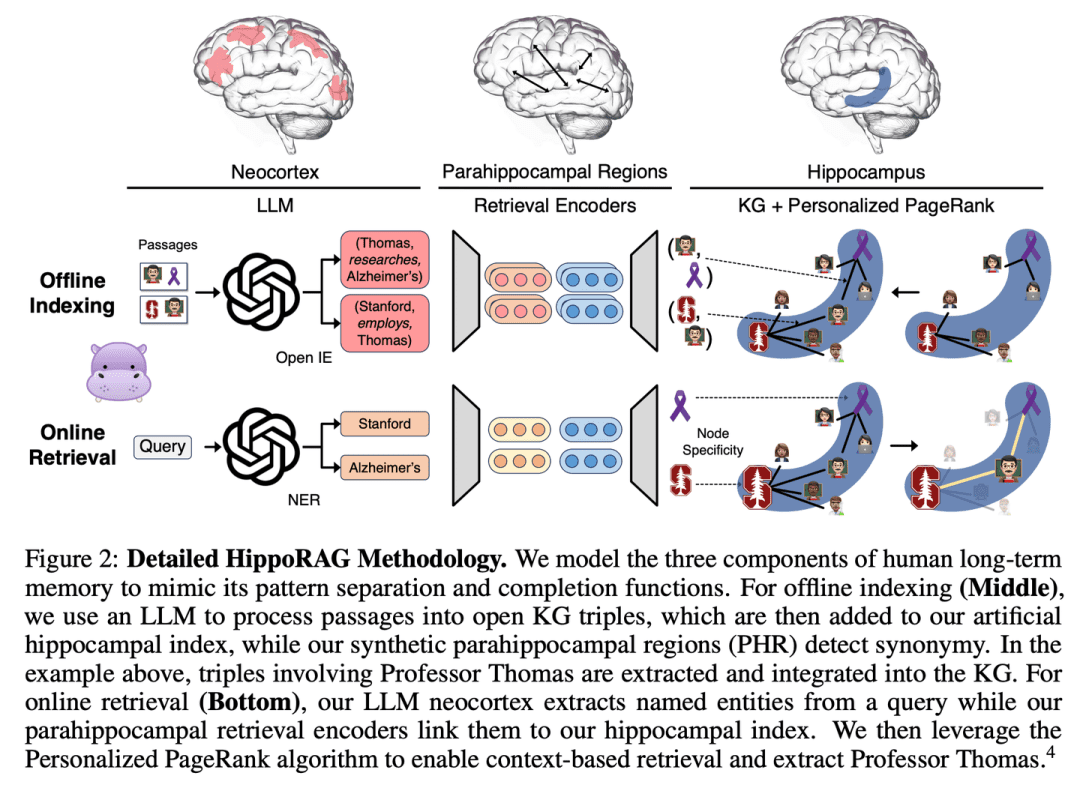

(09) HippoRAG [Hippocampus]

HippocampusWie der Pferdekörper des menschlichen Geistes wird altes und neues Wissen geschickt zu einem Netz verwoben. Es werden nicht einfach nur Informationen angehäuft, sondern jedes neue Wissen findet seinen angemessenen Platz.

- Dissertation: HippoRAG: Neurobiologisch inspiriertes Langzeitgedächtnis für große Sprachmodelle

- Projekt: https://github.com/OSU-NLP-Group/HippoRAG

HippoRAG ist ein neuartiges Retrieval Framework, das von der hippocampalen Indexierungstheorie des menschlichen Langzeitgedächtnisses inspiriert ist und darauf abzielt, eine tiefere und effizientere Wissensintegration neuer Erfahrungen zu ermöglichen. HippoRAG orchestriert synergetisch LLMs, Wissensgraphen und personalisierte PageRank-Algorithmen, um die unterschiedlichen Rollen des Neokortex und des Hippocampus im menschlichen Gedächtnis nachzuahmen.

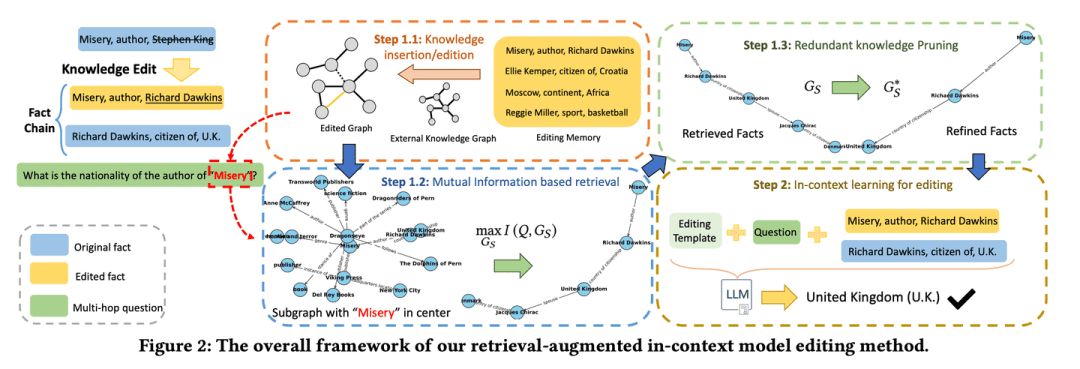

(10) RAE [intelligente Bearbeitung]

intelligenter Editor (Software)Wie ein sorgfältiger Nachrichtenredakteur wird er oder sie nicht nur tief in den relevanten Fakten graben, sondern auch die Schlüsselinformationen herausfinden, die durch Kettenschlüsse leicht übersehen werden können, und gleichzeitig wissen, wie man überflüssige Inhalte kürzt, um sicherzustellen, dass die endgültigen Informationen sowohl genau als auch prägnant sind, um das Problem des "viel reden, aber nicht zuverlässig" zu vermeiden.

- Dissertation: Retrieval-unterstützte Wissensaufbereitung in Sprachmodellen für Multi-Hop-Fragebeantwortung

- Projekt: https://github.com/sycny/RAE

RAE (Multi-hop Q&A Retrieval Enhanced Model Editing Framework) ruft zunächst bearbeitete Fakten ab und optimiert dann das Sprachmodell durch kontextuelles Lernen. Der auf gegenseitiger Informationsmaximierung basierende Suchansatz nutzt die Argumentationskraft des großen Sprachmodells, um verkettete Fakten zu identifizieren, die bei herkömmlichen, auf Ähnlichkeit basierenden Suchen übersehen werden könnten. Darüber hinaus beinhaltet das System eine Bereinigungsstrategie, um redundante Informationen aus den abgerufenen Fakten zu eliminieren, was die Bearbeitungsgenauigkeit verbessert und das Illusionsproblem entschärft.

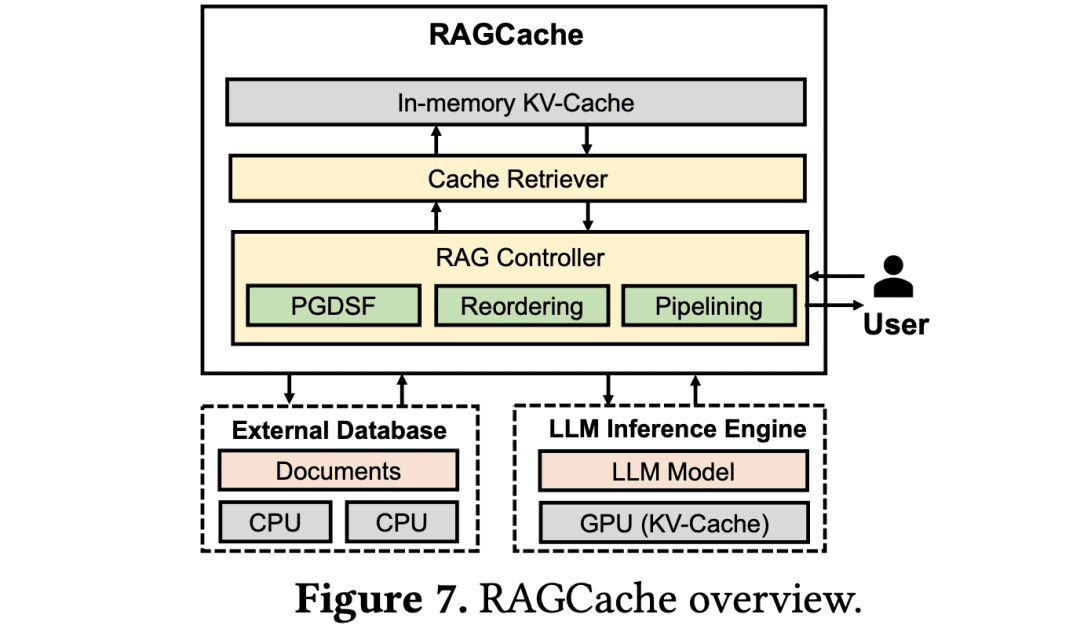

(11) RAGCache [Lagerverwalter]

LagerverwalterWie in einem großen Logistikzentrum sollten Sie häufig genutztes Wissen in die Regale stellen, die am leichtesten zu erreichen sind. Sie sollten wissen, wie Sie häufig genutzte Pakete an der Tür und selten genutzte Pakete in den hinteren Regalen ablegen, um die Effizienz der Abholung zu maximieren.

- Dissertation: RAGCache: Effizientes Wissens-Caching für Retrieval-Augmented Generation

RAGCache ist ein neuartiges mehrstufiges dynamisches Zwischenspeichersystem, das auf RAG zugeschnitten ist. Es organisiert die Zwischenzustände des abgerufenen Wissens in einem Wissensbaum und speichert sie sowohl in GPU- als auch in Host-Speicherhierarchien.RAGCache schlägt eine Substitutionsstrategie vor, die LLM-Schlussfolgerungsmerkmale und RAG-Abfragemuster berücksichtigt. Außerdem werden die Abruf- und Schlussfolgerungsschritte dynamisch überlappt, um die End-to-End-Latenz zu minimieren.

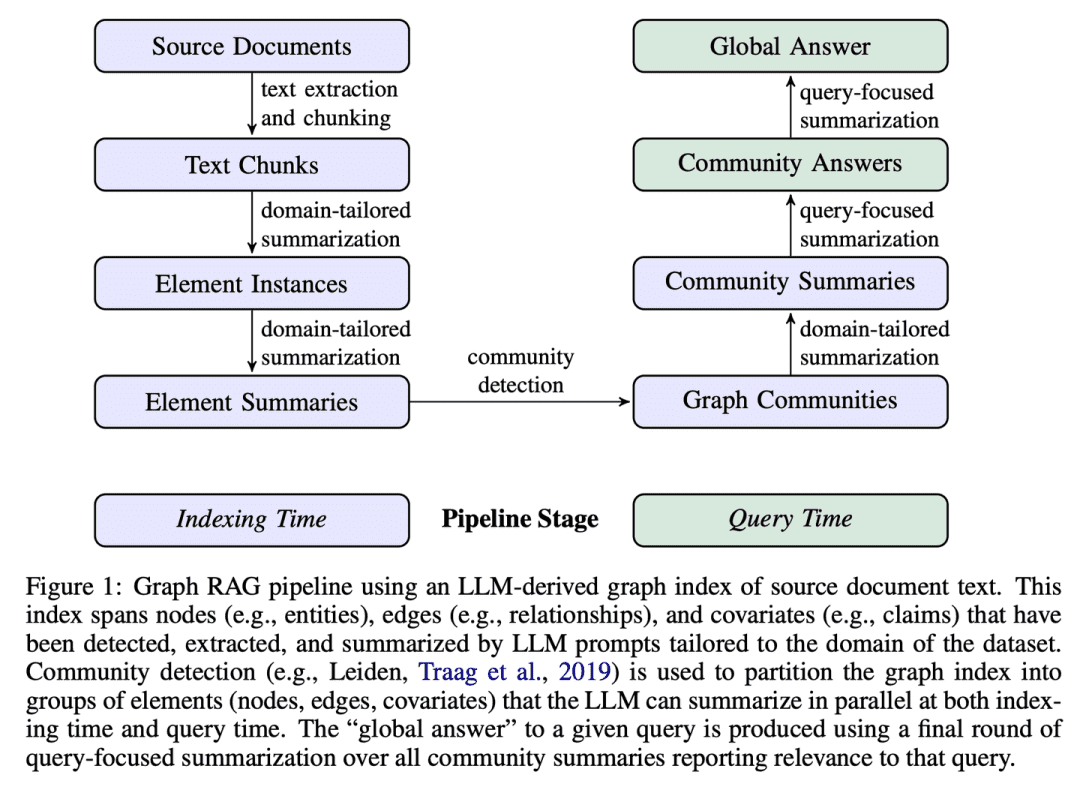

(12) GraphRAG [Zusammenfassung der Gemeinschaft]

Zusammenfassungen der GemeinschaftZunächst wird das Netzwerk der Bewohner in der Nachbarschaft sortiert, und dann wird jedem Nachbarschaftskreis ein Profil zugeordnet. Wenn jemand nach dem Weg fragt, liefert jeder Nachbarschaftskreis Hinweise, die schließlich in die vollständigste Antwort integriert werden.

- Dissertation: Vom Lokalen zum Globalen: Ein Graph-RAG-Ansatz zur abfrageorientierten Verdichtung

- Projekt: https://github.com/microsoft/graphrag

GraphRAG erstellt graphenbasierte Textindizes in zwei Schritten: Zunächst wird ein Wissensgraph der Entitäten aus den Quelldokumenten abgeleitet, und dann werden für alle Gruppen eng verwandter Entitäten Zusammenfassungen der Gemeinschaft vorab erstellt. Bei einem Problem wird jede Gemeinschaftszusammenfassung verwendet, um eine Teilantwort zu generieren, und dann werden alle Teilantworten in der endgültigen Antwort an den Benutzer erneut zusammengefasst.

(13) R4 [Meisterchoreograph]

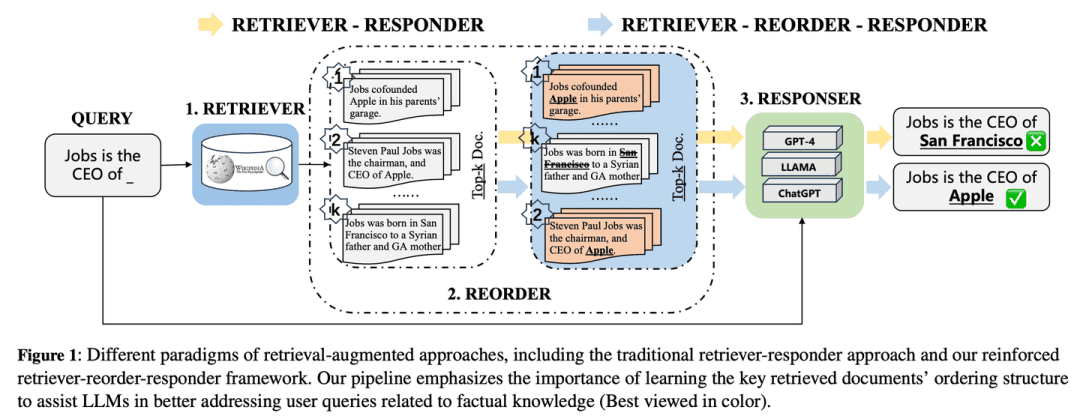

ArrangeurmeisterWie ein Meister-Typograf wird die Qualität der Ausgabe durch die Optimierung der Reihenfolge und der Präsentation des Materials verbessert, wodurch der Inhalt geordneter und konzentrierter wird, ohne dass das Kernmodell geändert werden muss.

- Dissertation: R4: Verstärkter Retriever-Reorder-Responder für Retrieval-erweiterte große Sprachmodelle

R4 (Reinforced Retriever-Reorder-Responder) wird verwendet, um die Dokumentenreihenfolge für ein Retrieval-erweitertes großes Sprachmodell zu erlernen, wodurch die generativen Fähigkeiten des großen Sprachmodells weiter verbessert werden, während eine große Anzahl seiner Parameter eingefroren bleibt. Der Lernprozess für die Neuordnung ist in zwei Schritte unterteilt, die auf der Qualität der generierten Antworten basieren: Anpassung der Dokumentenreihenfolge und Verbesserung der Dokumentendarstellung. Die Anpassung der Dokumentenreihenfolge zielt insbesondere darauf ab, die Reihenfolge der abgerufenen Dokumente in Anfangs-, Mittel- und Endpositionen auf der Grundlage des Graph-Attention-Learnings zu organisieren, um die Verstärkungsbelohnung der Antwortqualität zu maximieren. Die Verbesserung der Dokumentrepräsentation verfeinert die abgerufenen Dokumentrepräsentationen von Antworten schlechter Qualität durch Gradientenlernen auf Dokumentenebene.

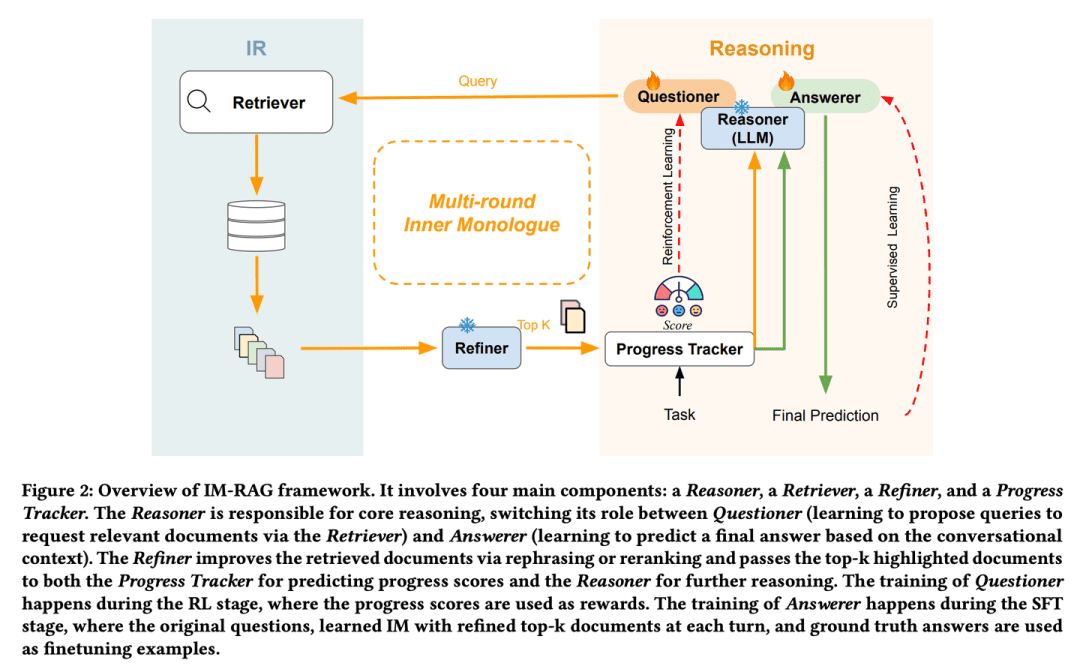

(14) IM-RAG [Selbstgespräche]

Selbstgespräche führenWenn sie auf ein Problem stoßen, rechnen sie im Kopf durch, "welche Informationen muss ich überprüfen" und "reichen diese Informationen aus", und verfeinern die Antwort durch einen ständigen inneren Dialog. Diese Fähigkeit des "Monologs" entspricht der eines menschlichen Experten, der in der Lage ist, tief zu denken und komplexe Probleme Schritt für Schritt zu lösen.

- Diplomarbeit: IM-RAG: Multi-Round Retrieval-Augmented Generation durch Lernen innerer Monologe

IM-RAG unterstützt mehrere Runden der Generierung von Retrievalverbesserungen durch das Lernen von Inneren Monologen, um IR-Systeme mit LLMs zu verbinden. Der Ansatz integriert das Information Retrieval System mit großen Sprachmodellen, um mehrere Runden der Retrievalverbesserung durch das Lernen von inneren Monologen zu unterstützen. Während des inneren Monologs fungiert das große Sprachmodell als zentrales Schlussfolgerungsmodell, das entweder eine Anfrage durch den Retriever stellen kann, um weitere Informationen zu sammeln, oder eine endgültige Antwort auf der Grundlage des Dialogkontexts liefert. Wir führen auch einen Optimierer ein, der den Output des Retrievers verbessert und so die Lücke zwischen dem Reasoner und den Informationsbeschaffungsmodulen mit unterschiedlichen Fähigkeiten effektiv überbrückt und die Kommunikation über mehrere Runden erleichtert. Der gesamte Prozess des inneren Monologs wird durch Reinforcement Learning (RL) optimiert, wobei auch ein Fortschrittsverfolger eingeführt wird, um Belohnungen für Zwischenschritte zu liefern, und die Antwortvorhersagen werden durch Supervised Fine-Tuning (SFT) individuell weiter optimiert.

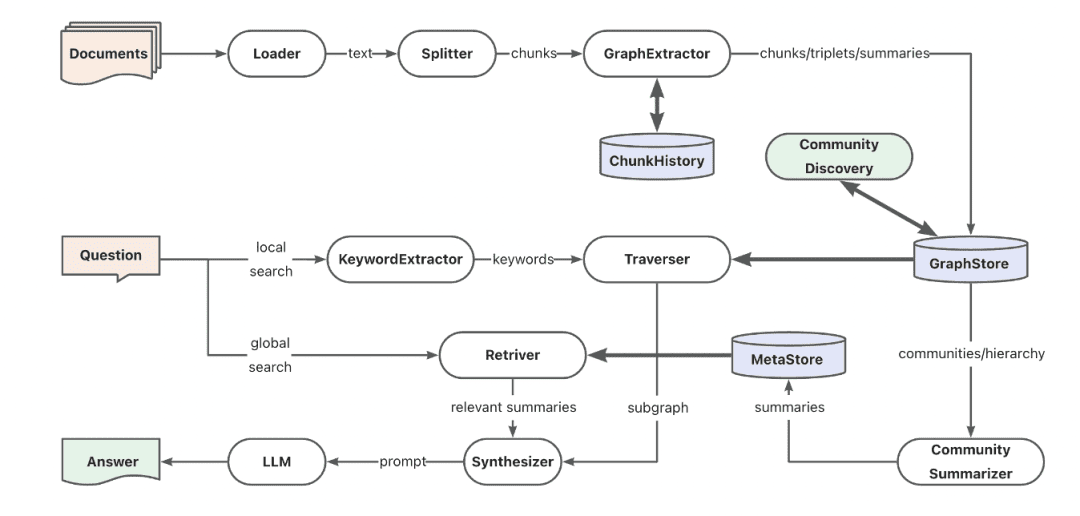

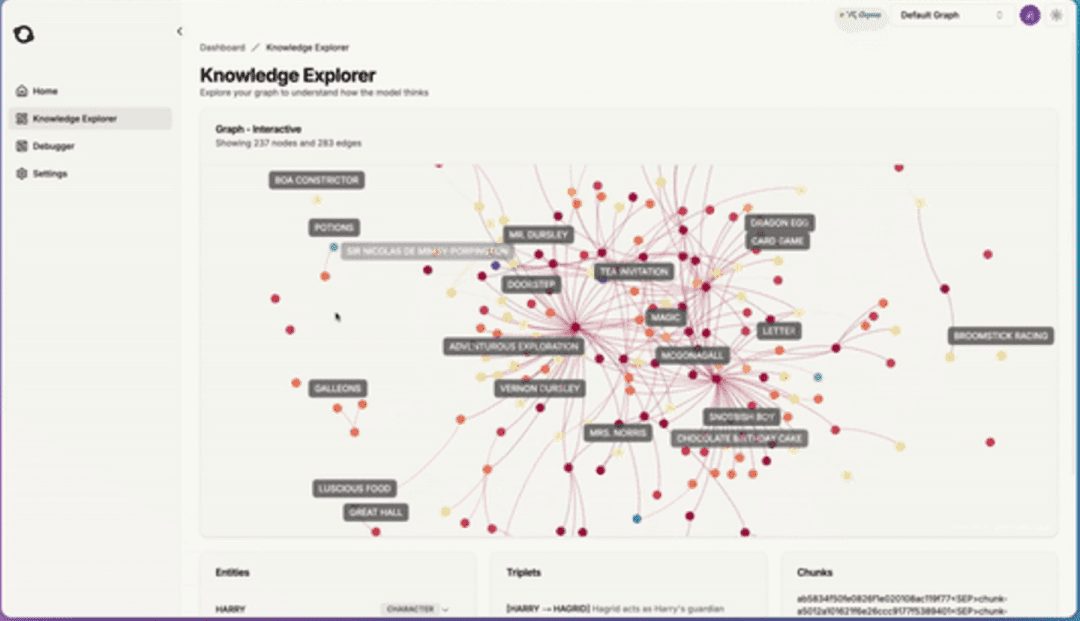

(15) AntGroup-GraphRAG [Hunderte von Experten]

hundert DenkschulenDas Unternehmen bringt die Besten der Besten aus der Branche zusammen und hat sich auf eine Vielzahl von Möglichkeiten spezialisiert, Informationen schnell zu finden, präzise Suchanfragen zu stellen und natürlichsprachliche Abfragen zu verstehen, wodurch komplexe Wissenssuchen sowohl kostengünstig als auch effizient werden.

- Projekt: https://github.com/eosphoros-ai/DB-GPT

Das TuGraph-Team hat das quelloffene GraphRAG-Framework auf der Grundlage von DB-GPT entwickelt, das mit einer Vielzahl von Wissensbasis-Indexierungssockeln wie Vektor, Graph, Volltext usw. kompatibel ist und kostengünstige Wissensextraktion, Dokumentenstruktur-Mapping, Graph-Community-Abstraktion und hybrides Retrieval zur Lösung von QFS-Q&A-Problemen unterstützt. Darüber hinaus bietet es Unterstützung für verschiedene Retrieval-Funktionen wie Schlüsselwörter, Vektoren und natürliche Sprache.

(16) Kotaemon [LEGO]

Lego (Spielzeug)Ein fertiger Satz von Q&A-Bausteinen, die direkt verwendet oder frei zerlegt und umgestaltet werden können. Die Benutzer können sie nach Belieben verwenden, und die Entwickler können sie nach Belieben ändern.

- Projekt: https://github.com/Cinnamon/kotaemon

Eine quelloffene, saubere und anpassbare RAG-Benutzeroberfläche zum Erstellen und Anpassen Ihres eigenen Dokumenten-Q&A-Systems. Sowohl die Bedürfnisse der Endbenutzer als auch die der Entwickler werden berücksichtigt.

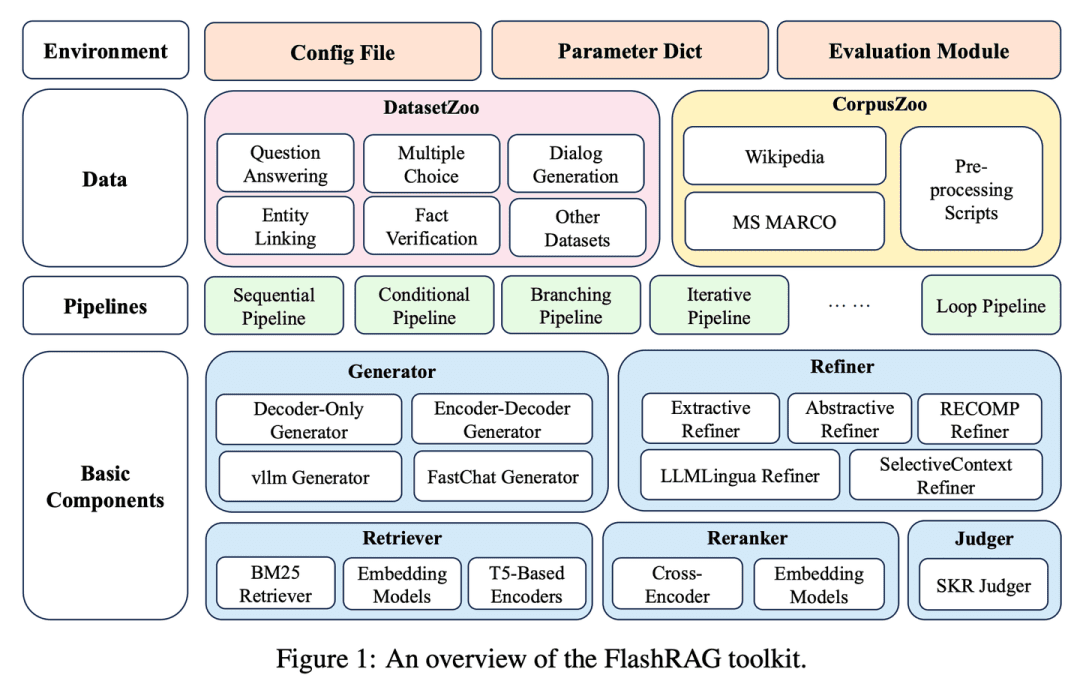

(17) FlashRAG [Schatztruhe]

SchatztruhePaketierung der verschiedenen RAG-Artefakte in einem Toolkit, das es den Forschern ermöglicht, ihre eigenen Retrieval-Modelle nach und nach zu erstellen, so wie man Bausteine auswählt.

- Dissertation: FlashRAG: Ein modulares Toolkit für effiziente Retrieval-Augmented Generation Forschung

- Projekt: https://github.com/RUC-NLPIR/FlashRAG

FlashRAG ist ein effizientes und modulares Open-Source-Toolkit, das Forschern helfen soll, bestehende RAG-Methoden zu reproduzieren und ihre eigenen RAG-Algorithmen innerhalb eines einheitlichen Rahmens zu entwickeln. Unser Toolkit implementiert 12 hochmoderne RAG-Methoden und sammelt und sammelt 32 Benchmark-Datensätze.

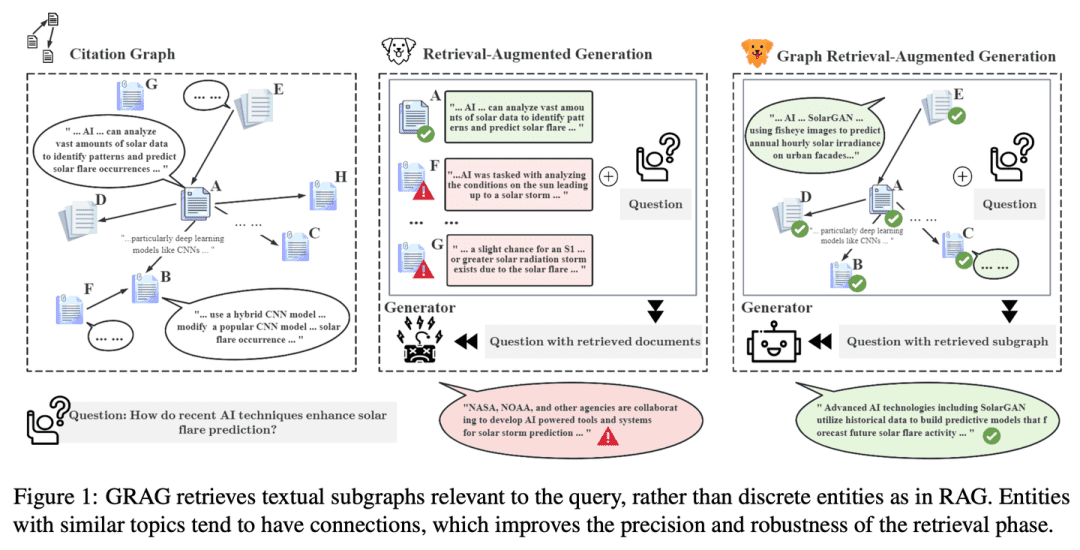

(18) GRAG [Detektiv]

Detektivarbeit leistenEr begnügt sich nicht mit oberflächlichen Hinweisen, sondern gräbt tiefer in das Netz der Verbindungen zwischen den Texten und spürt wie bei einem Verbrechen der Wahrheit hinter jeder Information nach, um die Antwort noch genauer zu machen.

- Diplomarbeit: GRAG: Graph Retrieval-Augmented Generation

- Projekt: https://github.com/HuieL/GRAG

Traditionelle RAG-Modelle ignorieren die Verbindungen zwischen Texten und die topologischen Informationen der Datenbank, wenn sie mit komplexen graphenstrukturierten Daten umgehen, was zu Leistungsengpässen führt.GRAG verbessert die Leistung erheblich und reduziert die Illusionen des Retrieval- und Generierungsprozesses, indem es die Bedeutung von Subgraphenstrukturen betont.

(19) Camel-GraphRAG [links und rechts]

Schlag mit einer Hand und dann mit der anderen, in schneller FolgeEin Auge scannt Text mit Mistral, um Informationen zu extrahieren, das andere webt ein Netz von Beziehungen mit Neo4j. Bei der Suche arbeiten das linke und das rechte Auge zusammen, um Ähnlichkeiten zu finden und die Spur zu verfolgen, was die Suche umfassender und genauer macht.

- Projekt: https://github.com/camel-ai/camel

Camel-GraphRAG stützt sich auf das Mistral-Modell, um Wissen aus gegebenen Inhalten zu extrahieren, Wissensstrukturen zu konstruieren und diese Informationen in einer Neo4j-Graphdatenbank zu speichern. Ein hybrider Ansatz, der Vektor-Retrieval mit Wissensgraphen-Retrieval kombiniert, wird dann zur Abfrage und Erkundung des gespeicherten Wissens verwendet.

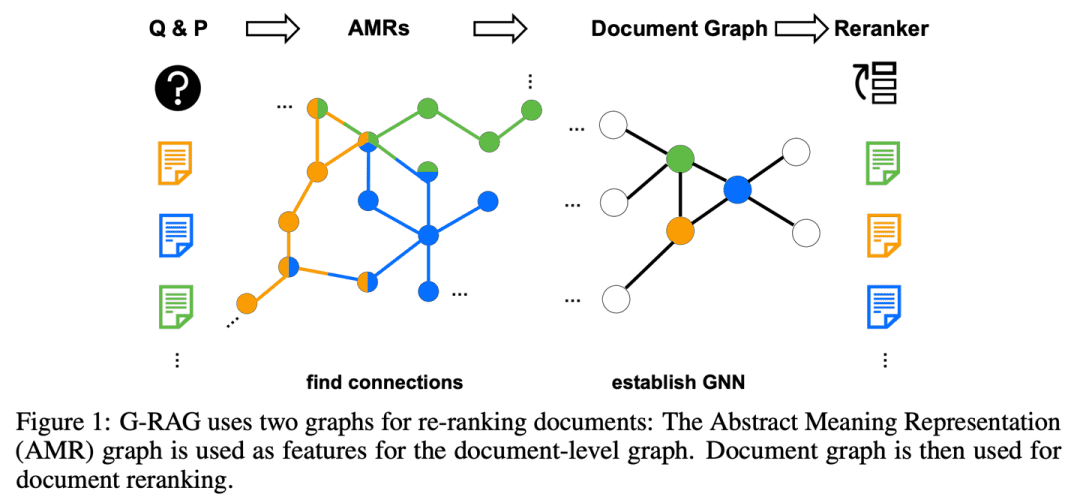

(20) G-RAG [Stringer]

lit. Türklopfer (Idiom); fig. ein Wundermittel für die Probleme der MenschenAnstatt allein nach Informationen zu suchen, bauen Sie für jeden Wissenspunkt ein Beziehungsnetz auf. Wie ein Socialite wissen Sie nicht nur, was jeder Ihrer Freunde gut kann, sondern Sie wissen auch, wer mit wem befreundet ist, sodass Sie die Spur direkt verfolgen können, wenn Sie nach Antworten suchen.

- Papier: Vergessen Sie nicht, sich zu verbinden! Verbesserung der RAG mit grafikbasiertem Reranking

RAG hat immer noch Probleme mit der Beziehung zwischen Dokumenten und dem Kontext der Frage, und das Modell ist möglicherweise nicht in der Lage, Dokumente effektiv zu nutzen, wenn ihre Relevanz für die Frage nicht offensichtlich ist oder wenn sie nur Teilinformationen enthalten. Darüber hinaus ist die Frage, wie Verbindungen zwischen Dokumenten sinnvoll abgeleitet werden können, ein wichtiges Thema.G-RAG implementiert ein auf einem neuronalen Netzwerk (GNN) basierendes Umordnungssystem zwischen dem RAG-Retriever und dem Leser. Die Methode kombiniert die Verbindungsinformationen zwischen Dokumenten und semantische Informationen (über einen abstrakten semantischen Repräsentationsgraphen), um einen kontextbasierten Ranker für RAG zu erstellen.

(21) LLM-Graph-Builder [Mover]

ein GepäckträgerDem chaotischen Text ein verständliches Zuhause geben. Tragen Sie ihn nicht einfach vor sich her, sondern beschriften Sie wie ein Zwanghafter jeden Wissenspunkt, ziehen Sie Beziehungslinien und bauen Sie schließlich ein wohlgeordnetes Wissensgebäude in der Neo4j-Datenbank auf.

- Projekt: https://github.com/neo4j-labs/llm-graph-builder

Neo4j Open Source LLM-basierter Generator zur Extraktion von Wissensgraphen, der unstrukturierte Daten in einen Wissensgraphen in Neo4j umwandeln kann. Mit großen Modellen zu extrahieren Knoten, Beziehungen und ihre Attribute aus unstrukturierten Daten.

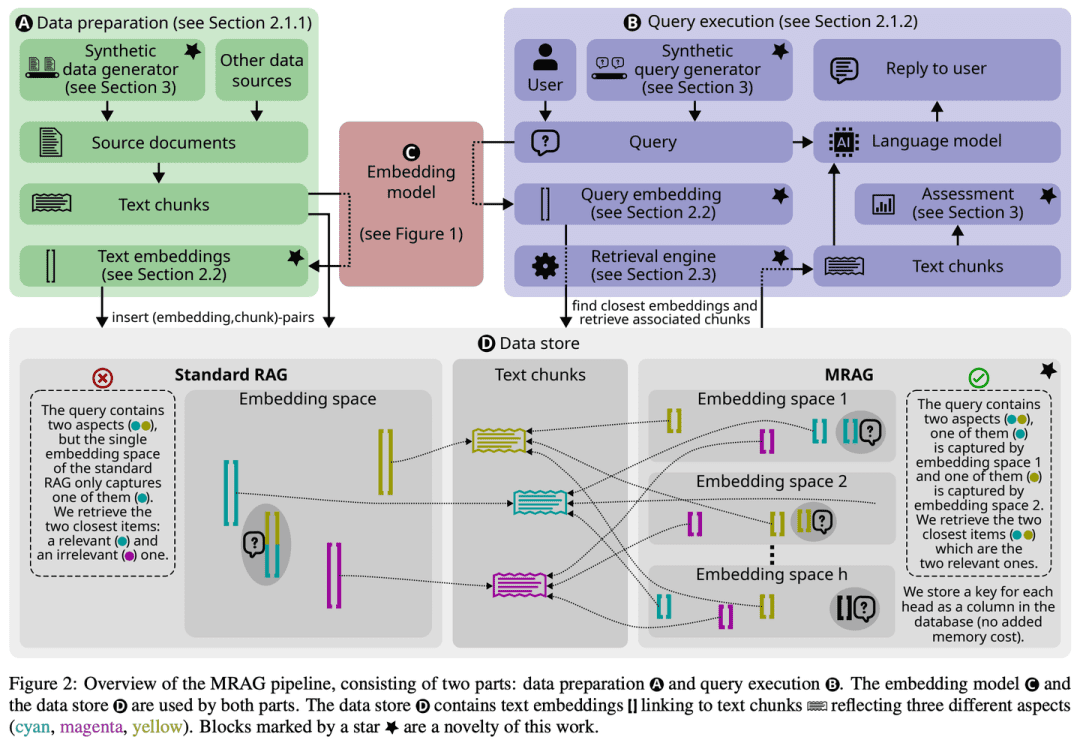

(22) MRAG [Oktopus]

OktopusAnstatt nur einen Kopf wachsen zu lassen, um für das Problem zu sterben, wachsen ihr mehrere Tentakel wie einem Kraken, wobei jeder Tentakel für das Erfassen eines Winkels zuständig ist. Einfach ausgedrückt, ist dies die KI-Version von "Multitasking".

- Dissertation: Multi-Head RAG: Lösen von Multi-Aspekt-Problemen mit LLMs

- Projekt: https://github.com/spcl/MRAG

Bestehende RAG-Lösungen konzentrieren sich nicht auf Abfragen, die den Zugriff auf mehrere Dokumente mit sehr unterschiedlichem Inhalt erfordern können. Solche Abfragen treten häufig auf, stellen aber eine Herausforderung dar, weil die Einbettungen dieser Dokumente im Einbettungsraum weit auseinander liegen können, was es schwierig macht, sie alle abzurufen. In diesem Papier wird Multihead RAG (MRAG) vorgestellt, ein neuartiges Verfahren, das diese Lücke mit einer einfachen, aber leistungsstarken Idee schließen soll: die Verwendung der Transformator Die Aktivierung einer mehrköpfigen Aufmerksamkeitsschicht anstelle einer Decoderschicht dient als Schlüssel zur Erfassung vielschichtiger Dokumente. Die treibende Motivation ist, dass verschiedene Aufmerksamkeitsköpfe lernen können, verschiedene Datenaspekte zu erfassen. Durch die Nutzung der entsprechenden Aktivierungen werden Einbettungen erzeugt, die Datenelemente und verschiedene Aspekte der Abfrage repräsentieren, wodurch die Abfragegenauigkeit bei komplexen Abfragen verbessert wird.

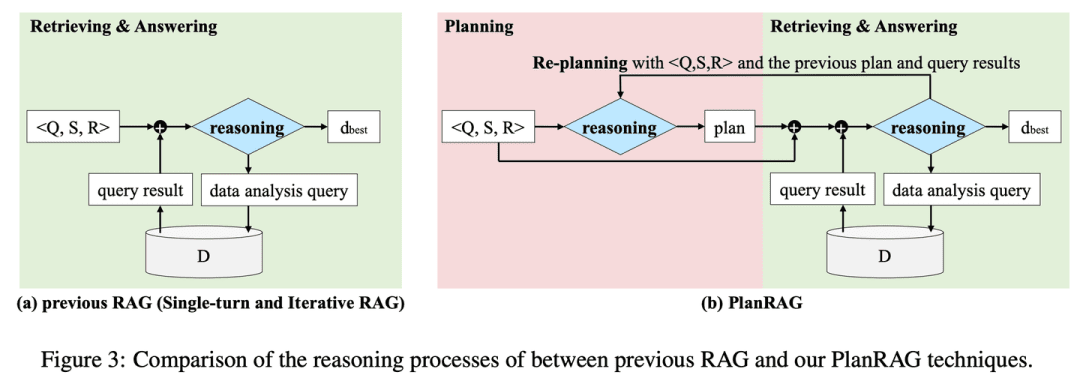

(23) PlanRAG [Stratege]

ein StrategeEin vollständiger Schlachtplan wird entwickelt, dann wird die Situation anhand der Regeln und Daten analysiert und schließlich werden die besten taktischen Entscheidungen getroffen.

- Dissertation: PlanRAG: Eine Plan-then-Retrieval Augmented Generation für generative große Sprachmodelle als Entscheidungsträger

- Projekt: https://github.com/myeon9h/PlanRAG

PlanRAG untersucht, wie groß angelegte Sprachmodelle zur Lösung komplexer Datenanalyse-Entscheidungsprobleme eingesetzt werden können, indem die Aufgabe Decision QA definiert wird, d.h. die Bestimmung der besten Entscheidung auf der Grundlage des Entscheidungsproblems Q, der Geschäftsregeln R und der Datenbank D. PlanRAG erzeugt zunächst einen Entscheidungsplan, und dann generiert der Retriever Abfragen zur Datenanalyse.

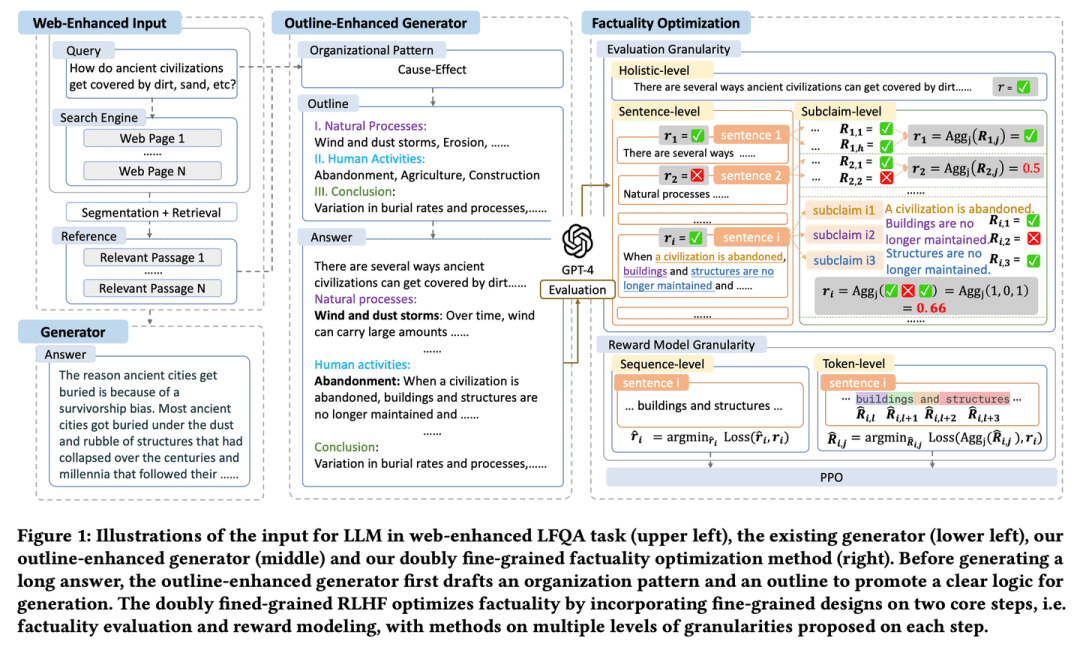

(24) FoRAG [Schriftsteller]

SchriftstellerDer Aufsatz wird in einer Gliederung geschrieben, die den Rahmen des Aufsatzes bildet und dann Absatz für Absatz erweitert und verfeinert wird. Es gibt auch einen "Redakteur", der dabei hilft, jedes Detail zu perfektionieren und die Qualität der Arbeit durch sorgfältige Überprüfung der Fakten und Änderungsvorschläge zu gewährleisten.

- Dissertation: FoRAG: Fakten-optimierte Retrieval Augmented Generation für Web-gestützte Langform-Fragenbeantwortung

FoRAG schlägt einen neuartigen Generator zur Verbesserung der Gliederung vor, der in der ersten Phase Gliederungsvorlagen verwendet, um auf der Grundlage der Benutzeranfrage und des Kontexts Antwortgliederungen zu entwerfen, und in der zweiten Phase jeden Standpunkt auf der Grundlage der generierten Gliederung erweitert, um die endgültige Antwort zu erstellen. Es wird auch ein Ansatz zur Optimierung von Fakten vorgeschlagen, der auf einem gut durchdachten, doppelt feinkörnigen RLHF-Rahmen basiert, der dichtere Belohnungssignale liefert, indem er ein feinkörniges Design in den beiden Kernschritten der Faktenbewertung und der Belohnungsmodellierung einführt.

(25) Multi-Meta-RAG [meta-screener]

meta-filterWie ein erfahrener Datenverwalter setzt es mehrere Filtermechanismen ein, um die relevantesten Inhalte aus einer riesigen Menge von Informationen herauszufiltern. Dabei wird nicht nur die Oberfläche betrachtet, sondern auch die "Identitäts-Tags" (Metadaten) der Dokumente analysiert, um sicherzustellen, dass jede gefundene Information wirklich zum Thema passt.

- Dissertation: Multi-Meta-RAG: Verbesserung der RAG für Multi-Hop-Abfragen durch Datenbankfilterung mit LLM-extrahierten Metadaten

- Projekt: https://github.com/mxpoliakov/multi-meta-rag

Multi-Meta-RAG verwendet Datenbankfilterung und LLM-extrahierte Metadaten, um die Auswahl relevanter Dokumente aus einer Vielzahl von Quellen, die für das Problem relevant sind, zu verbessern.

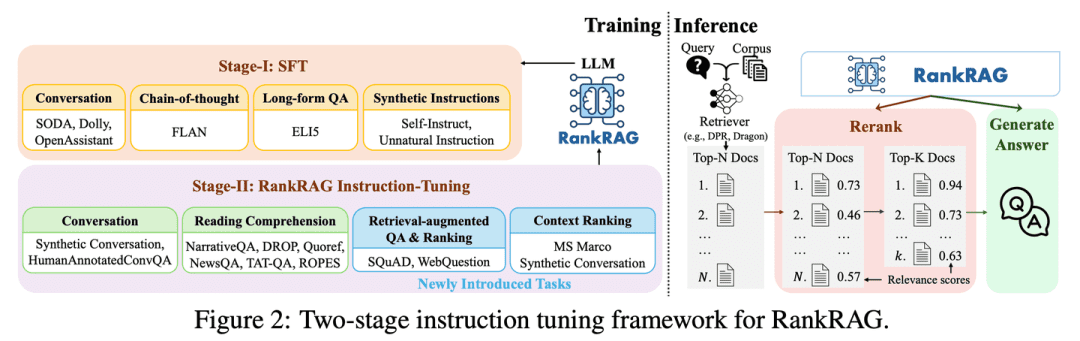

(26) RankRAG [Alleskönner]

AllrounderMit ein wenig Training können Sie sowohl ein "Richter" als auch ein "Wettbewerber" sein. Wie ein begabter Sportler können Sie mit ein wenig Coaching die Profis in mehreren Disziplinen übertreffen und trotzdem alle Ihre Fähigkeiten beherrschen.

- Dissertation: RankRAG: Vereinheitlichung von Kontext-Ranking mit Retrieval-unterstützter Generierung in LLMs

RankRAG stimmt einen einzelnen LLM mit Anweisungen ab, um sowohl kontextbezogenes Ranking als auch Antwortgenerierung durchzuführen. Durch die Hinzufügung einer kleinen Menge von Ranking-Daten zu den Trainingsdaten funktioniert die mit Anweisungen feinabgestimmte LLM überraschend gut und übertrifft sogar bestehende Experten-Ranking-Modelle, einschließlich der gleichen LLM, die speziell auf eine große Menge von Ranking-Daten feinabgestimmt wurde. Dieses Design vereinfacht nicht nur die Komplexität mehrerer Modelle in traditionellen RAG-Systemen, sondern verbessert auch die kontextbezogene Relevanzbeurteilung und die Effizienz der Informationsnutzung durch die gemeinsame Nutzung von Modellparametern.

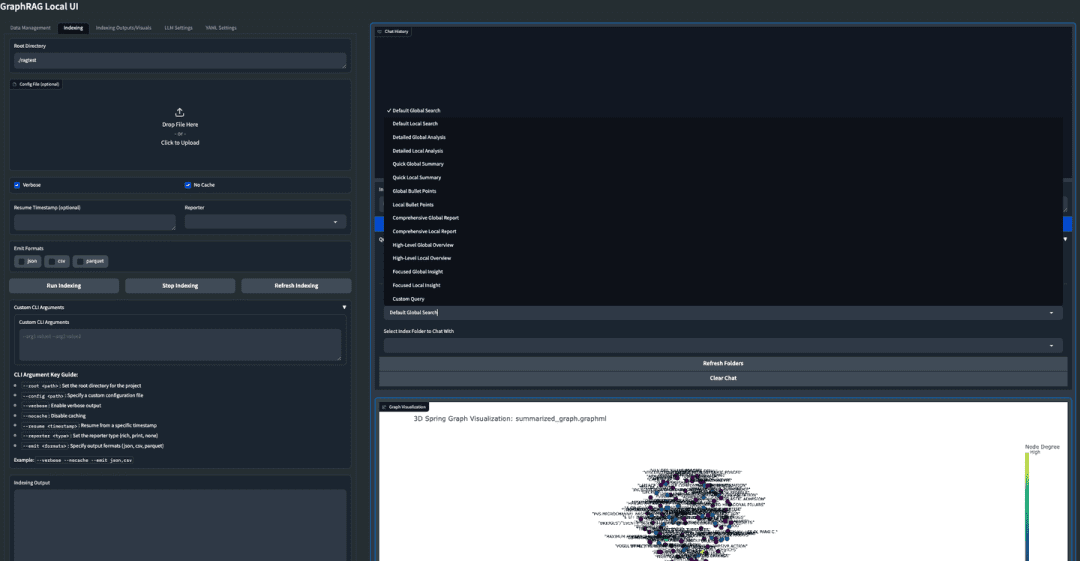

(27) GraphRAG-Lokal-UI [Modifikator]

TunerUmbau eines Sportwagens in ein praktisches Auto für den Nahverkehr, mit einem freundlichen Armaturenbrett, das das Fahren für jedermann erleichtert.

- Projekt: https://github.com/severian42/GraphRAG-Local-UI

GraphRAG-Local-UI ist eine an das lokale Modell angepasste Version von Microsoft-basiertem GraphRAG mit einem reichhaltigen Ökosystem interaktiver Benutzeroberflächen.

(28) ThinkRAG [kleine Sekretärin]

NachwuchssekretärinZusammenfassung eines umfangreichen Wissens in einer Version im Taschenformat, wie ein kleiner Sekretär für unterwegs, der Ihnen hilft, Antworten zu finden, ohne ein großes Gerät zu benötigen.

- Projekt: https://github.com/wzdavid/ThinkRAG

Das ThinkRAG Big Model Retrieval Enhanced Generation System kann leicht auf Laptops eingesetzt werden, um ein intelligentes Quiz der lokalen Wissensdatenbanken zu ermöglichen.

(29) Nano-GraphRAG [leichte Belastung]

wörtlich: mit leichtem Gepäck in die Schlacht ziehen (Idiom); Abb.: mit leichtem Gepäck zur Arbeit gehenWie ein Sportler, der mit leichtem Gepäck unterwegs ist, wurde die sperrige Ausrüstung vereinfacht, aber die Kernkompetenzen wurden beibehalten.

- Projekt: https://github.com/gusye1234/nano-graphrag

Nano-GraphRAG ist ein kleineres, schnelleres und übersichtlicheres GraphRAG unter Beibehaltung der Kernfunktionen.

(30) RAGFlow-GraphRAG [Navigator]

Navigator (in einem Flugzeug oder Boot)Abkürzungen durch das Labyrinth der Fragen und Antworten, indem man zunächst eine Karte zeichnet, auf der alle Wissenspunkte markiert sind, doppelte Wegweiser ausblendet und die Karte gezielt verschlankt, damit der Fragende nicht den langen Umweg nimmt.

- Projekt: https://github.com/infiniflow/ragflow

RAGFlow stützt sich auf die GraphRAG-Implementierung, um die Konstruktion von Wissensgraphen als optionale Option in der Vorverarbeitungsphase von Dokumenten einzuführen, um QFS-Q&A-Szenarien zu bedienen, und führt Verbesserungen wie Entitätsentlastung und Token-Optimierung ein.

(31) Medizinische-Grafik-RAG [Digitaler Arzt]

digitaler ArztWie ein erfahrener Mediziner wird das komplexe medizinische Wissen mit Diagrammen übersichtlich dargestellt, und die Diagnosevorschläge sind nicht aus der Luft gegriffen, sondern werden begründet, so dass sowohl der Arzt als auch der Patient die Gründe für jede Diagnose nachvollziehen können.

- Dissertation: Medical Graph RAG: Auf dem Weg zu einem sicheren medizinischen Großsprachenmodell durch Graph Retrieval-Augmented Generation

- Projekt: https://github.com/SuperMedIntel/Medical-Graph-RAG

MedGraphRAG ist ein Framework, das entwickelt wurde, um die Herausforderungen bei der Anwendung von LLM in der Medizin zu bewältigen. Es verwendet einen graphenbasierten Ansatz zur Verbesserung der diagnostischen Genauigkeit, Transparenz und Integration in klinische Arbeitsabläufe. Das System verbessert die diagnostische Genauigkeit durch die Generierung von Antworten, die von zuverlässigen Quellen gestützt werden, und geht damit auf die Schwierigkeit ein, den Kontext in großen Mengen medizinischer Daten zu erhalten.

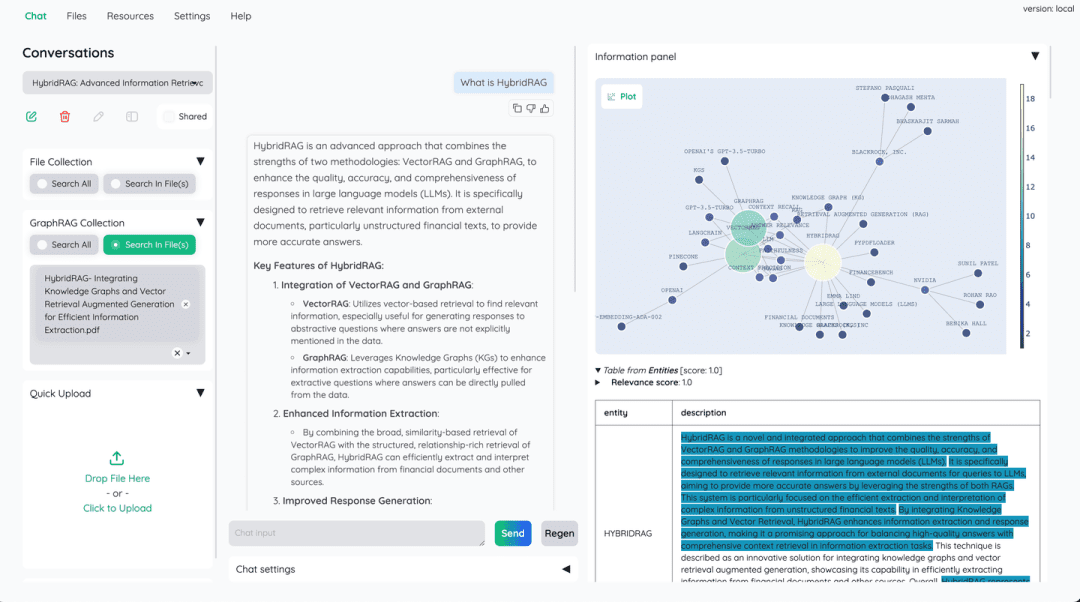

(32) HybridRAG [Kombinierte Formeln der chinesischen Medizin]

Rezept für chinesische MedizinGenau wie in der chinesischen Medizin ist ein einzelnes Medikament nicht so wirksam wie eine Kombination aus mehreren Medikamenten. Vektordatenbanken sind für den schnellen Abruf zuständig, und Wissensgraphen ergänzen die relationale Logik, indem sie die Stärken des jeweils anderen ergänzen.

- Dissertation: HybridRAG: Integration von Wissensgraphen und Vektor Retrieval Augmented Generation zur effizienten Informationsextraktion

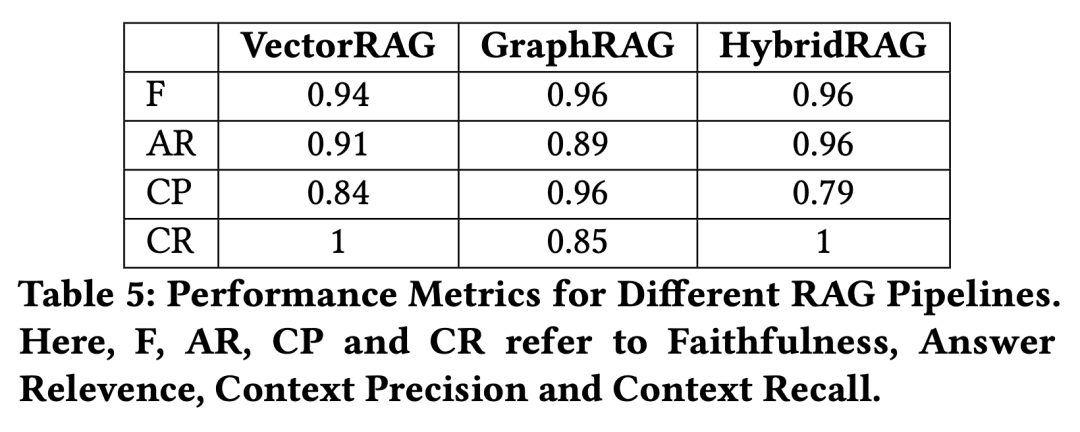

Ein neuer Ansatz auf der Grundlage einer Kombination von Knowledge Graph RAG-Techniken (GraphRAG) und VectorRAG-Techniken, genannt HybridRAG, zur Verbesserung von Frage- und Antwortsystemen für die Extraktion von Informationen aus Finanzdokumenten generiert nachweislich genaue und kontextrelevante Antworten. In der Abruf- und Generierungsphase übertrifft HybridRAG für den Abruf von Kontext aus Vektordatenbanken und Wissensgraphen die traditionellen Verfahren VectorRAG und GraphRAG in Bezug auf die Abrufgenauigkeit und die Generierung von Antworten.

(33) W-RAG [Evolutionäre Suche]

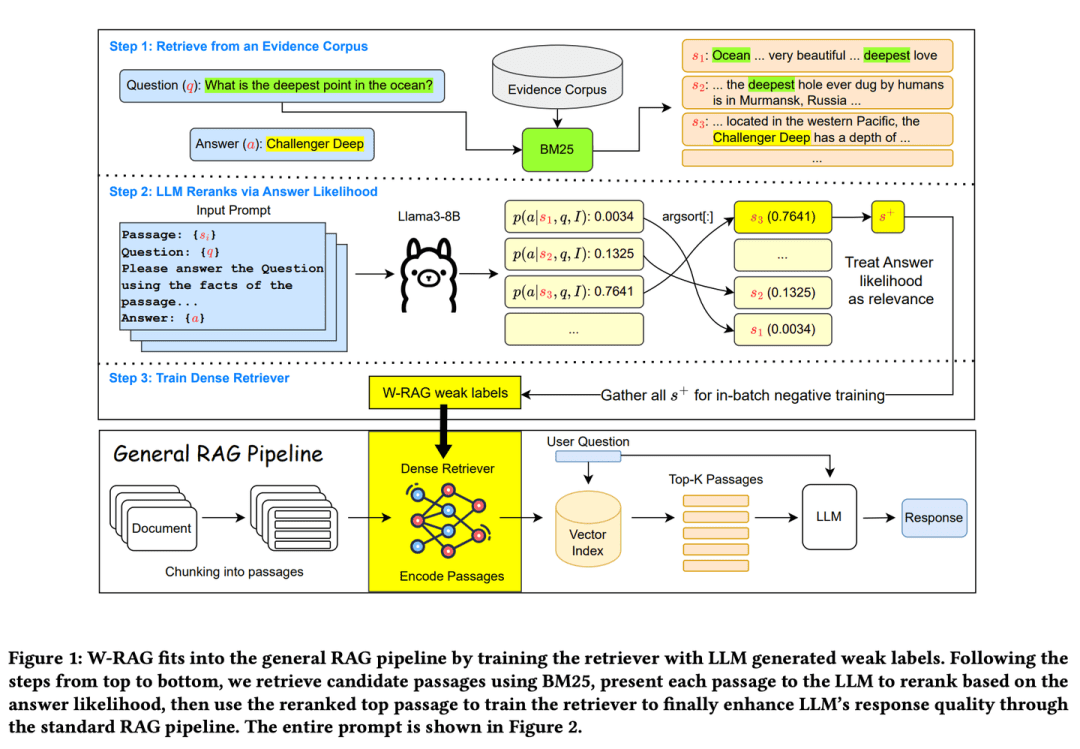

Evolution SucheWie eine gute, sich selbst entwickelnde Suchmaschine lernt sie, was eine gute Antwort ist, indem sie Absätze von Artikeln in einem großen Modell bewertet und so schrittweise ihre Fähigkeit verbessert, wichtige Informationen zu finden.

- Dissertation: W-RAG: Schwach überwachtes Dense Retrieval in RAG zur Beantwortung von Fragen in offenen Domänen

- Projekt: https://github.com/jmnian/weak_label_for_rag

Schwach überwachte dichte Retrieval-Techniken in offenen Quizbereichen nutzen die Ranking-Fähigkeiten großer Sprachmodelle, um schwach markierte Daten für das Training dichter Retriever zu erstellen. Durch die Bewertung der Wahrscheinlichkeit, dass das große Sprachmodell die richtige Antwort auf der Grundlage der Frage und jedes Absatzes generiert, wird die Wahrscheinlichkeit des Bestehens der BM25 Die obersten K abgerufenen Passagen werden neu gereiht. Die am höchsten eingestuften Passagen werden dann als positive Trainingsbeispiele für intensives Retrieval verwendet.

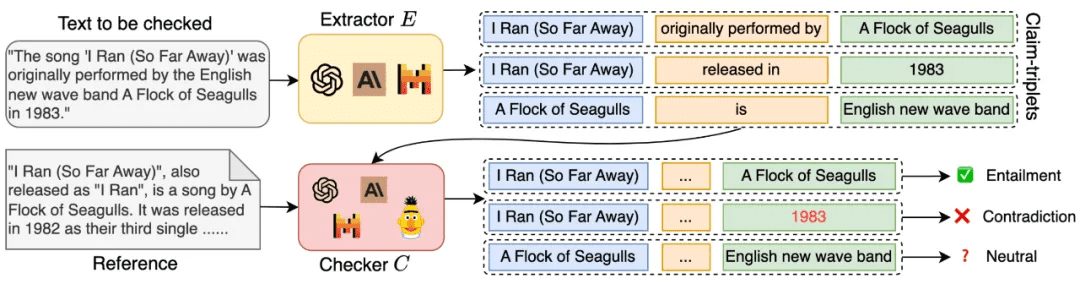

(34) RAGChecker [Qualitätskontrolleur]

QualitätsinspektorDie Antwort ist nicht einfach richtig oder falsch, sondern wird von der Informationssuche bis zur Erstellung der endgültigen Antwort eingehend geprüft, wie ein strenger Prüfer, der einen detaillierten Bewertungsbericht erstellt und darauf hinweist, wo spezifische Verbesserungen erforderlich sind.

- Dissertation: RAGChecker: Ein feinkörniges Framework zur Diagnose von Retrieval-Augmented Generation

- Projekt: https://github.com/amazon-science/RAGChecker

Das Diagnosewerkzeug von RAGChecker liefert feinkörnige, umfassende und zuverlässige Diagnoseberichte über das RAG-System und liefert umsetzbare Hinweise zur weiteren Leistungsverbesserung. Es bewertet nicht nur die Gesamtleistung des Systems, sondern bietet auch eine eingehende Analyse der Leistung der beiden Kernmodule, Abruf und Erzeugung.

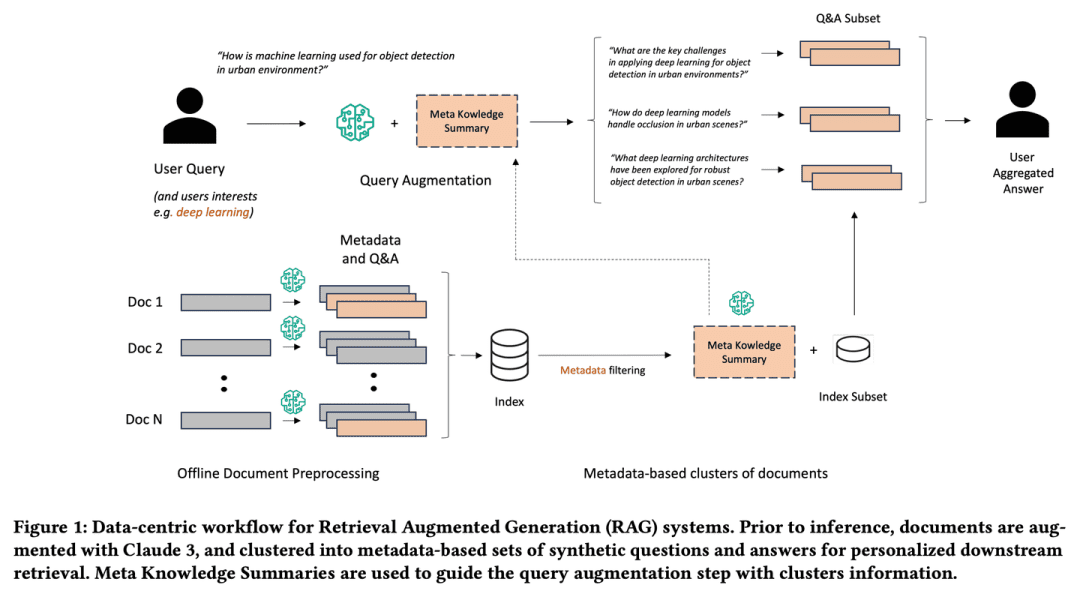

(35) Meta-Knowledge-RAG [Scholar]

akademieWie ein erfahrener Forscher in der Wissenschaft sammelt es nicht nur Informationen, sondern denkt auch aktiv über das Problem nach, kommentiert und fasst jedes Dokument zusammen und sieht sogar mögliche Probleme im Voraus voraus. Es verbindet verwandte Wissenspunkte zu einem Wissensnetzwerk, so dass die Abfrage an Tiefe und Breite gewinnt, genau wie ein Gelehrter, der Ihnen hilft, einen Überblick über die Forschung zu bekommen.

- Dissertation: Metawissen für das Retrieval von erweiterten großen Sprachmodellen

Meta-Knowledge-RAG (MK Summary) führt einen neuartigen datenzentrierten RAG-Workflow ein, der das traditionelle "retrieve-read"-System in ein fortschrittlicheres "prepare-rewrite-retrieve-read "Rahmen umwandelt, um ein besseres Verständnis der Wissensbasis auf der Ebene von Domänenexperten zu erreichen. Unser Ansatz stützt sich auf die Generierung von Metadaten und synthetischen Fragen und Antworten für jedes Dokument sowie auf die Einführung eines neuen Konzepts der Zusammenfassung von Metawissen für das metadatenbasierte Clustering von Dokumenten. Die vorgeschlagenen Innovationen ermöglichen eine personalisierte Verbesserung von Benutzeranfragen und eine tiefgreifende Suche nach Informationen in Wissensdatenbanken.

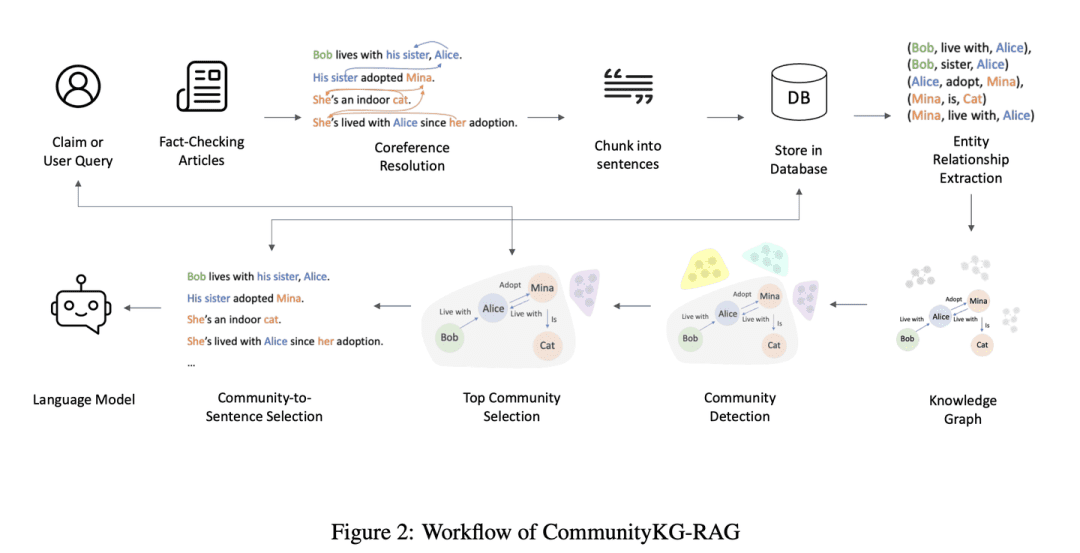

(36) CommunityKG-RAG [Community Exploration]

Erforschung der GemeinschaftWie ein Zauberer, der mit dem Beziehungsgeflecht der Gemeinschaft vertraut ist, ist er in der Lage, Assoziationen zwischen Wissen und Gruppenmerkmalen auszunutzen, um relevante Informationen genau zu finden und ihre Zuverlässigkeit ohne besondere Untersuchungen zu überprüfen.

- Dissertation: CommunityKG-RAG: Nutzung von Community-Strukturen in Wissensgraphen für erweiterte Retrieval-Augmented Generation in Fact- überprüfung

CommunityKG-RAG ist ein neuartiges Framework, das Community-Strukturen im Knowledge Graph mit einem RAG-System kombiniert, um den Fact-Checking-Prozess zu verbessern. CommunityKG-RAG ist in der Lage, sich ohne zusätzliches Training an neue Domänen und Abfragen anzupassen, und es nutzt die Multihop-Natur der Community-Strukturen im Knowledge Graph, um die Genauigkeit und Relevanz der Informationssuche deutlich zu verbessern. Relevanz.

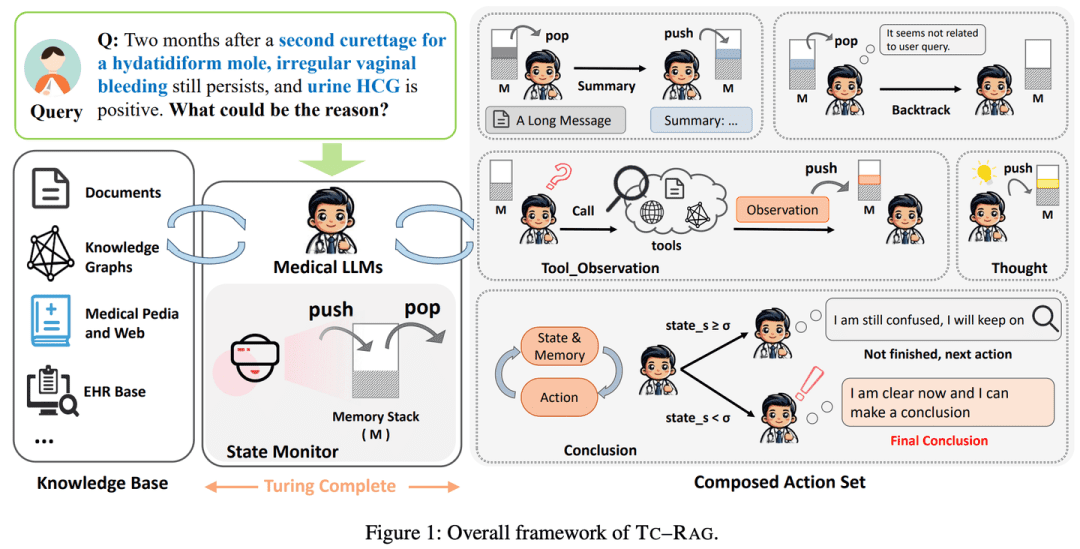

(37) TC-RAG [Speicherhexer]

GedächtniskünstlerEin Gehirn mit automatischer Bereinigungsfunktion auf LLM setzen. So wie wir Probleme lösen, werden wir die wichtigen Schritte auf den Entwurf schreiben und sie durchstreichen, wenn wir fertig sind. Das ist kein Auswendiglernen, sondern es merkt sich, was man sich merken sollte, und räumt das, was man vergessen sollte, rechtzeitig weg, wie ein Schultyrann, der sein Zimmer aufräumen kann.

- Dissertation: TC-RAG: Turing-Complete RAG's Fallstudie über medizinische LLM-Systeme

- Projekt: https://github.com/Artessay/TC-RAG

Durch die Einführung eines Turing-kompletten Systems zur Verwaltung von Zustandsvariablen wird eine effizientere und genauere Wissensabfrage erreicht. Durch die Verwendung eines Speicherstapelsystems mit adaptiven Abruf-, Denk- und Planungsfähigkeiten gewährleistet TC-RAG nicht nur ein kontrolliertes Anhalten des Abrufprozesses, sondern verringert auch die Ansammlung von fehlerhaftem Wissen durch Push- und Pop-Operationen.

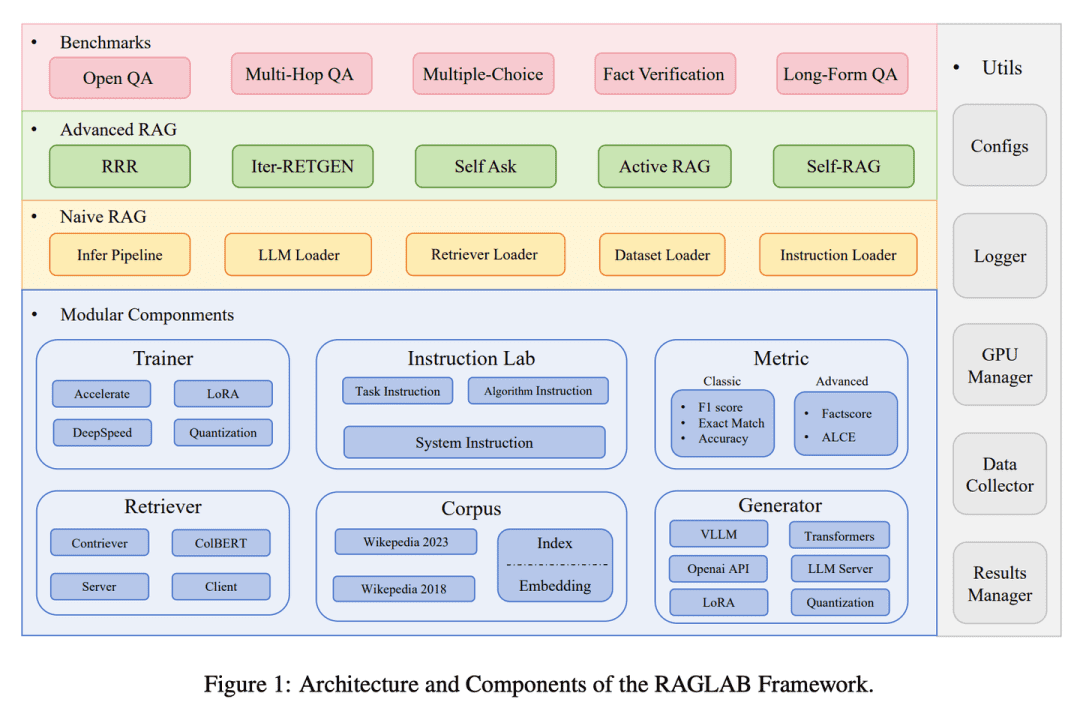

(38) RAGLAB [Arena]

arenaAlgorithmen nach den gleichen Regeln konkurrieren und vergleichen zu lassen, wie bei einem standardisierten Testverfahren in einem wissenschaftlichen Labor, gewährleistet, dass jede neue Methode objektiv und transparent bewertet wird.

- Dissertation: RAGLAB: Ein modulares und forschungsorientiertes Unified Framework für Retrieval-Augmented Generation

- Projekt: https://github.com/fate-ubw/RAGLab

Es besteht ein zunehmender Mangel an umfassenden und fairen Vergleichen zwischen neuartigen RAG-Algorithmen, und die hochgradige Abstraktion von Open-Source-Tools führt zu einem Mangel an Transparenz und schränkt die Möglichkeit ein, neue Algorithmen und Bewertungsmetriken zu entwickeln.RAGLAB ist eine modulare, forschungsorientierte Open-Source-Bibliothek, die die 6 Algorithmen reproduziert und ein umfassendes Forschungsökosystem aufbaut. Mit RAGLAB vergleichen wir die 6 Algorithmen auf faire Weise anhand von 10 Benchmarks und helfen Forschern, Algorithmen effizient zu bewerten und zu erneuern.

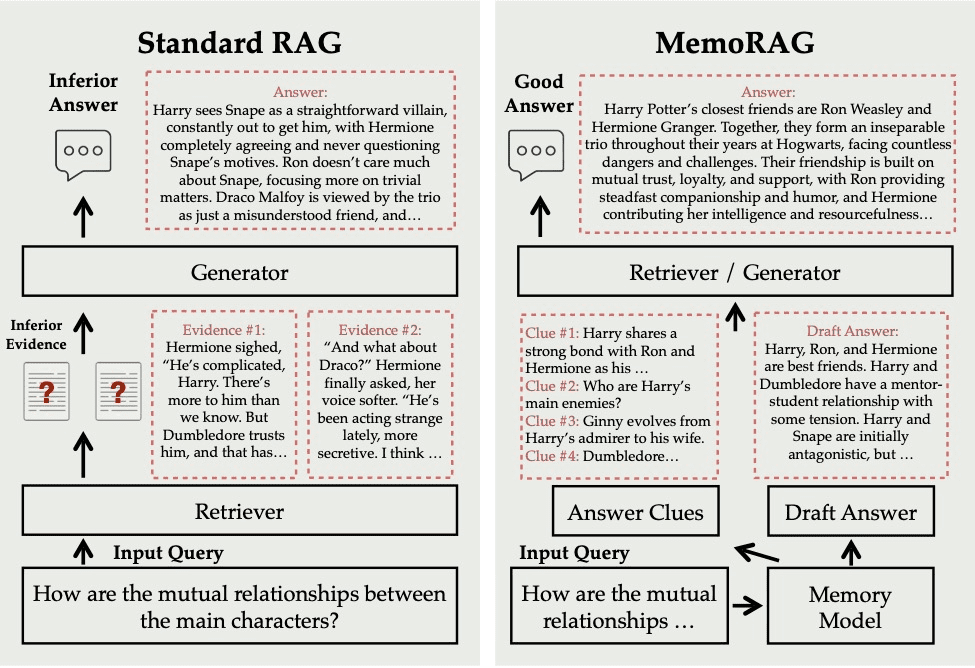

(39) MemoRAG.

ein sehr gutes Erinnerungsvermögen habenEs schlägt nicht nur bei Bedarf Informationen nach, sondern hat die gesamte Wissensbasis tiefgreifend verstanden und im Gedächtnis gespeichert. Wenn Sie eine Frage stellen, zieht es schnell relevante Erinnerungen aus diesem "Superhirn" und gibt eine genaue und aufschlussreiche Antwort, genau wie ein sachkundiger Experte.

- Projekt: https://github.com/qhjqhj00/MemoRAG

MemoRAG ist ein innovatives Retrieval Augmented Generation (RAG)-Framework, das auf einem effizienten, ultralangen Speichermodell aufbaut. Im Gegensatz zu Standard-RAGs, die sich in erster Linie mit Abfragen mit explizitem Informationsbedarf befassen, nutzt MemoRAG sein Speichermodell, um ein globales Verständnis der gesamten Datenbank zu erreichen. Indem MemoRAG abfragespezifische Hinweise aus dem Gedächtnis abruft, verbessert es den Abruf von Beweisen, was zu einer genaueren und kontextgerechten Antwortgenerierung führt.

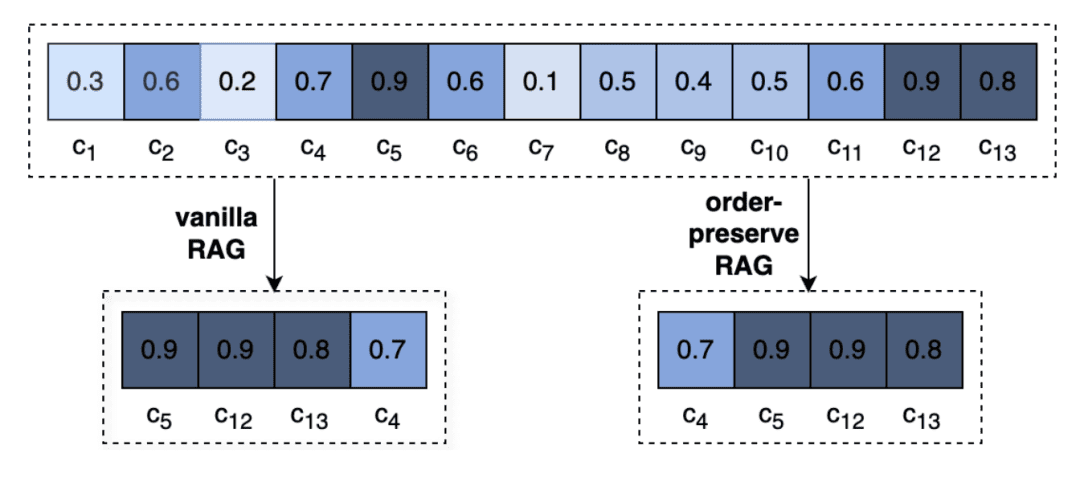

(40) OP-RAG [Aufmerksamkeitsmanagement]

AufmerksamkeitsmanagementEs ist wie bei der Lektüre eines besonders dicken Buches, man kann sich unmöglich an jedes Detail erinnern, aber die Leute, die wissen, wie man die Schlüsselkapitel markiert, sind die Meister. Es ist kein zielloses Lesen, sondern wie ein erfahrener Leser, der beim Lesen die wichtigsten Punkte notiert und bei Bedarf direkt auf die markierte Seite blättert.

- Dissertation: Zur Verteidigung der RAG in der Ära der Langkontextsprachmodelle

Extrem lange Kontexte in LLMs führen zu einer verminderten Aufmerksamkeit für relevante Informationen und einer potentiellen Verschlechterung der Antwortqualität. Wir überdenken die RAG bei der Generierung von Antworten in langen Kontexten und schlagen einen Mechanismus zur Verbesserung des Abrufs unter Wahrung der Reihenfolge (OP-RAG) vor, der die Leistung der RAG bei Frage- und Antwortanwendungen in langen Kontexten deutlich verbessert.

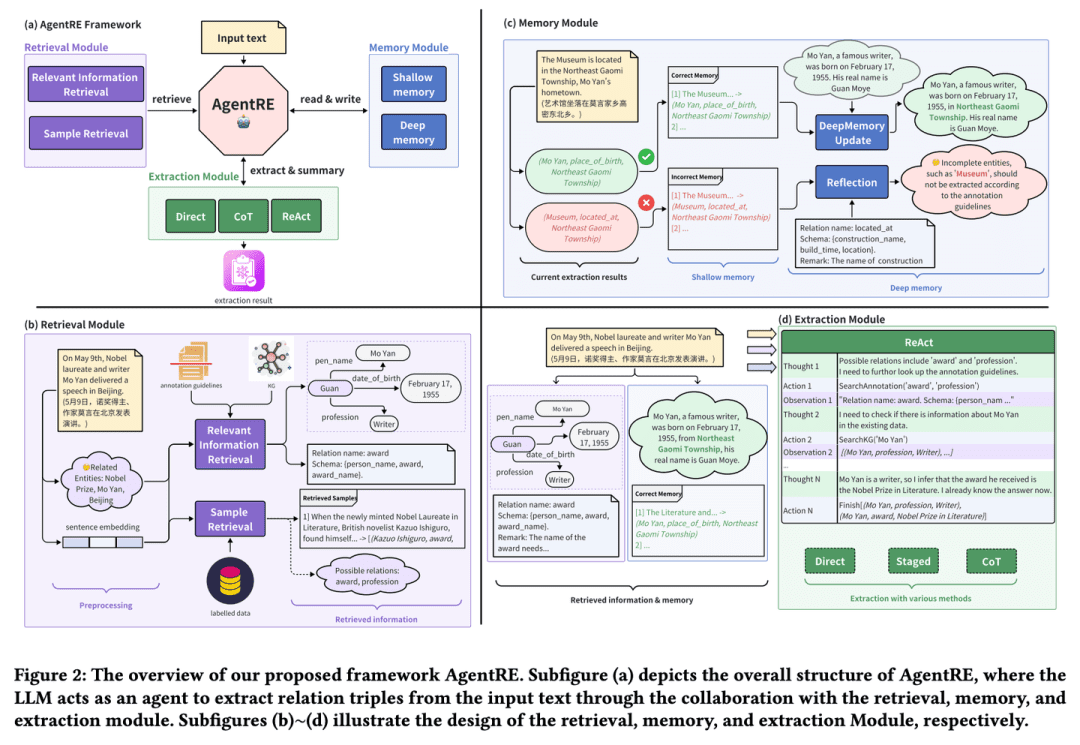

(41) AgentRE [Intelligente Extraktion]

Intelligente ExtraktionWie ein Soziologe, der Beziehungen gut beobachten kann, merkt er sich nicht nur die wichtigsten Informationen, sondern ergreift auch die Initiative, sie zu überprüfen und gründlich zu überdenken, um das komplexe Beziehungsgeflecht genau zu verstehen. Selbst angesichts komplexer Beziehungen sind sie in der Lage, diese aus verschiedenen Blickwinkeln zu analysieren, um ihnen einen Sinn zu geben und zu vermeiden, dass sie sich in sie hineinlesen.

- Dissertation: AgentRE: Ein agentenbasiertes Framework zur Navigation in komplexen Informationslandschaften bei der Relationsextraktion

- Projekt: https://github.com/Lightblues/AgentRE

Durch die Integration der Speicher-, Abruf- und Reflexionsfähigkeiten großer Sprachmodelle bewältigt AgentRE effektiv die Herausforderungen verschiedener Beziehungstypen bei der Extraktion komplexer Szenenbeziehungen und mehrdeutiger Beziehungen zwischen Entitäten in einem einzigen Satz.AgentRE besteht aus drei Hauptmodulen, die es Agenten ermöglichen, Informationen effizient zu erfassen und zu verarbeiten und die RE-Leistung erheblich zu verbessern.

(42) iText2KG [Architekt]

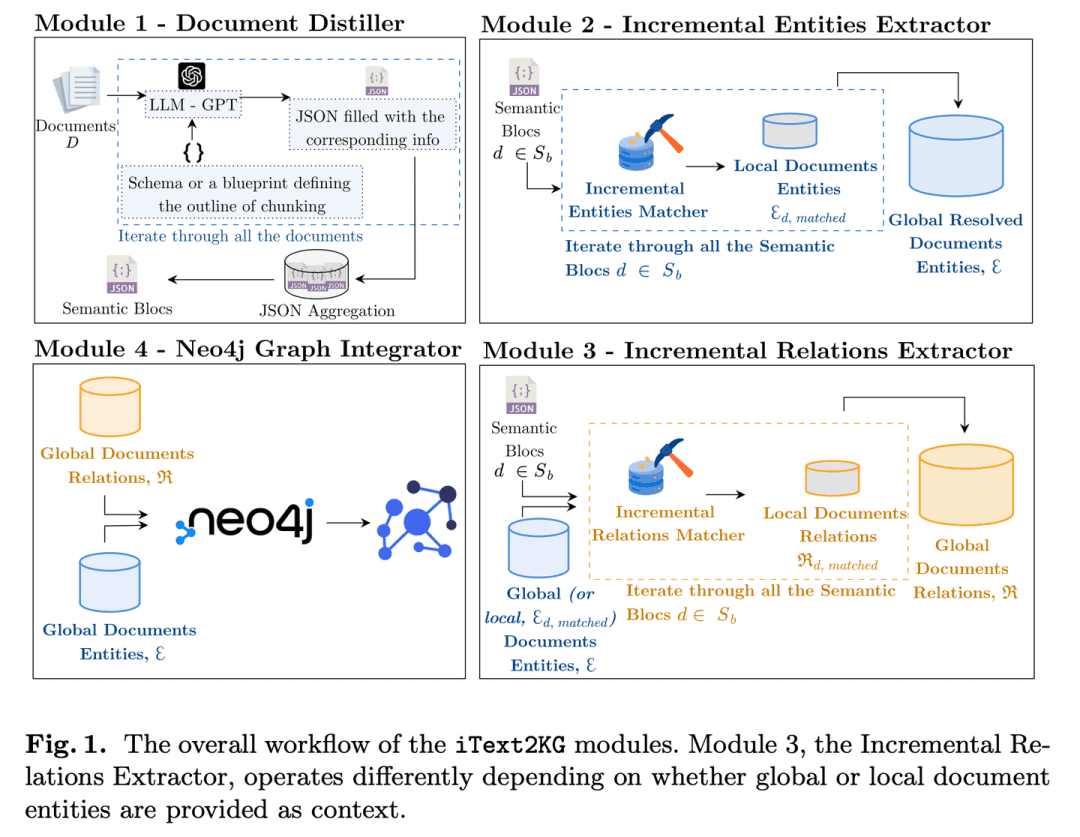

ArchitektenWie ein organisierter Ingenieur verwandelt es fragmentierte Dokumente schrittweise in ein systematisches Wissensnetz, indem es Informationen verfeinert, extrahiert und integriert. Es erfordert nicht die Vorbereitung detaillierter architektonischer Zeichnungen im Voraus und kann bei Bedarf flexibel erweitert und verbessert werden.

- Dissertation: iText2KG: Inkrementelle Konstruktion von Wissensgraphen unter Verwendung großer Sprachmodelle

- Projekt: https://github.com/AuvaLab/itext2kg

iText2KG (Incremental Knowledge Graph Construction) verwendet Large Language Models (LLMs) zur Erstellung von Wissensgraphen aus Rohdokumenten und ermöglicht die inkrementelle Erstellung von Wissensgraphen mit Hilfe von vier Modulen (Document Refiner, Incremental Entity Extractor, Incremental Relationship Extractor und Graph Integrator), ohne dass eine vorherige Definition von Ontologien oder umfangreiches überwachtes Training erforderlich ist.

(43) GraphInsight [grafische Auswertung]

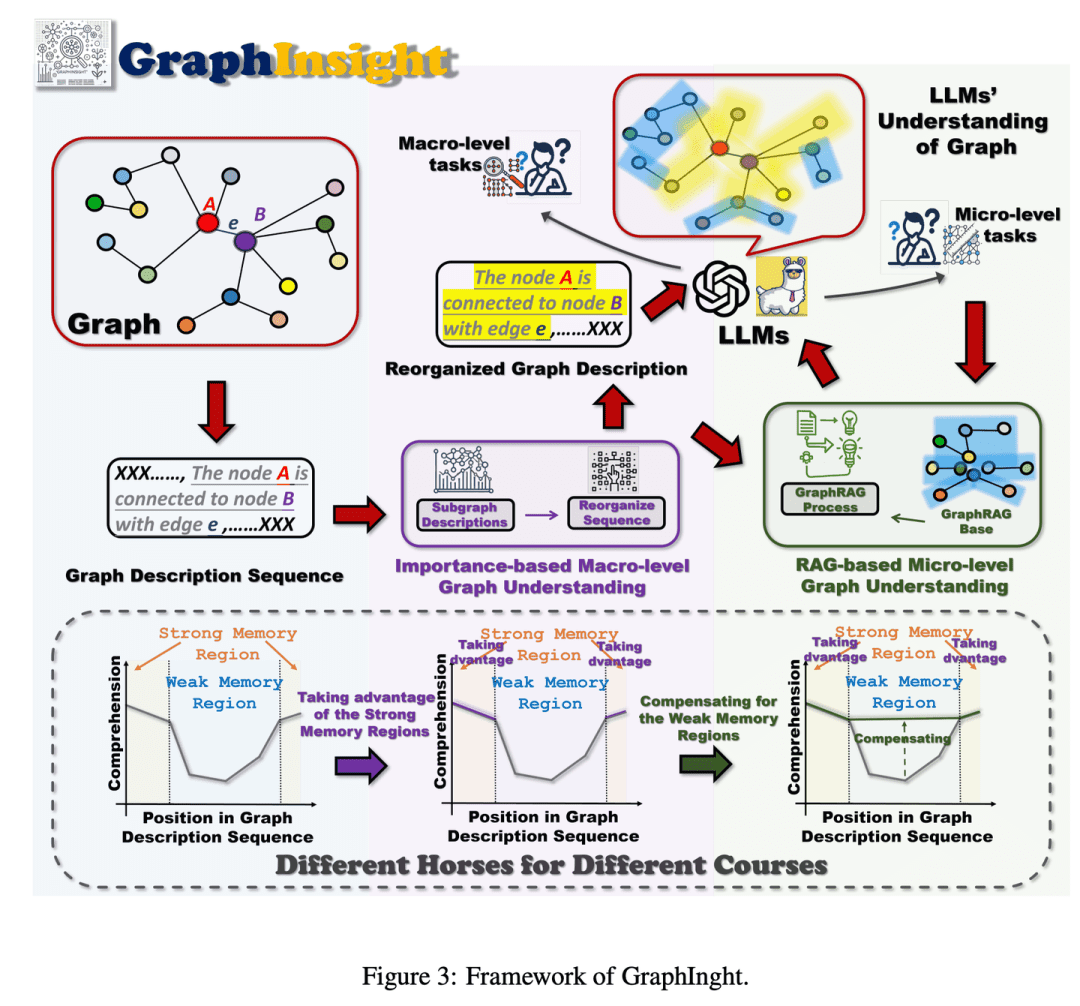

AtlasinterpretationWie ein Experte in der Analyse von Infografiken, der weiß, wie man wichtige Informationen an den prominentesten Stellen platziert, während er Referenzen zu Rate zieht, um bei Bedarf Details zu ergänzen, und der Schritt für Schritt durch komplexe Diagramme argumentiert, so dass die KI das große Ganze versteht, ohne die Details zu übersehen.

- Dissertation: GraphInsight: Entschlüsselung von Erkenntnissen in großen Sprachmodellen für das Verständnis von Graphenstrukturen

GraphInsight ist ein neuer Rahmen, der darauf abzielt, das Verständnis von LLMs für Grapheninformationen auf Makro- und Mikroebene zu verbessern. GraphInsight basiert auf zwei Schlüsselstrategien: 1) Platzierung von wichtigen Grapheninformationen an Stellen, an denen LLMs über eine starke Gedächtnisleistung verfügen, und 2) Einführung von leichtgewichtigen externen Wissensbasen für Regionen mit schwacher Gedächtnisleistung, die auf der Idee der Retrieval Augmented Generation (RAG) basieren. Darüber hinaus erforscht GraphInsight die Integration dieser beiden Strategien in den LLM-Agentenprozess für zusammengesetzte Graphenaufgaben, die eine mehrstufige Argumentation erfordern.

(44) LA-RAG [Dialektpass]

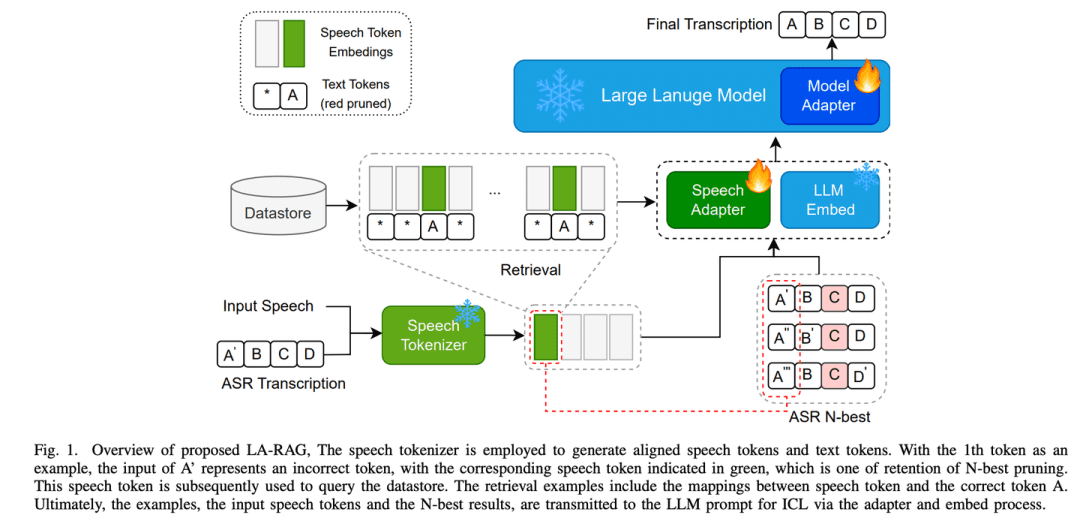

MundartbuchWie ein Linguist, der sich mit den Dialekten verschiedener Orte auskennt, kann die KI nicht nur das Standard-Mandarin genau erkennen, sondern durch sorgfältige Sprachanalyse und kontextuelles Verständnis auch Akzente mit lokalen Merkmalen verstehen, so dass die KI ohne Barrieren mit Menschen aus verschiedenen Regionen kommunizieren kann.

- Dissertation: LA-RAG:Verbesserung der LLM-basierten ASR-Genauigkeit durch Retrieval-erweiterte Generierung

LA-RAG, ein neuartiges Retrieval Augmented Generation (RAG)-Paradigma für LLM-basierte ASR. LA-RAG nutzt feinkörnige Sprachdatenspeicherung auf Token-Ebene und Mechanismen zum Abruf von Sprache zu Sprache, um die ASR-Genauigkeit durch LLM Contextual Learning (ICL)-Funktionalität zu verbessern.

(45) SFR-RAG [verfeinerte Suche]

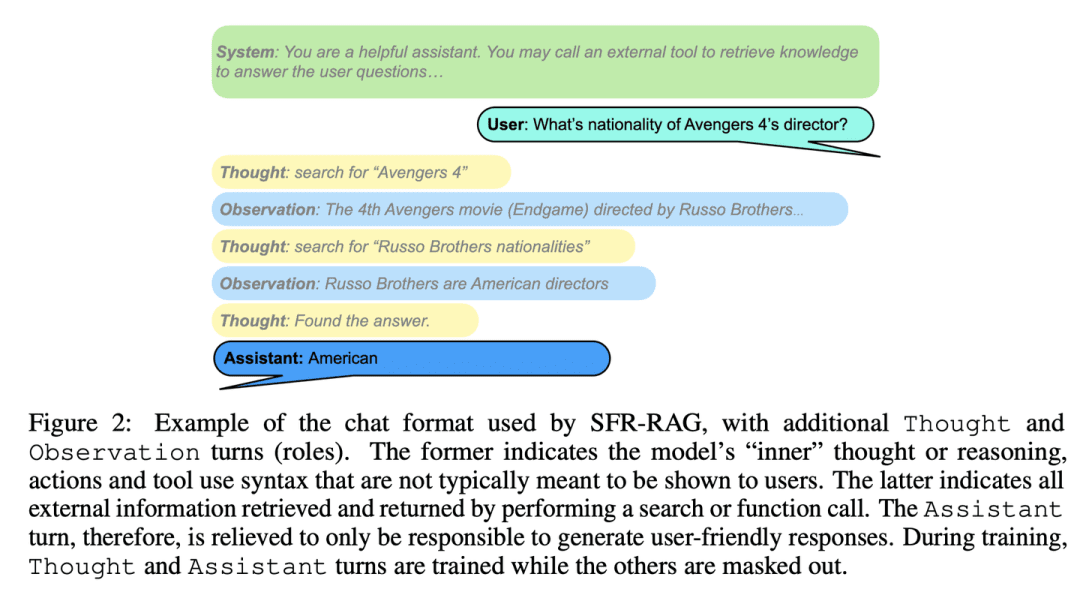

Optimierte SucheWie ein raffinierter Referenzberater, klein in der Größe, aber präzise in der Funktion, versteht er die Bedürfnisse und weiß, wie man externe Hilfe einholt, und gewährleistet, dass die Antworten sowohl genau als auch effizient sind.

- Dissertation: SFR-RAG: Auf dem Weg zu kontextgetreuen LLMs

SFR-RAG ist ein kleines Sprachmodell, das mit Anweisungen abgestimmt ist, die sich auf kontextbasierte Generierung und die Minimierung von Täuschungen konzentrieren. Das SFR-RAG-Modell konzentriert sich auf die Verringerung der Anzahl der Argumente bei gleichzeitiger Beibehaltung einer hohen Leistung und umfasst Funktionsaufrufe, die eine dynamische Interaktion mit externen Tools ermöglichen, um hochwertige Kontextinformationen abzurufen.

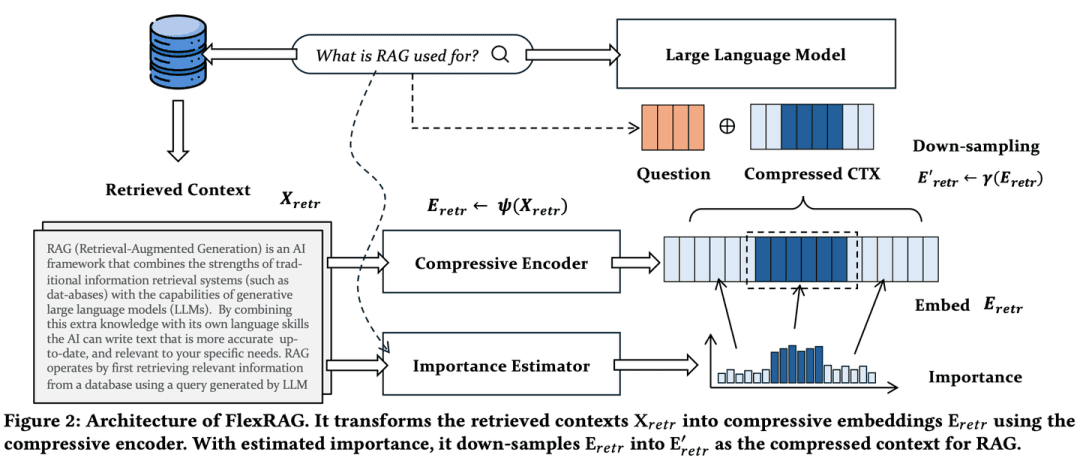

(46) FlexRAG [Kompressionsexperte]

Spezialist für KompressionDas Komprimierungsverhältnis kann je nach Bedarf flexibel angepasst werden, so dass die wichtigsten Informationen nicht verloren gehen und Speicher- und Verarbeitungskosten gespart werden können. Es ist so, als würde man ein dickes Buch in eine knappe Leseprobe umwandeln.

- Dissertation: Leichter und besser: Wege zur flexiblen Kontextanpassung für Retrieval Augmented Generation

Der von FlexRAG ermittelte Kontext wird in kompakte Einbettungen komprimiert, bevor er von LLMs kodiert wird. Gleichzeitig werden diese komprimierten Einbettungen optimiert, um die Leistung der nachgelagerten RAGs zu verbessern. Ein Hauptmerkmal von FlexRAG ist seine Flexibilität, verschiedene Kompressionsverhältnisse effizient zu unterstützen und wichtige Kontexte selektiv zu erhalten. Dank dieser technischen Konstruktionen erreicht FlexRAG eine überragende Generierungsqualität bei gleichzeitiger deutlicher Reduzierung der Betriebskosten. Umfassende Experimente mit verschiedenen Q&A-Datensätzen validieren unseren Ansatz als kosteneffiziente und flexible Lösung für RAG-Systeme.

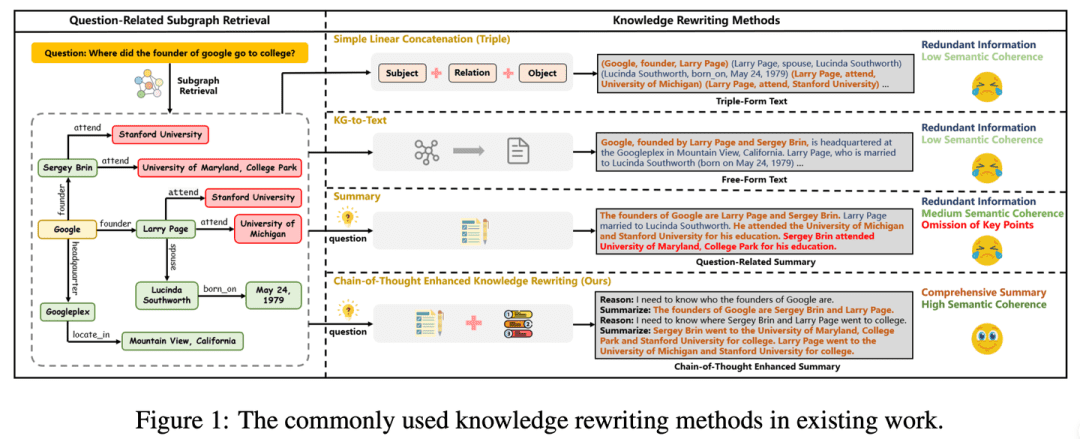

(47) CoTKR [Atlasübersetzung]

atlasübersetzungWie ein geduldiger Lehrer versteht er oder sie den Kontext des Wissens und erklärt es dann Schritt für Schritt, indem er es nicht einfach wiederholt, sondern in der Tiefe weitergibt. Gleichzeitig können Sie durch das Einholen von Feedback von den Schülern Ihre eigene Art des Erklärens verbessern, so dass das Wissen klarer und effektiver vermittelt werden kann.

- Dissertation: CoTKR: Chain-of-Thought Enhanced Knowledge Rewriting für die Beantwortung komplexer Wissensgraphenfragen

- Projekt: https://github.com/wuyike2000/CoTKR

Die CoTKR-Methode (Chain-of-Thought Enhanced Knowledge Rewriting) wechselt zwischen der Generierung von Inferenzpfaden und dem entsprechenden Wissen und überwindet so die Beschränkung des einstufigen Wissensumschreibens. Um den Präferenzunterschied zwischen dem Wissensumschreiber und dem QA-Modell zu überbrücken, schlagen wir außerdem eine Trainingsstrategie vor, die die Präferenzen aus dem Q&A-Feedback abgleicht, um den Wissensumschreiber weiter zu optimieren, indem das Feedback des QA-Modells genutzt wird.

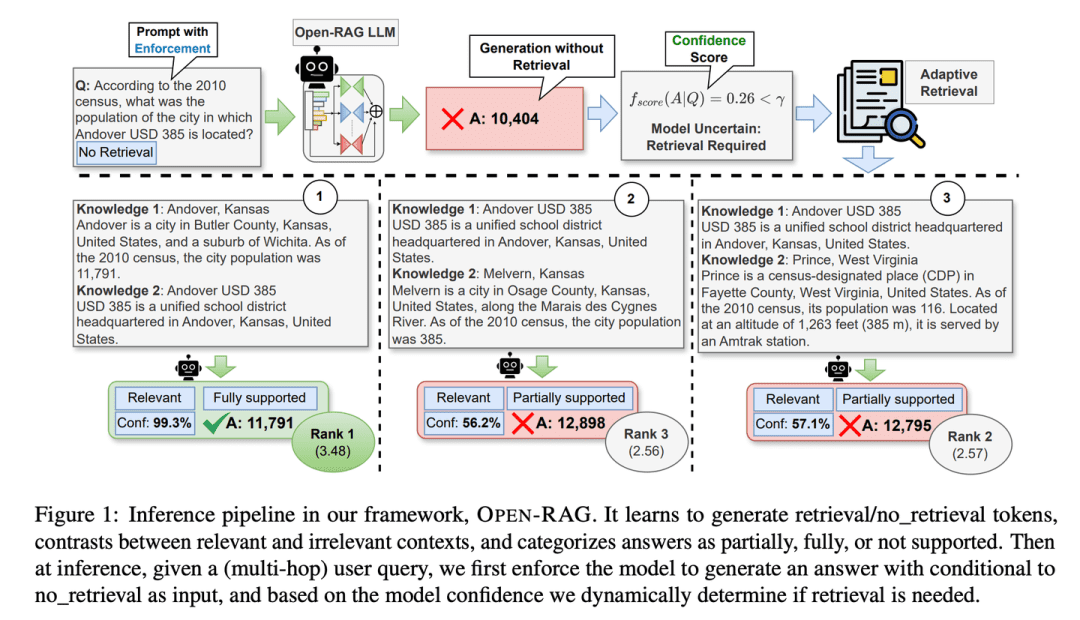

(48) Open-RAG [Denkfabrik]

RepositoryAufteilung des riesigen Sprachmodells in Expertengruppen, die sowohl unabhängig denken als auch zusammenarbeiten können, und die besonders gut zwischen wahren und falschen Informationen unterscheiden können und wissen, ob sie in kritischen Momenten Informationen nachschlagen müssen oder nicht, wie ein erfahrener Think Tank.

- Dissertation: Open-RAG: Erweitertes Retrieval-Augmented Reasoning mit Open-Source Large Language Models

- Projekt: https://github.com/ShayekhBinIslam/openrag

Open-RAG verbessert das Reasoning in RAG durch Open-Sourcing großer Sprachmodelle, indem es beliebig dichte große Sprachmodelle in parametereffiziente spärliche Mixed-Mixture-of-Experts (MoE)-Modelle umwandelt, die in der Lage sind, komplexe Reasoning-Aufgaben zu bewältigen, einschließlich Single-Hop- und Multi-Hop-Anfragen.OPEN-RAG trainiert die Modelle auf einzigartige Weise, um mit schwierigen interferierenden Begriffen umzugehen, die zwar relevant zu sein scheinen, aber irreführend sind.

(49) TableRAG [Excel-Experte]

Excel-SpezialistSie können nicht nur Tabellendaten anzeigen, sondern wissen auch, wie man Daten in Kopf- und Zelldimensionen versteht und abruft und wie man eine Pivot-Tabelle verwendet, um die benötigten Schlüsselinformationen schnell zu finden und zu extrahieren.

- Paper: TableRAG: Millionen-Token-Tabellenverstehen mit Sprachmodellen

TableRAG hat ein generatives Framework mit verbessertem Retrieval speziell für das Verstehen von Tabellen entwickelt, das Schema- und Zellenretrieval durch Abfrageerweiterung kombiniert, um Schlüsseldaten zu lokalisieren, bevor Informationen an das Sprachmodell weitergegeben werden, was eine effizientere Datenkodierung und ein präziseres Retrieval ermöglicht, die Länge von Hinweisen drastisch verkürzt und Informationsverluste reduziert.

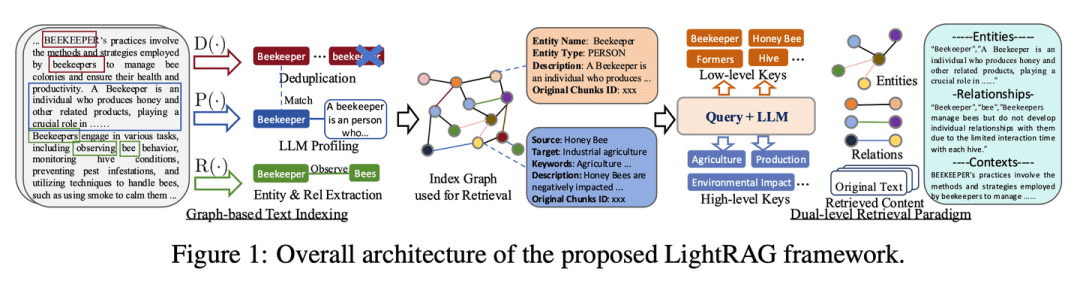

(50) LightRAG [Spider-Man]

SpidermanFlinkes Navigieren durch das Netz des Wissens, indem man sowohl die Fäden zwischen den Wissenspunkten auffängt als auch den Fäden durch das Netz folgt. Wie ein hellsichtiger Bibliothekar wissen Sie nicht nur, wo jedes Buch steht, sondern auch, welche Bücher Sie zusammen lesen sollten.

- Diplomarbeit: LightRAG: Einfache und schnelle Retrieval-Augmented Generation

- Projekt: https://github.com/HKUDS/LightRAG

Das Framework integriert Graphenstrukturen in den Textindizierungs- und -abrufprozess. Dieser innovative Rahmen verwendet ein zweistufiges Abfragesystem, das die umfassende Informationsabfrage sowohl auf niedriger als auch auf hoher Ebene der Wissensfindung verbessert. Darüber hinaus erleichtert die Kombination von Graphenstrukturen mit Vektordarstellungen die effiziente Abfrage relevanter Entitäten und ihrer Beziehungen, wodurch die Antwortzeiten erheblich verbessert werden, während die kontextuelle Relevanz erhalten bleibt. Diese Fähigkeit wird durch einen inkrementellen Aktualisierungsalgorithmus weiter verbessert, der die rechtzeitige Integration neuer Daten gewährleistet, so dass das System auch in einer sich schnell verändernden Datenumgebung effektiv und reaktionsschnell bleibt.

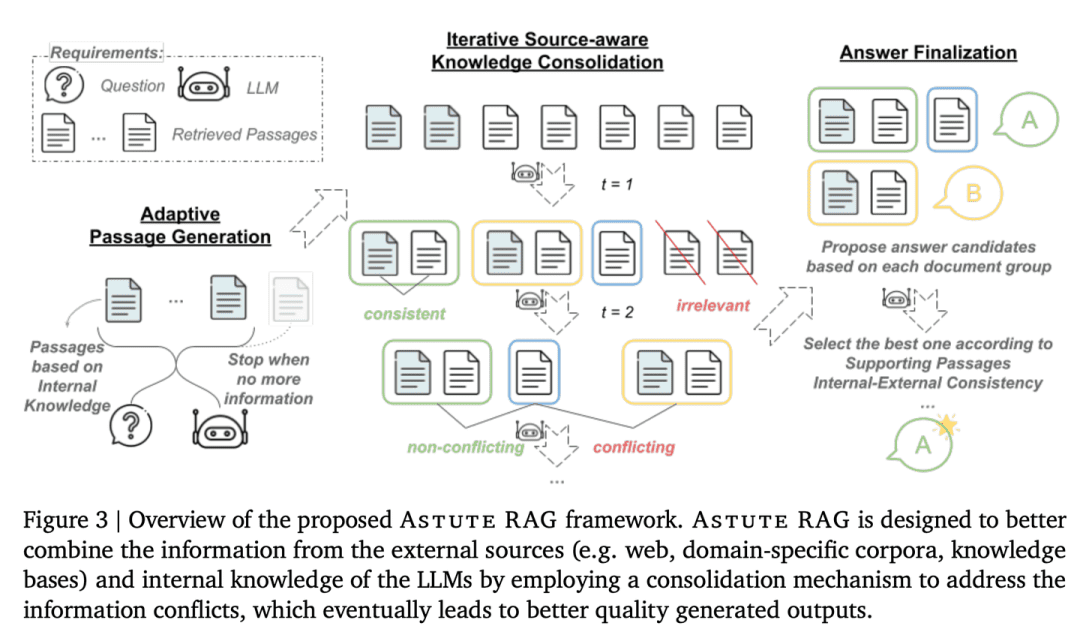

(51) AstuteRAG [Weiser Richter]

Vernünftige RichterinWachsamkeit gegenüber externen Informationen, kein Vertrauen in die Ergebnisse von Recherchen, Nutzung des eigenen Wissens, Prüfung der Echtheit von Informationen und Abwägung der Beweise mehrerer Parteien, um zu einer Schlussfolgerung zu gelangen, wie ein hoher Richter.

- Dissertation: Astute RAG: Überwindung unvollkommener Retrieval Augmentation und Wissenskonflikte für große Sprachmodelle

Die Robustheit und Vertrauenswürdigkeit des Systems wird dadurch verbessert, dass es adaptiv Informationen aus dem internen Wissen der LLMs extrahiert, diese mit externen Suchergebnissen kombiniert und die Antwort auf der Grundlage der Verlässlichkeit der Informationen festlegt.

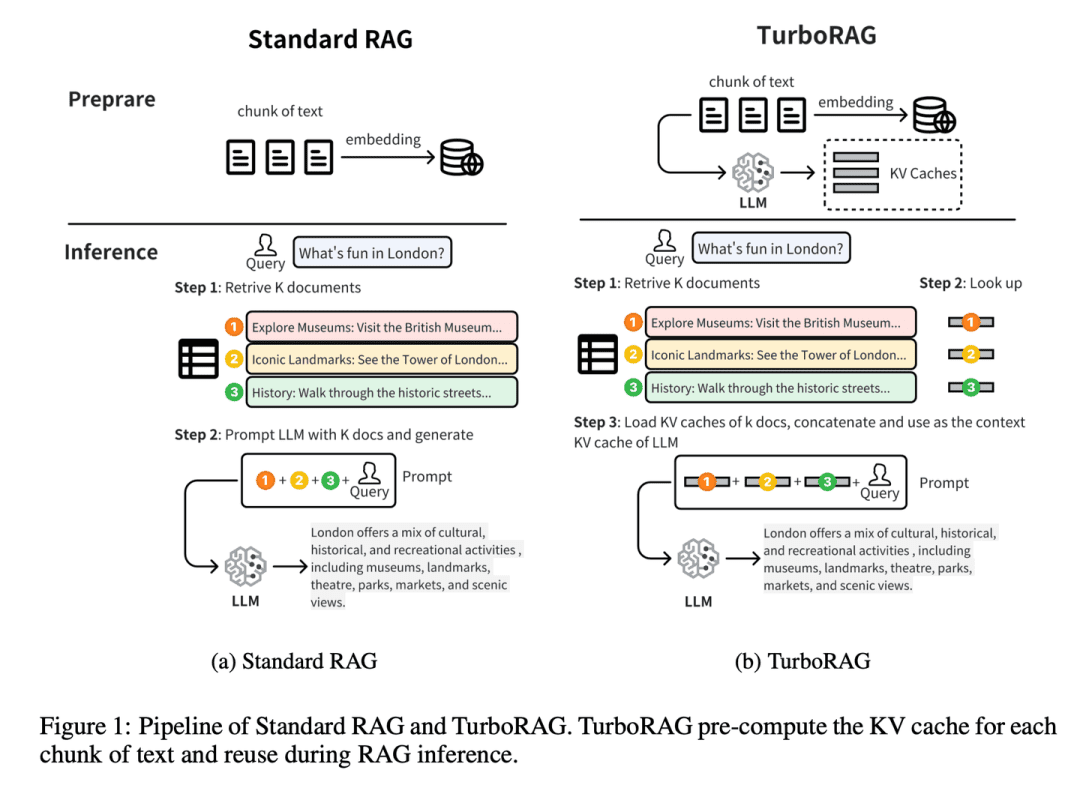

(52) TurboRAG [Kurzzeichen Master]

StenografenmeisterMachen Sie Ihre Hausaufgaben im Voraus und schreiben Sie alle Antworten in ein kleines Notizbuch. Wie ein Vor-Prüfung Razzia Schule Tyrann, nicht die klinische Klammer, aber die gemeinsamen Fragen im Voraus in das falsche Buch. Wenn Sie direkt ausfallen müssen, sparen Sie sich jedes Mal, wenn Sie einmal vor Ort ableiten müssen.

- Dissertation: TurboRAG: Beschleunigung der Retrieval-Augmented Generation mit vorberechneten KV-Caches für Chunked Text

- Projekt: https://github.com/MooreThreads/TurboRAG

TurboRAG optimiert das Schlussfolgerungsparadigma des RAG-Systems, indem es die KV-Caches von Dokumenten offline vorberechnet und speichert. Im Gegensatz zu traditionellen Ansätzen berechnet TurboRAG diese KV-Zwischenspeicher nicht mehr bei jeder Schlussfolgerung, sondern ruft stattdessen die vorberechneten Zwischenspeicher für eine effiziente Vorbelegung ab, wodurch die Notwendigkeit einer wiederholten Online-Berechnung entfällt. Dieser Ansatz reduziert den Rechenaufwand erheblich und beschleunigt die Reaktionszeit bei gleichbleibender Genauigkeit.

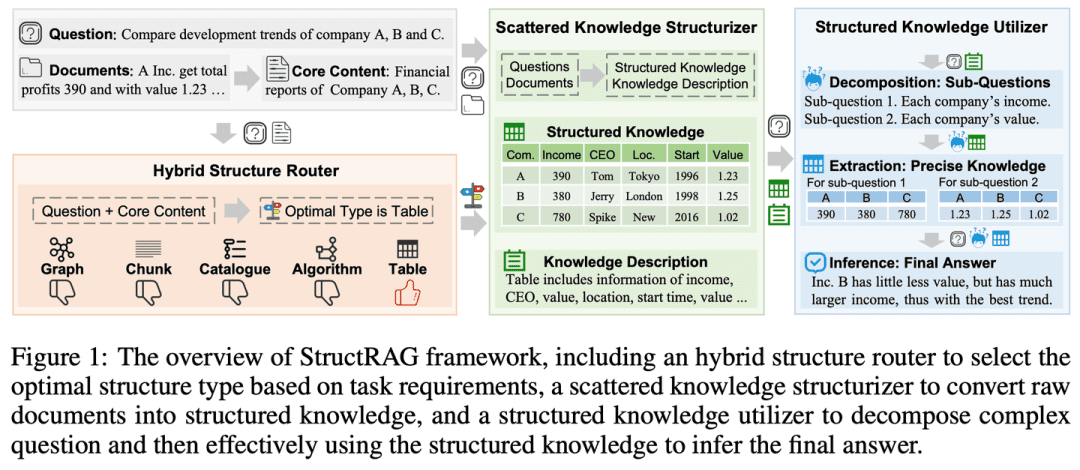

(53) StructRAG [Organisator]

VeranstalterOrdnen Sie das Informationswirrwarr in Kategorien wie einen geordneten Kleiderschrank. Wie ein Lehrer, der den menschlichen Verstand nachahmt, sollten Sie statt des Auswendiglernens zunächst eine Mind Map erstellen.

- Dissertation: StructRAG: Verstärkung der wissensintensiven Schlussfolgerung von LLMs durch inferenzzeitliche hybride Informationsstrukturierung

- Projekt: https://github.com/Li-Z-Q/StructRAG

Inspiriert von der kognitiven Theorie, dass Menschen Rohinformationen in strukturiertes Wissen umwandeln, wenn sie wissensintensive Schlussfolgerungen ziehen, führt der Rahmen einen hybriden Mechanismus zur Informationsstrukturierung ein, der strukturiertes Wissen in dem am besten geeigneten Format entsprechend den spezifischen Anforderungen der jeweiligen Aufgabe konstruiert und nutzt. Indem er menschenähnliche Denkprozesse nachahmt, verbessert er die LLM-Leistung bei wissensintensiven Argumentationsaufgaben.

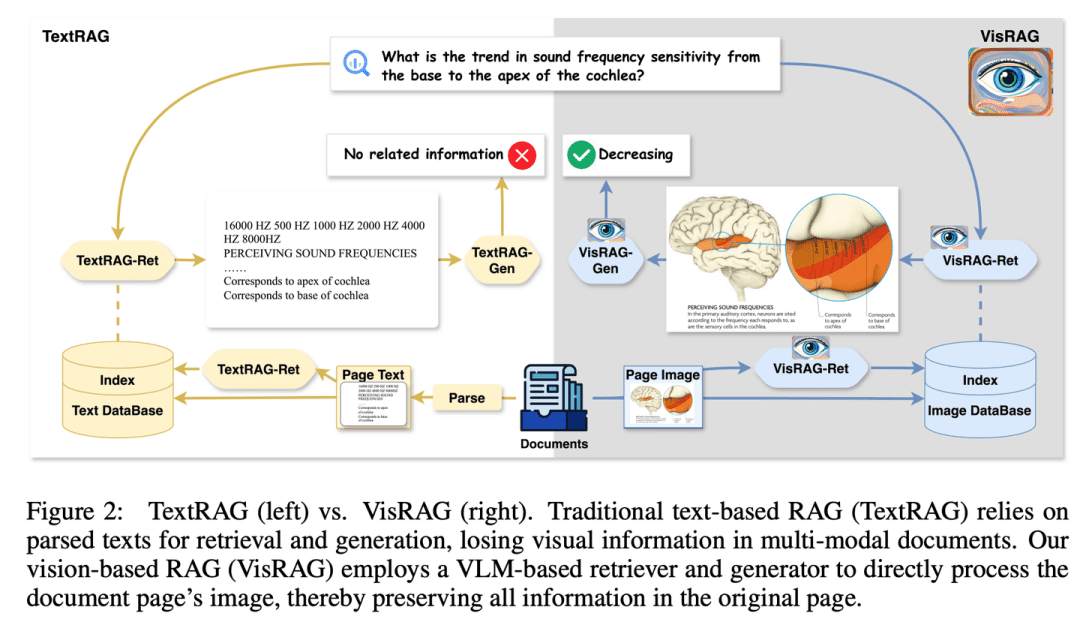

(54) VisRAG [Augen des Feuers]

erkennende AugenIch habe endlich begriffen, dass Worte nur eine besondere Form des Ausdrucks von Bildern sind. Wie ein Leser, der seine Augen geöffnet hat, besteht er nicht mehr darauf, Wort für Wort zu analysieren, sondern "sieht" direkt das ganze Bild. Statt OCR benutzte ich eine Kamera und lernte, dass ein Bild mehr sagt als tausend Worte.

- Diplomarbeit: VisRAG: Vision-based Retrieval-augmented Generation auf multimodalen Dokumenten

- Projekt: https://github.com/openbmb/visrag

Die Generierung wird verbessert, indem ein auf einem visuell-linguistischen Modell (VLM) basierendes RAG-Verfahren entwickelt wird, das Dokumente direkt als Bilder einbettet und abruft. Im Vergleich zu herkömmlicher Text-RAG vermeidet VisRAG Informationsverluste beim Parsen und bewahrt die Informationen des Originaldokuments umfassender. Experimente zeigen, dass VisRAG sowohl in der Abruf- als auch in der Generierungsphase die traditionelle RAG übertrifft, mit einer End-to-End-Leistungsverbesserung von 25-391 TP3 T. VisRAG nutzt nicht nur die Trainingsdaten effektiv, sondern zeigt auch starke Generalisierungsfähigkeiten, was es zu einer idealen Wahl für multimodale Dokumenten-RAG macht.

(55) AGENTiGraph [Wissensmanager]

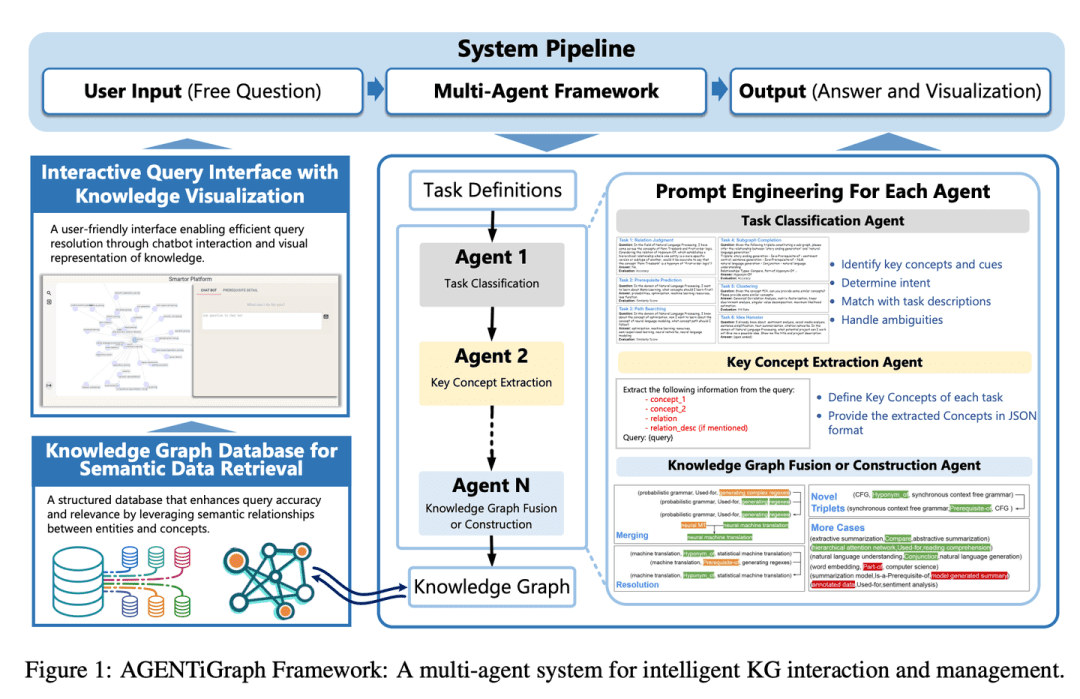

WissensmanagerWie ein dialogorientierter Bibliothekar hilft es Ihnen, Ihr Wissen durch tägliche Kommunikation zu organisieren und zu präsentieren, wobei ein Team von Assistenten bereitsteht, um Fragen zu beantworten und Informationen zu aktualisieren, was das Wissensmanagement einfach und natürlich macht.

- Diplomarbeit: AGENTiGraph: Eine interaktive Wissensgraphen-Plattform für LLM-basierte Chatbots unter Nutzung privater Daten

AGENTiGraph ist eine Plattform für Wissensmanagement durch natürlichsprachliche Interaktion. AGENTiGraph nutzt eine Multi-Intelligenz-Architektur, um die Absichten der Benutzer dynamisch zu interpretieren, Aufgaben zu verwalten und neues Wissen zu integrieren, um sicherzustellen, dass es sich an veränderte Benutzerbedürfnisse und Datenkontexte anpassen kann.

(56) RuleRAG [Rule Following]

dem Kompass folgen und sich an das vorgegebene Viereck halten (Idiom); die Regeln starr befolgenKI zu lehren, Dinge mit Regeln zu tun, ist so, als würde man eine neue Person an Bord holen und ihr zuerst ein Mitarbeiterhandbuch geben. Anstatt ziellos zu lernen, ist es wie ein strenger Lehrer, der zuerst die Regeln und Beispiele erklärt und dann die Schüler selbst machen lässt. Tun Sie mehr, werden diese Regeln zum Muskelgedächtnis, das nächste Mal, wenn Sie auf ähnliche Probleme stoßen, wissen Sie natürlich, wie Sie damit umgehen müssen.

- Dissertation: RuleRAG: Regelgeleitete Retrieval-augmentierte Generierung mit Sprachmodellen zur Beantwortung von Fragen

- Projekt: https://github.com/chenzhongwu20/RuleRAG_ICL_FT

RuleRAG schlägt einen regelbasierten Ansatz für die Generierung von Suchanfragen auf der Grundlage eines Sprachmodells vor, bei dem symbolische Regeln explizit als Beispiele für kontextuelles Lernen (RuleRAG - ICL) eingeführt werden, um einen Retriever anzuleiten, logisch relevante Dokumente in Richtung der Regeln zu finden, und einen Generator einheitlich anzuleiten, informierte Antworten zu produzieren, die sich an denselben Regeln orientieren. Darüber hinaus kann die Kombination von Abfragen und Regeln als überwachte Feinabstimmungsdaten für die Aktualisierung der Retriever und Generatoren (RuleRAG - FT) verwendet werden, um eine bessere Befolgung der regelbasierten Anweisungen zu erreichen, was wiederum hilfreichere Ergebnisse liefert und akzeptablere Antworten erzeugt.

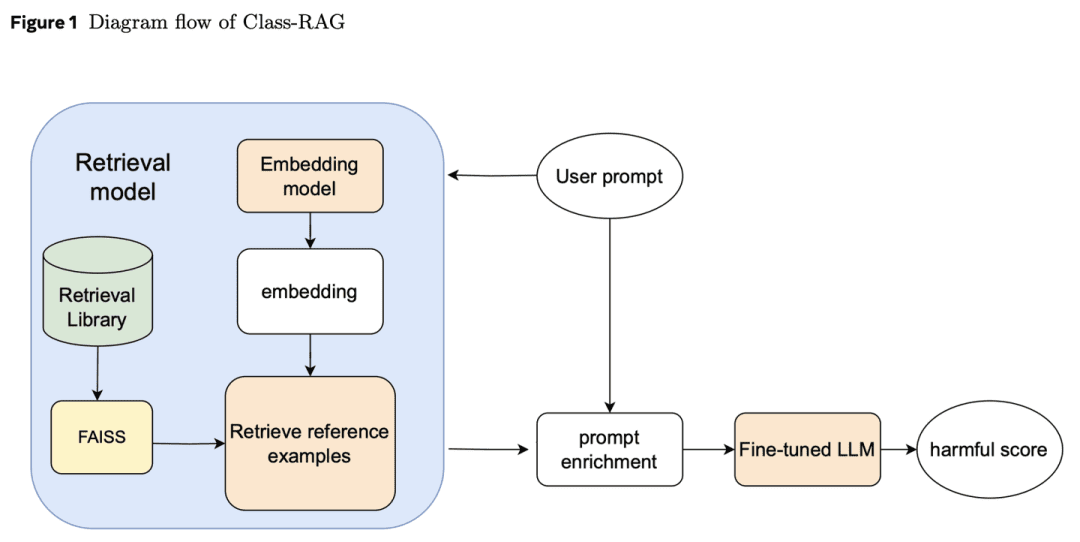

(57) Klasse-RAG [Richter]

RichterDer Richter stützt sich nicht auf starre Vorschriften, um Fälle zu entscheiden, sondern prüft das Urteil anhand einer ständig wachsenden Bibliothek der Rechtsprechung. Wie ein erfahrener Richter hält er einen Loseblattwerk-Kodex in der Hand und liest jederzeit die neuesten Fälle, so dass das Urteil sowohl Temperatur als auch Maßstab hat.

- Diplomarbeit: Class-RAG: Inhaltsmoderation mit Retrieval Augmented Generation

Klassifikatoren zur Überprüfung von Inhalten sind für die Sicherheit der generativen KI von entscheidender Bedeutung. Allerdings sind die Nuancen zwischen sicheren und unsicheren Inhalten oft schwer zu unterscheiden. Mit der zunehmenden Verbreitung von Technologien wird es immer schwieriger und teurer, die Modelle kontinuierlich zu verfeinern, um Risiken anzugehen. Aus diesem Grund schlagen wir den Class-RAG-Ansatz vor, der eine sofortige Risikominderung durch dynamische Aktualisierung der Abfragebasis ermöglicht. Class-RAG ist flexibler und transparenter als herkömmliche Feinabstimmungsmodelle und erzielt bessere Ergebnisse in Bezug auf Klassifizierung und Angriffsresistenz. Es wird auch gezeigt, dass die Erweiterung der Suchbasis die Prüfungsleistung bei geringen Kosten effektiv verbessern kann.

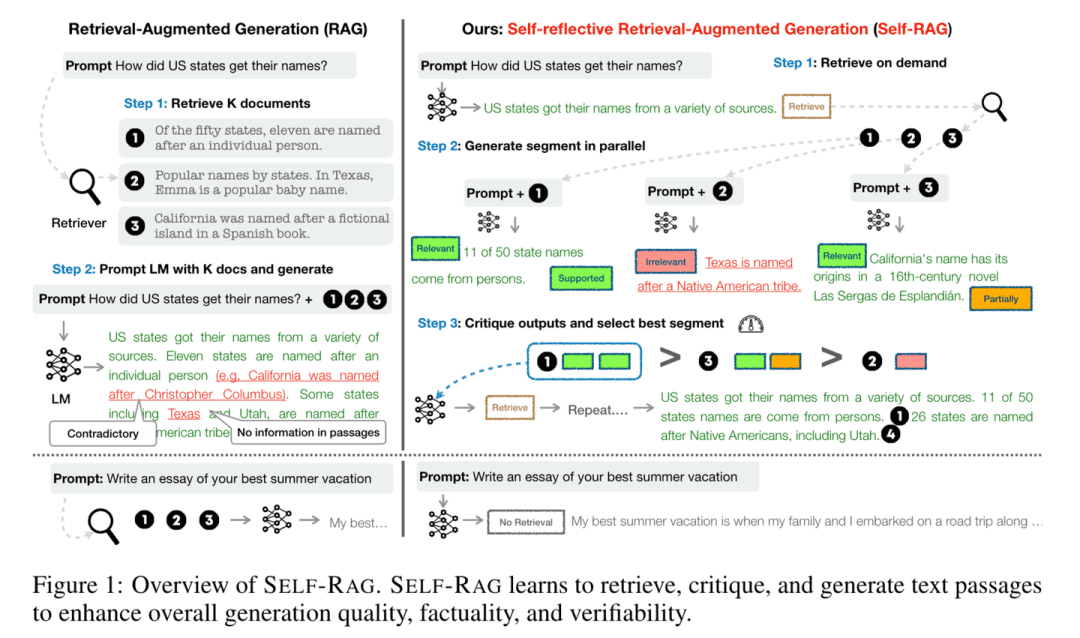

(58) Selbst-RAG [Reflektor]

DenkerBei der Beantwortung von Fragen ziehen sie nicht nur Informationen zu Rate, sondern denken auch nach und überprüfen ihre Antworten auf Richtigkeit und Vollständigkeit. Indem sie wie ein umsichtiger Gelehrter "beim Sprechen mitdenken", stellen sie sicher, dass jeder Standpunkt durch stichhaltige Beweise untermauert wird.

- Diplomarbeit: Self-RAG: Lernen, durch Selbstreflexion zu recherchieren, zu generieren und zu kritisieren

- Projekt: https://github.com/AkariAsai/self-rag

Self-RAG verbessert die Qualität und Genauigkeit von Sprachmodellen durch Abruf und Selbstreflexion. Das Framework trainiert ein einzelnes beliebiges Sprachmodell, das bei Bedarf adaptiv Passagen abrufen und spezielle Marker, sogenannte Reflexionsmarker, verwenden kann, um die abgerufenen Passagen und ihre eigenen generierten Inhalte zu erzeugen und zu reflektieren. Durch die Erzeugung von Reflexionsmarkern wird das Sprachmodell in der Argumentationsphase steuerbar, so dass es sein Verhalten an unterschiedliche Aufgabenanforderungen anpassen kann.

(59) SimRAG [autodidaktisch]

ein Selfmade-GenieWenn Sie mit einem Fachgebiet konfrontiert werden, stellen Sie Ihre eigenen Fragen, bevor Sie sie selbst beantworten, und erweitern Sie Ihren beruflichen Wissensvorrat durch ständiges Üben, so wie Studenten sich durch wiederholte Übungen mit ihrem beruflichen Wissen vertraut machen.

- Dissertation: SimRAG: Selbstverbessernde Retrieval-erweiterte Generierung zur Anpassung großer Sprachmodelle an spezialisierte Domänen

SimRAG ist eine Selbstlernmethode, die LLMs mit den gemeinsamen Fähigkeiten von Frage und Antwort und der Generierung von Fragen für bestimmte Bereiche ausstattet. Gute Fragen können nur gestellt werden, wenn das Wissen wirklich verstanden wird. Diese beiden Fähigkeiten ergänzen sich gegenseitig und helfen dem Modell, das Fachwissen besser zu verstehen. Das LLM wird zunächst in Bezug auf das Befolgen von Anweisungen, Fragen und Antworten und die Suche nach relevanten Daten feinabgestimmt. Anschließend wird dieselbe LLM aufgefordert, eine Vielzahl von domänenrelevanten Fragen aus einem nicht gekennzeichneten Korpus zu generieren, wobei zusätzliche Filterstrategien eingesetzt werden, um qualitativ hochwertige synthetische Beispiele zu erhalten. Durch die Verwendung dieser synthetischen Beispiele kann der LLM seine Leistung bei domänenspezifischen RAG-Aufgaben verbessern.

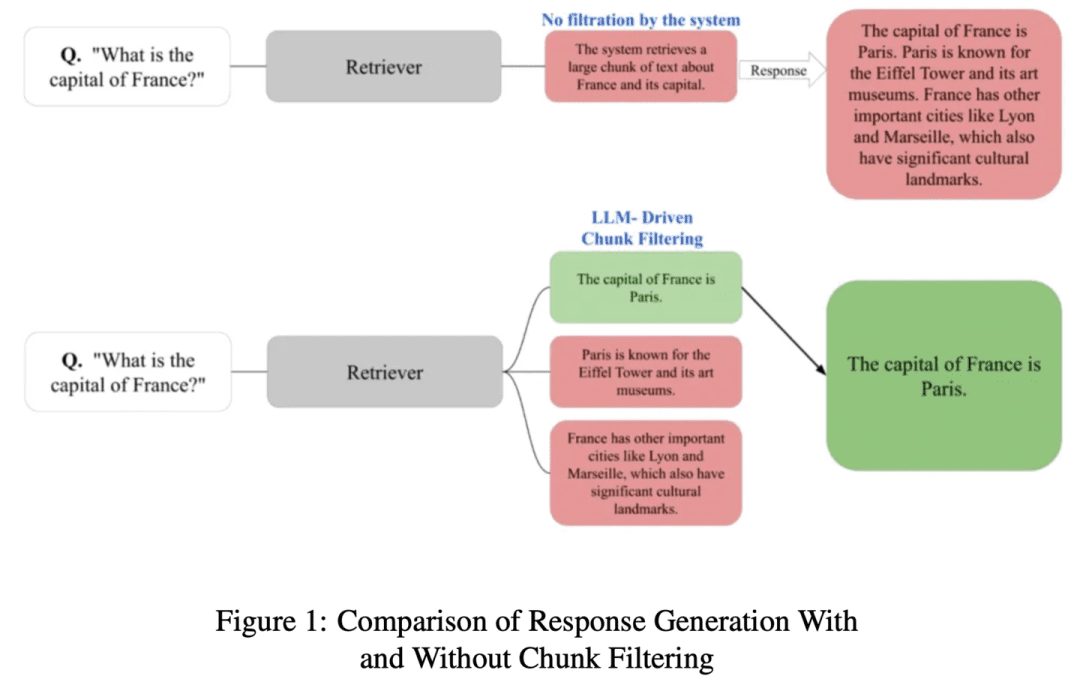

(60) ChunkRAG [Auszüge aus dem Master]

Person, die Auszüge aus einem Buch entnimmtLange Artikel in kleinere Absätze unterteilen und dann mit professionellem Blick die wichtigsten Teile heraussuchen, ohne das Wesentliche zu übersehen oder durch irrelevante Inhalte abgelenkt zu werden.

- Dissertation: ChunkRAG: Neuartiges LLM-Chunk-Filterverfahren für RAG-Systeme

ChunkRAG schlägt einen LLM-gesteuerten Chunk-Filterungsansatz vor, um den Rahmen von RAG-Systemen zu erweitern, indem die abgerufenen Informationen auf Chunk-Ebene bewertet und gefiltert werden, wobei "Chunks" kleinere kohärente Teile eines Dokuments darstellen. Unser Ansatz nutzt semantisches Chunking, um das Dokument in kohärente Teile zu unterteilen, und verwendet eine Relevanzbewertung, die auf einem großen Sprachmodell basiert, um zu beurteilen, wie gut jeder Chunk mit der Benutzeranfrage übereinstimmt. Indem wir weniger relevante Chunks vor der Generierungsphase herausfiltern, können wir Täuschungen deutlich reduzieren und die faktische Genauigkeit verbessern.

(61) FastGraphRAG [Radar]

Radar (Lehnwort)Wie bei Google Page Rank, geben Sie Wissenspunkten eine heiße Liste. Es ist wie ein Meinungsführer in einem sozialen Netzwerk, je mehr Leute ihm folgen, desto leichter wird er gesehen. Anstatt ziellos zu suchen, ist es wie ein Späher mit Radar, der dort sucht, wo das Signal stark ist.

- Projekt: https://github.com/circlemind-ai/fast-graphrag

FastGraphRAG bietet ein effizientes, interpretierbares und hochpräzises Fast Graph Retrieval Augmented Generation (FastGraphRAG) Framework. Es wendet den PageRank-Algorithmus auf den Traversalprozess des Wissensgraphen an, um schnell die relevantesten Wissensknoten zu finden. Durch die Berechnung der Wichtigkeit eines Knotens ermöglicht es PageRank GraphRAG, Informationen im Wissensgraphen intelligenter zu filtern und zu sortieren. Dies ist so, als ob GraphRAG mit einem "Wichtigkeitsradar" ausgestattet wäre, mit dem die wichtigsten Informationen in der riesigen Datenmenge schnell gefunden werden können.

(62) AutoRAG [Tuner]

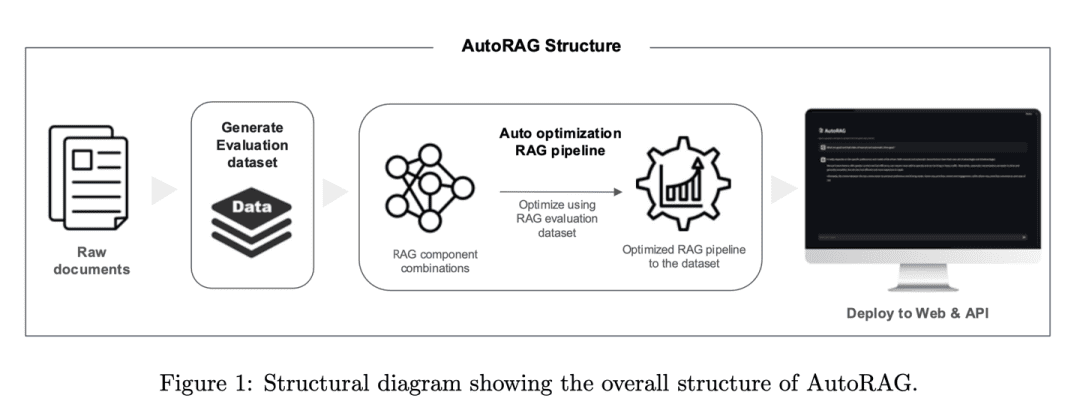

TunerDer RAG ist ein erfahrener Tuner, der den besten Klang nicht durch Raten, sondern durch wissenschaftliches Testen findet. Er probiert automatisch verschiedene Kombinationen von RAGs aus, so wie ein Mixer verschiedene Audiogeräte testet, um die harmonischste "Spiellösung" zu finden.

- Dissertation: AutoRAG: Automatisiertes Framework zur Optimierung der Retrieval Augmented Generation Pipeline

- Projekt: https://github.com/Marker-Inc-Korea/AutoRAG_ARAGOG_Paper

Das AutoRAG-Rahmenwerk identifiziert automatisch geeignete RAG-Module für einen gegebenen Datensatz und erforscht und approximiert die optimale Kombination von RAG-Modulen für diesen Datensatz. Durch die systematische Evaluierung verschiedener RAG-Einstellungen zur Optimierung der Wahl der Techniken ähnelt das Framework der Praxis von AutoML im traditionellen maschinellen Lernen, wo umfangreiche Experimente durchgeführt werden, um die Wahl der RAG-Techniken zu optimieren und die Effizienz und Skalierbarkeit des RAG-Systems zu verbessern.

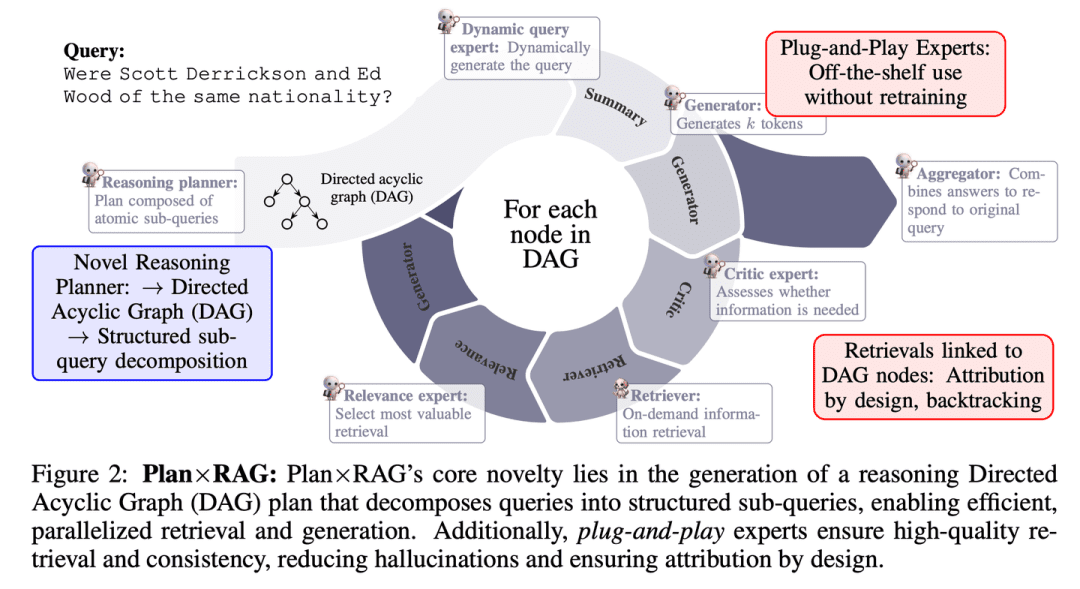

(63) Plan x RAG [Projektleiter]

ProjektleiterPlanung vor Aktion, Aufteilung großer Aufgaben in kleinere und parallele Arbeit mehrerer "Experten". Jeder Experte ist für seinen eigenen Bereich zuständig, und der Projektleiter ist für die Zusammenfassung der Ergebnisse am Ende verantwortlich. Diese Vorgehensweise ist nicht nur schneller und genauer, sondern liefert auch einen klaren Hinweis darauf, woher die einzelnen Schlussfolgerungen stammen.

- These: Plan × RAG: Planungsgeleitete Retrieval Augmented Generation

Plan×RAG ist ein neuartiges Framework, das das Paradigma "Abfrage - Schlussfolgerung" bestehender RAG-Frameworks zu einem "Plan - Abfrage"-Paradigma erweitert.Plan×RAG formuliert Schlussfolgerungspläne als gerichtete azyklische Graphen (DAGs), die Abfragen in Plan×RAG formuliert den Argumentationsplan als gerichteten azyklischen Graphen (DAG) und zerlegt die Anfrage in miteinander verbundene atomare Unterabfragen. Die Antwortgenerierung folgt der DAG-Struktur, was die Effizienz durch parallele Abfrage und Generierung erheblich verbessert. Während RAG-Lösungen nach dem Stand der Technik eine umfangreiche Datengenerierung und Feinabstimmung von Sprachmodellen (LMs) erfordern, beinhaltet Plan×RAG eingefrorene LMs als Plug-and-Play-Experten, um qualitativ hochwertige Antworten zu generieren.

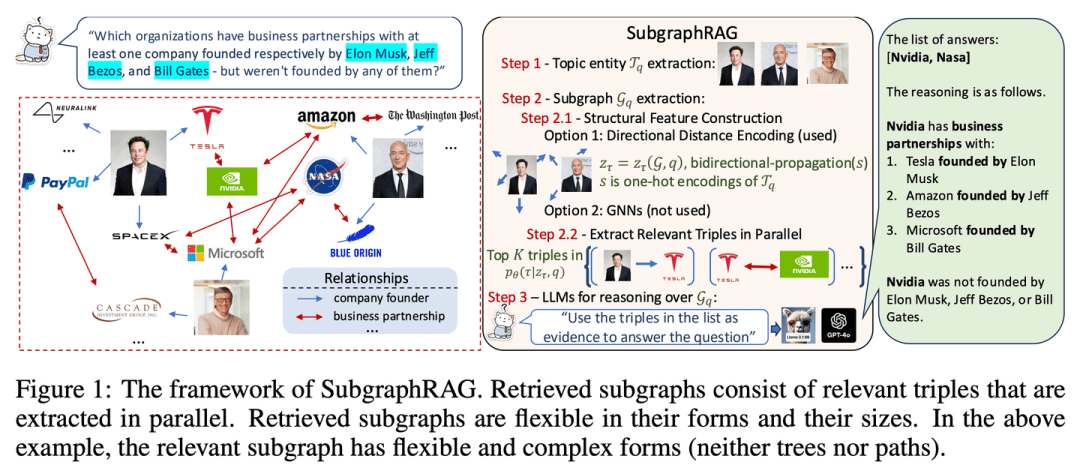

(64) SubgraphRAG [locator]

StellungsreglerAnstatt nach einer Nadel im Heuhaufen zu suchen, wird eine kleine Karte des Wissens präzise gezeichnet, damit die KI die Antwort schnell finden kann.

- Dissertation: Einfach ist effektiv: Die Rolle von Graphen und großen Sprachmodellen in der wissensgraphenbasierten Retrieval-Augmented Generation

- Projekt: https://github.com/Graph-COM/SubgraphRAG

SubgraphRAG erweitert den KG-basierten RAG-Rahmen durch das Abrufen von Teilgraphen und die Nutzung von LLM für Inferenz und Antwortvorhersage. Ein leichtgewichtiges mehrschichtiges Perzeptron wird mit einem parallelen ternären Scoring-Mechanismus für eine effiziente und flexible Abfrage von Teilgraphen kombiniert, während die gerichtete Strukturdistanz kodiert wird, um die Abfrageeffektivität zu verbessern. Die Größe der abgerufenen Teilgraphen kann flexibel an die Anforderungen der Abfrage und die Fähigkeiten des nachgeschalteten LLM angepasst werden. Dieses Design schafft ein Gleichgewicht zwischen Modellkomplexität und Inferenzfähigkeit und ermöglicht einen skalierbaren und vielseitigen Abrufprozess.

(65) RuRAG [Alchemist]

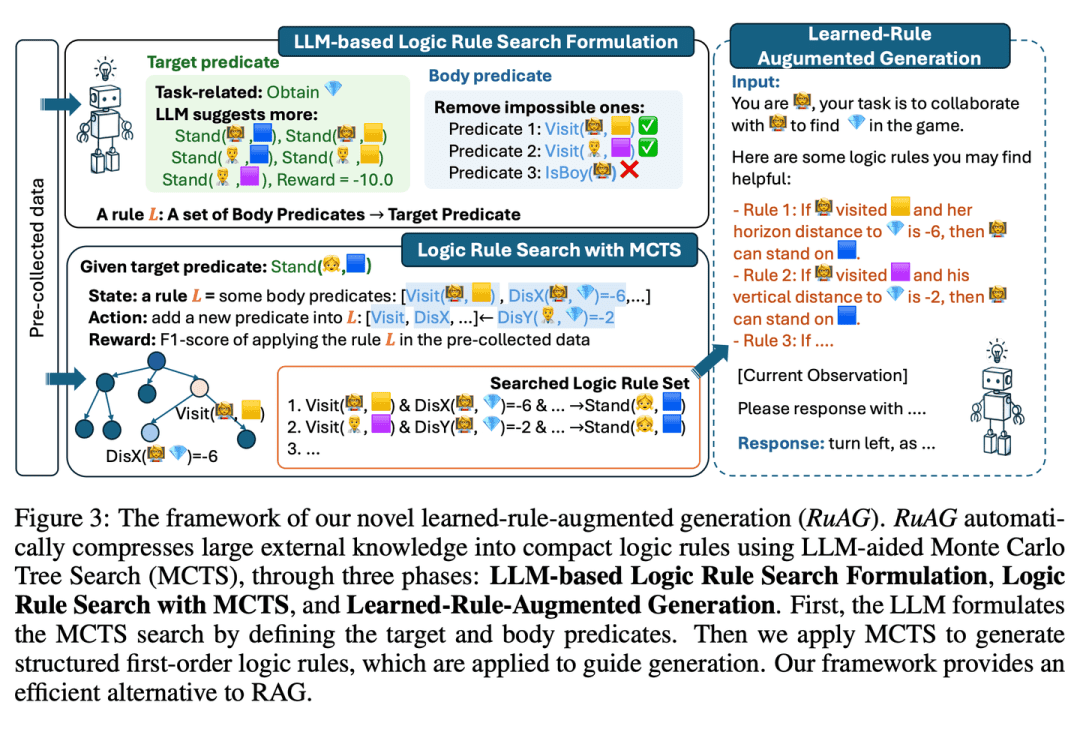

AlchemistWie ein Alchemist kann sie riesige Datenmengen in klare logische Regeln destillieren und diese in einfacher Sprache ausdrücken, was die KI in praktischen Anwendungen intelligenter macht.

- Dissertation: RuAG: Learned-rule-augmented Generation für große Sprachmodelle

zielt darauf ab, die Argumentationsfähigkeiten von groß angelegten Sprachmodellen (LLMs) zu verbessern, indem große Mengen von Offline-Daten automatisch in interpretierbare logische Regeln erster Ordnung destilliert und in LLMs injiziert werden. Das Framework verwendet Monte Carlo Tree Search (MCTS), um logische Regeln zu entdecken und diese Regeln in natürliche Sprache umzuwandeln, was die Wissensinjektion und die nahtlose Integration für nachgelagerte LLM-Aufgaben ermöglicht. Das Papier evaluiert die Effektivität des Frameworks bei öffentlichen und privaten industriellen Aufgaben und demonstriert sein Potenzial, LLM-Fähigkeiten bei verschiedenen Aufgaben zu verbessern.

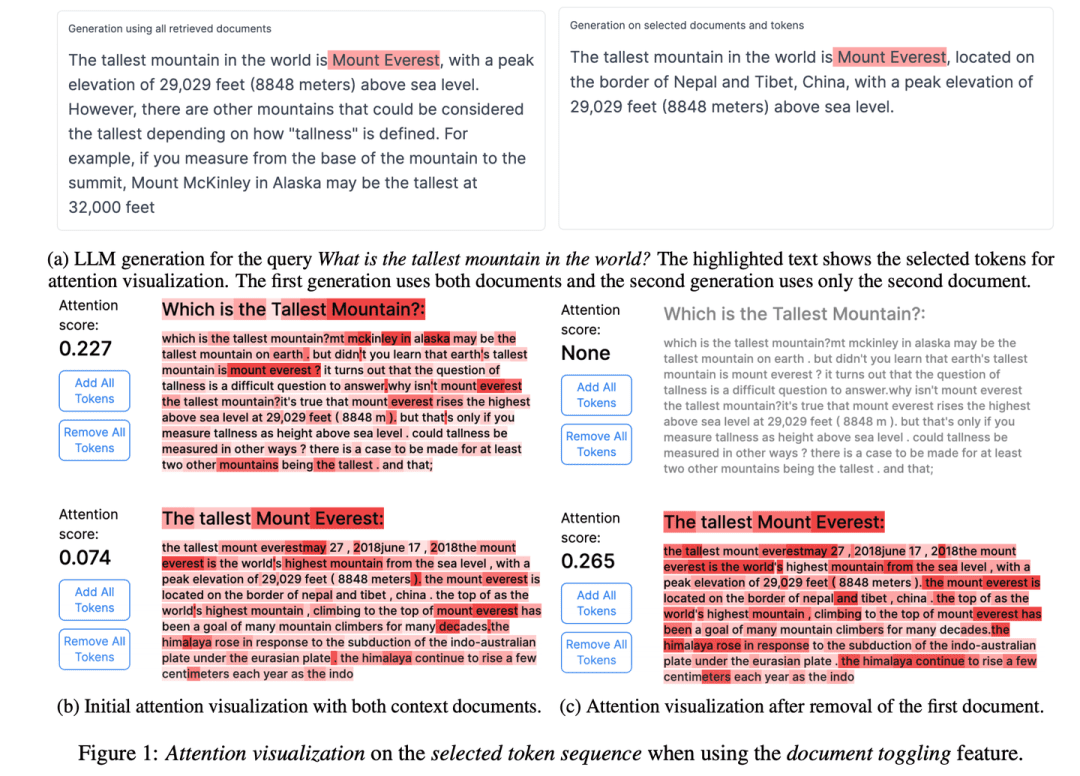

(66) RAGViz [Durchsichtiges Auge]

Tunnelblick: Machen Sie das RAG-System transparent, sehen Sie, welchen Satz das Modell liest, wie ein Arzt, der ein Röntgenbild betrachtet, und sehen Sie auf einen Blick, was falsch ist.

- Diplomarbeit: RAGViz: Diagnose und Visualisierung von Retrieval-Augmented Generation

- Projekt: https://github.com/cxcscmu/RAGViz

RAGViz bietet Visualisierungen der abgerufenen Dokumente und der Modellaufmerksamkeit, um den Benutzern zu helfen, die Interaktion zwischen dem generierten Markup und den abgerufenen Dokumenten zu verstehen, und kann zur Diagnose und Visualisierung von RAG-Systemen verwendet werden.

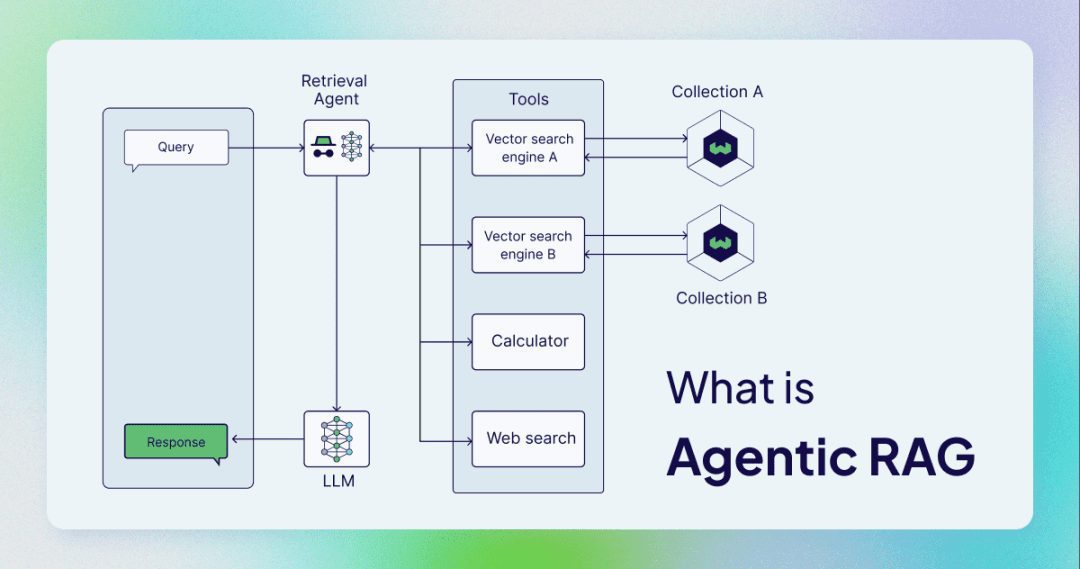

(67) AgenticRAG [Intelligenter Assistent]

intelligenter AssistentEs geht nicht mehr nur um das einfache Nachschlagen und Kopieren, sondern um einen Assistenten, der als vertrauliche Sekretärin fungieren kann. Wie ein kompetenter Verwalter weiß er nicht nur, wie man Informationen nachschlägt, sondern auch, wann man telefonieren, eine Besprechung abhalten und um Anweisungen bitten muss.

AgenticRAG beschreibt eine RAG, die auf der Implementierung von KI-Intelligenzen basiert. Konkret werden KI-Intelligenzen in den RAG-Prozess integriert, um dessen Komponenten zu koordinieren und zusätzliche Aktionen durchzuführen, die über die einfache Informationsbeschaffung und -generierung hinausgehen, um die Beschränkungen von nicht-intelligenten Körperprozessen zu überwinden.

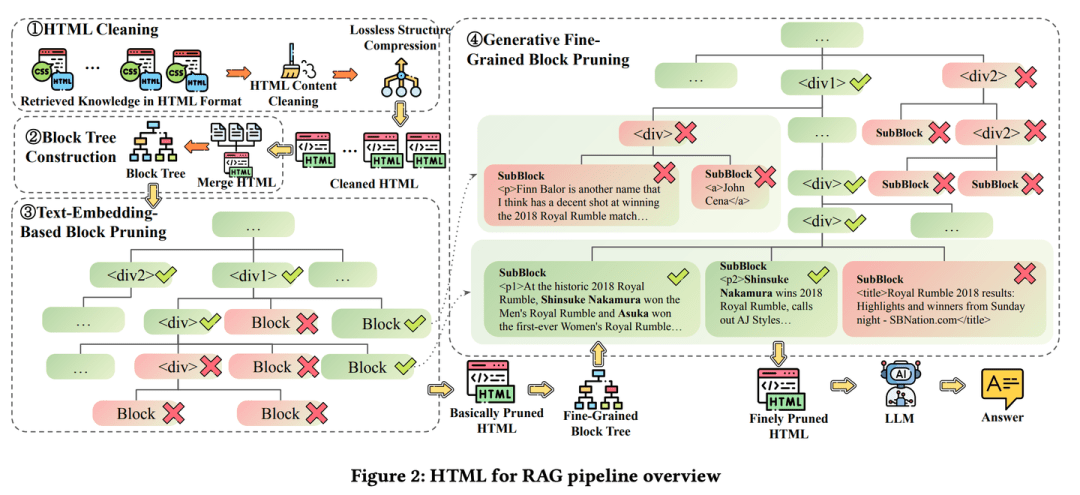

(68) HtmlRAG [Typograf]

TypografWissen wird nicht wie eine laufende Rechnung geführt, sondern wie ein Zeitschriftenlayout, mit Fettdruck, wo er nötig ist, und roter Kennzeichnung, wo er nötig ist. Es ist wie ein pingeliger Redakteur, der der Meinung ist, dass der Inhalt allein nicht ausreicht, sondern auch das Layout, so dass die wichtigsten Punkte auf einen Blick zu erkennen sind.

- Dissertation: HtmlRAG: HTML ist besser als reiner Text für die Modellierung von gewonnenem Wissen in RAG-Systemen

- Projekt: https://github.com/plageon/HtmlRAG

HtmlRAG verwendet HTML anstelle von einfachem Text als Format zum Abrufen von Wissen in RAG, HTML ist besser als einfacher Text, wenn es darum geht, Wissen aus externen Dokumenten zu modellieren, und die meisten LLMs haben ein starkes Verständnis von HTML.HtmlRAG schlägt HTML-Bereinigung, Kompression und Pruning-Strategien vor, um HTML zu kürzen und gleichzeitig den Informationsverlust zu minimieren.

(69) M3DocRAG [Sensualist]

SinnesmenschSie können nicht nur Bücher lesen, sondern auch Bilder lesen und Stimmen hören. Wie ein Allround-Teilnehmer in einer Varieté-Show kann er Bilder lesen, Wörter verstehen, springen, wenn er springen muss, sich auf Details konzentrieren, wenn er sich konzentrieren muss, und kann nicht durch alle Arten von Herausforderungen besiegt werden.

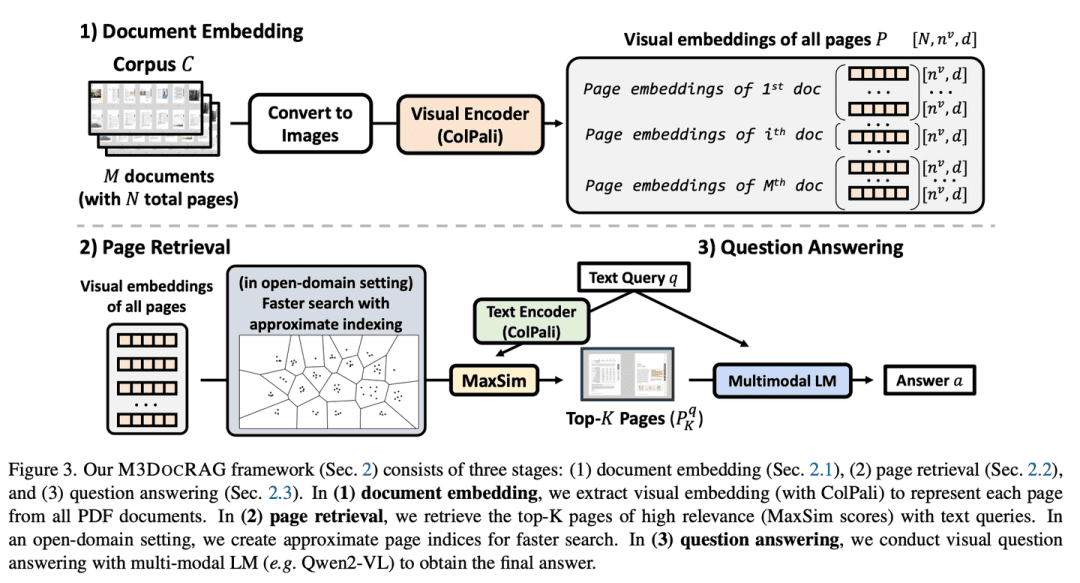

- Dissertation: M3DocRAG: Multi-modales Retrieval ist das, was man zum Verstehen von mehrseitigen Dokumenten braucht

M3DocRAG ist ein neuartiges multimodales RAG-Framework, das sich flexibel an eine Vielzahl von Dokumentenkontexten (geschlossene und offene Domänen), Fragesprüngen (einfach und mehrfach) und Beweisarten (Text, Diagramme, Grafiken usw.) anpasst. M3DocRAG verwendet einen multimodalen Retriever und ein MLM, um relevante Dokumente zu finden und Fragen zu beantworten. Informationen.

(70) KAG [Meister der Logik]

LogikmasterEs geht nicht nur darum, ähnliche Antworten nach Gefühl zu finden, sondern auch um den kausalen Zusammenhang zwischen Wissen. Wie ein strenger Mathelehrer müssen Sie nicht nur wissen, wie die Antwort lautet, sondern auch erklären, wie diese Antwort Schritt für Schritt abgeleitet wurde.

- Dissertation: KAG: Förderung von LLMs in professionellen Domänen durch wissenserweiterte Generierung

- Projekt: https://github.com/OpenSPG/KAG

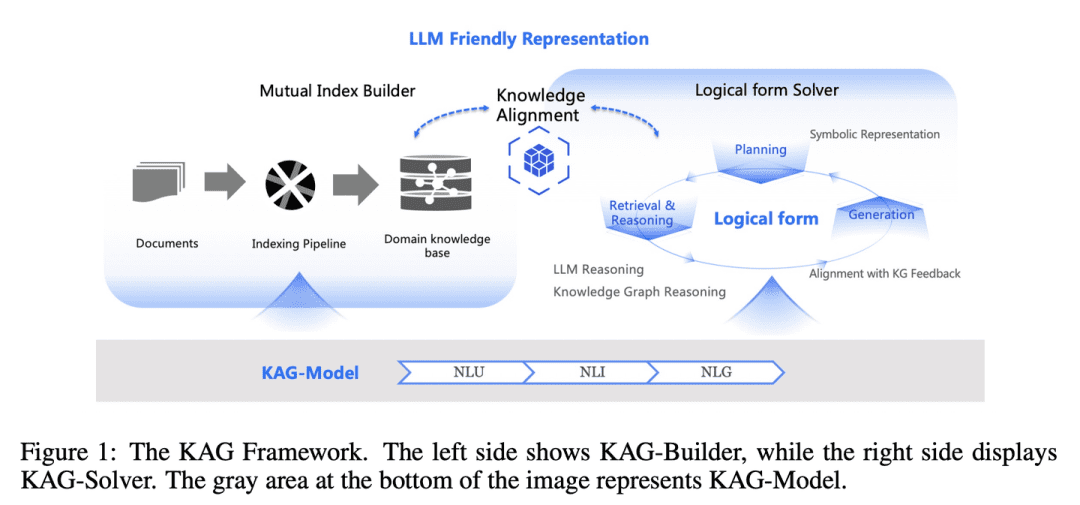

Die Diskrepanz zwischen der Ähnlichkeit von Vektoren und der Relevanz von Wissensschlüssen in RAG sowie die Unempfindlichkeit gegenüber Wissenslogiken (z. B. numerische Werte, zeitliche Beziehungen, Expertenregeln usw.) behindern die Effektivität von Expertendiensten.KAG wurde entwickelt, um die Stärken des Wissensgraphen (Knowledge Graph, KG) und des Vektor-Retrievals zu nutzen, um die oben genannten Herausforderungen zu bewältigen, und verbessert bidirektional die groß angelegten Sprachmodelle (LLMs) und den Wissensgraphen durch fünf Schlüsselaspekte um die Generierungs- und Inferenzleistung zu verbessern: (1) LLM-freundliche Wissensrepräsentation, (2) Querindizierung zwischen Knowledge Graph und rohen Chunks, (3) logische formgeführte hybride Inferenzmaschine, (4) Wissensabgleich mit semantischer Inferenz und (5) Verbesserung der Modellierungsfähigkeit von KAG.

(71) FILCO [Vorführgerät]

SiebmaschinenWie ein strenger Redakteur, der in der Lage ist, die wertvollsten Informationen aus großen Textmengen herauszufiltern und festzuhalten, um sicherzustellen, dass jeder an die KI gelieferte Inhalt korrekt und relevant ist.

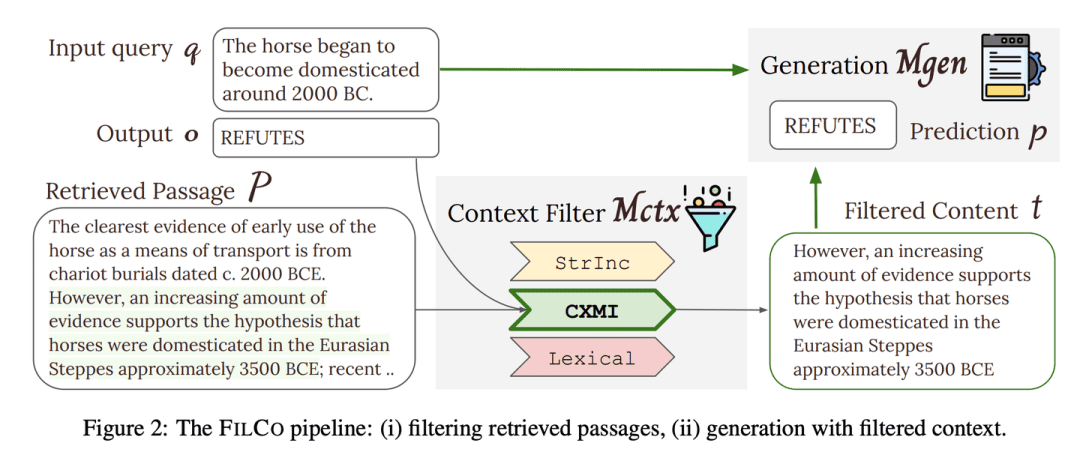

- Dissertation: Lernen, Kontext zu filtern für Retrieval-Augmented Generation

- Projekt: https://github.com/zorazrw/filco

FILCO verbessert die Qualität des Kontexts, der dem Generator zur Verfügung gestellt wird, indem es nützliche Kontexte auf der Grundlage lexikalischer und informationstheoretischer Ansätze identifiziert und ein Modell zur Kontextfilterung trainiert, um die abgerufenen Kontexte zu filtern.

(72) LazyGraphRAG [Aktuar]

VersicherungsmathematikerEin Schritt ist ein Schritt, wenn man ihn sparen kann und die großen, teuren Modelle gut gebrauchen kann. Wie eine Hausfrau, die weiß, wie man lebt, kauft man nicht einfach, wenn man im Supermarkt ein Angebot sieht, sondern man vergleicht, bevor man entscheidet, wo man sein Geld ausgibt, um das beste Preis-Leistungs-Verhältnis zu erzielen.

- Projekt: https://github.com/microsoft/graphrag

Ein neuartiger Ansatz zur graphengestützten Generierung eines erweiterten Retrievals (RAG). Dieser Ansatz reduziert die Indizierungs- und Abfragekosten erheblich, während er die Qualität der Antworten beibehält oder sogar übertrifft, was ihn für eine Vielzahl von Anwendungsfällen hoch skalierbar und effizient macht.LazyGraphRAG verzögert den Einsatz von LLM. Während der Indizierungsphase verwendet LazyGraphRAG nur leichtgewichtige NLP-Techniken zur Verarbeitung des Textes und verzögert den Aufruf des LLM bis zur eigentlichen Anfrage. Diese "faule" Strategie vermeidet hohe Vorlaufkosten für die Indizierung und ermöglicht eine effiziente Ressourcennutzung.

| Traditionelle GraphRAG | LazyGraphRAG | |

| Indizierungsphase | - Extrahieren und Beschreiben von Entitäten und Beziehungen mit LLM - Zusammenfassungen für jede Entität und Beziehung generieren - Zusammenfassen von Gemeinschaftsinhalten mit LLM - Erzeugen von Einbettungsvektoren - Erzeugen von Parkettdateien | - Extrahieren von Konzepten und wiederkehrenden Beziehungen mithilfe von NLP-Techniken - Erstellen von konzeptionellen Karten - Extraktion von Gemeinschaftsstrukturen - LLM wird in der Indizierungsphase nicht verwendet |

| Anfrage-Phase | - Direkte Beantwortung von Anfragen mit Hilfe von Gemeinschaftszusammenfassungen - Mangelnde Verfeinerung der Abfragen und Konzentration auf relevante Informationen | - Verwendung von LLM zur Verfeinerung von Abfragen und zur Erstellung von Unterabfragen - Auswahl von Textsegmenten und Communities nach Relevanz - Extrahieren und Generieren von Antworten mit LLM - Stärkere Konzentration auf relevante Inhalte, präzisere Antworten |

| LLM-Aufruf | - Starke Nutzung sowohl in der Indizierungsphase als auch in der Abfragephase | - LLM wird in der Indizierungsphase nicht verwendet - Aufruf des LLM nur in der Abfragephase - LLM wird effizienter genutzt |

| Kosteneffizienz | - Hohe Kosten und zeitaufwändige Indexierung - Abfrageleistung durch Indexqualität begrenzt | - Die Indizierungskosten betragen nur 0,1% des traditionellen GraphRAG - Hohe Abfrageeffizienz und gute Qualität der Antworten |

| Datenspeicherung | - Parquet-Dateien werden aus indizierten Daten erzeugt und eignen sich für die Speicherung und Verarbeitung großer Datenmengen. | - Indizierte Daten werden in leichtgewichtigen Formaten (z. B. JSON, CSV) gespeichert, die für eine schnelle Entwicklung und kleine Datenmengen besser geeignet sind. |

| Verwendungsszenarien | - Für Szenarien, die nicht von Rechenressourcen und Zeit abhängig sind - Der gesamte Wissensgraph muss im Voraus erstellt und als Parquet-Datei gespeichert werden, damit er später für komplexe Analysen in die Datenbank importiert werden kann. | - Für Szenarien, die eine schnelle Indizierung und Reaktion erfordern - Ideal für einmalige Abfragen, Sondierungsanalysen und die Verarbeitung von Streaming-Daten |

RAG-Umfrage

- Ein Überblick über Retrieval-unterstützte Textgenerierung

- Abrufen multimodaler Informationen für Augmented Generation: Ein Überblick

- Retrieval-unterstützte Generierung für große Sprachmodelle: Ein Überblick

- Retrieval-unterstützte Generierung für KI-generierte Inhalte: Ein Überblick

- Ein Überblick über Retrieval-unterstützte Texterstellung für große Sprachmodelle

- RAG und RAU: Ein Überblick über Retrieval-Augmented Language Model in der natürlichen Sprachverarbeitung

- Ein Überblick über RAG Meeting LLMs: Auf dem Weg zu Retrieval-Augmented Large Language Models

- Bewertung der Retrieval-unterstützten Generierung: Ein Überblick

- Retrieval-unterstützte Generierung für die Verarbeitung natürlicher Sprache: Ein Überblick

- Graph Retrieval-Augmented Generation: Ein Überblick

- Ein umfassender Überblick über Retrieval-Augmented Generation (RAG): Entwicklung, gegenwärtige Landschaft und zukünftige Wege

- Retrieval Augmented Generation (RAG) und darüber hinaus: Ein umfassender Überblick darüber, wie Ihre LLMs externe Daten sinnvoller nutzen können

RAG-Benchmark

- Benchmarking großer Sprachmodelle in Retrieval-unterstützter Generierung

- RECALL: Ein Benchmark für die Robustheit von LLMs gegenüber externem kontrafaktischem Wissen

- ARES: Ein automatisierter Bewertungsrahmen für Retrieval-erweiterte Generierungssysteme

- RAGASAutomatisierte Auswertung von Retrieval Augmented Generation

- CRUD-RAG: Ein umfassender chinesischer Benchmark für die Retrieval-gestützte Generierung großer Sprachmodelle

- FeB4RAG: Evaluierung der föderierten Suche im Kontext der Retrieval Augmented Generation

- CodeRAG-Bench: Kann Retrieval die Codegenerierung unterstützen?

- Long2RAG: Evaluierung von Long-Context & Long-Form Retrieval-Augmented Generation mit Key Point Recall

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...