Modelo pequeno, grande potência: QwQ-32B com parâmetro 1/20 para lutar contra o DeepSeek-R1 de sangue puro

Recentemente, houve avanços impressionantes no campo da IA, especialmente no aprimoramento da capacidade de raciocínio dos modelos de linguagem grande (LLMs). Entre eles, a Aprendizagem por Reforço (RL) está se tornando uma tecnologia fundamental para eliminar o gargalo de desempenho dos modelos tradicionais. Muitos estudos confirmaram que a RL pode melhorar significativamente a capacidade de raciocínio dos modelos. Por exemplo, o modelo DeepSeek R1 alcançou o pensamento profundo e o raciocínio complexo ao integrar dados de início frio e treinamento em vários estágios, atingindo o nível de liderança na época.

Diante desse cenário, a AliCloud lançou o modelo QwQ-32B, que mais uma vez atraiu a atenção do setor. Esse modelo com 32 bilhões de parâmetros é comparável em desempenho ao DeepSeek-R1 que tem um número elevado de 671 bilhões de parâmetros (37 bilhões de parâmetros ativados). O excelente desempenho do QwQ-32B é uma forte demonstração da eficácia da aprendizagem por reforço no aprimoramento da inteligência de modelos de base avançados pré-treinados com base no conhecimento maciço do mundo.

Além disso, a Aliyun também incorporou recursos relacionados ao agente no modelo de raciocínio do QwQ-32B, permitindo que ele não apenas pense de forma crítica, mas também utilize ferramentas e ajuste o processo de raciocínio com base no feedback ambiental. Esses avanços tecnológicos demonstram o potencial transformador da tecnologia de RL e preparam o caminho para a Inteligência Artificial Geral (AGI).

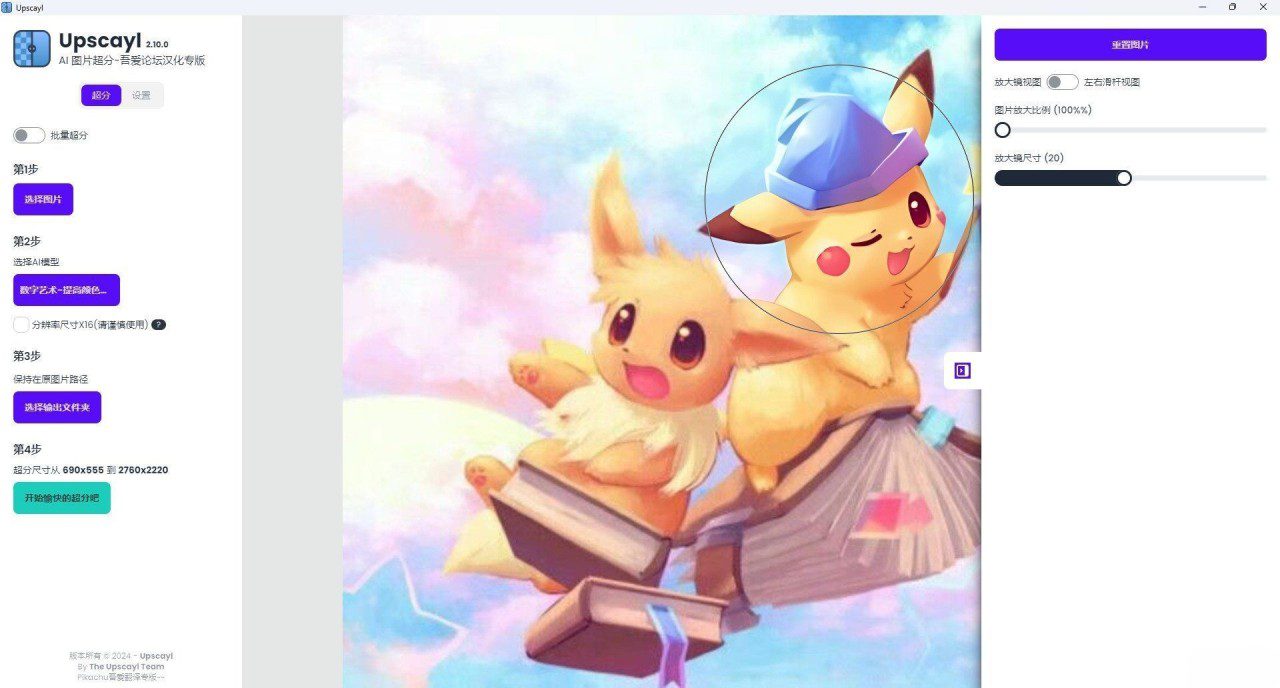

Atualmente, o QwQ-32B foi lançado nas plataformas Hugging Face e ModelScope sob o protocolo de código aberto Apache 2.0, e os usuários podem acessá-lo por meio do Qwen Chat Experiência.

Introdução

O QwQ é o modelo de inferência da família de modelos "Qwen". Em comparação com os modelos tradicionais de ajuste fino de instruções, os modelos QwQ têm recursos de pensamento e raciocínio mais fortes e apresentam ganhos significativos de desempenho em tarefas downstream, especialmente ao resolver quebra-cabeças complexos. é comparável aos modelos de inferência avançados, como o DeepSeek-R1 e o1-mini.

Características do modelo.

- tipologiaModelos de linguagem causal

- fase de treinamentoPré-treinamento e pós-treinamento, incluindo ajuste fino supervisionado e aprendizado por reforço.

- construirEstrutura de transformadores com codificação posicional RoPE, função de ativação SwiGLU, normalização RMSNorm e viés de atenção QKV Viés do mecanismo de atenção

- escala de parâmetros: $32,5 bilhões (32,5B)

- Tamanhos de parâmetros de camadas não incorporadas: $31 bilhões (31.0B)

- andar: 64

- Chefes de atenção (GQA): 40 no lado da consulta e 8 no lado da chave/valor.

- Comprimento do contexto: Completo 131.072 tokens

tomar nota de:: Para obter a melhor experiência, consulte o Diretrizes para uso O modelo QwQ é implantado posteriormente.

Os usuários podem usar o Demonstração Ter uma experiência ou passar pelo QwenChat Para acessar o modelo QwQ, lembre-se de abrir o Thinking (QwQ).

Para obter informações mais detalhadas, consulte Repositórios do GitHub também documento oficial.

Desempenho

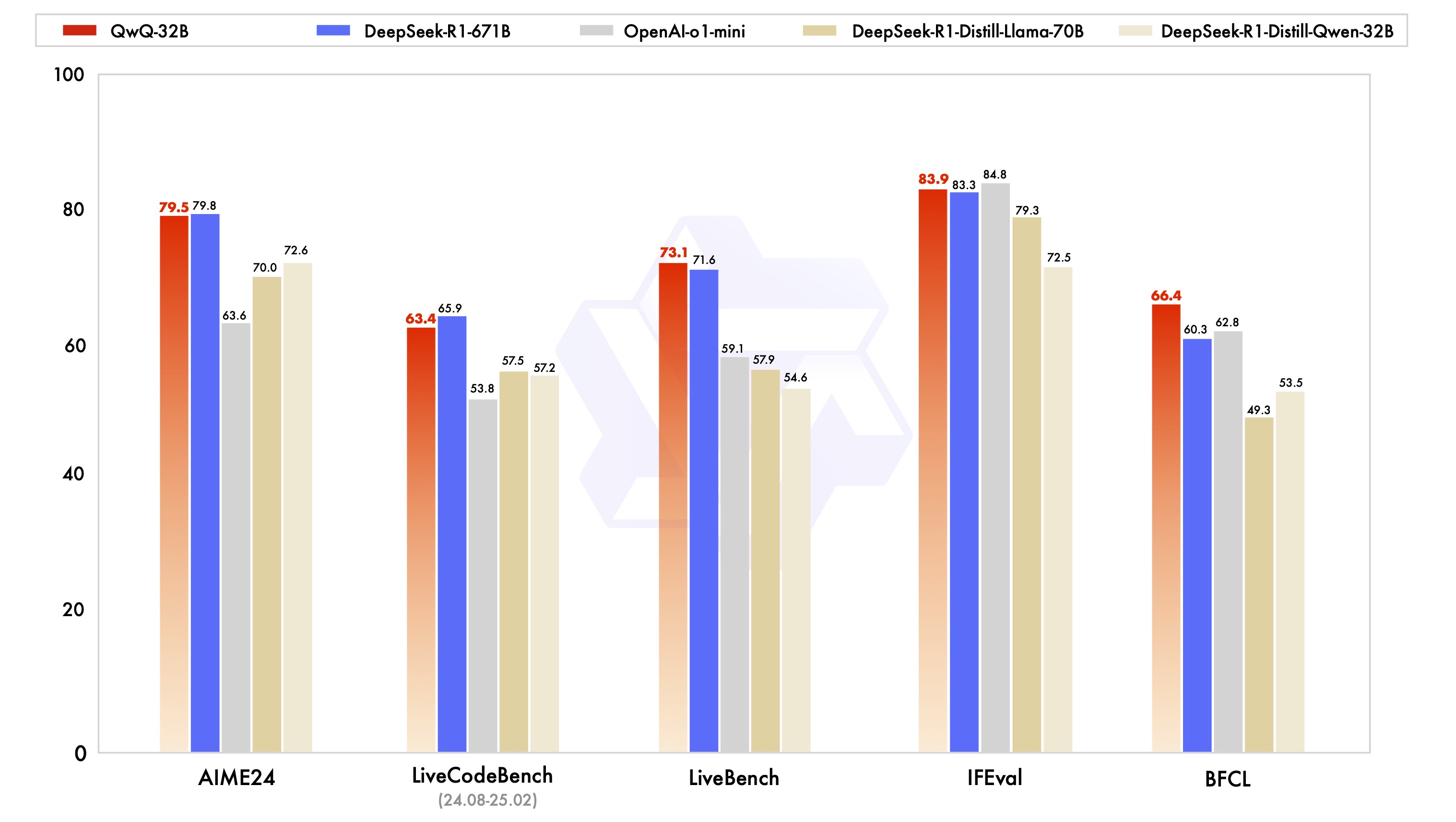

O modelo QwQ-32B foi avaliado em uma série de testes de benchmark projetados para fornecer uma visão abrangente de seus recursos de raciocínio matemático, elaboração de códigos e solução de problemas genéricos. O gráfico abaixo ilustra o desempenho do QwQ-32B em relação a outros modelos líderes, incluindo DeepSeek-R1-Distilled-Qwen-32B, DeepSeek-R1-Distilled-Llama-70B, o1-mini e o DeepSeek-R1 original.

Com base nos resultados, o QwQ-32B apresenta desempenho semelhante ou até melhor do que os principais modelos em vários benchmarks importantes. É especialmente digno de nota o fato de que o QwQ-32B ainda mantém sua competitividade em relação ao DeepSeek-R1, que tem um número muito maior de parâmetros do que o QwQ-32B, o que comprova ainda mais o grande potencial do aprendizado por reforço para melhorar o desempenho do modelo.

Aprendizagem por reforço

O excelente desempenho do QwQ-32B se deve, em grande parte, à tecnologia de Aprendizado por Reforço (RL) por trás dele. Simplificando, o Reinforcement Learning é um método que orienta um modelo a aprender a tomar decisões ideais em um determinado ambiente por meio de mecanismos de recompensa ou punição. Diferentemente do aprendizado supervisionado tradicional, o aprendizado por reforço não depende de grandes quantidades de dados rotulados, mas interage com o ambiente e aprende por tentativa e erro, dominando as estratégias necessárias para concluir a tarefa.

Durante o treinamento do QwQ-32B, a equipe de pesquisa da Aliyun implementou um método de extensão de aprendizagem por reforço com base na recompensa de resultados, partindo de um ponto de verificação de início frio. Na fase inicial, eles se concentraram na extensão da RL para tarefas de matemática e código. Em vez de confiar nos modelos de recompensa tradicionais, a equipe usou um verificador de precisão para as perguntas de matemática, a fim de garantir a exatidão das respostas finais, e um servidor de execução de código para avaliar se o código gerado passou com êxito nos casos de teste predefinidos.

À medida que o treinamento avançava, o desempenho do modelo nos domínios da matemática e do código apresentava uma melhoria consistente. Após a primeira fase, a equipe de pesquisa acrescentou uma fase de treinamento de RL para recursos genéricos. Essa fase de treinamento usou sinais de recompensa do modelo de recompensa genérico e vários validadores baseados em regras. Os resultados experimentais mostram que um pequeno número de etapas de treinamento de RL pode melhorar efetivamente os recursos de uso geral do modelo em termos de adesão às instruções, alinhamento de preferências humanas e desempenho do agente sem causar degradação significativa do desempenho nos recursos matemáticos e de codificação.

Aqui está um artigo sobre por que o Qwen-2.5-3B tem excelentes habilidades de raciocínio:Como os grandes modelos ficam mais "inteligentes"? A Universidade de Stanford revela a chave para o autoaperfeiçoamento: quatro comportamentos cognitivos

Diretrizes de uso

As configurações a seguir são recomendadas para um desempenho ideal:

- Forçar os modelos a pensar sobre a produção: Assegure-se de que os modelos sejam modelados com

<think>\npara evitar a geração de conteúdo de pensamento vazio, o que pode reduzir a qualidade da saída. Se você usar oapply_chat_templatee configuraradd_generation_prompt=TrueIsso é implementado automaticamente. Observe, no entanto, que isso pode fazer com que a resposta não apareça no início do<think>Rotulagem, o que é normal. - Parâmetros de amostragem:

- fazer uso de

Temperature=0.6responder cantandoTopP=0.95Em vez da decodificação Greedy para evitar repetições intermináveis. - fazer uso de

TopKEntre 20 e 40 para filtrar as raridades Token aparecem, mantendo a diversidade do resultado gerado.

- fazer uso de

- Formatos de saída padronizadosRecomendamos que você use o prompt Prompt para padronizar a saída do modelo durante o benchmarking.

- problema de matemáticaNo Prompt, adicione "Please reason step by step, and put your final answer within \boxed{}. " (Raciocine passo a passo e coloque sua resposta final dentro da \boxed{}.

- pergunta de múltipla escolhaAdicione a seguinte estrutura JSON ao Prompt para padronizar a resposta: "Please show your choice in the

answercom apenas a letra de escolha, por exemplo.\"answer\": \"C\". " (Acrescente o seguinte aoanswerO campo exibe sua seleção e contém apenas a letra da seleção, por exemplo\"answer\": \"C\").

- Manuseio de entradas longasPara entradas com mais de 32.768 tokens, ative YaRN para melhorar a capacidade do modelo de capturar efetivamente informações de sequências longas.

Para estruturas compatíveis, o seguinte pode ser adicionado ao config.json para ativar o YaRN:

{

...,

"rope_scaling": {

"factor": 4.0,

"original_max_position_embeddings": 32768,

"type": "yarn"

}

}

Para a implantação, recomenda-se o vLLM. Se você não estiver familiarizado com o vLLM, consulte o documento oficial para obter o uso. Atualmente, o vLLM suporta apenas YARNs estáticos, o que significa que o fator de escala permanece constante à medida que o comprimento da entrada muda.Isso pode afetar o desempenho do modelo ao lidar com textos mais curtos. Portanto, recomenda-se adicionar contextos longos somente quando eles precisarem ser processados rope_scaling Configuração.

Como usar o QwQ-32B (Use o QwQ-32B)

O breve exemplo a seguir mostra como usar o modelo QwQ-32B por meio dos transformadores Hugging Face e da API AliCloud DashScope.

via Hugging Face Transformers.

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/QwQ-32B"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "How many r's are in the word \"strawberry\""

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(response)

Via API do AliCloud DashScope.

from openai import OpenAI

import os

# Initialize OpenAI client

client = OpenAI(

# If the environment variable is not configured, replace with your API Key: api_key="sk-xxx"

# How to get an API Key:https://help.aliyun.com/zh/model-studio/developer-reference/get-api-key

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1"

)

reasoning_content = ""

content = ""

is_answering = False

completion = client.chat.completions.create(

model="qwq-32b",

messages=[

{"role": "user", "content": "Which is larger, 9.9 or 9.11?"}

],

stream=True,

# Uncomment the following line to return token usage in the last chunk

# stream_options={

# "include_usage": True

# }

)

print("\n" + "=" * 20 + "reasoning content" + "=" * 20 + "\n")

for chunk in completion:

# If chunk.choices is empty, print usage

if not chunk.choices:

print("\nUsage:")

print(chunk.usage)

else:

delta = chunk.choices[0].delta

# Print reasoning content

if hasattr(delta, 'reasoning_content') and delta.reasoning_content is not None:

print(delta.reasoning_content, end='', flush=True)

reasoning_content += delta.reasoning_content

else:

if delta.content != "" and is_answering is False:

print("\n" + "=" * 20 + "content" + "=" * 20 + "\n")

is_answering = True

# Print content

print(delta.content, end='', flush=True)

content += delta.content

Trabalho futuro

O lançamento do QwQ-32B marca uma etapa inicial, porém crítica, na ampliação do aprendizado por reforço (RL) para raciocínio aprimorado com a família de modelos Qwen. Por meio dessa exploração, a Aliyun não apenas testemunhou o enorme potencial de aplicações ampliadas da aprendizagem por reforço, mas também reconheceu o potencial inexplorado dos modelos de linguagem pré-treinados.

Olhando para o desenvolvimento da próxima geração de modelos "Mil Perguntas", a Aliyun está confiante. Eles acreditam que, ao combinar um modelo de base mais robusto com técnicas de aprendizagem por reforço, com recursos de computação em escala, espera-se acelerar o objetivo final da Inteligência Artificial Geral (AGI). Além disso, a AliCloud está explorando ativamente uma integração mais profunda dos agentes com a RL para possibilitar recursos de raciocínio de longo alcance e está comprometida em desbloquear maior inteligência por meio do dimensionamento no ponto de inferência.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...