Implementação nativa do Windows do chatbot inteligente WeChat com base no DeepSeek-R1

Bom ano novo! Saudações a todos vocês! Recentemente, meu círculo de amigos tem sido DeepSeek-R1 Tenho certeza de que todos vocês já ouviram falar do DeepSeek, nosso modelo de código aberto desenvolvido internamente! Acredito que você já tenha ouvido falar do nosso modelo doméstico de código aberto - DeepSeek. Os tutoriais on-line sobre como implantar localmente o DeepSeek-R1 têm sido bastante numerosos. Hoje, vamos fazer algo diferente, combinado com exemplos práticos, de mãos dadas para levá-lo a brincar com o DeepSeek-R1 e ver como ele é realmente poderoso! O primeiro passo é usar o DeepSeek-R1 para implantar um novo sistema em um ambiente local!

Esta edição compartilha principalmente como usar o DeepSeekR1 local para acessar o WeChat e criar um chatbot inteligente do WeChat! As etapas de implementação são divididas em três partes principais: implantação local do Ollama, acesso ao WeChat, modificação da configuração.

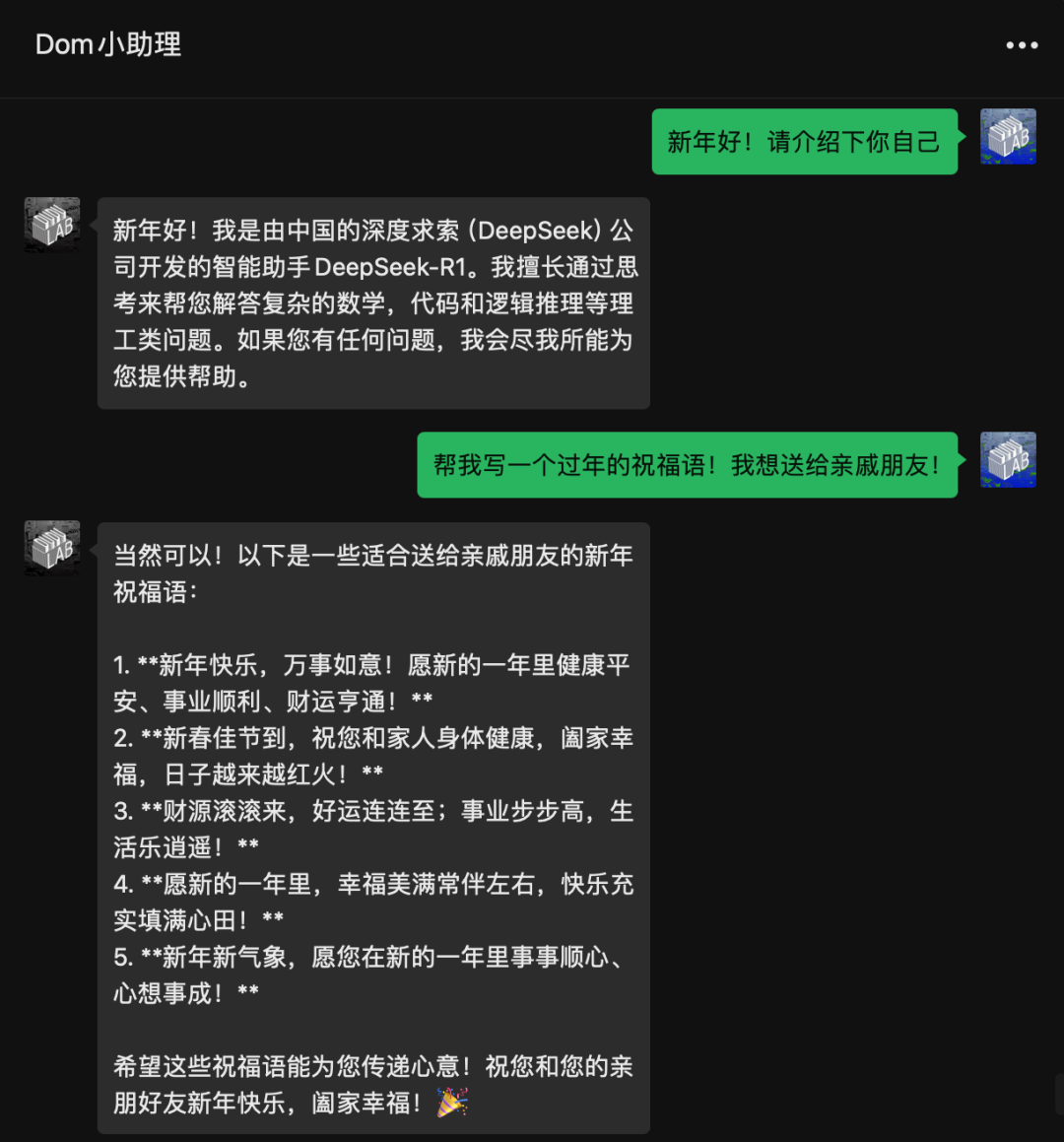

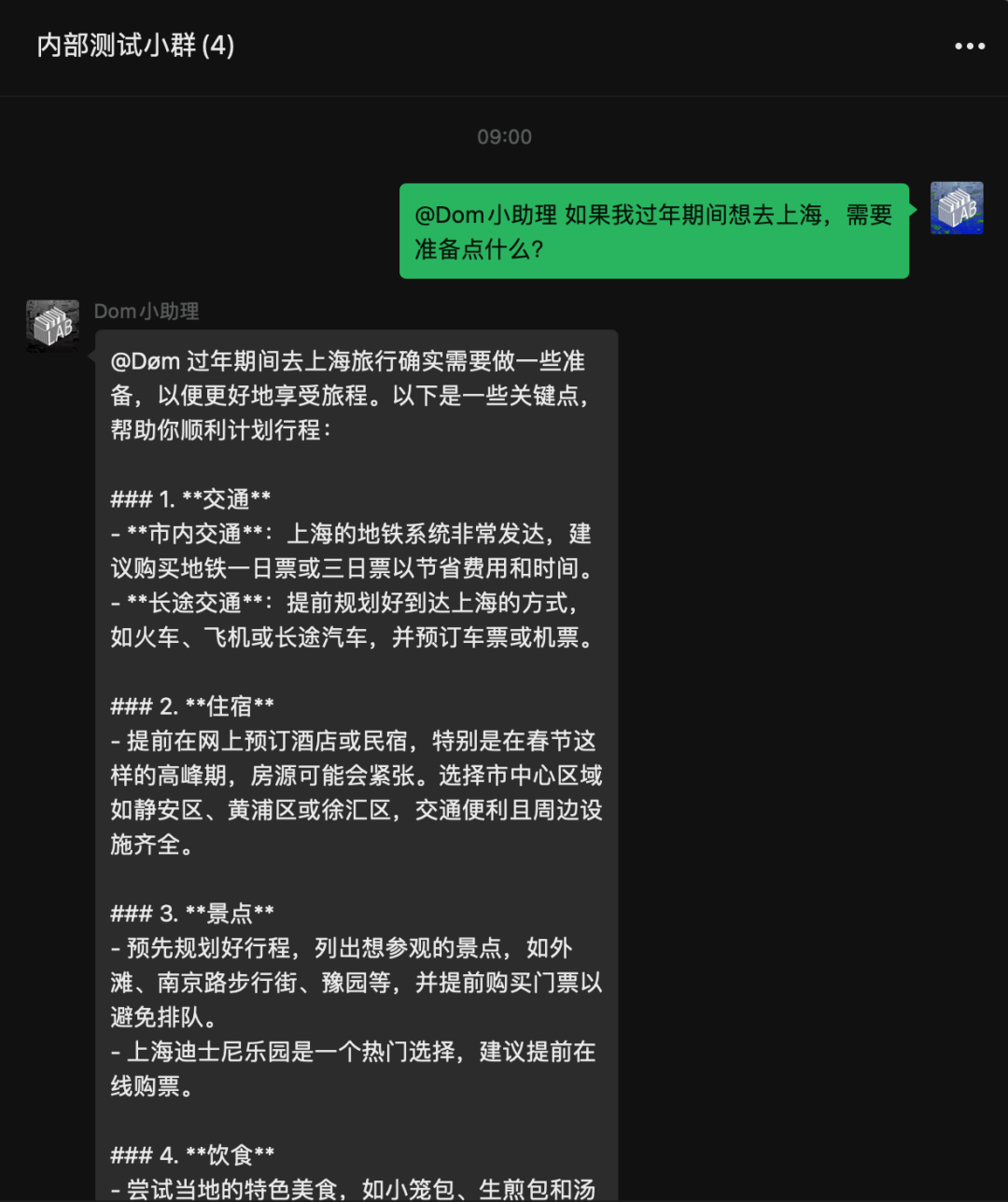

Aqui está o efeito do acesso! Tudo localizado! Não há necessidade de acessar a API do DeepSeek.

Todo o processo não é difícil e leva cerca de 10 minutos. Encapsulei toda a complexidade do trabalho, portanto, tudo o que você precisa fazer é baixá-lo, instalá-lo e executá-lo!

Implementação local do DeepSeek-R1

Primeiro, você precisa implantar o DeepSeek-R1 localmente. Se você não conseguir instalar o DeepSeek-R1 localmente, vá para a próxima etapa:Implementando o modelo de código aberto DeepSeek-R1 on-line com potência de GPU gratuita

Deve-se observar que as versões 1.5B, 7B, 8B e assim por diante são as versões "destiladas" do Qwen/llama que são aprimoradas pelo raciocínio do R1, e não o R1 real. Você pode simplesmente entender que não é um R1 puro-sangue, e a experiência é uma mistura de Qwen2.5-1.5B ou llama+R1. A versão completa do 671B é o R1 real. Obviamente, nossa placa de vídeo para consumidores em geral não é capaz de reproduzir a versão completa do 671B, portanto, use primeiro a versão destilada para jogar.

Instalação da Ollama

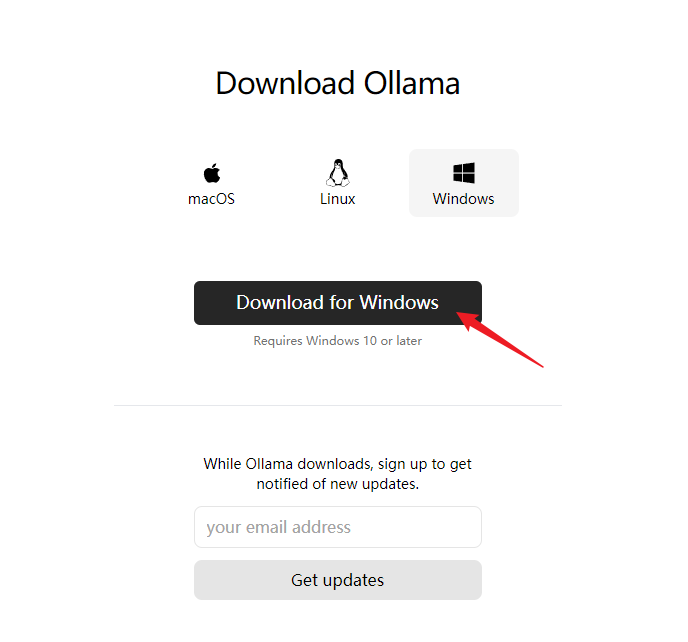

Aqui, usamos a ferramenta Ollama, que coloquei em minha unidade de rede, ou você pode baixá-la do site oficial.

site oficial

https://ollama.com/

Faça o download da versão para Windows (aqui para dizer que, no momento, devido às limitações do WeChat, o acesso ao WeChat é compatível apenas com a plataforma Windows)

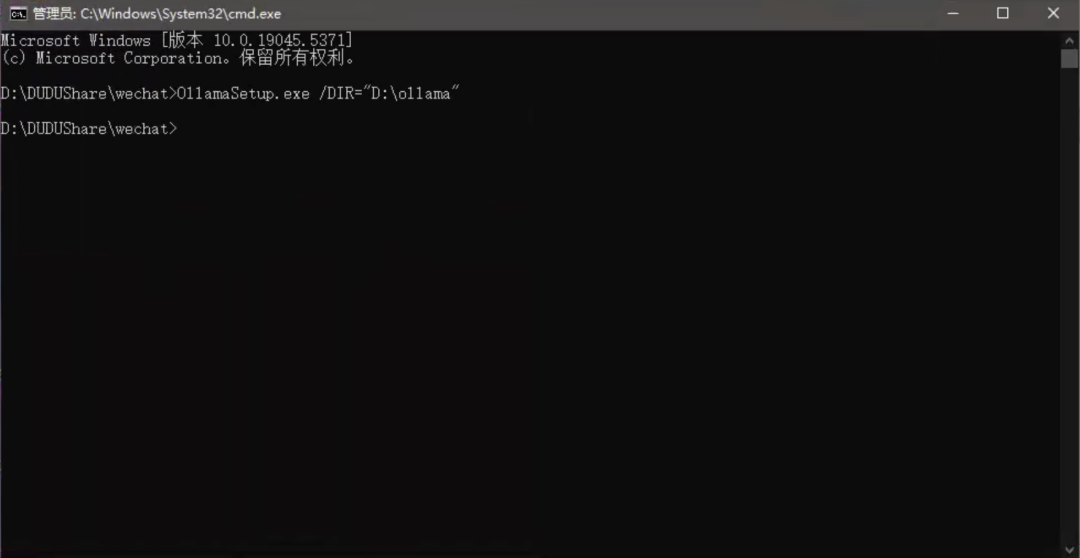

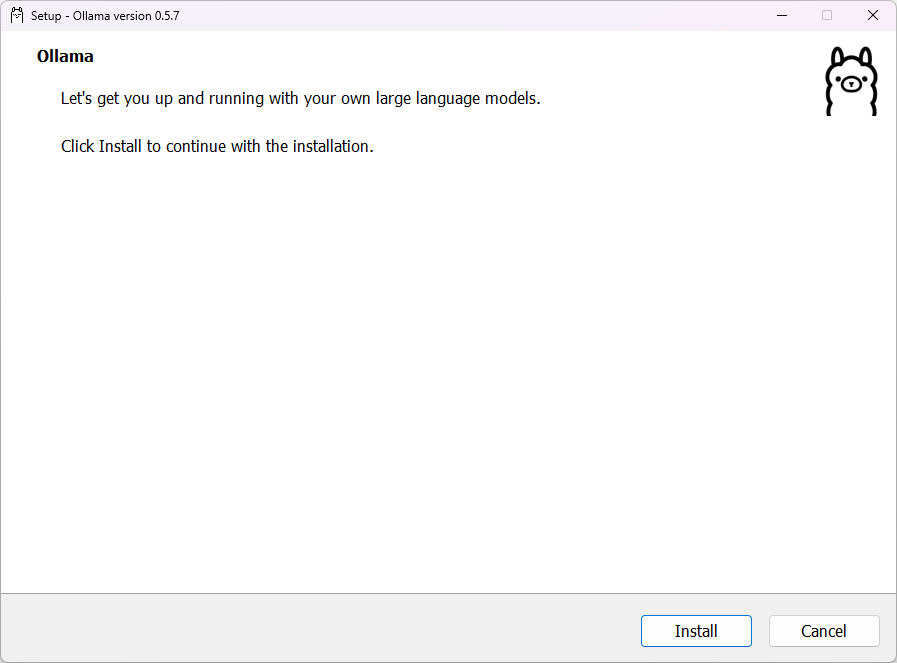

Configuração dos caminhos de instalação e do modelo

Abra o instalador para instalar; por padrão, ele é instalado na unidade C. Você pode fazer isso digitando na linha de comando mais/DIR=para especificar o caminho de instalação.

OllamaSetup.exe /DIR="D:ollama"

Se você já instalou o Ollama na unidade C, mas deseja alterar o diretório de instalação.

Definir esse caminho comoOllamaMova a pasta para o diretório onde você deseja instalar

C:Users你的用户名AppDataLocalProgramsOllama

por exemplo

E:Ollama

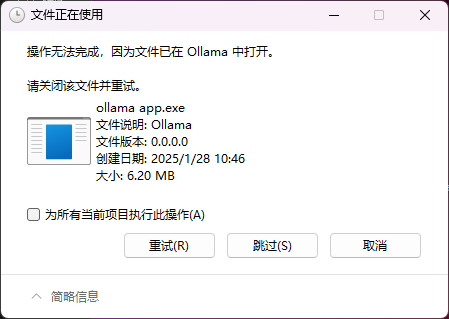

Você pode encontrar o seguinte problema ao se mover, pois isso se deve ao fato de que, após a instalação doOllamaEle já é iniciado por padrão.

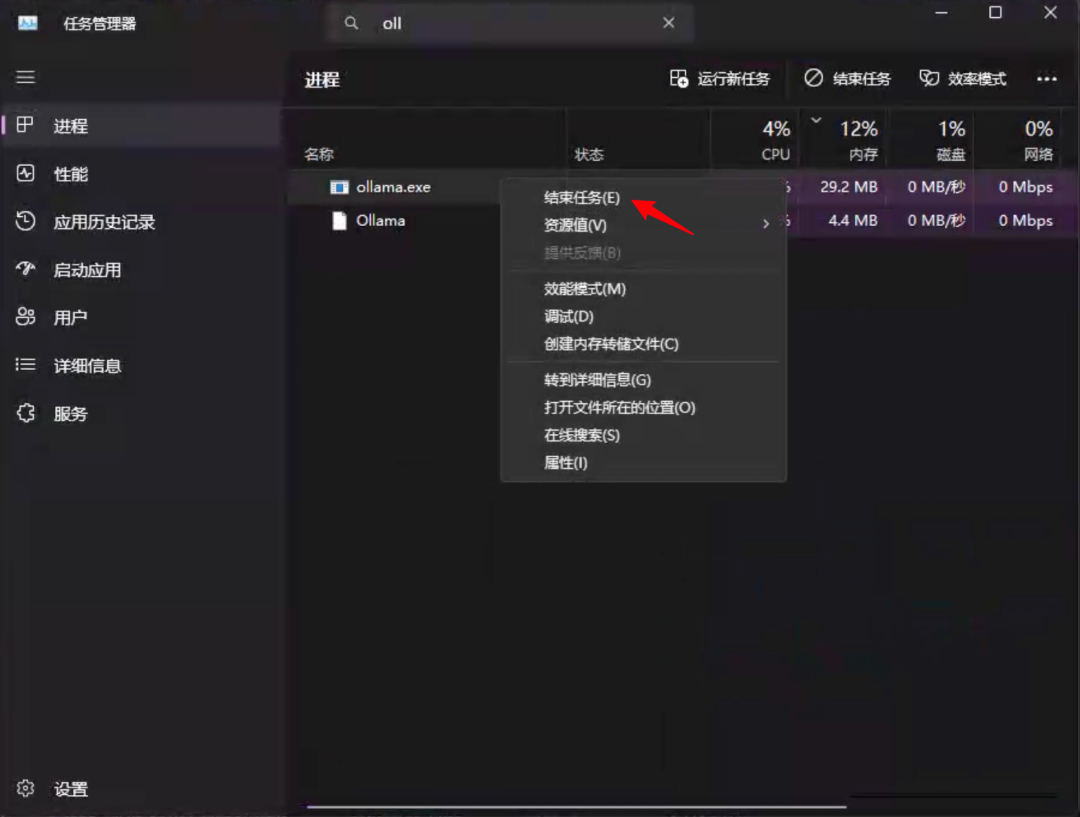

Ele precisa ser encontrado no gerenciador de tarefasOllamaresponder cantandoollama.exePara ambos os processos, clique com o botão direito do mouse em结束任务. Ela precisa ser fechada primeiroOllamareligamentoollama.exe.

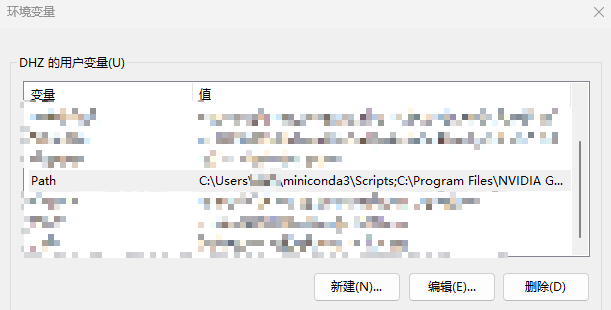

Em seguida, você precisará alterar as variáveis de ambiente

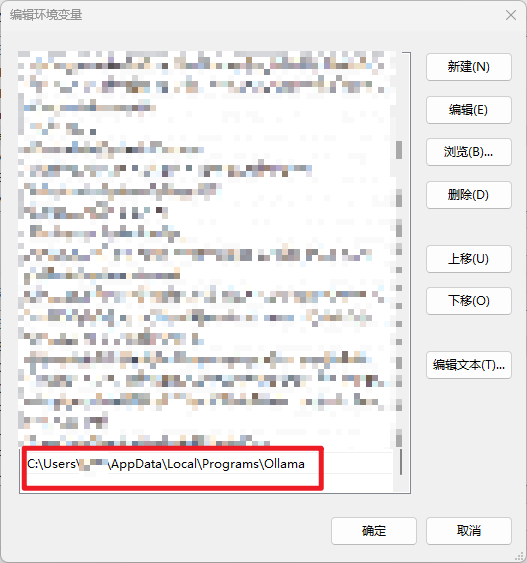

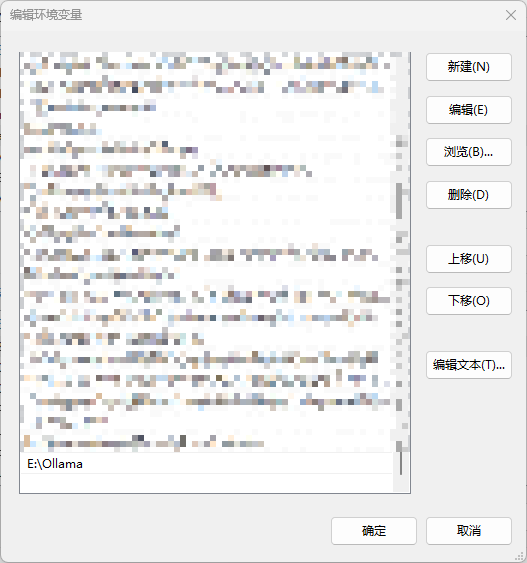

Abra Settings-Advanced System Settings-Environmental Variables-Find Path (Configurações-Avançadas do Sistema-Variáveis Ambientais-Encontrar Caminho) e clique duas vezes para editar.

Localize-o na unidade C.Ollamatrilhas

Mude para o diretório que você especificou

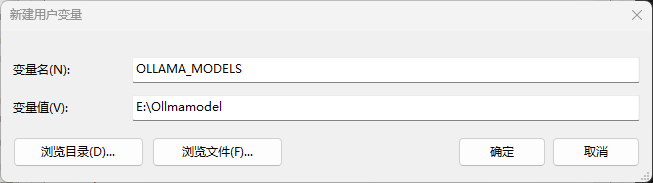

Adicionar uma nova variável de usuárioOLLAMA_MODELSEsse é o local onde o modelo baixado é armazenado. Se você não o definir, ele estará na pasta do usuário na unidade C por padrão.

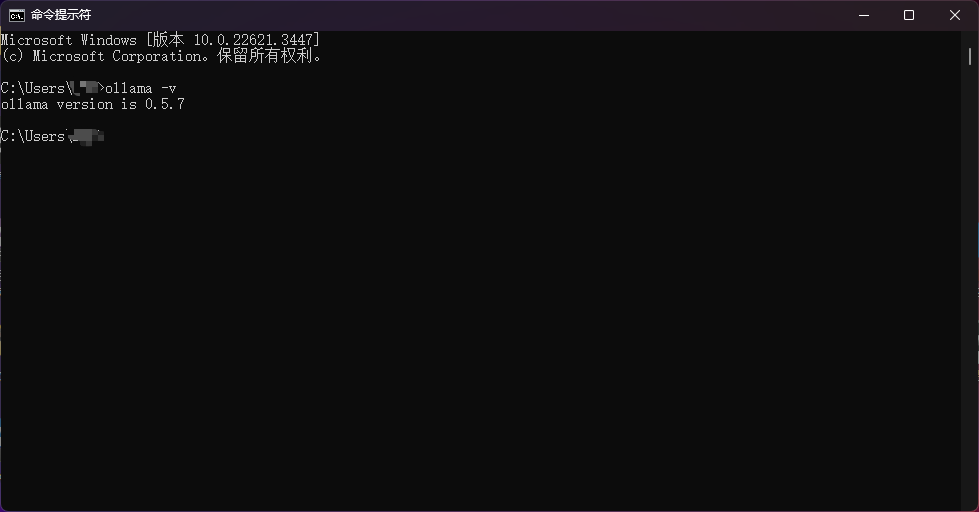

Depois que todos os itens acima estiverem configurados, na linha de comando, digiteollama -vVerifique se funcionou.

Modelos para download

https://ollama.com/library/deepseek-r1:1.5b

Vá para a página para ver todos os modelos atualmente disponíveis para a R1

Aqui está a memória de vídeo correspondente necessária para executar o modelo.

- deepseek-r1:1.5b - 1-2G de memória de vídeo

- deepseek-r1:7b - 6-8G de memória gráfica

- deepseek-r1:8b - 8G de memória de vídeo

- deepseek-r1:14b - 10-12G de memória de vídeo

- deepseek-r1:32b - Memória de vídeo 24G-48

- deepseek-r1:70b - Memória de vídeo 96G-128

- deepseek-r1:671b - requer 496 GB de memória de vídeo ou mais!

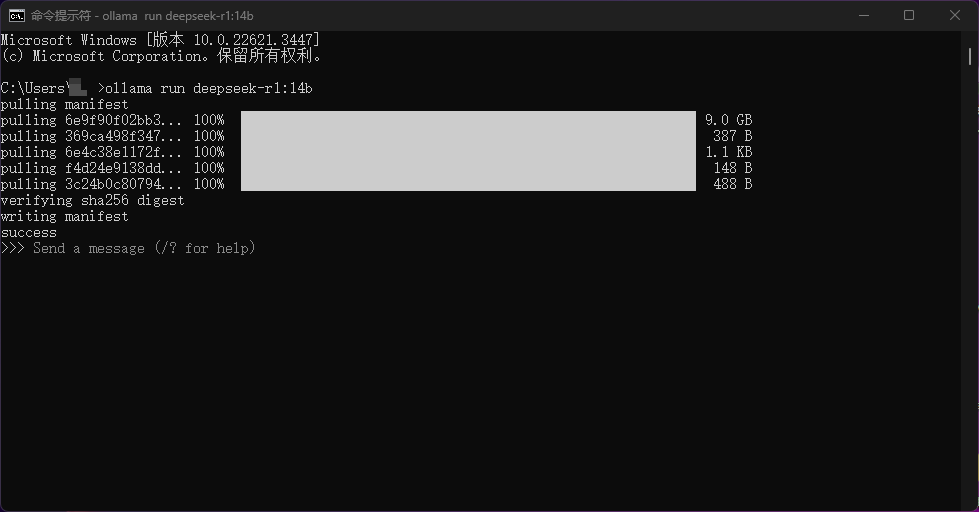

Selecione o modelo correspondente de acordo com a configuração do seu computador, cole o comando na linha de comando e execute-o. O modelo será baixado automaticamente. Por exemplo, o que eu executei aqui foiollama run deepseek-r1:14b

Também preparei um modelo de 1,5 B e um modelo de 14 B no diretório da Web. Se você não tiver uma boa conexão com a Internet, poderá descompactar o modelo diretamente no caminho do modelo e executá-lo, sem precisar usá-lo novamente!ollamaFaça o download.

Implante o BOT para acessar o WeChat

Quando tiver realizado essa etapa, você estará mais perto do sucesso! As etapas restantes são muito simples!

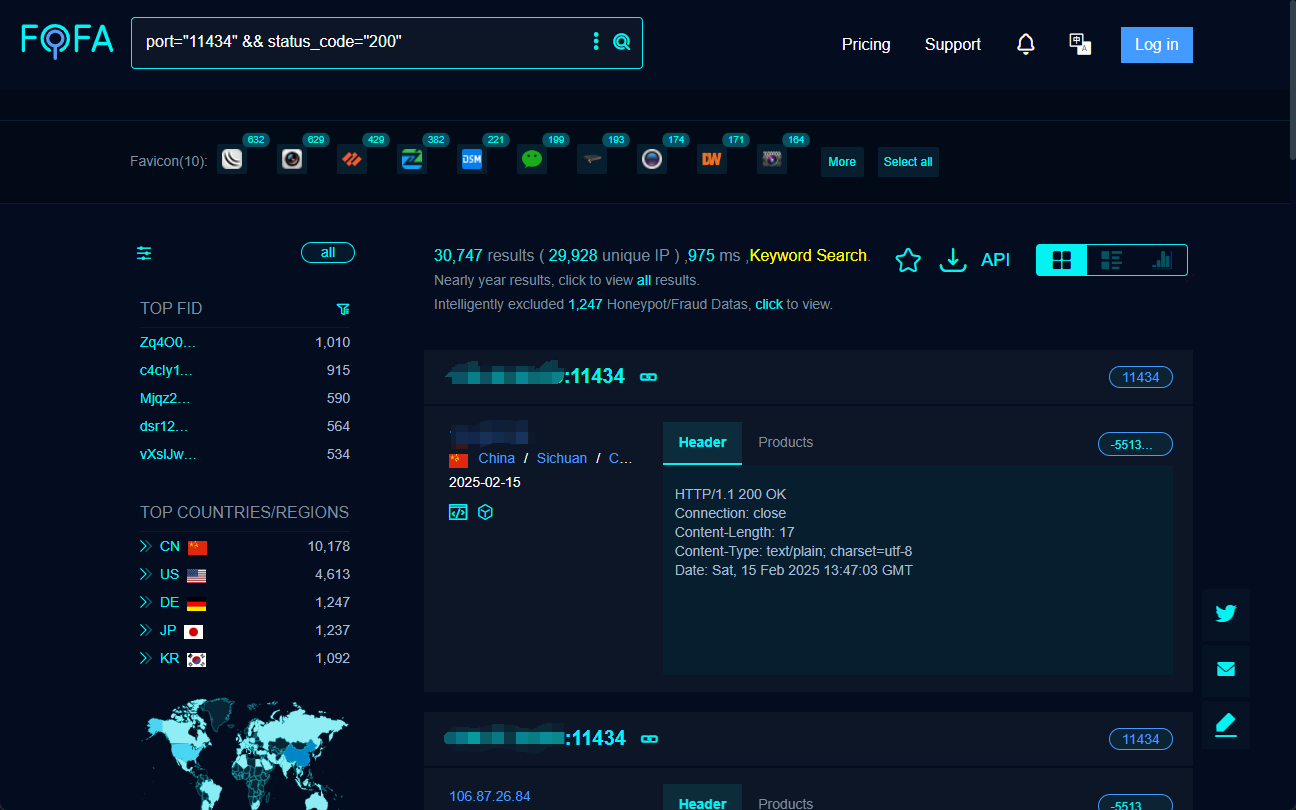

Precisamos usar oNGCBotEsse projeto para colocar aDeepSeekAcesso ao WeChat

Endereço do projeto:

https://github.com/ngc660sec/NGCBot

O projeto original oferece suporte ao acesso à API de plataformas como Xunfei Starfire, kimi, gpt, deepseek e assim por diante.Mas para o acesso local ao DeepSeek não é compatível, fiz as seguintes modificações no projeto original com código-fonte aberto!Você é bem-vindo para participar da manutenção!

- Suporte para deepseek local

- Escudo de proteção

- Suporte ao diálogo contextual

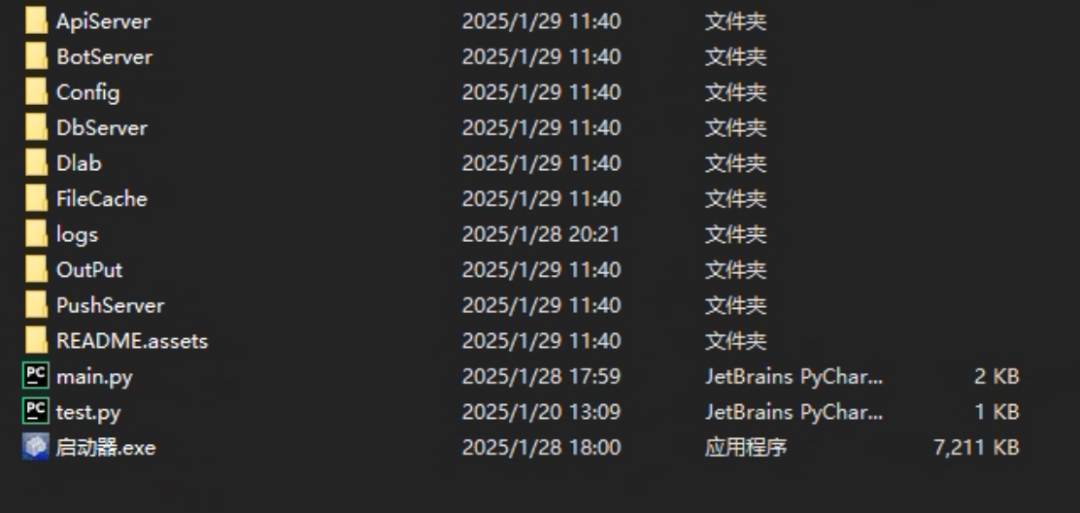

Coloque o netbook noNGCBot.zipDesembalagem

Descompacte e clique duas vezes no iniciador para abrir o projeto

O projeto abrirá automaticamente seu WeChat, que será solicitado nesse momento:只支持64位微信ou当前微信版本不支持

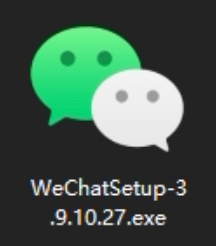

Isso ocorre porque a versão do WeChat instalada em nosso computador é muito nova.NGCBotÉ necessário instalar uma versão específica.

Instale a versão do WeChat que preparei e reabra a janelaNGCBotProjeto, deslize o dedo para fazer login no WeChat e pronto!

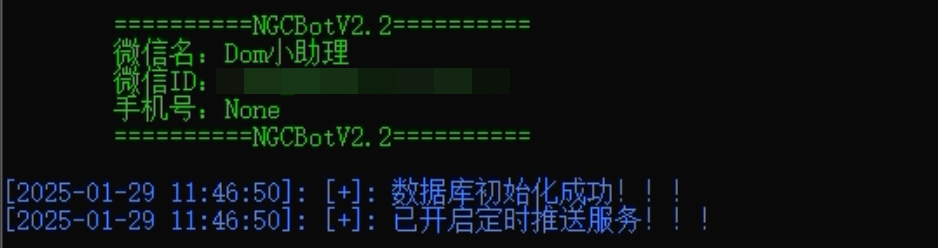

Quando o seguinte é exibido no iniciador, isso prova que o serviço foi inicializado com êxito.

Nesse momento, enviamos uma mensagem para o usuário conectado no WeChat para testá-la.

Pronto!

Modificar a configuração do BOT

Não, o robô está pronto! Não fique tão feliz! Há outra coisa que você precisa saber.NGCBotdefinições de configuração!

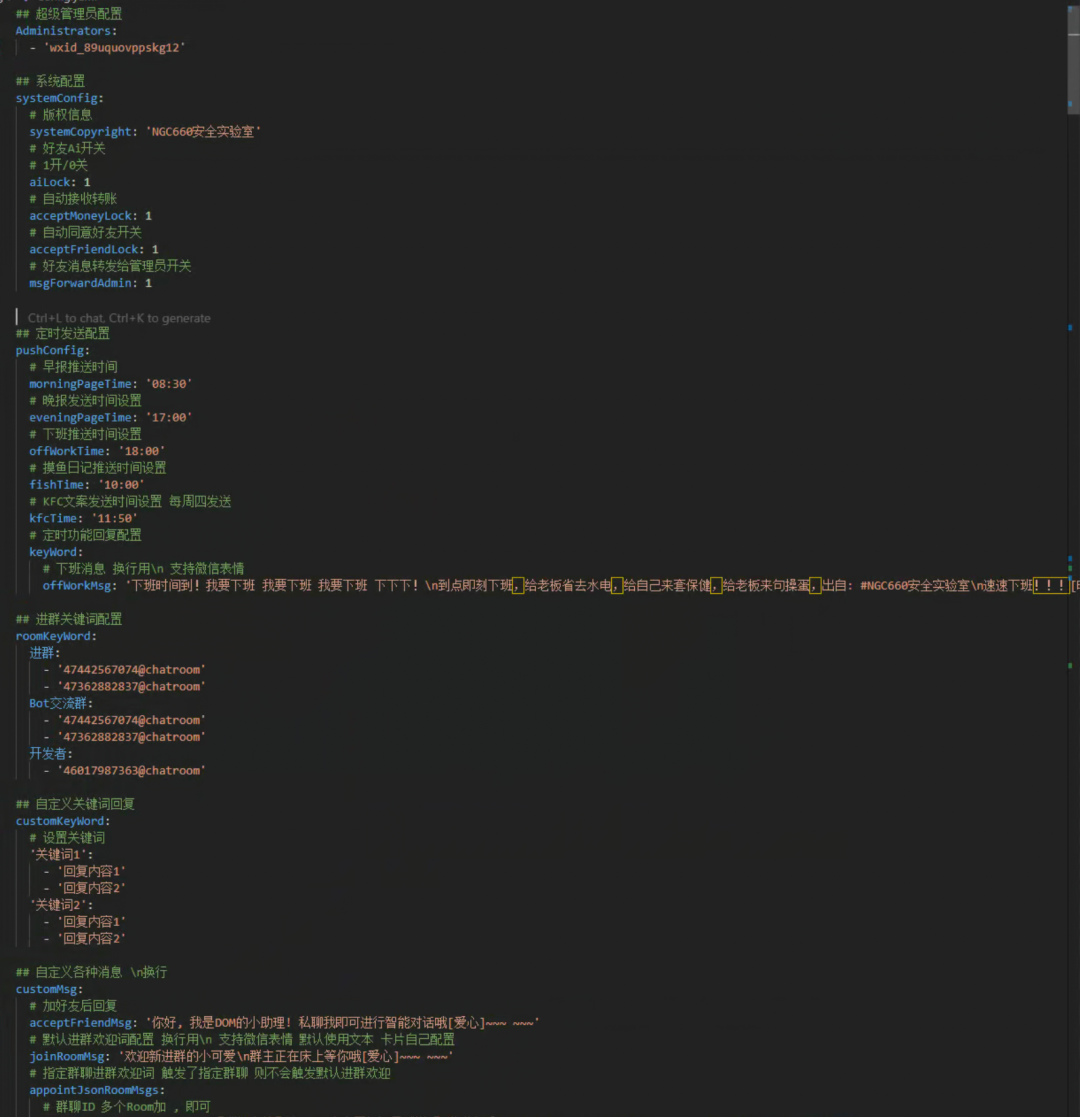

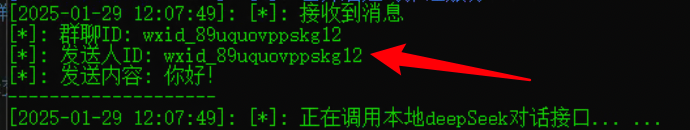

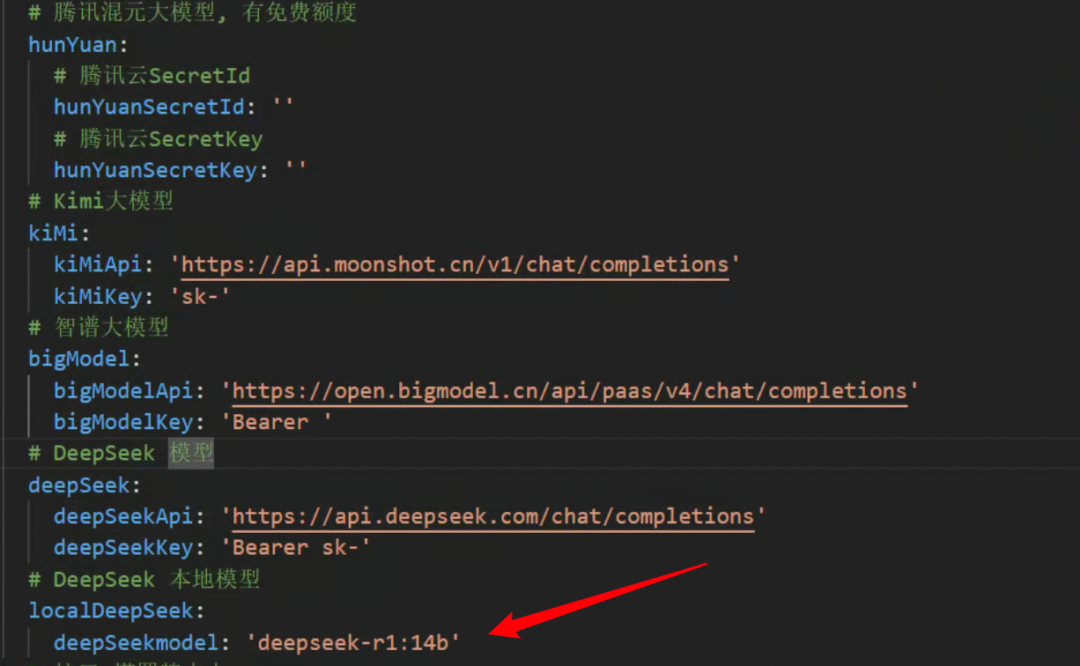

show (um ingresso)NGCBotno diretório raiz do projeto.Config/Config.yamlpapéis

Apenas duas configurações necessárias são descritas aqui, e você pode verificar os detalhes oficiais para as demais.

A primeira é uma modificação超级管理员配置Aqui, preencha o ID de seu outro weibo, o weibo do administrador.

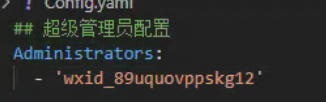

A identificação pode ser obtida copiando qualquer mensagem enviada ao robô de outro micro-sinal para esse micro-sinal.

A segunda opção é modificarlocalDeepSeekinferiordeepSeekmodelO nome do modelo no arquivo

O modelo que você instalou com o ollama é preenchido aqui.

Depois de concluir as etapas acima, parabéns, você tem uma versão local do chatbot da Microsoft DeepSeek-R1.

problemas

- P: O MAC pode ser acessado?

- R: Não.

NGCBotO projeto é compatível apenas com o Windows, mas o Ollama pode ser implantado. - P: Preciso estar conectado ao WeChat o tempo todo? Não posso desativá-lo?

- R: Sim, é equivalente a fazer login na versão Windows do WeChat, o telefone celular pode conversar normalmente, mas certamente não pode ser executado normalmente depois de desligar o computador. Se você quiser executá-lo continuamente, é recomendável implantá-lo em um servidor em nuvem.

- P: É o mesmo que o anterior?

chatgpt-on-wechatQual é a diferença? - R: Os protocolos são diferentes e, há algum tempo, o microfilme envolveu o

chatgpt-on-wechatusada, portanto, atualmente, essa interface baseada em HookNGCBotO projeto ainda é muito estável.

Aquisição de pacotes de integração

Versão Tootsie Lab:

Quark: https://pan.quark.cn/s/bc26b60912da

Baidu:https://pan.baidu.com/s/1QKFWV1tMti9s4m9K_HAPFg?pwd=428a

escrever no final

Recebi uma mensagem privada há um ano dizendochatgpt-on-wechatEssa interface de projeto foi bloqueada pelos funcionários do WeChat e foi planejada para ser combinada com oCOZECompartilhe.NGCBotEsse projeto, hahaha, é perfeitoDeepSeek-R1Em toda a linha! E assim . ... COZE, vamos deixar isso em segundo plano por enquanto! Feliz Ano Novo a todos, estou indo comer bolinhos de massa .....

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...