Os produtos para PC Microsoft Azure+Copilot+AI suportam totalmente os modelos DeepSeek R1

Em 30 de janeiro de 2025, a Microsoft informou que o modelo R1 do DeepSeek já está disponível em sua plataforma de computação em nuvem Azure e nas ferramentas do GitHub para desenvolvedores em geral. A Microsoft também disse que, em breve, os clientes poderão usar o modelo R1 do DeepSeek em seus Copiloto + Execute o modelo R1 localmente no PC.

Como mencionamos anteriormente, o copiloto usará gradualmente outros grandes modelos além do OpenAI:

A Microsoft tem sido notícia mais recentemente, e um dos itens mais notáveis é que aO copiloto do GitHub é gratuito e aberto!embora em menor número (2.000 por mês para conclusões de código e 50 por mês para conversas de bate-papo), mas pelo menos é um evento marcante, e o modelo foi expandido do único GPT 4o original para o1 Claude responder cantando Gêmeos e muitos outros modelos.

O que isso realmente significa é que a Microsoft está se afastando de sua dependência da tecnologia OpenAI, que, de certa forma, não é mais o melhor modelo e não é mais, infelizmente, o mais econômico para operar.

Como resultado da recente busca profunda A influência mais poderosa no mundo, uma série de novos recursos atraentes continuam a ser disponibilizados on-line, mas também causaram a competição de vida ou morte entre a China e os Estados Unidos no campo da IA. A Microsoft, a fim de tornar o copiloto mais compatível com o idioma chinês, está pronta para usar o modelo R1 da deepseek no copiloto.

O CEO da Microsoft, Indian, também enfatizou na chamada que os modelos DeepSeek R1 estão agora disponíveis por meio da plataforma de IA da Microsoft, Azure AI Foundry e GitHub, e em breve serão executados em computadores Copilot+. Nadella disse que o DeepSeek "tem algumas inovações reais" e que o custo da IA está tendendo para baixo: "A Lei de Escalonamento está se acumulando nos cálculos de tempo de pré-treinamento e inferência. Ao longo dos anos, observamos melhorias significativas na eficiência do treinamento e da inferência de IA. No lado da inferência, normalmente vemos uma melhoria de mais de 2x no preço/desempenho por geração de hardware e uma melhoria de mais de 10x no preço/desempenho por geração de modelos."

Ficamos felizes em ver isso.

O copilot for Microsoft 365 é um plug-in nativo do copilot para o Office 365 (Word, Excel, Ppt, OneNote, teams etc.), que pode gerar conteúdo com base em outros arquivos no Word, gerar fórmulas e cálculos no Excel, criar apresentações com base em outros arquivos no PPT Você também pode criar apresentações a partir de outros documentos no PPT, organizar anotações e gerar mais anotações no OneNote, resumir reuniões em equipes e muito mais.

Leitura relacionada 1: "Executando modelos DeepSeek R1 otimizados por destilação localmente em PCs Copilot+

A IA está se movendo para a borda, e os PCs Copilot+ estão liderando o caminho. À medida que o Azure AI Foundry entra em operação com o DeepSeek R1 hospedado na nuvem (leitura relacionada2), estamos trazendo uma versão otimizada para NPU do DeepSeek-R1 diretamente para os PCs Copilot+, com as primeiras adaptações para a plataforma Qualcomm Snapdragon X, seguidas de suporte para plataformas como Intel Core Ultra 200V. A primeira versão do DeepSeek-R1-Distill-Qwen-1.5B estará disponível no AI Toolkit, com as versões 7B e 14B a seguir. Esses modelos otimizados permitem que os desenvolvedores criem e implementem aplicativos de IA que são executados com eficiência no dispositivo, aproveitando ao máximo a potência da NPU nos PCs Copilot+.

A NPU (Neural Processing Unit, unidade de processamento neural) do Copilot+ PC oferece um mecanismo altamente eficiente para inferência de modelos, abrindo um novo paradigma para que a IA generativa não seja apenas executada sob demanda, mas também permita serviços de execução semicontínua. Isso permite que os desenvolvedores criem experiências contínuas proativas com mecanismos de inferência avançados. Por meio do acúmulo de tecnologias do projeto Phi Silica, conseguimos uma inferência eficiente, minimizando a duração da bateria e o consumo de recursos do sistema e, ao mesmo tempo, garantindo tempos de resposta competitivos no primeiro token e taxas de transferência. O modelo DeepSeek otimizado para NPU usa várias das principais tecnologias do projeto, incluindo: design modular do modelo para um equilíbrio ideal entre desempenho e eficiência, técnicas de quantificação de baixa largura de bits e estratégia de mapeamento do Transformer na NPU. Além disso, aproveitamos o Windows Copilot Runtime (WCR) para permitir o dimensionamento em todo o ecossistema do Windows por meio do formato ONNX QDQ.

Experimente agora!

Em primeiro lugar... Vamos começar rapidamente.

Para experimentar o DeepSeek em PCs Copilot+, basta fazer o download da extensão VS Code para o AI Toolkit. Os modelos DeepSeek otimizados no formato ONNX QDQ estarão disponíveis em breve no repositório de modelos do AI Toolkit e serão extraídos diretamente do Azure AI Foundry. Clique no botão "Download" para fazer o download localmente. Após o download, basta abrir o Playground, carregar o modelo "deepseek_r1_1_5" e começar a experimentar os prompts.

Além do modelo ONNX otimizado para o Copilot+ PC, você também pode usar o modelo ONNX para o Copilot+ PC clicando no botão "DeepSeek R1"Tente entrar". Playground" para experimentar o modelo original hospedado na nuvem no Azure Foundry.

O AI Toolkit é uma parte importante do fluxo de trabalho do desenvolvedor, dando suporte à experimentação de modelos e à prontidão de implantação. Com esse Playground, você pode testar facilmente os modelos do DeepSeek no Azure AI Foundry para implantação local.

Otimização em nível de chip

O modelo Qwen 1.5B otimizado para destilação contém um tokenizador, uma camada de incorporação, um modelo de processamento de contexto, um modelo de iteração de token, um cabeçalho de modelo de idioma e um módulo de destokenizador.

Usamos a quantificação de pedaços de 4 bits para a camada de incorporação e o cabeçalho do modelo de linguagem e executamos essas operações com uso intensivo de memória na CPU. Concentrando os principais recursos de otimização da NPU no módulo Transformer, que é intensivo em termos de computação e contém processamento de contexto e iteração de token, a quantização canal a canal int4 é usada e o processamento seletivo de precisão mista é implementado para os pesos, enquanto os valores de ativação usam precisão int16.

Embora a versão do Qwen 1.5B da DeepSeek tenha uma versão int4, ela não pode ser adaptada diretamente às NPUs devido à presença de formas e comportamentos de entrada dinâmicos - eles precisam ser otimizados para compatibilidade e eficiência ideal. Além disso, usamosONNX QDQpara dar suporte ao dimensionamento de vários tipos de NPUs no ecossistema do Windows. Otimizamos o layout do operador entre a CPU e a NPU para obter o melhor equilíbrio entre o consumo de energia e a velocidade.

Para atingir os objetivos duplos de baixo consumo de memória e inferência rápida (semelhante ao esquema Phi Silica), fizemos dois aprimoramentos importantes: primeiro, adotamos um design de janela deslizante, que permite um tempo de resposta ultrarrápido do primeiro Token e suporte a contexto longo, mesmo quando a pilha de hardware não oferece suporte a tensor dinâmico; e, segundo, usamos um esquema de quantificação QuaRot de 4 bits, que aproveita ao máximo o processamento de baixa largura de bits. O QuaRot elimina as discrepâncias nos pesos e nos valores de ativação por meio da rotação Hadamard, facilitando a quantificação do modelo. Em comparação com os métodos existentes, como o GPTQ, o QuaRot melhora significativamente a precisão da quantificação, especialmente em cenários de baixa granularidade, como a quantificação canal a canal. A combinação de quantificação de baixa largura de bits e otimizações de hardware, como o design da janela deslizante, permite que o modelo atinja as propriedades comportamentais de um modelo grande com um espaço de memória compacto. Como resultado dessas otimizações, o modelo atinge um tempo de resposta do primeiro token de 130 ms e uma taxa de transferência de 16 tokens/segundo em cenários de dicas curtas (<64 tokens).

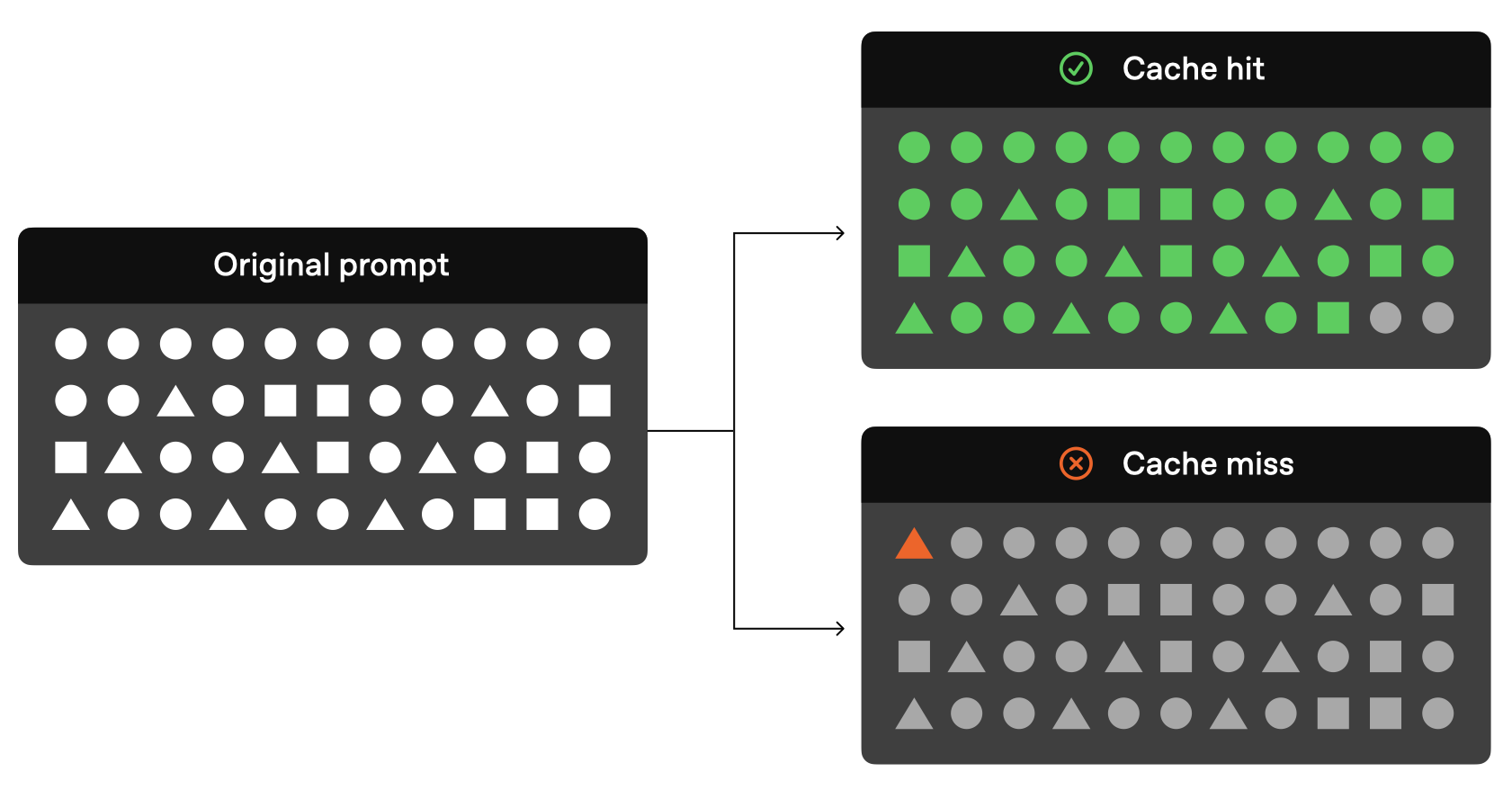

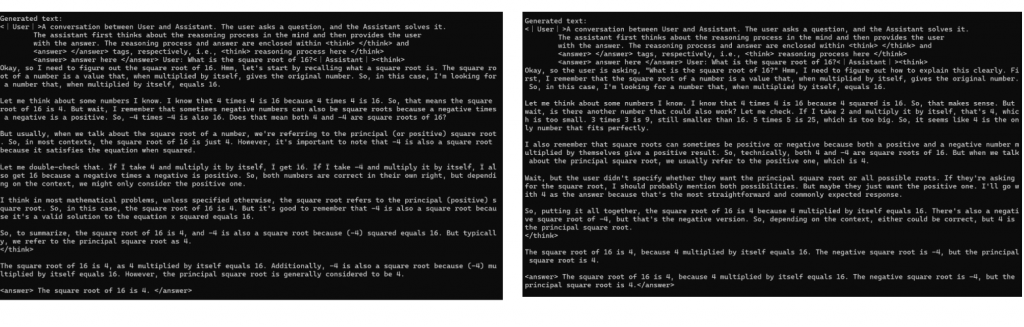

Demonstramos as diferenças sutis entre a resposta do modelo original e a resposta do modelo quantitativo com o exemplo a seguir, que alcança a otimização da eficiência energética e mantém o alto desempenho:

Fig. 1: Comparação qualitativa. Exemplos do modelo original (esquerda) e do modelo otimizado da NPU (direita) respondendo às mesmas dicas, incluindo uma demonstração do poder de raciocínio do modelo. O modelo otimizado mantém o padrão de raciocínio do modelo original e chega à mesma conclusão, demonstrando que mantém intacto o poder de raciocínio do modelo original.

Com a velocidade superior e o desempenho de eficiência energética dos modelos DeepSeek R1 otimizados por NPU, os usuários poderão interagir com esses modelos inovadores localmente e de forma totalmente autônoma.

Leitura relacionada 2: "DeepSeek R1 agora disponível no Azure AI Foundry e no GitHub

O DeepSeek R1 já está disponível Fundição de IA do Azure e o catálogo de modelos do GitHub, juntando-se a um portfólio diversificado de mais de 1.800 modelos que abrangem modelos de IA de ponta, de código aberto, específicos do setor e orientados para tarefas. Como parte do Azure AI Foundry, o DeepSeek R1 pode ser acessado por meio de uma plataforma confiável, dimensionável e pronta para a empresa, que permite que as organizações integrem perfeitamente tecnologias avançadas de IA, atendendo aos SLAs, à segurança e à promessa de IA responsável - tudo com o apoio da confiabilidade e da inovação da Microsoft. tudo isso com o apoio da confiabilidade e da inovação da Microsoft.

Acelerando o raciocínio de IA para os desenvolvedores do Azure AI Foundry

O raciocínio de IA está ganhando popularidade em um ritmo alarmante, mudando a maneira como os desenvolvedores e as empresas aplicam a inteligência de ponta. Como explica a DeepSeek, o R1 fornece modelos avançados e econômicos que permitem que mais usuários acessem os recursos mais avançados de IA com um investimento mínimo em infraestrutura.

O principal benefício de usar o DeepSeek R1 ou outros modelos no Azure AI Foundry é a velocidade com que os desenvolvedores podem experimentar, iterar e integrar a IA em seus fluxos de trabalho. Com ferramentas de avaliação de modelos incorporadas, os desenvolvedores podem comparar rapidamente os resultados, avaliar benchmarks de desempenho e dimensionar aplicativos orientados por IA. Esse acesso rápido, inimaginável há apenas alguns meses, é o cerne da nossa visão para o Azure AI Foundry: reunir os melhores modelos de IA em um só lugar, acelerando a inovação e liberando novas possibilidades para organizações em todo o mundo.

Desenvolvendo com IA confiável

Temos o compromisso de ajudar nossos clientes a criar rapidamente aplicativos de IA prontos para produção e, ao mesmo tempo, manter os mais altos padrões de segurança. O deepSeek R1 passou por rigorosos "testes de equipe vermelha" e avaliações de segurança, incluindo avaliações automatizadas do comportamento do modelo e uma análise de segurança abrangente para mitigar possíveis riscos. A filtragem de conteúdo integrada é ativada por padrão com opções flexíveis de desativação por meio do Azure AI Content Security. Além disso, um sistema de avaliação de segurança ajuda os clientes a testar aplicativos com eficiência antes da implantação. Essas proteções permitem que o Azure AI Foundry forneça às organizações um ambiente seguro, compatível e responsável para a implantação de soluções de IA.

Como usar o DeepSeek em um catálogo de modelos

- Se você não tem uma assinatura do Azure, agora podeRegistre-se para obter uma conta do Azure

- Procure o DeepSeek R1 no catálogo de modelos

- Abra o cartão de modelo no catálogo de modelos do Azure AI Foundry

- Clique em "Deploy" para obter a API de inferência e a chave e acessar o banco de testes

- Você será levado à página de implementação que mostra a API e a chave em 1 minuto e poderá tentar inserir os prompts no banco de testes

- A API e a chave podem ser usadas por uma variedade de clientes

Comece agora

O DeepSeek R1 agora está acessível por meio de um ponto de extremidade sem servidor no catálogo de modelos do Azure AI Foundry.Acesse o Azure AI Foundry hoje mesmo e selecione o modelo DeepSeek.

Explore mais recursos e obtenha um guia passo a passo para integrar perfeitamente o DeepSeek R1 em seu aplicativo no GitHub. Leia mais Modelos do GitHub Postagem no blog.

Em breve: os clientes poderão executar localmente em PCs Copilot+ usando um modelo básico do DeepSeek R1. Leia mais Desenvolvedor do Windows Postagem no blog.

À medida que continuamos a expandir o catálogo de modelos da Azure AI Foundry, estamos ansiosos para ver como os desenvolvedores e as empresas usam o DeepSeek R1 para enfrentar os desafios do mundo real e criar experiências transformadoras. Temos o compromisso de fornecer o portfólio mais abrangente de modelos de IA para garantir que organizações de todos os tamanhos tenham acesso a ferramentas de ponta para impulsionar a inovação e o sucesso.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...