O futuro está aqui: uma análise aprofundada da era do "modelo como produto"

Nos últimos anos, houve uma discussão interminável sobre o próximo estágio do desenvolvimento da IA: Agentização? Recursos de raciocínio mais fortes? Ou uma verdadeira fusão multimodal? Todos os tipos de especulações surgiram, sinalizando uma nova mudança no campo da IA.

Agora, acho que é hora de fazer um julgamento definitivo:A era do "modelo como produto" chegou. Isso não é apenas uma tendência, mas uma visão profunda do atual cenário de desenvolvimento de IA.

Seja na vanguarda da pesquisa acadêmica ou na direção real do mercado comercial, todos os sinais apontam claramente para essa direção transformadora.

- O aumento de escala do modelo genérico está enfrentando gargalos: O modelo de desenvolvimento "maior é melhor" do modelo genérico de grande porte está gradualmente revelando suas limitações. Isso não é apenas um desafio técnico, mas também uma consideração econômica. Como a discussão do setor após o GPT-4 revelou, a relação entre o aumento da capacidade do modelo e o aumento do custo aritmético não é simplesmente linear, mas sim uma diferença de tesoura cada vez maior. A potência dos modelos pode crescer apenas em uma taxa linear, mas o custo de treinamento e operação desses gigantes aumenta exponencialmente. Mesmo as empresas com tanta tecnologia e recursos quanto a OpenAI, sem falar em outros fornecedores, estão lutando para encontrar um modelo de negócios que possa cobrir seu enorme investimento. Isso indica que a era de depender exclusivamente da expansão dos tamanhos dos parâmetros do modelo para melhorar infinitamente os recursos de IA pode ter acabado. Precisamos encontrar caminhos mais eficientes, econômicos e sustentáveis para o desenvolvimento da IA.

- O treinamento de orientação surgiu como uma nova força, com resultados que superam em muito as expectativas: Em contraste com o desenvolvimento atrofiado de modelos genéricos, o"Treinamento opinativo". mostra um potencial incrível. Esse paradigma de treinamento enfatiza o ajuste fino e o treinamento de modelos para tarefas específicas e cenários de aplicativos. A convergência das técnicas de Aprendizado por Reforço e Raciocínio revigorou o treinamento direcionado. Em vez de simplesmente "aprender os dados", estamos vendo os modelos realmente começarem a "aprender a tarefa". Esse é um salto qualitativo que marca uma mudança na forma como a IA é pensada. Seja pelo desempenho impressionante de modelos pequenos em matemática, pela evolução dos modelos de código, de geradores de código a gerenciadores autônomos de bases de código, ou pela Claude Os casos de jogos complexos com quase nenhuma entrada de informações são a prova do poder do treinamento de orientação. Essa rota de desenvolvimento de modelos "pequenos, mas finos" e "especializados, mas fortes" pode se tornar a corrente principal dos futuros aplicativos de IA.

- Os custos de inferência de modelos caem vertiginosamente: O custo do raciocínio, antes visto como um "obstáculo" para a adoção da IA, também foi bastante atenuado. Graças a DeepSeek Com os avanços na otimização de modelos e na aceleração de inferências por empresas como a AI, o limite para a implantação e a aplicação de modelos de AI foi drasticamente reduzido. A pesquisa mais recente da DeepSeek mostra que o poder de computação da GPU existente pode, teoricamente, acomodar bilhões de pessoas em todo o mundo, cada uma usando modelos de ponta para processar 10.000 modelos de IA por dia. tokens necessidades. Isso significa que a aritmética não é mais um fator importante que restringe a popularidade da IA, e a era da aplicação em larga escala da IA está se acelerando. Para os provedores de modelos, confiar no modelo de negócios "pay-per-use" de apenas vender tokens claramente não é suficiente para explorar totalmente o valor dos modelos de IA. Eles devem buscar a extremidade superior da cadeia de valor, como o fornecimento de serviços e soluções de modelos mais verticais e especializados.

Todos esses sinais indicam que o foco do desenvolvimento do setor de IA está mudando de um "modelo geral" para um novo paradigma de "modelo como produto". Não se trata apenas de um ajuste técnico, mas também de uma mudança profunda no modelo de negócios e no padrão industrial. A filosofia tradicional de que "os aplicativos são o rei" talvez precise ser revisada. Por muito tempo, investidores e empreendedores se concentraram na camada de aplicativos de IA, acreditando que a inovação de aplicativos é a chave para a comercialização da IA. No entanto, na era do "modelo como produto", a camada de aplicativos pode ser a primeira a ser automatizada e interrompida. O foco da futura competição será nos modelos em si, e quem tiver modelos mais avançados, mais eficientes e mais profissionais poderá assumir uma posição de destaque na competição de IA.

O formato dos modelos futuros: especialização, verticalização, serviços

Nas últimas semanas, vimos dois produtos icônicos surgirem do paradigma "modelo como produto": o DeepResearch da OpenAI e o Antrópica Esses dois produtos refletem as tendências da nova geração de modelos e são um prenúncio de como serão os modelos do futuro.

O DeepResearch da OpenAI, que gerou muita atenção desde seu lançamento, foi acompanhado de muitas interpretações errôneas. Muitos o interpretaram simplesmente como um aplicativo "shell" do GPT-4 ou como uma ferramenta de aprimoramento de pesquisa baseada no GPT-4. Mas isso está longe de ser verdade. Na verdade, a OpenAI treina um modelo totalmente novo especificamente para tarefas de pesquisa e recuperação de informações. O DeepResearch não é um "fluxo de trabalho" que depende de mecanismos de pesquisa externos ou de chamadas de ferramentas, mas um verdadeiro "Modelo de linguagem de pesquisa".Possui recursos de pesquisa, navegação, integração de informações e geração de relatórios autônomos de ponta a ponta, sem nenhuma intervenção externa. Ele tem recursos de pesquisa, navegação, integração de informações e geração de relatórios autônomos de ponta a ponta, sem nenhuma intervenção externa. Qualquer pessoa que tenha usado o DeepResearch pode sentir claramente a diferença entre ele e os LLMs ou chatbots tradicionais. Os relatórios que ele gera são claramente estruturados, rigorosamente argumentados e rastreáveis de forma confiável, refletindo um profissionalismo e uma profundidade que excedem em muito as ferramentas de pesquisa e os LLMs tradicionais.

Em contraste, outros produtos no mercado que afirmam ser "Deep Search", como Perplexidade O mesmo pode ser dito em relação aos recursos do Google e do Google, que são ofuscados por eles próprios. Como aponta Hanchung Lee, esses produtos ainda são essencialmente baseados em um modelo genérico com alguns ajustes simples e sobreposições de recursos, e carecem de otimização profunda e design sistemático para a tarefa de pesquisa. O surgimento do DeepResearch marca a aterrissagem inicial do conceito de "modelo como produto" e também nos mostra a direção do desenvolvimento de modelos especializados e verticalizados.

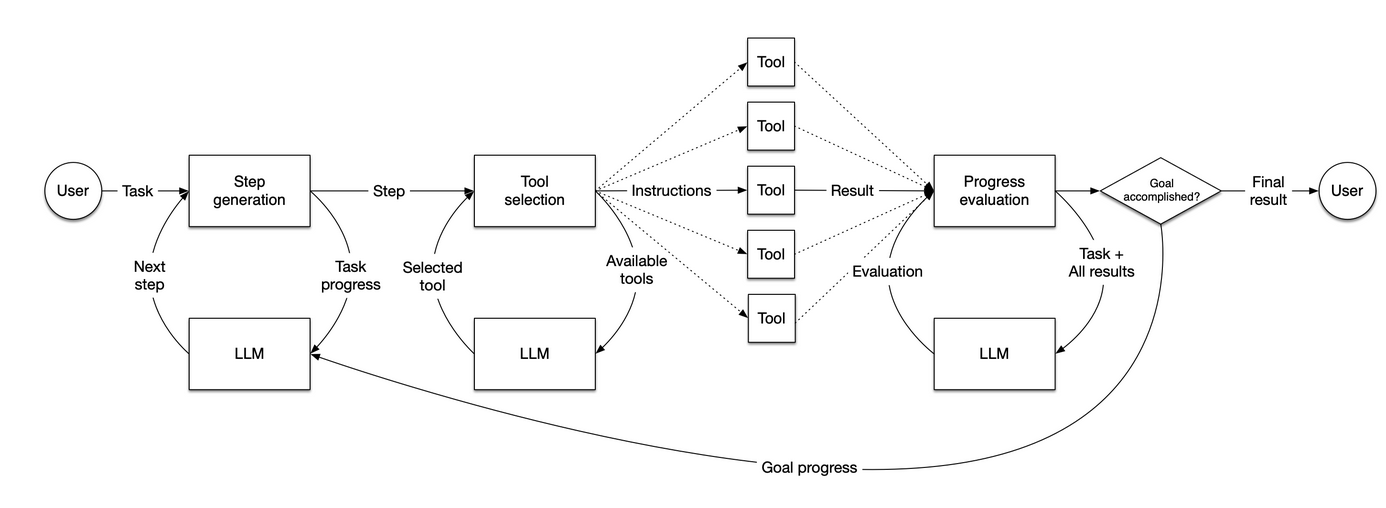

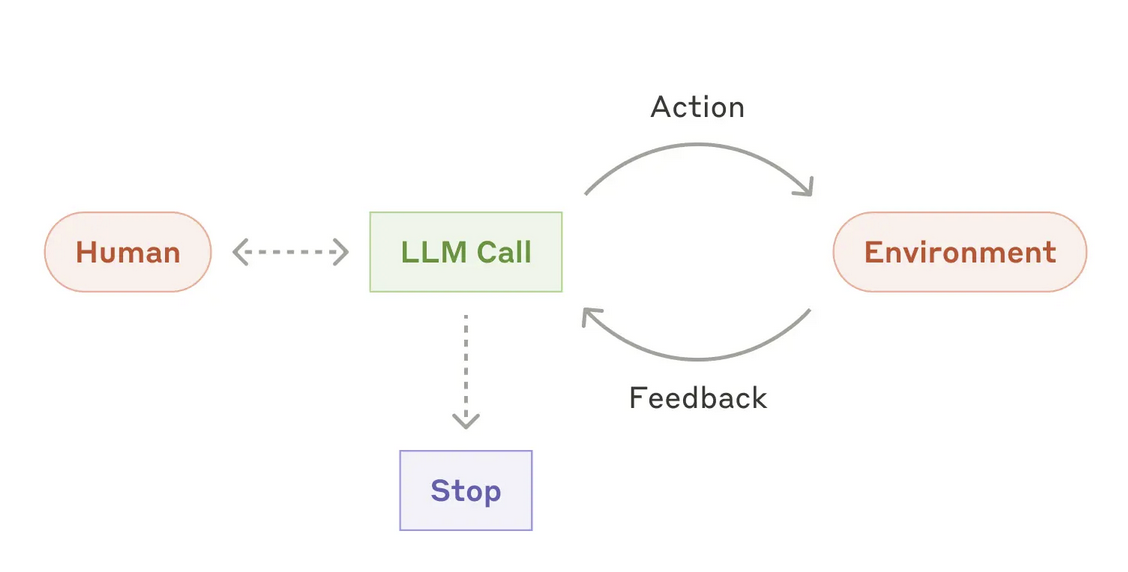

A Anthropic também está buscando ativamente uma estratégia de "modelo como produto" e forneceu insights sobre modelos de agentes. Eles publicaram um artigo em dezembro do ano passadorelatório de pesquisaA Anthropic redefiniu o modelo de agente. A Anthropic argumenta que um verdadeiro modelo de agente deve ter "Autonomia".que é capaz de concluir a tarefa-alvo de forma independente, e não apenas como um link no fluxo de trabalho. Da mesma forma que a DeepResearch, a Anthropic enfatiza que os modelos de agente devem ser "Internamente" Conclua todo o processo de execução de tarefas, incluindo o planejamento dinâmico do fluxo de tarefas, a seleção autônoma e a invocação de ferramentas etc., em vez de depender de caminhos de código predefinidos e orquestração externa.

Atualmente, há um grande número de startups de agentes surgindo no mercado, mas a maioria dos "agentes" que elas estão criando ainda está presa na "Fluxo de trabalho" Nível. Esses "agentes" são essencialmente uma série de fluxos de código predefinidos que vinculam LLMs e várias ferramentas para executar tarefas em um número fixo de etapas. Essa abordagem de "pseudo-agente", embora possa ter algum valor em determinadas verticais, ainda está muito longe da abordagem de "agente real" definida pela Anthropic e pela OpenAI. Os sistemas verdadeiramente autônomos devem ser reformulados e inovados no nível do modelo para dar um salto qualitativo.

O lançamento do Anthropic Claude 3.7 confirma ainda mais a tendência do "modelo como produto". O Claude 3.7 é um modelo profundamente otimizado para cenários de código complexos. O Claude 3.7 demonstra excelente desempenho na geração, compreensão e edição de códigos. É especialmente digno de nota o fato de que mesmo um modelo como o Devin Esse fluxo de trabalho de "programador de IA" altamente complexo e inteligente, com a tecnologia do Claude 3.7, também conseguiu obter melhorias significativas nos benchmarks SWE. Isso sugere que o poder do modelo em si é a chave para a criação de aplicativos excelentes. Em vez de gastar muito esforço projetando fluxos de trabalho complexos e ferramentas externas, os recursos devem ser investidos no desenvolvimento e na otimização do próprio modelo.

A equipe Pleias da RAG A exploração do domínio Retrieval-Augmented Generation (RAG) também reflete a ideia de "modelo como produto". Os sistemas RAG tradicionais geralmente são compostos de vários fluxos de trabalho independentes e acoplados, como roteamento de dados, fragmentação de texto, reordenação de resultados, compreensão de consultas, expansão de consultas, fusão de contextos, otimização de buscas etc. A falta de integração orgânica entre esses links resulta em alta vulnerabilidade e altos custos de manutenção e otimização. A falta de integração orgânica entre esses links leva a uma alta vulnerabilidade do sistema e a altos custos de manutenção e otimização. A equipe Pleias está tentando usar as mais recentes técnicas de treinamento para integrar os vários aspectos do sistema RAG. "Modelagem"O RAG tem dois modelos principais: um para pré-processamento de dados e construção de base de conhecimento e outro para recuperação de informações, geração de conteúdo e saída de relatórios. Esses dois modelos colaboram entre si para concluir todas as tarefas do processo do RAG. Essa solução, que exige um novo projeto de arquitetura de modelo, um pipeline de dados sintéticos refinado e uma função de recompensa de aprendizagem por reforço personalizada, é uma verdadeira inovação tecnológica e um avanço na pesquisa. Ao "modelar" o sistema RAG, a arquitetura do sistema pode ser bastante simplificada, o desempenho e a estabilidade do sistema podem ser aprimorados, os custos de implantação e manutenção podem ser reduzidos e a aplicação em escala da tecnologia RAG pode ser realizada.

Em resumo, o conceito central do "Modelo como produto" é que "Deslocando a complexidade". Problemas complexos que originalmente precisam ser resolvidos na camada do aplicativo são processados e digeridos antecipadamente no nível do modelo por meio do treinamento do modelo. O modelo aprende e se adapta a vários cenários complexos e situações extremas com antecedência durante a fase de treinamento, o que torna a implantação e a aplicação do modelo mais simples e eficiente. No futuro, o valor central dos produtos de IA estará mais no modelo em si do que em recursos sofisticados e fluxos de trabalho complexos na camada de aplicativos. Os instrutores de modelos se tornarão os participantes dominantes na criação e captura de valor. O objetivo da Anthropic Claude é interromper e substituir os atuais sistemas de "pseudo-agentes" baseados em fluxo de trabalho, como a estrutura de agentes subjacente fornecida pela LlamaIndex. Eles querem habilitar aplicativos de IA mais inteligentes, mais autônomos e mais fáceis de usar com modelos mais avançados.

será substituído por uma arquitetura de modelagem mais avançada, conforme descrito abaixo:

Sobrevivência na era do "modelo como produto": desenvolver seu próprio modelo ou ser engolido por ele?

Novamente, o posicionamento estratégico dos grandes laboratórios de IA não é uma "operação secreta", mas é claro e aberto. Embora, em alguns aspectos, suas estratégias possam parecer pouco transparentes, suas intenções principais são claras: Elas começarão na camada de modelo e penetrarão na camada de aplicativo para criar produtos e serviços de IA de ponta a ponta e buscar dominar a cadeia de valor. As implicações comerciais dessa tendência são de longo alcance. Naveen Rao, vice-presidente de IA de geração da Databricks, acerta em cheio:

Nos próximos dois ou três anos, todos os provedores de modelos de IA de código fechado deixarão gradualmente de vender interfaces de API diretamente. Somente os modelos de código aberto continuarão a fornecer serviços por meio de APIs. O objetivo dos provedores de modelos de código fechado é desenvolver recursos de IA não genéricos e exclusivamente competitivos e, para fornecer esses recursos, eles precisam criar a melhor experiência de usuário e interface de aplicativo. O produto de IA do futuro não será mais apenas o modelo em si, mas um aplicativo completo que integra o modelo, a interface do aplicativo e recursos específicos.

Isso significa que o período de lua de mel da "divisão de trabalho" entre os provedores de modelos e os desenvolvedores de aplicativos chegou ao fim. Os desenvolvedores de aplicativos, especialmente as empresas "wrapper" que dependem de APIs de modelos de terceiros para criar aplicativos, estão enfrentando desafios sem precedentes para sua sobrevivência. No futuro, o cenário competitivo do setor de IA poderá evoluir nas seguintes direções:

- Os provedores de modelos desenvolvem seus próprios aplicativos para conquistar participação no mercado: Código Claude e o DeepSearch sinalizaram que os provedores de modelos estão expandindo ativamente suas áreas de aplicação. O DeepSearch não tem uma interface de API aberta, mas está integrado ao serviço de assinatura premium da OpenAI como um recurso principal que aumenta o valor do serviço. O Claude Code é uma ferramenta leve de integração de endpoints que permite aos desenvolvedores usar os modelos do Claude 3.7 diretamente em um editor de código. Esses movimentos indicam que os provedores de modelos estão acelerando a construção de seus próprios ecossistemas de aplicativos para fornecer serviços diretamente aos usuários e conquistar participação no mercado. Vale a pena observar que alguns wrappers de aplicativos, como o Cursor, sofreram degradação de desempenho e rotatividade de usuários quando conectados ao modelo Claude 3.7. Isso reforça ainda mais a ideia de que o modelo é o produto: Um verdadeiro agente de IA está preocupado em maximizar os próprios recursos do modelo, em vez de acomodar e adaptar-se aos fluxos de trabalho existentes.

- Transformação do invólucro do aplicativo, foco na autopesquisa de modelos: Em face do "golpe descendente" dos provedores de modelos, alguns invólucros de aplicativos principais começaram a buscar ativamente a transformação, tentando criar seus próprios recursos de treinamento de modelos. Apesar do início tardio e da relativa fraqueza no treinamento de modelos, essas empresas estão ativamente preparando o terreno. A Cursor, por exemplo, enfatiza o valor de seus modelos de preenchimento automático de código pequeno; WindSurf tem um modelo de código interno e de baixo custo, o Codium; a Perplexity há muito tempo conta com um classificador interno para roteamento de tráfego e começou a treinar sua própria variante do DeepSeek para aprimoramento da pesquisa. Esses movimentos mostram que os wrappers de aplicativos perceberam que é difícil confiar apenas no modelo de "chamada de API" para se firmar na concorrência futura e que eles precisam dominar determinados recursos de autodesenvolvimento de modelos para permanecerem competitivos.

- O que os pequenos empacotadores farão a partir de agora? A inovação da interface do usuário pode ser a chave para o sucesso: Para o grande número de wrappers de aplicativos de pequeno e médio porte, a margem de sobrevivência será ainda mais estreita no futuro. Se os grandes laboratórios de modelos reduzirem seus serviços de API de forma generalizada, esses pequenos wrappers poderão ser forçados a recorrer a provedores de serviços de raciocínio de terceiros mais neutros. Com a convergência dos recursos do modelo, a inovação na interface do usuário (UI) e na experiência do usuário pode se tornar a chave para os pequenos empacotadores se destacarem. Há muito tempo, o valor da interface do usuário tem sido subestimado no espaço da IA. À medida que os modelos genéricos se tornam mais avançados e os processos de implantação e aplicação de modelos se tornam cada vez mais simplificados, aUma interface de usuário excelente será o principal fator para aumentar a competitividade do produto e atrair usuários. Especialmente em cenários de aplicação como o RAG, a capacidade do modelo pode não ser mais o fator decisivo, e a facilidade de uso, a interatividade e a experiência do usuário se tornarão mais importantes.

Em resumo, para a maioria dos wrappers de aplicativos, o futuro reserva um dilema "ou ou": Ou você será transformado em um instrutor de modelos (Treinamento) ou acabará sendo engolido pelo proprietário do modelo (Sendo treinado). Atualmente, todo o trabalho realizado por esses wrappers de aplicativos tornou-se, de certa forma, "pesquisa de mercado gratuita" e "rotulagem de dados gratuita" para grandes laboratórios de modelos. Isso ocorre porque todos os dados de interação com o usuário e o feedback acabam fluindo para os provedores de modelos para ajudá-los a aprimorar seus modelos, otimizar seus produtos e fortalecer ainda mais sua posição no mercado.

A direção futura dos wrappers de aplicativos também depende, em grande parte, das atitudes e percepções dos investidores. É preocupante o fato de que o clima de investimento atual parece ser um pouco "tendencioso" contra o espaço de treinamento de modelos. Muitos investidores ainda se apegam ao conceito tradicional de "o aplicativo é rei" e não reconhecem o valor e o potencial do treinamento de modelos. Essa "incompatibilidade" de investimentos pode prejudicar o desenvolvimento saudável da tecnologia de IA e até mesmo fazer com que o setor ocidental de IA fique para trás na concorrência futura. Como resultado, alguns aplicativos podem também ter que "esconder" seus esforços no treinamento de modelos para não serem mal interpretados pelos investidores. As miniaturas da Cursor e a Codium, por exemplo, até agora não tiveram publicidade e promoção adequadas. Essa orientação de investimento de "foco em aplicativos, mas não em modelos" precisa despertar profunda reflexão e vigilância no setor.

O subestimado aprendizado por reforço: a chave para a futura competição da IA

No atual espaço de investimento em IA, há uma ampla "O aprendizado por reforço não foi incluído no preço". O fenômeno. Por trás desse fenômeno está o viés cognitivo da comunidade de investimentos em relação à tendência de desenvolvimento da tecnologia de IA e sua negligência quanto à importância estratégica da tecnologia de aprendizagem por reforço.

As decisões de investimento dos VCs em IA geralmente se baseiam em várias suposições:

- A camada de aplicativo é o bolso de valor, a camada de modelo é apenas a infraestrutura: Em geral, os investidores acreditam que o valor real da IA se reflete na camada do aplicativo, e a inovação do aplicativo é a chave para desestabilizar o mercado existente. A camada de modelo é apenas uma infraestrutura que fornece interfaces de API e não tem competitividade central.

- Os preços das APIs de modelo continuarão caindo, e os invólucros de aplicativos continuarão a se beneficiar: Os investidores esperam que os provedores de modelos continuem a reduzir o preço das chamadas de API para ganhar participação no mercado, aumentando assim a lucratividade dos wrappers de aplicativos.

- A API de modelo de código fechado é suficiente para todos os aplicativos: Os investidores acreditam que os aplicativos criados em APIs de modelo de código fechado podem atender às necessidades de uma ampla gama de cenários, mesmo em setores sensíveis com altos requisitos de segurança e autonomia de dados.

- O treinamento de modelos é um grande investimento, de ciclo longo e de alto risco; é melhor comprar a API diretamente: Os investidores geralmente acreditam que a criação de recursos de treinamento de modelos é um investimento "ingrato". O treinamento de modelos exige grandes quantidades de capital, ciclos longos e altos limites técnicos, e o risco é muito maior do que a compra direta de APIs de modelos e o desenvolvimento rápido de aplicativos.

No entanto, essas suposições estão se tornando cada vez mais insustentáveis no contexto da era do "modelo como produto". Preocupa-me o fato de que, se a comunidade de investimentos continuar se apegando a essas noções ultrapassadas, poderá perder oportunidades estratégicas para o desenvolvimento da IA e até mesmo levar a uma má alocação dos recursos do mercado. O atual boom de investimentos em IA pode se transformar em uma "aposta arriscada", uma "falha de mercado que não consegue avaliar com precisão os últimos desenvolvimentos tecnológicos (especialmente a aprendizagem por reforço)".

Os fundos de capital de risco (VC), que supostamente buscam investimentos em um portfólio de "Não correlacionado"O objetivo dos VCs não é superar o índice S&P500. O objetivo de um VC não é superar o índice S&P500, mas construir um portfólio diversificado que reduza o risco geral e garanta que alguns investimentos ainda compensem durante os ciclos de baixa. Treinamento de modelos, que se encaixa no perfil de investimento "não correlacionado". Contra o pano de fundo dos riscos de recessão nas principais economias ocidentais, o campo de treinamento de modelos de IA, que abriga um enorme potencial de inovação e crescimento, está fracamente correlacionado com os ciclos macroeconômicos. No entanto, as empresas de treinamento modelo geralmente enfrentam dificuldades de financiamento, o que é contrário à lógica essencial do capital de risco. A Prime Intellect é uma das poucas startups ocidentais de treinamento de modelos de IA com potencial para se transformar em um laboratório de IA de ponta. Apesar de seus avanços tecnológicos, incluindo o treinamento do primeiro LLM descentralizado, sua escala de financiamento é comparável à de uma empresa de aplicativos "shell" comum. Esse fenômeno do "dinheiro ruim expulsando o dinheiro bom" é instigante.

Com exceção de alguns grandes laboratórios, o ecossistema atual para treinamento de modelos de IA permanece muito frágil e marginal. Globalmente, há apenas algumas empresas inovadoras que se concentram no treinamento de modelos. Prime Intellect, Moondream, Arcee, Nous, Pleias, Jina, a equipe de pré-treinamento da HuggingFace (que é muito pequena) e outras compõem quase a totalidade do espaço de treinamento de modelos de IA de código aberto. Juntamente com algumas instituições acadêmicas, como Allen AI, EleutherAI, etc., eles estão construindo e mantendo os pilares da atual infraestrutura de treinamento de IA de código aberto. Na Europa, fiquei sabendo que há 7 a 8 projetos de LLM que planejam treinar modelos com base no corpus Common Corpus e nas ferramentas de pré-treinamento desenvolvidas pela equipe Pleias. A próspera comunidade de código aberto compensou, de certa forma, a falta de investimento comercial, mas também se esforçou para chegar à raiz dos desafios enfrentados pelo ecossistema de treinamento de modelos.

A OpenAI também parece estar ciente da importância da "RL vertical". Recentemente, houve relatos de que os executivos da OpenAI expressaram insatisfação com o cenário de startups do Vale do Silício, que é "leve em RL e pesado em aplicativos". Presumivelmente, essa mensagem veio do próprio Sam Altman e pode se refletir no próximo YC Startup Camp. Isso sinaliza uma possível mudança na estratégia de colaboração da OpenAI. No futuro, a escolha de parceiros da OpenAI pode não ser mais apenas clientes de API, mas "co-contratantes" envolvidos nos estágios iniciais de treinamento dos modelos. O treinamento de modelos, que passará dos bastidores para a frente do palco, se tornará um aspecto essencial da competição de IA.

A era do "modelo como produto" implica uma mudança de paradigma na inovação da IA. A era de lutar sozinho acabou, a cooperação aberta e a inovação colaborativa se tornarão a tendência. Os domínios de pesquisa e código são os primeiros a alcançar o "modelo como produto", em grande parte devido à relativa maturidade dos cenários de aplicativos nesses dois domínios, à clara demanda do mercado e ao claro caminho da tecnologia, o que facilita a rápida "escolha dos frutos mais fáceis". Como Cursor Esses produtos inovadores podem ser rapidamente iterados e lançados em apenas alguns meses. No entanto, cenários de aplicação de IA de maior valor para o futuro, como a atualização inteligente de sistemas baseados em regras, ainda estão em um estágio inicial de exploração, com enormes desafios técnicos e demanda de mercado incerta, o que dificulta a obtenção de avanços de forma "curta, média e rápida". Essas são áreas que exigem equipes pequenas com formação interdisciplinar e um alto grau de foco para investimentos em P&D aprofundados e de longo prazo. Essas equipes de inovação "pequenas e bonitas" podem se tornar uma força importante no setor de IA no futuro e podem ser adquiridas por grandes empresas de tecnologia para realizar seu valor após a conclusão de seu acúmulo inicial de tecnologia. Modelos de colaboração semelhantes poderiam surgir no espaço da interface do usuário (UI). Algumas empresas focadas na inovação da interface do usuário poderiam criar produtos de IA diferenciados e competitivos estabelecendo parcerias estratégicas com grandes laboratórios de modelos para obter acesso exclusivo à API de modelos especializados de código fechado.

O layout estratégico da DeepSeek é, sem dúvida, mais ambicioso e voltado para o futuro na tendência "modelo é produto". O objetivo do DeepSeek não é apenas "modelo como produto", mas "modelo como camada de infraestrutura comum". Assim como a OpenAI e a Anthropic, o fundador da DeepSeek, Wenfeng Lien, declarou publicamente sua visão para a DeepSeek:

Acreditamos que a fase atual é Uma explosão de inovação tecnológica, não uma explosão de aplicativosO primeiro passo é ter certeza de que você tem a melhor solução possível para o problema. Somente quando um ecossistema completo do setor de IA upstream e downstream for estabelecido, o DeepSeek não precisará fazer o aplicativo em si. É claro que, se necessário, o DeepSeek também pode fazer aplicativos, mas isso não é uma prioridade. A estratégia principal da DeepSeek sempre foi aderir à inovação tecnológica e construir uma poderosa plataforma de infraestrutura comum de IA.

Na era do "modelo como produto", limitar nossa atenção à camada de aplicativos não é diferente de "Use os generais da última geração de guerra para comandar a próxima geração de guerra."O mais preocupante é que o setor ocidental de IA ainda parece estar imerso na velha mentalidade de que "o aplicativo é o rei". O preocupante é que o setor ocidental de IA ainda parece estar imerso na velha mentalidade de "o aplicativo é o rei" e não tem conhecimento e preparação suficientes para as novas tendências de desenvolvimento de IA. Talvez muitas pessoas ainda não tenham percebido que a "guerra" no campo da IA entrou discretamente em uma nova fase. Quem for o primeiro a adotar o novo paradigma de "modelo como produto" terá uma vantagem inicial na futura competição de IA.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...