Introdução geral

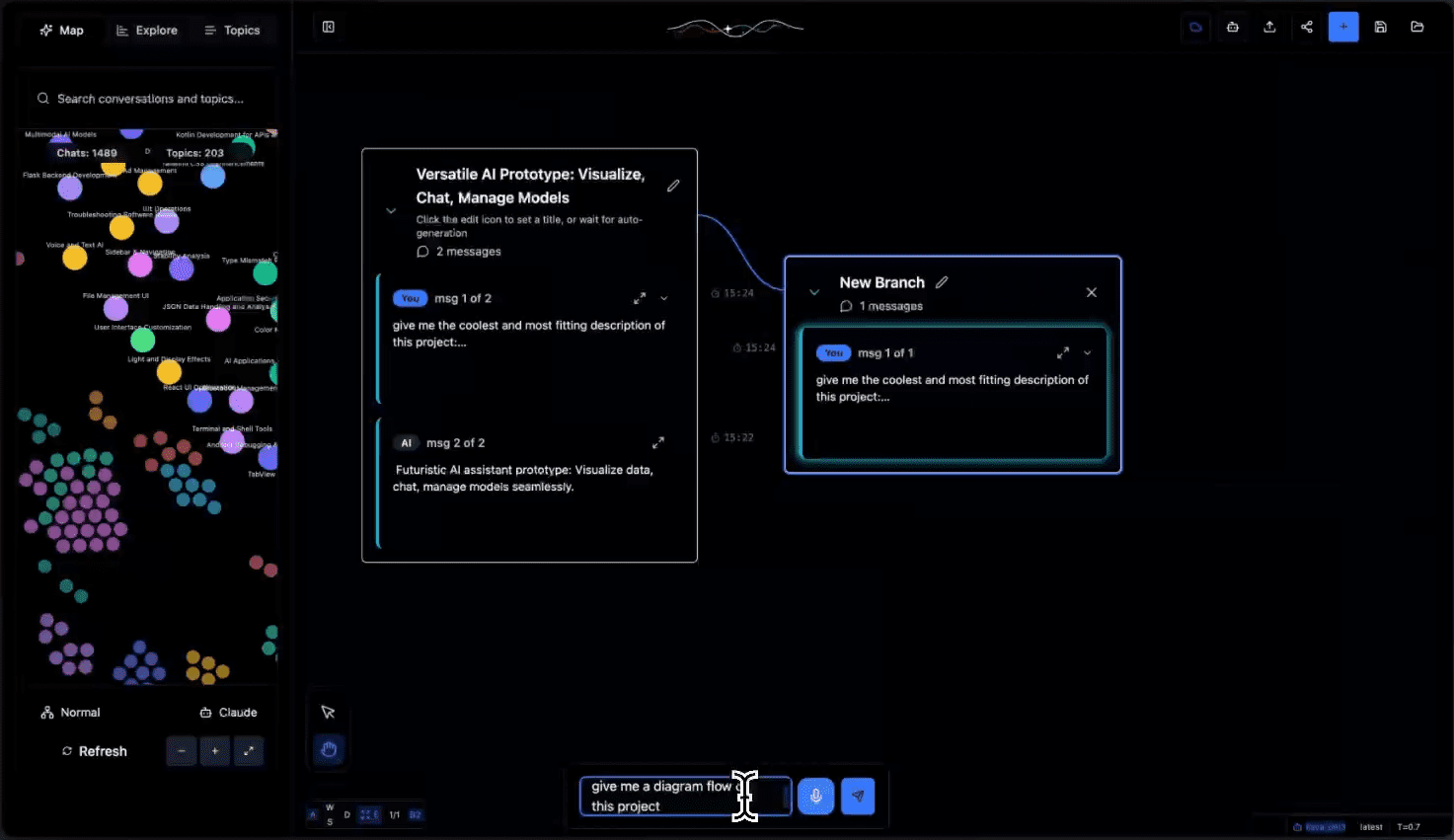

O Tangent é uma ferramenta inovadora de tela de diálogo de IA que combina a interação visual do Excalidraw com a flexibilidade do ComfyUI, com foco na criação de uma nova experiência exploratória para conversas LLM (Large Language Model). Diferentemente das interfaces de bate-papo tradicionais, o Tangent transforma os diálogos de IA em experimentos visuais, dando aos usuários a liberdade de ramificar, mesclar e comparar diferentes caminhos de diálogo. Ele oferece suporte a um modelo de implantação local off-line primeiro que depende inteiramente de modelos locais para ser executado e, no momento, é implementado principalmente por meio do Ollama, com planos de expansão para oferecer suporte a mais back-ends. O projeto é de código aberto sob a licença Apache 2.0, incentiva as contribuições da comunidade e fornece uma nova plataforma experimental para a exploração de diálogos de IA.

Lista de funções

- Recuperação e continuação do diálogo: rompendo as restrições contextuais e recuperando perfeitamente os diálogos anteriores

- Sistema de exploração de ramificação: crie ramificações em qualquer nó de diálogo para testar várias direções de diálogo

- Implementação local off-line: é executada inteiramente em um modelo local para proteger a segurança dos dados privados

- Agrupamento dinâmico de tópicos: inferir automaticamente tópicos de conversas e organizá-los em categorias para otimizar a experiência de navegação.

- Compatibilidade de dados de exportação: suporta os formatos de exportação de dados Claude e ChatGPT

- Árvore de diálogo visual: exibição de ramificações de diálogo e processos experimentais em uma estrutura de árvore

- Suporte à API: uma API REST completa está disponível para processar e gerenciar dados de diálogo.

- Rastreamento de status em tempo real: monitore o progresso do processamento do diálogo e o status da tarefa

Usando a Ajuda

1. preparação ambiental

1.1 Instale as dependências necessárias:

- Sussurro.cpp: para processamento de fala

git clone https://github.com/ggerganov/whisper.cpp cd whisper.cpp sh . /models/download-ggml-model.sh base.en make

- Ollama: ambiente de tempo de execução do modelo local

- Visite https://ollama.com/ para fazer o download da versão apropriada para seu sistema

- Verifique a instalação:

ollama --versão - Faça o download dos modelos necessários:

ollama pull all-minilm ollama pull qwen2.5-coder:7b

1.2 Inicie o serviço Ollama:

ollama serve

2. configuração de back-end

2.1 Inicialize o ambiente Python:

cd tangent-api

source my_env/bin/activate

pip install -r requirements.txt

2.2 Configure o modelo local:

cd src

python3 app.py --embedding-model "custom-embedding-model" --generation-model "custom-generation-model"

O serviço de back-end será iniciado em http://localhost:5001/api

3. configuração de front-end

cd simplified-ui

npm i

npm start

Acesse http://localhost:3000 para usar a interface

4. descrição do uso das principais funções

4.1 Gerenciamento de diálogo:

- Crie uma nova caixa de diálogo: clique no botão "+" no canto superior direito da tela.

- Diálogo de ramificação: Clique com o botão direito do mouse em qualquer nó de diálogo e selecione "Criar ramificação".

- Mesclar diálogos: arraste e solte diálogos de diferentes ramificações para o nó de destino para mesclá-los.

4.2 Organização de tópicos:

- Agrupamento automático: o sistema analisa automaticamente o conteúdo do diálogo para gerar tags de tópicos

- Filtragem de tópicos: Localize rapidamente conversas relevantes por meio da lista de tópicos à esquerda.

- Rotulagem manual: suporta rótulos e categorias de tópicos personalizados

4.3 Importação e exportação de dados:

- Suporte para importação de registros de diálogo do Claude e do ChatGPT

- Os registros de conversas podem ser exportados para vários formatos

- Fornecer interface de API para automatizar o processamento

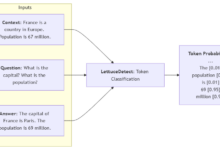

5. diretrizes para o uso da API

Principais desfechos:

- POST

/api/processProcessamento de dados de diálogo carregados - OBTER

/api/process/status/Status do processamento da consulta - POST

/api/chats/saveSalvar dados de diálogo - OBTER

/api/chats/load/Carregamento de diálogos específicos - OBTER

/api/tópicosObter a lista de tópicos gerados