Story-Flicks: Insira tópicos para gerar automaticamente vídeos de histórias curtas para crianças

Introdução geral

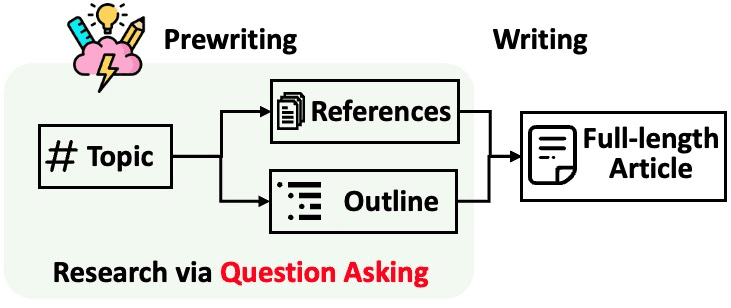

O Story-Flicks é uma ferramenta de IA de código aberto focada em ajudar os usuários a gerar rapidamente vídeos de histórias em HD. Os usuários só precisam inserir um tópico de história, o sistema gerará o conteúdo da história por meio de um grande modelo de linguagem e, combinado com imagens, áudio e legendas gerados por IA, a saída do trabalho de vídeo completo. O backend do projeto é baseado em Python e na estrutura FastAPI, e o frontend é construído com React, Ant Design e Vite. Ele é compatível com OpenAI, AliCloud, DeepSeek e outros provedores de serviços de modelo, e os usuários podem escolher com flexibilidade modelos de geração de texto e imagem. Seja para criar histórias infantis, animações curtas ou vídeos didáticos, o Story-Flicks pode facilmente atender às necessidades de desenvolvedores, criadores e educadores.

Lista de funções

- Gerar vídeo com um cliqueInsira um tópico de história e gere automaticamente um vídeo com imagens, texto, áudio e legendas.

- Suporte a vários modelosCompatível com OpenAI, Aliyun, DeepSeek, Ollama e SiliconFlow de modelos de texto e imagem.

- Personalização de segmentosImagem: O usuário pode especificar o número de parágrafos da história, e cada parágrafo gera uma imagem correspondente.

- saída multilíngueSuporte para geração de texto e áudio em vários idiomas, adaptado para usuários globais.

- implantação de código abertoInstalação manual: fornece instalação manual e implantação do Docker para facilitar a operação local.

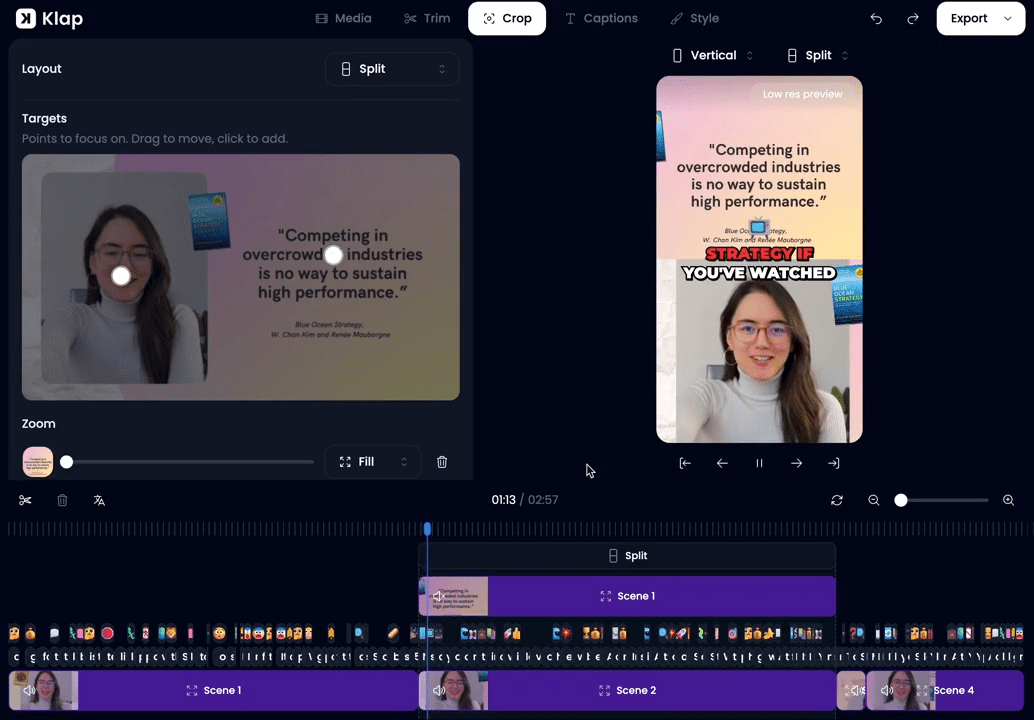

- interface intuitivaA página de front-end é fácil de usar e oferece suporte à seleção de parâmetros e à visualização de vídeos.

Usando a Ajuda

Processo de instalação

O Story-Flicks oferece dois métodos de instalação: instalação manual e implantação do Docker. Abaixo estão as etapas detalhadas para garantir que os usuários possam criar o ambiente sem problemas.

1. instalação manual

Etapa 1: Faça o download do projeto

Clone o projeto localmente digitando o seguinte comando no terminal:

git clone https://github.com/alecm20/story-flicks.git

Etapa 2: Configurar informações do modelo

Vá para o diretório backend e copie o arquivo de configuração do ambiente:

cd backend

cp .env.example .env

show (um ingresso) .env para configurar o modelo de geração de texto e imagem. Exemplo:

text_provider="openai" # 文本生成服务商,可选 openai、aliyun、deepseek 等

image_provider="aliyun" # 图像生成服务商,可选 openai、aliyun 等

openai_api_key="你的OpenAI密钥" # OpenAI 的 API 密钥

aliyun_api_key="你的阿里云密钥" # 阿里云的 API 密钥

text_llm_model="gpt-4o" # 文本模型,如 gpt-4o

image_llm_model="flux-dev" # 图像模型,如 flux-dev

- Se você escolher o OpenAI, é recomendável usar

gpt-4ocomo um modelo textual.dall-e-3como um modelo de imagem. - Se você escolher o AliCloud, é recomendável usar

qwen-plustalvezqwen-max(modelagem textual) eflux-dev(modelo de imagem, atualmente disponível para teste gratuito, veja detalhes emDocumentação de Aliyun). - Salve o arquivo quando a configuração estiver concluída.

Etapa 3: Inicie o back-end

Vá para o diretório backend no terminal, crie o ambiente virtual e instale as dependências:

cd backend

conda create -n story-flicks python=3.10 # 创建 Python 3.10 环境

conda activate story-flicks # 激活环境

pip install -r requirements.txt # 安装依赖

uvicorn main:app --reload # 启动后端服务

Após a inicialização bem-sucedida, o terminal exibirá a tela:

INFO: Uvicorn running on http://127.0.0.1:8000 (Press CTRL+C to quit)

INFO: Application startup complete.

Isso indica que o serviço de back-end foi executado http://127.0.0.1:8000.

Etapa 4: Inicie o front-end

Vá para o diretório do front-end em um novo terminal, instale as dependências e execute-o:

cd frontend

npm install # 安装前端依赖

npm run dev # 启动前端服务

Após a inicialização bem-sucedida, o terminal exibe:

VITE v6.0.7 ready in 199 ms

➜ Local: http://localhost:5173/

Acessado em um navegador http://localhost:5173/Você pode ver a interface de front-end.

2. implantação do Docker

Etapa 1: Preparar o ambiente

Certifique-se de que o Docker e o Docker Compose estejam instalados localmente; caso contrário, faça o download deles no site oficial.

Etapa 2: Iniciar o projeto

Execute-o no diretório raiz do projeto:

docker-compose up --build

O Docker cria e inicia automaticamente os serviços de front-end e back-end. Quando terminar, visite a seção http://localhost:5173/ Exibir a página de front-end.

Uso

Após a instalação, os usuários podem gerar vídeos de histórias por meio da interface de front-end. Abaixo está o fluxo de operação específico:

1. acesso à interface de front-end

Digite em seu navegador http://localhost:5173/A página principal do Story-Flicks é aberta.

2. definir os parâmetros de geração

A interface oferece as seguintes opções:

- Provedor de modelo de geração de texto: Seleção

openaiealiyunetc. - Provedor de modelos de geração de imagens: Seleção

openaiealiyunetc. - modelo de textoDigite o nome do modelo, por exemplo

gpt-4otalvezqwen-plus. - modelagem de imagensDigite o nome do modelo, por exemplo

flux-devtalvezdall-e-3. - Linguagem de vídeoSelecione um idioma, como chinês ou inglês.

- Tipo de vozSelecione um estilo de áudio, como masculino ou feminino.

- Tópicos da históriaInsira um tema, por exemplo, "The Adventures of the Rabbit and the Fox" (As aventuras do coelho e da raposa).

- Número de parágrafos da históriaDigite um número (por exemplo, 3), com cada segmento correspondendo a uma imagem.

3. geração de vídeo

Depois de preencher os parâmetros, clique no botão "Generate" (Gerar). O sistema gerará o vídeo de acordo com as configurações. O tempo de geração está relacionado ao número de parágrafos; quanto mais parágrafos, mais tempo leva. Quando terminar, o vídeo será exibido na página, com suporte para reprodução e download.

advertência

- Se a geração falhar, verifique o

.envpara obter a chave de API correta ou verifique se a conexão de rede está funcionando. - fazer uso de Ollama Ao definir o

ollama_api_key="ollama"Recomendadoqwen2.5:14bou modelos maiores, os modelos menores podem não funcionar tão bem. - O modelo de imagem do SiliconFlow só foi testado até o momento.

black-forest-labs/FLUX.1-devCertifique-se de selecionar um modelo compatível.

Operação da função em destaque

Gerar vídeo completo com um clique

Na interface, digite "The story of the wolf and the rabbit" (A história do lobo e do coelho), defina 3 parágrafos e clique em "Generate" (Gerar). Após alguns minutos, você obterá um vídeo com 3 imagens, narração e legendas. Por exemplo, o vídeo de demonstração oficial mostra as histórias "The Rabbit and the Fox" (O coelho e a raposa) e "The Wolf and the Rabbit" (O lobo e o coelho).

Suporte a vários idiomas

Deseja gerar um vídeo em inglês? Defina o "Video Language" (Idioma do vídeo) como "English" (Inglês) e o sistema gerará texto, áudio e legendas em inglês. Mudar para outros idiomas é igualmente fácil.

Segmentação personalizada

Precisa de uma história mais longa? Defina o número de parágrafos para 5 ou mais. Cada parágrafo gera uma nova imagem e a história se expande de acordo.

Com essas etapas, os usuários podem instalar e usar facilmente o Story-Flicks para criar rapidamente vídeos de histórias em HD. Seja para entretenimento pessoal ou uso educacional, essa ferramenta pode ajudá-lo a ser criativo!

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...