Implementação privada do DeepSeek + Dify: criação de um sistema de assistente de IA local seguro e controlável

delineado

DeepSeek é um modelo inovador de big language de código aberto que traz uma experiência revolucionária para a interação de diálogo de IA com sua arquitetura algorítmica avançada e recursos de encadeamento reflexivo. Com a implementação privada, você tem controle total sobre a segurança dos dados e a segurança do uso. Você também pode ajustar com flexibilidade o esquema de implementação e implementar um sistema personalizado conveniente.

Dify Como a mesma plataforma de desenvolvimento de aplicativos de IA de código aberto, ela oferece uma solução completa de implementação privada. Ao integrar perfeitamente os serviços DeepSeek implantados localmente na plataforma Dify, as organizações podem criar aplicativos avançados de IA em um ambiente de servidor local, garantindo a privacidade dos dados.

Veja a seguir as vantagens da opção de implementação privada:

- desempenho superior Fornecer uma experiência de interação de diálogo comparável aos modelos de negócios

- isolamento ambiental Operação totalmente off-line, eliminando o risco de vazamento de dados

- Controlabilidade dos dados Controle total dos ativos de dados para atender aos requisitos de conformidade

pré-posicionamento

Ambiente de hardware:

- CPU >= 2 núcleos

- Memória de vídeo/RAM ≥ 16 GiB (recomendado)

Ambiente de software:

- Docker

- Docker Compose

- Ollama

- Dify Community Edition

Início da implantação

1. instalação do Ollama

O Ollama é um cliente de gerenciamento de modelos grandes de plataforma cruzada (MacOS, Windows, Linux) projetado para implantar perfeitamente modelos de linguagem grandes (LLMs), como DeepSeek, Llama, Mistral etc. O Ollama oferece implantação de modelos grandes com um clique, e todos os dados de uso são armazenados localmente na máquina, proporcionando total privacidade de dados e segurança.

Visite o site do Ollama e siga as instruções para fazer o download e instalar o cliente Ollama. Após a instalação, execute ollama -v exibirá o número da versão.

➜~ollama-v

ollamaversionis0.5.5

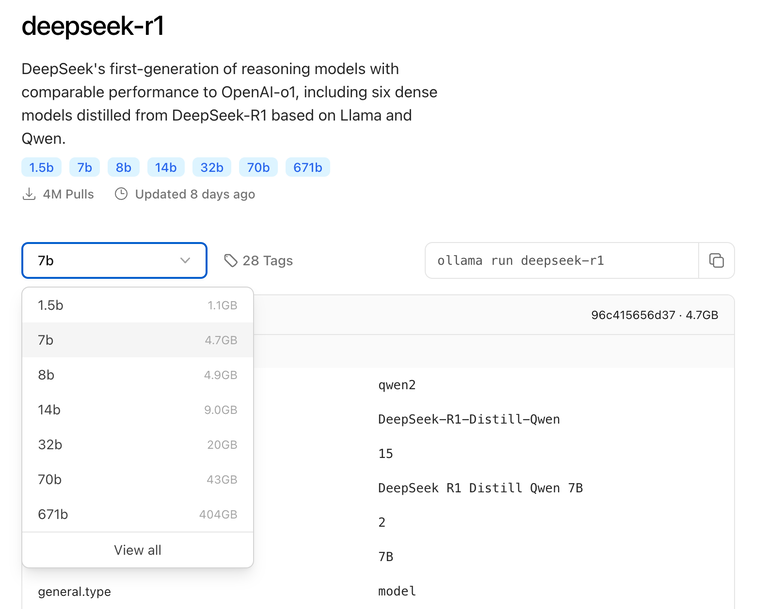

Selecione o modelo de tamanho apropriado do DeepSeek para a implementação com base na configuração real do ambiente. O modelo de tamanho 7B é recomendado para a instalação inicial.

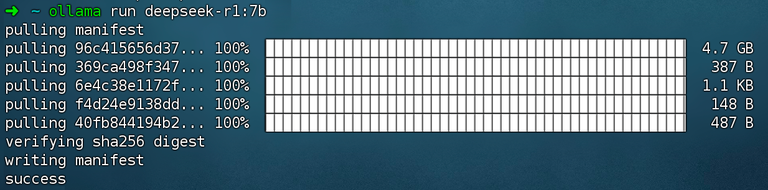

Executar comando ollama run deepseek-r1:7b montagem DeepSeek R1 Modelos.

2 Instale a Dify Community Edition

Visite o endereço do projeto Dify no GitHub e execute os seguintes comandos para concluir o repositório de código de extração e o processo de instalação.

gitclonehttps://github.com/langgenius/dify.git

cddify/docker

cp.env.example.env

dockercomposeup-d# 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

Depois de executar o comando, você verá o status e o mapeamento de portas de todos os contêineres. Para obter instruções detalhadas, consulte Implantação do Docker Compose.

O Dify Community Edition usa a porta 80 por padrão. http://your_server_ip Acesse sua plataforma privatizada da Dify.

3. conectando o DeepSeek à Dify

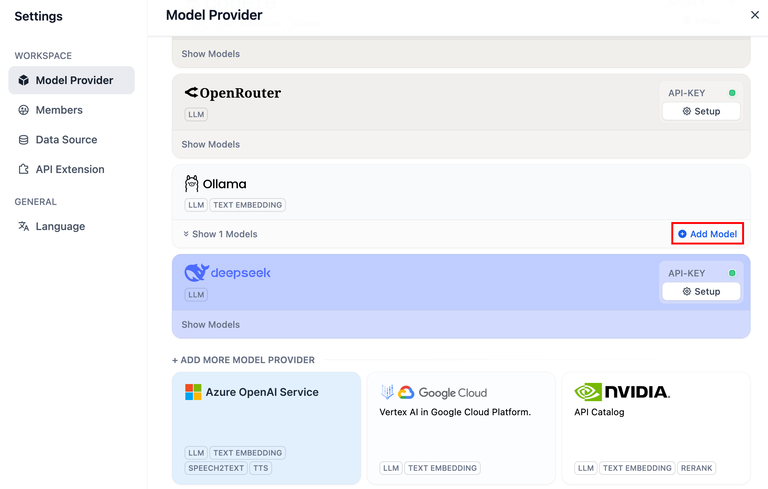

Clique no canto superior direito da plataforma Dify Avatar → Configurações → Fornecedor de modelos Selecione Ollama e toque em Add Model (Adicionar modelo).

O DeepSeek dentro do provedor de modelo corresponde ao serviço API on-line; os modelos DeepSeek implantados localmente correspondem ao cliente Ollama. Certifique-se de que o modelo DeepSeek tenha sido implementado com sucesso pelo cliente Ollama, conforme detalhado nas instruções de implementação acima.

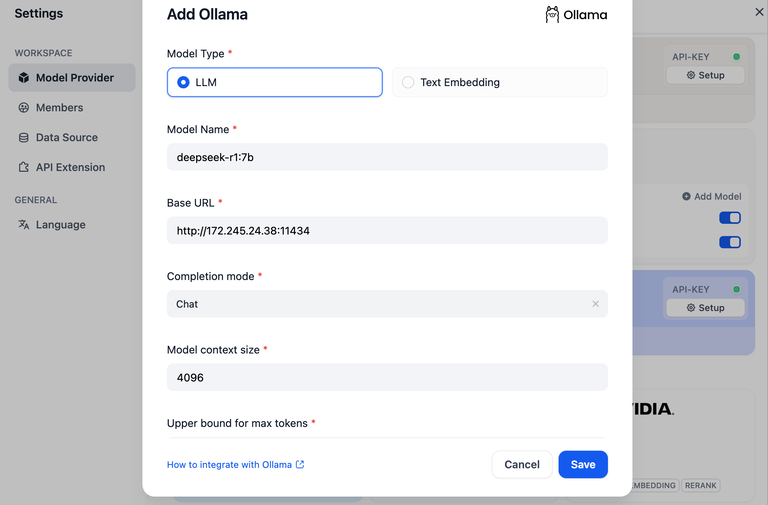

Selecione o tipo de modelo LLM.

- Nome do modelo, preencha o nome do modelo implantado. O modelo implantado acima é o deepseek-r1 7b, portanto, preencha o campo

deepseek-r1:7b - URL base, o endereço onde o cliente Ollama está sendo executado, geralmente

http://your_server_ip:11434. Em caso de problemas de conexão, leia emproblemas comuns. - As outras opções permanecem em seus valores padrão. Dependendo do Descrição do modelo DeepSeekO comprimento máximo gerado é de 32.768 tokens.

Criação de aplicativos de IA

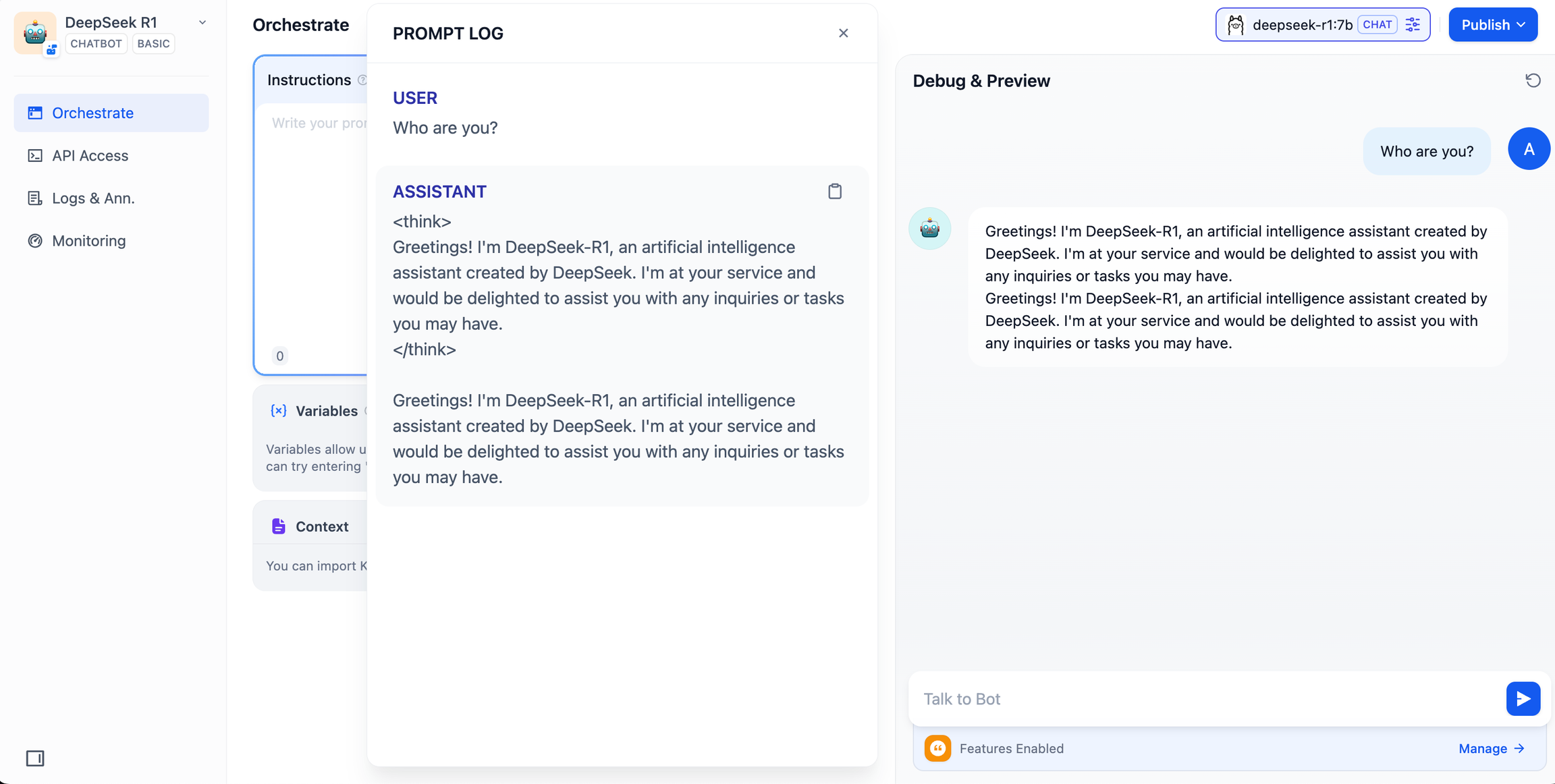

DeepSeek AI Chatbot (aplicativo simples)

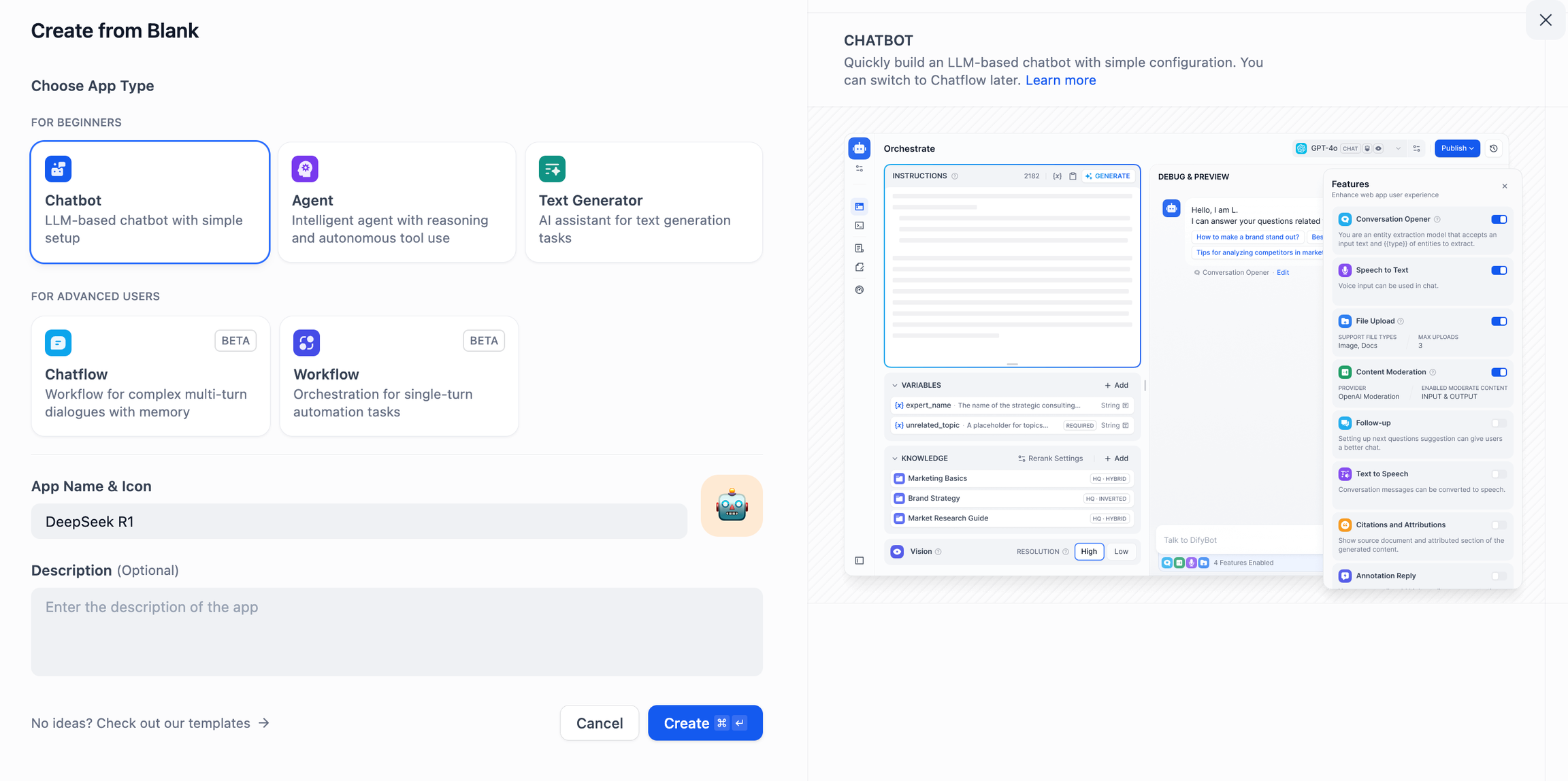

- Toque em "Create a Blank App" (Criar um aplicativo em branco) no lado esquerdo da página inicial da plataforma Dify, selecione o tipo de aplicativo "Chat Assistant" (Assistente de bate-papo) e dê um nome simples a ele.

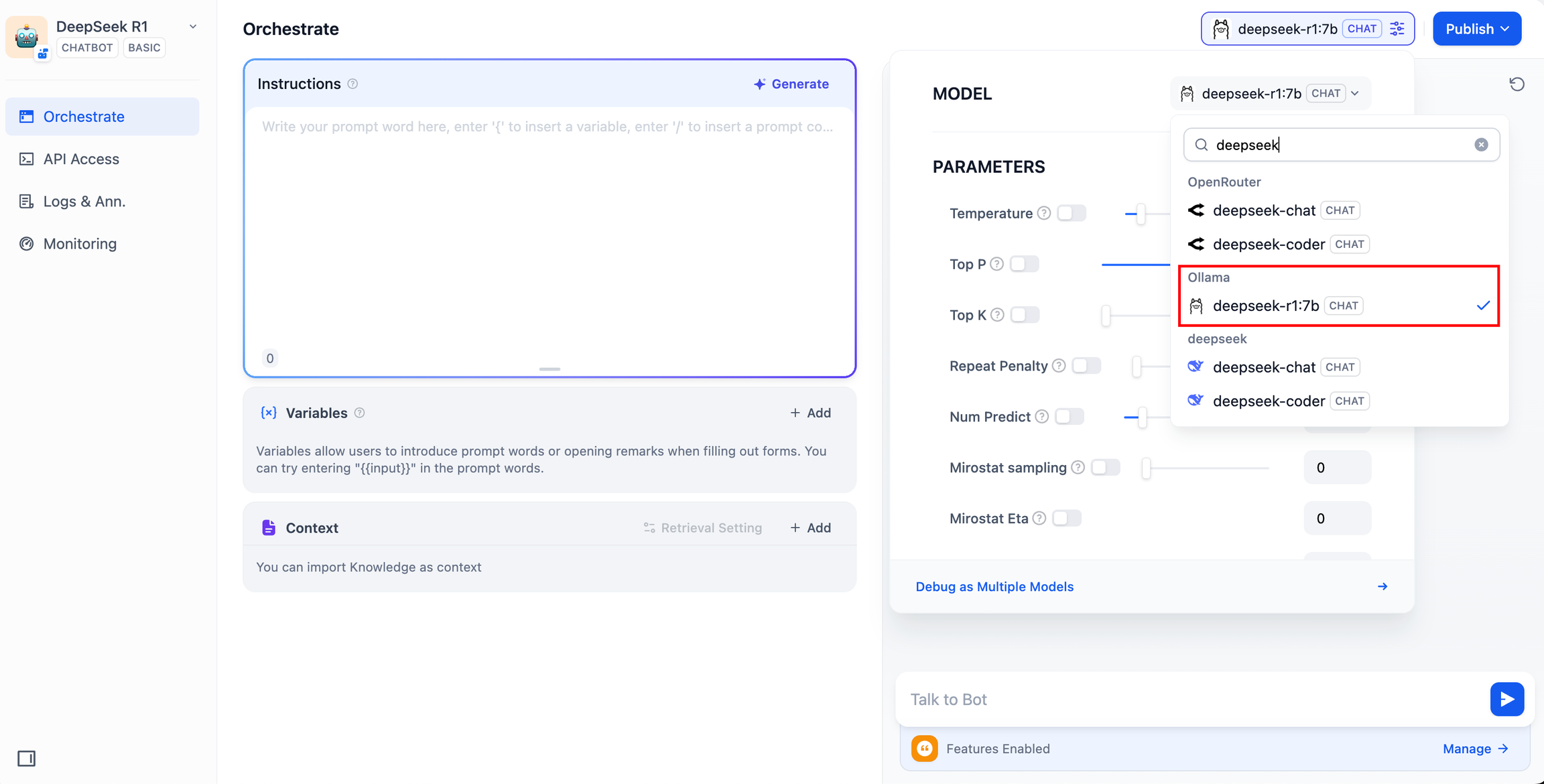

- No canto superior direito, em Application Type (Tipo de aplicativo), selecione a estrutura Ollama na lista

deepseek-r1:7bModelos.

- Verifique se o aplicativo de IA funciona inserindo conteúdo na caixa de diálogo de visualização. A geração de uma resposta significa que a compilação do aplicativo de IA está concluída.

- Toque no botão Publicar no canto superior direito do aplicativo para obter um link para o aplicativo de IA e compartilhá-lo com outras pessoas ou incorporá-lo em outro site.

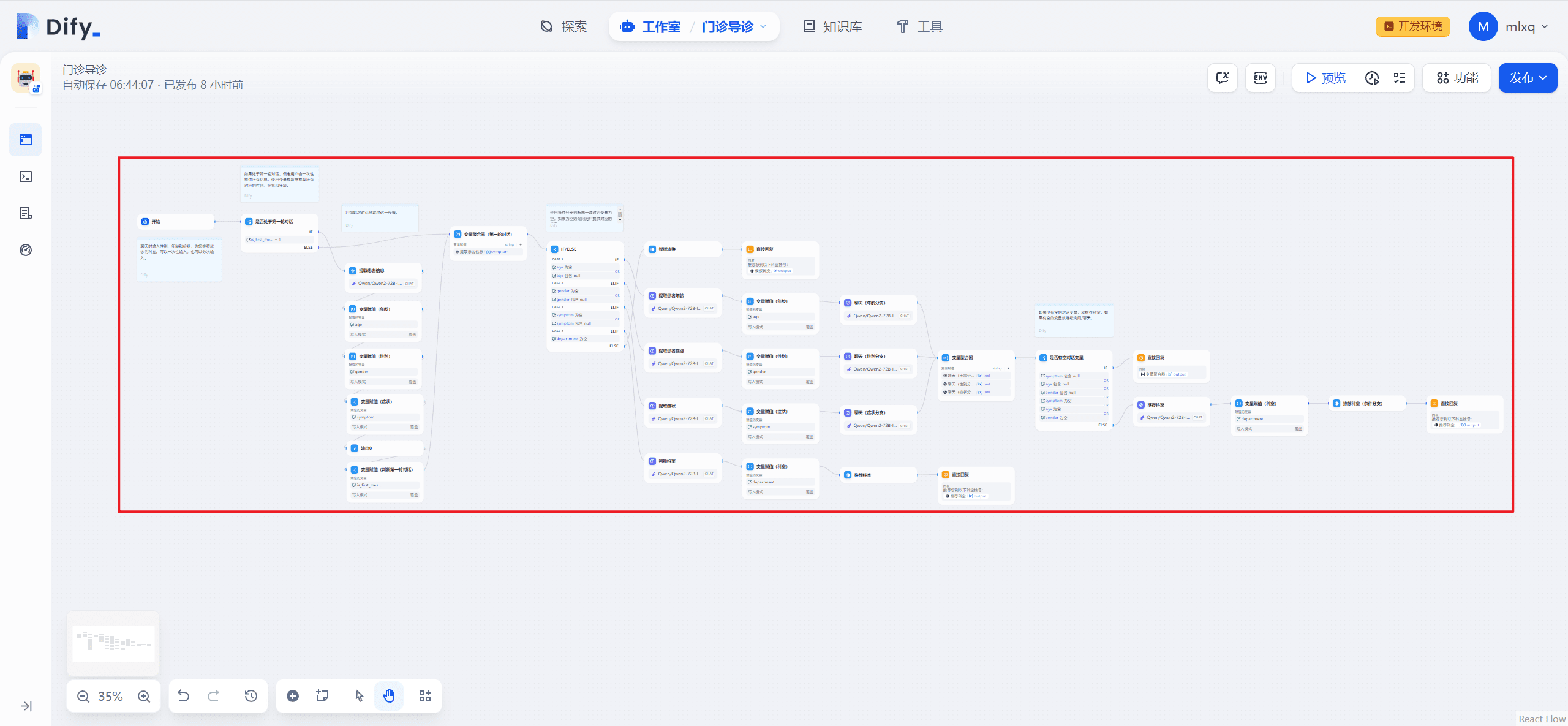

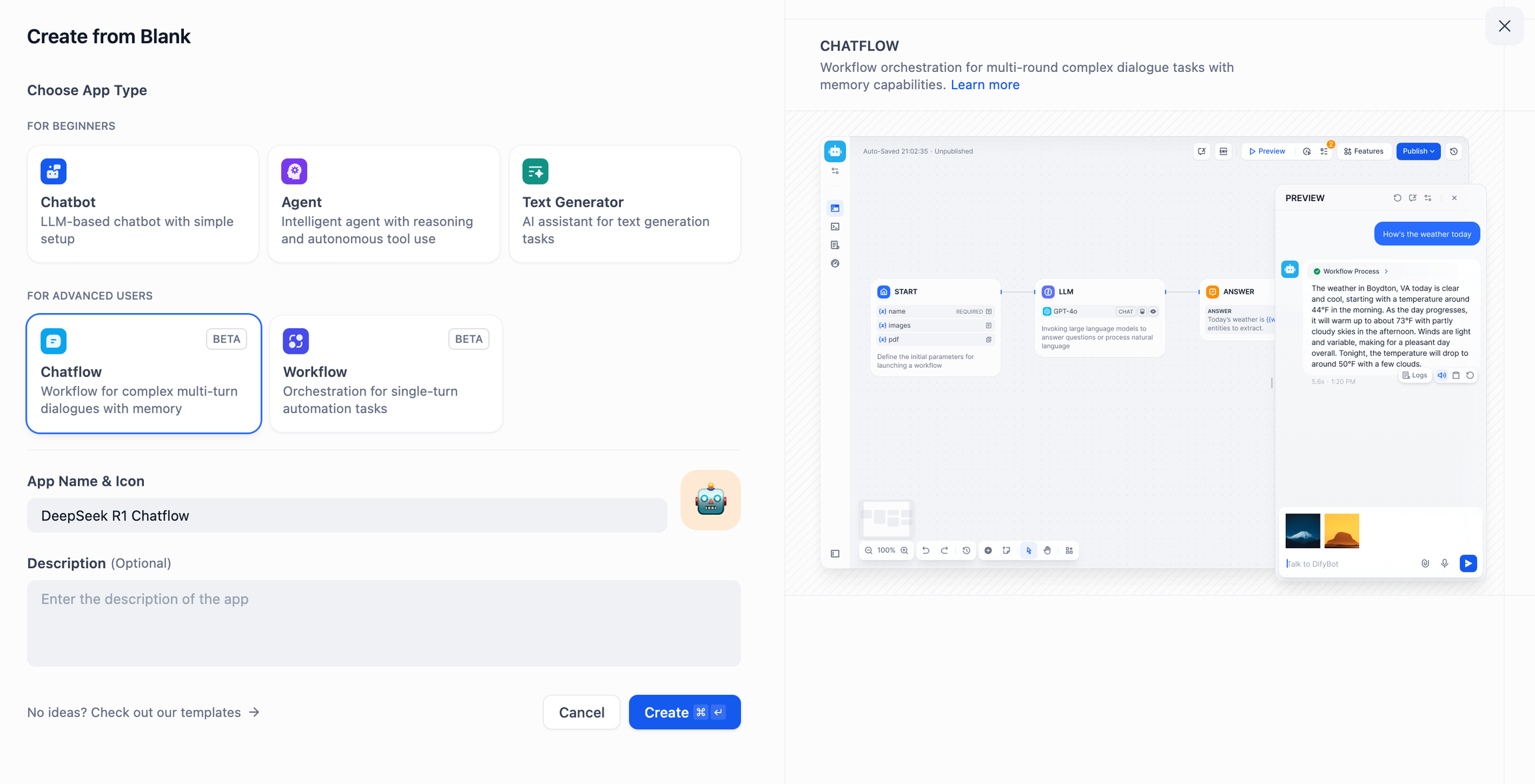

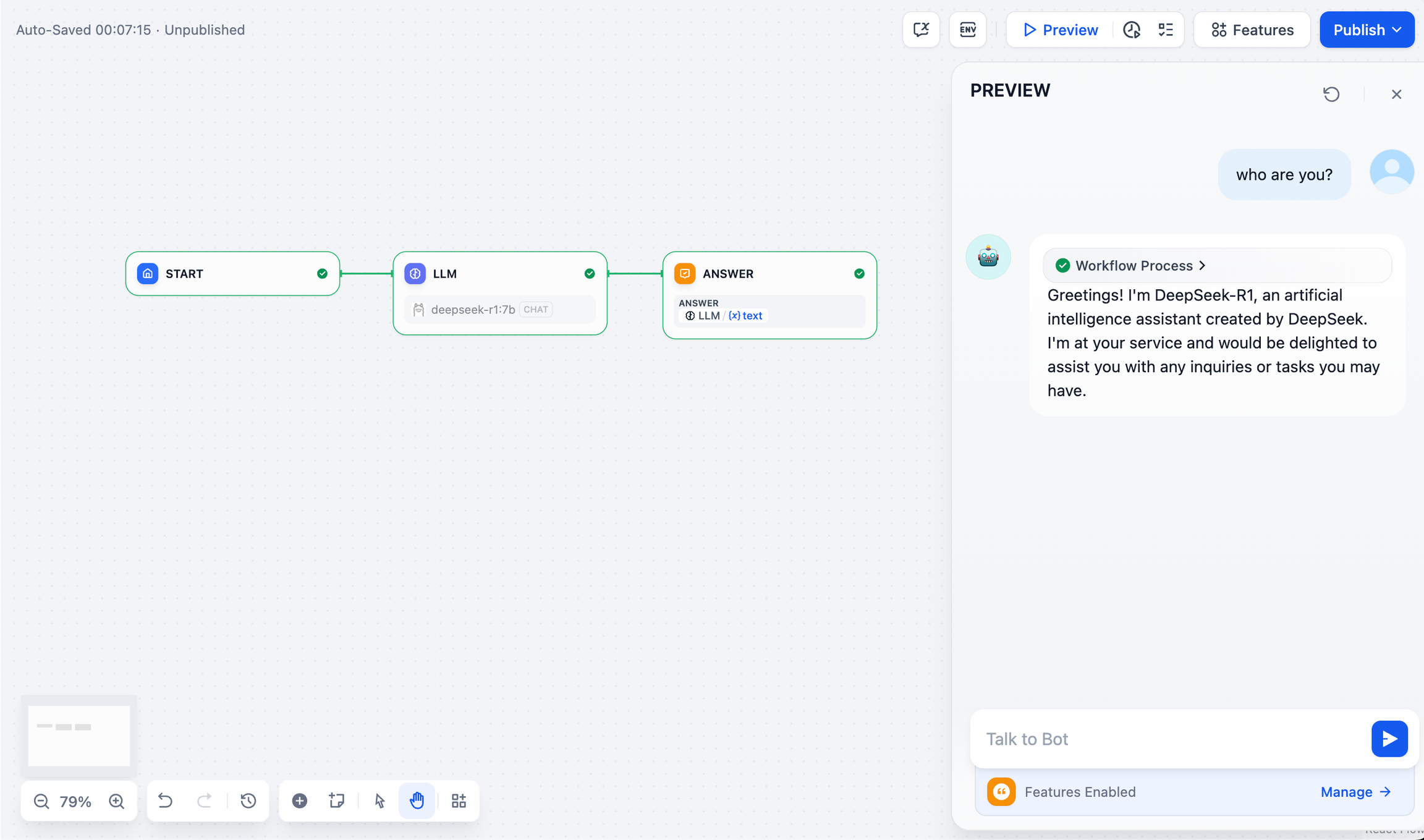

DeepSeek AI Chatflow / Fluxo de trabalho (aplicativos avançados)

Chatflow / Fluxo de trabalho Os aplicativos podem ajudá-lo a criar aplicativos de IA com funcionalidades mais complexas, como a capacidade de ter reconhecimento de documentos, reconhecimento de imagens, reconhecimento de voz e muito mais. Para obter instruções detalhadas, consulteDocumentação do fluxo de trabalho.

- Toque em "Create a Blank App" (Criar um aplicativo em branco) no lado esquerdo da página inicial da plataforma Dify, selecione um aplicativo do tipo "Chatflow" ou "Workflow" e dê a ele um nome simples.

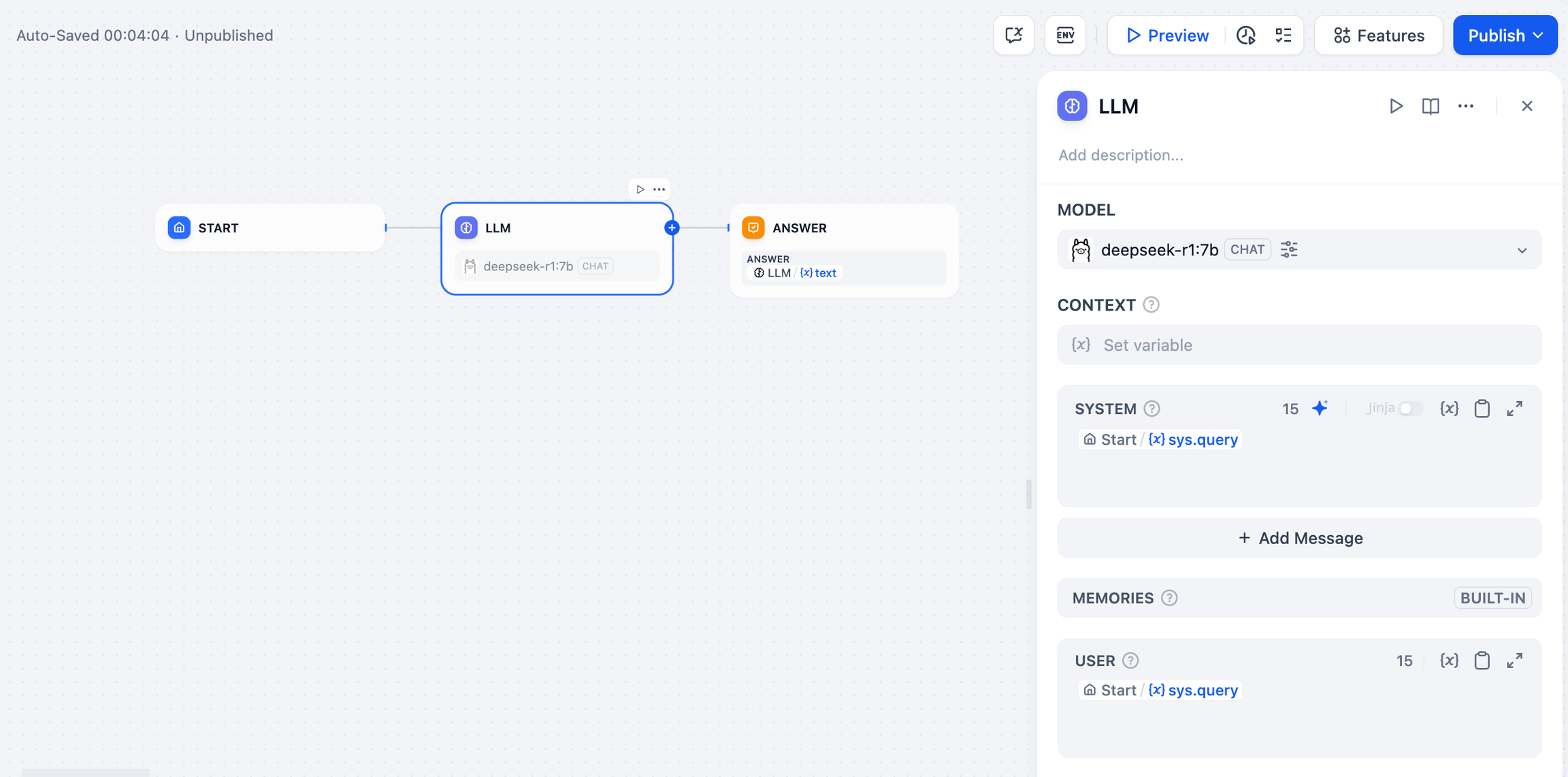

- Para adicionar um nó LLM, selecione a estrutura Ollama na seção

deepseek-r1:7be adicione a palavra de prompt do sistema no modelo{{#sys.query#}}para conectar o nó inicial.

- Adicione o nó final para concluir a configuração. Você pode inserir conteúdo na caixa de visualização para teste. A geração de uma resposta significa que a compilação do aplicativo de IA está concluída.

problemas comuns

1. erros de conexão durante a implantação do Docker

Os seguintes erros podem ser encontrados ao implantar o Dify e o Ollama com o Docker:

httpconnectionpool(host=127.0.0.1,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

Causa do erro Localhost: Esse erro ocorre porque o serviço Ollama não está acessível no contêiner do Docker. localhost geralmente aponta para o próprio contêiner, não para o host ou outro contêiner. Para resolver esse problema, você precisa expor o serviço Ollama à rede.

Método de configuração do ambiente do macOS:

Se o Ollama estiver sendo executado como um aplicativo do macOS, você precisará definir as variáveis de ambiente usando o launchctl:

- Isso é feito chamando o

launchctl setenvConfiguração de variáveis de ambiente:

launchctlsetenvOLLAMA_HOST"0.0.0.0"

- Reinicie o aplicativo Ollama.

- Se as etapas acima não funcionarem, você pode usar o seguinte método:

O problema é que, dentro do docker, você deve se conectar ao host.docker.internalpara acessar o host da estação, portanto, defina o localhost Substituir por host.docker.internal O serviço está pronto para entrar em vigor:

http://host.docker.internal:11434

Método de configuração do ambiente Linux:

Se o Ollama estiver sendo executado como um serviço systemd, você deverá usar o comando systemctl Configuração de variáveis de ambiente:

- Isso é feito chamando o

systemctl edit ollama.serviceEdite o serviço systemd. Isso abrirá um editor. - Para cada variável de ambiente, a variável

[Service]Adicione uma linha abaixo da seçãoEnvironment::

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

- Salvar e sair.

- carga pesada (em um caminhão)

systemde reiniciar o Ollama:

systemctldaemon-reload

systemctlrestartollama

Método de configuração do ambiente do Windows:

No Windows, o Ollama herda as variáveis de ambiente do usuário e do sistema.

- Em primeiro lugar, clique em Ollama na barra de tarefas para sair do programa.

- Edite as variáveis de ambiente do sistema no painel de controle

- Edite ou crie novas variáveis para sua conta de usuário, como

OLLAMA_HOSTeOLLAMA_MODELSetc. - Clique em OK / Aplicar Salvar

- Executar em uma nova janela de terminal

ollama

2) Como posso alterar o endereço do serviço Ollama e o número da porta?

Encadernação padrão Ollama 127.0.0.1 porta 11434, que pode ser acessada por meio do OLLAMA_HOST As variáveis de ambiente alteram o endereço de vinculação.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...