Perguntas frequentes sobre o uso da API DeepSeek-R1

API do DeepSeek-R1

O nome do modelo padrão é: deepseek-reasoner

O DeepSeek-R1 suporta acessos ao cache

Os acessos ao cache são geralmente usados para entradas de alta frequência com poucos exemplos de amostra, entradas de documentos grandes com várias saídas (menos de 64 tokens (cujo conteúdo não será armazenado em cache)

A parte de entrada do sistema e as mensagens do usuário são contadas como acessos ao cache.

Os acessos ao cache são sensíveis ao tempo, normalmente variando de algumas horas a alguns dias

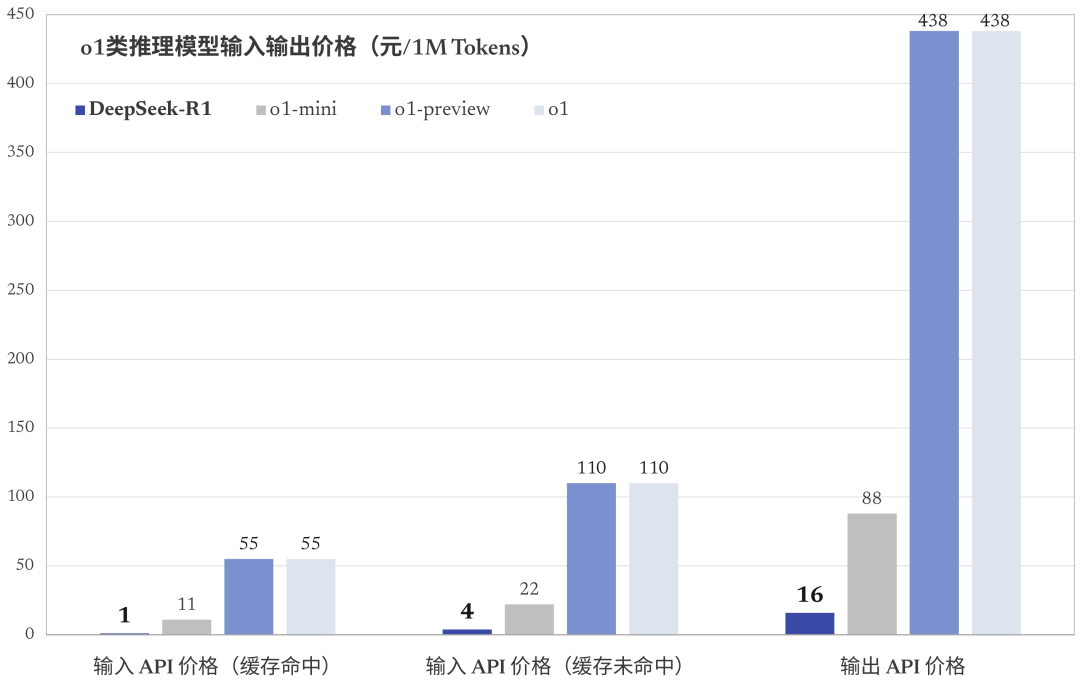

Número de tokens atingidos pelo cache ($1/milhão de tokens)

Problemas de saída do DeepSeek-R1

DeepSeek-R1 A saída consiste na saída da cadeia de raciocínio e na saída da resposta, sendo que ambas contam como saída token O faturamento é o mesmo.

A API suporta até 64 mil contextos, e as cadeias de pensamento não contam para o comprimento total.

A saída da cadeia de raciocínio pode ser definida para um máximo (reasoning_effort) de 32 mil tokens; a saída da resposta pode ser definida para um máximo (max_tokens) de 8 mil tokens.

Splicing de contexto do DeepSeek-R1

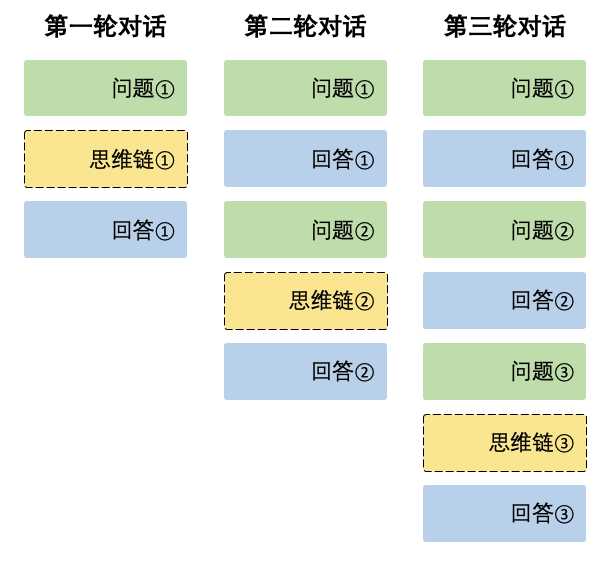

Durante cada rodada de diálogo, o modelo gera o conteúdo da cadeia de pensamento (reasoning_content) e a resposta final (content). Na próxima rodada de diálogo, o conteúdo do resultado da cadeia de pensamento da rodada anterior não é inserido no contexto, como mostrado abaixo:

O contexto sempre retém a última rodada da cadeia de pensamento, caso contrário, a resposta de saída será confusa.

Sobre o uso da API DeepSeek-R1 de terceiros

Observe a incompatibilidade com os formatos oficiais! Por exemplo, fluxo baseado em silício.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...