Como faço para converter a API fornecida pela Dify em um formato compatível com a interface OpenAI?

Sim, eu fiz. Dify Para aqueles que conhecem o Dify, devem saber que, embora seja um ótimo aplicativo de IA, a API que ele fornece é incompatível com o Open AI, o que impossibilita a interface de alguns aplicativos com o Dify.

O que pode ser feito a respeito?

É possível usar "APIs de trânsito", a mais famosa das quais seria Uma API: gerenciamento de API de vários modelos e balanceamento de carga, sistema de distribuição Ele pode agregar diferentes modelos de IA e, em seguida, unificá-los em APIs OpenAI para distribuição, mas ainda não oferece suporte ao acesso da Dify, portanto, embora haja uma saída, ele não pode resolver o problema acima.

Neste momento, uma grande oportunidade, com base na API One para fazer a segunda abertura, o nome do projeto é Nova APIEsse projeto é totalmente compatível com a Dify, portanto, podemos finalmente brincar com a API da Dify!

Após a implementação bem-sucedida, nós o acessamos via IP + porta:

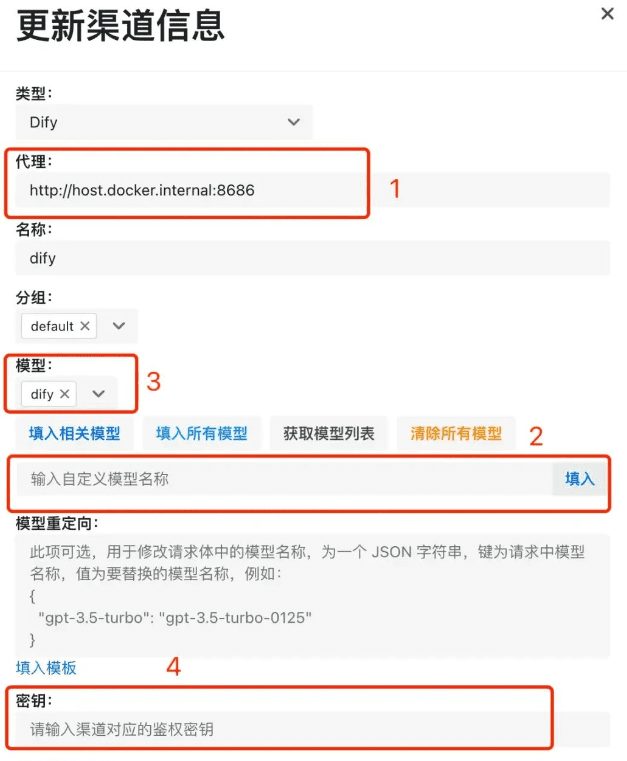

- Depois de verificarmos o tipo de Dify, temos de inserir o endereço do serviço Dify. Se o serviço new-api e o dify forem implantados em uma única máquina via docker, lembre-se de inserir o endereço do serviço

http://host.docker.internal:你的端口号A captura de tela é meu exemplo, portanto, não a copie como está. Se você não estiver usando o método de implantação do docker, precisará digitar o endereçohttp:// ip + 端口号Pronto para começar; - Como estamos acessando o dify, tudo o que precisamos fazer para a seleção do modelo é inserir um nome de modelo personalizado, como dify, e depois clicar no botão "Fill in" (Preencher) no final;

- Seja um modelo personalizado ou outro modelo selecionado, ele deve ser mostrado na posição 3 da captura de tela, e o fato de não ser mostrado significa que não está configurado;

- Ao concluir o envio, podemos ver os dados na lista de canais ~~~

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...