TL;DR Este artigo tem mais de 8200 palavras e leva cerca de 15 minutos para ser lido na íntegra. Este documento analisa brevemente os mais recentes aplicativos de modelos grandes, desde máquinas perceptuais até aprendizagem profunda ChatGPT A história do

Original: https://hutusi.com/articles/the-history-of-neural-networks

Não há nada a temer na vida, apenas coisas a entender.

-- Sra. Curie

I Redes de crenças profundas

Em 2006, Jeffrey Hinton, professor da Universidade de Toronto, no Canadá, estava pesquisando como treinar redes neurais de várias camadas e vem trabalhando discretamente no campo das redes neurais há mais de três décadas. Embora seja considerado uma figura titânica nesse campo, os resultados de sua pesquisa foram subestimados pelo setor porque as redes neurais foram subestimadas no setor de inteligência artificial.

Nascido em Londres, Inglaterra, a família de Hinton produziu vários acadêmicos eminentes, e George Boole, o lógico que fundou a álgebra booleana, era seu tataravô. Seu avô era escritor científico e seu pai, entomologista. Hinton era mais inteligente do que todos ao seu redor, mas sua trajetória escolar foi um pouco difícil, primeiro estudando arquitetura na universidade, depois física, depois filosofia e, por fim, graduando-se em psicologia. Em 1972, Hinton ingressou na Universidade de Edimburgo para fazer um doutorado em redes neurais, que na época era considerado o campo mais popular do setor. Na época, as redes neurais eram desprezadas pelo setor e até mesmo os supervisores de Hinton achavam que elas eram de pouca utilidade prática e não tinham futuro. No entanto, Hinton não se deixou abalar e acreditou na pesquisa de redes neurais, insistindo que poderia provar o valor das redes neurais, o que fez por mais de 30 anos.

Hinton sofreu um deslizamento de disco na coluna lombar quando era jovem e estava movendo um aquecedor e, desde então, sofre de problemas lombares. Nos últimos anos, o problema se agravou e, na maioria das vezes, ele precisa deitar-se de costas para aliviar a dor, o que significa que não pode dirigir, voar ou mesmo deitar-se em uma cama dobrável em seu escritório quando se reúne com os alunos no laboratório. A dor física da provação não atingiu Hinton de forma tão intensa quanto a indiferença em relação à pesquisa acadêmica. Já em 1969, Minsky, em seu livro Perceptual Machines (Máquinas Perceptuais), estabeleceu a lei sobre as máquinas perceptuais de múltiplas camadas, colocando um selo de aprovação na pesquisa subsequente de redes neurais: "Não haverá futuro para as máquinas perceptuais de múltiplas camadas porque ninguém no mundo pode treinar uma máquina perceptual de múltiplas camadas bem o suficiente, nem mesmo para torná-la capaz de aprender os métodos mais simples de funcionamento". A capacidade limitada dos perceptrons de camada única, que não conseguem nem mesmo resolver problemas básicos de classificação, como "heterocedasticidade", e a falta de métodos de treinamento disponíveis para perceptrons multicamadas equivalem a dizer que a direção da pesquisa de redes neurais é um beco sem saída. As redes neurais eram consideradas uma heresia acadêmica no setor, e ninguém acreditava que pudessem ser bem-sucedidas. Portanto, os alunos tinham o cuidado de ignorar as redes neurais ao escolher seus supervisores e, por algum tempo, Sinton não conseguia nem mesmo recrutar um número suficiente de alunos de pós-graduação.

Em 1983, Hinton inventou a máquina de Boltzmann e, mais tarde, a máquina de Boltzmann restrita simplificada foi aplicada ao aprendizado de máquina e tornou-se a base para a estrutura hierárquica das redes neurais profundas. Em 1986, Hinton propôs o algoritmo de retropropagação de erros (BP) para máquinas perceptuais multicamadas, um algoritmo que estabeleceu a base para o que se tornaria o aprendizado profundo. Hinton inventava algo novo de vez em quando e persistia em escrever mais de duzentos artigos relacionados a redes neurais, mesmo que não fossem bem recebidos. Em 2006, Hinton havia acumulado uma rica base teórica e prática e, dessa vez, publicou um artigo que mudaria todo o aprendizado de máquina e, de fato, o mundo inteiro.

Sinton descobriu que as redes neurais com várias camadas ocultas podem ter a capacidade de extrair automaticamente recursos para aprendizado, o que é mais eficaz do que o aprendizado de máquina tradicional com extração manual de recursos. Além disso, a dificuldade de treinar redes neurais de várias camadas pode ser reduzida por meio do pré-treinamento camada por camada, o que resolve o problema de longa data do treinamento de redes neurais de várias camadas. Hinton publicou seus resultados em dois artigos em uma época em que o termo rede neural era rejeitado por muitos editores de revistas acadêmicas, e alguns títulos de manuscritos foram até devolvidos porque continham a palavra "rede neural". Para não irritar a sensibilidade dessas pessoas, Hinton adotou um novo nome e batizou o modelo de "Deep Belief Network" (Rede de Crença Profunda).

II. sensores

Na verdade, a pesquisa da rede neural remonta à década de 1940. Em 1940, Walter Pitts, de 17 anos, conheceu o professor Warren McCulloch, de 42 anos, na Universidade de Illinois em Chicago, e juntou-se ao projeto de pesquisa deste último: tentar usar redes de neurônios para construir um modelo mecânico do cérebro com base em operações lógicas. Eles usaram operações lógicas para abstrair o modelo de pensamento do cérebro humano e propuseram o conceito de "Rede Neural" (Rede Neural), e os neurônios são a menor unidade de processamento de informações na rede neural; eles abstraíram e simplificaram o processo de trabalho dos neurônios em um modelo de operação lógica muito simples, que mais tarde foi denominado "M O modelo foi batizado de "Modelo de neurônio M-P" após as iniciais de seus dois nomes.

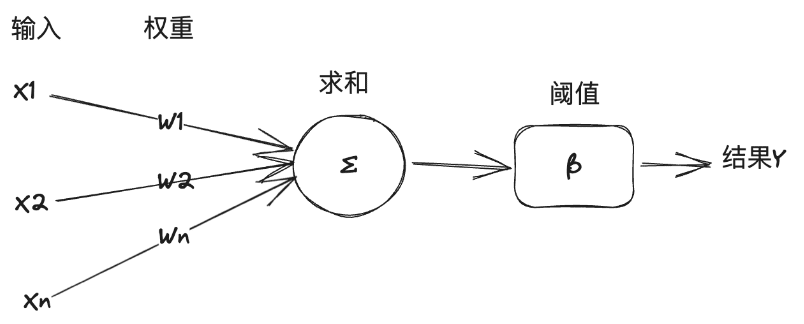

Nesse modelo, um neurônio recebe vários sinais de entrada de outros neurônios, e o significado dos sinais de entrada varia de um neurônio para outro, o que é representado pelo "peso" da conexão, e o neurônio soma todas as entradas de acordo com o peso e compara o resultado com o "limiar" do neurônio para decidir se deve ou não emitir o sinal. O neurônio soma todas as entradas de acordo com os pesos e compara o resultado com o "limiar" do neurônio para decidir se deve ou não emitir um sinal para o mundo externo.

O "modelo M-P" é suficientemente simples e direto para ser modelado pela lógica simbólica, e os especialistas em IA o usaram como base para a criação de modelos de redes neurais para resolver tarefas de aprendizado de máquina. Aqui está uma breve explicação da relação entre inteligência artificial, aprendizado de máquina e aprendizado profundo: Inteligência artificial é o uso da tecnologia da computação para alcançar a inteligência humana, no livro geral definido como o estudo e a construção de agentes inteligentes. Agente inteligente é um agente inteligente, ou simplesmente agente, que resolve tarefas específicas ou tarefas de uso geral imitando o pensamento e a cognição humanos. O agente inteligente que resolve tarefas características é conhecido como inteligência artificial fraca, ou inteligência artificial estreita (ANI), enquanto o agente inteligente que resolve tarefas de uso geral é conhecido como inteligência artificial forte, ou inteligência artificial de uso geral (AGI). O aprendizado de máquina é um ramo da IA que aprende com os dados e aprimora os sistemas. O aprendizado profundo, por outro lado, é outro ramo do aprendizado de máquina, que usa técnicas de rede neural para aprendizado de máquina.

Em 1957, Rosenblatt, professor de psicologia da Universidade de Cornell, simulou e implementou um modelo de rede neural, que ele chamou de Perceptron, em um computador IBM. Sua abordagem era montar um conjunto de neurônios do modelo M-P que pudesse ser usado para treinar e executar algumas tarefas de reconhecimento de padrões de visão de máquina. Em geral, o aprendizado de máquina tem dois tipos de tarefas: classificação e regressão. A classificação é o problema de determinar em qual classe os dados se encontram, como identificar se uma imagem é de um gato ou de um cachorro, enquanto a regressão é o problema de prever um dado a partir de outro, como prever o peso de uma pessoa com base em sua imagem. Os Perceptrons resolvem problemas de classificação linear. Explique isso com um exemplo de como as máquinas perceptron funcionam do livro "The Frontiers of Intelligence":

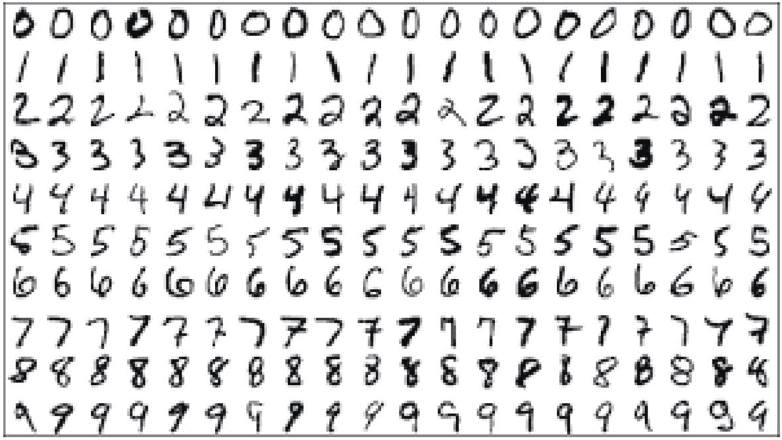

Suponhamos que o objetivo da tarefa seja reconhecer automaticamente os algarismos arábicos; os números a serem reconhecidos serão escritos à mão ou impressos de várias formas; os números serão armazenados por meio de digitalização em um arquivo de imagem com tamanho de 14*14 pixels. Primeiramente, um conjunto de treinamento semelhante ao da figura a seguir é preparado para o aprendizado de máquina. O conjunto de treinamento é um conjunto de dados fornecido especialmente para o aprendizado de computador; não é apenas um conjunto de imagens e outros dados, ele será pré-rotulado manualmente para informar à máquina quais são os números representados pelos dados da imagem.

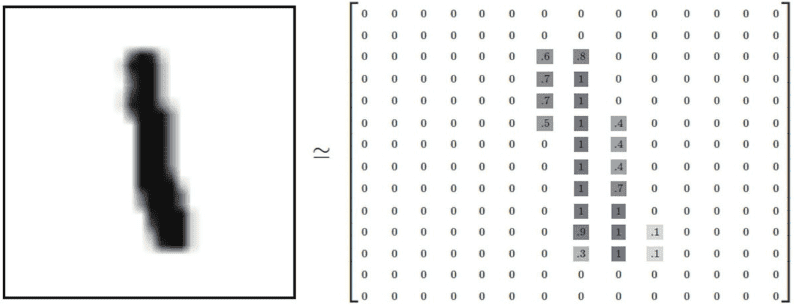

Em seguida, temos de projetar uma estrutura de dados para que a máquina possa armazenar e processar essas imagens. Para uma imagem digital em escala de cinza 14*14, os pixels pretos podem ser representados por 1, os pixels brancos por 0 e os pixels em escala de cinza entre preto e branco são representados por um número de ponto flutuante entre 0 e 1, dependendo da intensidade da escala de cinza. Conforme mostrado na figura a seguir, essa figura pode ser convertida em uma matriz de tensor bidimensional:

E a máquina é capaz de reconhecer quais são os números na imagem, principalmente encontrando os recursos da imagem que representam um determinado número. Para os seres humanos, é fácil reconhecer esses números escritos à mão, mas é difícil para nós explicar o que são esses recursos. O objetivo do aprendizado de máquina é extrair os recursos dessas imagens no conjunto de treinamento que representam números e, de acordo com o modelo M-P, a maneira de extrair os recursos é escolher ponderar e somar os valores dos pixels individuais da imagem e calcular o peso de cada pixel correspondente a cada número com base nos resultados da correspondência entre as imagens de amostra no conjunto de treinamento e os dados anotados: se um determinado pixel tiver uma evidência muito negativa de que a imagem não pertence a um número Se um pixel tiver evidência muito negativa de que a imagem não pertence a um determinado número, o peso desse pixel será definido como um valor negativo para esse número; ao contrário, se um pixel tiver evidência muito positiva de que a imagem pertence a um determinado número, o peso desse pixel será definido como um valor positivo para esse número. Por exemplo, para o número "0", o pixel no ponto médio da imagem não deve ter um pixel preto (1); se ele aparecer, a imagem pertence ao número 0 como evidência negativa, o que reduz a probabilidade de que a imagem seja o número 0. Dessa forma, após o treinamento e a calibração do conjunto de dados, a distribuição de peso de cada pixel correspondente a cada número de 0 a 9 pode ser obtida como 14*14 (=196).

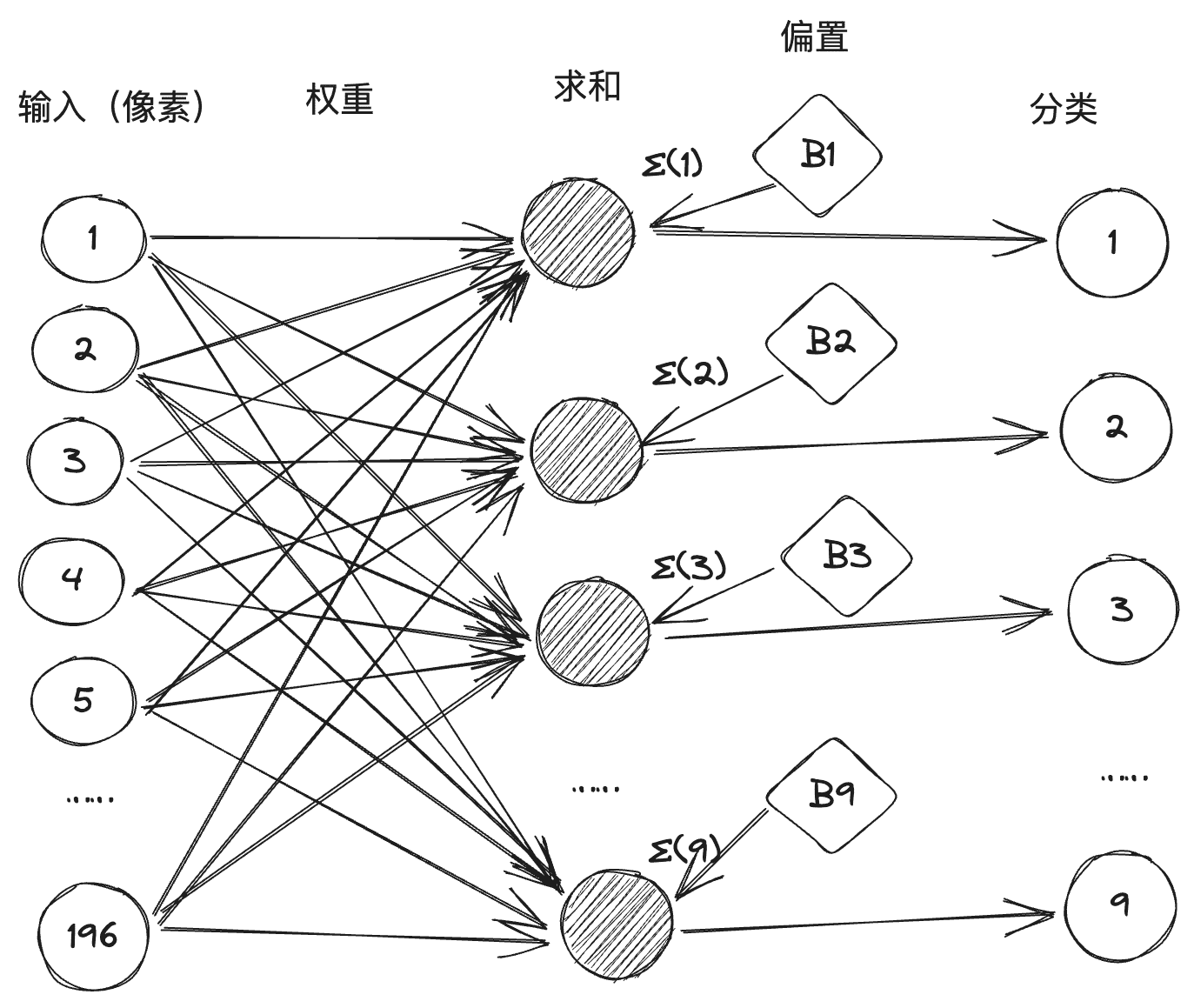

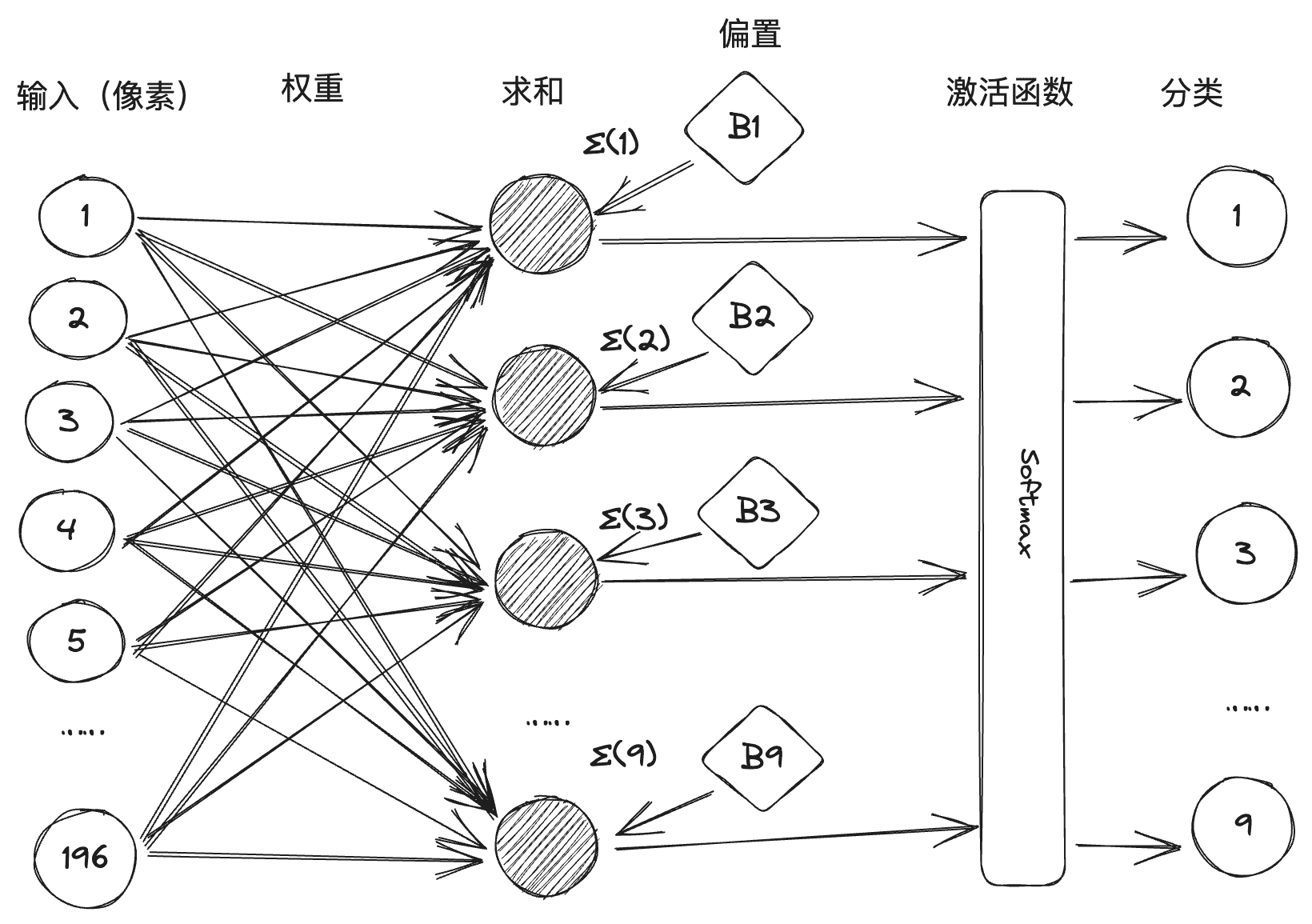

Em seguida, convertemos o processo de classificação de cada número em um neurônio M-P. Cada neurônio tem 196 entradas de pixel, e o valor do peso entre cada entrada e esse neurônio é obtido por meio de treinamento, de modo que ele constitui uma rede neural composta por 10 neurônios, 196 entradas e 1.960 linhas de conexão com pesos antes delas, conforme mostrado abaixo: (Geralmente, em uma rede neural, o valor limite será é convertido em um viés de polarização, chamado de um dos termos de soma, para simplificar o processo aritmético).

Entretanto, na prática, há ambiguidades em algumas fontes manuscritas que podem resultar na ativação de dois ou mais neurônios após a soma ponderada. Portanto, a máquina perceptual é implementada por meio da introdução do design da função de ativação, conforme mostrado na figura abaixo. A Softmax é uma função de ativação que processará o valor da soma para inibir a classificação numérica com pequena probabilidade e aprimorar a classificação numérica com grande probabilidade.

Dois anos depois, Rosenblatt criou o primeiro perceptron de hardware do mundo, o "Mark-1", capaz de identificar o alfabeto inglês, mas que, na época, causou grande sensação. O Departamento de Defesa dos EUA e os militares da Marinha também perceberam e deram muito apoio financeiro. Rosenblatt atingiu o pico de confiança na percepção da máquina, e até mesmo um repórter perguntou: "não há percepção de que a máquina não pode fazer coisas", e a resposta de Rosenblatt foi: "amor, esperança, desespero! A resposta de Rosenblatt foi "amor, esperança, desespero". A fama de Rosenblatt cresceu, e sua personalidade extravagante o levou a fazer inimigos em toda parte, sendo o mais famoso deles outro gigante da inteligência artificial, Marvin Minsky. Minsky foi o organizador da Conferência de Dartmouth e um dos fundadores da IA. Em 1969, ele publicou seu livro Perceptual Machines (Máquinas perceptuais), que identificava claramente as falhas que existiam nas máquinas perceptuais. A primeira foi uma demonstração matemática de que as máquinas perceptuais não conseguiam lidar com problemas de classificação não linear, como a heterocedasticidade, e a segunda foi uma demonstração de que a complexidade das máquinas perceptuais multicamadas levava a uma expansão drástica dos dados conectados sem um método de treinamento adequado. Minsky ganhou o quarto Prêmio Turing no ano da publicação do livro, e o imenso prestígio de seu julgamento sobre máquinas perceptuais condenou a pesquisa de redes neurais à morte. O conexionismo foi derrotado, e a pesquisa simbolista tornou-se a corrente principal da IA.

Há duas principais escolas de pensamento no campo da inteligência artificial: conectivismo e simbolismo, um pouco como a Seita da Espada e a Seita do Qi nos romances de artes marciais, que competem entre si há muito tempo. O conexionismo desenvolve a IA modelando o cérebro humano para criar redes neurais, armazenando conhecimento em um grande número de conexões e aprendendo com base nos dados. O simbolismo, por outro lado, acredita que o conhecimento e o raciocínio devem ser representados por símbolos e regras, ou seja, um grande número de definições de regras "se-então" para gerar decisões e raciocínio, e desenvolve a IA com base em regras e lógica. A primeira é representada por redes neurais e a segunda por sistemas especializados.

III Aprendizagem profunda

Com o fracasso da máquina de percepção, o investimento do governo no campo da IA diminuiu, e a IA entrou em seu primeiro período de inverno. E, na década de 1980, o simbolismo, representado por sistemas especializados, tornou-se a corrente principal da IA, desencadeando a segunda onda de IA, enquanto a pesquisa de redes neurais foi deixada de lado. Conforme mencionado anteriormente, há apenas uma pessoa que ainda persiste: Geoffrey Hinton.

Com base em seus predecessores, Sinton inventou sucessivamente a máquina de Boltzmann e o algoritmo de retropropagação de erros. As contribuições pioneiras de Sinton para o campo das redes neurais deram vida a esse campo, embora a corrente principal do campo da inteligência artificial da década de 1980 até o início do século ainda fosse a base de conhecimento e a análise estatística, e as várias técnicas de redes neurais começaram a surgir, com exemplos representativos, como as redes neurais convolucionais (CNNs), as redes de memória de longo prazo de curto prazo (LSTM), etc. (LSTM), etc. Em 2006, Hinton propôs redes de crenças profundas, o que abriu a era da aprendizagem profunda.

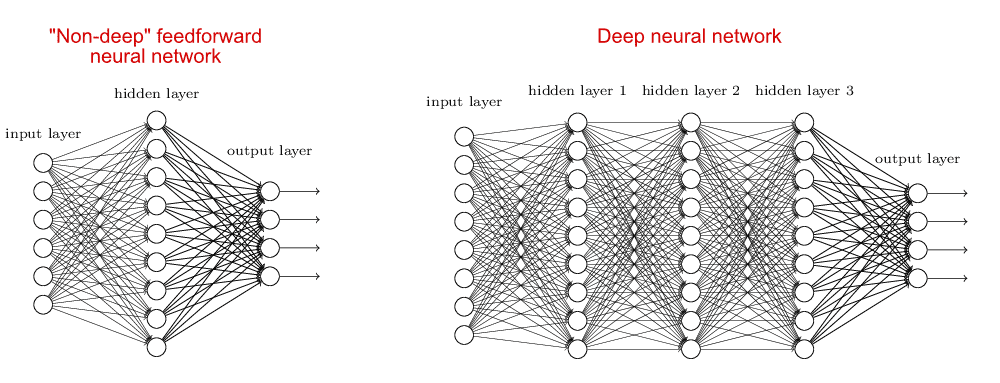

O modelo de rede neural correspondente à aprendizagem profunda é chamado de rede neural profunda, que é relativa às redes neurais superficiais. Nas redes neurais superficiais, geralmente há apenas uma camada oculta (ou camada intermediária), além das camadas de entrada e saída, em um total de três camadas. As redes neurais profundas, por outro lado, têm mais de uma camada oculta, comparando os dois tipos de redes neurais:

O motivo pelo qual as pessoas têm se concentrado em redes neurais superficiais antes da aprendizagem profunda é que o aumento no número de camadas da rede neural leva a um aumento na dificuldade de treinamento, por um lado, há uma falta de suporte aritmético suficiente e, por outro lado, não há um bom algoritmo. A rede de crenças profundas proposta por Hinton resolve esse problema de treinamento usando um algoritmo de retropropagação de erros e pré-treinando camada por camada. Depois da rede de crenças profundas, a rede neural profunda se tornou o principal modelo de aprendizado de máquina; os populares GPT, Llama e outros grandes modelos atuais são criados a partir de uma ou mais redes neurais profundas.

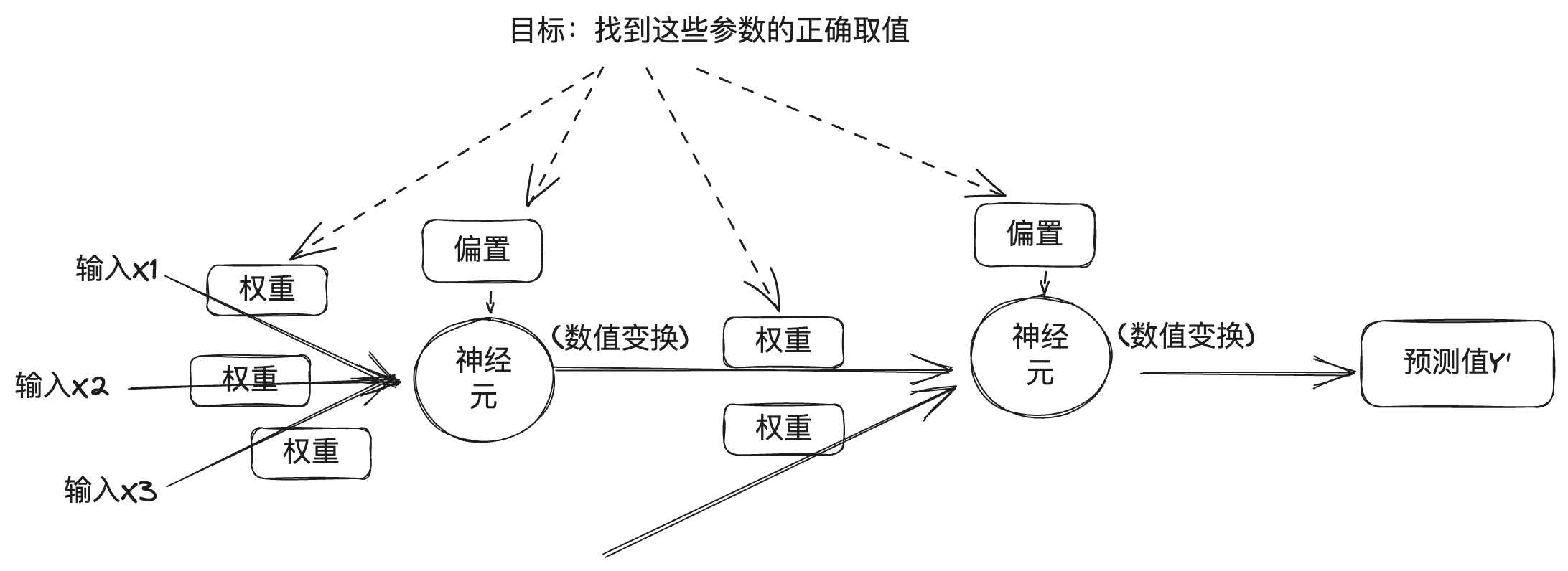

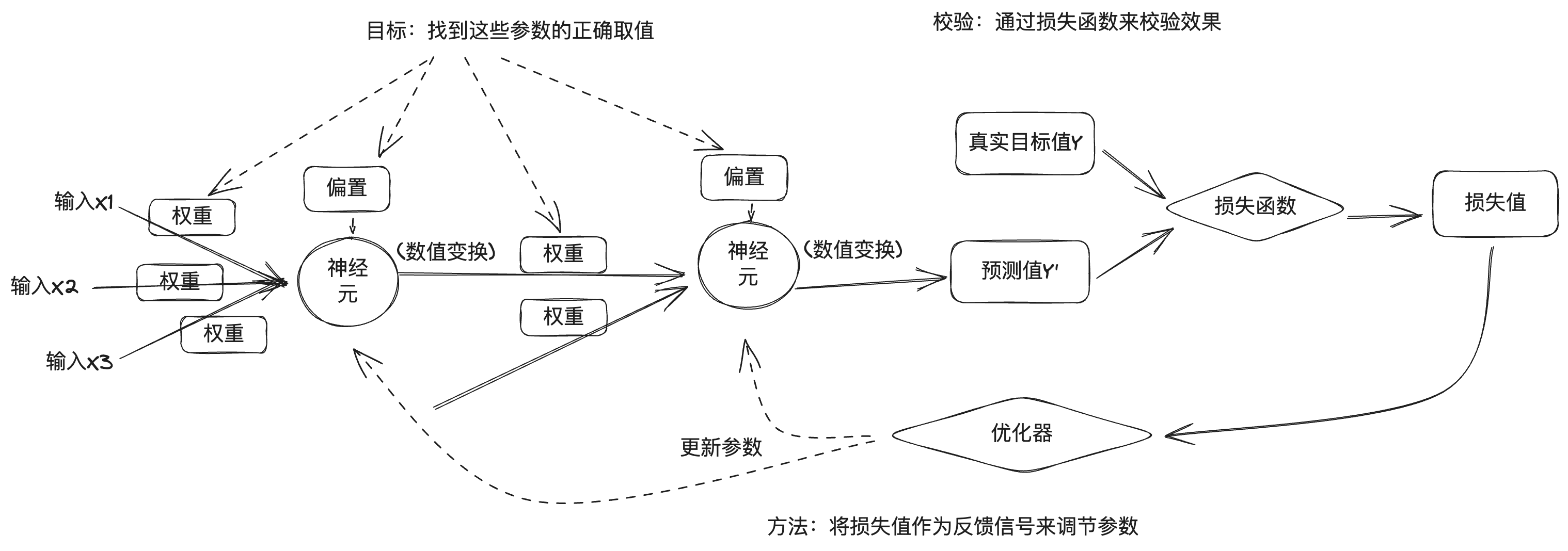

Para entender as redes neurais profundas, consulte a introdução do princípio da máquina perceptual acima. A rede neural profunda é considerada uma combinação de vários neurônios em várias camadas. A partir da seção anterior, pode-se entender que cada camada da saída está relacionada ao peso, à polarização e à função de ativação, e a saída da rede neural profunda também está relacionada ao número de camadas e a outros valores numéricos. Nas redes neurais profundas, esses valores podem ser divididos em duas categorias: uma é o número de camadas, a função de ativação, o otimizador etc., conhecido como hiperparâmetro, que é definido pelo engenheiro; a outra é o peso e a polarização, conhecidos como parâmetro, que são obtidos automaticamente durante o processo de treinamento das redes neurais profundas, e encontrar o parâmetro correto é o objetivo da aprendizagem profunda.

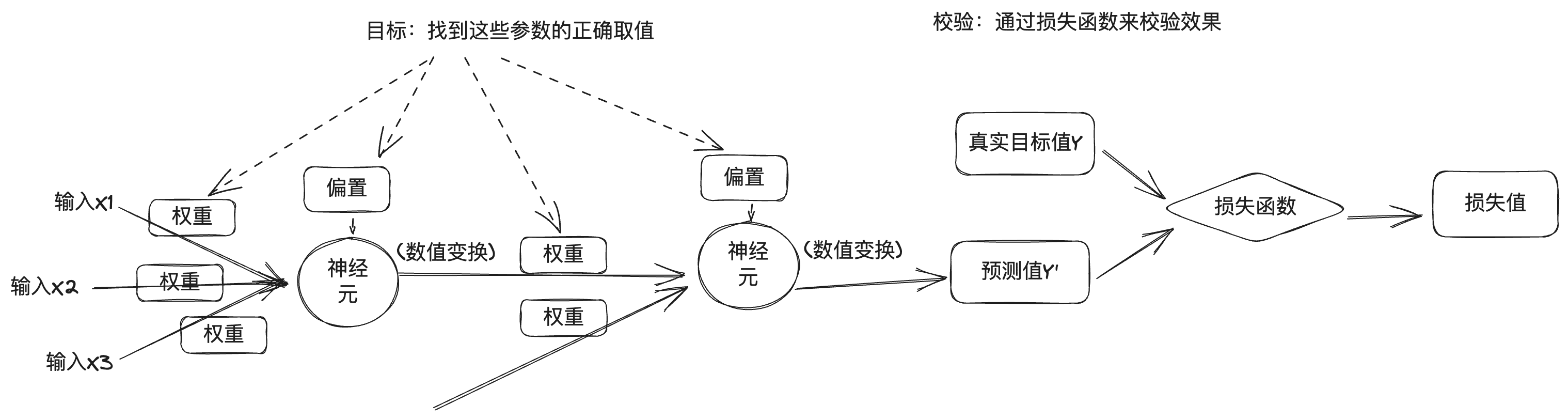

Mas o problema é que uma rede neural profunda contém um grande número de parâmetros, e a modificação de um parâmetro afetará o comportamento dos outros, portanto, encontrar os valores corretos para esses parâmetros é uma tarefa difícil. Para descobrir os valores corretos dos parâmetros e produzir a saída do modelo com precisão, precisamos de uma maneira de medir a diferença entre a saída do modelo e a saída desejada. Portanto, o treinamento de aprendizagem profunda é medido usando uma função de perda, que também é conhecida como função objetiva ou função de custo. A função de perda indica quão bom ou ruim é o modelo de rede neural nessa amostra de treinamento, comparando o valor previsto da rede neural profunda com o valor real do alvo para obter o valor da perda.

A abordagem de aprendizagem profunda usa os valores de perda como sinais de feedback para fazer o ajuste fino dos parâmetros a fim de reduzir os valores de perda para o treinamento da amostra atual. Esse ajuste é feito por um otimizador que implementa algoritmos de otimização, como a descida de gradiente, para atualizar os parâmetros dos nós dos neurônios em cada camada por meio da retropropagação.

No início, os parâmetros da rede neural serão atribuídos aleatoriamente, um lote de dados de treinamento será inserido e, depois de obter a saída prevista da rede por meio da camada de entrada e da camada oculta para a camada de saída, o valor da perda será calculado de acordo com a função de perda, que é o processo de propagação para frente; em seguida, a partir da camada de saída, o gradiente dos parâmetros será calculado na direção inversa ao longo de cada camada até a camada de entrada e os parâmetros da rede serão atualizados usando o algoritmo de otimização com base no gradiente, que é o processo de propagação para trás . A cada lote de amostras de treinamento processadas pela rede neural, os parâmetros são ajustados na direção certa e os valores de perda são reduzidos, o que constitui o ciclo de treinamento. Um número suficiente de ciclos de treinamento resulta em parâmetros que minimizam a função de perda, o que resulta em um bom modelo de rede neural.

É claro que o processo real de aprendizagem profunda é muito mais complexo do que isso, portanto, aqui está apenas uma breve visão geral do processo geral.

Em 2012, Hinton liderou dois de seus alunos, Alex Krizhevsky e Ilya Sutskever, para desenvolver a rede neural AlexNet, que competiu no concurso de reconhecimento de imagens ImageNet e venceu o campeonato, com uma taxa de precisão muito maior do que a do segundo colocado. Em seguida, Hinton e seus alunos fundaram a DNNResearch, Inc. para se concentrar em redes neurais profundas. A empresa não tinha produtos ou ativos, mas o sucesso da AlexNet atraiu vários gigantes da Internet. No inverno de 2012, um leilão secreto estava em andamento em Lake Tahoe, na fronteira entre os EUA e o Canadá: o objeto do leilão era a recém-fundada DNNResearch, e os compradores eram o Google, a Microsoft, a DeepMind e o Baidu. No final, enquanto o Google e o Baidu ainda estavam dando lances para aumentar o preço, Hinton cancelou o leilão e optou por vendê-lo ao Google por US$ 44 milhões.Em 2014, o Google embolsou o DeepMind.Em 2016, o AlphaGo, que usa uma combinação de busca clássica em árvore de Monte Carlo e redes neurais profundas, derrotou Lee Sedol e, no ano seguinte, derrotou o jogador número 1 do ranking mundial de Go, Ke Jie, e o AlphaGo levou os limites da inteligência artificial e da aprendizagem profunda para um novo patamar.

Quatro modelos principais

Em 2015, Musk, o CTO da Stripe, Greg Brockman, os CEOs da YC Ventures, Sam Altman e Ilya Sutskever, e outros se reuniram no Resewood Hotel, na Califórnia, para discutir a criação de um laboratório de IA para combater o controle da tecnologia de IA por grandes empresas de Internet. Em seguida, Greg Brockman reuniu um grupo de pesquisadores do Google, Microsoft e outros para formar um novo laboratório chamado OpenAI, com Greg Brockman, Sam Altman e Ilya Sutskever atuando como presidente, CEO e cientista-chefe da OpenAI, respectivamente.

Musk e Sam Altman originalmente imaginaram a OpenAI como uma organização sem fins lucrativos que abriria a tecnologia de IA para todos como uma forma de combater os perigos representados pelo controle da tecnologia de IA por grandes empresas de Internet. Como a tecnologia de IA de aprendizagem profunda estava explodindo, ninguém podia prever se a tecnologia seria uma ameaça para a humanidade no futuro, e a abertura poderia ser a melhor maneira de combater isso. E, mais tarde, em 2019, a OpenAI optou por criar uma subsidiária lucrativa para financiar o desenvolvimento de sua tecnologia e fechar o código-fonte de sua tecnologia principal, que foi uma reflexão tardia.

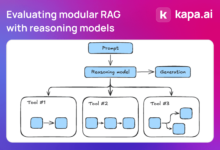

Em 2017, os engenheiros do Google publicaram um artigo chamado Attention is all you need (Atenção é tudo o que você precisa), no qual foi proposto que a Transformador Arquitetura de rede neural, que se caracteriza pela introdução de mecanismos de atenção humana nas redes neurais. O reconhecimento de imagens mencionado anteriormente é um cenário na aprendizagem profunda, em que os dados da imagem são dados discretos sem correlação entre eles. Na vida real, há outro cenário, que é lidar com dados temporais, como texto, em que o contexto do texto está relacionado, assim como voz, vídeo etc., que são dados temporais. Esses dados ordenados no tempo são chamados de sequência (sequence), e a tarefa real geralmente é uma sequência em outra sequência, como tradução, um parágrafo de chinês em um parágrafo de inglês, bem como perguntas e respostas de robôs, um parágrafo da pergunta em um parágrafo de respostas geradas de forma inteligente e, portanto, o uso do conversor (Transformer), que também é a origem do nome Transformer. É daí que vem o nome Transformer. Conforme mencionado anteriormente, a excitação de um neurônio é determinada pela soma ponderada dos dados de entrada aos quais ele está conectado, e o peso representa a força da conexão. No caso de dados de séries temporais, o peso de cada elemento é diferente, o que é consistente com nossa experiência diária, por exemplo, veja a passagem a seguir:

Pesquisas demonstraram que a ordem dos caracteres chineses nem sempre afeta a leitura; por exemplo, quando você termina de ler esta frase, descobre que todos os caracteres nela estão confusos.

Isso se aplica não apenas aos caracteres chineses, mas também a outros idiomas humanos, como o inglês. Os engenheiros do Google introduziram o mecanismo de atenção no modelo de rede neural, usado no processamento de linguagem natural, para que a máquina possa "entender" a intenção da linguagem humana. Posteriormente, em 2018, a OpenAI lançou o GPT-1 com base na arquitetura Transformer, o GPT-2 em 2019, o GPT-3 em 2020 e o programa de perguntas e respostas ChatGPT AI com base no GPT-3.5 no final de 2022, o que é chocante em termos de sua capacidade de diálogo, e a IA deu um grande passo na direção da AGI.

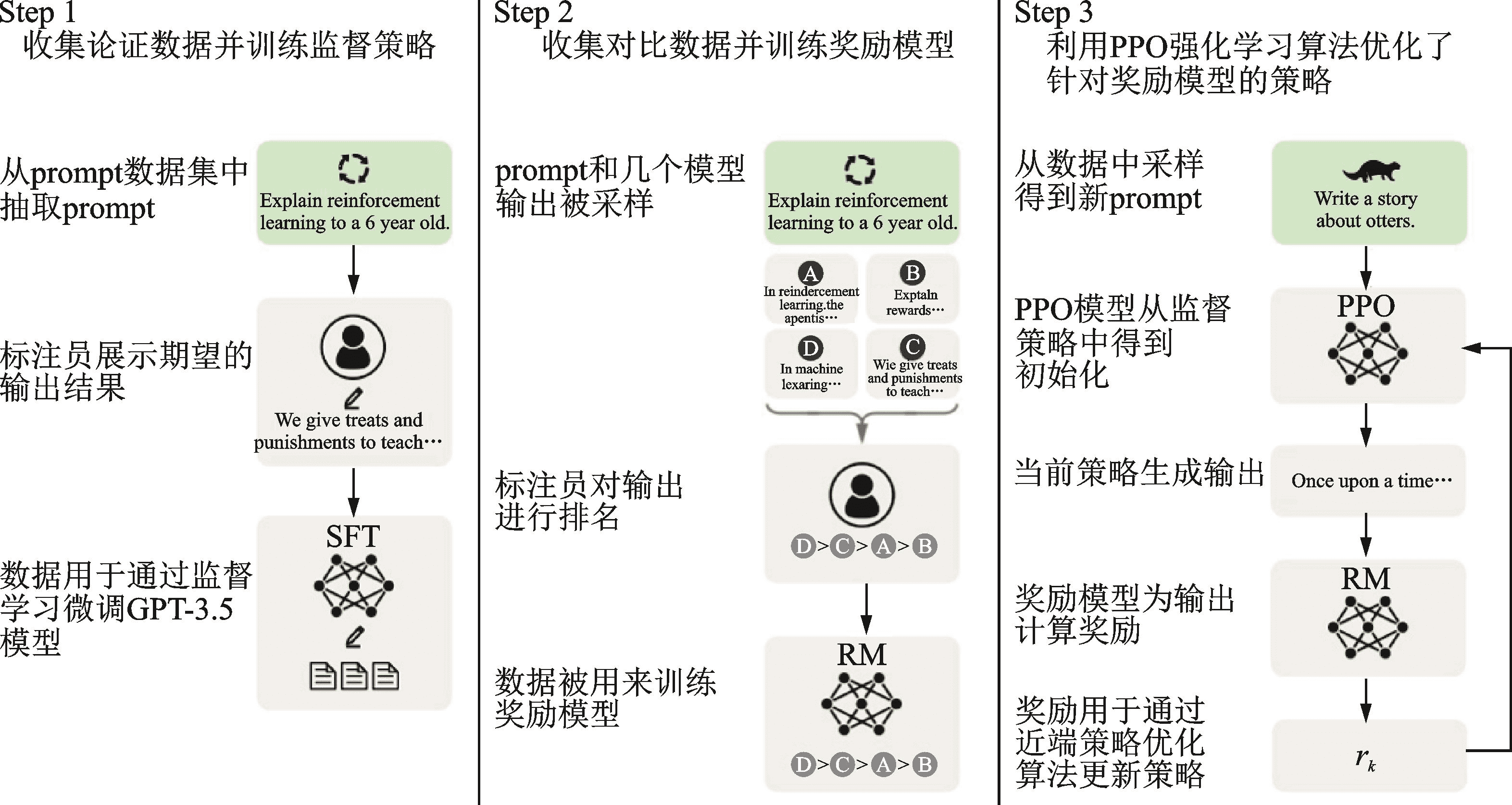

O nome completo do GPT é Generative Pre-trained Transformer, Generative indica sua capacidade de gerar novo conteúdo, Transformer é sua infraestrutura e Pre-trained no meio indica que seu método de treinamento é pré-treinamento. Por que ele é chamado de pré-treinado? Porque, a partir do AlexNet, as pessoas começaram a usar dados maiores e mais parâmetros no treinamento de redes neurais para obter melhores resultados, o que significa que o treinamento se tornou mais engenhoso e demorado. Esse custo é um pouco alto para o treinamento de tarefas específicas e é um pouco desperdiçador, pois não pode ser compartilhado com outras redes neurais. Portanto, o setor começou a adotar uma abordagem de pré-treinamento + ajuste fino para treinar modelos de redes neurais, ou seja, primeiro concluir o treinamento de um modelo geral grande em um conjunto de dados maior e, em seguida, concluir o ajuste fino do modelo com um conjunto de dados menor para cenários de tarefas específicas. O ChatGPT usa o aprendizado por reforço a partir de feedback humano (RLHF) para pré-treinamento e ajuste fino, que é dividido em três etapas: a primeira etapa é o pré-treinamento de um modelo de linguagem (LM); a segunda etapa é a coleta de dados de perguntas e respostas e o treinamento de um modelo de recompensa (RM); e a terceira etapa é o ajuste fino do modelo de linguagem (LM) com aprendizado por reforço (RL). Esse modelo de recompensa contém feedback humano, portanto, o processo de treinamento é chamado de RLHF.

Os usuários estão impressionados com a capacidade de várias rodadas de diálogo, além de sua precisão durante o uso do ChatGPT. De acordo com a exploração subjacente das redes neurais, vemos que cada processo de inferência vai da entrada até a saída, passando pela ponderação e ativação de cada neurônio, e não há capacidade de memória. E a razão pela qual o ChatGPT funciona bem com o diálogo de várias rodadas é porque ele usa a tecnologia da Prompt Engineering no gerenciamento do diálogo.

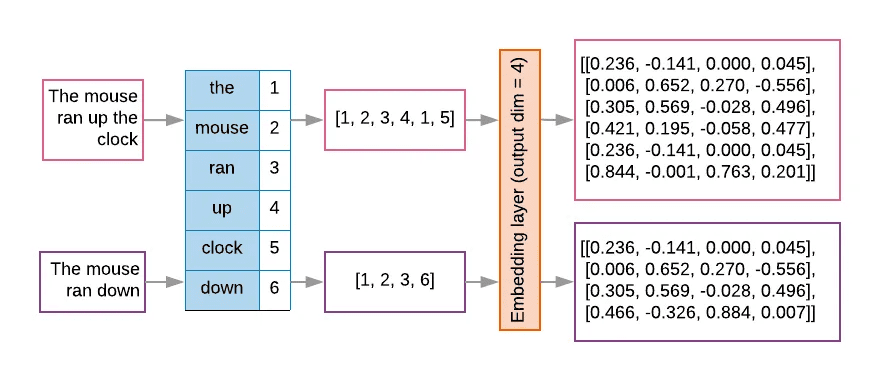

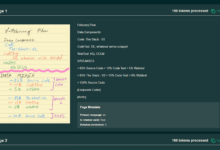

Para modelos de linguagem grandes, como o ChatGPT, sua entrada é um token após a conversão de uma cadeia de texto, e os modelos grandes geralmente projetam uma janela de contexto fixa para limitar o número de tokens de entrada devido à eficiência computacional e às restrições de memória. O texto será primeiramente subdividido pelo tokenizador e numerado pela tabela de pesquisa e, em seguida, incorporado à matriz em um vetor espacial de alta dimensão, que é o processo de vetorização do texto, conforme mostrado na figura a seguir.

Devido às limitações do número de tokens, é necessário usar técnicas de engenharia de prompts para fornecer ao modelo maior informações mais abrangentes em uma janela de contexto limitada. O Prompt Engineering usa várias estratégias para otimizar as entradas do modelo, de modo que ele produza saídas que correspondam melhor às expectativas.

Por trás do sucesso do ChatGPT está a evolução técnica do grande modelo representado pelo GPT. A OpenAI acredita que esforços vigorosos produzem milagres e tem expandido continuamente os parâmetros do GPT, com os parâmetros do modelo GPT-1 tendo 117 milhões, os parâmetros do modelo GPT-2 aumentados para 1,5 bilhão, o GPT-3 atingindo 175 bilhões e os parâmetros do modelo GPT-4 supostamente tendo 1,8 trilhão. Portanto, a OpenAI resumiu a "Lei da Escala", que afirma que o desempenho de um modelo está relacionado ao tamanho do modelo, ao volume de dados e aos recursos de computação, o que significa simplesmente que quanto maior o modelo, maior o volume de dados e maiores os recursos de computação, melhor será o desempenho do modelo. Rich Sutton, o pai do aprendizado por reforço, expressou uma visão semelhante em seu artigo "the Bitter Lesson" (a lição amarga), analisando o desenvolvimento da inteligência artificial nas últimas décadas, e concluiu que, no curto prazo, as pessoas estão sempre tentando melhorar o desempenho do corpo inteligente por meio da construção de conhecimento, mas, no longo prazo, o poderoso poder aritmético é o rei.

A capacidade dos grandes modelos também mudou de quantitativa para qualitativa. O cientista-chefe do Google, Jeff Dean, chamou isso de "habilidades emergentes" (Emergent abilities) dos grandes modelos. O mercado vê essa oportunidade: por um lado, os principais fornecedores de grandes modelos investem na corrida armamentista; por outro lado, o grande modelo da ecologia de código aberto também está em pleno andamento.

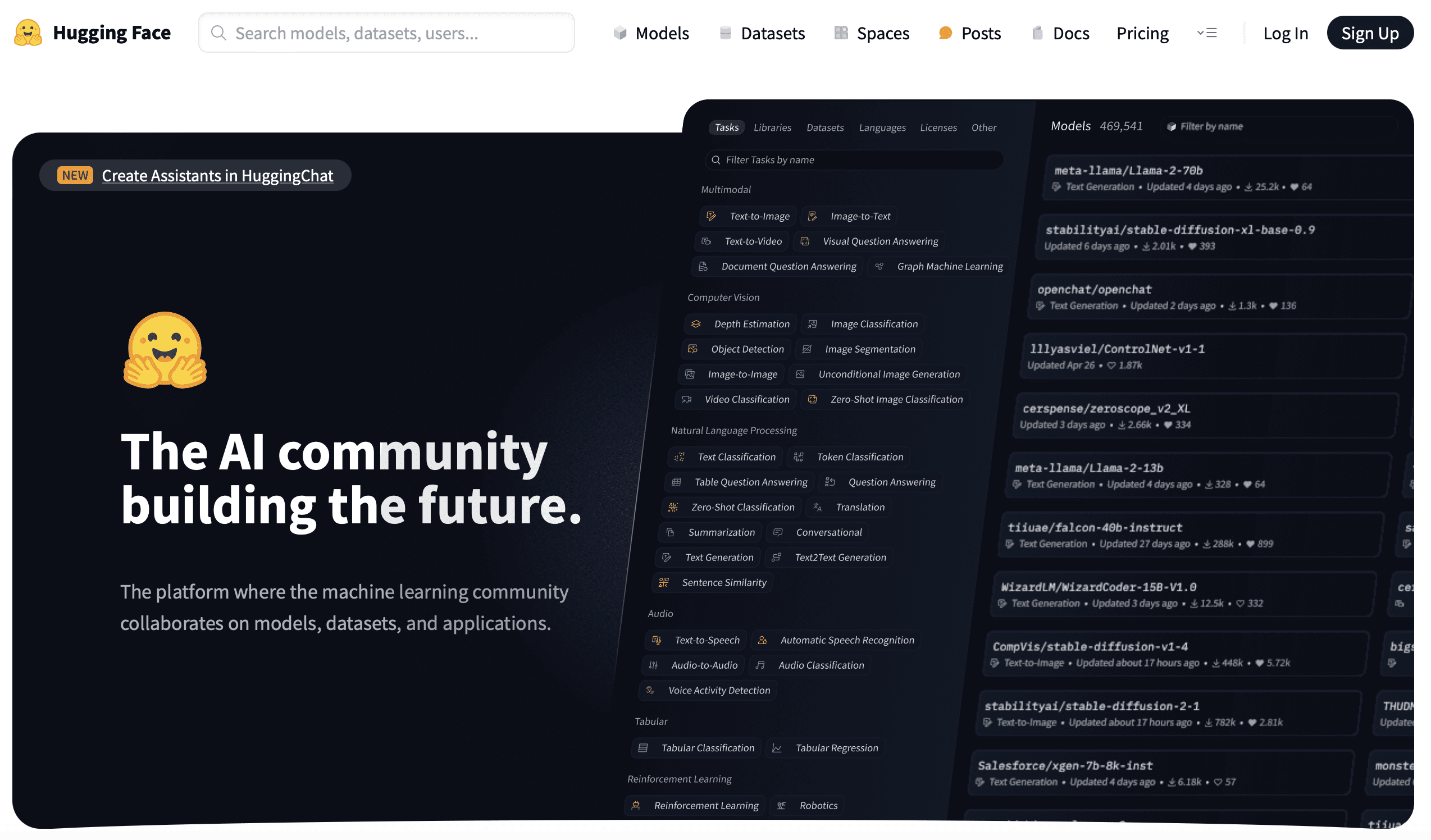

V Cara de abraço

Em 2016, os franceses Clément Delangue, Julien Chaumond e Thomas Wolf fundaram uma empresa chamada Hugging Face, com o ícone de emoji como logotipo. A Hugging Face começou desenvolvendo chatbots inteligentes para jovens, depois desenvolveu algumas ferramentas de treinamento de modelos e as disponibilizou em código aberto no processo de treinamento de modelos. Posteriormente, eles desenvolveram algumas ferramentas de treinamento de modelos e as tornaram de código aberto no processo, e mais tarde até mudaram seu foco para o último, uma abordagem aparentemente "não profissional" que os levou a um novo caminho e a um papel indispensável no campo da aprendizagem profunda.

O Vale do Silício tem muitas empresas que estão no negócio paralelo para fazer conquistas, como o Slack originalmente desenvolveu jogos, a equipe da empresa é distribuída em muitos lugares, no processo de operação desenvolveu uma ferramenta de comunicação que resulta no incêndio acidental, ou seja, Slack. Em 2018, o Google lançou o grande modelo BERT, e os funcionários da Hugging Face usaram a estrutura familiar do Pytorch para implementar o BERT, chamaram o modelo de pytorch-pretrained-bert e o abriram para o GitHub. Mais tarde, com a ajuda da comunidade, um grupo de modelos como GPT, GPT-2, Transformer-XL e assim por diante foi introduzido, e o projeto foi renomeado para O campo de aprendizagem profunda tem sido a competição entre as duas estruturas Pytorch e TensorFlow, e os pesquisadores frequentemente alternam entre as duas estruturas para comparar as vantagens e desvantagens das duas estruturas, de modo que o projeto de código aberto adicionou a função de alternar entre as duas estruturas, e o nome do projeto também foi alterado para Transformers. O Transformers também se tornou o projeto de crescimento mais rápido no GitHub.

A Hugging Face continua a desenvolver e a abrir o código-fonte de uma série de outras ferramentas de aprendizado de máquina: Datasets, Tokenizer, Diffusers ...... Essas ferramentas também padronizam o processo de desenvolvimento de IA. Antes da Hugging Face, pode-se dizer que o desenvolvimento de IA era dominado por pesquisadores sem uma abordagem de engenharia padronizada. A Hugging Face fornece um conjunto abrangente de ferramentas de IA e estabelece um conjunto de padrões de fato, o que também permite que mais desenvolvedores de IA e até mesmo profissionais que não são de IA iniciem e treinem modelos rapidamente.

Em seguida, a Hugging Face lançou o Hugging Face Hub para hospedar modelos, conjuntos de dados e aplicativos de IA com base nas tecnologias Git e Git LFS e, até o momento, 350.000 modelos, 75.000 conjuntos de dados e 150.000 aplicativos de IA de amostra foram hospedados na plataforma. O trabalho de hospedar e abrir modelos e conjuntos de dados e estabelecer um centro global de repositório de código aberto é inovador e de longo alcance. Embora a abordagem de pré-treinamento + ajuste fino mencionada acima facilite o compartilhamento de recursos de treinamento de redes neurais, o Hugging Face Hub vai um passo além ao permitir que os desenvolvedores de IA reutilizem facilmente os resultados de última geração do mundo e os complementem, tornando possível a democratização da IA para que todos possam usá-la e desenvolvê-la. GitHub, ou como diz seu slogan: construindo a comunidade de IA do futuro. Já escrevi dois artigos anteriormente, um sobre oUm commit de código que mudou o mundoApresentando o Git, um artigo emO caminho de zero a US$ 10 bilhõesApresentando o GitHub e o Git, GitHub, Hugging Face, acho que há algum tipo de legado entre eles, um legado de hacking que está mudando o mundo para construir o futuro, e essa é uma das coisas que me levou a escrever este post.

VI. Pós-escrito

Quando estava chegando ao fim deste artigo, assisti a uma palestra que Hinton deu recentemente na Universidade de Oxford. Na palestra, Hinton apresentou duas grandes escolas de pensamento no campo da inteligência artificial: uma que ele chamou de abordagem lógica, ou simbolismo, e a outra que ele chamou de abordagem biológica, ou conexionismo de rede neural, que simula o cérebro humano. E a abordagem biológica provou ser uma clara vencedora em relação à abordagem lógica. As redes neurais são modelos projetados para imitar a compreensão do cérebro humano, e grandes modelos funcionam e compreendem como o cérebro. Hinton acredita que a inteligência artificial além do cérebro humano surgirá no futuro, e muito antes do que prevemos.

Anexo 1 Cronologia dos eventos

Em 1943, McCulloch e Pitts publicaram o "modelo de neurônio M-P", que usava lógica matemática para explicar e simular as unidades de computação do cérebro humano e introduziu o conceito de redes neurais.

O termo "inteligência artificial" foi cunhado pela primeira vez na Conferência de Dartmouth em 1956.

Em 1957, Rosenblatt propôs o modelo "Perceptron" e, dois anos depois, conseguiu construir o Mark-1, um perceptron de hardware capaz de reconhecer o alfabeto inglês.

Em 1969, Minsky publicou Perceptual Machines, e os defeitos das máquinas perceptuais apontados no livro foram um duro golpe para a pesquisa de máquinas perceptuais e até mesmo de redes neurais.

Em 1983, Hinton inventou a máquina de Boltzmann.

Em 1986, Hinton inventou o algoritmo de retropropagação de erros.

Em 1989, Yann LeCun inventou a Rede Neural Convolucional (CNN).

Em 2006, Hinton propôs a Deep Belief Network, dando início à era da aprendizagem profunda.

A aprendizagem profunda foi levada a sério pelo setor em 2012, quando Hinton e dois de seus alunos projetaram o AlexNet para vencer a competição ImageNet com uma vitória esmagadora.

Em 2015, a DeepMind, uma empresa adquirida pelo Google, lançou o AlphaGo, que derrotou Lee Sedol em 2016 e Ke Jie em 2017.

A Hugging Face foi fundada em 2016.

Em 2017, o Google publicou o documento do modelo do Transformer.

Em 2018, a OpenAI lançou o GPT-1 com base na arquitetura Transformer, e a Hugging Face lançou o projeto Transformers.

Em 2019, a OpenAI lançou o GPT-2.

Em 2020, a OpenAI lança o GPT-3. A Hugging Face lança o Hugging Face Hub.

Em 2022, a OpenAI lança o ChatGPT.

Anexo 2 Referências

Livros:

Fronteiras da inteligência: das máquinas de Turing à inteligência artificial por Zhou Zhiming (autor) Mechanical Industry Press, outubro de 2018

A revolução da aprendizagem profunda por Cade Metz Shuguang Du CITIC Press Janeiro de 2023

Aprendizado profundo em Python (2ª edição) François Chollet (autor) Liang Zhang (tradutor) Editora dos Correios e Telecomunicações do Povo Agosto de 2022

Uma introdução ao aprendizado profundo: teoria e implementação baseadas em Python por Yasui Saito (autor) Yujie Lu (tradutor) People's Posts and Telecommunications Publishing House 2018

Aprendizado profundo avançado: processamento de linguagem natural por Yasuyoshi Saito (autor) Yujie Lu (tradutor) Editora de Correios e Telecomunicações do Povo Outubro de 2020

This is ChatGPT Stephen Wolfram (Autor) WOLFRAM Media Chinese Group (Tradutor) People's Posts and Telecommunications Publishing House Julho de 2023

Inteligência Artificial Generativa por Ding Lei (Autor) CITIC Press Maio de 2023

Huggingface Natural Language Processing Explained by Li Fulin (Autor) Tsinghua University Press April 2023

Artigo:

Uma introdução às redes neurais por Yifeng Nguyen

2012, 180 dias que mudaram o destino da humanidade" Instituto de Pesquisa Enkawa

Evolução da família GPT MetaPost

Transformer - Atenção é tudo o que você precisa".

O desenvolvimento de modelos de linguagem pré-treinados.

Guia para a Prompt Engineering

ChatGPT por trás do "crédito" - explicação detalhada da tecnologia RLHF.

Desenvolvimento e aplicação de técnicas de modelagem de grande porte ChatGPT.

The Bitter Lesson (A lição amarga), Rich Sutton.

Uma entrevista com o CTO da HuggingFace: a ascensão do código aberto, histórias de startups e a democratização da IA".