Original: TheDense X Retrieval: que granularidade de recuperação devemos usar?O

Observação: esse método é adequado para um pequeno número de modelos, como a série OPENAI, a série Claude, Mixtral, Yi, qwen e assim por diante.

resumos

Em tarefas de Processamento de Linguagem Natural (PLN) de domínio aberto, a recuperação densa tornou-se um método importante para a aquisição de conhecimento contextual ou mundial relevante. Quando usamos recuperadores densos aprendidos para recuperar corpora no momento da inferência, uma escolha de design frequentemente negligenciada é a unidade de recuperação, ou seja, a granularidade na qual o corpus é indexado, por exemplo, documentos, parágrafos ou frases. Descobrimos que a escolha da unidade de recuperação afeta significativamente o desempenho da recuperação, bem como o desempenho das tarefas posteriores. Em contraste com a abordagem tradicional que usa parágrafos ou frases, introduzimos uma nova unidade de recuperação, proposições, para recuperação intensiva. As proposições são definidas como expressões atômicas no texto, cada uma das quais encapsula um fato exclusivo e é apresentada em um formato de linguagem natural conciso e independente. Comparamos empiricamente diferentes granularidades de recuperação. Nossos resultados mostram que a recuperação baseada em proposições supera significativamente as abordagens tradicionais baseadas em parágrafos ou frases na recuperação densa. Além disso, a recuperação por proposições melhora o desempenho de tarefas de resposta a perguntas (QA) posteriores porque o texto recuperado contém informações relevantes para a pergunta de forma mais compacta, reduzindo a necessidade de tokens de entrada longos e minimizando a inclusão de informações irrelevantes.

1 Introdução

Os recuperadores densos são uma classe de técnicas usadas para acessar fontes externas de informações para tarefas de conhecimento intensivo. Antes de podermos usar um recuperador denso aprendido para recuperar de um corpus, uma importante decisão de projeto que devemos tomar é a unidade de recuperação, ou seja, a granularidade na qual segmentamos e indexamos o corpus recuperado em nosso raciocínio. Na prática, a escolha das unidades de recuperação, por exemplo, documentos, pedaços de parágrafos ou frases de comprimento fixo etc., geralmente é predeterminada com base em como o modelo de recuperação densa foi instanciado ou treinado.

Neste artigo, exploramos uma questão de pesquisa que tem sido negligenciada no raciocínio de recuperação densa - em que granularidade de recuperação devemos segmentar e indexar o corpus recuperado? Descobrimos que a escolha da granularidade de recuperação apropriada no momento do raciocínio pode ser uma estratégia simples, mas eficaz, para melhorar o desempenho de recuperadores densos para tarefas de recuperação e downstream.

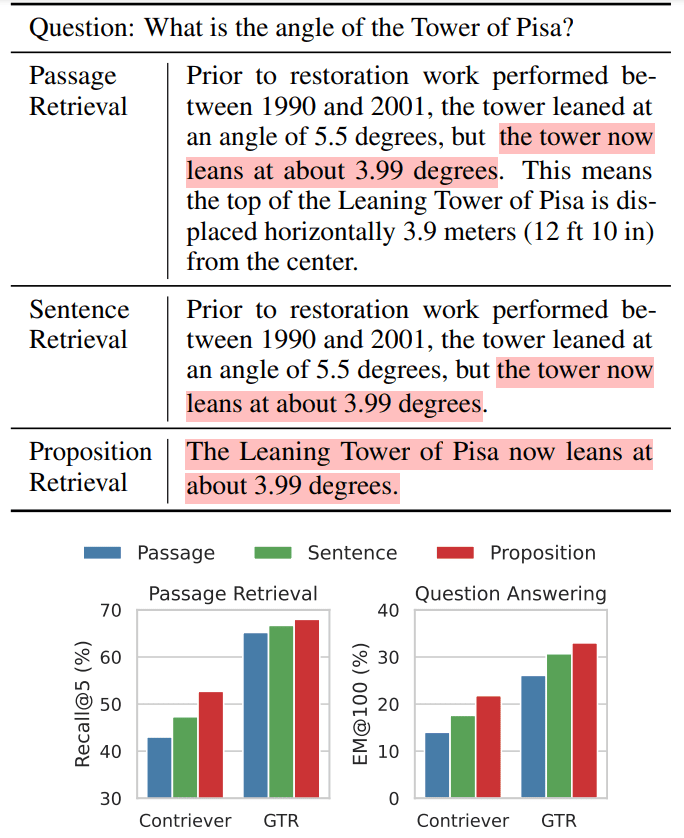

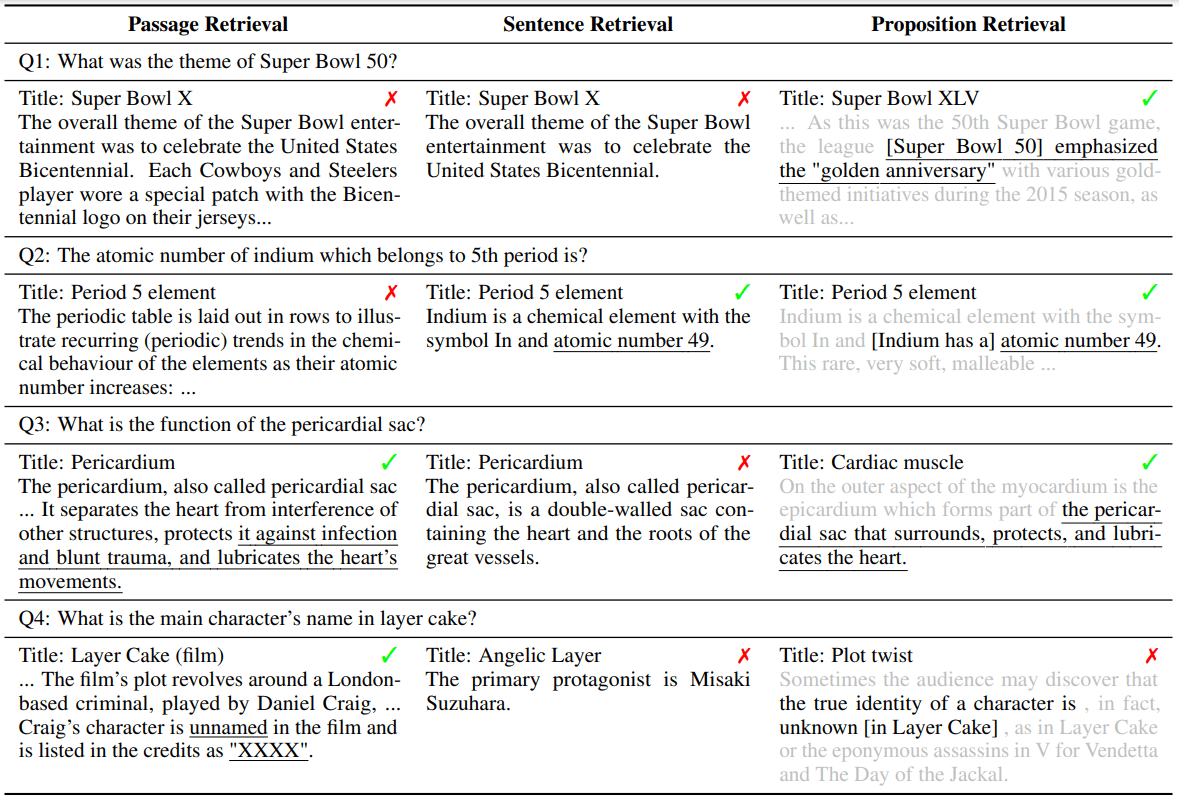

Ilustramos nossa intuição com um exemplo de pergunta e resposta (QA) de domínio aberto (Tabela 1).

Tabela 1 Figura 1: Exemplos de três granularidades de pesquisa para o texto da Wikipédia ao usar a pesquisa intensiva

Parte superior: Demonstra que o texto da Wikipédia pode ser dividido em três unidades de pesquisa diferentes ao usar um método de pesquisa denso.

INFERIOR: observamos que a recuperação por meio de proposições (proposições) produziu o melhor desempenho de recuperação em tarefas de recuperação de parágrafos e em tarefas de perguntas e respostas (QA) de domínio aberto a jusante. Por exemplo, o Contriever (Izacard et al., 2022) ou o GTR (Ni et al., 2022) foram usados como recuperadores de backbone. As seções destacadas indicam seções que contêm respostas a perguntas.

Este exemplo mostra o mesmo modelo recuperando texto em três níveis diferentes de granularidade. Teoricamente, as passagens que representam uma granularidade mais grosseira podem fornecer informações mais relevantes para a pergunta. Entretanto, os parágrafos geralmente contêm detalhes adicionais que podem distrair a atenção do recuperador e do modelo de linguagem da tarefa downstream (por exemplo, o período de recuperação e o deslocamento horizontal no exemplo da Tabela 1). A indexação em nível de frase, por outro lado, oferece uma abordagem mais granular, mas não resolve totalmente esse problema. Isso se deve ao fato de que as frases ainda podem ser complexas e compostas e, em geral, não são autônomas, carecendo das informações contextuais necessárias para julgar a relevância da consulta-documento.

Para solucionar essas deficiências das unidades de recuperação tradicionais (por exemplo, parágrafos ou frases), propomos o uso de proposições como uma nova unidade de recuperação para pesquisa intensiva. As proposições são definidas como expressões atômicas em um texto, cada uma das quais encapsula um fato exclusivo e é apresentada em um formato de linguagem natural conciso e independente. Mostramos um exemplo de proposição na Tabela 1. A proposição descreve informações sobre o ângulo de inclinação atual da Torre Inclinada de Pisa de forma autônoma e responde exatamente ao que a pergunta solicita. Apresentamos uma definição e uma descrição mais detalhadas na Seção II.

Para validar a eficácia do uso de proposições como unidades de recuperação para inferência densa de retriever, primeiro processamos e indexamos um despejo da Wikipédia em inglês que divide todos os documentos em proposições, que chamamos de FACTOIDWIKI. Em seguida, realizamos experimentos em cinco conjuntos de dados de controle de qualidade de domínio aberto diferentes e comparamos empiricamente o desempenho dos seis recuperadores de codificador duplo quando a Wikipédia é indexada por parágrafos, frases e nossas proposições propostas desempenho de seis recuperadores de codificador duplo quando indexados por parágrafo, sentença e proposição. Nossa avaliação é dupla: examinamos o desempenho da recuperação e o impacto nas tarefas de controle de qualidade posteriores. Notavelmente, nossas descobertas sugerem que a recuperação baseada em proposições supera as abordagens baseadas em frases e parágrafos em termos de generalização, conforme discutido na Seção V. Isso sugere que as proposições atuam como contextos compactos e ricos em conteúdo que permitem que os recuperadores densos acessem informações precisas, mantendo o contexto adequado. A melhoria na recuperação média @20 para a recuperação baseada em passagens é de +10,1 no recuperador denso não supervisionado e +2,2 no recuperador supervisionado. Além disso, observamos uma clara vantagem no desempenho de QA downstream ao usar a recuperação baseada em proposições, conforme detalhado na Seção VI. Dado o comprimento tipicamente limitado dos tokens de entrada em um modelo de linguagem, as proposições fornecem inerentemente uma densidade maior de informações relevantes para a pergunta.

A principal contribuição de nosso artigo é:

- Propomos o uso de proposições como unidades de recuperação ao indexar um corpus recuperado para melhorar o desempenho da recuperação intensiva.

- Apresentamos o FACTOIDWIKI, um dump processado da Wikipédia em inglês no qual cada página é dividida em várias granularidades: parágrafos de 100 palavras, frases e proposições.

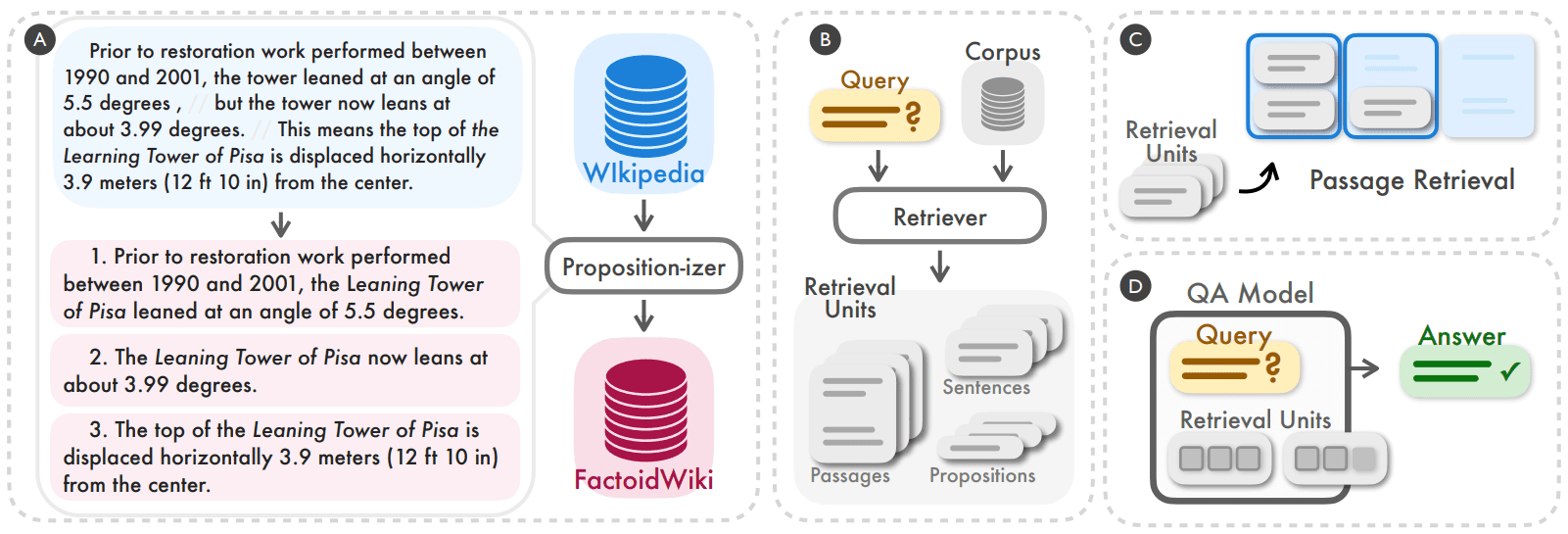

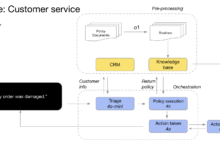

Figura 2: Descobrimos que segmentar e indexar o corpus de recuperação no nível proposicional pode ser uma estratégia simples e eficaz para melhorar o desempenho de generalização dos recuperadores densos ao raciocinar (A, B). Comparamos empiricamente o desempenho do recuperador denso em tarefas de recuperação e de perguntas e respostas (QA) de domínio aberto a jusante ao trabalhar no nível de parágrafo, frase ou proposição de 100 palavras (C, D).

2 Proposições como unidades de pesquisa

O objetivo do nosso estudo é entender empiricamente como a granularidade de um corpus de recuperação afeta o desempenho de um modelo de recuperação denso. Além das unidades de recuperação comumente usadas, como parágrafos ou frases de 100 palavras, propomos o uso de proposições como uma opção alternativa de unidade de recuperação. Aqui, as proposições representam expressões atômicas de significado em um texto e são definidas pelos três princípios a seguir.

- Cada proposição deve corresponder a um fragmento único de significado no texto, e a combinação de todas as proposições representará a semântica de todo o texto.

- A proposição deve ser mínima, ou seja, não pode ser dividida em outras proposições separadas.

- As proposições devem ser contextualizadas e autônomas. As proposições devem conter todo o contexto necessário do texto (por exemplo, correferência) para explicar seu significado.

O uso de proposições como unidades de recuperação foi inspirado por uma série de trabalhos recentes que foram bem-sucedidos na representação e avaliação da semântica de textos em nível proposicional. Demonstramos a noção de proposições e como um parágrafo pode ser particionado em seu conjunto de proposições por meio do exemplo no lado esquerdo da Figura 2. O parágrafo contém três proposições, cada uma correspondendo a um fato exclusivo sobre a Torre Inclinada de Pisa: o ângulo antes da restauração, o ângulo atual e o deslocamento horizontal. Em cada proposição, o contexto necessário da passagem é incluído para que o significado da proposição possa ser interpretado independentemente do texto original, por exemplo, a referência à torre na primeira proposição é analisada como seu nome completo, a Torre Inclinada de Pisa. Esperamos que cada proposição descreva com precisão um fato atômico contextualizado, portanto, nossa intuição é que as proposições serão adequadas como unidades de recuperação para problemas de recuperação de informações.

3 FACTOIDWIKI: indexação e pesquisa em nível proposicional da Wikipédia

Comparamos empiricamente o uso de parágrafos, frases e proposições de 100 palavras como unidades de recuperação na Wikipédia. A Wikipédia é uma fonte de recuperação comumente usada em tarefas de PNL com uso intensivo de conhecimento. Para permitir comparações justas em diferentes granularidades, processamos 2021-10-13 despejos da Wikipédia em inglês, conforme usado por Bohnet et al. (2022). Dividimos o texto de cada documento em três granularidades diferentes: parágrafos de 100 palavras, frases e proposições. Usamos a mesma granularidade noApêndice Acontém informações detalhadas sobre o corpus de segmentação em nível de parágrafo e sentença.

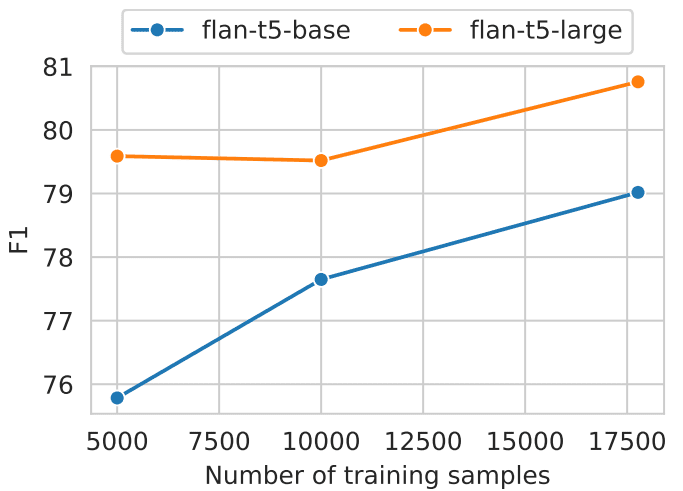

A passagem parafraseada é proposicional:Para dividir as páginas da Wikipédia em proposições, ajustamos um modelo de geração de texto que chamamos de Propositionizer. O propositor recebe um parágrafo como entrada e gera uma lista de proposições dentro do parágrafo. Seguindo a abordagem de Chen et al. (2023b), treinamos o propositor usando um processo de destilação em duas etapas. Primeiro, usamos o prompt de instrução GPT-4 que contém definições de proposição e um exemplo de demonstração. Incluímos detalhes dos prompts na Figura 8. Começamos com um conjunto de 42 mil passagens e usamos o GPT-4 para gerar um conjunto de sementes de pares de passagem para proposição. Em seguida, usamos o conjunto de sementes para ajustar o modelo FlanT5-large.

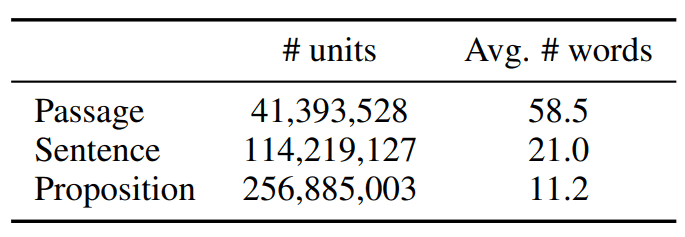

Referimo-nos ao corpus processado como FACTOIDWIKI. As estatísticas do FACTOIDWIKI são mostradas na Tabela 1.

Tabela 1: Dados estatísticos sobre unidades de texto no depósito de dados da Wikipédia em inglês em 13 de outubro de 2021

4 Configuração experimental

Para avaliar o impacto das três opções de unidades de recuperação, realizamos experimentos em cinco conjuntos de dados de controle de qualidade de domínio aberto diferentes no FACTOIDWIKI. Para cada conjunto de dados, avaliamos a recuperação de parágrafos e o desempenho de controle de qualidade downstream quando o recuperador denso usa a Wikipédia indexada em diferentes granularidades.

4.1 Conjuntos de dados de QA de domínio aberto

Realizamos nossa avaliação em cinco conjuntos de dados diferentes de QA de domínio aberto que usam a Wikipédia como fonte de recuperação: Natural Questions (NQ) (Kwiatkowski et al., 2019), TriviaQA (TQA) (Joshi et al., 2017), Web Questions ( WebQ) (Berant et al., 2013), SQuAD (Rajpurkar et al., 2016) e Perguntas sobre entidades (EQ) (Sciavolino et al., 2021).

4.2 Modelos de pesquisa densos

Comparamos o desempenho dos seis modelos dense retriever supervisionados ou não supervisionados a seguir. Aqui, os modelos supervisionados referem-se a modelos que são treinados durante o período de treinamento usando o

Pares de consulta-parágrafo rotulados manualmente como modelos supervisionados e vice-versa.

- SimCSE é um codificador de base BERT treinado em frases não rotuladas selecionadas aleatoriamente da Wikipédia.

- Contribuinte é um pesquisador não supervisionado instanciado como um codificador de base BERT. O Contriever é treinado pela comparação de pares de contraste construídos a partir de pares de documentos da Wikipédia sem rótulos e de dados de rastreamento da Web.

- DPR é um modelo de base BERT de dois codificadores ajustado em cinco conjuntos de dados de QA de domínio aberto, incluindo os quatro conjuntos de dados em nossa avaliação (NQ, TQA, WebQ e SQuAD).

- ANCE Foram usadas as mesmas configurações do DPR e o modelo foi treinado pelo método ANCE (Approximate Nearest Neighbour Negative Contrast Estimation), um método de treinamento baseado em hard negative.

- TAS-B é um modelo de base BERT de dois codificadores extraído de um modelo de professor com treinamento de atenção cruzada e ajustado no MS MARCO.

- GTR é um codificador baseado em T5 pré-treinado em pares de dados de QA de fóruns on-line sem rótulos e ajustado em MS MARCO e Natural Question.

4.3 Avaliação das pesquisas de parágrafos

Avaliamos o desempenho da recuperação no nível do parágrafo ao indexar o corpus no nível do parágrafo, da frase ou da proposição. Para a recuperação em nível de frase e proposição, seguimos a configuração apresentada por Lee et al. (2021b), em que a pontuação de um parágrafo se baseia na pontuação máxima de similaridade entre a consulta e todas as frases ou proposições do parágrafo. Na prática, primeiro recuperamos um pouco mais de unidades de texto, mapeamos cada unidade para um parágrafo de origem e retornamos os k principais parágrafos exclusivos. Usamos recall @k como nossa métrica de avaliação, que é definida como a porcentagem de perguntas que encontram a resposta correta nas primeiras k passagens recuperadas.

4.4 Avaliação de QA downstream

Para entender o impacto do uso de diferentes unidades de recuperação em tarefas de controle de qualidade de domínio aberto downstream, avaliamos o uso do modelo de recuperação em uma configuração de recuperação e leitura. Na configuração recuperar depois de ler, o modelo de recuperação primeiro recupera k unidades de texto para uma determinada consulta. Em seguida, essas k unidades de texto recuperadas são usadas como entradas para o modelo de leitura junto com a consulta para chegar à resposta final. Normalmente, a escolha de k é limitada pela restrição do comprimento máximo de entrada ou pelo orçamento computacional do modelo de leitura, que aumenta com o número de tokens de entrada.

Portanto, seguimos uma configuração de avaliação em que o número máximo de palavras recuperadas é limitado a l = 100 ou 500, ou seja, somente as primeiras l palavras de um parágrafo, frase ou recuperação de nível de proposição são inseridas no modelo do leitor. Avaliamos a porcentagem de perguntas para as quais a resposta prevista corresponde exatamente (EM) à resposta verdadeira. Referimo-nos à nossa métrica como EM@l. Para nossa avaliação, usamos o UnifiedQA-v2 de tamanho grande T5 como modelo de leitor.

5 Resultados: pesquisa de parágrafo

Nesta seção, relatamos e discutimos o desempenho da tarefa de recuperação. Nossos resultados mostram que, embora nenhum dos modelos tenha sido treinado em dados no nível da proposição, todos os modelos de recuperação apresentam desempenho comparável ou superior à recuperação baseada em parágrafos ou frases quando o corpus é indexado no nível da proposição.

5.1 Desempenho da pesquisa de parágrafos

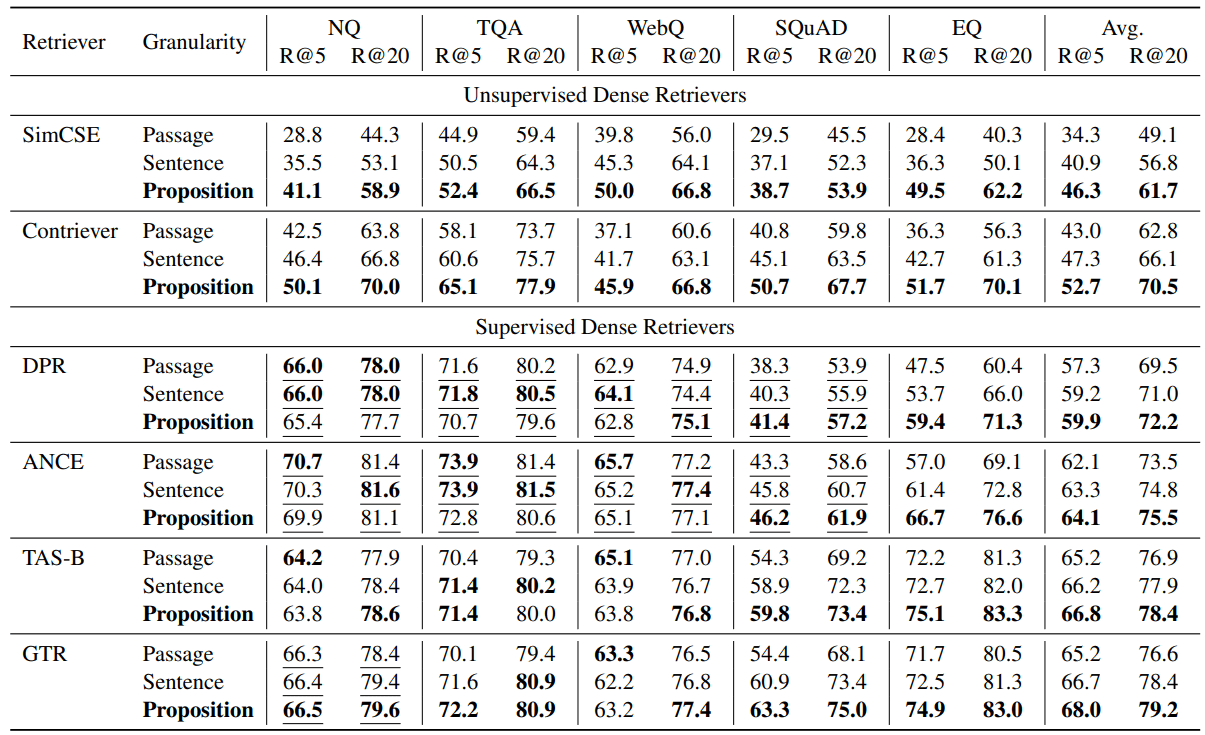

Relatamos nossos resultados de avaliação na Tabela 2. Observamos que a recuperação baseada em proposições supera a recuperação baseada em frases ou parágrafos na maioria das tarefas, tanto para recuperadores não supervisionados quanto supervisionados.

Em todos os recuperadores intensivos testados, a recuperação baseada em proposições superou consistentemente a recuperação baseada em frases e parágrafos, em média, nos cinco conjuntos de dados. Para os recuperadores não supervisionados, ou seja, SimCSE e Contriever, observamos uma melhoria média no Recall@5 de +12,0 e +9,3 nos cinco conjuntos de dados (uma melhoria relativa de 35,01 TP3T e 22,51 TP3T).

Para recuperadores supervisionados, a recuperação em nível de proposição ainda apresenta uma vantagem média, mas a melhoria é menor. Nossa hipótese é que isso se deve ao fato de que esses recuperadores são treinados em pares de consulta-parágrafo. Por exemplo, para DPR e ANCE, que são treinados em NQ, TQA, WebQ e SQuAD, observamos que a recuperação baseada em proposição e em frase é ligeiramente pior do que a recuperação baseada em parágrafo em todos os três conjuntos de dados, exceto no SQuAD. Conforme mostrado na Tabela 2, no NQ, TQA e WebQ, o desempenho de todos os recuperadores supervisionados nas três granularidades de recuperação é comparável.

No entanto, em conjuntos de dados que o modelo retriever não tinha visto durante o treinamento, observamos uma clara vantagem para a recuperação baseada em proposição. Por exemplo, em SQuAD ou EntityQuestions, observamos que a recuperação baseada em proposição supera significativamente as outras duas granularidades. Observamos uma melhoria relativa no Recall@5 para 17-25% em recuperadores relativamente fracos, como DPR e EntityQuestions para ANCE. Além disso, o Recall@5 para recuperação baseada em proposição no SQuAD melhora mais no TAS-B e no GTR, com uma melhoria relativa de 10-16%.

Tabela 2: Desempenho da recuperação de parágrafos (recall @k = 5, 20) em cinco conjuntos de dados diferentes de perguntas e respostas de domínio aberto quando o recuperador denso pré-treinado trabalha com três granularidades diferentes no corpus de recuperação. O sublinhado indica que a segmentação de treinamento do conjunto de dados de destino está incluída nos dados de treinamento do recuperador denso.

5.2 Recuperação baseada em proposições ⇒ melhor generalização entre tarefas

Nossos resultados mostram que os benefícios da recuperação baseada em proposições são mais evidentes na configuração de generalização entre tarefas. Observamos que a recuperação baseada em proposições traz mais ganhos de desempenho na generalização entre tarefas no SQuAD e no EntityQuestions.

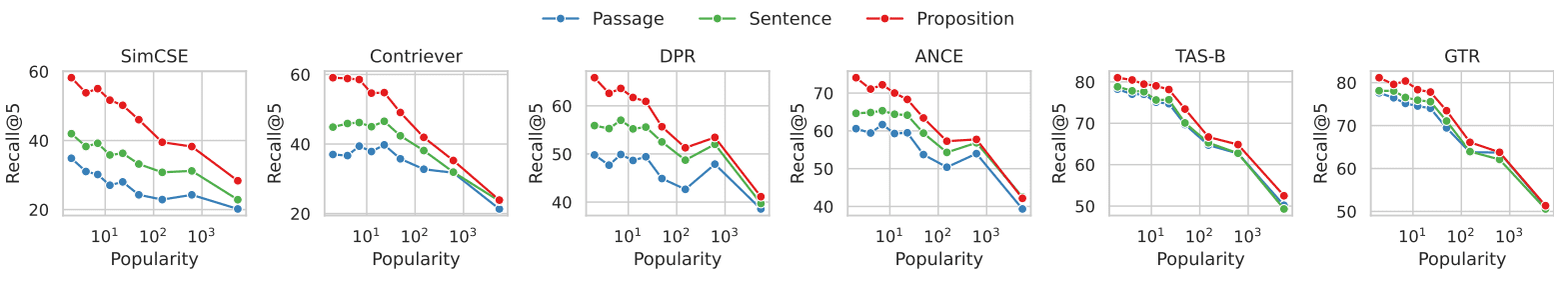

Para entender melhor as fontes de melhoria, realizamos análises adicionais no EntityQuestions. Como as EntityQuestions apresentam perguntas que visam atributos de entidades de cauda longa, investigamos como o desempenho da recuperação é afetado pela popularidade da entidade-alvo na pergunta, ou seja, a frequência com que a entidade aparece na Wikipédia, em três níveis diferentes de granularidade. Estimamos a popularidade de cada entidade usando o seguinte método. Dada a forma superficial de uma entidade, usamos o BM25 para recuperar as primeiras 1.000 passagens relevantes da Wikipédia. Usamos o número de vezes que a entidade aparece em seus primeiros 1.000 parágrafos como uma estimativa de sua popularidade. Das 20.000 consultas de teste no EntityQuestion, cerca de 25% das entidades-alvo têm um valor de popularidade menor ou igual a 3.

A Figura 3 mostra a relação entre o desempenho da recuperação de parágrafos e a popularidade das entidades visadas em cada problema. Em todos os seis recuperadores densos, observamos que a recuperação baseada em proposição mostra uma vantagem maior sobre a recuperação baseada em parágrafo para problemas que visam entidades menos comuns. A diferença de desempenho diminui à medida que a popularidade das entidades aumenta. Nossas descobertas sugerem que a melhoria de desempenho da recuperação baseada em proposições é atribuída principalmente a consultas que visam informações de cauda longa. Isso reflete nossa observação de que a recuperação baseada em proposições melhora o desempenho de generalização entre tarefas de recuperadores densos.

Figura 3: Recuperação de documentos vs. popularidade da entidade-alvo de cada pergunta no conjunto de dados EntityQuestions

No conjunto de dados do EntityQuestions, a popularidade de cada pergunta (ou seja, valores menores indicam que a entidade é menos comum e vice-versa) foi estimada pela frequência de ocorrência da entidade nas primeiras 1.000 passagens recuperadas pelo BM25.

Para consultas que contêm entidades menos comuns, observamos que a recuperação por proposições apresenta maiores vantagens em comparação com a recuperação por entidades.

6 Resultado: QA em campo aberto

Nesta seção, investigamos como a seleção da granularidade da recuperação afeta as tarefas de GQ de domínio aberto posteriores. Mostramos o forte impacto da recuperação baseada em proposições no desempenho de GQ posterior em uma configuração de recuperação após a leitura, em que o número de tokens de recuperação inseridos no modelo de GQ do leitor é limitado a l = 100 ou 500 palavras. Observamos que o desempenho do controle de qualidade na métrica média EM@l é maior entre os recuperadores ao usar proposições como unidades de recuperação.

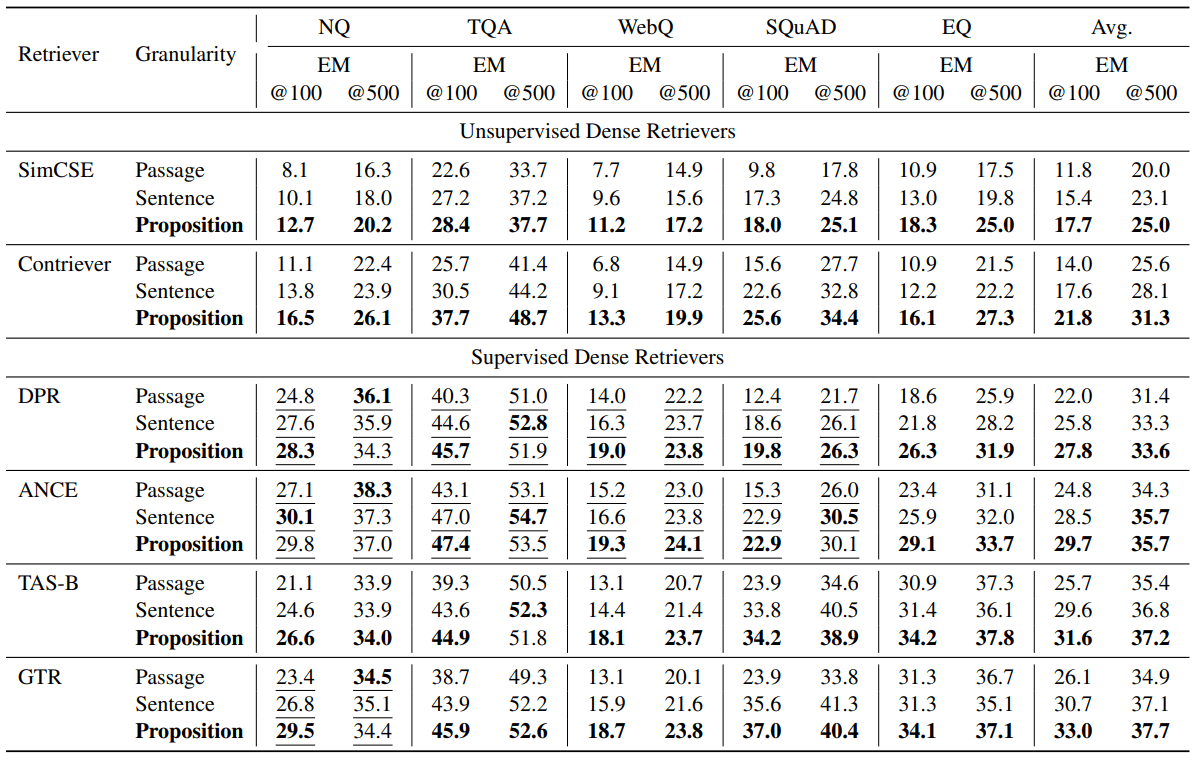

6.1 Desempenho de QA

A Tabela 3 mostra os resultados da avaliação. Em todos os diferentes recuperadores, observamos um melhor desempenho de QA na métrica média EM@l ao usar proposições como unidades de recuperação. Os recuperadores não supervisionados SimCSE e Contriever melhoraram suas pontuações EM@100 em +5,9 e +7,8, respectivamente (melhorias relativas para 50% e 55%). Os recuperadores supervisionados DPR, ANCE, TAS-B e GTR melhoraram em +5,8, +4,9, +5,9 e +6,9 no EM@100, respectivamente (melhorias relativas para 26%, 19%, 22% e 26%). Semelhante às nossas observações de avaliação de recuperação de parágrafos, descobrimos que a recuperação baseada em proposição é mais benéfica em termos de desempenho de controle de qualidade downstream, especialmente quando o recuperador não é treinado no conjunto de dados de destino. Em outros casos, a recuperação baseada em proposição ainda é vantajosa, mas com margens médias menores.

Tabela 3: Desempenho do questionário de domínio aberto (EM = correspondência exata) na configuração de leitura pós-recuperação, em que o número de palavras recuperadas passadas para o modelo de questionário do leitor foi limitado a l = 100 ou 500. As primeiras l palavras das principais unidades de texto recuperadas conectadas foram passadas como entrada para o modelo de leitor. O sublinhado indica que a segmentação de treinamento do conjunto de dados de destino foi incluída nos dados de treinamento do recuperador denso. Na maioria dos casos, vemos que o uso de unidades de recuperação menores leva a um melhor desempenho de Q&A.

6.2 Proposição ⇒ maior densidade de informações relevantes para a pergunta

Intuitivamente, a vantagem das proposições em relação a frases ou parágrafos como unidades de recuperação é que as proposições recuperadas têm uma densidade maior de informações relevantes para a consulta. Usando unidades de recuperação mais refinadas, é mais provável que a resposta correta a uma consulta apareça nos principais termos de pesquisa de um pesquisador denso.

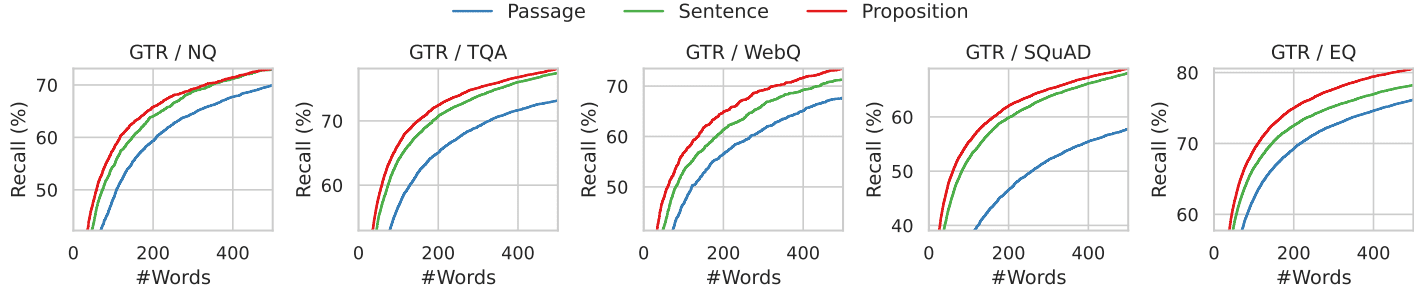

Ilustramos esse fenômeno com a análise mostrada na Figura 4. Aqui, examinamos a posição da resposta correta nas primeiras l palavras recuperadas. Especificamente, calculamos a recuperação da resposta de ouro nas primeiras l palavras recuperadas pelo recuperador GTR ao usar a Wikipédia indexada em três granularidades diferentes.

Mostramos os resultados nas Figuras 4 e 7, onde l varia de 0 a 500, abrangendo todos os cinco conjuntos de dados. Para um orçamento fixo de palavras recuperadas, a recuperação proposicional tem uma taxa de sucesso maior do que os métodos de recuperação de frases e parágrafos no intervalo das primeiras 100 a 200 palavras, o que corresponde a aproximadamente 10 proposições, 5 frases ou 2 parágrafos. À medida que a contagem de palavras aumenta, as taxas de recuperação das três granularidades convergem, pois todas as informações relevantes para a pergunta estão contidas no texto recuperado.

Figura 4: Recuperação da resposta padrão ouro quando o texto recuperado é restrito às primeiras k palavras para o recuperador GTR. As recuperações mais refinadas têm maior recuperação em todos os intervalos de contagem de palavras.

6.3 Estudos de caso de erros

Para entender as fontes de erros em cada granularidade de recuperação, apresentamos e discutimos quatro exemplos típicos de erros na Tabela 4. Em cada exemplo, são mostrados os problemas recuperados pelo recuperador GTR nas três granularidades e suas unidades de texto top-1 correspondentes.

Na recuperação em nível de canal, a ambiguidade das entidades ou de suas referências representa um desafio para os pesquisadores densos, ecoando as descobertas de (Min et al., 2020). Por exemplo, no exemplo Q1, a pergunta pede "Super Bowl 50", mas o artigo e a frase recuperados apontam para "Super Bowl 5". No exemplo Q2, a pesquisa de parágrafo não consegue identificar a seção que faz referência ao "número do átomo" correto. Em vez disso, o primeiro artigo recuperado referia-se a "atomic number" em um contexto diferente e não relacionado à pergunta. A recuperação de frase por frase também pode ter problemas semelhantes aos da recuperação de parágrafo por parágrafo, como no Exemplo Q1, e outro desafio para a recuperação de frases é a falta de contexto. No exemplo Q3, a recuperação baseada em frases falha porque a frase correta no artigo recuperado usa "it" para se referir ao saco pericárdico.

A recuperação baseada em proposições resolve o problema acima, garantindo que cada unidade de recuperação contenha apenas um fato com o contexto necessário na proposição. No entanto, a recuperação baseada em proposição enfrenta o desafio do raciocínio multihop que envolve análises textuais de longo alcance. No Exemplo Q4, as passagens recuperadas descrevem os nomes dos atores e os papéis que eles desempenham, respectivamente. Nenhuma das proposições continha perguntas e respostas.

Tabela 4: Exemplos de casos que mostram os casos em que a primeira unidade de texto classificada recuperada em cada granularidade de pesquisa não fornece a resposta correta. O texto sublinhado é a resposta correta. O texto cinza é o contexto da proposição, mas é usado apenas para fins ilustrativos e não é fornecido ao recuperador e ao modelo de Q&A posterior.

7 Trabalhos relacionados

Os trabalhos recentes sobre recuperadores densos geralmente usam uma arquitetura de codificador duplo. Com codificadores duplos, cada consulta e documento é codificado separadamente como um vetor de recursos de baixa dimensão, e a correlação entre eles é medida por uma função de similaridade não paramétrica entre os vetores incorporados. Devido ao poder expressivo limitado da função de similaridade, os modelos de codificador duplo geralmente têm pouca capacidade de generalização em novas tarefas, especialmente quando os dados de treinamento são escassos. Por esse motivo, estudos anteriores usaram técnicas como aumento de dados, pré-treinamento contínuo, treinamento com reconhecimento de tarefas, recuperação híbrida esparso-densa ou recuperação de estratégia híbrida para melhorar o desempenho de generalização entre tarefas dos recuperadores densos.

Nosso trabalho é motivado, em parte, por ecos da recuperação de vários vetores, por exemplo, ColBERT, DensePhrase (Lee et al., 2021a,b), ME-BERT, MVR, em que o modelo de recuperação aprende a codificar unidades de recuperação candidatas em vários vetores para aumentar a representatividade do modelo e melhorar a granularidade da recuperação. Nosso trabalho se concentra em configurações que não atualizam o modelo de recuperação denso ou seus parâmetros. Mostramos que o particionamento do corpus de recuperação em proposições de granulação mais fina pode ser uma estratégia simples e ortogonal para melhorar a capacidade de generalização do recuperador denso de codificador duplo durante a inferência.

A ideia de usar proposições como unidades de representação textual pode ser rastreada até a abordagem de pirâmide na avaliação automática de resumos (Nenkova e Passonneau, 2004), em que os resumos gerados por modelos são avaliados por meio de cada proposição. A extração de proposições do texto tem sido uma tarefa de longa data na PNL, com as primeiras formulações focadas em representações estruturadas de proposições, por exemplo, extração de informações abertas, rotulagem de função semântica. Estudos mais recentes extraíram com sucesso proposições em formato de linguagem natural usando modelos de linguagem grandes com menos dicas ou ajustando modelos menores.

A recuperação durante a leitura ou, de forma mais ampla, a geração aprimorada por recuperação, tornou-se recentemente um paradigma popular para P&R de domínio aberto. Embora os primeiros trabalhos tenham fornecido aos leitores downstream até 100 passagens recuperadas, a quantidade de contexto permitida é significativamente reduzida (por exemplo, as primeiras 10) ao usar modelos mais recentes de linguagem grande devido ao comprimento limitado da janela de contexto e à incapacidade de lidar com contextos longos. Esforços recentes tentaram melhorar a qualidade dos contextos do leitor filtrando ou compactando os documentos recuperados. Nosso trabalho aborda esse problema de forma eficaz, utilizando uma nova unidade de recuperação, a proposição, que não apenas reduz o comprimento do contexto, mas também fornece maior densidade de informações.

8 Conclusão

Propomos o uso de proposições como unidades de recuperação para indexar corpora a fim de melhorar o desempenho da recuperação densa durante a inferência. Por meio de nossos experimentos em cinco conjuntos de dados de controle de qualidade de domínio aberto usando seis recuperadores intensivos diferentes, descobrimos que a recuperação baseada em proposições supera a recuperação baseada em parágrafos ou frases em termos de precisão de recuperação de parágrafos e desempenho de controle de qualidade downstream com orçamentos fixos de palavras de recuperação. Apresentamos o FACTOIDWIKI, uma versão indexada do dump da Wikipédia em inglês, na qual o texto de 6 milhões de páginas é dividido em 250 milhões de proposições. Esperamos que o FACTOIDWIKI e nossas descobertas no artigo facilitem futuras pesquisas sobre recuperação de informações.

limitações

Nosso estudo atual sobre a granularidade do corpus de recuperação tem as seguintes limitações. (1) Corpus de recuperação - Nosso estudo se concentra apenas na Wikipédia como corpus de recuperação, já que a maioria dos conjuntos de dados de QA de domínio aberto usa a Wikipédia como corpus de recuperação. (2) Tipos de recuperadores densos avaliados - Na versão atual deste documento, avaliamos apenas seis recuperadores densos populares, a maioria dos quais segue uma arquitetura de codificador duplo ou de codificador duplo. Em versões futuras, incluiremos e discutiremos os resultados de uma variedade maior de recuperadores densos. (3) Idioma - Nosso estudo atual está limitado à Wikipédia em inglês. Deixamos a exploração de outros idiomas para trabalhos futuros.

A Recuperar o processamento do corpus

O despejo da Wikipédia em inglês usado neste estudo foi publicado por Bohnet et al. em 2022, e foi escolhido para uso porque foi filtrado para remover gráficos, tabelas e listas, e organizado em forma de parágrafo. O despejo data de 13 de outubro de 2021. Para este estudo, segmentamos a Wikipédia em três unidades de pesquisa: blocos de parágrafos de 100 palavras, frases e proposições. Usamos um método guloso para dividir os parágrafos em blocos de parágrafos de 100 palavras. Segmentamos somente no final das frases para garantir que cada bloco de parágrafo contenha frases completas. À medida que processamos os parágrafos, adicionamos as frases uma a uma. Se a inclusão da próxima frase fizer com que o bloco de parágrafos exceda 100 palavras, iniciaremos um novo bloco de parágrafos a partir dessa frase. No entanto, se o bloco de parágrafo final tiver menos de 50 palavras, nós o mesclamos com o anterior para evitar fragmentos muito pequenos. Além disso, dividimos cada parágrafo em frases usando o modelo Python SpaCy en_core_web_lg amplamente utilizado. Além disso, nosso modelo Propositionizer decompõe cada parágrafo em proposições. No total, decompusemos 6 milhões de páginas em 41,39 milhões de parágrafos, 11,42 milhões de frases e 257 milhões de proposições. Em média, um parágrafo contém 6,3 proposições e uma frase contém 2,3 proposições.

B Treinamento de proponentes

Usamos o GPT-4 para gerar uma lista de proposições a partir de uma determinada passagem, conforme mostrado na Figura 8. Após a filtragem, um total de 42.857 pares foi usado para ajustar o modelo Flan-T5-Large. Nomeamos o modelo como Propositionizer. Usamos o otimizador AdamW com um tamanho de lote de 64, uma taxa de aprendizado de 1e-4 e um decaimento de peso de 1e-4, e treinamos por 3 ciclos. Para comparar o desempenho das proposições geradas por diferentes modelos, configuramos um conjunto de desenvolvimento e uma métrica de avaliação. O conjunto de desenvolvimento contém mais 1.000 pares de amostras coletadas pelo GPT-4 usando o mesmo método do conjunto de treinamento. Avaliamos a qualidade das proposições previstas pelas pontuações F1 dos dois conjuntos de proposições. Inspirados pelas pontuações F1 dos dois conjuntos de marcadores no BertScore, projetamos pontuações F1 para os dois conjuntos de proposições. Seja P = {p1, ... , pn} denotar o conjunto de proposições rotuladas, ˆP = {ˆp1, ... , ˆpm} denotam o conjunto de proposições previstas. Usamos sim(pi, ˆpj) para representar a similaridade entre duas proposições. Teoricamente, qualquer métrica de similaridade textual pode ser usada. Optamos por usar o BertScore como a função sim porque queremos que nossa métrica reflita as diferenças semânticas entre as proposições. Definimos:

Recall = 1 / |P| ∑(max(sim(pi, ˆpj)) for ˆpj in ˆP) Precision = 1 / |ˆP| ∑(max(sim(pi, ˆpj)) for pi in P) F1 = 2 * Precision * Recall / (Precision + Recall)

Aqui está uma explicação gráfica da pontuação F1: a recuperação representa a porcentagem de proposições no conjunto rotulado que são semelhantes às proposições no conjunto gerado, a precisão representa a porcentagem de proposições no conjunto gerado que são semelhantes às proposições no conjunto rotulado, e F1 é a média reconciliada de recuperação e precisão. F1 é 1 se os dois conjuntos forem idênticos e 0 se quaisquer duas proposições forem semanticamente diferentes.

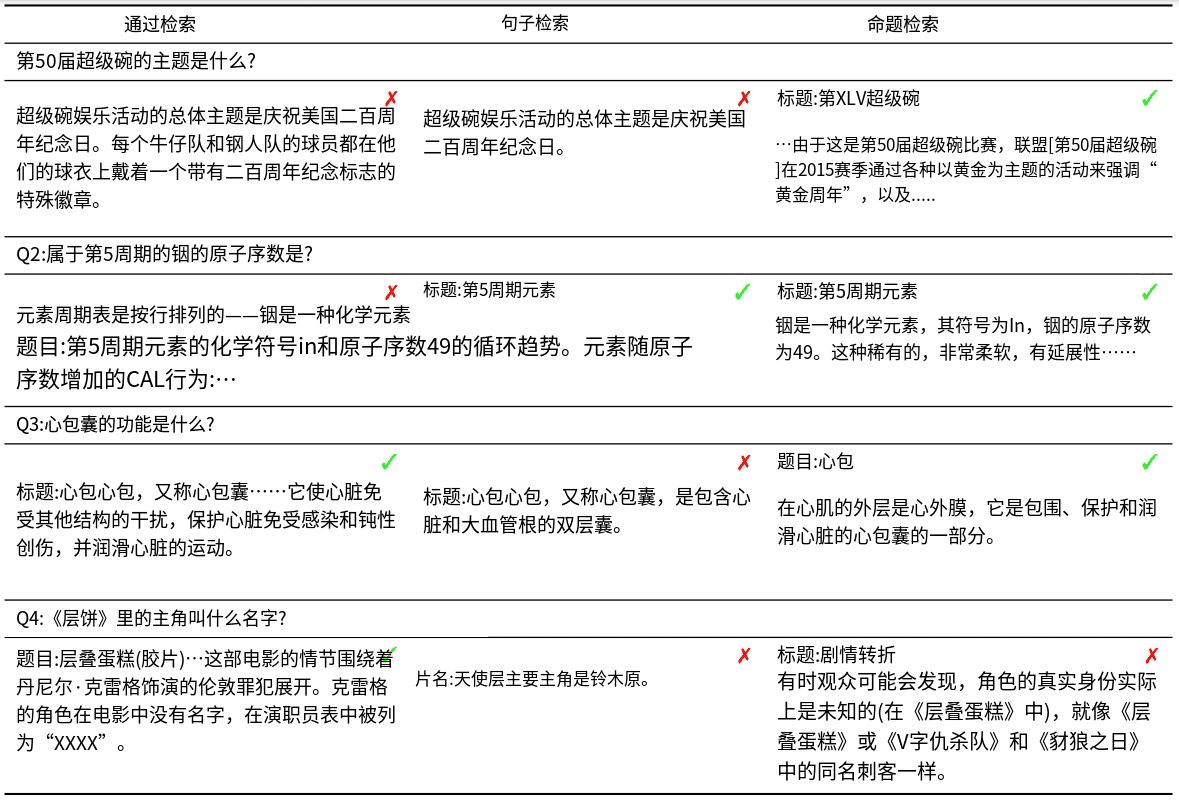

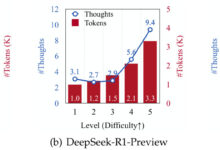

Realizamos uma análise comparativa dos modelos Flan-T5 básico e de grande porte, que foram treinados com diferentes quantidades de dados (conforme mostrado na Fig. 5). Os resultados do estudo mostram que modelos maiores, associados a grandes quantidades de dados de treinamento, produzem melhores resultados. O analisador de proposições obteve um valor F1 de 0,822. Depois de revisar manualmente as proposições geradas, consideramos que elas são satisfatórias.

Fig. 5: Desempenho da decomposição em nível proposicional para modelos de diferentes tamanhos e número de dados de treinamento.

C Índice off-line

Codificamos as unidades recuperadas como embeddings usando os pacotes pyserini e faiss. Codificamos cada unidade de texto usando várias GPUs agrupadas em 1 milhão de unidades com um tamanho de lote de 64. Após o pré-processamento dos embeddings, realizamos todos os experimentos usando a pesquisa exata com produto interno (faiss.IndexFlatIP). O índice puro do FACTOIDWIKI tem aproximadamente 768 GB de tamanho. Para reduzir a pressão da memória, a incorporação é dividida em 8 fatias. Cada fatia executa uma pesquisa aproximada do vizinho mais próximo antes de agregar todos os resultados. Embora o número de proposições seja seis vezes maior que o número de passagens, é possível obter tempos de pesquisa sublineares em relação ao número total de vetores usando técnicas de indexação eficientes. Além disso, a exploração do paralelismo da GPU e a indexação distribuída reduzem significativamente o tempo de pesquisa on-line. Assim, com uma implementação adequada, podemos tornar a pesquisa proposicional uma opção prática e eficiente.

D Modelo Retriever

Usamos os pacotes transformers e sentence-transformers para a implementação do modelo. Usamos os seguintes pontos de verificação publicados no HuggingFace: SimCSE (princeton-nlp/unsup-simcse-bert-base-uncased), Contriever (facebook/contriever), DPR (facebook/dpr- ctx_encoder-multiset-base, facebook/dpr-question_encoder-multiset-base), ANCE (castorini/ance-dpr-context-multi, castorini/ance-dpr- question-multi,), TAS-B (sentence-transformers/msmarco-distilbert-base-tas-b) e GTR (sentence-transformers/gtr-t5-base).

E Resultados adicionais

Na Seção 5.2, mostramos as vantagens da recuperação baseada em proposições em relação à recuperação baseada em frases, especialmente em EQs em que a população de entidades diminui. Usamos o número de ocorrências nos primeiros 1.000 parágrafos recuperados pelo BM25 como um indicador de prevalência, em vez de usar o número de hiperlinks para entidades, conforme usado em Sciavolino et al. (2021). Como resultado, a tendência do gráfico de desempenho vs. popularidade (Figura 6) mostra algumas diferenças entre nossos resultados e os de Sciavolino et al. (2021). Por exemplo, algumas entidades são ambíguas (por exemplo, 1992, uma série de TV). Nesse caso, o número de ocorrências da forma superficial da entidade é grande. Ao mesmo tempo, as perguntas relacionadas a entidades difusas são difíceis de responder, o que resulta em baixa recuperação. Na Seção 6.2, discutimos a recuperação de respostas no texto recuperado como uma função do comprimento do contexto. Além disso, mostramos a tendência de desempenho dos seis recuperadores densos, conforme mostrado na Fig. 7. Os resultados mostram que a recuperação de proposições é consistentemente melhor do que a de frases e parágrafos. Nossos resultados levam à conclusão de que há uma densidade maior de unidades relevantes para a pergunta nas proposições em comparação com frases e parágrafos.

Figura 8: Dicas para gerar proposições de artigos usando o GPT-4.

Decompor o "Conteúdo" em proposições claras e simples, garantindo que elas sejam interpretáveis

de contexto.

1. dividir a sentença composta em sentenças simples. manter o fraseado original da entrada

sempre que possível.

2. para qualquer entidade nomeada que seja acompanhada de informações descritivas adicionais, separe-as

informações em sua própria proposição distinta.

3. descontextualizar a proposição adicionando o modificador necessário a substantivos ou frases inteiras

e substituindo os pronomes (por exemplo, "it", "he", "she", "they", "this", "that") pelo nome completo da

entidades a que se referem.

4. apresentar os resultados como uma lista de cadeias de caracteres, formatada em JSON.Entrada. Título: Eostre. Seção: Teorias e interpretações, Conexão com as lebres da Páscoa. Conteúdo: ¯

A evidência mais antiga da lebre da Páscoa (Osterhase) foi registrada no sudoeste da Alemanha em

1678 pelo professor de medicina Georg Franck von Franckenau, mas permaneceu desconhecida em

O estudioso Richard Sermon escreve que "as lebres eram um dos principais animais de estimação do mundo".

frequentemente visto em jardins na primavera e, portanto, pode ter servido como uma explicação conveniente para o

Como alternativa, há uma tradição europeia de "os primeiros ovos europeus", que é uma forma dos "primeiros ovos europeus", e os "segundos ovos europeus", que é uma forma dos "segundos ovos europeus".

que as lebres botavam ovos, já que o arranhão ou a forma de uma lebre e o ninho de um abibe são muito parecidos, e

Ambos ocorrem em pastagens e são vistos pela primeira vez na primavera. No século XIX, a influência do

de cartões, brinquedos e livros de Páscoa foi popularizar a lebre/coelho da Páscoa em toda a Europa.

Os imigrantes alemães exportaram o costume para a Grã-Bretanha e para os Estados Unidos, onde ele evoluiu para o

Coelhinho da Páscoa".

Saída. [ "A evidência mais antiga da lebre da Páscoa foi registrada no sudoeste da Alemanha em

1678 por Georg Franck von Franckenau.", "Georg Franck von Franckenau foi um professor de

A evidência da lebre da Páscoa permaneceu desconhecida em outras partes da Alemanha

até o século XVIII.", "Richard Sermon era um acadêmico.", "Richard Sermon escreve uma hipótese

sobre a possível explicação para a conexão entre as lebres e a tradição durante a Páscoa".

"As lebres eram vistas com frequência nos jardins na primavera.", "As lebres podem ter servido como um

explicação para a origem dos ovos coloridos escondidos nos jardins para as crianças.", "Há uma

tradição europeia de que as lebres botavam ovos.", "O arranhão ou forma de uma lebre e o ninho de um abibe parecem muito

similar.", "Os ninhos de lebres e de abibes ocorrem em pastagens e são vistos pela primeira vez na primavera.", "Os ninhos de lebres e de abibes ocorrem em pastagens e são vistos pela primeira vez na primavera.".

"No século XIX, a influência dos cartões de Páscoa, brinquedos e livros era fazer com que a Páscoa se tornasse uma data especial.

Hare/Rabbit popular em toda a Europa.", "Os imigrantes alemães exportaram o costume da

O costume da lebre/coelho da Páscoa evoluiu para a Grã-Bretanha e para a América.", "O costume da lebre/coelho da Páscoa evoluiu para

o coelhinho da Páscoa na Grã-Bretanha e na América"]. Entrada. <a new passage>

Saída.

Divida o "conteúdo" em ideias claras e simples para garantir que elas façam sentido quando retiradas de seu contexto original.

1. divida as frases compostas em frases simples e, sempre que possível, mantenha a formulação original.

2) Para entidades específicas com informações descritivas adicionais, essas informações são separadas em asserções distintas.

3. tirar as afirmações do contexto adicionando os modificadores necessários aos substantivos ou a frases inteiras ou substituindo os pronomes (por exemplo, "isso", "ele", "ela", "eles", "isso", "aquilo") pelo nome completo da entidade à qual se referem.

4. apresente os resultados como uma lista de cadeias de caracteres e use o formato JSON.Entrada:Título: Eostre. capítulo: teorias e explicações, com links para o coelhinho da Páscoa. Conteúdo: A evidência mais antiga do coelhinho da Páscoa (Osterhase) foi registrada por Georg Franck von Franckenau em 1678 no sudoeste da Alemanha, mas era desconhecido no resto da Alemanha até o século XVIII. O acadêmico Richard Sermon escreve que "as lebres eram frequentemente vistas em jardins na primavera, portanto, podem ter sido usadas como uma explicação conveniente para a origem dos ovos coloridos que as crianças encontravam em seus jardins. Além disso, há uma tradição na Europa de que as lebres põem ovos porque seus arranhões ou formas se assemelham muito aos ninhos de pássaros de trigo, e elas são encontradas em prados e descobertas pela primeira vez na primavera. No século XIX, a influência dos cartões de Páscoa, brinquedos e livros tornou o coelhinho da Páscoa popular em toda a Europa. O costume foi então disseminado por imigrantes alemães na Inglaterra e nos Estados Unidos, onde evoluiu para o coelhinho da Páscoa como o conhecemos hoje."

Saída:[ "A evidência mais antiga relacionada ao coelhinho da Páscoa foi encontrada por Georg Franck von Franckenau no sudoeste da Alemanha em 1678." , "Georg Franck von Franckenau era professor de medicina." , "Foi somente no século XVIII que as pessoas em outras partes da Alemanha começaram a tomar conhecimento dessa evidência da associação do coelho da Páscoa." , "Richard Sermon era um acadêmico." , "Richard Sermon ofereceu uma hipótese sobre possíveis explicações para a associação tradicional da lebre com a Páscoa.", "Hares can often be found in gardens in the springtime.", "Hares can be found in gardens in the springtime." , "Hares may be a simple explanation for why children find coloured eggs in their gardens.", "Hares may be a simple explanation for why children find coloured eggs in their gardens." , "Há uma visão tradicional na Europa de que as lebres põem ovos." , "O raspado ou forma da lebre é extremamente semelhante ao ninho do pássaro do trigo, ambos encontrados em pastagens e descobertos pela primeira vez na primavera." , "No século XIX, o coelhinho da Páscoa tornou-se amplamente conhecido na Europa devido à popularidade dos cartões, brinquedos e livros de Páscoa." , "Os imigrantes alemães levaram o costume do coelhinho da Páscoa para a Inglaterra e os Estados Unidos." , "Na Inglaterra e nos Estados Unidos, o costume do coelhinho da Páscoa evoluiu gradualmente para o coelhinho da Páscoa que conhecemos hoje." ] Entrada:

Saída: