Introdução geral

O GPT Crawler é uma ferramenta de código aberto que permite aos usuários gerar arquivos de conhecimento por meio do rastreamento do conteúdo de um site específico, o que, por sua vez, cria modelos GPT personalizados. O projeto é usado principalmente para rastrear e organizar informações da Web, com suporte para execução por meio da API e implantação local. Os usuários podem configurar o rastreador de forma flexível para se adaptar a diferentes estruturas e necessidades de sites, de modo a gerar documentos de base de conhecimento adequados para seu próprio uso.

Lista de funções

- Rastreamento do conteúdo do site para gerar arquivos de conhecimento

- Suporta API e execuções de implementação local

- Configuração flexível dos parâmetros do rastreador

- Gerar modelos GPT personalizados

- Suporta a exclusão de vários formatos de arquivo

Usando a Ajuda

Processo de instalação

- armazém de clonesPrimeiro, verifique se você tem o Node.js >= 16 instalado. Em seguida, execute o seguinte comando para clonar o repositório:

git clone https://github.com/BuilderIO/gpt-crawler - Instalação de dependênciasInstalação das dependências: Vá para o diretório do projeto e instale as dependências:

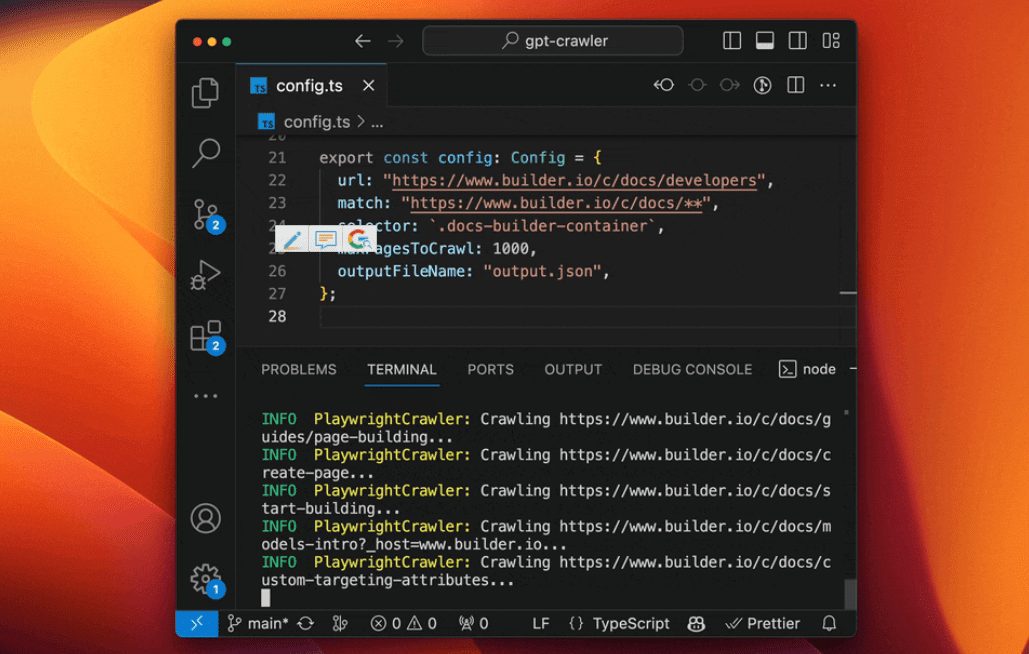

cd gpt-crawler instalação do npm - Configuração do rastreador: Aberto

config.tsedite o arquivourlresponder cantandoseletorpara atender às suas necessidades. Por exemplo, para rastrear documentos do Builder.io, você pode usar a seguinte configuração:exportação const defaultConfig: Configuração = { url: "https://www.builder.io/c/docs/developers", partida: "https://www.builder.io/c/docs/**", seletor: ".docs-builder-container", maxPagesToCrawl: 50, outputFileName: "output.json", }; - Executando o rastreadorConfiguração: Quando a configuração estiver concluída, execute o seguinte comando para iniciar o rastreador:

npm run start

Instruções de uso

- arquivo de configuração: em

config.tsvocê pode definir parâmetros como o URL inicial do rastreador, o padrão de correspondência, o seletor, o número máximo de páginas a serem rastreadas e assim por diante. Certifique-se de que esses parâmetros correspondam à estrutura do site de destino. - Executando o rastreador: Uso

npm run startinicia o rastreador, que rastreia o conteúdo do site e gera arquivos de conhecimento com base nos parâmetros do arquivo de configuração. - Gerar modelo GPTQuando o rastreador estiver concluído, os arquivos de conhecimento gerados serão salvos no diretório do projeto. Você pode carregar esses arquivos no OpenAI ou em outros serviços de GPT para criar modelos de GPT personalizados.

- Uso da APISe você quiser executar o rastreador por meio da API, poderá consultar a documentação da API no projeto para configurar e iniciar o serviço da API.

advertência

- exclusão de recursos: em

config.tsvocê pode passar o arquivoresourceExclusionsexclui tipos de arquivos indesejados, como imagens, vídeos, etc. - Limite de tamanho de arquivo: Você pode definir

maxFileSizeresponder cantandomaxTokensque limita o tamanho máximo do arquivo gerado e o tamanho máximo do arquivo de token Quantidade.