Detalhes do exemplo do notebook Qwen2.5-VL: Primeiros passos com modelos visuais multimodais

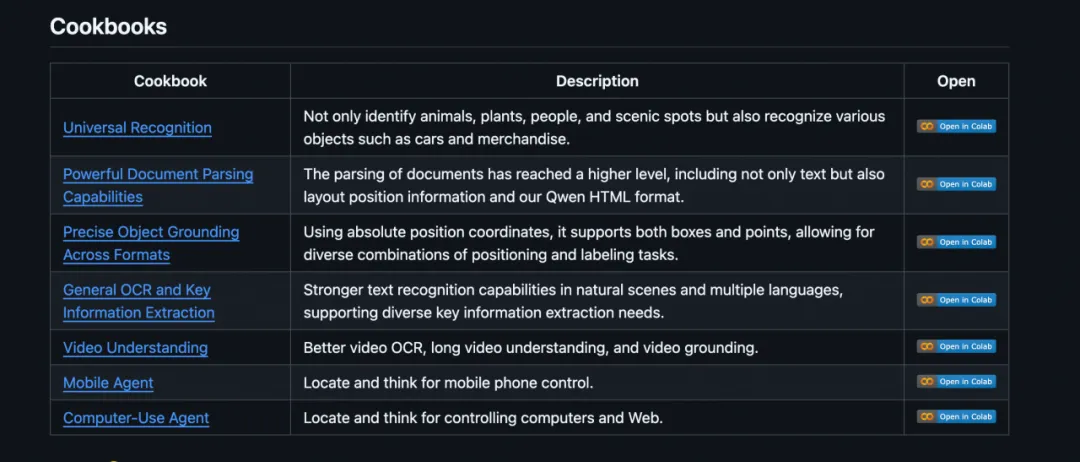

Recentemente, a equipe da Qwen orgulhosamente lançou uma série de Exemplo de caderno de casos de uso do Qwen2.5-VLEsta é uma demonstração abrangente do poder dos modelos e APIs nativos. Esta coleção de Notebooks cuidadosamente elaborados foi projetada para ajudar os desenvolvedores e usuários a obter uma compreensão mais profunda dos Qwen2.5-VL compreensão visual poderosa e inspirar aplicativos mais inovadores.

Exemplo de notebook: Primeiros passos com o Qwen 2.5-VL

Com esses exemplos detalhados do Notebook, os desenvolvedores podem Acelere e veja por si mesmo o desempenho do modelo Qwen 2.5-VL em todas as tarefas!Qwen2.5-VL Seja lidando com a análise de documentos complexos, executando tarefas precisas de OCR ou realizando uma compreensão profunda do conteúdo de vídeo, o Qwen2.5-VL fornece feedback eficiente e preciso, demonstrando seu desempenho superior.

Ao mesmo tempo, a equipe do Qwen aguarda ansiosamente o feedback e as contribuições da comunidade para melhorar e expandir os recursos do Qwen 2.5-VL e trabalhar em conjunto para promover o desenvolvimento da tecnologia multimodal.

🔗 RELACIONADOS:

- Repositório do GitHub. https://github.com/QwenLM/Qwen2.5-VL/tree/main/cookbooks

- Experiência on-line. https://chat.qwenlm.ai (selecione o modelo Qwen2.5-VL-72B-Instruct)

- Link do modelo ModelScope: https://www.modelscope.cn/collections/Qwen25-VL-58fbb5d31f1d47

- Interface API da Parsons Brinckerhoff. https://help.aliyun.com/zh/model-studio/user-guide/vision/

Exemplos de notebooks em detalhes

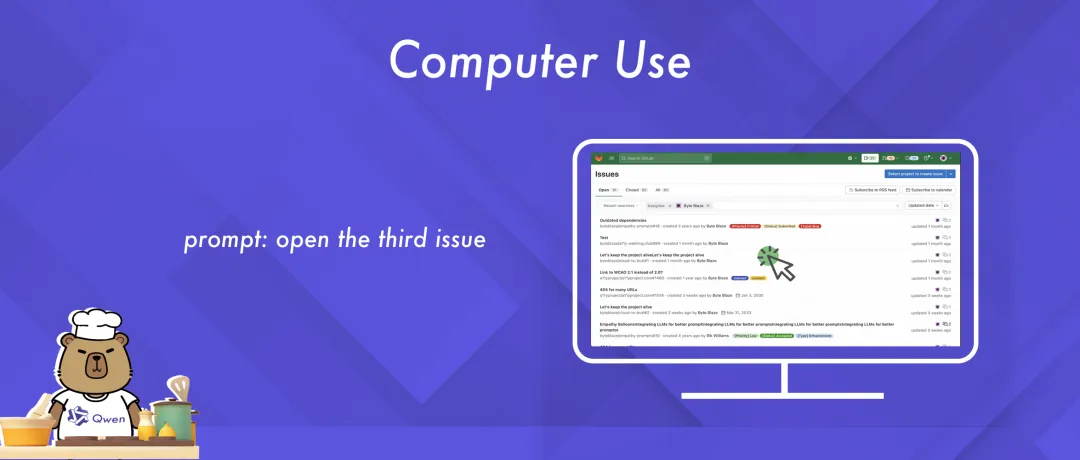

01 Uso do computador

Este exemplo de Notebook demonstra como usar o Qwen2.5-VL para realizar tarefas relacionadas ao uso do computador.

Os usuários só precisam tirar uma captura de tela da área de trabalho do computador e fazer uma consulta. O modelo Qwen2.5-VL pode analisar o conteúdo da captura de tela, entender a intenção do usuário e gerar instruções precisas, como clicar ou digitar, para obter o controle inteligente do computador.

👉 Links para o notebook. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/computer_use.ipynb

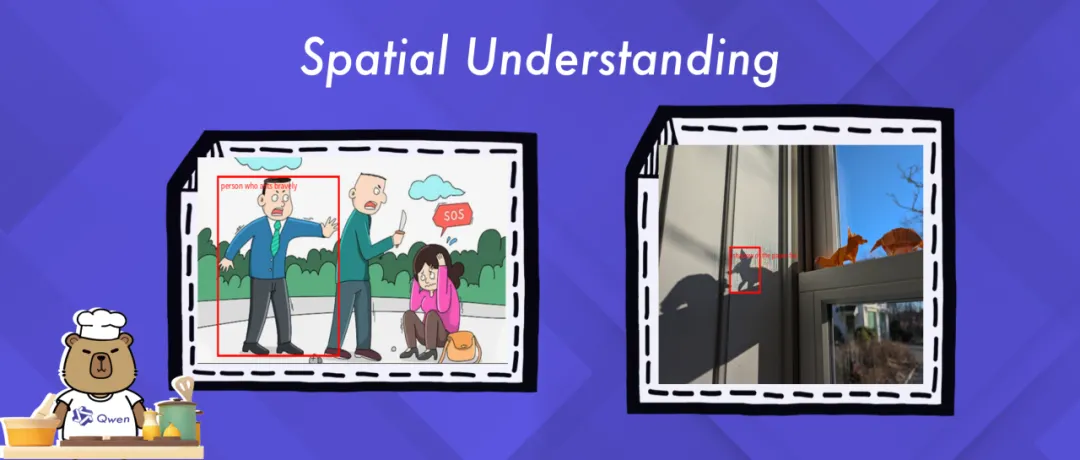

02 Compreensão espacial

Esse exemplo do Notebook destaca os recursos avançados de localização espacial do Qwen2.5-VL, incluindo a detecção precisa de objetos e a localização de alvos específicos em uma imagem.

Os exemplos fornecem uma visão de como o Qwen2.5-VL integra efetivamente a compreensão visual e linguística para interpretar com precisão cenários complexos e permitir o raciocínio espacial avançado.

👉 Links para o notebook. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/spatial_understanding.ipynb

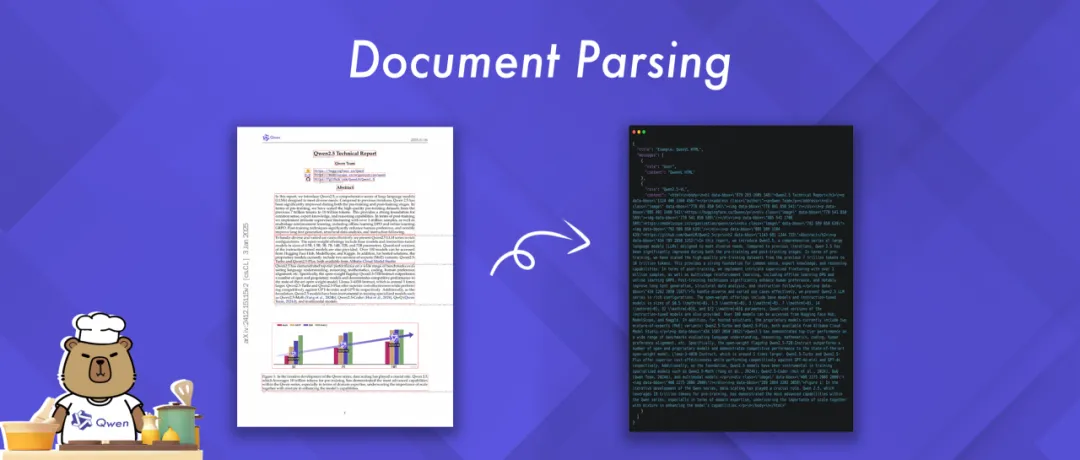

03 Análise de documentos

Este exemplo do Notebook destaca os poderosos recursos de análise de documentos do Qwen2.5-VL. Ele pode processar documentos em uma variedade de formatos de imagem e gerar os resultados analisados em uma variedade de formatos, incluindo HTML, JSON, MD e LaTeX.

De interesse especial é a introdução inovadora da Qwen de um formato HTML QwenVL exclusivo. Esse formato contém informações sobre a localização de cada componente no documento, permitindo a reconstrução precisa e a manipulação flexível do documento.

👉 Links para o notebook. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/document_parsing.ipynb

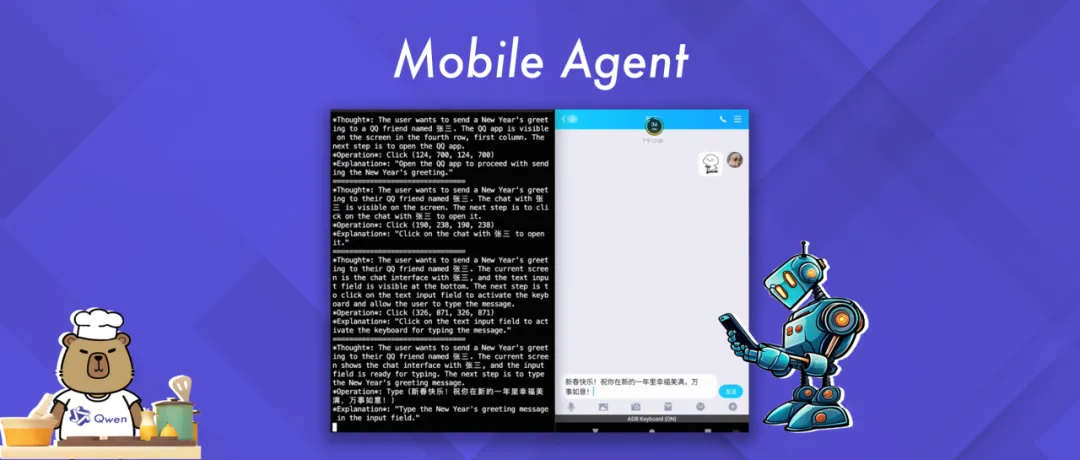

04 Agente móvel (agente de dispositivo móvel)

Este exemplo do Notebook demonstra como interagir de forma inteligente com um dispositivo móvel usando os recursos de agente do Qwen2.5-VL.

O exemplo mostra como o modelo Qwen2.5-VL gera e executa ações com base na consulta do usuário e no contexto visual do dispositivo móvel, permitindo um controle fácil do dispositivo móvel.

👉 Links para o notebook. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/mobile_agent.ipynb

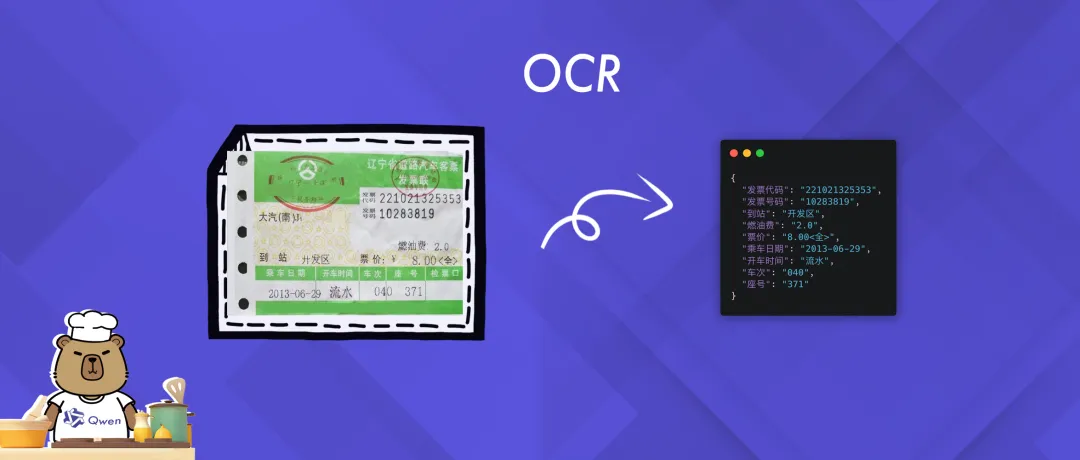

05 OCR (reconhecimento óptico de caracteres)

Este exemplo de Notebook se concentra em demonstrar os recursos de OCR (reconhecimento óptico de caracteres) do Qwen2.5-VL, incluindo a extração e o reconhecimento precisos de informações de texto de imagens.

Por meio dos exemplos, os usuários podem entender intuitivamente como o Qwen2.5-VL pode capturar e interpretar com precisão o conteúdo de texto em cenários complexos, demonstrando seus poderosos recursos de reconhecimento de texto.

👉 Links para o notebook. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/ocr.ipynb

06 Reconhecimento universal

Este exemplo do Notebook mostra como usar o Qwen2.5-VL para reconhecimento genérico de objetos.

O modelo Qwen2.5-VL analisa a imagem, compreende a intenção de consulta do usuário e fornece o resultado de reconhecimento correspondente, obtendo uma compreensão abrangente do conteúdo da imagem.

👉 Links para o notebook. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/universal_recognition.ipynb

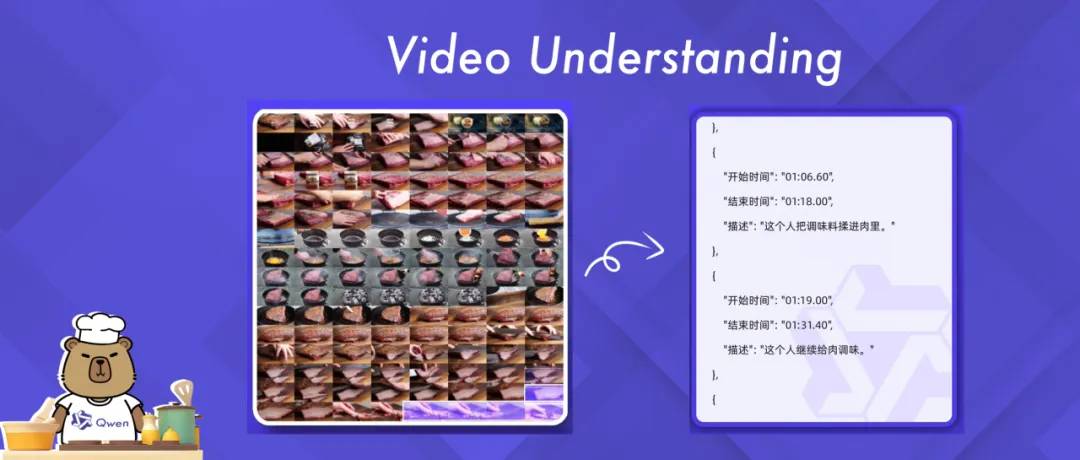

07 Compreensão de vídeo

O Qwen2.5-VL tem recursos poderosos de compreensão de vídeos longos e pode lidar com conteúdo de vídeo com mais de 1 hora de duração. Este exemplo do Notebook oferece uma exploração aprofundada dos recursos do modelo Qwen2.5-VL para tarefas de compreensão de vídeo.

O Qwen2.5-VL foi projetado para demonstrar seu potencial em uma ampla variedade de cenários de análise de vídeo, desde o OCR (Optical Character Recognition) básico até a detecção de eventos complexos e a sumarização de conteúdo.

👉 Links para o notebook. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/video_understanding.ipynb

Práticas recomendadas do Magic Hitch: exemplo de livro de receitas de jogo aritmético gratuito

Na comunidade do ModelScope Magic Hitch, os usuários podem experimentar facilmente esses exemplos do Cookbook com aritmética livre.

Primeiro, faça o download do código Qwen2.5-VL.

git clone https://github.com/QwenLM/Qwen2.5-VL.git

Use a API Models no Notebook: A API-Inference da Plataforma MagicBuilder fornece uma API gratuita para a família de modelos Qwen2.5-VL, que pode ser usada diretamente pelos usuários do MagicBuilder por meio de chamadas de API, substituindo a base-URL no Cookbook e preenchendo o MagicBuilder SDK. Token Pronto para começar.Documentação detalhada: https://www.modelscope.cn/docs/model-service/API-Inference/intro

from openai import OpenAI

client = OpenAI(

api_key="<MODELSCOPE_SDK_TOKEN>", # ModelScope Token

base_url="https://api-inference.modelscope.cn/v1"

)

response = client.chat.completions.create(

model="Qwen/Qwen2.5-VL-72B-Instruct", # ModelScope Model-Id

messages = [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": "https://modelscope.oss-cn-beijing.aliyuncs.com/demo/images/bird-vl.jpg"}

},

{ "type": "text",

"text": "Count the number of birds in the figure, including those that are only showing their heads. To ensure accuracy, first detect their key points, then give the total number."

},

],

}

],

stream=True

)

O Notebook usa um modelo local: Selecione o modelo da GPU.

Conclusão: Bem-vindo à experiência e à criação do futuro juntos

No futuro, a equipe do Qwen continuará a atualizar e expandir esses exemplos do Notebook para incorporar mais recursos úteis e cenários de aplicação, em um esforço para fornecer aos desenvolvedores soluções mais abrangentes. Bem-vindo ao repositório GitHub do Qwen2.5-VL ou ao ModelScope para experimentar esses exemplos do Notebook e compartilhar sua experiência e aplicações inovadoras! A equipe do Qwen está ansiosa para explorar as possibilidades do Qwen2.5-VL com você.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...