Introdução geral

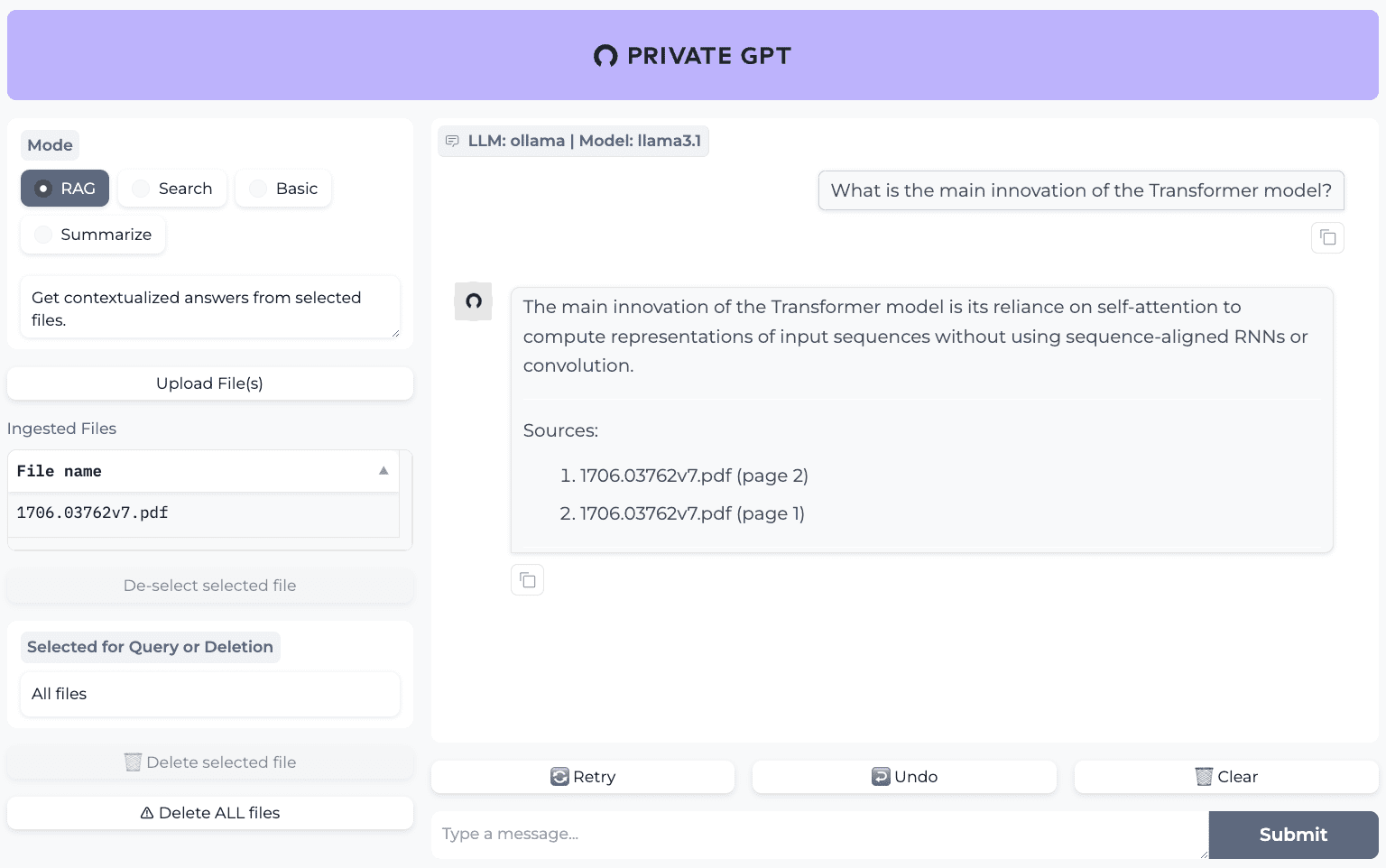

O PrivateGPT é um projeto de IA disponível para ambientes de produção que permite aos usuários fazer testes em documentos usando modelos de linguagem grandes (LLMs) sem uma conexão com a Internet. O projeto garante a privacidade dos dados para o 100%, e todos os dados são processados no ambiente de execução do usuário sem divulgação. O PrivateGPT foi desenvolvido pela equipe da Zylon para fornecer uma API que suporta a criação de aplicativos de IA privados e com reconhecimento de contexto. O projeto segue e amplia o padrão da API OpenAI para oferecer suporte a respostas normais e de streaming. O PrivateGPT é adequado para domínios que exigem um alto grau de privacidade de dados, como saúde e direito.

Projetos semelhantes:Kotaemon: uma ferramenta de questionário de documentos multimodais de código aberto simples de implantar

Lista de funções

- Ingestão de documentos: gerencie a análise de documentos, a divisão, a extração de metadados, a geração de incorporação e o armazenamento.

- Chat & Finish: Conversação e conclusão de tarefas usando o contexto do documento ingerido.

- Geração de incorporação: gera incorporação com base no texto.

- Pesquisa de blocos de contexto: ingere os blocos de texto mais relevantes em um documento com base nos retornos da consulta.

- Gradio UI Client: fornece um cliente funcional para testar a API.

- Ferramentas para scripts de download de modelos em lote, scripts de ingestão, monitoramento de pastas de documentos e muito mais.

Usando a Ajuda

Processo de instalação

- armazém de clonesPrimeiro, clone o repositório GitHub do PrivateGPT.

git clone https://github.com/zylon-ai/private-gpt.git

cd private-gpt

- Instalação de dependências: Uso

tubulaçãoInstale as dependências necessárias do Python.

pip install -r requirements.txt

- Ambiente de configuraçãoConfigure as variáveis de ambiente e os arquivos de configuração conforme necessário.

cp settings-example.yaml settings.yaml

# Edite o arquivo settings.yaml para configurar os parâmetros relevantes

- Início dos serviçosIniciar o serviço usando o Docker.

docker-compose up -d

Usando a função de perguntas e respostas da documentação

- ingestão de documentosScript de ingestão: coloque os documentos a serem processados na pasta especificada e execute o script de ingestão.

python scripts/ingest.py --input-folder path/to/documents

- Interação de perguntas e respostasUse o cliente Gradio UI para interações de perguntas e respostas.

python app.py

# Abra seu navegador em http://localhost:7860

Uso de API de alto nível

- Análise de documentos e geração de incorporaçãoAnálise de documentos e geração de incorporação usando APIs de alto nível.

de private_gpt import HighLevelAPI

api = HighLevelAPI()

api.ingest_documents("path/to/documents")

- Pesquisa de contexto e geração de respostasRecuperação de contexto e geração de respostas usando APIs de alto nível.

response = api.chat("sua pergunta")

print(response)

Uso da API de baixo nível

- Geração de incorporaçãoGerar incorporação de texto usando a API de baixo nível.

de private_gpt import LowLevelAPI

api = LowLevelAPI()

embedding = api.generate_embedding("seu texto")

- pesquisa de blocos de contextoRecuperação de blocos de contexto usando APIs de baixo nível.

pedaços = api.retrieve_chunks("sua consulta")

print(chunks)

Uso do conjunto de ferramentas

- Download do modelo de loteUse o script Bulk Model Download para fazer o download dos modelos necessários.

python scripts/download_models.py

- Monitoramento da pasta DocumentosIngestão automática de novos documentos usando a ferramenta Document Folder Monitor.

python scripts/watch_folder.py --folder path/to/documents