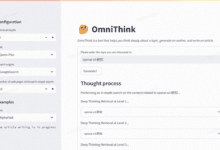

Introdução geral

O Pieces-OS é um projeto de código aberto que tem como objetivo reverter os fluxos GRPC do Pieces-OS e convertê-los na interface padrão da API OpenAI, com suporte para Claude, GPT e Gemini. O projeto foi desenvolvido pela Nekohy, com base no protocolo de código aberto GPL-3.0, principalmente para aprendizado e comunicação, não para uso comercial. O projeto oferece uma variedade de compatibilidade de modelos e suporte para a implantação de um clique do Vercel.

direção reversa peças A implementação gratuita de um minuto de interfaces de API com suporte aos modelos Claude, GPT e Gemini. Fornecerversão go.

Lista de funções

- Inversão de fluxo GRPCGRPC: converte fluxos GRPC do Pieces-OS para a interface padrão do OpenAI.

- Suporte a vários modelos: Compatível Claude série GPT, série Gemini e muitos outros modelos.

- Implementação em um clique: Suporte Implementação da plataforma Vercel com um cliqueque é fácil para os usuários criarem rapidamente.

- Configuração do modelo de nuvemForneça perfis de modelos de nuvem para que os usuários possam extrair e usar modelos diferentes conforme necessário.

- Gerenciamento de solicitações de APIGerencie caminhos de prefixo, chaves, novas tentativas etc. para solicitações de API configurando variáveis de ambiente.

Usando a Ajuda

Processo de instalação

- projeto de clonagem: Uso

clone do gitpara clonar o projeto localmente.git clone https://github.com/Nekohy/pieces-os.git - Instalação de dependênciasVá para o diretório do projeto e instale

package.jsonBibliotecas de dependência definidas nocd pieces-os npm install - procedimento de acionamento: Implementação

node index.jsIniciar o procedimento.node index.js

Processo de uso

- Obter uma lista de modelosObtenha a lista de modelos disponíveis com o seguinte comando.

curl --request GET 'http://127.0.0.1:8787/v1/models' --header 'Content-Type: application/json' - Enviar solicitaçãoUse o comando a seguir para enviar uma solicitação de bate-papo.

curl --request POST 'http://127.0.0.1:8787/v1/chat/completions' --header 'Content-Type: application/json' --data '{ "messages": [ { "role": "user", "content":[ { "content": "Hello!" } ],, "model": "gpt-4o", "content": "Hello!" } "model": "gpt-4o", "stream": true }'

Configuração da variável de ambiente

- API_PREFIXCaminho do prefixo para solicitações de API; o valor padrão é

'/'. - API_KEYChave da solicitação de API: a chave da solicitação de API tem como padrão uma cadeia de caracteres vazia.

- MAX_RETRY_COUNTNúmero máximo de tentativas: o padrão é

3. - RETRY_DELAYTempo de atraso de nova tentativa em milissegundos; o valor padrão é

5000(5 segundos). - PORTO: a porta na qual o serviço escuta, o valor padrão é

8787.

Configuração do modelo

O projeto fornece perfis para vários modelos cloud_model.jsonO usuário pode extrair e usar modelos diferentes conforme necessário. Por exemplo:

- Série Claude::

claude-3-5-sonnet@20240620eclaude-3-haiku@20240307etc. - Série GPT::

gpt-3.5-turboegpt-4egpt-4-turboetc. - Série Gemini::

gemini-1.5-flashegemini-1.5-proetc.

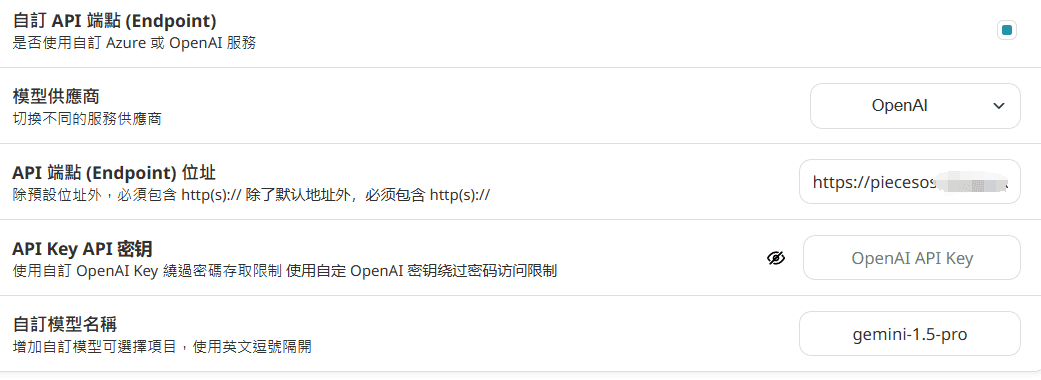

Como usá-lo após a implantação

Configurado no nextchat:

Preencha o nome do domínio diretamente, não adicione após o URL/v1/modelos e /v1/chat/completions

API_KEY não está configurada no Vercel, então nenhuma entrada é necessária.

Configuração em tradução imersiva: (não recomendado devido a problemas de concorrência)

https://你的域名/v1/chat/completions

Se apikey não estiver definida, preencha os espaços em branco.