Open WebUI: WebUI de bate-papo com IA hospedada localmente

Introdução geral

A Open WebUI (anteriormente conhecida como Ollama WebUI) é uma interface de usuário interativa de IA amigável projetada para LLMs (Large Language Models). Ela é dimensionável, rica em recursos e é executada totalmente off-line. Os recursos excepcionais da Open WebUI incluem design de interface de bate-papo, alta capacidade de resposta, fácil configuração usando o Docker ou o Kubernetes, destaque de código, suporte a Markdown e LaTeX, integração RAG local e remota, funcionalidade de chamada de voz/vídeo, integração de geração de imagem e muito mais! recursos e muito mais.

Sobre o OpenWebUI:

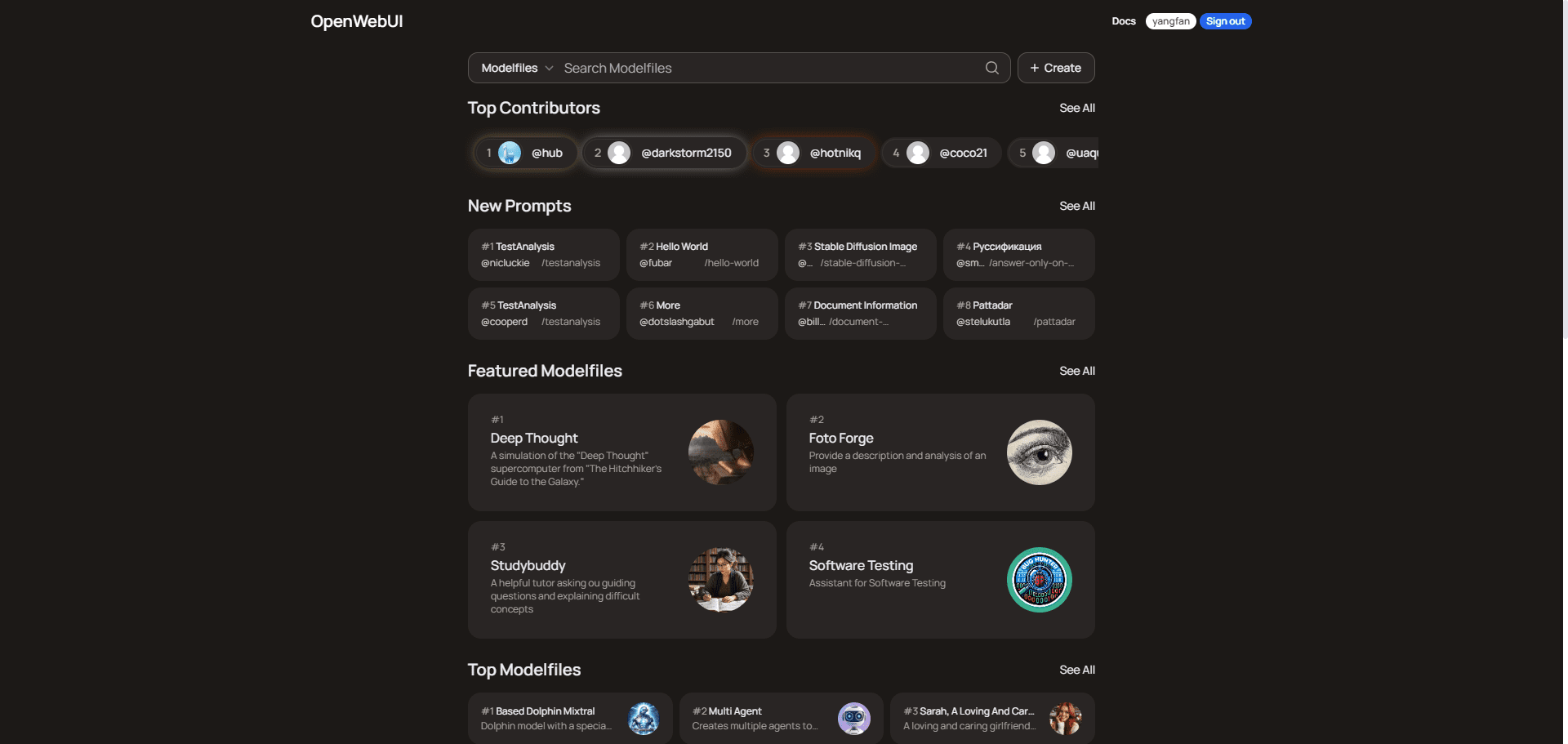

O OpenWebUI é uma plataforma de comunidade de usuários que fornece arquivos de modelos multiuso que abrangem programação, redação, produtividade, educação, negócios e análise de dados. Os usuários podem explorar e baixar esses arquivos de modelo para aumentar a eficiência de suas tarefas e projetos. A plataforma tem mais de 15.000 usuários e é baseada em classificações de colaboradores e em registros de bate-papo inteligentes compartilhados para comunicação e aprendizado.

Para obter o método de implementação gratuita na nuvem, consulte Implementação de um conjunto personalizado de ferramentas de bate-papo em miniatura em computadores de baixo perfil A seguir, uma descrição da implementação do Open WebUI pela Koyeb.

Lista de funções

- Instalação perfeitaInstalação fácil via Docker ou Kubernetes, com suporte para Ollama e imagens marcadas com CUDA.

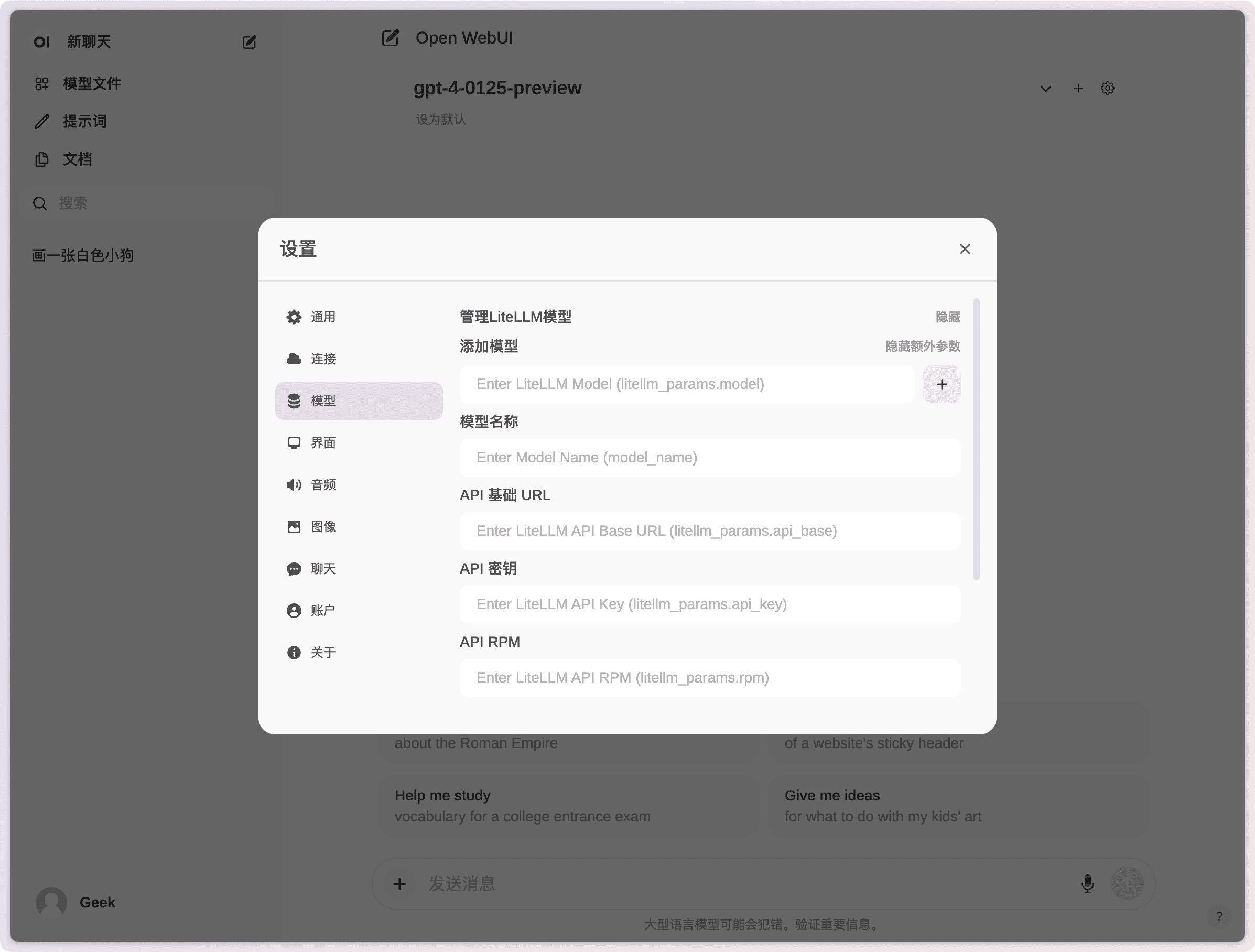

- Integração de APIIntegração fácil com APIs compatíveis com OpenAI e suporte a vários modelos de diálogo.

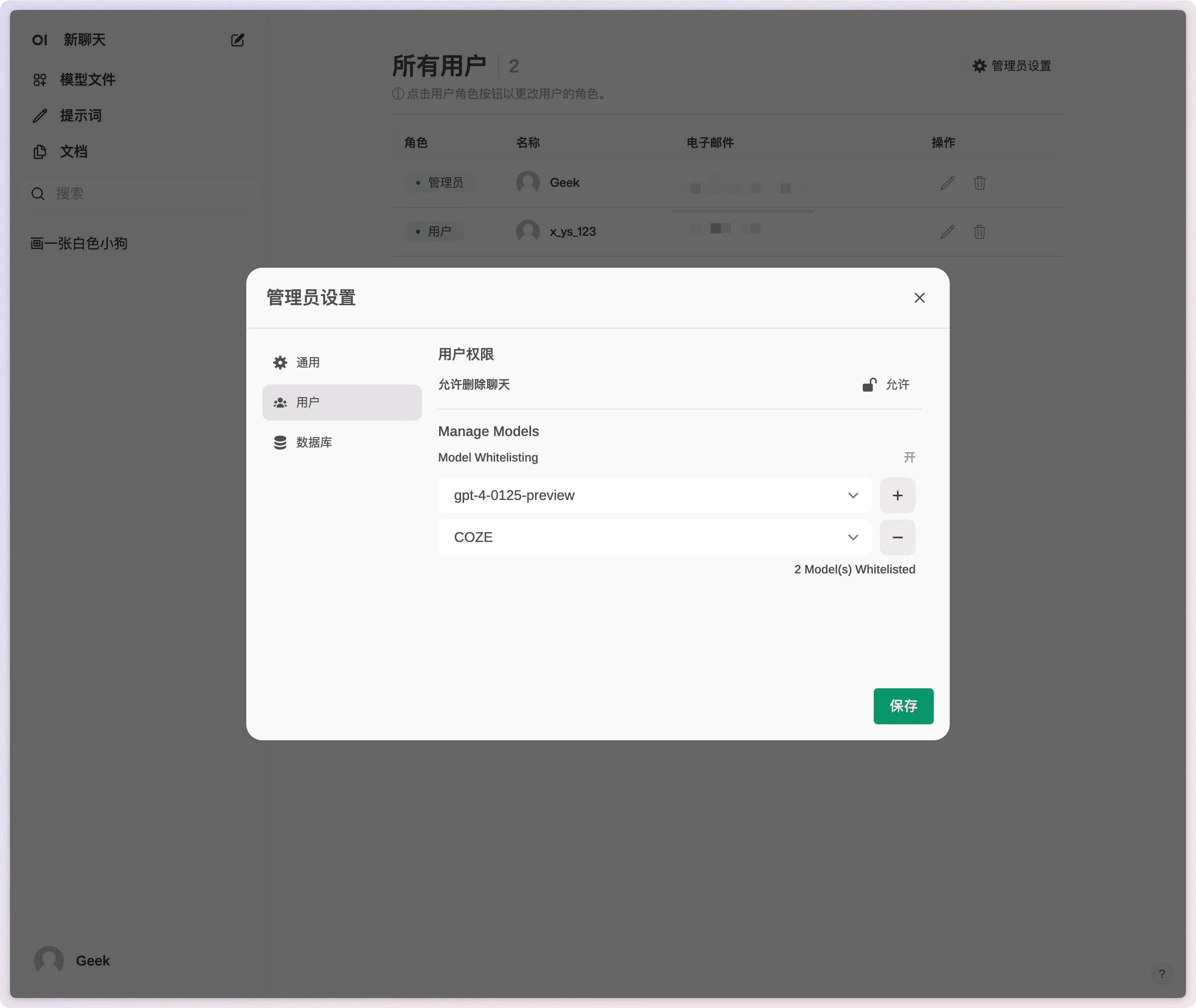

- Permissões e grupos de usuários com granularidade finaOs administradores podem criar funções e permissões de usuário detalhadas para garantir um ambiente de usuário seguro.

- design responsivoAproveite uma experiência perfeita em PCs desktop, laptops e dispositivos móveis.

- Aplicativos Web progressivos (PWA)Fornecer uma experiência semelhante a um aplicativo nativo em dispositivos móveis com suporte para acesso off-line.

- Suporte a Markdown e LaTeXMarkdown e LaTeX: Forneça funcionalidade abrangente de Markdown e LaTeX para aprimorar a experiência interativa.

- Chamadas de voz/vídeoIntegração de chamadas de voz e vídeo sem o uso das mãos para um ambiente de bate-papo mais dinâmico.

- construtor de modelosCrie facilmente modelos Ollama e adicione funções/agentes personalizados por meio da interface do usuário da Web.

- Integração do RAG localSuporte para Retrieval Augmented Generation (RAG) para integrar perfeitamente a interação com documentos à experiência de bate-papo.

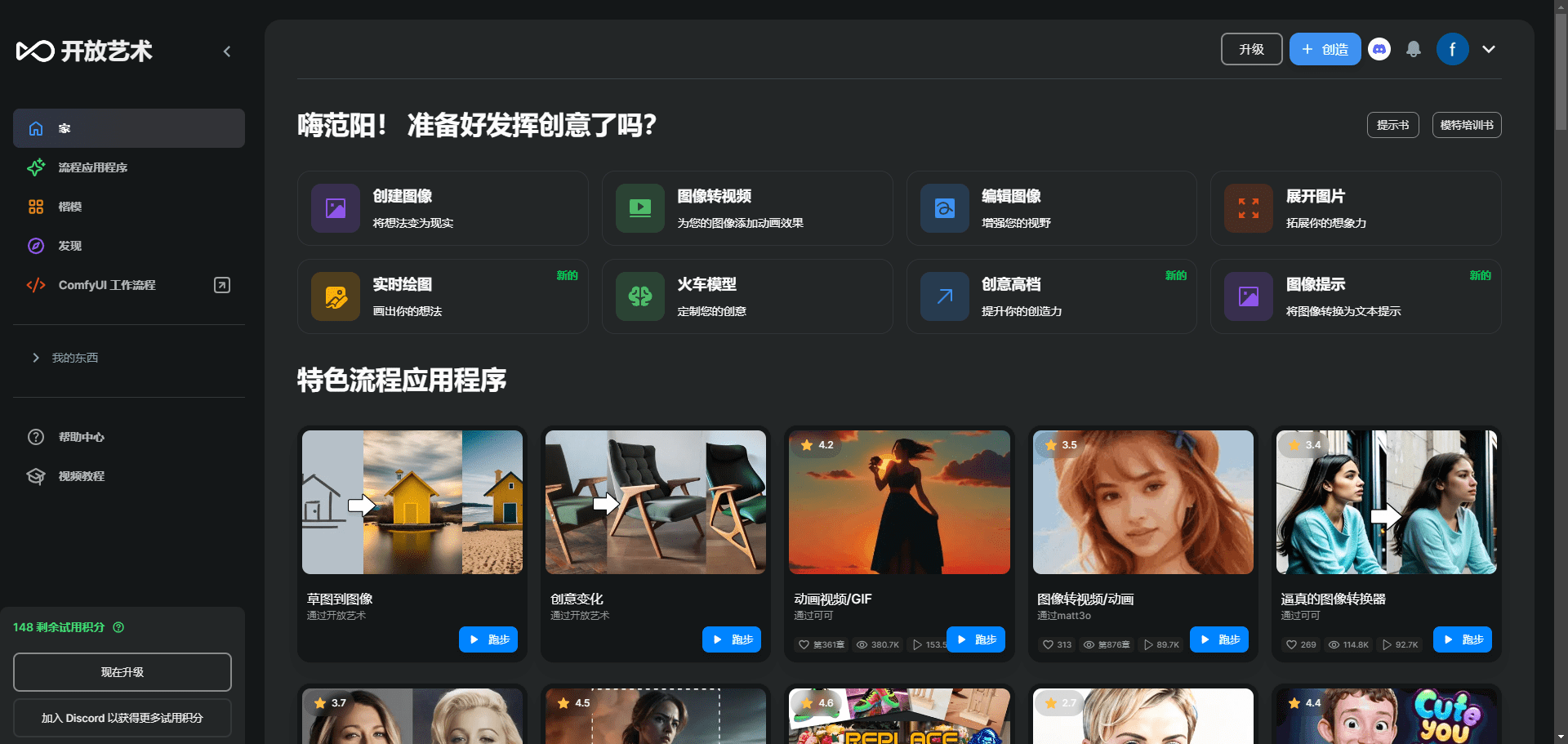

- Integração de geração de imagensSuporte à API AUTOMATIC1111, ComfyUI e DALL-E da OpenAI para enriquecer a experiência de bate-papo.

- diálogo multimodeloInterage com vários modelos ao mesmo tempo, aproveitando seus pontos fortes exclusivos para fornecer a melhor resposta possível.

- Controle de acesso baseado em função (RBAC)Acesso seguro: garanta o acesso seguro, com apenas o pessoal autorizado tendo acesso ao Ollama e às permissões de criação/construção de modelos.

- Suporte a vários idiomasSuporte à internacionalização: O suporte à internacionalização é fornecido para que os usuários possam escolher o idioma de sua preferência.

- Suporte a plug-insIntegração perfeita de lógica personalizada e bibliotecas Python por meio da estrutura de plug-in do Pipelines.

Usando a Ajuda

Processo de instalação

Instalação com o Docker

- Puxando espelhosExecute o seguinte comando em um terminal para extrair a imagem mais recente do Open WebUI Docker do registro de contêineres do GitHub:

docker pull ghcr.io/open-webui/open-webui:main - Execução de contêineresExecute o contêiner com as configurações padrão para garantir o armazenamento persistente dos dados:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main- mapeamento de volumeArmazenamento persistente de dados: garanta o armazenamento persistente de dados para evitar a perda de dados quando o contêiner for reiniciado.

- mapeamento de portasExponha a WebUI à porta 3000 no computador local.

Instalação usando Python

- Instalação da Open WebUIObservação: Certifique-se de usar o Python 3.11 para evitar problemas de compatibilidade. Execute o seguinte comando no terminal:

pip install open-webui - Execução da Open WebUIApós a conclusão da instalação, execute o seguinte comando para iniciar o Open WebUI:

open-webui serveIsso iniciará o servidor Open WebUI, que pode ser encontrado em http://localhost:8080访问.

Guia de operação de funções

Chamadas de voz/vídeo

- iniciar uma chamadaChamada de voz ou vídeo: Clique no botão Chamada de voz ou vídeo na tela de bate-papo para selecionar um contato e iniciar a chamada.

- controle de chamadasDurante uma chamada, você pode usar os botões de controle na interface para silenciar e desligar.

Geração de imagens

- Selecione a ferramenta Image GeneratorSelecione AUTOMATIC1111 API, ComfyUI ou DALL-E da OpenAI na tela de bate-papo.

- Descrição da entradaDigite a descrição da imagem na caixa de entrada e clique no botão Generate (Gerar).

- Exibir resultadosImagem: A imagem gerada será exibida na interface de bate-papo e poderá ser salva ou compartilhada pelo usuário.

Integração do RAG local

- Carregando documentosUse o comando # na interface de bate-papo para carregar documentos ou adicionar arquivos à biblioteca de documentos.

- recuperarDigite uma consulta no bate-papo e o sistema recuperará automaticamente as informações relevantes dos documentos carregados e gerará uma resposta.

problemas comuns

- problema de conectividadeSe tiver problemas de conexão, verifique se o contêiner do Docker tem acesso ao servidor Ollama. Use o seguinte comando para resolver o problema:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main - Atualizando a instalação do DockerUse o Watchtower para atualizar sua instalação local do Docker para a versão mais recente:

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui

Implementação da Open WebUI em um clique no Cuddleface

https://codeberg.org/fossandroid/Open-WebUI.git

https://linux.do/t/topic/274417

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...