OpenManus: a versão de código aberto do Manus do MetaGPT

Introdução geral

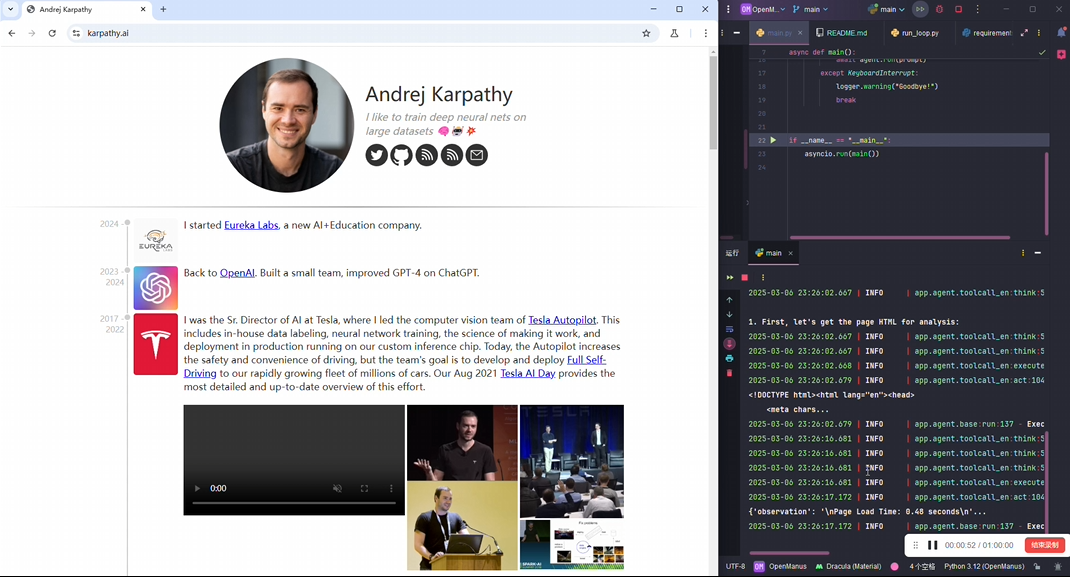

O OpenManus é um projeto de código aberto desenvolvido para ajudar os usuários a executar inteligências localmente com configurações simples para realizar várias ideias criativas. Ele consiste em MetaGPT Os membros da comunidade @mannaandpoem, @XiangJinyu, @MoshiQAQ e @didiforgithub o desenvolveram em apenas 3 horas e, enquanto isso, você pode acompanhar o projeto de programação automatizada deles! MGX Em comparação com o Manus, que exige um código de convite, o OpenManus não exige nenhuma barreira de entrada. Em comparação com o Manus, que exige um código de convite, o OpenManus não exige nenhuma barreira de entrada, e os usuários só precisam clonar o código e configurar a API LLM para começar rapidamente. O projeto se baseia no desenvolvimento em Python, com uma estrutura simples e clara, dando suporte à entrada de tarefas por meio do terminal para que o corpo inteligente execute as operações. No momento, trata-se de uma implementação rudimentar, e a equipe está aberta a sugestões ou contribuições de código. Os planos futuros incluem otimizar o planejamento de tarefas e adicionar recursos de demonstração em tempo real.

Versão da interface OpenManus: https://github.com/YunQiAI/OpenManusWeb

OpenManusWeb (não oficial)

Lista de funções

- Operação da intelligentsia localExecutar operações automatizadas localmente usando as APIs LLM configuradas, inserindo tarefas por meio do terminal.

- Oferece suporte aos principais modelos de LLMO GPT-4o é integrado por padrão, e o usuário pode ajustar a configuração do modelo conforme necessário.

- partida com um toque: Executar

python main.pyVocê pode entrar rapidamente no modo de entrada de tarefas. - Versão experimental: Fornecido

python run_flow.pyUsado para testar novos recursos em desenvolvimento. - Colaboração comunitáriaApoio à participação no desenvolvimento do projeto, enviando problemas ou códigos pelo GitHub.

Usando a Ajuda

Processo de instalação

A instalação do OpenManus é simples e adequada para usuários familiarizados com Python. Veja a seguir as etapas detalhadas:

1. criando o ambiente Conda

Para evitar conflitos de dependência, é recomendável criar um ambiente autônomo usando o Conda:

conda create -n open_manus python=3.12

conda activate open_manus

- instruçõesO primeiro comando cria um arquivo chamado

open_manususando Python 3.12; o segundo comando ativa o ambiente, e o prompt do terminal muda para(open_manus). - pré-condiçõesConda: O Conda precisa ser instalado e pode ser baixado do site da Anaconda.

2. clonagem do repositório de código

Faça o download do projeto OpenManus no GitHub:

git clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus

- instruçõesO primeiro comando clona o código localmente e o segundo comando entra no diretório do projeto.

- pré-condiçõesGit: O Git precisa ser instalado, o que pode ser feito por meio de

git --versionVerifique se ele está disponível; caso contrário, faça o download em git-scm.com.

3. instalação de dependências

Instale os pacotes Python necessários para seu projeto:

pip install -r requirements.txt

- instruções::

requirements.txtlista todos os pacotes dependentes que serão instalados automaticamente ao executar esse comando. - otimização da redeSe o download estiver lento, você poderá usar um espelho doméstico, como

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple.

Etapas de configuração

O OpenManus exige que a API do LLM seja configurada para acionar a funcionalidade do smartbody, conforme descrito abaixo:

1. criação de arquivos de configuração

No diretório raiz do projeto do config para criar um arquivo de configuração:

cp config/config.example.toml config/config.toml

- instruçõesEsse comando copia o arquivo de exemplo como um arquivo de configuração real.

config.tomlé o arquivo lido em tempo de execução.

2. edição de arquivos de configuração

show (um ingresso) config/config.tomlPreencha sua chave de API e seus parâmetros:

# 全局 LLM 配置

[llm]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # 替换为你的 OpenAI API 密钥

max_tokens = 4096

temperature = 0.0

# 可选的视觉模型配置

[llm.vision]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # 替换为你的 OpenAI API 密钥

- Descrição do parâmetro::

modelEspecifica o modelo LLM, o padrão é GPT-4o.base_urlEndereço de acesso à API: o padrão é a interface oficial da OpenAI.api_keyChave: Chave obtida da OpenAI para autenticação.max_tokensNúmero máximo de geração única token número que controla o comprimento da saída.temperatureRandomização: controla a aleatoriedade do conteúdo gerado, sendo que 0,0 indica o resultado mais estável.

- Obtendo a chave da APIVisite o site da OpenAI, faça login e gere uma chave na página "API Keys" e copie-a para o seu arquivo de configuração.

Operação e uso

Após a conclusão da instalação e da configuração, o OpenManus pode ser iniciado das seguintes maneiras:

1. operações básicas

Execute o programa principal:

python main.py

- fluxo de trabalho::

- Depois que o terminal exibir o prompt, digite sua tarefa (por exemplo, "Help me generate a weekly plan").

- Pressione Enter para confirmar e o OpenManus chamará o LLM para processar a tarefa.

- Os resultados do processamento são exibidos diretamente no terminal.

- Cenários de usoIdeal para testes rápidos ou para executar tarefas simples, como gerar texto ou trechos de código.

2. execuções experimentais

Execute a versão instável para experimentar os novos recursos:

python run_flow.py

- especificidadesInclui recursos em desenvolvimento, pode ter bugs e é adequado para usuários que desejam experimentá-lo.

- tomar nota deVerifique se o arquivo de configuração está correto ou a execução poderá falhar.

Operação da função em destaque

Operação da intelligentsia local

- Descrição funcionalEntrada de uma tarefa pelo terminal e o OpenManus chama o LLM localmente para processá-la e retornar o resultado.

- Exemplo de operação::

- estar em movimento

python main.py. - Entrada: "Escreva uma função Python que calcule a soma de 1 a 100".

- Exemplo de saída:

def sum_to_100(): return sum(range(1, 101))

- estar em movimento

- de pontaExecuta localmente sem fazer upload de dados, protege a privacidade e é responsivo.

Oferece suporte aos principais modelos de LLM

- Descrição funcionalOs usuários podem alternar entre diferentes modelos de LLM de acordo com suas necessidades.

- procedimento::

- compilador

config.tomlvontademodelMudar para outro modelo (por exemplo"gpt-3.5-turbo"). - Salvar e executar

python main.py. - Tarefas de entrada para experimentar o resultado de diferentes modelos.

- compilador

- sugestãoO GPT-4o para tarefas complexas e o GPT-3.5-turbo para tarefas simples são mais econômicos.

Perguntas frequentes

- problemasErro de execução: É executado com o erro "ModuleNotFoundError".

- tackleVerificar se as dependências estão totalmente instaladas e executar novamente

pip install -r requirements.txt.

- tackleVerificar se as dependências estão totalmente instaladas e executar novamente

- problemas: "Chave de API inválida".

- tackle: Inspeção

config.tomlacertou em cheioapi_keyestiver correto ou regenerar a chave.

- tackle: Inspeção

- problemasFunciona de forma gaguejada ou sem resposta.

- tackleVerifique se a conexão de rede está estável ou reduza o número de conexões.

max_tokenspara reduzir a quantidade de cálculos. - Ver demonstraçãoProjetos fornecem Vídeo de demonstraçãodemonstrando os resultados operacionais reais.

- tackleVerifique se a conexão de rede está estável ou reduza o número de conexões.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...