A OpenAI lança uma nova geração de APIs de modelo de áudio, uma grande atualização na tecnologia de interação por voz

A OpenAI anunciou recentemente o lançamento de sua nova geração de APIs de modelagem de áudio, projetada para capacitar os desenvolvedores a criar assistentes de voz mais avançados e inteligentes. Essa iniciativa é vista como um grande avanço no campo da tecnologia de interação por voz, sinalizando que a interação por voz entre humanos e computadores dará início a uma nova fase, mais natural e eficiente.

O lançamento inclui duas atualizações importantes: um modelo de fala para texto mais avançado e um modelo de texto para fala mais expressivo, que, segundo a OpenAI, estabelece um novo padrão de precisão e confiabilidade, especialmente em cenários desafiadores com sotaques complexos, ambientes ruidosos e velocidades de fala variadas. As melhorias de desempenho são particularmente significativas em cenários desafiadores, como sotaques complexos, ambientes ruidosos e velocidades de fala variáveis. Isso significa que o novo modelo melhorará consideravelmente a qualidade e a eficiência da transcrição em aplicativos como centrais de atendimento ao cliente e transcrição de atas de reuniões.

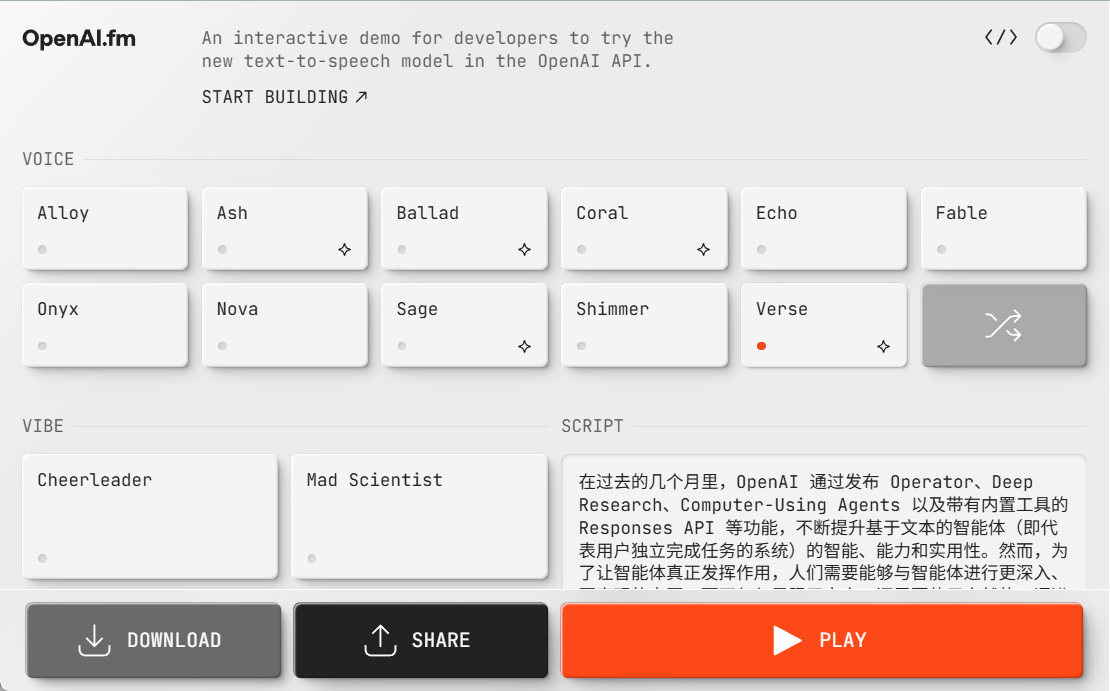

Em especial, pela primeira vez, a OpenAI permite que os desenvolvedores instruam os modelos de conversão de texto em fala a falar de uma maneira específica. Por exemplo, os desenvolvedores podem configurar o modelo para "falar como um agente de atendimento ao cliente empático", oferecendo aos assistentes de voz um escopo de personalização sem precedentes. Esse recurso abre novas portas para uma variedade de cenários, desde um atendimento ao cliente mais humano até uma narrativa criativa mais expressiva.

A OpenAI lançou seu primeiro modelo de áudio, o Whisper, em 2022 e, desde então, continua investindo no aprimoramento da inteligência, da precisão e da confiabilidade do modelo. O lançamento de um novo modelo de áudio é o ponto culminante desse esforço de longa data. Os desenvolvedores agora podem criar sistemas de conversão de fala em texto mais precisos, bem como sons de conversão de texto em fala mais distintos e vívidos por meio da API.

Uma nova geração de modelos de fala para texto: gpt-4o-transcribe e gpt-4o-mini-transcribe

A OpenAI lançou dois novos modelos, gpt-4o-transcribe e gpt-4o-mini-transcribe, que são modelos mais novos que os anteriores. Sussurro eles mostram melhorias significativas na taxa de erro de palavras (WER), no reconhecimento de idiomas e na precisão.

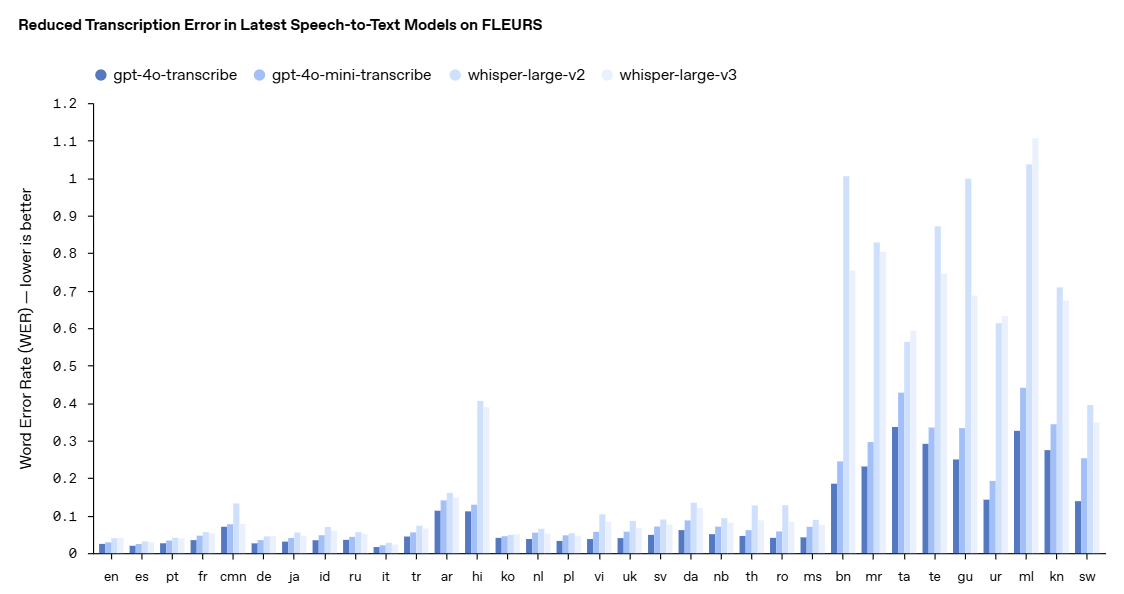

- A taxa de erro de palavras (WER) mede a precisão de um modelo de reconhecimento de fala calculando a porcentagem de palavras transcritas incorretamente em comparação com uma transcrição de referência - quanto menor a WER, melhor, menos erros. Nosso modelo mais recente de conversão de fala em texto atinge baixo WER em vários benchmarks, incluindo o FLEURS (Learning Evaluation of Speech Universal Representation with Small Samples), um benchmark de fala multilíngue que abrange mais de 100 idiomas usando amostras de áudio transcritas manualmente. Esses resultados demonstram maior precisão de transcrição e maior cobertura de idiomas. Como mostrado aqui, nosso modelo supera consistentemente o Whisper v2 e o Whisper v3 em todas as avaliações de idiomas.

O gpt-4o-transcribe demonstrou que a taxa de erro de palavras supera o desempenho do modelo Whisper em uma série de referências confiáveis. A taxa de erro de palavras é uma medida fundamental da precisão de um modelo de reconhecimento de fala, com valores mais baixos representando menos erros, e a OpenAI afirma que essas melhorias resultam de inovações direcionadas no aprendizado de reforço e treinamento provisório em larga escala usando conjuntos de dados de áudio diversos e de alta qualidade.

Como resultado, os novos modelos de fala para texto são mais capazes de capturar nuances de fala, reduzir erros de reconhecimento e melhorar a confiabilidade da transcrição, especialmente ao lidar com situações complexas, como sotaques, ambientes ruidosos e velocidades de fala variadas. Atualmente, esses modelos estão abertos para uso na API de fala para texto.

Para demonstrar a melhoria de desempenho de forma mais visual, a OpenAI cita o FLEURS (Few-shot Learning Evaluation of Universal Resultados do benchmark Representations of Speech (FLEURS), um benchmark de fala multilíngue que abrange mais de 100 idiomas usando amostras de áudio transcritas manualmente. Os resultados mostram que o novo modelo da OpenAI tem taxas de erro de palavras mais baixas do que o Whisper v2 e o Whisper v3 em avaliações entre idiomas, demonstrando maior precisão de transcrição e cobertura mais ampla de idiomas.

Uma nova geração de modelos de conversão de texto em fala: gpt-4o-mini-tts

Além do modelo de fala para texto, a OpenAI também apresentou o novo modelo de texto para fala gpt-4o-mini-tts, cujo destaque é sua maior capacidade de controle. Os desenvolvedores podem não apenas controlar o que o modelo diz, mas também instruir o modelo sobre como dizer. Esse recurso proporciona mais personalização à experiência do usuário, com aplicações que vão desde o atendimento ao cliente até o conteúdo criativo. O modelo também está disponível na API Text-to-Speech. Observe que esses modelos de conversão de texto em fala estão atualmente limitados a vozes sintetizadas predefinidas, que a OpenAI monitora para garantir que sejam consistentes com as predefinições sintetizadas.

Veja uma rápida amostra do gpt-4o-mini-tts aqui!

https://www.openai.fm/

A inovação tecnológica por trás do modelo

A OpenAI revela que os novos modelos de áudio foram desenvolvidos com base nas arquiteturas GPT-4o e GPT-4o-mini e foram pré-treinados em escala usando conjuntos de dados especificamente voltados para áudio, o que é fundamental para otimizar o desempenho do modelo. Essa abordagem direcionada permite que os modelos compreendam mais profundamente as sutilezas da fala e se sobressaiam em uma variedade de tarefas relacionadas ao áudio.

Além disso, a OpenAI aprimorou suas técnicas de refinamento de conhecimento para permitir a transferência de conhecimento de modelos de áudio grandes para modelos pequenos e eficientes. Ao aproveitar métodos avançados de autojogo, seu conjunto de dados de refinamento captura com eficácia a dinâmica real do diálogo e replica cenários reais de interação entre usuário e assistente. Isso ajuda o modelo pequeno a oferecer excelente qualidade de diálogo e capacidade de resposta.

Para a modelagem de fala para texto, a OpenAI adotou um paradigma baseado em aprendizado por reforço (RL) para elevar a precisão da transcrição a um novo patamar. Essa abordagem melhora significativamente a precisão e reduz a alucinação, tornando sua solução de fala para texto mais competitiva em cenários complexos de reconhecimento de fala.

Esses avanços tecnológicos representam o mais recente progresso no campo da modelagem de áudio, no qual a OpenAI combina abordagens inovadoras com aprimoramentos práticos destinados a melhorar o desempenho dos aplicativos de fala.

Abertura da API e perspectivas futuras

Esses novos modelos de áudio já estão disponíveis para todos os desenvolvedores. Para os desenvolvedores que já estão usando modelos de texto para criar experiências de diálogo, a integração de modelos de fala para texto e de texto para fala é a maneira mais fácil de criar assistentes de voz, e a OpenAI também lançou a integração com o SDK de agentes para simplificar o processo de desenvolvimento. Para os desenvolvedores que desejam criar experiências de fala para fala de baixa latência, a OpenAI recomenda o uso dos modelos de fala para fala na API Realtime.

No futuro, a OpenAI planeja continuar a investir mais na inteligência e na precisão de seus modelos de áudio e explorar maneiras de permitir que os desenvolvedores introduzam sons personalizados para criar experiências mais personalizadas e, ao mesmo tempo, garantir a conformidade com seus padrões de segurança. Além disso, a OpenAI está dialogando ativamente com legisladores, pesquisadores, desenvolvedores e criadores sobre os desafios e as oportunidades que o som sintetizado pode apresentar. A OpenAI está entusiasmada com os aplicativos inovadores que os desenvolvedores criarão usando esses recursos de áudio aprimorados e diz que continuará a investir em outras modalidades, incluindo vídeo, para dar suporte aos desenvolvedores na criação de experiências inteligentes multimodais.

O lançamento de uma nova geração de APIs de modelo de áudio pela OpenAI, sem dúvida, injetou uma nova vitalidade no desenvolvimento da tecnologia de interação por voz. Com o progresso contínuo da tecnologia e os cenários de aplicativos cada vez mais ricos, temos motivos para acreditar que o futuro do mundo digital se tornará mais "capaz de ouvir e falar", e a interação humano-computador será mais natural e suave.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...