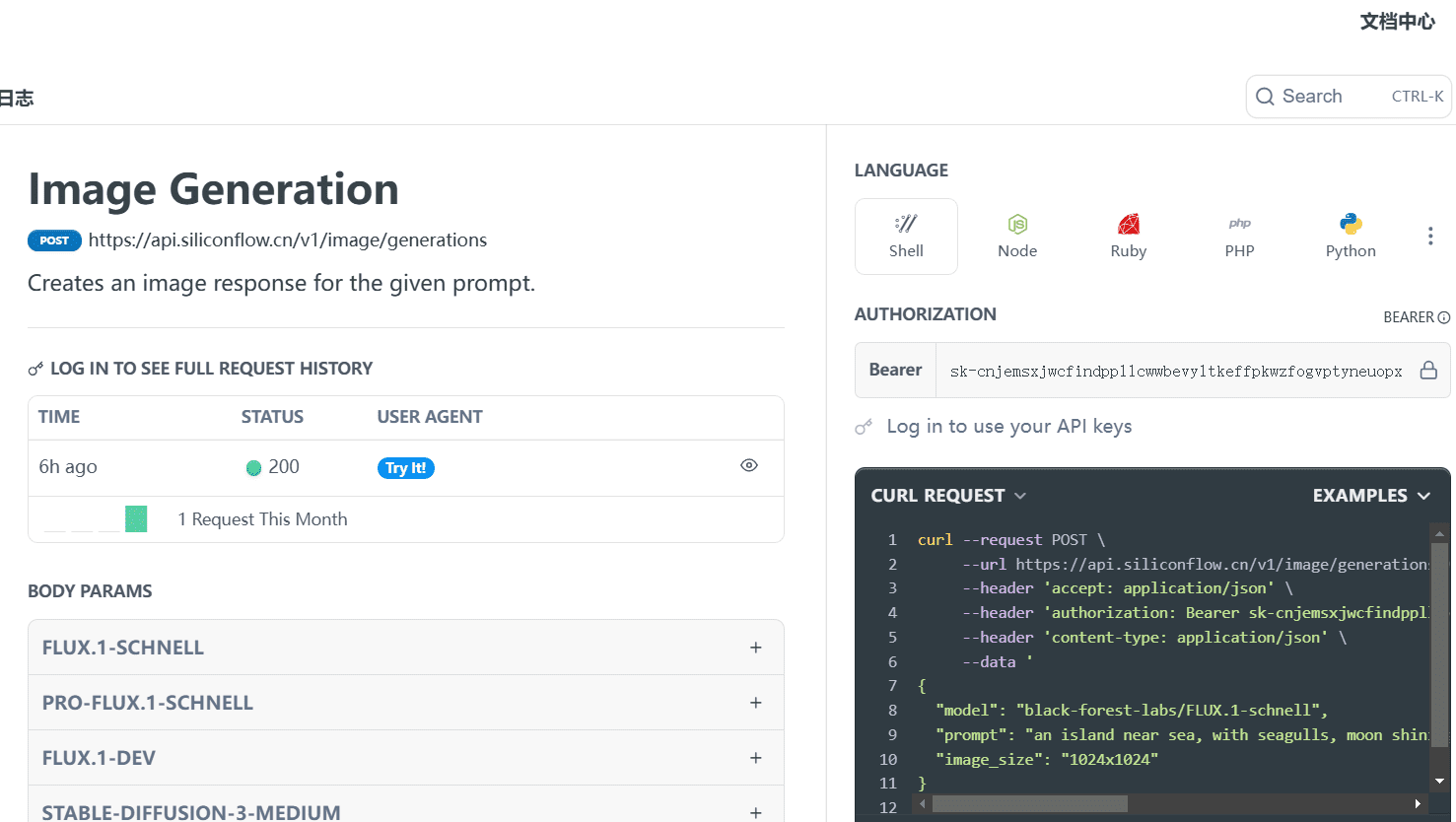

Instalação e configuração do Ollama - artigo do docker

breve

Esta seção ensina como concluir o processo do Docker Ollama A instalação e a configuração do

O Docker é uma tecnologia de contêineres virtualizados que se baseia em imagens e pode iniciar vários contêineres em segundos. Cada um desses contêineres é um ambiente de tempo de execução completo que permite o isolamento entre os contêineres.

Ollama Download: https://ollama.com/download

Página inicial oficial da Ollama: https://ollama.com

Repositório oficial de código-fonte do GitHub da Ollama: https://github.com/ollama/ollama/

Tutorial oficial de instalação do Docker: https://hub.docker.com/r/ollama/ollama

I. Puxando o espelho de Ollama

O autor fez o download prévio do docker no Windows 👉.download da instalação do docker site oficial

Caminho 1: Pesquisa e download de software do Docker na interface de visualização

Caminho 2: o site oficial recomenda usar diretamente o seguinte comando para extrair a imagem de download; esse projeto pode ser executado somente na CPU.

# CPU 或者 Nvidia GPU

docker pull ollama/ollama

# AMD GPU

docker pull ollama/ollama:rocm

Observação: se o leitor quiser usar uma versão específica da imagem que especifique o ambiente de tempo de execução, o seguinte comando poderá ser usado.

# CPU 或 Nvidia GPU下载ollama 0.3.0

docker pull ollama/ollama:0.3.0

# AMD GPU下载ollama 0.3.0

docker pull ollama/ollama:0.3.0-rocm

II. Executando a imagem ollama

Maneira 1: o Docker executa a imagem em uma interface visual

- Quando o download estiver concluído, ele poderá ser encontrado na seção

Imagesacertou em cheioOllamaEspelho, cliquerunObserve que, antes de executar, selecione um número de porta (por exemplo, 8089) na janela pop-up de configurações opcionais.

- existir

ContainersEncontre o espelho noOLLMAcesso à interface Ollama

- Verifique se a instalação está concluída, na seção

ExecEntre em:

ollama -h

O resultado é o seguinte: isso significa que a instalação foi bem-sucedida🎉.

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

- Terminal Use Ollama.

A seguir estão os comandos comuns usados pelo Ollama:

ollama serve #启动ollama

ollama create #从模型文件创建模型

ollama show #显示模型信息

ollama run #运行模型

ollama pull #从注册表中拉取模型

ollama push #将模型推送到注册表

ollama list #列出模型

ollama cp #复制模型

ollama rm #删除模型

ollama help #获取有关任何命令的帮助信息

library (ollama.com) Aqui está a biblioteca de modelos da Ollama, procure o modelo que você deseja e inicie-o diretamente!

ollama run llama3

A velocidade de download depende de sua largura de banda e está pronta para ser usada ✌Lembre-se de usar o

control + DSair do bate-papo

Maneira 2: inicialização por linha de comando

- Versão da CPU:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...