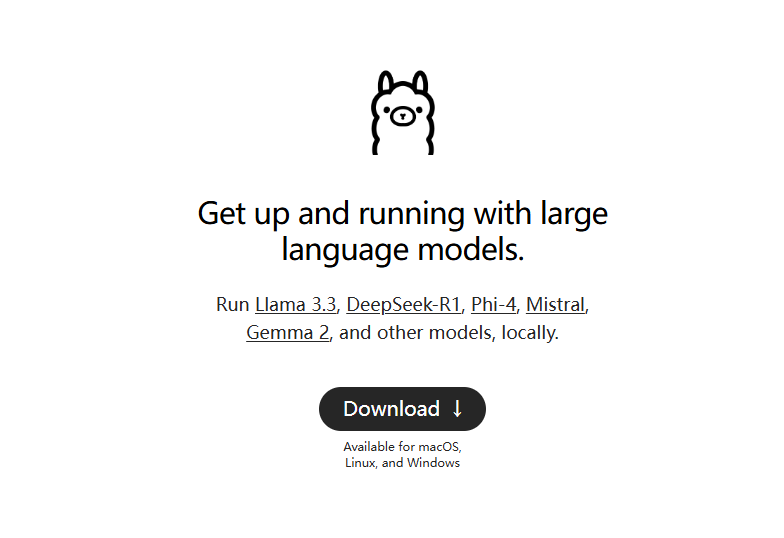

Ollama: Implementação nativa de modelos de linguagem grande de código aberto com um clique

Introdução geral de Ollama

O ollama é uma estrutura leve para a execução de modelos de idiomas nativos, permitindo que os usuários criem e executem facilmente modelos de idiomas grandes. Ele oferece várias opções de início rápido e instalação, é compatível com o Docker e inclui um rico conjunto de bibliotecas para os usuários escolherem. É fácil de usar, fornece uma API REST e tem uma variedade de plug-ins e extensões que se integram à comunidade.

O ollama é uma ferramenta de linha de comando pura para computadores pessoais, recomendada para a implantação de interfaces de bate-papo locais, como: Open WebUI, Lobe Chat, NextChat.

Modifique o diretório de instalação padrão: https://github.com/ollama/ollama/issues/2859

Lista de recursos do Ollama

Como colocar modelos de idiomas grandes em funcionamento rapidamente

Suporte a sistemas macOS, Windows e Linux

Fornece bibliotecas como ollama-python, ollama-js, etc.

Incluindo o Llama 2. MistralModelo pré-construído de Gemma et al.

Oferece suporte a instalações locais e do Docker

Fornecer funcionalidade de modelo personalizado

Suporte para conversão de modelos do GGUF e do PyTorch

Fornecer um guia de operação da CLI

Fornecer suporte à API REST

Comandos de ollama comumente usados

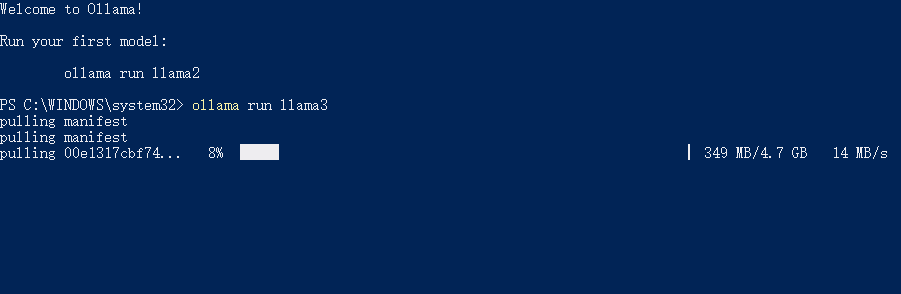

Modelo pull: ollama pull llama3.1

Modelo em execução: llama run llama3.1

Excluir modelo: llama rm llama3.1

Lista de todos os modelos disponíveis: lista de ollama

Consultar o endereço do serviço da API: ollama serve (padrão: http://localhost:11434/)

Ajuda da Ollama

Scripts e guias de instalação disponíveis no site da ollama e na página do GitHub

Instalação usando a imagem do Docker fornecida

Criação, extração, remoção e cópia de modelos por meio de operações de CLI

Inicialização e execução de uma compilação local

Executar o modelo e interagir com ele

Alguns dos modelos suportados pela Ollama

| Modelo | Parâmetros | Tamanho | Baixar |

|---|---|---|---|

| Lhama 2 | 7B | 3,8 GB | ollama run llama2 |

| Mistral | 7B | 4,1 GB | ollama run mistral |

| Dolphin Phi | 2.7B | 1,6 GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1,7 GB | ollama run phi |

| Bate-papo neural | 7B | 4,1 GB | ollama run neural-chat |

| Starling | 7B | 4,1 GB | ollama run starling-lm |

| Código Llama | 7B | 3,8 GB | ollama run codellama |

| Llama 2 sem censura | 7B | 3,8 GB | ollama run llama2-uncensored |

| Lhama 2 13B | 13B | 7,3 GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39 GB | ollama run llama2:70b |

| Orca Mini | 3B | 1,9 GB | ollama run orca-mini |

| Vicunha | 7B | 3,8 GB | ollama run vicuna |

| LLaVA | 7B | 4,5 GB | ollama run llava |

| Gemma | 2B | 1,4 GB | ollama run gemma:2b |

| Gemma | 7B | 4,8 GB | ollama run gemma:7b |

Download do Ollama

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...