MuseV+Muse Talk: Estrutura completa de geração de vídeo humano digital | Retrato para vídeo | Pose para vídeo | Sincronização labial

Introdução geral

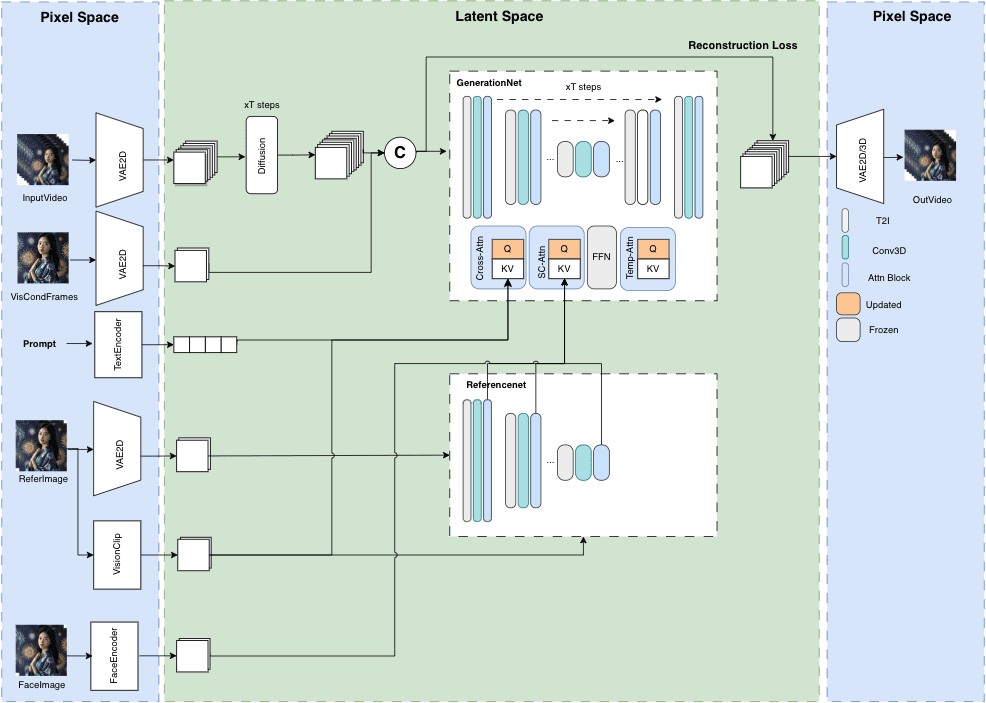

O MuseV é um projeto público no GitHub que visa à geração de vídeos de avatar com duração ilimitada e alta fidelidade. Ele se baseia na tecnologia de difusão e oferece vários recursos, como Image2Video, Text2Image2Video, Video2Video e outros. São fornecidos detalhes da estrutura do modelo, casos de uso, guia de início rápido, scripts de inferência e agradecimentos.

O MuseV é uma estrutura de geração de vídeo humano virtual baseada em um modelo de difusão com os seguintes recursos:

Ele suporta a geração de comprimento infinito usando um novo esquema de redução de ruído paralelo condicional visual sem o problema de acúmulo de erros, especialmente para cenas com posições fixas de câmera.

É fornecido um modelo pré-treinado para geração de vídeo de avatar treinado em um conjunto de dados de tipo de personagem.

Oferece suporte à geração de imagem para vídeo, texto para imagem para vídeo e vídeo para vídeo.

Compatível com o ecossistema de geração de gráficos da Stable Diffusion, incluindo base_model, lora, controlnet e muito mais.

Suporte a várias tecnologias de imagens de referência, incluindo IPAdapter, ReferenceOnly, ReferenceNet, IPAdapterFaceID.

Também lançaremos o código de treinamento mais tarde.

Lista de funções

Geração de vídeos com duração ilimitada

Imagens humanas virtuais de alta fidelidade

Suporte versátil: Image2Video, Text2Image2Video, Video2Video

Estrutura clara do modelo e casos de uso

Início rápido e scripts de raciocínio

Usando a Ajuda

Visite os repositórios do GitHub para obter atualizações e recursos para download

Siga o Guia de Início Rápido para a configuração inicial do projeto

Use os scripts de inferência fornecidos para gerar conteúdo de vídeo

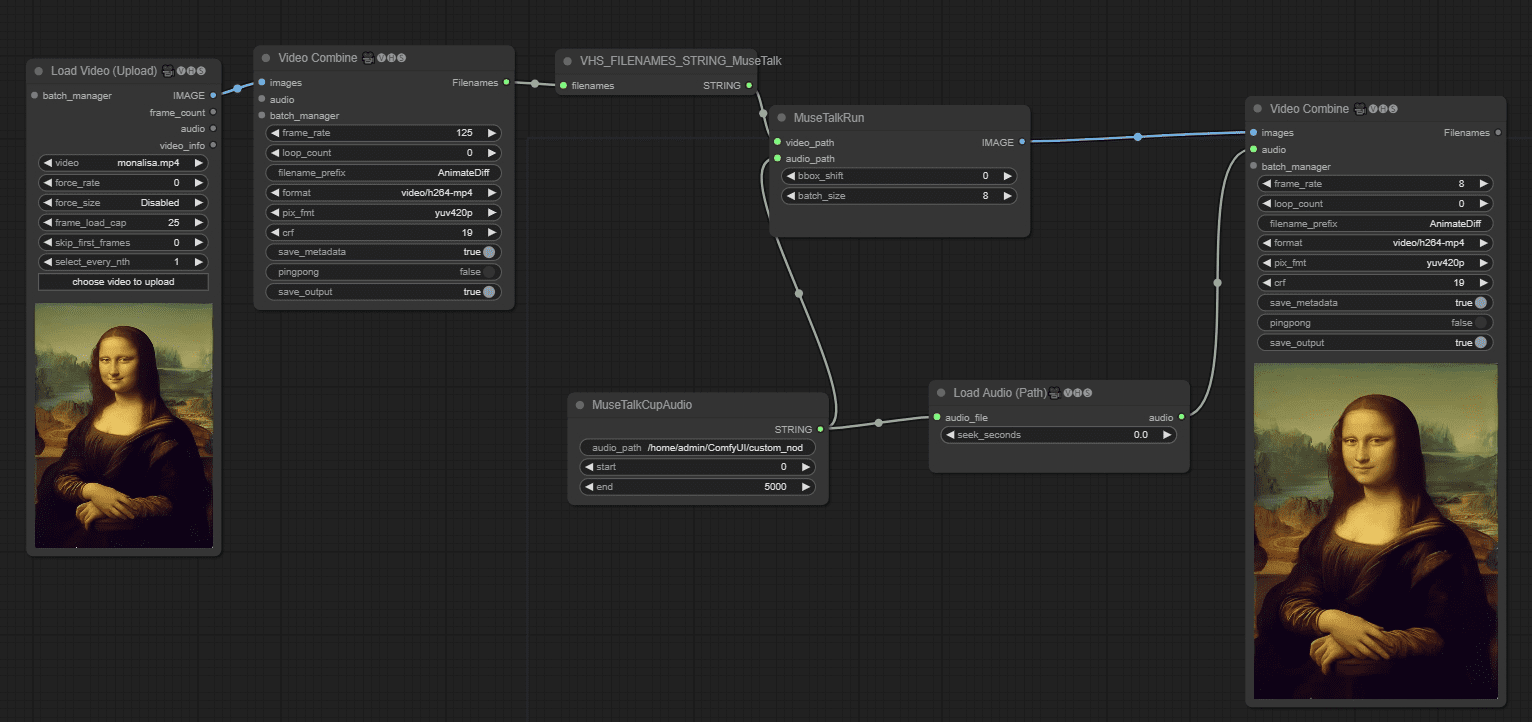

Método de uso combinado:

Método 1: Gravação de vídeo ao vivo + Muse Talk

Método 2: Imagem + MuseV + Muse Talk

um produto acabado

Em um vídeo em loop de imagem estática, faça o personagem de anime falar; os lábios do personagem de desenho animado não estão presentes, o que torna a fala estranha; da próxima vez, você deve alterar a imagem com "lábios", de preferência com "pessoas reais". 45 segundos do vídeo oficial Aguarde cerca de 15 minutos para o ambiente de teste.

Como fazer o vídeo falar nos fluxos de trabalho do ComfyUI

Lançamos MuseTalk O MuseTalk é um modelo de sincronização de boca de alta qualidade e em tempo real (30 fps+ no NVIDIA Tesla V100). O MuseTalk pode ser aplicado com vídeo de entrada, como o gerado pelo MuseV, como uma solução completa de avatar.

MuseV Online Experience / Pacote de instalação com um clique para Windows

Experiência on-line do MuseTalk

O modelo de sincronização de boca do MuseV MuseTalk

Link: https://pan.quark.cn/s/ed896ceda5c8

Código de extração: JygA

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...