Vídeo MOFA: a tecnologia de adaptação de campo de movimento converte imagens estáticas em vídeo

Introdução geral

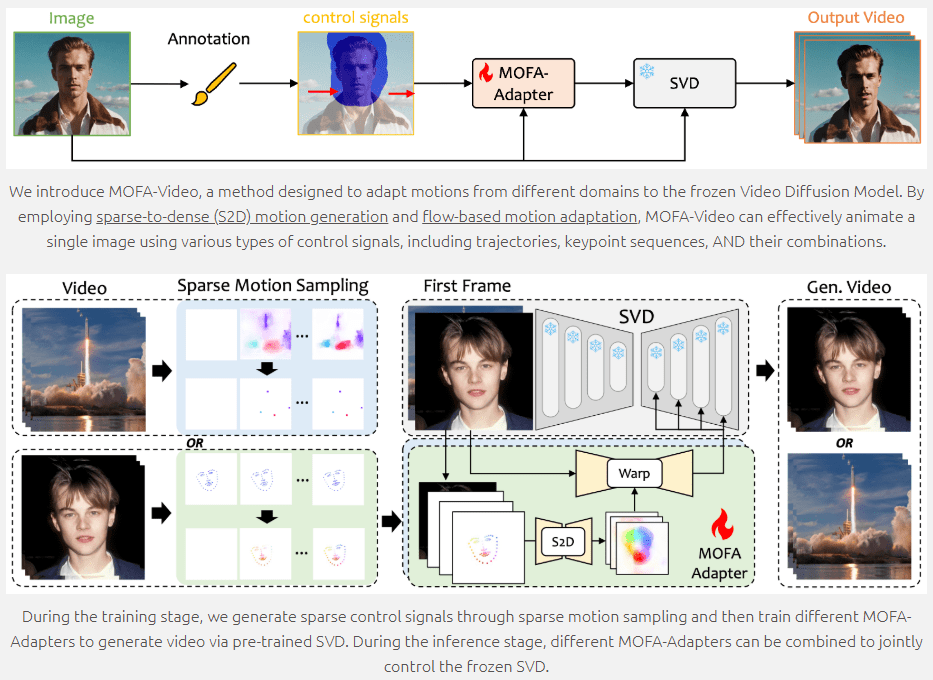

O MOFA-Video é uma ferramenta de geração de animação de imagens de última geração que utiliza técnicas generativas de adaptação de campo de movimento para converter imagens estáticas em vídeo dinâmico. Desenvolvido em colaboração com a Universidade de Tóquio e o Tencent AI Lab, e a ser apresentado no ECCV 2024, o MOFA-Video é compatível com uma variedade de sinais de controle, incluindo trajetórias, sequências de pontos-chave e suas combinações, permitindo a animação de imagens de alta qualidade. Os usuários podem acessar o código e os recursos relacionados por meio do repositório do GitHub para começar facilmente.

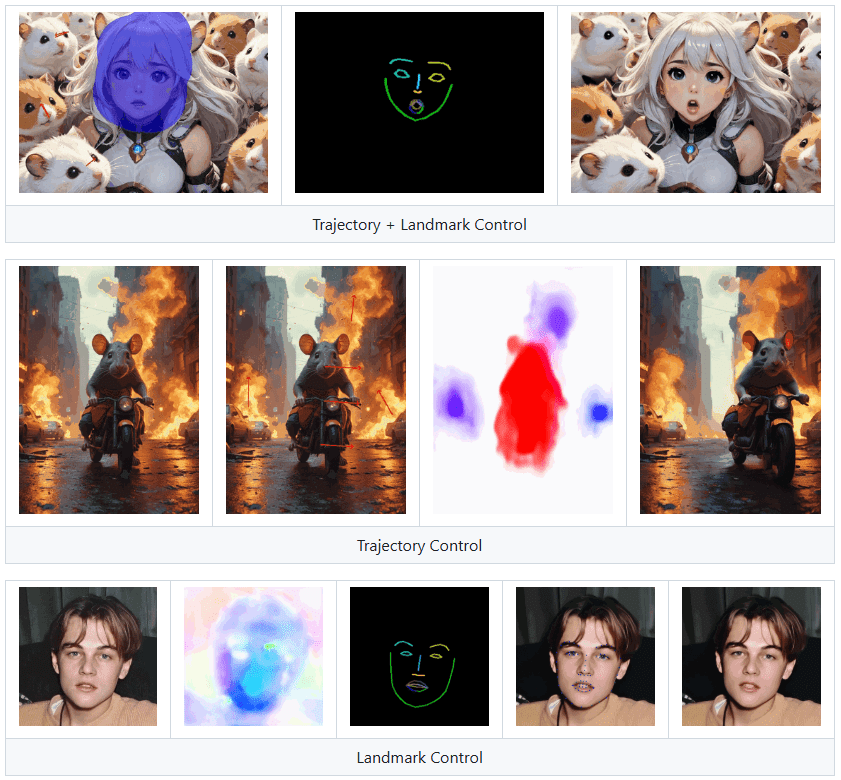

O Landmark Control pode fazer com que pessoas em imagens falem, mas não é adequado para ser usado como clone de uma pessoa digital.

Lista de funções

- Image Animation Generation: Converte imagens estáticas em vídeo em movimento

- Vários sinais de controle: suporta trajetórias, sequências de pontos-chave e suas combinações

- Adaptação do campo de movimento: animação por meio de geração de movimento esparso a denso e adaptação de movimento baseada em fluxo

- Scripts de treinamento e inferência: fornecimento de código completo para treinamento e inferência

- Demonstração do Gradio: Demonstração on-line e download do ponto de verificação

- Código aberto: tornar o código e os recursos disponíveis publicamente no GitHub

Usando a Ajuda

Configurações ambientais

- armazém de clones

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

- Criar e ativar um ambiente Conda

conda create -n mofa python==3.10

conda activate mofa

- Instalação de dependências

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

- Faça o download dos pontos de verificação Faça o download dos pontos de verificação do repositório HuggingFace e coloque-os na pasta

./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpointsCatálogo.

Demonstração com o Gradio

- Uso de áudio para impulsionar a animação facial

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

- Como conduzir a animação facial com vídeo de referência

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

A interface do Gradio exibirá as instruções relevantes, portanto, siga as instruções na interface para realizar a operação de raciocínio.

Treinamento e raciocínio

O MOFA-Video fornece scripts completos de treinamento e inferência, que podem ser personalizados conforme necessário. Para obter instruções detalhadas, consulte o arquivo README no repositório do GitHub.

Funções principais

- Geração de animação de imagem: Carregue uma imagem estática, selecione os sinais de controle (trajetória, sequência de pontos-chave ou uma combinação deles) e clique no botão Generate (Gerar) para gerar um vídeo dinâmico.

- Vários sinais de controle: os usuários podem escolher diferentes combinações de sinais de controle para obter efeitos de animação mais ricos.

- Adaptação do campo de movimento: garanta efeitos de animação suaves e naturais por meio de geração de movimento esparso a denso e técnicas de adaptação de movimento baseadas em fluxo.

O MOFA-Video oferece funções avançadas e instruções detalhadas para que os usuários possam gerar animações de imagens e personalizar o treinamento de acordo com suas necessidades, além de obter facilmente efeitos de animação de imagens de alta qualidade.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...