Introdução geral

A CLI do provedor de contexto de modelo (mcp-cli) é uma ferramenta de linha de comando em nível de protocolo para interagir com servidores de provedores de contexto de modelo. A ferramenta permite que os usuários enviem comandos, consultem dados e interajam com uma variedade de recursos fornecidos pelo servidor. A mcp-cli oferece suporte a vários provedores e modelos, incluindo OpenAI e Ollama, com os modelos padrão sendo gpt-4o-mini e qwen2.5-coder, respectivamente. A ferramenta requer Python 3.8 ou superior e as dependências dependências apropriadas. Você pode usar a ferramenta clonando o repositório do GitHub e instalando as dependências necessárias.

Lista de funções

- Suporte para comunicação em nível de protocolo com servidores de provisionamento de contexto de modelo

- Ferramentas e recursos dinâmicos para explorar

- Suporte a vários provedores e modelos (OpenAI e Ollama)

- Fornece um modo interativo que permite aos usuários executar comandos dinamicamente

- Os comandos suportados incluem: ping, list-tools, list-resources, list-prompts, chat, clear, help, quit/exit

- Os parâmetros de linha de comando compatíveis incluem: --server, --config-file, --provider, --model

Usando a Ajuda

Processo de instalação

- Armazém de Clonagem:

git clone https://github.com/chrishayuk/mcp-cli

cd mcp-cli

- Instalar UV:

pip install uv

- Sincronização de dependências:

uv sincronização --reinstalação

Uso

- Inicie o cliente e interaja com o servidor SQLite:

uv run main.py --server sqlite

- Execute o cliente com o provedor e o modelo padrão da OpenAI:

uv run main.py --server sqlite

- Usando configurações específicas e Ollama O provedor executa o cliente:

uv run main.py --server sqlite --provider ollama --model llama3.2

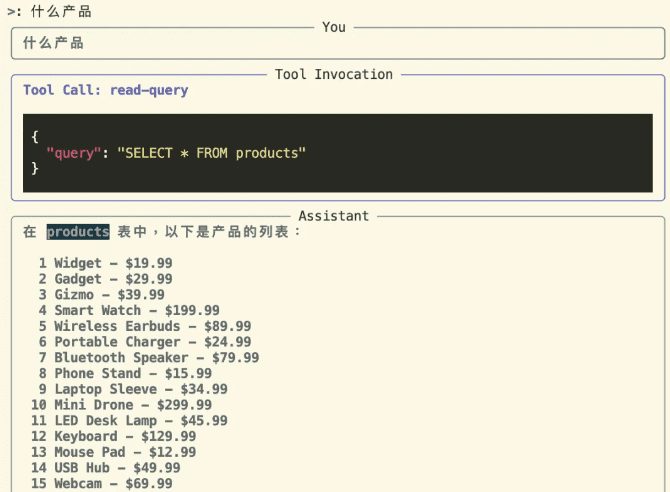

modo interativo

Entre no modo interativo e interaja com o servidor:

uv run main.py --server sqlite

No modo interativo, você pode usar a ferramenta e interagir com o servidor. O provedor e o modelo especificados na inicialização serão exibidos da seguinte forma:

Entrando no modo de bate-papo usando o provedor 'ollama' e o modelo 'ollama3.2'...

Comandos suportados

ping (computação)Verificar se o servidor está respondendoFerramentas de listaMostrar ferramentas disponíveislista de recursosMostrar recursos disponíveislista-promptsMostrar dicas disponíveisbate-papoBate-papo interativo: Entre no modo de bate-papo interativoclaroLimpar a tela do terminalajudaExibe uma lista de comandos suportadossair/saídaSair do cliente

Uso de provedores OpenAI

Se quiser usar um modelo OpenAI, você deve definir o parâmetro OPENAI_API_KEY que pode ser encontrada na variável de ambiente .env ou definido como uma variável de ambiente.