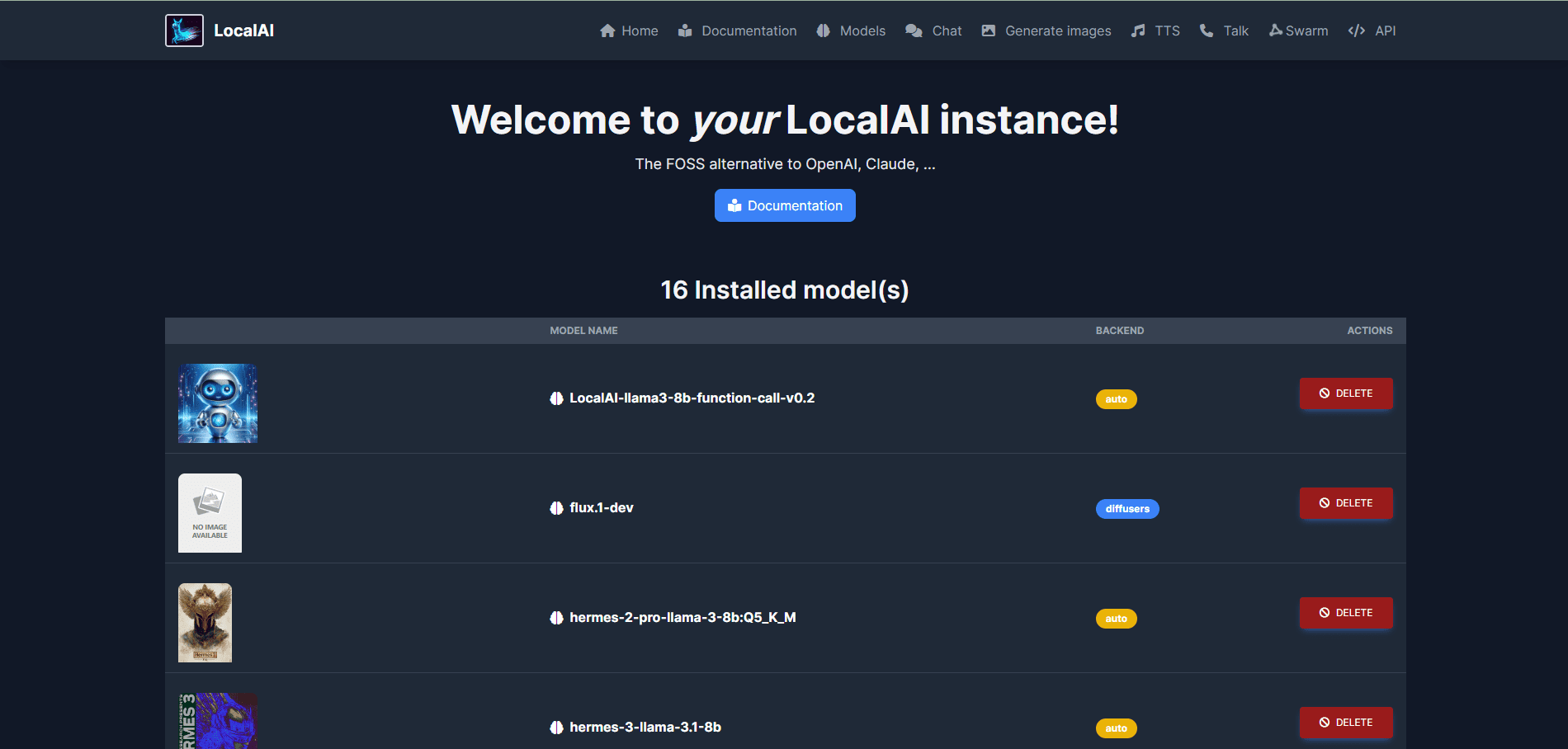

LocalAI: soluções de implementação de IA local de código aberto, suporte para várias arquiteturas de modelo, gerenciamento unificado de modelos e APIs na WebUI

Introdução geral

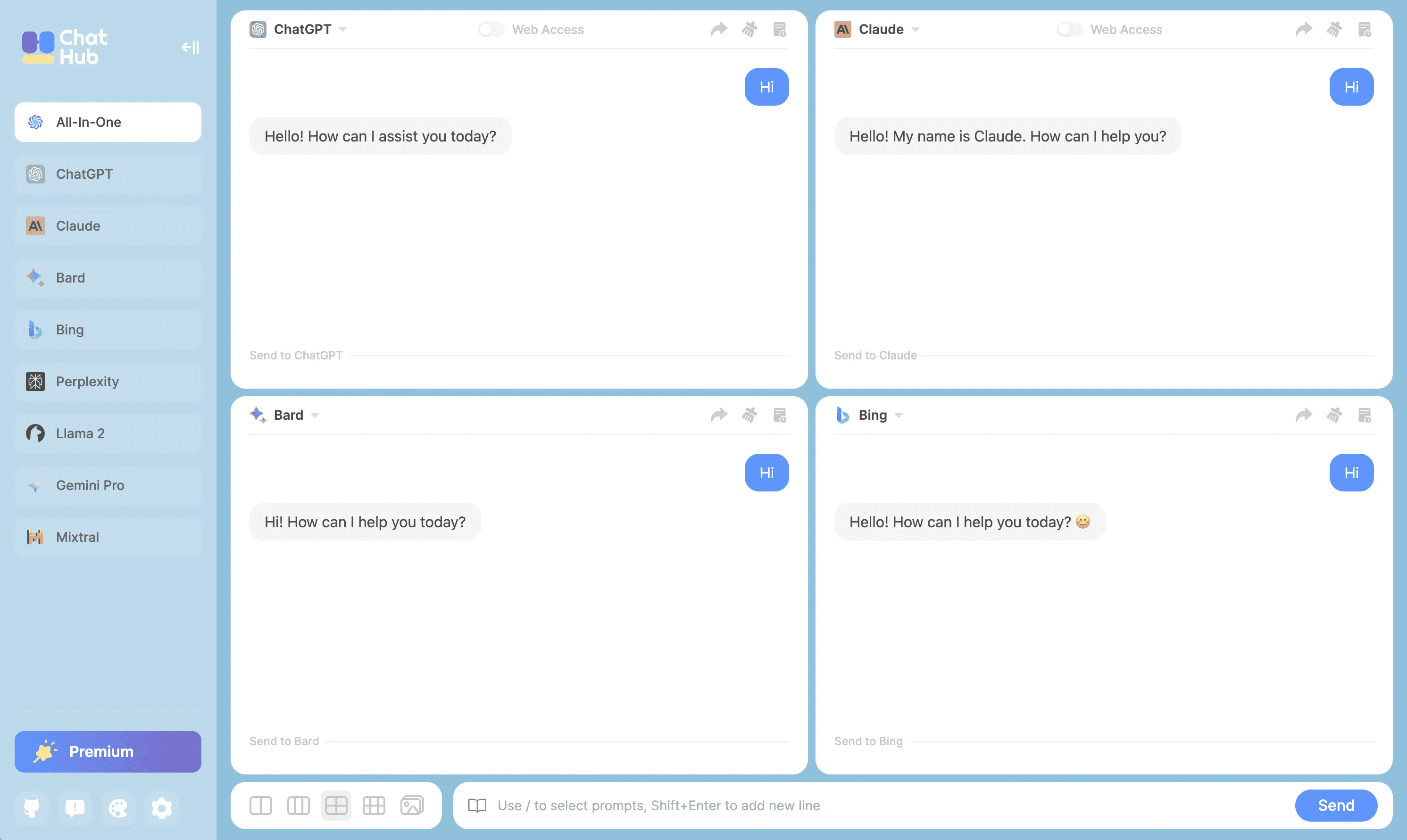

O LocalAI é uma alternativa de IA local de código aberto que visa fornecer interfaces de API compatíveis com o OpenAI, Claude e outros. O LocalAI foi criado e é mantido por Ettore Di Giacinto e oferece suporte a uma ampla gama de arquiteturas de modelos, incluindo gguf, transformadores, difusores e muito mais para implantações locais ou no local.

Lista de funções

- Geração de texto: suporta a série de modelos GPT, capaz de gerar conteúdo de texto de alta qualidade.

- Geração de áudio: gere uma voz natural e suave por meio da função texto para áudio.

- Geração de imagens: imagens de alta qualidade são geradas usando um modelo de difusão estável.

- Clonagem de fala: gere uma fala semelhante à voz original por meio da tecnologia de clonagem de fala.

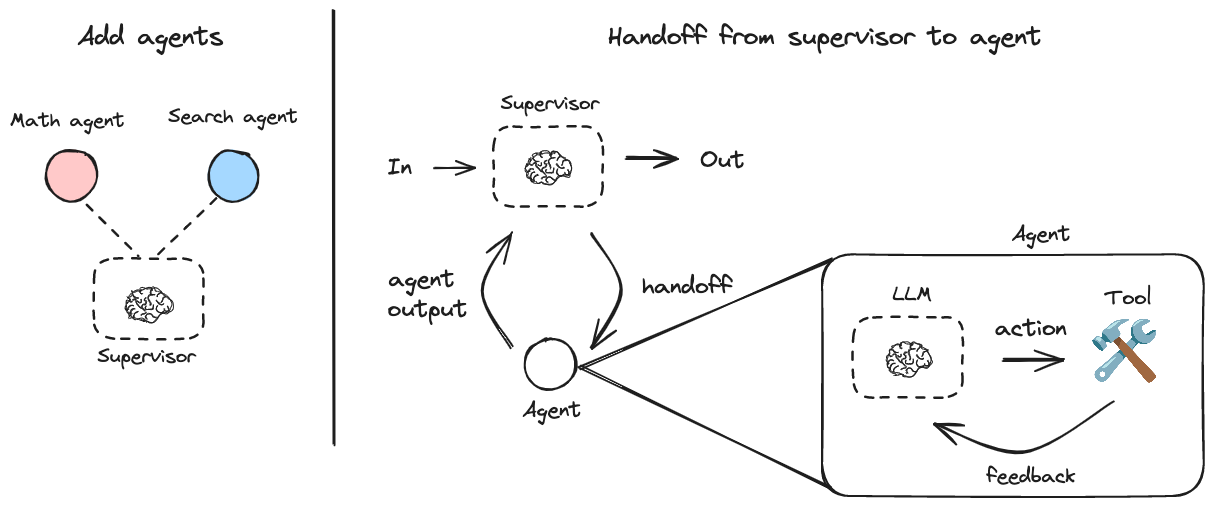

- Raciocínio distribuído: suporta raciocínio P2P para melhorar a eficiência do raciocínio de modelos.

- Download de modelos: Faça o download e execute modelos diretamente de plataformas como a Huggingface.

- WebUI integrada: fornece uma interface de usuário integrada na Web para facilitar a operação.

- Geração de incorporação de banco de dados vetorial: oferece suporte à geração de incorporação de banco de dados vetorial.

- Sintaxe restrita: suporte à geração de conteúdo de texto com sintaxe restrita.

- API de visão: fornece funções de processamento e análise de imagens.

- API de reordenação: suporta reordenação e otimização de conteúdo de texto.

Processo de instalação

- Uso de scripts de instalação::

- Execute o seguinte comando para baixar e instalar o LocalAI:

curl -s https://localai.io/install.sh | sh

- Execute o seguinte comando para baixar e instalar o LocalAI:

- Usando o Docker::

- Se não houver GPU, execute o seguinte comando para iniciar o LocalAI:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu - Se você tiver uma GPU Nvidia, execute o seguinte comando:

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12

- Se não houver GPU, execute o seguinte comando para iniciar o LocalAI:

Processo de uso

- Iniciar a LocalAI::

- Depois de iniciar o LocalAI por meio do processo de instalação descrito acima, acesse o arquivo

http://localhost:8080Acesse a WebUI.

- Depois de iniciar o LocalAI por meio do processo de instalação descrito acima, acesse o arquivo

- Modelos de carregamento::

- Na WebUI, navegue até a guia Models (Modelos) e selecione e carregue o modelo desejado.

- Como alternativa, use a linha de comando para carregar o modelo, por exemplo:

local-ai run llama-3.2-1b-instruct:q4_k_m

- Gerar conteúdo::

- Na WebUI, selecione o módulo de função apropriado (por exemplo, geração de texto, geração de imagem etc.), insira os parâmetros necessários e clique no botão Generate (Gerar).

- Por exemplo, para gerar texto, digite o prompt, selecione o modelo e clique no botão "Generate Text" (Gerar texto).

- inferência distribuída::

- Configure várias instâncias do LocalAI para obter inferência P2P distribuída e melhorar a eficiência da inferência.

- Consulte o Guia de Configuração de Inferência Distribuída na documentação oficial.

Recursos avançados

- Modelos personalizados::

- Os usuários podem fazer download e carregar modelos personalizados da Huggingface ou do registro OCI para atender a necessidades específicas.

- Integração de API::

- A LocalAI fornece uma API REST compatível com a API OpenAI, facilitando a integração dos desenvolvedores aos aplicativos existentes.

- Consulte a documentação oficial da API para obter detalhes sobre o uso da API.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...