Mecanismo de API do LLM: geração e implementação rápidas de APIs por meio de linguagem natural

Introdução geral

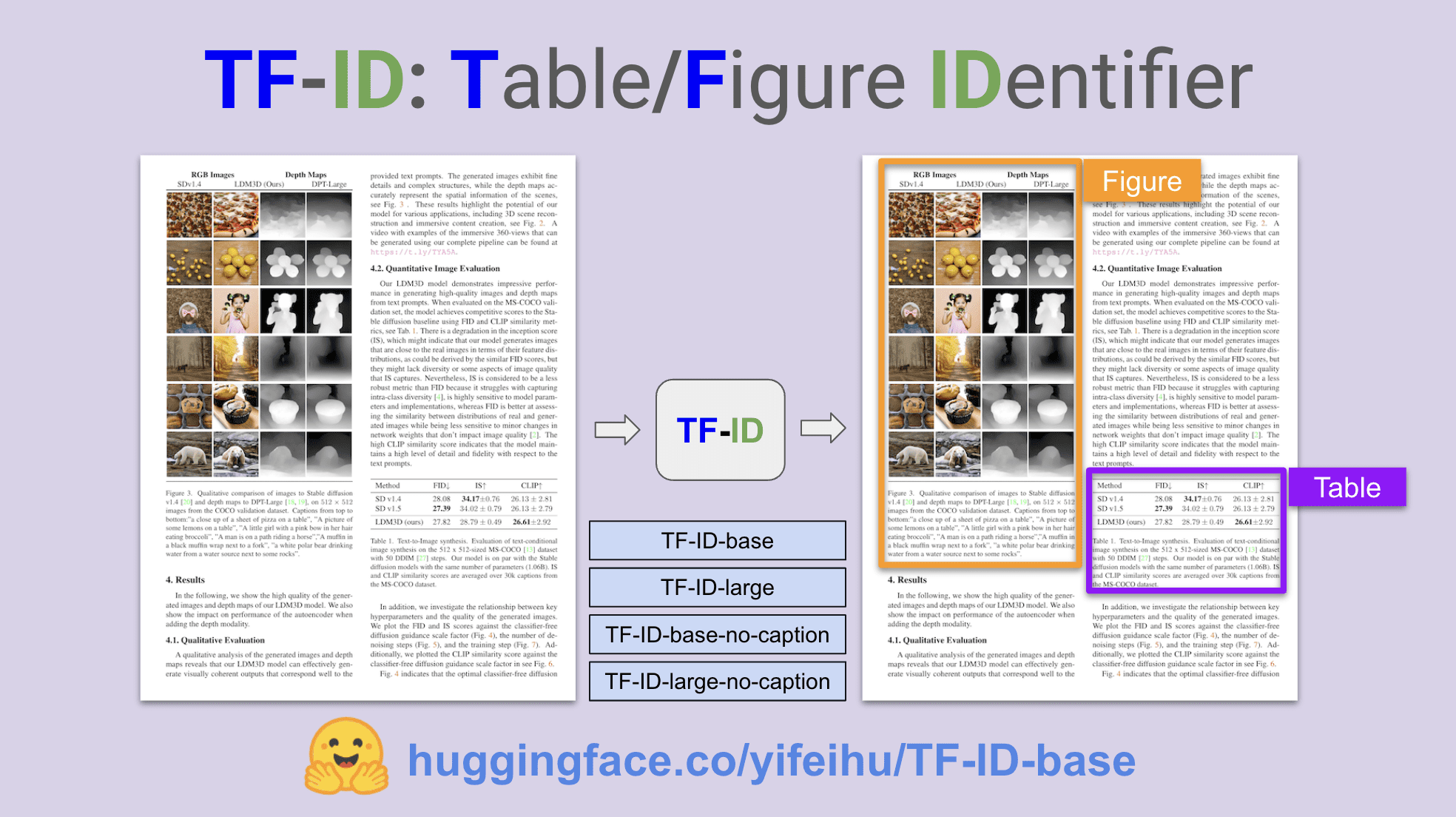

O LLM API Engine é um projeto de código aberto desenvolvido para ajudar os desenvolvedores a criar e implantar rapidamente APIs com tecnologia de IA. O projeto aproveita o Large Language Model (LLM) e as tecnologias inteligentes de rastreamento da Web para permitir que os usuários criem APIs personalizadas por meio de descrições de linguagem natural. O LLM API Engine tem uma arquitetura modular e suporta a implantação de pontos de extremidade de API em várias plataformas, como Cloudflare Workers, Vercel Edge Functions e AWS Lambda.

Lista de funções

- Conversão de texto para APIGeração de APIs com descrições simples de linguagem natural.

- Geração automática de estrutura de dadosGeração automática de estruturas de dados usando a tecnologia OpenAI.

- Rastreamento inteligente da WebRastreamento de dados de páginas da Web usando a tecnologia Firecrawl.

- Atualizações de dados em tempo realSuporte para rastreamentos cronometrados e atualizações de dados em tempo real.

- Implementação instantânea de APIImplementação rápida de pontos de extremidade de API.

- Saída de dados estruturadosValidação de dados: valida os dados de saída por meio do esquema JSON.

- Arquitetura de armazenamento em cache e armazenamentoUso do Redis para armazenamento em cache e armazenamento.

Usando a Ajuda

Processo de instalação

- armazém de clones::

git clone https://github.com/developersdigest/llm-api-engine.git

cd llm-api-engine

- Instalação de dependências::

npm install

- Criação de um arquivo de variável de ambienteCriar no diretório raiz do projeto

.enve adicione as seguintes variáveis:

OPENAI_API_KEY=your_openai_key

FIRECRAWL_API_KEY=your_firecrawl_key

UPSTASH_REDIS_REST_URL=your_redis_url

UPSTASH_REDIS_REST_TOKEN=your_redis_token

NEXT_PUBLIC_API_ROUTE=http://localhost:3000

- Executando o servidor de desenvolvimento::

npm run dev

Abra seu navegador para acessarhttp://localhost:3000Exibir aplicativo.

Função Fluxo de operação

- Criação de pontos de extremidade de API::

- Visite a página inicial do aplicativo e clique no botão "Create New API" (Criar nova API).

- Digite o nome e a descrição da API e selecione o tipo de fonte de dados (por exemplo, rastreamento da Web).

- Use linguagem natural para descrever as estruturas de dados e as regras de rastreamento necessárias.

- Clique no botão "Generate API" e o sistema gerará automaticamente os pontos de extremidade e as estruturas de dados da API.

- Configuração e gerenciamento da API::

- Visualize a lista de APIs criadas na tela API Management.

- Clique em uma API para ir para a página de detalhes, onde você pode editar a configuração da API, visualizar os registros de rastreamento e testar os pontos de extremidade da API.

- Configurado usando a API de armazenamento do Redis, com suporte para alterações e atualizações a qualquer momento.

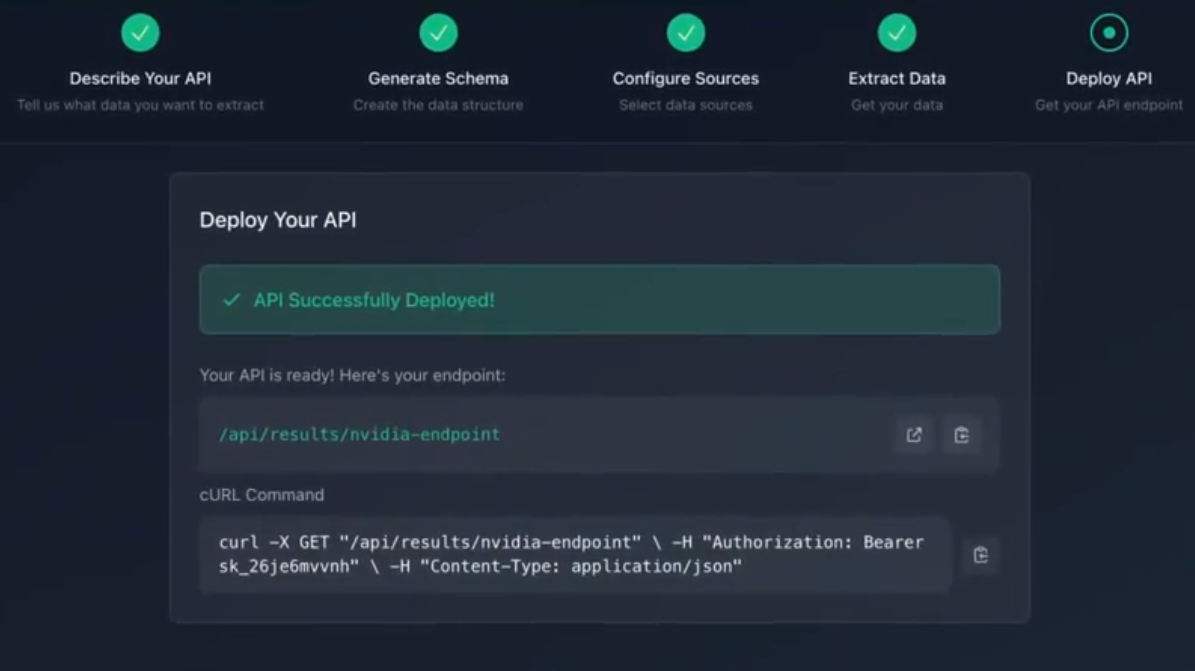

- Implementação de pontos de extremidade de API::

- Selecione a plataforma de implementação (por exemplo, Vercel, AWS Lambda, etc.).

- Configure os parâmetros de implementação de acordo com os requisitos da plataforma e clique no botão "Deploy" (Implementar).

- Após a conclusão da implementação, você poderá visualizar o URL e o status dos pontos de extremidade da API na tela "API Management".

- Uso de pontos de extremidade de API::

- Chame os pontos de extremidade da API em seu aplicativo para obter dados estruturados.

- Oferece suporte ao acesso a pontos de extremidade da API por meio de solicitações HTTP que retornam dados no formato JSON.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...