llamafile: distribuir e executar LLMs usando um único arquivo, simplificar a implementação de LLMs, suporte multiplataforma para LLMs

Introdução geral

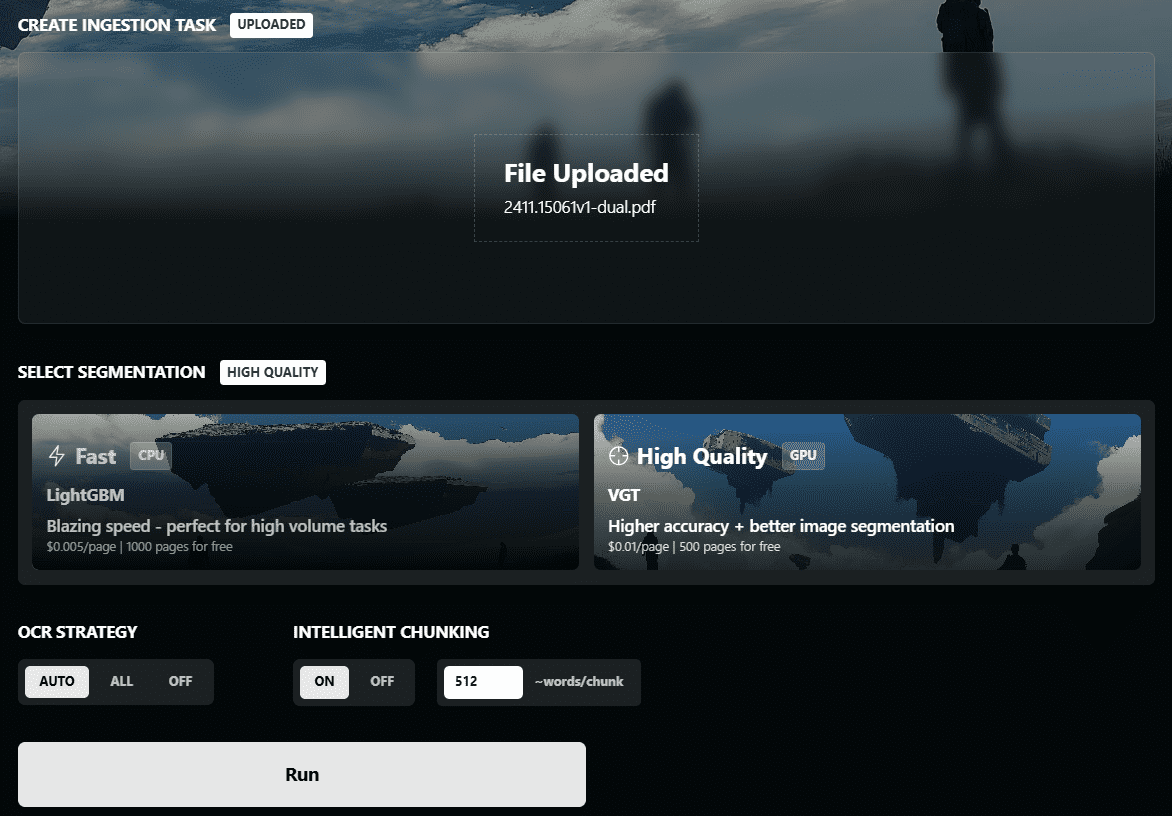

O llamafile é uma ferramenta do projeto Mozilla Builders criada para simplificar a implantação e a operação do Large Language Model (LLM). Ao combinar o llama.cpp Em conjunto com o Cosmopolitan Libc, o llamafile simplifica o complexo processo de implantação do LLM em um único arquivo executável que permite a execução local em uma ampla variedade de sistemas operacionais, sem necessidade de instalação. A ferramenta não só suporta diálogos de texto, mas também lida com a entrada de imagens para garantir a privacidade dos dados.

Lista de funções

- Operação de arquivo únicoEmpacota o modelo LLM e o ambiente de tempo de execução em um único executável.

- Compatibilidade entre plataformasWindows, macOS, Linux, FreeBSD, OpenBSD e NetBSD são compatíveis.

- operação localNão é necessária conexão com a Internet e todo o processamento de dados é feito localmente para garantir a privacidade e a segurança.

- suporte multimodalSuporte a entrada de texto e imagem, oferecendo recursos interativos avançados.

- Compatível com a API da OpenAIInterface de usuário: fornece uma interface compatível com a API OpenAI para facilitar a integração com aplicativos existentes.

- alto desempenhoKernel de multiplicação de matriz otimizado para operação mais rápida na CPU e na GPU.

- projeto de código abertoCódigo-fonte aberto, contribuições ativas da comunidade, atualizações e otimizações contínuas.

Usando a Ajuda

Instalação e operação

- Baixar o llamafile: Acesso Página do GitHub Faça o download da versão mais recente do llamafile.

- Delegação de autoridade executiva(para usuários de macOS, Linux e BSD):

chmod +x path/to/llamafile - Executar o llamafile::

- Para usuários de macOS, Linux e BSD:

./path/to/llamafile - Para usuários do Windows: renomeie o arquivo para

.exee executar:.\path\to\llamafile.exe

- Para usuários de macOS, Linux e BSD:

Operação da função

- Iniciando a interface da WebObservação: Depois de executar o llamafile, o navegador abrirá automaticamente uma tela de bate-papo (se isso não acontecer, visite-a manualmente).

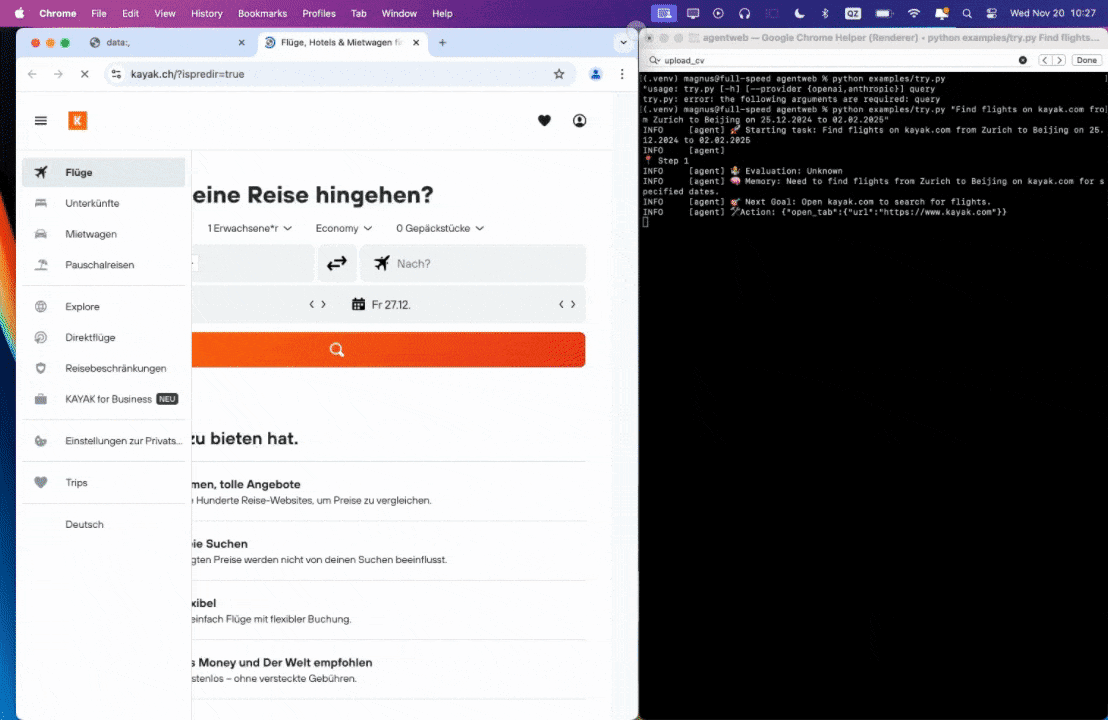

http://127.0.0.1:8080/). - Usando a interface da API OpenAIO llamafile fornece uma interface compatível com a API OpenAI e oferece suporte a casos de uso comuns da API. Ele pode ser chamado com os seguintes comandos:

curl http://localhost:8080/v1/chat/completions -H "Content-Type: application/json" -d '{ "model": "LLaMA_CPP", "messages": [{"role": "user", "content": "Hello, world!"}] }' - entrada de imagemCarregar imagens e fazer perguntas sobre elas, por exemplo:

curl -X POST http://localhost:8080/v1/images -F "image=@path/to/image.jpg" -F "prompt=Describe this image" - modo de linha de comandoO llamafile também oferece suporte ao modo de linha de comando para operações com script:

./path/to/llamafile --cli -p "Your prompt here"

problemas comuns

- Problemas de competênciaSe você encontrar problemas de permissões, verifique se o arquivo tem permissões de execução (usando o comando

chmod +xcomando). - Limite de tamanho de arquivoOs usuários do Windows devem observar que o tamanho de um único arquivo executável não pode exceder 4 GB, e arquivos de peso externos podem ser usados para resolver esse problema.

- problema de dependência: os usuários do macOS precisam instalar o Xcode Comando Line Tools, os usuários do Linux talvez precisem instalar o CUDA SDK ou o ROCm SDK para oferecer suporte à aceleração de GPU.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...