Resumos.

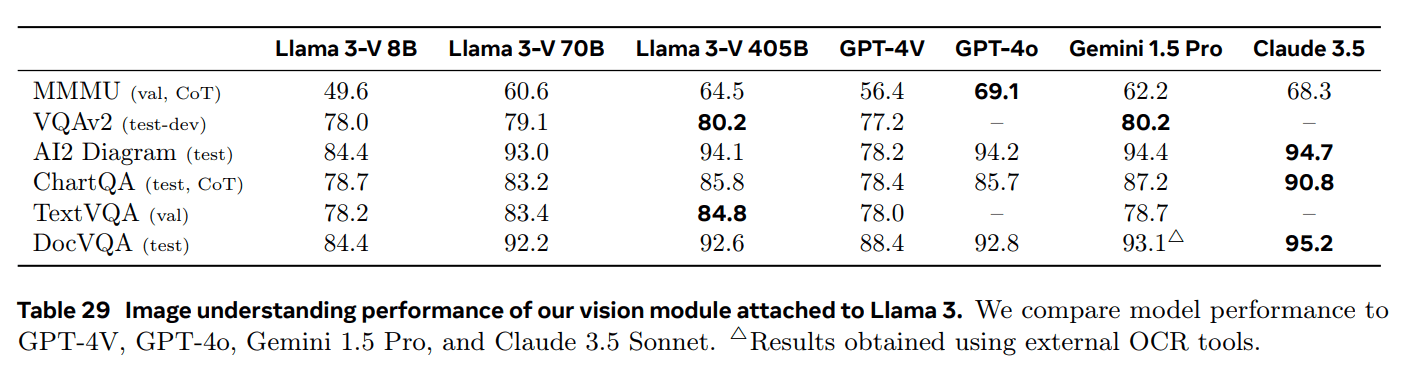

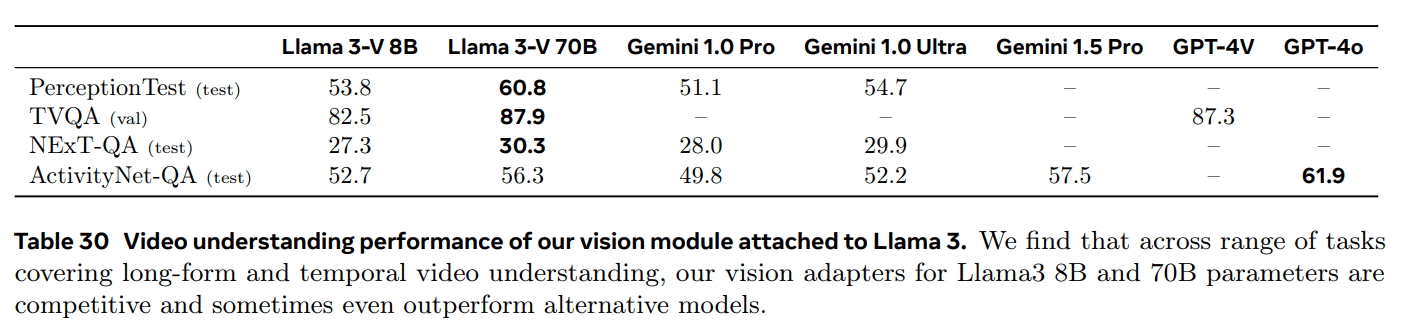

Este artigo apresenta um novo conjunto de modelos básicos chamado Llama 3. O Llama 3 é uma comunidade de modelos de linguagem que oferece suporte inerente ao multilinguismo, à criação de códigos, ao raciocínio e ao uso de ferramentas. Nosso maior modelo é um Transformer denso com 405 bilhões de parâmetros e uma janela de contexto de até 128.000 tokens. Este artigo realiza uma série extensa de avaliações empíricas do Llama 3. Os resultados mostram que a Llama 3 atinge uma qualidade comparável à dos principais modelos de linguagem, como o GPT-4, em muitas tarefas. Disponibilizamos publicamente a Llama 3, incluindo modelos de linguagem de 405 bilhões de parâmetros pré-treinados e pós-treinados, bem como o modelo Llama Guard 3 para segurança de entrada e saída. Este documento também apresenta resultados experimentais sobre a integração de recursos de imagem, vídeo e fala na Llama 3 por meio de uma abordagem combinatória. Observamos que essa abordagem é competitiva com as abordagens mais modernas para tarefas de reconhecimento de imagem, vídeo e fala. Como esses modelos ainda estão em fase de desenvolvimento, eles não foram amplamente publicados.

Download do texto completo em pdf:

1 Introdução

modelo básicosão modelos gerais de linguagem, visão, fala e outras modalidades projetadas para dar suporte a uma ampla gama de tarefas de IA. Eles formam a base de muitos sistemas modernos de IA.

O desenvolvimento de um modelo básico moderno é dividido em duas fases principais:

(1) Fase de pré-treinamento. Os modelos são treinados em grandes quantidades de dados, usando tarefas simples, como a previsão de palavras ou a geração de anotações em gráficos;

(2) Fase pós-treinamento. Os modelos são ajustados para seguir instruções, alinhar-se às preferências humanas e aprimorar recursos específicos (por exemplo, codificação e raciocínio).

Este artigo apresenta um novo conjunto de modelos de base de linguagem chamado Llama 3. A família de modelos Llama 3 Herd oferece suporte inerente ao multilinguismo, à codificação, ao raciocínio e ao uso de ferramentas. Nosso maior modelo é um Transformer denso com 405B parâmetros, capaz de processar informações em janelas de contexto de até 128K tokens.

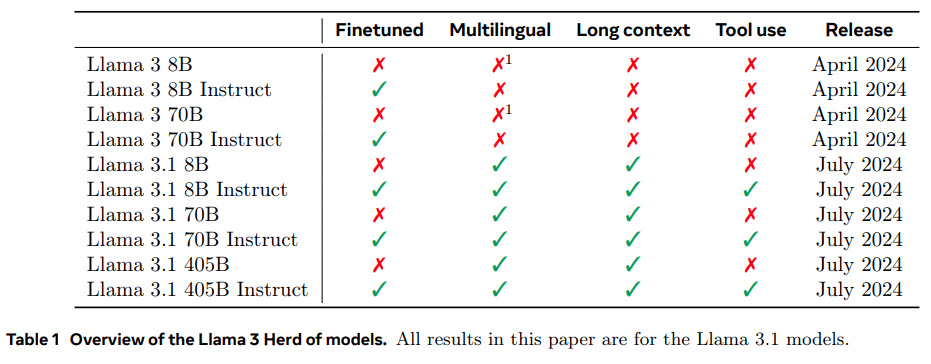

A Tabela 1 lista cada membro do rebanho. Todos os resultados apresentados neste documento baseiam-se no modelo Llama 3.1 (Llama 3, para abreviar).

Acreditamos que as três principais ferramentas para o desenvolvimento de modelos básicos de alta qualidade são o gerenciamento de dados, escala e complexidade. Faremos o possível para otimizar essas três áreas durante nosso processo de desenvolvimento:

- Dados. Tanto a quantidade quanto a qualidade dos dados que usamos no pré-treinamento e no pós-treinamento foram aprimoradas em comparação com as versões anteriores do Llama (Touvron et al., 2023a, b). Esses aprimoramentos incluem o desenvolvimento de pipelines de pré-processamento e curadoria mais cuidadosos para os dados de pré-treinamento e o desenvolvimento de garantia de qualidade e filtragem mais rigorosas. O desenvolvimento de pipelines de pré-processamento e curadoria mais cuidadosos para dados de pré-treinamento e o desenvolvimento de garantia de qualidade e filtragem mais rigorosas A Llama 3 foi pré-treinada em um corpus de cerca de 15T de tokens multilíngues, enquanto a Llama 2 foi pré-treinada em 1,8T de tokens.

- Escopo. Treinamos um modelo maior do que o modelo Llama anterior: nosso principal modelo de linguagem usa 3,8 × 1025 FLOPs para pré-treinamento, quase 50 vezes mais do que a maior versão do Llama 2. Especificamente, pré-treinamos um modelo principal com 405B parâmetros treináveis em 15,6T tokens de texto. Como esperado, o

- Gerenciando a complexidade. As escolhas de design que fizemos tinham como objetivo maximizar a escalabilidade do processo de desenvolvimento de modelos. Por exemplo, escolhemos um modelo padrão denso Transformador (Vaswani et al., 2017) com alguns pequenos ajustes, em vez de usar um modelo de mistura especializado (Shazeer et al., 2017) para maximizar a estabilidade do treinamento. Da mesma forma, empregamos um pós-processador relativamente simples com base em ajuste fino supervisionado (SFT), amostragem de rejeição (RS) e otimização de preferência direta (DPO; Rafailov et al. (2023)), em vez de algoritmos de aprendizado por reforço mais complexos (Ouyang et al., 2022; Schulman et al., 2017), que geralmente são menos estáveis e e difíceis de escalonar.

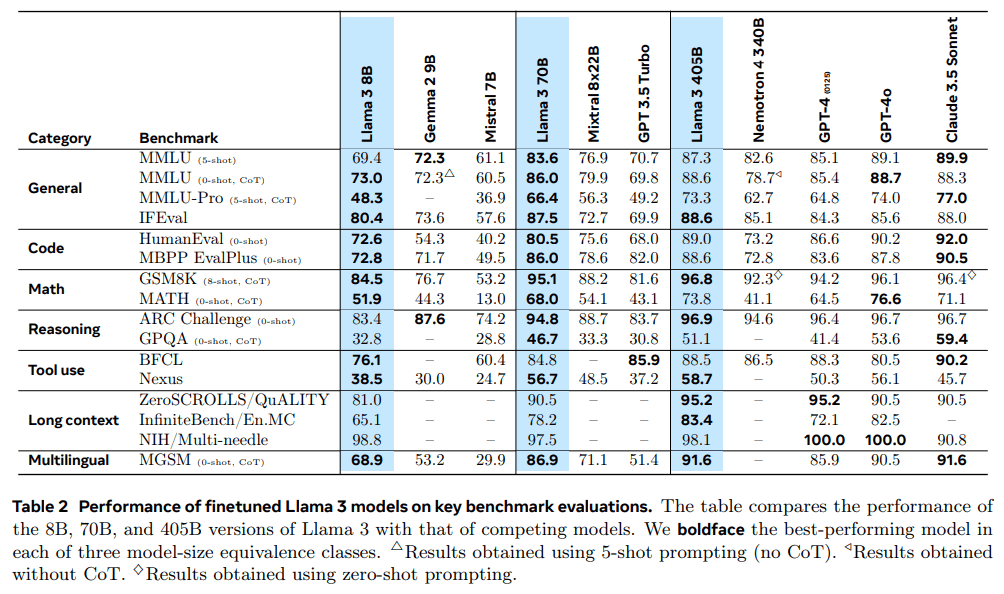

O resultado de nosso trabalho é o Llama 3: um multilíngue de três idiomas com parâmetros 8B, 70B e 405B.1população de modelos de linguagem. Avaliamos o desempenho da Llama 3 em um grande número de conjuntos de dados de referência que abrangem uma ampla gama de tarefas de compreensão de linguagem. Além disso, realizamos extensas avaliações manuais comparando a Llama 3 com modelos concorrentes. A Tabela 2 mostra uma visão geral do desempenho do modelo principal da Llama 3 nos principais testes de referência. Nossas avaliações experimentais mostram que nosso modelo principal está no mesmo nível dos principais modelos de linguagem, como o GPT-4 (OpenAI, 2023a), e próximo do estado da arte em várias tarefas. Nosso modelo menor é o melhor da categoria e supera outros modelos com um número semelhante de parâmetros (Bai et al., 2023; Jiang et al., 2023). O Llama 3 também alcança um equilíbrio melhor entre utilidade e inocuidade do que seu antecessor (Touvron et al., 2023b). Analisamos a segurança da Llama 3 em detalhes na Seção 5.4.

Estamos lançando todos os três modelos Llama 3 publicamente, usando uma versão atualizada da Licença Comunitária Llama 3; consulte https://llama.meta.com. Isso inclui versões pré-treinadas e pós-processadas do nosso modelo de linguagem paramétrico 405B, bem como uma nova versão do modelo Llama Guard (Inan et al., 2023) para segurança de entrada e saída. segurança de entrada e saída. Esperamos que o lançamento público de um modelo emblemático inspire uma onda de inovação na comunidade de pesquisa e acelere o progresso em direção ao desenvolvimento responsável da Inteligência Artificial (AGI).

Multilíngue: refere-se à capacidade do modelo de entender e gerar texto em vários idiomas.

Durante o desenvolvimento do Llama 3, também desenvolvemos extensões multimodais do modelo para permitir o reconhecimento de imagens, o reconhecimento de vídeos e a compreensão da fala. Esses modelos ainda estão em desenvolvimento ativo e ainda não estão prontos para lançamento. Além dos nossos resultados de modelagem de linguagem, este documento apresenta os resultados de nossos experimentos iniciais com esses modelos multimodais.

O Llama 3 8B e o 70B foram pré-treinados em dados multilíngues, mas naquela época eram usados principalmente para o inglês.

2 Geral

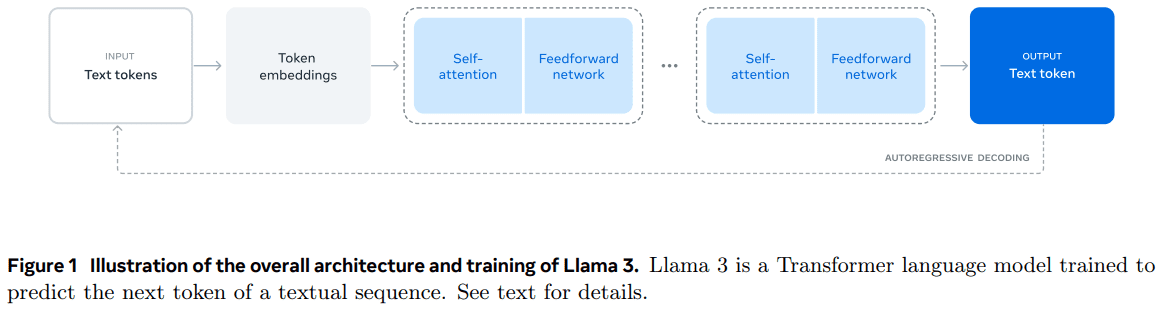

A arquitetura do modelo da Llama 3 é mostrada na Figura 1. O desenvolvimento do nosso modelo de linguagem Llama 3 é dividido em duas fases principais:

- Pré-treinamento do modelo de idioma.Primeiro, convertemos um grande corpus de texto multilíngue em tokens discretos e pré-treinamos um modelo de linguagem grande (LLM) nos dados resultantes para a próxima previsão de tokens. Na fase de pré-treinamento do LLM, o modelo aprende a estrutura do idioma e adquire uma grande quantidade de conhecimento sobre o mundo a partir do texto que ele "lê". Para fazer isso de forma eficiente, o pré-treinamento é feito em escala: pré-treinamos um modelo com 405B parâmetros em um modelo com 15,6T tokens, usando uma janela de contexto de 8K tokens. Essa fase de pré-treinamento padrão é seguida por uma fase de pré-treinamento contínuo, que aumenta a janela de contexto suportada para 128 mil tokens. Consulte a Seção 3 para obter mais informações.

- Treinamento pós-modelo.O modelo de linguagem pré-treinado tem uma rica compreensão da linguagem, mas ainda não seguiu instruções nem se comportou como o assistente que esperamos que ele se comporte. Calibramos o modelo por meio de feedback humano em várias rodadas, cada uma incluindo o ajuste fino supervisionado (SFT) e a otimização direta de preferências (DPO; Rafailov et al., 2024) em dados ajustados por instruções. Nessa fase pós-treinamento, também integramos novos recursos, como o uso de ferramentas, e observamos melhorias significativas em áreas como codificação e inferência. Para obter mais informações, consulte a Seção 4. Por fim, as atenuações de segurança também são integradas ao modelo na fase de pós-treinamento, cujos detalhes são descritos na Seção 5.4. Os modelos gerados são ricos em funcionalidade. Eles são capazes de responder a perguntas em pelo menos oito idiomas, escrever códigos de alta qualidade, resolver problemas complexos de inferência e usar ferramentas prontas para uso ou com amostra zero.

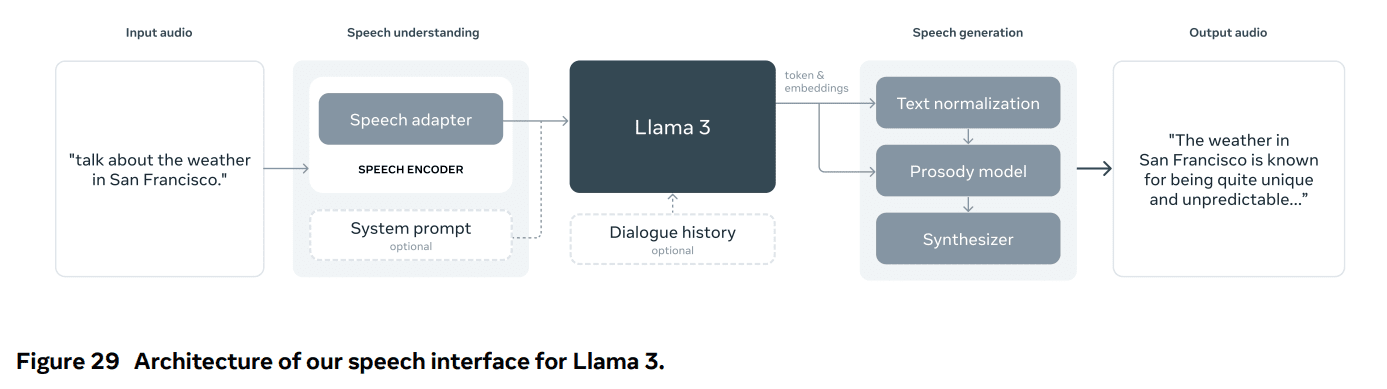

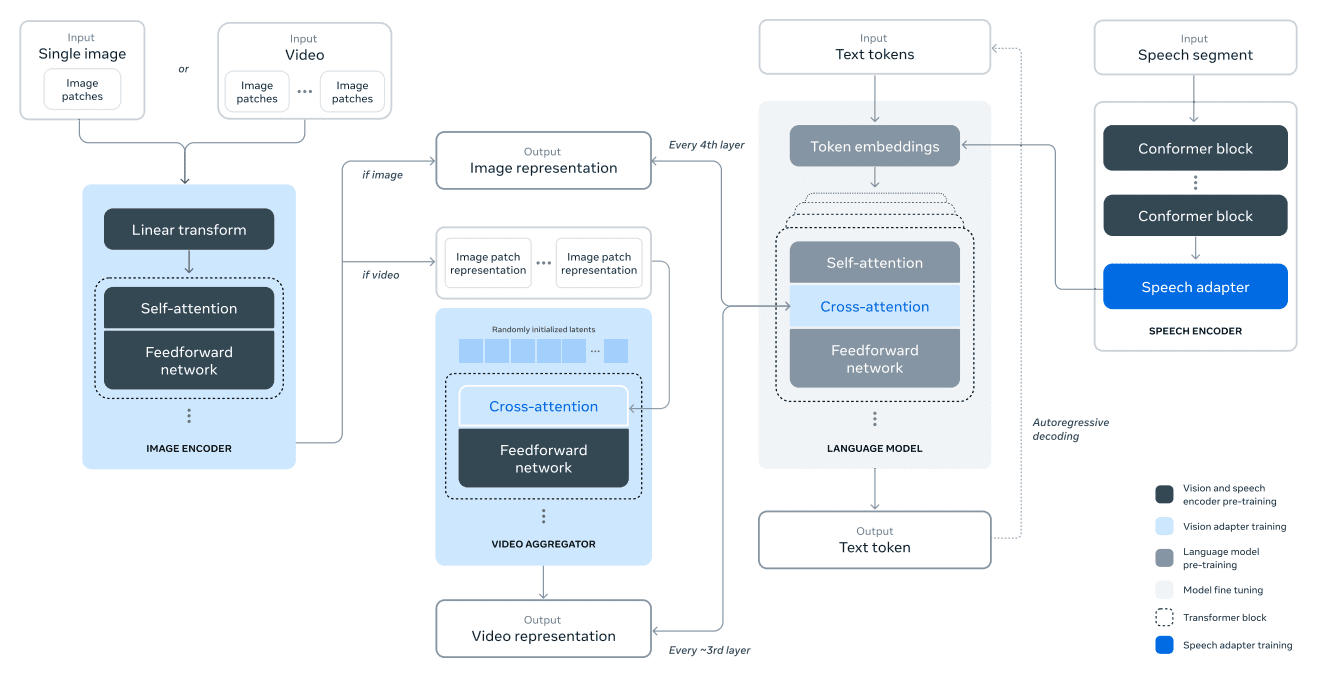

Também realizamos experimentos para adicionar recursos de imagem, vídeo e voz à Llama 3 por meio de uma abordagem combinada. A abordagem que investigamos consiste em três fases adicionais mostradas na Figura 28:

- Pré-treinamento do codificador multimodal.Treinamos codificadores separados para imagem e fala. Treinamos o codificador de imagem em um grande número de pares imagem-texto. Isso permite que o modelo aprenda a relação entre o conteúdo visual e sua descrição em linguagem natural. Nosso codificador de fala usa um método autossupervisionado que mascara uma parte da entrada da fala e tenta reconstruir a parte mascarada por meio de uma representação discreta de marcadores. Assim, o modelo aprende a estrutura do sinal de fala. Consulte a Seção 7 para obter mais informações sobre codificadores de imagem e a Seção 8 para obter mais informações sobre codificadores de fala.

- Treinamento do adaptador visual.Treinamos um adaptador que integra um codificador de imagem pré-treinado com um modelo de linguagem pré-treinado. O adaptador consiste em uma série de camadas de atenção cruzada que alimentam a representação do codificador de imagem no modelo de linguagem. O adaptador é treinado em pares de texto-imagem, o que alinha a representação da imagem com a representação do idioma. Durante o treinamento do adaptador, também atualizamos os parâmetros do codificador de imagem, mas intencionalmente não atualizamos os parâmetros do modelo de linguagem. Também treinamos um adaptador de vídeo em cima do adaptador de imagem, usando dados de texto de vídeo emparelhados. Isso permite que o modelo agregue informações entre quadros. Para obter mais informações, consulte a Seção 7.

- Por fim, integramos o codificador de fala ao modelo por meio de um adaptador que converte a codificação da fala em uma representação tokenizada que pode ser alimentada diretamente no modelo de linguagem com ajuste fino. Durante a fase de ajuste fino supervisionado, os parâmetros do adaptador e do codificador são atualizados em conjunto para obter uma compreensão de fala de alta qualidade. Não alteramos o modelo de idioma durante o treinamento do adaptador de fala. Também integramos um sistema de conversão de texto em fala. Consulte a Seção 8 para obter mais detalhes.

Nossos experimentos multimodais levaram a modelos que reconhecem o conteúdo de imagens e vídeos e suportam a interação por meio de uma interface de fala. Esses modelos ainda estão em desenvolvimento e ainda não estão prontos para serem lançados.

3 Pré-treinamento

O pré-treinamento de modelos de linguagem envolve os seguintes aspectos:

(1) Coleta e filtragem de corpora de treinamento em larga escala;

(2) Desenvolvimento de arquiteturas de modelos e leis de escala correspondentes para determinar o tamanho do modelo;

(3) Desenvolvimento de técnicas para pré-treinamento eficiente em grande escala;

(4) Desenvolvimento de um programa de pré-treinamento. Descreveremos cada um desses componentes a seguir.

3.1 Dados de pré-treinamento

Criamos conjuntos de dados de pré-treinamento de modelos de linguagem a partir de várias fontes de dados que contêm conhecimento até o final de 2023. Aplicamos vários métodos de eliminação de duplicação e mecanismos de limpeza de dados a cada fonte de dados para obter uma rotulagem de alta qualidade. Removemos os domínios que continham grandes quantidades de informações de identificação pessoal (PII), bem como os domínios conhecidos por conter conteúdo adulto.

3.11 Limpeza de dados da Web

A maioria dos dados que utilizamos vem da Web e descrevemos nosso processo de limpeza abaixo.

PII e filtragem de segurança. Entre outras medidas, implementamos filtros projetados para remover dados de sites que possam conter conteúdo inseguro ou grandes quantidades de PII, domínios classificados como prejudiciais de acordo com vários padrões de segurança Meta e domínios conhecidos por conter conteúdo adulto.

Extração e limpeza de textos. Processamos o conteúdo HTML bruto para extrair texto diversificado e de alta qualidade e usamos documentos da Web não truncados para essa finalidade. Para isso, criamos um analisador personalizado que extrai o conteúdo HTML e otimiza a precisão da remoção de modelos e a recuperação de conteúdo. Avaliamos a qualidade do analisador por meio de avaliação manual e o comparamos com analisadores HTML populares de terceiros, otimizados para o conteúdo de artigos semelhantes, e descobrimos que ele tem um bom desempenho. Tomamos cuidado com as páginas HTML que contêm matemática e conteúdo de código para preservar a estrutura desse conteúdo. Mantemos o texto do atributo alt da imagem porque o conteúdo matemático geralmente é representado como uma imagem pré-renderizada em que a matemática também é fornecida no atributo alt.

Descobrimos que o Markdown prejudicava o desempenho do modelo, que foi treinado principalmente em dados da Web, em comparação com o texto simples, portanto, removemos todas as tags do Markdown.

Desacentuação. Aplicamos várias rodadas de desduplicação no nível do URL, do documento e da linha:

- Desduplicação em nível de URL. Realizamos a desduplicação em nível de URL em todo o conjunto de dados. Para cada página correspondente a um URL, mantemos a versão mais recente.

- Desduplicação em nível de documento. Realizamos a desduplicação global MinHash (Broder, 1997) em todo o conjunto de dados para remover documentos quase duplicados.

- Desduplicação em nível de linha. Realizamos a desduplicação em nível radical semelhante à ccNet (Wenzek et al., 2019). Removemos as linhas que ocorrem mais de 6 vezes em cada grupo contendo 30 milhões de documentos.

Embora nossas análises qualitativas manuais sugiram que a desduplicação em nível de linha remova não apenas o conteúdo boilerplate residual de vários sites (por exemplo, menus de navegação, avisos de cookies), mas também textos frequentes de alta qualidade, nossas avaliações empíricas mostram melhorias significativas.

Filtragem heurística. A heurística foi desenvolvida para remover outros documentos de baixa qualidade, outliers e documentos com muitas repetições. Alguns exemplos de heurística incluem:

- Usamos a cobertura de n-tuplas duplicadas (Rae et al., 2021) para remover linhas que consistem em conteúdo duplicado (por exemplo, logs ou mensagens de erro). Essas linhas podem ser muito longas e exclusivas e, portanto, não podem ser filtradas pela desduplicação de linhas.

- Usamos uma contagem de "palavras sujas" (Raffel et al., 2020) para filtrar sites adultos que não são cobertos pela lista negra de domínios.

- Usamos a dispersão de Kullback-Leibler da distribuição de tokens para filtrar os documentos que contêm muitos tokens anômalos em comparação com a distribuição do corpus de treinamento.

Filtragem de qualidade baseada em modelos.

Além disso, tentamos usar vários classificadores de qualidade baseados em modelos para selecionar rótulos de alta qualidade. Esses métodos incluem:

- Usar classificadores rápidos, como o fasttext (Joulin et al., 2017), que são treinados para reconhecer se um determinado texto será citado pela Wikipédia (Touvron et al., 2023a).

- Foi usado um classificador de modelo Roberta (Liu et al., 2019a) mais intensivo em termos de computação, que foi treinado nas previsões do Llama 2.

Para treinar o classificador de qualidade baseado na Llama 2, criamos um conjunto de documentos da Web limpos que descrevem os requisitos de qualidade e instruímos o modelo de bate-papo da Llama 2 a determinar se os documentos atendiam a esses requisitos. Para maior eficiência, usamos o DistilRoberta (Sanh et al., 2019) para gerar pontuações de qualidade para cada documento. Avaliaremos experimentalmente a eficácia de várias configurações de filtragem de qualidade.

Código e dados de inferência.

Semelhante ao DeepSeek-AI et al. (2024), construímos pipelines específicos de domínio para extrair páginas da Web relacionadas à matemática e que contêm código. Especificamente, os classificadores de código e de inferência são modelos DistilledRoberta treinados usando dados da Web anotados pelo Llama 2. Diferentemente dos classificadores de qualidade genéricos mencionados acima, realizamos o ajuste de dicas para direcionar as páginas da Web que contêm inferências matemáticas, raciocínio em domínios STEM e código incorporado em linguagem natural. Como as distribuições de tokens do código e da matemática são muito diferentes das da linguagem natural, esses pipelines implementam extração de HTML específica do domínio, recursos de texto personalizados e heurística para filtragem.

Dados multilíngues.

Semelhante ao pipeline de processamento em inglês descrito acima, implementamos filtros para remover dados de sites que possam conter informações de identificação pessoal (PII) ou conteúdo inseguro. Nosso pipeline de processamento de texto multilíngue tem os seguintes recursos exclusivos:

- Usamos um modelo de reconhecimento de idioma baseado em texto rápido para classificar documentos em 176 idiomas.

- Realizamos a desduplicação de dados em nível de documento e de linha para cada idioma.

- Aplicamos heurísticas específicas do idioma e filtros baseados em modelos para remover documentos de baixa qualidade.

Além disso, usamos um classificador multilíngue baseado em Llama 2 para classificar a qualidade dos documentos multilíngues e garantir que o conteúdo de alta qualidade seja priorizado. O número de tokens multilíngues que usamos no pré-treinamento é determinado experimentalmente, e o desempenho do modelo é equilibrado em testes de referência em inglês e multilíngues.

3.12 Determinação da combinação de dados

为了获得高质量语言模型,必须谨慎确定预训练数据混合中不同数据源的比例。我们主要利用知识分类和尺度定律实验来确定这一数据混合。

知识分类。我们开发了一个分类器,用于对网页数据中包含的信息类型进行分类,以便更有效地确定数据组合。我们使用这个分类器对网页上过度代表的数据类别(例如艺术和娱乐)进行下采样。

为了确定最佳数据混合方案。我们进行规模定律实验,其中我们将多个小型模型训练于特定数据混合集上,并利用其预测大型模型在该混合集上的性能(参见第 3.2.1 节)。我们多次重复此过程,针对不同的数据混合集选择新的候选数据混合集。随后,我们在该候选数据混合集上训练一个更大的模型,并在多个关键基准测试上评估该模型的性能。

数据混合摘要。我们的最终数据混合包含大约 50% 的通用知识标记、25% 的数学和推理标记、17% 的代码标记以及 8% 的多语言标记。

3.13 Dados de recozimento

Os resultados empíricos mostram que o recozimento em uma pequena quantidade de código de alta qualidade e dados matemáticos (consulte a Seção 3.4.3) pode melhorar o desempenho de modelos pré-treinados nos principais testes de benchmark. Semelhante ao estudo de Li et al. (2024b), fazemos o recozimento usando um conjunto de dados misto que contém dados de alta qualidade de domínios selecionados. Nossos dados recozidos não contêm nenhum conjunto de treinamento de testes de referência comumente usados. Isso nos permite avaliar a verdadeira capacidade de aprendizado de poucas amostras e a generalização fora do domínio da Llama 3.

Seguindo OpenAI (2023a), avaliamos o efeito do recozimento nos conjuntos de treinamento GSM8k (Cobbe et al., 2021) e MATH (Hendrycks et al., 2021b). Descobrimos que o recozimento melhora o desempenho do modelo Llama 3 8B pré-treinado em 24,0% e 6,4% nos conjuntos de validação GSM8k e MATH, respectivamente. No entanto, a melhoria é insignificante para o modelo 405B, sugerindo que nosso modelo principal tem fortes recursos de aprendizado e inferência contextuais e que não requer amostras de treinamento específicas do domínio para obter um bom desempenho.

Use o recozimento para avaliar a qualidade dos dados.Assim como Blakeney et al. (2024), descobrimos que o recozimento nos permite avaliar o valor de pequenos conjuntos de dados específicos do domínio. Medimos o valor desses conjuntos de dados por meio do recozimento linear da taxa de aprendizado do modelo Llama 3 8B, que foi treinado com 50%, para 0 em 40 bilhões de tokens. Nesses experimentos, atribuímos 301 pesosTP3T ao novo conjunto de dados e os 701 pesosTP3T restantes à combinação de dados padrão. É mais eficiente usar o recozimento para avaliar novas fontes de dados do que realizar experimentos de lei de escala em cada conjunto de dados pequeno.

3.2 Arquitetura do modelo

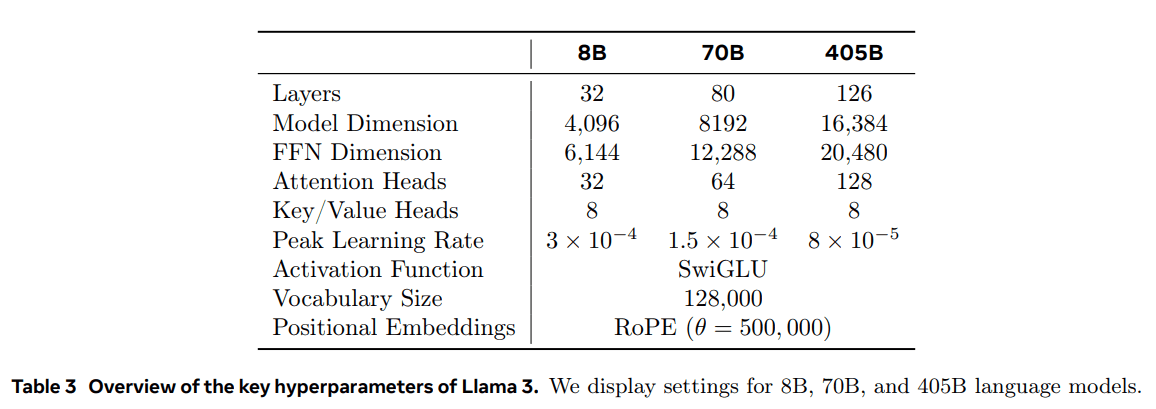

A Llama 3 usa a arquitetura Transformer densa padrão (Vaswani et al., 2017). A arquitetura de seu modelo não é significativamente diferente da Llama e da Llama 2 (Touvron et al., 2023a, b); nossos ganhos de desempenho vêm principalmente de melhorias na qualidade e diversidade dos dados, bem como do aumento do tamanho do treinamento.

Fizemos algumas pequenas modificações:

- Usamos o Grouped Query Attention (GQA; Ainslie et al. (2023)), em que 8 cabeçalhos de valores-chave são usados para aumentar a velocidade de inferência e reduzir o tamanho do cache de valores-chave durante a decodificação.

- Usamos uma máscara de atenção para evitar mecanismos de autoatenção entre diferentes documentos da sequência. Descobrimos que essa alteração tem impacto limitado durante o pré-treinamento padrão, mas é importante durante o pré-treinamento contínuo de sequências muito longas.

- Usamos um vocabulário de 128 mil tokens. Nosso vocabulário tokenizado combina os 100 mil tokens do vocabulário tiktoken3 com 28 mil tokens adicionais para oferecer melhor suporte a idiomas que não sejam o inglês. Em comparação com o vocabulário do Llama 2, nosso novo vocabulário melhora a compactação de amostras de dados em inglês de 3,17 para 3,94 caracteres/token. Isso permite que o modelo "leia" mais texto com a mesma quantidade de computação de treinamento. Também descobrimos que a adição de 28 mil tokens de idiomas específicos não ingleses melhorou a compactação e o desempenho downstream, sem afetar a tokenização em inglês.

- Aumentamos o hiperparâmetro de frequência de base RoPE para 500.000. Isso nos permite suportar melhor contextos mais longos; Xiong et al. (2023) mostram que esse valor é válido para contextos de até 32.768.

O Llama 3 405B usa uma arquitetura com 126 camadas, 16.384 dimensões de representação de marcadores e 128 cabeças de atenção; para obter mais informações, consulte a Tabela 3. Isso resulta em um tamanho de modelo que é aproximadamente ideal do ponto de vista computacional com base em nossos dados e um orçamento de treinamento de 3,8 × 10^25 FLOPs.

3.2.1 Leis de escala

Usamos as leis de escalonamento (Hoffmann et al., 2022; Kaplan et al., 2020) para determinar o tamanho ideal do modelo principal com base em nosso orçamento computacional de pré-treinamento. Além de determinar o tamanho ideal do modelo, a previsão do desempenho do modelo principal em tarefas de benchmark downstream apresenta desafios significativos pelos seguintes motivos:

- As leis de dimensionamento existentes normalmente preveem apenas a perda de previsão da próxima marca, não um desempenho específico de benchmarking.

- As leis de escala podem ser ruidosas e não confiáveis porque são desenvolvidas com base em execuções de pré-treinamento usando um orçamento computacional pequeno (Wei et al., 2022b).

Para enfrentar esses desafios, implementamos uma abordagem de duas fases para desenvolver leis de dimensionamento que prevejam com precisão o desempenho do benchmarking downstream:

- Primeiro, estabelecemos a correlação entre os FLOPs de pré-treinamento e o cálculo da probabilidade de logaritmo negativo do melhor modelo na tarefa downstream.

- Em seguida, correlacionamos a probabilidade de log negativo na tarefa downstream com a precisão da tarefa usando o modelo Scaling Laws e um modelo mais antigo treinado anteriormente usando FLOPs computacionais mais altos. Nessa etapa, utilizamos exclusivamente a família de modelos Llama 2.

Essa abordagem nos permite prever o desempenho da tarefa downstream (para modelos computacionalmente ideais) com base em um número específico de FLOPs pré-treinados. Usamos uma abordagem semelhante para selecionar nossas combinações de dados de pré-treinamento (consulte a Seção 3.4).

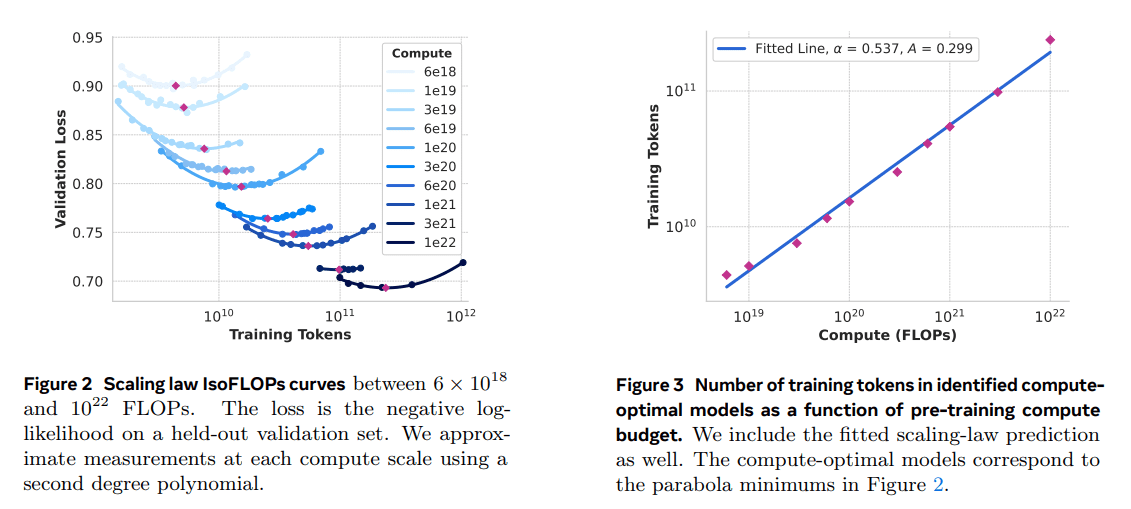

Dimensionamento Experiência jurídica.Especificamente, construímos leis de escala pré-treinando modelos usando orçamentos computacionais entre 6 × 10^18 FLOPs e 10^22 FLOPs. Em cada orçamento computacional, pré-treinamos modelos com tamanhos entre 40M e 16B parâmetros e usamos uma fração do tamanho do modelo em cada orçamento computacional. Nessas execuções de treinamento, usamos o agendamento da taxa de aprendizado cosseno e o aquecimento linear em 2.000 etapas de treinamento. O pico da taxa de aprendizagem foi definido entre 2 × 10^-4 e 4 × 10^-4, dependendo do tamanho do modelo. Definimos o decaimento do cosseno como 0,1 vezes o valor de pico. O decaimento do peso para cada etapa foi definido como 0,1 vezes a taxa de aprendizado para essa etapa. Usamos um tamanho de lote fixo para cada tamanho computacional, variando de 250K a 4M.

Esses experimentos produziram as curvas IsoFLOPs na Figura 2. As perdas nessas curvas foram medidas em conjuntos de validação separados. Ajustamos os valores de perda medidos usando um polinômio de segunda ordem e determinamos o valor mínimo de cada parábola. Referimo-nos ao mínimo da parábola como o modelo computacionalmente ideal sob o orçamento computacional pré-treinado correspondente.

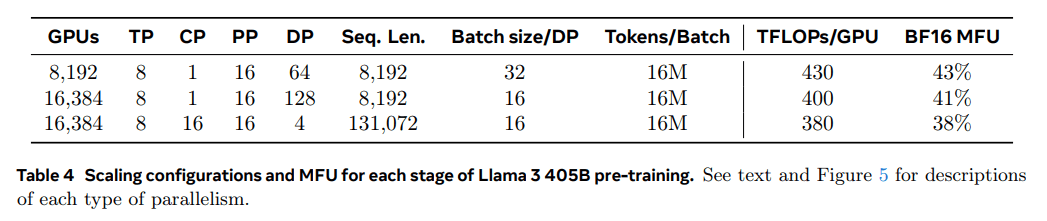

Usamos o modelo computacionalmente ideal identificado dessa forma para prever o número ideal de tokens de treinamento para um determinado orçamento computacional. Para esse fim, assumimos uma relação de lei de potência entre o orçamento computacional C e o número ideal de tokens de treinamento N (C):

N (C) = AC α .

Ajustamos A e α usando os dados da Fig. 2. Encontramos (α, A) = (0,53, 0,29); o ajuste correspondente é mostrado na Fig. 3. A extrapolação da lei de escala resultante para 3,8 × 10 25 FLOPs sugere o treinamento de um modelo com 402B parâmetros e o uso de 16,55T tokens.

Uma observação importante é que a curva de IsoFLOPs se torna mais plana em torno do mínimo à medida que o orçamento computacional aumenta. Isso implica que o desempenho do modelo principal é relativamente estável em relação a pequenas variações no equilíbrio entre o tamanho do modelo e os marcadores de treinamento. Com base nessa observação, finalmente decidimos treinar um modelo principal contendo o parâmetro 405B.

Previsão de desempenho em tarefas downstream.Usamos o modelo computacionalmente ideal gerado para prever o desempenho do modelo principal da Llama 3 no conjunto de dados de referência. Primeiro, relacionamos linearmente a probabilidade de logaritmo negativo (normalizada) da resposta correta no benchmark com os FLOPs de treinamento. Para essa análise, usamos somente o modelo de lei de escalonamento treinado para 10^22 FLOPs na mistura de dados acima. Em seguida, estabelecemos uma relação em forma de S entre a probabilidade de registro e a precisão usando o modelo de lei de escala e o modelo Llama 2, que foi treinado usando o mix de dados e o tagger do Llama 2. (Mostramos os resultados desse experimento no benchmark ARC Challenge na Figura 4). Consideramos que essa previsão da lei de escalonamento em duas etapas (extrapolada em quatro ordens de magnitude) é bastante precisa: ela subestima apenas ligeiramente o desempenho final do modelo principal da Llama 3.

3.3 Infraestrutura, expansão e eficiência

Descrevemos o hardware e a infraestrutura de suporte ao pré-treinamento do Llama 3 405B e discutimos várias otimizações que melhoram a eficiência do treinamento.

3.3.1 Infraestrutura de treinamento

Os modelos Llama 1 e Llama 2 foram treinados no supercluster de pesquisa de IA do Meta (Lee e Sengupta, 2022). À medida que aumentamos a escala, o treinamento da Llama 3 foi migrado para o cluster de produção do Meta (Lee et al., 2024). Essa configuração otimiza a confiabilidade no nível de produção, o que é fundamental à medida que aumentamos o treinamento.

Recursos de computação: O Llama 3 405B treina em até 16.000 GPUs H100, cada uma executando a 700W TDP com 80GB HBM3, usando a plataforma de servidor Grand Teton AI da Meta (Matt Bowman, 2022). Cada servidor é equipado com oito GPUs e duas CPUs; dentro do servidor, as oito GPUs são conectadas via NVLink. Os trabalhos de treinamento são programados usando o MAST (Choudhury et al., 2024), o programador de treinamento em escala global do Meta.

Armazenamento: O Tectonic (Pan et al., 2021), o sistema de arquivos distribuídos de uso geral do Meta, foi usado para criar a arquitetura de armazenamento para o pré-treinamento do Llama 3 (Battey e Gupta, 2024). Ele fornece 240 PB de espaço de armazenamento e consiste em 7.500 servidores equipados com SSDs que suportam uma taxa de transferência sustentável de 2 TB/s e uma taxa de transferência de pico de 7 TB/s. Um grande desafio é suportar gravações de pontos de verificação altamente explosivas que saturam a malha de armazenamento em um curto período de tempo. Os pontos de verificação salvam o estado do modelo por GPU, variando de 1 MB a 4 GB por GPU, para recuperação e depuração. Nosso objetivo é minimizar o tempo de pausa da GPU durante o checkpointing e aumentar a frequência do checkpointing para reduzir o volume de trabalho perdido após a recuperação.

Trabalho em rede: O Llama 3 405B usa uma arquitetura RDMA over Converged Ethernet (RoCE) baseada nos switches de rack Arista 7800 e Minipack2 Open Compute Project (OCP). Os modelos menores da série Llama 3 foram treinados usando a rede Nvidia Quantum2 Infiniband. Os clusters RoCE e Infiniband utilizam uma conexão de link de 400 Gbps entre as GPUs. Apesar das diferenças na tecnologia de rede subjacente desses clusters, ajustamos ambos para oferecer desempenho equivalente para lidar com essas grandes cargas de trabalho de treinamento. Vamos nos aprofundar mais em nossa rede RoCE à medida que nos apropriarmos totalmente de seu design.

- Topologia de rede: Nosso cluster de IA baseado em RoCE contém 24.000 GPUs (nota de rodapé 5) conectadas por meio de uma rede Clos de três camadas (Lee et al., 2024). Na camada inferior, cada rack hospeda 16 GPUs, alocadas em dois servidores e conectadas por meio de um único switch Minipack2 top-of-rack (ToR). Na camada intermediária, 192 desses racks são conectados por meio de switches de cluster para formar um Pod de 3.072 GPUs com largura de banda bidirecional total, garantindo que não haja excesso de assinatura. Na camada superior, oito desses Pods no mesmo edifício do data center são conectados por meio de switches de agregação para formar um cluster de 24.000 GPUs. No entanto, em vez de manter a largura de banda bidirecional total, as conexões de rede na camada de agregação têm uma taxa de excesso de assinatura de 1:7. Tanto a nossa abordagem de modelo paralelo (consulte a Seção 3.3.2) quanto o agendador de tarefas de treinamento (Choudhury et al., 2024) são otimizados para conhecer a topologia da rede, com o objetivo de minimizar a comunicação de rede entre os pods.

- Balanceamento de carga: O treinamento de grandes modelos de linguagem gera um tráfego de rede pesado que é difícil de equilibrar em todos os caminhos de rede disponíveis por meio de métodos tradicionais, como o roteamento Equal Cost Multipath (ECMP). Para enfrentar esse desafio, empregamos duas técnicas. Primeiro, nossa biblioteca agregada cria 16 fluxos de rede entre duas GPUs em vez de uma, reduzindo assim o volume de tráfego por fluxo e fornecendo mais fluxos para o balanceamento de carga. Em segundo lugar, nosso protocolo Enhanced ECMP (E-ECMP) equilibra de forma eficaz esses 16 fluxos em diferentes caminhos de rede, fazendo o hashing de outros campos no pacote de cabeçalho RoCE.

- Controle de congestionamento: Usamos switches de buffer profundo (Gangidi et al., 2024) na rede de backbone para acomodar o congestionamento transitório e o armazenamento em buffer causados por padrões de comunicação agregados. Isso ajuda a limitar o impacto do congestionamento persistente e da contrapressão da rede causada por servidores lentos, o que é comum no treinamento. Por fim, o melhor balanceamento de carga por meio do E-ECMP reduz bastante a probabilidade de congestionamento. Com essas otimizações, executamos com sucesso um cluster de 24.000 GPUs sem a necessidade de métodos tradicionais de controle de congestionamento, como o Data Center Quantified Congestion Notification (DCQCN).

3.3.2 Paralelismo no aumento de escala do modelo

Para ampliar o treinamento do nosso maior modelo, dividimos o modelo usando o paralelismo 4D - um esquema que combina quatro abordagens paralelas diferentes. Essa abordagem distribui efetivamente o cálculo em várias GPUs e garante que os parâmetros do modelo, os estados do otimizador, os gradientes e os valores de ativação de cada GPU se ajustem ao seu HBM. Nossa implementação paralela 4D (conforme mostrado em et al. (2020); Ren et al. (2021); Zhao et al. (2023b)) divide o modelo, o otimizador e o gradiente enquanto implementa o paralelismo de dados, que processa os dados em paralelo em várias GPUs e os sincroniza após cada etapa de treinamento. Usamos o FSDP para fatiar o estado do otimizador e o gradiente para o Llama 3, mas para o fatiamento do modelo não fatiamos novamente após a computação direta para evitar a comunicação adicional de coleta completa durante a passagem inversa.

Utilização da GPU.Ajustando cuidadosamente a configuração paralela, o hardware e o software, conseguimos uma utilização de FLOPs do modelo BF16 (MFU; Chowdhery et al. (2023)) de 38-43%. As configurações mostradas na Tabela 4 indicam que, em comparação com 43% em GPUs de 8K e DP=64, a queda na MFU em GPUs de 16K e DP=128 para 41% se deve à necessidade de reduzir o tamanho do lote de cada grupo de DP para manter constante o número de tokens globais durante o treinamento.

Simplificar os aprimoramentos paralelos.Encontramos vários desafios em nossa implementação atual:

- Limitações de tamanho de lote.As implementações atuais colocam um limite no tamanho do lote suportado por GPU, exigindo que ele seja divisível pelo número de estágios do pipeline. Para o exemplo da Fig. 6, o paralelismo do pipeline para o agendamento depth-first (DFS) (Narayanan et al. (2021)) requer N = PP = 4, enquanto o agendamento breadth-first (BFS; Lamy-Poirier (2023)) requer N = M, em que M é o número total de microbatches e N é o número de microbatches consecutivos no mesmo estágio na direção direta ou reversa. No entanto, o pré-treinamento geralmente exige flexibilidade no dimensionamento dos lotes.

- Desequilíbrio de memória.As implementações paralelas em pipeline existentes levam a um consumo desequilibrado de recursos. O primeiro estágio consome mais memória devido à incorporação e ao aquecimento de micro lotes.

- Os cálculos não estão equilibrados. Após a última camada do modelo, precisamos computar as saídas e as perdas, o que torna essa fase um gargalo em termos de latência de execução. em que Di é o índice da i-ésima dimensão paralela. Neste exemplo, a GPU0 [TP0, CP0, PP0, DP0] e a GPU1 [TP1, CP0, PP0, DP0] estão no mesmo grupo TP, a GPU0 e a GPU2 estão no mesmo grupo CP, a GPU0 e a GPU4 estão no mesmo grupo PP e a GPU0 e a GPU8 estão no mesmo grupo DP.

Para resolver esses problemas, modificamos a abordagem de programação do pipeline, conforme mostrado na Figura 6, que permite uma configuração flexível de N - neste caso, N = 5, o que permite a execução de qualquer número de microbatches em cada lote. Isso nos permite:

(1) Quando houver um limite de tamanho de lote, execute menos microbatches do que o número de estágios; ou

(2) Executar mais microbatches para ocultar a comunicação ponto a ponto e encontrar a melhor eficiência de comunicação e memória entre o Depth-First Scheduling (DFS) e o Breadth-First Scheduling (BFS). Para equilibrar o pipeline, reduzimos uma camada do Transformer do primeiro estágio e do último estágio, respectivamente. Isso significa que o primeiro bloco de modelo no primeiro estágio tem apenas a camada de incorporação, enquanto o último bloco de modelo no último estágio tem apenas a projeção de saída e o cálculo de perda.

Para reduzir as bolhas de pipeline, usamos uma abordagem de programação intercalada (Narayanan et al., 2021) em uma hierarquia de pipeline com V estágios de pipeline. A taxa geral de bolhas do pipeline é PP-1 V * M . Além disso, empregamos comunicação assíncrona ponto a ponto, o que acelera significativamente o treinamento, especialmente nos casos em que as máscaras de documentos introduzem desequilíbrios computacionais adicionais. Habilitamos o TORCH_NCCL_AVOID_RECORD_STREAMS para reduzir o uso de memória da comunicação ponto a ponto assíncrona. Por fim, para reduzir os custos de memória, com base em uma análise detalhada da alocação de memória, liberamos proativamente tensores que não serão usados para cálculos futuros, inclusive tensores de entrada e saída para cada estágio do pipeline. ** Com essas otimizações, conseguimos executar os tensores de 8K sem o uso de pontos de verificação de ativação, sem o uso de pontos de verificação de ativação. token sequências para o pré-treinamento da Llama 3.

A paralelização de contexto é usada para sequências longas. Aproveitamos a paralelização de contexto (CP) para melhorar a eficiência da memória ao dimensionar os comprimentos de contexto do Llama 3 e para permitir o treinamento em sequências muito longas de até 128K. Na CP, particionamos as dimensões da sequência, especificamente dividimos a sequência de entrada em blocos de 2 × CP, de modo que cada nível de CP receba dois blocos para melhorar o balanceamento de carga. O i-ésimo nível de CP recebe o i-ésimo bloco e (2 × CP -1 -i) blocos.

Diferentemente das implementações de CP existentes que sobrepõem a comunicação e a computação em uma estrutura em anel (Liu et al., 2023a), nossa implementação de CP emprega uma abordagem baseada em all-gather que primeiro agrega globalmente o tensor de valor-chave (K, V) e, em seguida, calcula as saídas de atenção dos blocos de tensor de consulta local (Q). Embora a latência da comunicação all-gather esteja no caminho crítico, ainda adotamos essa abordagem por dois motivos principais:

(1) É mais fácil e mais flexível oferecer suporte a diferentes tipos de máscaras de atenção, como máscaras de documentos, na atenção CP baseada em coleta total;

(2) A latência de coleta total exposta é pequena porque o tensor K e V da comunicação é muito menor do que o tensor Q, devido ao uso de GQA (Ainslie et al., 2023). Como resultado, a complexidade de tempo do cálculo de atenção é uma ordem de grandeza maior do que a de coleta total (O(S²) versus O(S), em que S denota o comprimento da sequência na máscara causal completa), tornando a sobrecarga de coleta total insignificante.

Configuração paralela com reconhecimento de rede.A ordem das dimensões de paralelização [TP, CP, PP, DP] é otimizada para a comunicação de rede. A camada mais interna de paralelização exige a maior largura de banda de rede e a menor latência e, portanto, geralmente é restrita ao mesmo servidor. A camada mais externa de paralelização pode abranger redes com vários saltos e deve ser capaz de tolerar uma latência de rede mais alta. Portanto, com base nos requisitos de largura de banda e latência da rede, classificamos as dimensões de paralelização na ordem de [TP, CP, PP, DP]. O DP (ou seja, FSDP) é a camada mais externa de paralelização, pois pode tolerar uma latência de rede mais longa por meio da pré-busca assíncrona dos pesos do modelo de fatiamento e da redução do gradiente. Determinar a configuração ideal de paralelização com o mínimo de sobrecarga de comunicação e, ao mesmo tempo, evitar o estouro de memória da GPU é um desafio. Desenvolvemos um estimador de consumo de memória e uma ferramenta de projeção de desempenho que nos ajudou a explorar várias configurações de paralelização, prever o desempenho geral do treinamento e identificar lacunas de memória com eficiência.

Estabilidade numérica.Ao comparar as perdas de treinamento entre diferentes configurações paralelas, corrigimos alguns problemas numéricos que afetam a estabilidade do treinamento. Para garantir a convergência do treinamento, usamos a acumulação de gradiente FP32 durante o cálculo reverso de vários micro-lotes e reduzimos os gradientes de dispersão usando FP32 entre os trabalhadores paralelos de dados no FSDP. Para tensores intermediários que são usados várias vezes em cálculos avançados, como saídas de codificadores visuais, o gradiente reverso também é acumulado em FP32.

3.3.3 Comunicações coletivas

A biblioteca de comunicação coletiva da Llama 3 é baseada em uma ramificação da biblioteca NCCL da Nvidia chamada NCCLX. A NCCLX melhora muito o desempenho da NCCL, especialmente para redes de alta latência. Lembre-se de que a ordem das dimensões paralelas é [TP, CP, PP, DP], em que DP corresponde a FSDP, e que as dimensões paralelas mais externas, PP e DP, podem se comunicar em uma rede de vários saltos com latências de dezenas de microssegundos. As operações de comunicação coletiva all-gather e reduce-scatter da NCCL original são usadas no FSDP, enquanto a comunicação ponto a ponto é usada para o PP, que exige fragmentação de dados e replicação de dados em etapas. Essa abordagem leva a algumas das seguintes ineficiências:

- Um grande número de pequenas mensagens de controle precisa ser trocado pela rede para facilitar a transferência de dados;

- Operações adicionais de cópia de memória;

- Use ciclos adicionais da GPU para comunicação.

Para o treinamento da Llama 3, resolvemos algumas dessas ineficiências adaptando a fragmentação e as transferências de dados à latência da nossa rede, que pode chegar a dezenas de microssegundos em grandes clusters. Também permitimos que pequenas mensagens de controle passem pela nossa rede com prioridade mais alta, evitando especificamente o bloqueio do chefe de fila em switches de núcleo com buffer profundo.

Nosso trabalho em andamento para as futuras versões do Llama inclui mudanças mais profundas no NCCLX para resolver totalmente todos os problemas acima.

3.3.4 Confiabilidade e desafios operacionais

A complexidade e os possíveis cenários de falha do treinamento da GPU de 16K excedem os dos clusters de CPU maiores em que operamos. Além disso, a natureza síncrona do treinamento o torna menos tolerante a falhas - uma única falha de GPU pode exigir a reinicialização de todo o trabalho. Apesar desses desafios, no caso da Llama 3, conseguimos tempos de treinamento efetivos superiores a 90% e, ao mesmo tempo, oferecemos suporte à manutenção automatizada do cluster (por exemplo, atualizações de firmware e do kernel do Linux (Vigraham e Leonhardi, 2024)), o que resultou em pelo menos uma interrupção de treinamento por dia.

O tempo de treinamento efetivo é a quantidade de tempo gasto em treinamento efetivo durante o tempo decorrido. Durante o instantâneo de 54 dias de pré-treinamento, tivemos um total de 466 interrupções operacionais. Dessas, 47 foram interrupções planejadas devido a operações de manutenção automatizadas (por exemplo, upgrades de firmware ou operações iniciadas pelo operador, como atualizações de configuração ou de conjunto de dados). As 419 restantes foram interrupções imprevistas, que estão categorizadas na Tabela 5. Aproximadamente 78% das interrupções imprevistas foram atribuídas a problemas de hardware identificados, como falhas de GPU ou de componentes do host, ou suspeitas de problemas relacionados a hardware, como corrupção silenciosa de dados e eventos de manutenção não planejados de hosts individuais. Apesar do grande número de falhas, apenas três grandes intervenções manuais foram necessárias durante esse período e os problemas restantes foram resolvidos por meio de automação.

Para melhorar o tempo de treinamento efetivo, reduzimos o tempo de inicialização e de checkpointing do trabalho e desenvolvemos ferramentas para diagnóstico rápido e solução de problemas. Utilizamos amplamente o gravador de voo NCCL integrado do PyTorch (Ansel et al., 2024) - um recurso que captura metadados coletivos e traços de pilha em um buffer em anel, o que nos permite diagnosticar rapidamente problemas de travamento e desempenho em escala, especialmente no caso de aspectos do aspectos do NCCLX. Com ele, podemos registrar com eficiência os eventos de comunicação e as durações de cada operação coletiva e despejar automaticamente os dados de rastreamento no caso de um tempo limite de watchdog ou heartbeat do NCCLX. Com as alterações de configuração on-line (Tang et al., 2015), podemos habilitar seletivamente operações de rastreamento mais intensivas em termos de computação e coleta de metadados sem liberações de código ou reinícios de trabalho. Os problemas de depuração no treinamento em larga escala são complicados pelo uso misto de NVLink e RoCE em nossa rede. Normalmente, as transferências de dados são realizadas pelo NVLink por meio de operações de carga/armazenamento emitidas pelo kernel CUDA, e a falha de uma GPU remota ou de uma conexão NVLink geralmente se manifesta como uma operação de carga/armazenamento paralisada no kernel CUDA sem retornar um código de erro explícito. PyTorch acesse o estado interno do NCCLX e rastreie as informações relevantes. Embora não seja possível evitar completamente os travamentos devido a falhas no NVLink, nosso sistema monitora o estado das bibliotecas de comunicação e automaticamente atinge o tempo limite quando esses travamentos são detectados. Além disso, o NCCLX rastreia a atividade do kernel e da rede para cada comunicação NCCLX e fornece um instantâneo do estado interno do coletivo NCCLX com falha, incluindo transferências de dados concluídas e não concluídas entre todas as fileiras. Analisamos esses dados para depurar problemas de extensão do NCCLX.

Às vezes, problemas de hardware podem resultar em retardatários ainda em execução, mas lentos, que são difíceis de detectar. Mesmo que haja apenas um retardatário, ele pode deixar milhares de outras GPUs mais lentas, geralmente na forma de operação normal, mas com comunicação lenta. Desenvolvemos ferramentas para priorizar comunicações potencialmente problemáticas de grupos selecionados de processos. Ao investigar apenas alguns dos principais suspeitos, muitas vezes conseguimos identificar efetivamente os retardatários.

Uma observação interessante é o impacto dos fatores ambientais no desempenho do treinamento em larga escala. Para o Llama 3 405B, notamos flutuações de rendimento de 1-2% com base na variação de tempo. Essa flutuação é causada pelas temperaturas mais altas do meio-dia que afetam a tensão dinâmica da GPU e o dimensionamento da frequência. Durante o treinamento, dezenas de milhares de GPUs podem aumentar ou diminuir simultaneamente o consumo de energia, por exemplo, devido ao fato de que todas as GPUs estão aguardando a conclusão de um ponto de verificação ou de uma comunicação coletiva, ou que um trabalho de treinamento inteiro seja iniciado ou encerrado. Quando isso acontece, pode levar a flutuações transitórias no consumo de energia dentro do data center da ordem de dezenas de megawatts, o que amplia os limites da rede elétrica. Esse é um desafio contínuo à medida que dimensionamos o treinamento para modelos futuros e ainda maiores da Llama.

3.4 Programas de treinamento

A receita de pré-treinamento do Llama 3 405B contém três etapas principais:

(1) pré-treinamento inicial, (2) pré-treinamento de contexto longo e (3) recozimento. Cada um desses três estágios é descrito abaixo. Usamos receitas semelhantes para pré-treinar os modelos 8B e 70B.

3.4.1 Pré-treinamento inicial

Pré-treinamos o modelo Llama 3 405B usando um esquema de taxa de aprendizado de cosseno com uma taxa de aprendizado máxima de 8 × 10-⁵, aquecido linearmente até 8.000 etapas e decaído para 8 × 10-⁷ após 1.200.000 etapas de treinamento. Para melhorar a estabilidade do treinamento, usamos um tamanho de lote menor no início do treinamento e, posteriormente, aumentamos o tamanho do lote para melhorar a eficiência. Especificamente, inicialmente temos um tamanho de lote de 4 milhões de tokens e um comprimento de sequência de 4.096. Após o pré-treinamento de 252 milhões de tokens, dobramos o tamanho do lote e o comprimento da sequência para 8 milhões de sequências e 8.192 tokens, respectivamente. Esse método de treinamento é muito estável: ocorrem pouquíssimos picos de perda e não é necessária nenhuma intervenção para corrigir desvios no treinamento do modelo.

Ajuste das combinações de dados. Durante o treinamento, fizemos vários ajustes na combinação de dados de pré-treinamento para melhorar o desempenho do modelo em tarefas específicas de downstream. Em especial, aumentamos a proporção de dados que não estavam em inglês durante o pré-treinamento para melhorar o desempenho multilíngue da Llama 3. Também aumentamos a proporção de dados matemáticos para aprimorar o raciocínio matemático do modelo, adicionamos dados de rede mais recentes nos estágios posteriores do pré-treinamento para atualizar os limites de conhecimento do modelo e reduzimos a proporção de um subconjunto de dados que foi posteriormente identificado como sendo de qualidade inferior.

3.4.2 Pré-treinamento de contexto longo

No estágio final do pré-treinamento, treinamos sequências longas para suportar janelas de contexto de até 128.000 tokens. Não treinamos sequências longas antes porque o cálculo na camada de autoatenção aumenta quadraticamente com o comprimento da sequência. Aumentamos gradativamente o comprimento do contexto suportado e fazemos o pré-treinamento depois que o modelo se adaptou com sucesso ao aumento do comprimento do contexto. Avaliamos a adaptação bem-sucedida medindo ambos:

(1) Se o desempenho do modelo em avaliações de contexto curto foi totalmente recuperado;

(2) Se o modelo pode resolver perfeitamente a tarefa "agulha em um palheiro" até esse tamanho. No pré-treinamento do Llama 3 405B, aumentamos gradativamente o comprimento do contexto em seis estágios, começando com uma janela de contexto inicial de 8.000 tokens e, por fim, chegando a uma janela de contexto de 128.000 tokens. Essa longa fase de pré-treinamento de contexto usou aproximadamente 800 bilhões de tokens de treinamento.

3.4.3 Recozimento

Durante o pré-treinamento dos últimos 40 milhões de tokens, recozemos a taxa de aprendizado linearmente para 0, mantendo um comprimento de contexto de 128 mil tokens. Durante essa fase de recozimento, também ajustamos a combinação de dados para aumentar o tamanho da amostra de fontes de dados de altíssima qualidade; consulte a Seção 3.1.3. Por fim, calculamos a média dos pontos de verificação do modelo (média de Polyak (1991)) durante o recozimento para gerar o modelo pré-treinado final.

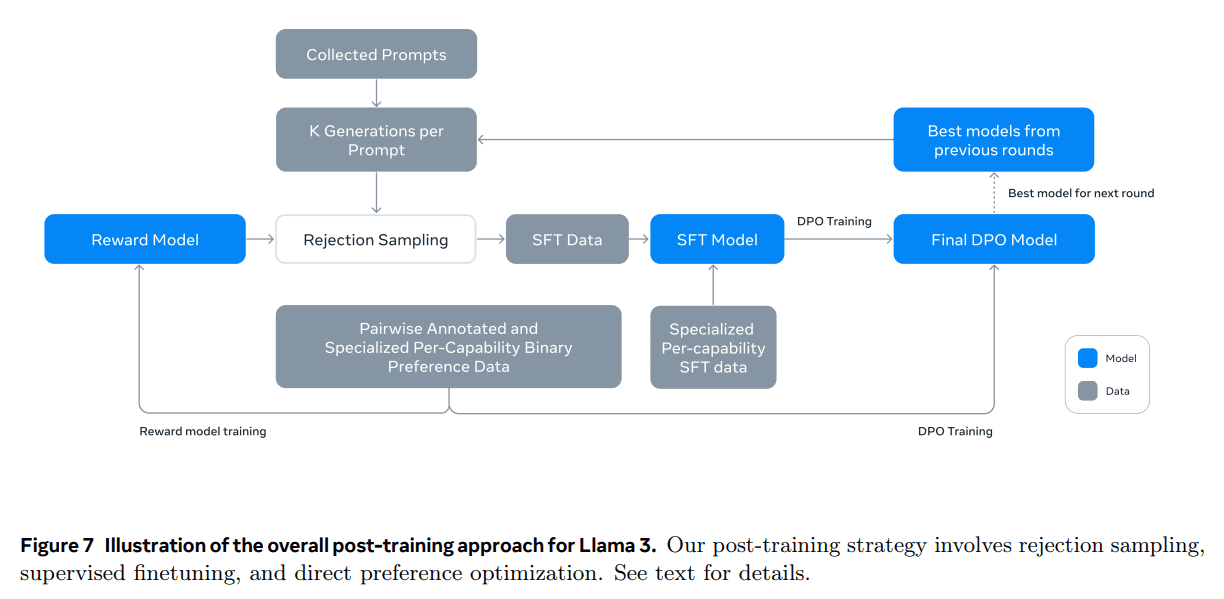

4 Treinamento de acompanhamento

Geramos e alinhamos os modelos da Llama 3 aplicando várias rodadas de treinamento de acompanhamento. Esses treinamentos de acompanhamento são baseados em pontos de verificação pré-treinados e incorporam feedback humano para o alinhamento do modelo (Ouyang et al., 2022; Rafailov et al., 2024). Cada rodada de treinamento de acompanhamento consistiu em ajuste fino supervisionado (SFT), seguido de otimização de preferência direta (DPO; Rafailov et al., 2024) usando exemplos gerados por meio de anotação ou síntese manual. Descrevemos nossa modelagem de treinamento subsequente e os métodos de dados nas Seções 4.1 e 4.2, respectivamente. Além disso, fornecemos mais detalhes sobre estratégias personalizadas de agrupamento de dados na Seção 4.3 para aprimorar o modelo em termos de inferência, recursos de programação, fatoração, suporte multilíngue, uso de ferramentas, contextos longos e aderência a instruções precisas.

4.1 Modelagem

A base da nossa estratégia de pós-treinamento é um modelo de recompensa e um modelo de linguagem. Primeiro, treinamos um modelo de recompensa sobre os pontos de verificação de pré-treinamento usando dados de preferência rotulados por humanos (consulte a Seção 4.1.2). Em seguida, ajustamos os pontos de verificação de pré-treinamento com o ajuste fino supervisionado (SFT; consulte a Seção 4.1.3) e os alinhamos ainda mais com os pontos de verificação usando a otimização direta de preferências (DPO; consulte a Seção 4.1.4). Esse processo é mostrado na Figura 7. Salvo indicação em contrário, nosso processo de modelagem se aplica ao Llama 3 405B, ao qual nos referimos como Llama 3 405B para simplificar.

4.1.1 Formato do diálogo de bate-papo

Para adaptar um Modelo de Linguagem Grande (LLM) para a interação humano-computador, precisamos definir um protocolo de diálogo de bate-papo que permita ao modelo entender os comandos humanos e executar tarefas de diálogo. Em comparação com seu antecessor, o Llama 3 tem novos recursos, como o uso de ferramentas (Seção 4.3.5), o que pode exigir a geração de várias mensagens em uma única rodada de diálogo e o envio delas para diferentes locais (por exemplo, usuário, ipython). Para dar suporte a isso, criamos um novo protocolo de bate-papo com várias mensagens que usa uma variedade de tokens especiais de cabeçalho e de terminação. Os tokens de cabeçalho são usados para indicar a origem e o destino de cada mensagem em um diálogo. Da mesma forma, os marcadores de término indicam quando é a vez de o humano e a IA alternarem a fala.

4.1.2 Modelagem de recompensas

Treinamos um modelo de recompensa (RM) que abrange diferentes habilidades e o construímos com base em pontos de verificação pré-treinados. O objetivo do treinamento é o mesmo da Llama 2, mas removemos o termo marginal da função de perda porque observamos uma melhoria reduzida à medida que o tamanho dos dados aumenta. Como na Llama 2, usamos todos os dados de preferência para modelagem de recompensa depois de filtrar as amostras com respostas semelhantes.

Além dos pares de preferências de resposta padrão (selecionada, rejeitada), a anotação cria uma terceira "resposta editada" para algumas dicas, em que a resposta selecionada do par é editada ainda mais para ser melhorada (consulte a Seção 4.2.1). Assim, cada amostra de classificação de preferências tem duas ou três respostas que são claramente classificadas (editada > selecionada > rejeitada). Durante o treinamento, concatenamos as dicas e as várias respostas em uma linha e randomizamos as respostas. Essa é uma aproximação do cenário padrão de computação de pontuações, colocando as respostas em linhas separadas, mas em nossos experimentos de ablação, essa abordagem melhora a eficiência do treinamento sem perda de precisão.

4.1.3 Ajuste fino da supervisão

As pistas rotuladas por humanos são primeiro rejeitadas para amostragem usando o modelo de recompensa, cuja metodologia detalhada é descrita na Seção 4.2. Combinamos esses dados de amostragem de rejeição com outras fontes de dados (incluindo dados sintéticos) para ajustar o modelo de linguagem pré-treinado usando perdas de entropia cruzada padrão, com o objetivo de prever a marcação de destino (enquanto mascaramos as perdas da marcação de cued). Consulte a Seção 4.2 para obter mais detalhes sobre a combinação de dados. Embora muitos dos alvos de treinamento sejam gerados pelo modelo, nos referimos a essa fase como ajuste fino supervisionado (SFT; Wei et al. 2022a; Sanh et al. 2022; Wang et al. 2022b).

Nosso modelo máximo é ajustado com uma taxa de aprendizado de 1e-5 em 8,5 mil a 9 mil etapas. Consideramos que essas configurações de hiperparâmetros são adequadas para diferentes rodadas e combinações de dados.

4.1.4 Otimização de preferência direta

Treinamos ainda mais nossos modelos SFT para o alinhamento de preferências humanas usando a otimização direta de preferências (DPO; Rafailov et al., 2024). No treinamento, usamos principalmente os lotes de dados de preferência mais recentes coletados dos modelos de melhor desempenho na rodada anterior de alinhamento. Como resultado, nossos dados de treinamento correspondem melhor à distribuição dos modelos de estratégia otimizados em cada rodada. Também exploramos algoritmos de estratégia como o PPO (Schulman et al., 2017), mas descobrimos que o DPO requer menos computação e tem melhor desempenho em modelos de grande escala, especialmente em benchmarks de adesão a instruções como o IFEval (Zhou et al., 2023).

Para o Llama 3, usamos uma taxa de aprendizado de 1e-5 e definimos o hiperparâmetro β como 0,1. Além disso, aplicamos as seguintes modificações algorítmicas ao DPO:

- Mascaramento de marcadores de formatação em perdas de DPO. Mascaramos os marcadores de formato especial (incluindo marcadores de cabeçalho e de terminação descritos na Seção 4.1.1) das respostas selecionadas e rejeitadas para estabilizar o treinamento do OPD. Observamos que o envolvimento desses marcadores na perda pode levar a um comportamento indesejado do modelo, como a duplicação da cauda ou a geração repentina de marcadores de terminação. Nossa hipótese é que isso se deve à natureza contrastante da perda de OPD - a presença de marcadores comuns nas respostas selecionadas e rejeitadas pode levar a objetivos de aprendizado conflitantes, pois o modelo precisa aumentar e diminuir simultaneamente a probabilidade desses marcadores.

- Regularização usando perdas NLL: o Acrescentamos um termo de perda adicional de log-likelihood negativo (NLL) às sequências selecionadas com um fator de escala de 0,2, semelhante ao de Pang et al. (2024). Isso ajuda a estabilizar ainda mais o treinamento de DPO, mantendo o formato necessário para a geração e evitando que a probabilidade de logaritmo das respostas selecionadas diminua (Pang et al., 2024; Pal et al., 2024).

4.1.5 Cálculo da média do modelo

Por fim, calculamos a média dos modelos obtidos em experimentos usando várias versões de dados ou hiperparâmetros em cada estágio de RM, SFT ou DPO (Izmailov et al. 2019; Wortsman et al. 2022; Li et al. 2022). Apresentamos informações estatísticas sobre os dados de preferência humana coletados internamente e usados para o condicionamento da Llama 3. Pedimos aos avaliadores que participassem de várias rodadas de diálogo com o modelo e comparamos as respostas de cada rodada. Durante o pós-processamento, dividimos cada diálogo em vários exemplos, cada um contendo um prompt (incluindo o diálogo anterior, se disponível) e uma resposta (por exemplo, uma resposta que foi selecionada ou rejeitada).

4.1.6 Rodadas de iteração

Seguindo a Llama 2, aplicamos a metodologia acima em seis rodadas de iterações. Em cada rodada, coletamos novos dados de rotulagem de preferências e ajuste fino (SFT) e coletamos dados sintéticos do modelo mais recente.

4.2 Dados pós-treinamento

A composição dos dados pós-treinamento desempenha um papel fundamental na utilidade e no comportamento do modelo de linguagem. Nesta seção, discutimos nosso procedimento de anotação e coleta de dados de preferência (Seção 4.2.1), a composição dos dados do SFT (Seção 4.2.2) e os métodos de controle e limpeza da qualidade dos dados (Seção 4.2.3).

4.2.1 Preferências

Nosso processo de rotulagem de dados de preferência é semelhante ao da Llama 2. Após cada rodada, implantamos vários modelos para anotação e coletamos amostras de duas respostas de modelos diferentes para cada dica do usuário. Esses modelos podem ser treinados usando diferentes esquemas de combinação e alinhamento de dados, resultando em diferentes pontos fortes de capacidade (por exemplo, experiência em código) e maior diversidade de dados. Pedimos aos anotadores que classificassem as pontuações de preferência em um dos quatro níveis com base em seu nível de preferência: significativamente melhor, melhor, ligeiramente melhor ou ligeiramente melhor.

Também incluímos uma etapa de edição após a ordenação de preferências para incentivar o anotador a refinar ainda mais a resposta preferida. O anotador pode editar diretamente a resposta selecionada ou usar o modelo de sugestão de feedback para refinar sua própria resposta. Como resultado, alguns dados de preferência têm três respostas ordenadas (Editar > Selecionar > Rejeitar).

As estatísticas de anotação de preferências que usamos para o treinamento do Llama 3 são relatadas na Tabela 6. O inglês geral abrange várias subcategorias, como perguntas e respostas baseadas em conhecimento ou seguimento de instruções precisas, que estão além do escopo de habilidades específicas. Em comparação com a Llama 2, observamos um aumento na duração média dos prompts e das respostas, o que sugere que estamos treinando a Llama 3 em tarefas mais complexas. Além disso, implementamos processos de análise de qualidade e avaliação manual para avaliar rigorosamente os dados coletados, o que nos permitiu refinar os prompts e fornecer feedback sistemático e prático aos anotadores. Por exemplo, à medida que a Llama 3 for melhorando após cada rodada, aumentaremos a complexidade das dicas para atingir as áreas em que o modelo está atrasado.

Em cada rodada de treinamento tardio, usamos todos os dados de preferência disponíveis no momento para a modelagem de recompensas e apenas os lotes mais recentes de cada capacidade para o treinamento de DPO. Tanto para a modelagem de recompensas quanto para o DPO, treinamos com amostras rotuladas como "resposta de seleção significativamente melhor ou melhor" e descartamos amostras com respostas semelhantes.

4.2.2 Dados SFT

Nossos dados de ajuste fino vêm principalmente das seguintes fontes:

- Dicas de nossa coleção anotada manualmente e sua rejeição de respostas de amostragem

- Dados sintéticos para recursos específicos (consulte a Seção 4.3 para obter detalhes)

- Pequena quantidade de dados rotulados manualmente (consulte a seção 4.3 para obter detalhes)

À medida que avançávamos em nosso ciclo de pós-treinamento, desenvolvemos variantes mais poderosas do Llama 3 e as usamos para coletar conjuntos de dados maiores para abranger uma ampla gama de recursos complexos. Nesta seção, discutimos os detalhes do processo de amostragem de rejeição e a composição geral da mistura de dados SFT final.

Recusa de amostragem.Na Amostragem de Rejeição (RS), para cada pista que coletamos durante a anotação manual (Seção 4.2.1), coletamos amostras de K saídas da estratégia de modelagem de bate-papo mais recente (normalmente os melhores pontos de verificação de execução da iteração pós-treinamento anterior ou os melhores pontos de verificação de execução para uma competência específica) e usamos nosso modelo de recompensa para selecionar o melhor candidato, de acordo com Bai et al. (2022). Em estágios posteriores do pós-treinamento, introduzimos dicas do sistema para orientar as respostas de RS de acordo com um tom, estilo ou formato desejado, que pode variar para diferentes habilidades.

Para melhorar a eficiência da amostragem de rejeição, empregamos o PagedAttention (Kwon et al., 2023). O PagedAttention melhora a eficiência da memória por meio da alocação dinâmica do cache de valores-chave. Ele suporta um comprimento de saída arbitrário agendando dinamicamente as solicitações com base na capacidade atual do cache. Infelizmente, isso introduz o risco de troca quando a memória se esgota. Para eliminar essa sobrecarga de troca, definimos um comprimento máximo de saída e só executamos solicitações se houver memória suficiente para manter saídas desse comprimento. O pagedAttention também nos permite compartilhar a página de cache de valor-chave sugerida em todas as saídas correspondentes. No geral, isso resultou em um aumento de mais de 2x na taxa de transferência durante a amostragem de rejeição.

Composição de dados agregados.A Tabela 7 mostra as estatísticas de cada uma das categorias amplas de dados em nossa combinação de "utilidade". Embora os dados de SFT e de preferências contenham domínios sobrepostos, eles são curados de forma diferente, resultando em estatísticas de contagem diferentes. Na Seção 4.2.3, descrevemos as técnicas usadas para categorizar o assunto, a complexidade e a qualidade das nossas amostras de dados. Em cada rodada de pós-treinamento, ajustamos cuidadosamente nossa combinação geral de dados para ajustar o desempenho em vários eixos para uma ampla gama de benchmarks. Nossa combinação final de dados será iterada várias vezes para determinadas fontes de alta qualidade e reduzida para outras.

4.2.3 Processamento de dados e controle de qualidade

Considerando que a maior parte dos nossos dados de treinamento é gerada por modelos, é necessária uma limpeza cuidadosa e um controle de qualidade.

Limpeza de dados: Nos estágios iniciais, observamos muitos padrões indesejados nos dados, como o uso excessivo de emoticons ou pontos de exclamação. Portanto, implementamos uma série de estratégias de modificação e exclusão de dados baseadas em regras para filtrar ou remover dados problemáticos. Por exemplo, para atenuar o problema da entonação excessivamente apologética, identificamos frases usadas em excesso (por exemplo, "I'm sorry" ou "I apologise") e equilibramos cuidadosamente a proporção de tais amostras no conjunto de dados.

Poda de dados: Também aplicamos várias técnicas baseadas em modelos para remover amostras de treinamento de baixa qualidade e melhorar o desempenho geral do modelo:

- Classificação do assunto: Primeiro, ajustamos o Llama 3 8B em um classificador de tópicos e analisamos todos os dados para categorizá-los em categorias de granulação grossa ("Raciocínio matemático") e categorias de granulação fina ("Geometria e trigonometria").

- Classificação de qualidade: Usamos o modelo de recompensa e os sinais baseados em Llama para obter pontuações de qualidade para cada amostra. Para as pontuações baseadas em RM, consideramos os dados com pontuações no quartil mais alto como de alta qualidade. Para as pontuações baseadas na Llama, solicitamos que os pontos de verificação da Llama 3 pontuassem os dados de inglês geral em três níveis (precisão, aderência à instrução e tom/apresentação) e os dados de código em dois níveis (reconhecimento de erros e intenção do usuário) e consideramos as amostras que receberam as pontuações mais altas como dados de alta qualidade. As pontuações baseadas em RM e Llama têm altas taxas de conflito, e descobrimos que a combinação desses sinais resultou na melhor recuperação para o conjunto de testes internos. Por fim, selecionamos os exemplos que são rotulados como de alta qualidade pelos filtros baseados em RM ou Llama.

- Classificação de dificuldade: Como também estávamos interessados em priorizar exemplos de modelos mais complexos, pontuamos os dados usando duas métricas de dificuldade: o Instag (Lu et al., 2023) e a pontuação baseada em Llama. Para o Instag, solicitamos à Llama 3 70B que realizasse a rotulagem de intenção nas dicas de SFT, em que mais intenção implica maior complexidade. Também pedimos à Llama 3 que medisse a dificuldade do diálogo em três níveis (Liu et al., 2024c).

- Desênfase semântica: Por fim, realizamos a desduplicação semântica (Abbas et al., 2023; Liu et al., 2024c). Primeiro, agrupamos diálogos completos usando o RoBERTa (Liu et al., 2019b) e classificamos por pontuação de qualidade × pontuação de dificuldade em cada agrupamento. Em seguida, realizamos uma seleção gulosa iterando sobre todos os exemplos classificados, mantendo apenas aqueles cuja semelhança máxima de cosseno com os exemplos vistos nos clusters até o momento é menor que um limite.

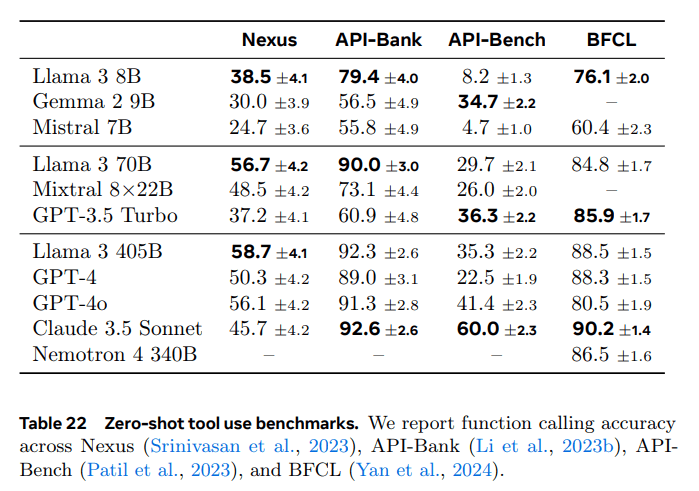

4.3 Capacidade

Em particular, destacamos alguns dos esforços feitos para aprimorar competências específicas, como manuseio de códigos (Seção 4.3.1), multilinguismo (Seção 4.3.2), habilidades matemáticas e de raciocínio (Seção 4.3.3), contextualização longa (Seção 4.3.4), uso de ferramentas (Seção 4.3.5), factualidade (Seção 4.3.6) e controlabilidade (Seção 4.3.7).

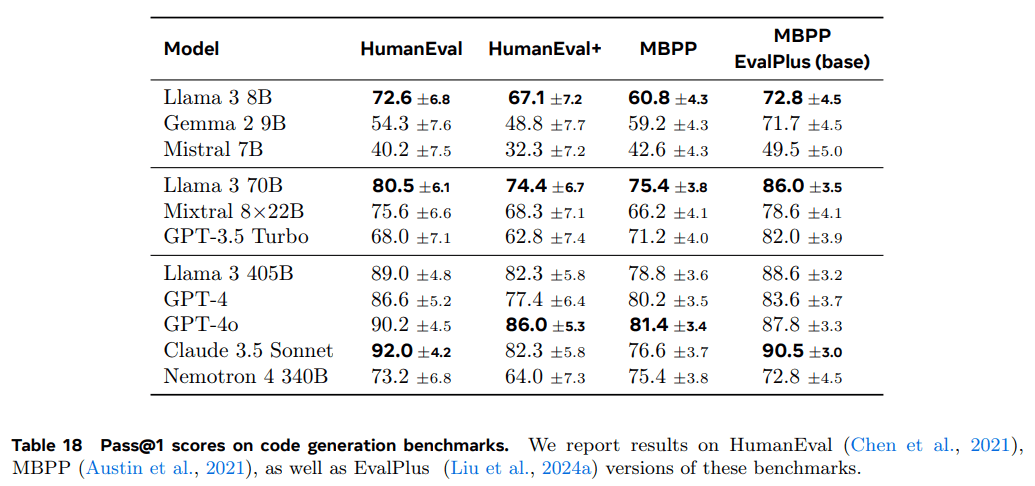

4.3.1 Código

desde (uma época) Copiloto e Codex (Chen et al., 2021) foram lançados, os LLMs para código receberam muita atenção. Os desenvolvedores agora usam esses modelos extensivamente para gerar trechos de código, depurar, automatizar tarefas e melhorar a qualidade do código. Para o Llama 3, nosso objetivo é aprimorar e avaliar os recursos de geração, documentação, depuração e revisão de código para as seguintes linguagens de programação prioritárias: Python, Java, JavaScript, C/C++, TypeScript, Rust, PHP, HTML/CSS, SQL e bash/shell. treinamento de especialistas em código, geração de dados sintéticos para SFT, mudança para formatos aprimorados por meio de avisos do sistema e criação de filtros de qualidade para remover amostras ruins dos dados de treinamento para aprimorar esses recursos de codificação.

Treinamento especializado.Treinamos um especialista em código e o usamos em várias rodadas subsequentes de pós-treinamento para coletar anotações de código humano de alta qualidade. Isso foi obtido por meio da ramificação da execução principal do pré-treinamento e da continuação do pré-treinamento em uma combinação de tokens de 1T que eram principalmente dados de código (>85%). O pré-treinamento contínuo em dados específicos de domínio demonstrou ser eficaz para melhorar o desempenho em domínios específicos (Gururangan et al., 2020). Seguimos uma receita semelhante à do CodeLlama (Rozière et al., 2023). Nos últimos milhares de etapas do treinamento, realizamos o ajuste fino de contexto longo (LCFT) em uma combinação de alta qualidade de dados de código em nível de repositório, estendendo o comprimento do contexto do especialista para 16 mil tokens. Por fim, seguimos uma receita de modelagem pós-treinamento semelhante à descrita na Seção 4.1 para alinhar o modelo, mas usando uma combinação de dados de SFT e DPO que são principalmente específicos de código. O modelo também é usado para amostragem de rejeição de dicas de codificação (Seção 4.2.2).

Geração de dados sintéticos.Durante o desenvolvimento, identificamos os principais problemas com a geração de código, incluindo dificuldade em seguir instruções, erros de sintaxe de código, geração incorreta de código e dificuldade em corrigir erros. Embora anotações humanas densas pudessem teoricamente resolver esses problemas, a geração de dados sintéticos oferece uma abordagem complementar que é mais barata, melhor dimensionada e não é limitada pelo nível de especialização dos anotadores.

Portanto, usamos o Llama 3 e o Code Expert para gerar um grande número de diálogos sintéticos de SFT. Descrevemos três métodos de alto nível para gerar dados de código sintético. No total, usamos mais de 2,7 milhões de exemplos sintéticos durante o SFT.

1. Geração de dados sintéticos: implementação de feedback.Os modelos 8B e 70B apresentam melhorias significativas de desempenho em dados de treinamento gerados por modelos maiores e mais competentes. No entanto, nossos experimentos preliminares sugerem que treinar apenas o Llama 3 405B em seus próprios dados gerados não ajuda (ou até mesmo prejudica o desempenho). Para resolver essa limitação, introduzimos o feedback de execução como uma fonte de verdade que permite que o modelo aprenda com seus erros e permaneça no caminho certo. Em particular, geramos um conjunto de dados de aproximadamente um milhão de diálogos de código sintético usando o seguinte procedimento:

- Geração de descrição de problemas:Primeiro, geramos um grande conjunto de descrições de problemas de programação que abrange uma variedade de tópicos (incluindo distribuições de cauda longa). Para alcançar essa diversidade, coletamos aleatoriamente trechos de código de várias fontes e solicitamos ao modelo que gerasse problemas de programação com base nesses exemplos. Isso nos permitiu aproveitar uma ampla gama de tópicos e criar um conjunto abrangente de descrições de problemas (Wei et al., 2024).

- Geração de soluções:Em seguida, solicitamos ao Llama 3 que resolvesse cada problema na linguagem de programação fornecida. Observamos que adicionar boas regras de programação aos prompts melhorou a qualidade das soluções geradas. Além disso, achamos útil pedir ao modelo que explicasse seu processo de pensamento com anotações.

- Análise da correção: Depois de gerar soluções, é fundamental reconhecer que sua correção não é garantida e que a inclusão de soluções incorretas no conjunto de dados ajustado pode comprometer a qualidade do modelo. Embora não possamos garantir a correção total, desenvolvemos métodos para aproximar a correção. Para isso, pegamos o código-fonte extraído das soluções geradas e aplicamos uma combinação de técnicas de análise estática e dinâmica para testar sua correção, incluindo:

- Análise estática: Executamos todo o código gerado por meio de um analisador e de ferramentas de verificação de código para garantir a correção sintática, detectando erros de sintaxe, uso de variáveis não inicializadas ou funções não importadas, problemas de estilo de código, erros de tipo etc.

- Geração e execução de testes unitários: Para cada problema e solução, solicitamos que o modelo gere testes unitários e os execute com a solução em um ambiente de contêiner, detectando erros de execução em tempo de execução e alguns erros semânticos.

- Feedback de erros e autocorreção iterativa: Quando a solução falha em qualquer etapa, solicitamos ao modelo que a modifique. O aviso contém a descrição original do problema, a solução errada e o feedback do analisador/ferramenta de inspeção de código/programa de teste (saída padrão, erro padrão e código de retorno). Após uma falha na execução de um teste de unidade, o modelo pode corrigir o código para passar nos testes existentes ou modificar seus testes de unidade para se adequar ao código gerado. Somente os diálogos que passam em todas as verificações são incluídos no conjunto de dados final para o ajuste fino supervisionado (SFT). Notavelmente, observamos que aproximadamente 20% das soluções estavam inicialmente incorretas, mas foram autocorrigidas, o que sugere que o modelo aprendeu com o feedback da execução e melhorou seu desempenho.

- Ajuste fino e aprimoramento iterativo: O processo de ajuste fino ocorre em várias rodadas, sendo que cada rodada se baseia na rodada anterior. Após cada rodada de ajuste fino, o modelo é aprimorado para gerar dados sintéticos de maior qualidade para a próxima rodada. Esse processo iterativo permite refinamentos incrementais e melhorias no desempenho do modelo.

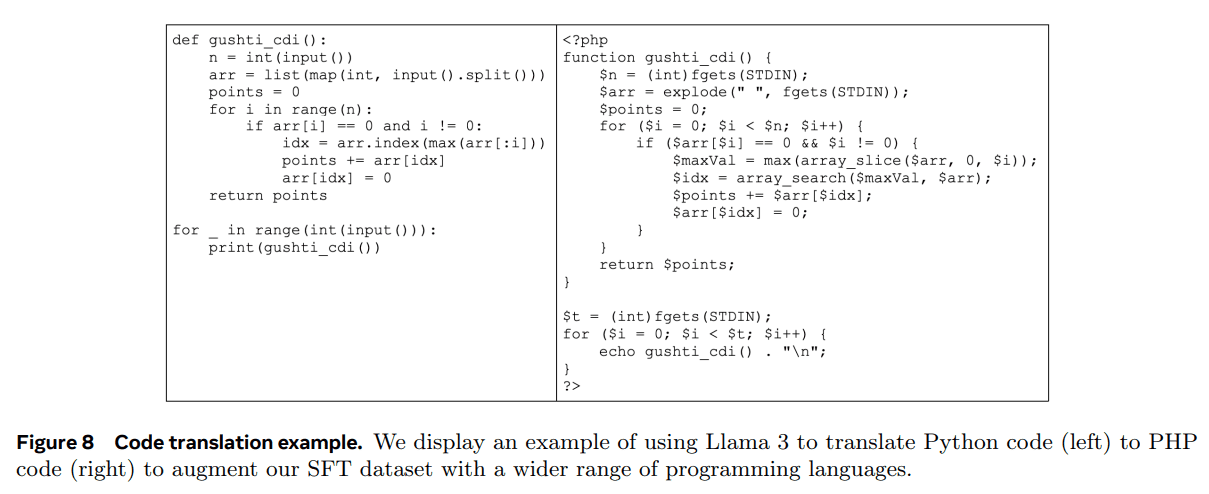

2. geração de dados sintéticos: tradução da linguagem de programação. Observamos uma lacuna de desempenho entre as principais linguagens de programação (por exemplo, Python/C++) e as linguagens de programação menos comuns (por exemplo, Typescript/PHP). Isso não é surpreendente, pois temos menos dados de treinamento para linguagens de programação menos comuns. Para atenuar isso, complementaremos os dados disponíveis traduzindo dados de linguagens de programação comuns para linguagens menos comuns (semelhante a Chen et al. (2023) no campo da inferência). Isso é feito solicitando o Llama 3 e garantindo a qualidade por meio de análise sintática, compilação e execução. A Figura 8 mostra um exemplo de código PHP sintético traduzido do Python. Isso melhora significativamente o desempenho de linguagens menos comuns medidas pelo benchmark MultiPL-E (Cassano et al., 2023).

3. geração de dados sintéticos: tradução reversa. Para aprimorar determinados recursos de codificação (por exemplo, documentação, interpretação) em que a quantidade de informações do feedback de execução é insuficiente para determinar a qualidade, usamos outra abordagem em várias etapas. Usando esse processo, geramos aproximadamente 1,2 milhão de diálogos sintéticos relacionados à interpretação, geração, documentação e depuração de código. Começando com trechos de código em várias linguagens dos dados de pré-treinamento:

- Gerar: Solicitamos que o Llama 3 gerasse dados que representassem os recursos-alvo (por exemplo, adicionando comentários e sequências de documentação a um trecho de código ou solicitando que o modelo interpretasse um trecho de código).

- Tradução reversa. Solicitamos que o modelo faça a "retrotradução" dos dados gerados sinteticamente para o código original (por exemplo, solicitamos que o modelo gere código somente a partir de seus documentos ou solicitamos que o modelo gere código somente a partir de suas explicações).

- Filtragem. Usando o código original como referência, solicitamos ao Llama 3 que determine a qualidade do resultado (por exemplo, perguntamos ao modelo se o código retrotraduzido é fiel ao código original). Em seguida, usamos o exemplo gerado com a maior pontuação de autovalidação no SFT.

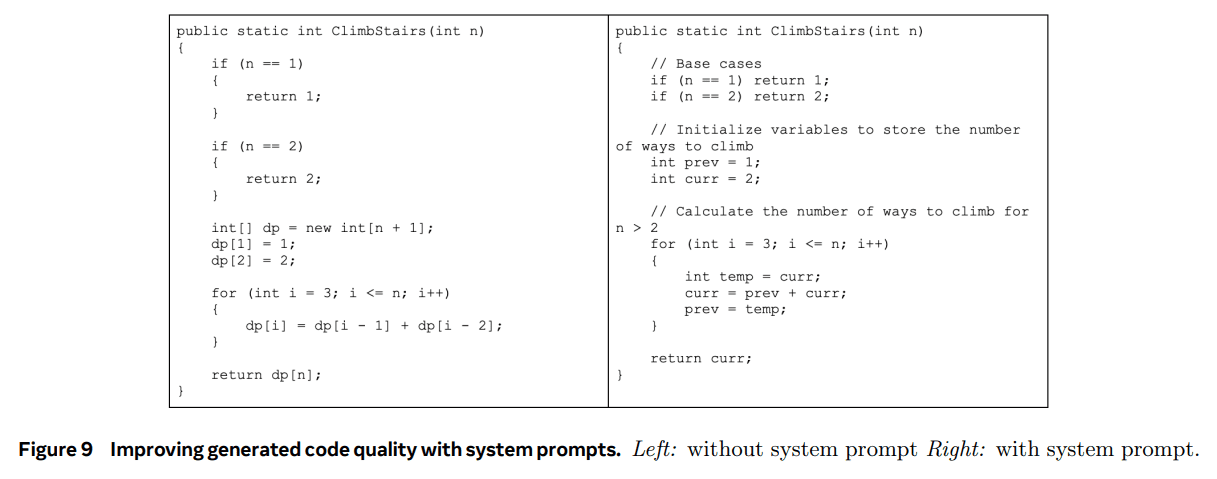

Guia de prompt do sistema para rejeição de amostras. Durante a amostragem de rejeição, usamos dicas de sistema específicas do código para melhorar a legibilidade, a documentação, a integridade e a concretude do código. Lembre-se de que, na Seção 7, esses dados são usados para ajustar o modelo de linguagem. A Figura 9 mostra um exemplo de como as dicas do sistema podem ajudar a melhorar a qualidade do código gerado - ele adiciona os comentários necessários, usa nomes de variáveis mais informativos, economiza memória e assim por diante.

Filtragem de dados de treinamento usando a execução e o modelo como uma rubrica. Conforme descrito na Seção 4.2.3, ocasionalmente encontramos problemas de qualidade nos dados de amostragem rejeitados, como a inclusão de blocos de código errôneos. Detectar esses problemas nos dados de amostragem de rejeição não é tão simples quanto detectar nossos dados de código sintético, porque as respostas de amostragem de rejeição geralmente contêm uma mistura de linguagem natural e código que nem sempre pode ser executável. (Por exemplo, as solicitações do usuário podem pedir explicitamente pseudocódigo ou edições apenas em partes muito pequenas do executável). Para resolver esse problema, utilizamos uma abordagem de "modelo como juiz", em que as versões anteriores do Llama 3 são avaliadas e recebem uma pontuação binária (0/1) com base em dois critérios: correção do código e estilo do código. Somente as amostras com uma pontuação perfeita de 2 foram mantidas. Inicialmente, essa filtragem rigorosa resultou em uma degradação do desempenho do benchmark downstream, principalmente porque removeu desproporcionalmente amostras com dicas desafiadoras. Para neutralizar isso, modificamos estrategicamente algumas das respostas categorizadas como os dados codificados mais desafiadores até que elas atendessem aos critérios de "modelo como juiz" baseados no Llama. Ao melhorar essas perguntas desafiadoras, os dados codificados equilibraram a qualidade e a dificuldade para obter um desempenho downstream ideal.

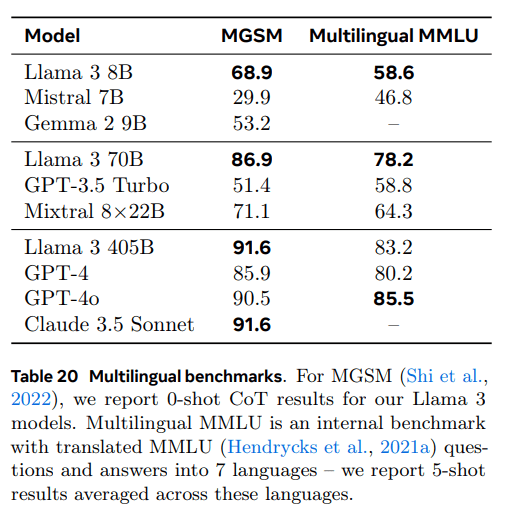

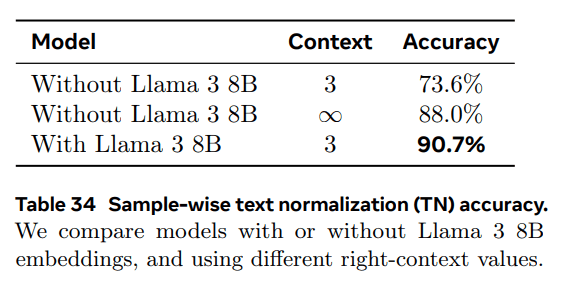

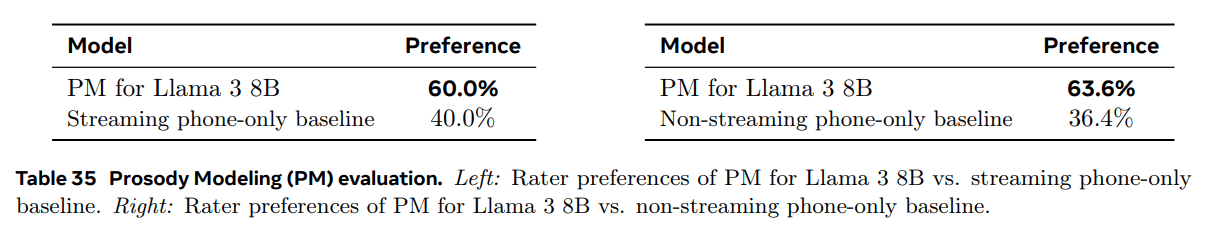

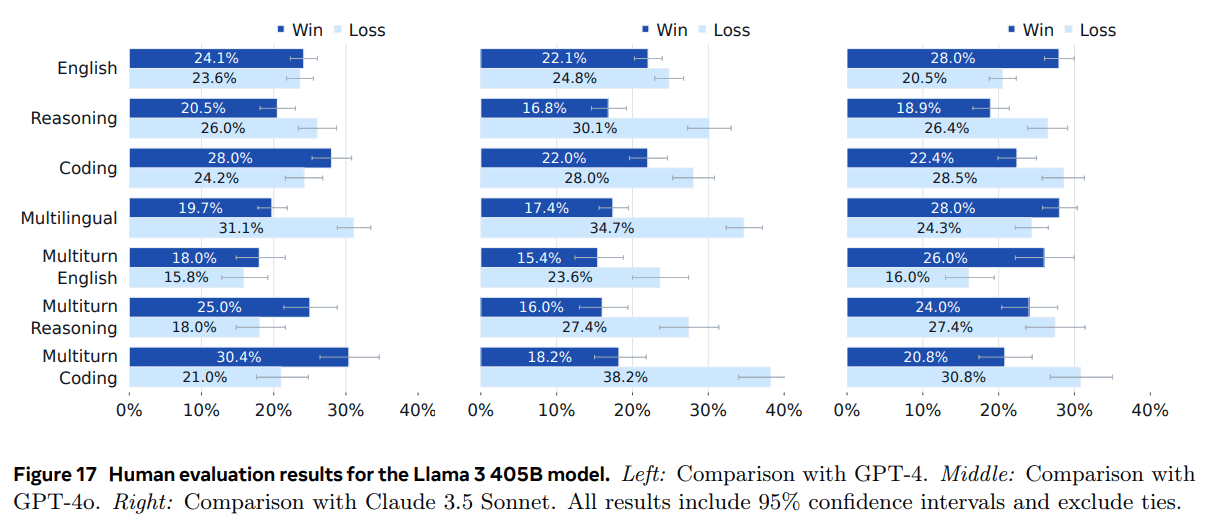

4.3.2 Multilinguismo