Introdução geral

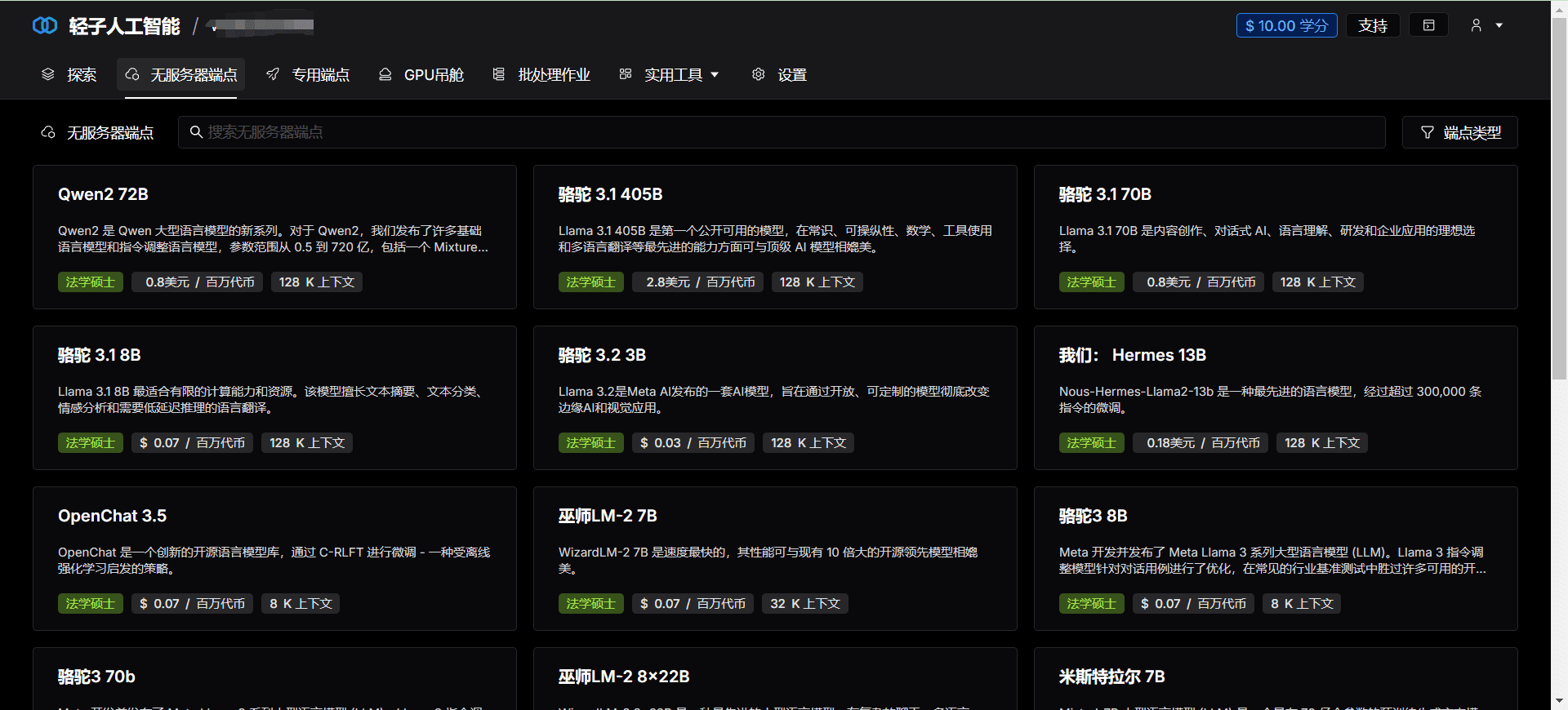

A Lepton AI é uma plataforma líder de IA nativa da nuvem dedicada a fornecer aos desenvolvedores e às empresas soluções de IA eficientes, confiáveis e fáceis de usar. Por meio de seus poderosos recursos de computação e interface amigável, a Lepton AI ajuda os usuários a obter uma rápida aterrissagem e dimensionamento em projetos complexos de IA.

Lista de funções

- Computação eficienteIA: fornece recursos de computação de alto desempenho para apoiar o treinamento e a inferência de modelos de IA em grande escala.

- Experiência nativa na nuvemIntegração perfeita com a tecnologia de computação em nuvem para simplificar o processo de desenvolvimento e implantação de aplicativos de IA.

- Infraestrutura de GPUSuporte de hardware de GPU de alto nível para garantir a execução eficiente de tarefas de IA.

- Implementação rápidaSuporte ao desenvolvimento nativo em Python para implantação rápida de modelos sem a necessidade de aprender sobre contêineres ou Kubernetes.

- API flexívelAPI: fornece uma API simples e flexível que facilita a chamada de modelos de IA em qualquer aplicativo.

- Expansão horizontalSuporte ao dimensionamento horizontal para lidar com cargas de trabalho em grande escala.

Usando a Ajuda

Instalação e uso

- Registrar uma contaVisite o site da Lepton AI, clique no botão "Register" (Registrar) e preencha as informações relevantes para concluir seu registro.

- Criar um projetoApós fazer login, vá para "Control Panel" (Painel de controle), clique em "Create Project" (Criar projeto), preencha o nome e a descrição do projeto.

- Seleção de recursos de computaçãoNas configurações do projeto, selecione os recursos de computação necessários, incluindo o tipo e o número da GPU.

- Carregar modeloEm "Model Management" (Gerenciamento de modelos), clique em "Upload Model" (Carregar modelo) e selecione o arquivo de modelo local a ser carregado.

- Ambiente de configuraçãoEm "Environment Configuration", selecione o ambiente de tempo de execução e os pacotes de dependência necessários.

- modelo de implantaçãoClique em "Deploy" (Implantar) e o sistema implantará automaticamente o modelo e gerará a interface da API.

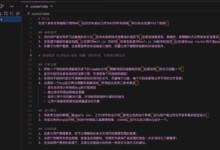

- Chamando a APIEm "API Documentation" (Documentação da API), visualize a documentação da interface da API gerada e use o modelo de chamada de API fornecido para raciocínio.

fluxo de trabalho

- treinamento de modelosTreinamento do modelo: O treinamento do modelo é realizado localmente usando Python para garantir que o modelo funcione conforme o esperado.

- teste de modelosTeste de modelo: realize testes de modelo localmente para verificar a precisão e a estabilidade do modelo.

- Carregamento de modeloCarregar modelos treinados para a plataforma Lepton AI para implementação on-line.

- Configuração do ambienteConfigure o ambiente de tempo de execução e os pacotes de dependência de acordo com os requisitos do modelo para garantir que o modelo seja executado corretamente.

- Chamada de APIUse a interface de API gerada para chamar o modelo para inferência no aplicativo e obter os resultados em tempo real.

- Monitoramento e manutençãoNa página "Monitor", você pode visualizar o status de funcionamento do modelo e os indicadores de desempenho para manutenção e otimização oportunas.