A Kunlun Weaver lança o primeiro modelo de grande vídeo de código aberto da China para peças curtas com IA

Cenários gerais versus cenários verticais, essa é a primeira opção para o desenvolvimento de grandes modelos de IA.

A maioria dos modelos de vídeo no mercado são modelos gerais que podem gerar conteúdo de vídeo para vários cenários com base em palavras de alerta inseridas pelos usuários. Ao mesmo tempo, alguns dos grandes modelos de vídeo também começaram a explorar campos verticais que estão mais próximos dos cenários de aplicativos, como o recém-lançado modelo da ByteDance Goku O modelo, portanto, concentra-se no aplicativo de bandas ao vivo da Digital Man.

SkyReels V1: um marco para os modelos de geração de vídeos de drama curto com IA na China

A Kunlun World Wide anunciou hoje o SkyReels V1, o primeiro grande modelo de geração de vídeo da China para a criação de dramas curtos com IA. A Kunlun Wanwei lançou oficialmente a SkyReels, uma plataforma de drama curto com IA, em dezembro de 2024, e a SkyReels A V1 fornecerá suporte robusto à tecnologia de modelos grandes para a plataforma.

De acordo com a observação e a experiência reais, o SkyReels V1 pode ser considerado o modelo de vídeo com "maior desempenho" do mercado. Ele demonstrou seu poder expressivo comparável ao do cinema e da televisão em muitos aspectos, como microexpressões de personagens, detalhes de ações, construção de cenas, composição de imagens e operação de lentes, e é capaz de gerar filmagens de desempenho de "estrelas de cinema e rainhas".

SkyReels A1: algoritmos simultâneos de código aberto para movimentos de expressão controlados

Lançado em conjunto com o SkyReels V1, o SkyReels A1, que é o primeiro algoritmo controlável de expressão-ação de nível SOTA, baseado em modelo de base de vídeo, desenvolvido pela KunlunWanwei.

Além disso, o SkyReels V1 e o SkyReels A1 são modelos de código aberto, e todos os usuários podem fazer download e usá-los gratuitamente de acordo com o contrato de código aberto. O endereço de código aberto é o seguinte:

https://github.com/SkyworkAI/SkyReels-V1

https://github.com/SkyworkAI/SkyReels-A1

https://skyworkai.github.io/skyreels-a1.github.io/report.pdf

se DeepSeek R1 estabeleceu uma nova referência de código aberto para grandes modelos de texto, especialmente modelos de inferência, e o SkyReels V1 O SkyReels A1 e o SkyReels A1 estabeleceram um novo nível de código aberto no crescente mercado de dramas curtos de IA. Com o suporte desses dois modelos, espera-se que o mercado de curta-metragem de IA dê início ao "momento DeepSeek".

1. o mega-modelo de vídeo com "melhor desempenho

O SkyReels V1 é um modelo grande que se beneficia da comunidade de código aberto e contribui ativamente para ela. Ele é treinado com base no HunYuan-Video, um modelo híbrido de vídeo grandioso de código aberto pela Tencent em dezembro de 2023.

Embora os modelos de código aberto tenham um bom desempenho em tarefas de uso geral, seu desempenho pode não ser ideal em domínios específicos ou tarefas segmentadas. Como resultado, os fornecedores de modelos geralmente precisam realizar muitos ajustes finos, otimização de inferência e alinhamento de segurança durante o processo de treinamento real.

Atualmente, os grandes modelos de vídeo no mercado de dramas curtos com IA geralmente apresentam deficiências na geração de expressões de personagens, e o problema mais proeminente é que as expressões dos personagens são vazias e sem vivacidade. Com o SkyReels V1, a Kunlun quer superar esses pontos problemáticos do setor.

O treinamento de modelos é um componente fundamental para o domínio do conhecimento e das capacidades de um modelo grande. No processo de treinamento do SkyReels V1, o objetivo principal do KunlunWei é ensinar o modelo "como executar". Para esse fim, a Kunlun realizou principalmente as duas principais inovações tecnológicas a seguir:

Limpeza e rotulagem de dados: uma pedra angular do ajuste fino do modelo

A primeira é a limpeza e rotulagem de dados, que é uma parte fundamental do ajuste fino do modelo. Da mesma forma que um professor precisa de materiais didáticos de alta qualidade para se preparar para uma aula, a KunlunWavi criou um conjunto de dados de filmes, séries de TV e documentários de alta qualidade, com nível de dez milhões de níveis, com base em seu processo de limpeza de dados de alta qualidade e rotulagem manual. Isso constitui o "material didático" para o SkyReels V1 aprender a atuar.

O Grande Modelo Multimodal Centrado no Ser Humano de Compreensão de Vídeo: Melhorando a Compreensão de Personagens

Os "materiais didáticos" por si só não são suficientes; é necessária uma orientação mais aprofundada sobre modelagem. Portanto, a KunlunWanwei desenvolveu seu próprio modelo multimodal centrado no ser humano (centrado no personagem) para a compreensão de vídeos. O objetivo é melhorar significativamente a capacidade do modelo de entender as informações relacionadas aos personagens do vídeo.

Esse conjunto de sistemas de análise inteligente de personagens com base em um grande modelo multimodal de compreensão de vídeo pode obter efeitos de desempenho de personagens "nível estrela de cinema" em vários níveis, como reconhecimento de expressão, percepção da localização espacial do personagem, compreensão da intenção comportamental e compreensão da cena de desempenho.

O que é um desempenho de "estrela de cinema"?

Por exemplo, o SkyReels V1 é capaz de gerar desempenhos de microexpressões de personagens com qualidade cinematográfica, suportando 33 expressões sutis de personagens e mais de 400 combinações de movimentos naturais, reproduzindo, assim, expressões emocionais da vida real.

Outro exemplo é o fato de o SkyReels V1 também dominar a estética da iluminação de nível cinematográfico. Treinados com dados de alta qualidade de filmes e TV de Hollywood, cada quadro gerado pelo SkyReels V1 tem uma qualidade cinematográfica em termos de composição, posição do ator e ângulo da câmera.

Comparação do SkyReels V1 com modelos de fonte fechada

Embora o SkyReels V1 seja um modelo de código aberto, ele gera resultados comparáveis aos modelos de código fechado, como o Conch AI e o Corinne AI. Sob as mesmas condições de palavra-chave, a comparação dos resultados de geração do SkyReels V1, Conch AI e Keling AI é a seguinte:

Palavra-chave 1: Uma foto de uma mulher de cabelos castanhos com lindos óculos vermelhos e batom vermelho. Ela acenou com a mão para a frente, sorrindo e depois rindo.

SkyReels V1.

Conch AI.

Kerin AI.

Palavra-chave 2: Um close-up frontal dramático revela o rosto de um mergulhador de alto-mar usando um capacete de mergulho de cobre antiquado. O vidro circular espesso do capacete oferece uma visão clara de sua expressão calma. Pequenas bolhas flutuam para cima dentro do capacete, com gotículas de água grudadas nas paredes internas. Ele segurava cuidadosamente um livro aberto, com as páginas tremulando suavemente nas correntes subaquáticas. O livro parecia estar seco e intacto, em forte contraste com o ambiente aquático. Feixes suaves de luz solar atravessavam a água, iluminando seu rosto e lançando um brilho dourado sobre as páginas. Os peixes nadavam ao redor, com suas cores atenuadas pela profundidade, mas ainda vivas em frente ao fundo azul-esverdeado. O mergulhador lê o texto atentamente, completamente imerso na leitura, apesar de estar debaixo d'água. A combinação surreal da literatura e das profundezas do oceano cria uma atmosfera de sonho, destacando a busca pelo conhecimento nos lugares mais inesperados.

SkyReels V1.

Conch AI.

Kerin AI.

Em termos de resultados reais, o SkyReels V1 mostra a força dos modelos de código fechado em termos de nitidez da imagem e da precisão do desempenho dos personagens. O SkyReels V1 supera até mesmo os modelos de código fechado em termos de dinâmica capilar e outros detalhes.

Recursos de vídeo gerados por gráficos inigualáveis em modelos de código aberto

Além disso, o SkyReels V1 não apenas oferece suporte a vídeos gerados por texto, mas também a vídeos gerados por imagens, que é um dos modelos de vídeo gerados por gráficos mais avançados entre os modelos de código aberto atuais.

Para validar os recursos de vídeo gerados por gráficos do SkyReels V1, alimentamos o modelo com fotos da popular marmota do filme de Ano Novo Chinês Ne Zha's Demon Child Descends e definimos uma palavra-chave: a marmota olha para cima, faz uma pausa de um segundo e depois grita. Os resultados gerados pelo SkyReels V1 são impressionantes:

É discutível.O SkyReels V1 é o macromodelo de vídeo com o melhor desempenho do mercado atual.

2. estrutura de inferência desenvolvida pelo próprio SkyReels Infer: criação de um modelo de código aberto para todos

O que é ainda mais valioso é o fato de o SkyReels V1, como modelo de código aberto, não apenas ter feito um avanço significativo na geração de resultados, mas também ter uma eficiência de inferência muito alta. Isso se deve ao SkyReels Infer, uma estrutura de raciocínio desenvolvida por Kunlun Wanwei.

Implicações de uma estrutura de raciocínio de autoestudo

Qual é a importância das estruturas de raciocínio de autopesquisa?

Em geral, os modelos de código aberto são otimizados com menos frequência especificamente para estruturas de inferência, especialmente em cenários de aplicativos de grande escala. No entanto, sem otimizar a estrutura de raciocínio, é difícil atender aos requisitos de experiência do usuário em termos de eficiência e custo do raciocínio.

Um caso em questão é o lançamento do OpenAI no início de 2024. Sora Na época, alguns usuários relataram que o Sora levava uma hora para gerar um vídeo de um minuto. Esse foi um dos principais motivos pelos quais o Sora saiu do ar quase um ano após seu lançamento. Até hoje, muitos dos grandes modelos de vídeo ainda enfrentam o problema de longos tempos de espera para gerar vídeos.

O SkyReels Infer, a estrutura de inferência desenvolvida pela KunlunWanwei, não apenas mantém o alto desempenho, mas também leva em conta a eficiência e a facilidade de uso.

Desempenho superior do SkyReels Infer

A velocidade de inferência do SkyReels Infer é excelente. Em uma única placa RTX 4090, são necessários apenas 80 segundos para gerar um vídeo de 544P. Os usuários podem estar perdidos em pensamentos ou navegando em seus telefones celulares e o vídeo já foi gerado.

O SkyReels Infer oferece suporte à computação paralela distribuída de várias placas. Essa é uma tecnologia avançada. Em poucas palavras, ela permite que várias placas de vídeo trabalhem juntas em tarefas de geração de vídeo.

Com tecnologias como Context Parallel, CFG Parallel e VAE Parallel, várias placas gráficas trabalham juntas como uma equipe altamente eficiente para atingir velocidades de processamento significativas. Isso é especialmente útil para aplicativos que exigem computação em grande escala, como a criação de animações complexas ou vídeos com efeitos especiais.

O SkyReels Infer também se destaca na otimização de baixa memória de vídeo. Ele usa a tecnologia fp8 quantisation e parameter-level offloading para fazer com que o SkyReels Infer seja executado sem problemas, mesmo em placas de vídeo comuns com pouca memória de vídeo.

A memória gráfica é um parâmetro fundamental de uma placa gráfica, que determina a quantidade de dados que a placa pode processar simultaneamente. No passado, muitos modelos de geração de vídeo exigiam alta memória gráfica, que muitas vezes não estava disponível para o usuário comum devido à falta de desempenho da placa gráfica. A otimização de baixa memória do SkyReels Infer mudou completamente essa situação. Isso significa que os usuários podem experimentar facilmente o poder dos modelos de geração de vídeo sem precisar comprar placas gráficas caras de última geração. Sem dúvida, isso reduz o limite da geração de vídeo de IA, permitindo que mais usuários aproveitem a diversão da tecnologia de IA.

O SkyReels Infer é baseado na biblioteca Diffuser de código aberto. A biblioteca Diffuser é uma excelente biblioteca de código aberto que oferece uma grande variedade de recursos e ferramentas. O SkyReels Infer é baseado na biblioteca Diffuser e, naturalmente, herda muitas de suas vantagens. Para os desenvolvedores, isso significa que eles podem começar rapidamente e integrar facilmente o SkyReels Infer em seus projetos existentes.

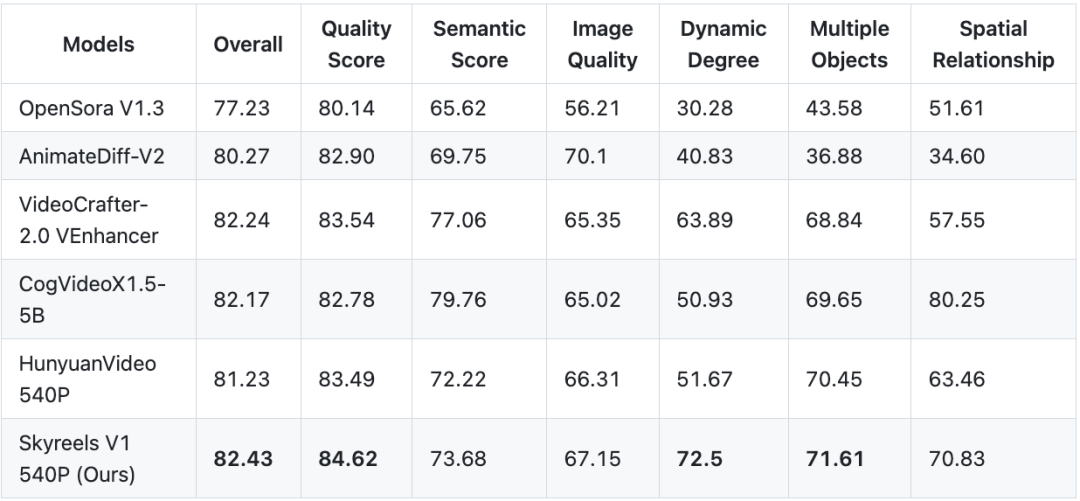

Comparação de desempenho

Qual é o desempenho real do SkyReels Infer? A Kunlun usa o SkyReels V1, que é equipado com a estrutura de inferência do SkyReels Infer, e o HunYuan-Video, que é o código aberto oficial da Tencent, para realizar um teste de comparação de desempenho. Os resultados do teste mostram que o SkyReels V1 tem melhor velocidade e latência do que o HunYuan-Video na geração de vídeos de 544p.

Além disso, o SkyReels V1 oferece suporte a uma estratégia de implantação de várias placas, permitindo que até 8 placas gráficas sejam utilizadas simultaneamente para acelerar as tarefas de computação. Além disso, o SkyReels V1 é compatível com placas de vídeo de ponta, como a A800, e placas de vídeo de consumo, como a RTX 4090, atendendo às necessidades de usuários profissionais e casuais.

3. algoritmo de controle de movimento de expressão de código aberto SkyReels A1: tecnologia "AI face-swapping" líder do setor

Vale a pena mencionar que, após as sessões de treinamento e inferência do modelo, oPara obter uma geração de vídeo de personagem mais precisa e controlável, a Kunlun também abriu o SkyReels A1, um algoritmo controlável para movimentos de expressão com base em um modelo de base de vídeo.

O SkyReels A1 é um algoritmo de camada de aplicativo que fica sobre a tecnologia subjacente de treinamento e inferência, e é comparado com a tecnologia Act-One da Runway para captura de expressões cinematográficas.

O jogo "AI Face Swap" do SkyReels A1.

A jogabilidade principal do Runway Act-One e do Kunlun SkyReels A1 é a "AI Face Swap": os usuários só precisam preparar uma foto do personagem A e um videoclipe do personagem B e, em seguida, a expressão, o movimento e as linhas do personagem B podem ser transplantados diretamente para o personagem A. A jogabilidade do Runway Act-One e do Kunlun SkyReels A1 é baseada na "AI Face Swap".

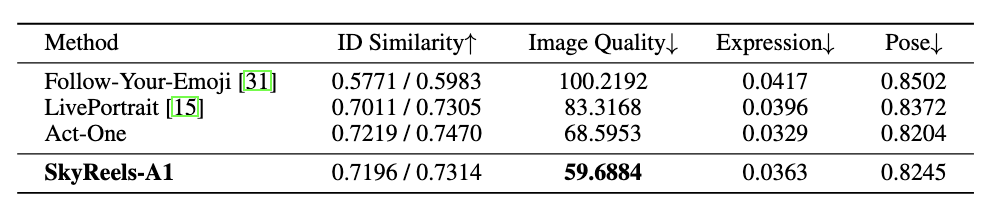

Em termos de Similaridade de ID, Qualidade de Imagem, Expressão e Pose, o SkyReels A1 alcança resultados SOTA (Estado da Arte) em comparação com algoritmos de código aberto semelhantes no setor. Em comparação com algoritmos de código aberto semelhantes no setor, o SkyReels A1 alcança resultados SOTA (estado da arte), que são próximos aos da tecnologia Act-One de código fechado, com uma vantagem na qualidade da geração.

Captura de expressão cinematográfica orientada por vídeo

Em primeiro lugar, o SkyReels A1 permite a captura de expressões cinematográficas e orientadas por vídeo, com um grau maior de controle da expressão do personagem do que o Runway Act-One.

Reprodução de microexpressão de alta fidelidade

O próximo passo é a reprodução de microexpressões de alta fidelidade. O SkyReels A1 é capaz de gerar vídeos altamente realistas de pessoas em movimento com base em qualquer escala humana, incluindo retratos, composições de meio corpo e corpo inteiro. Esse realismo vem da simulação precisa das mudanças de expressão e das emoções, bem como da profundidade dos detalhes multidimensionais, como a textura da pele e o acompanhamento do movimento do corpo.

Por exemplo, geração de controle de expressão facial lateral:

e geração de microexpressões mais realistas nas sobrancelhas e nos olhos:

Face Hold e processamento de movimentos amplos

Além das microexpressões, o SkyReels A1 também supera o Runway Act-One em áreas como retenção de faces e processamento de movimentos em larga escala. A retenção de faces e o processamento de movimentos em larga escala são exatamente as áreas em que muitos modelos de geração de vídeo são propensos a erros.

Por exemplo, no caso a seguir, o rosto do personagem mais à direita mostra uma distorção significativa que não corresponde à imagem original do personagem.

O SkyReels A1 também permite maior movimentação da cabeça e do corpo natural. No caso a seguir, o corpo do personagem mais à direita quase não tem movimento.

É fácil perceber que os algoritmos A1 da SkyReels simplificam o complexo processo de produção de vídeo tradicional, oferecendo aos criadores de conteúdo uma solução eficiente, flexível e de baixo custo que pode ser amplamente utilizada na produção de uma variedade de conteúdos criativos.

4. o "momento DeepSeek" no mercado de curtas-metragens com IA

O código-fonte aberto do SkyReels V1 e do SkyReels A1 é apenas a primeira etapa do plano de código-fonte aberto da KunlunWei para modelos de vídeo grandes. No futuro, a Kunlun continuará a abrir o código-fonte de tecnologias relacionadas, incluindo versões de controle de espelho de nível profissional, parâmetros de modelo de resolução 720P, parâmetros de modelo para conjuntos de dados de treinamento maiores e algoritmos de geração de vídeo que suportam a geração controlada de corpo inteiro.

De fato, o código-fonte aberto há muito tempo está integrado ao DNA da Kunlun World Wide. Fang Han, Presidente e CEO da Kunlun World Wide, como fundador do Linux chinês, um dos Quatro Mosqueteiros do Linux chinês e um dos primeiros especialistas em segurança cibernética da China, tem 30 anos de experiência no setor de Internet. Fang Han tem se envolvido ativamente no movimento de código aberto desde 1994 e é um dos primeiros promotores do conceito de código aberto na Internet.

Fang Han declarou publicamente que o grande modelo de código aberto é um complemento importante e uma alternativa ao grande modelo comercial de código fechado, esperando promover a democratização da tecnologia e reduzir o limite do setor por meio do código aberto.

Já em dezembro de 2022, a Kunlun WV lançou toda a série de algoritmos e modelos do AIGC "Kunlun Tiangong" e anunciou o código aberto completo. A Kunlun não é apenas uma das empresas com o layout mais abrangente no campo do AIGC doméstico, mas também a primeira empresa na China a se dedicar à comunidade de código aberto do AIGC.

Nos últimos três anos, a KunlunWanwei vem lançando e abrindo a série Tiangong de grandes modelos. Em abril de 2024, a Kunlun World Wide lançou e simultaneamente abriu o código-fonte do Tiangong 3.0, um supermodelo MoE com 400 bilhões de parâmetros, cujo desempenho excede o do Grok 1.0 ao mesmo tempo. Em junho de 2024, a KunlunWei novamente abriu o código-fonte do modelo MoE esparso de 200 bilhões, tornando-se o primeiro modelo MoE de 100 bilhões de código-fonte aberto que suporta inferência em um único servidor RTX 4090. Em novembro de 2024, a KWL abriu o código-fonte do Skywork-o1-Open e de outras séries de modelos.

Com a crença na tecnologia de código aberto, a Kunlun tem o compromisso de levar o setor a realizar o sonho da AGI (General Artificial Intelligence, Inteligência Artificial Geral).

Desde que entrou no campo da IA em 2020, a Kunlun concluiu o layout de toda a cadeia industrial de "infraestrutura aritmética - algoritmo de modelo grande - aplicativo de IA" e construiu uma matriz de negócios de IA diversificada.

Os dramas curtos de IA são um segmento importante da matriz diversificada de aplicativos de IA da Kunlun Wealth.

Os dramas curtos de IA são um mercado emergente, que deverá ter um grande crescimento em 2025. O "2024 Short Drama Overseas Marketing White Paper", lançado pela TikTok for Business, prevê que a média mensal de usuários de curta-metragem em mercados estrangeiros chegará a 200-300 milhões no futuro, e o tamanho do mercado deve chegar a US$ 10 bilhões, portanto, o potencial de mercado é enorme.

Em dezembro de 2024, a KunlunWanwei lançou a plataforma de curta-metragem de IA Skyreels nos EUA, marcando um passo importante para a KunlunWanwei no mercado global de entretenimento de IA e trazendo uma nova experiência de curta-metragem inteligente para o público norte-americano. A plataforma de dramas curtos de IA SkyReels não só oferece ferramentas de criação poderosas para criadores de conteúdo profissionais, mas também reduz significativamente o limite de criação de dramas curtos de IA, facilitando o início para usuários não profissionais.

As implicações de longo alcance da IA para o setor global de cinema e televisão

Como a tecnologia de IA revolucionará o setor global de cinema e televisão?

Em seu discurso na Conferência Mundial de Inteligência Artificial de 2024, Fang Han, presidente da Kunlun World Wide, ressaltou que a IA tem um enorme dividendo de desenvolvimento no exterior, especialmente em países de idioma pequeno.

Citando o setor de cinema e teatro como exemplo, ele observou que custa cerca de US$ 20.000 para produzir um filme na Nigéria. Essa produção é claramente não competitiva quando comparada a Wandering Earth, que custou 300 milhões de RMB à China, e Avatar, que custou centenas de milhões de dólares aos EUA. No entanto, espera-se que o advento da tecnologia de IA preencha essa lacuna.

"Minha previsão pessoal é que, dentro de três a cinco anos, o custo de produção de um blockbuster do nível de Wandering Earth poderá cair para dezenas de milhares de dólares com a ajuda da tecnologia de IA. Isso trará enormes oportunidades de desenvolvimento para muitas regiões no exterior. As pessoas em todos os lugares estão ansiosas para ver produtos culturais localizados, sejam romances, músicas, vídeos ou quadrinhos, e precisam de conteúdo mais próximo de sua cultura local. Portanto, a IA no exterior traz um enorme dividendo de desenvolvimento". disse Fang Han.

Em um nível menor, o dividendo trazido pela IA está na redução exponencial do custo de produção de produtos culturais, o que torna possível o modo de criação de "uma pessoa, um drama". Em um nível maior, ao reduzir o limite de criação, a tecnologia AIGC capacita grupos culturais desfavorecidos a produzir conteúdo por conta própria, o que promoverá a afirmação cultural global, que é a melhor manifestação da tecnologia para o bem.

O setor geralmente considera o surgimento da IA como o "momento iPhone", mas Fang Han acredita que a IA é mais parecida com a revolução da câmera do telefone celular, porque a câmera desencadeou uma mudança na forma de filmar, que, por sua vez, deu origem a enormes plataformas de vídeos curtos, como Jitterbug e Shutterbug. Da mesma forma, a IA também dará origem a um grande número de novas plataformas de UGC com IA, abrindo uma era de ouro de produção e consumo de conteúdo personalizado.

O SkyReels V1, o primeiro modelo de geração de vídeo de código aberto para a criação de dramas curtos com IA, e o SkyReels A1, o primeiro algoritmo de controle de expressões faciais baseado em um modelo de base de vídeo com classificação SOTA, são exatamente as ferramentas para acelerar a universalidade da era AIGC. O SkyReels V1, o primeiro modelo de geração de vídeo de código aberto para a criação de dramas curtos com IA, e o SkyReels A1, o primeiro algoritmo de nível SOTA para controle de expressões faciais com base em um modelo de base de vídeo, são exatamente as ferramentas para acelerar a chegada do AIGC.

Espera-se que o mercado de dramas curtos de IA dê início ao "momento DeepSeek" que lhe pertence.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...