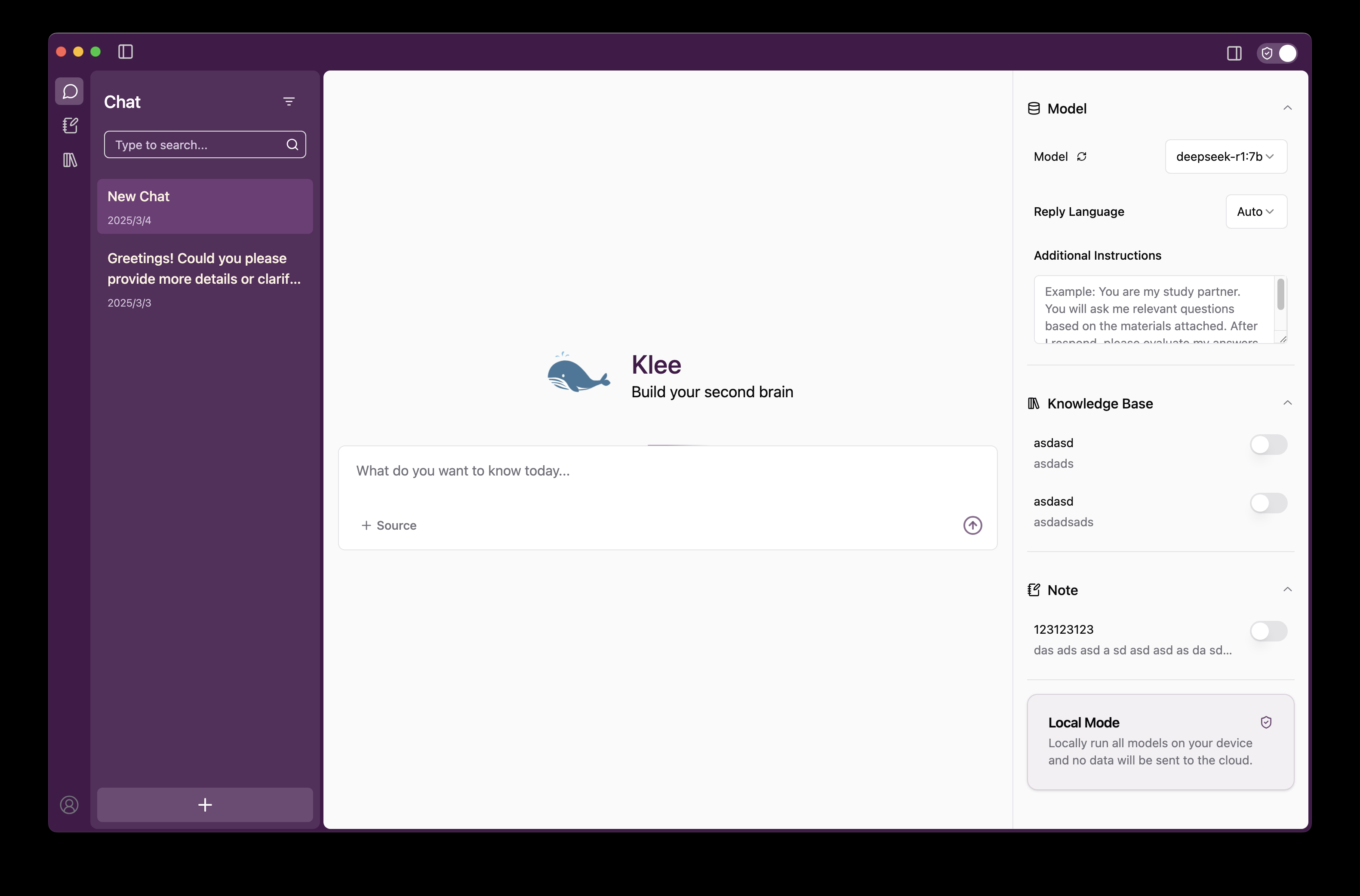

Klee: execução de macromodelos de IA localmente no desktop e gerenciamento de uma base de conhecimento privada

Introdução geral

O Klee é um aplicativo de desktop de código aberto projetado para ajudar os usuários a executar modelos de linguagem grandes (LLMs) de código aberto localmente com gerenciamento seguro de bases de conhecimento privadas e recursos de anotações Markdown. Ele é baseado em Ollama Criado com a tecnologia LlamaIndex, o Klee permite que os usuários baixem e executem modelos de IA com operações simples, e todo o processamento de dados é feito localmente, sem a necessidade de conexão com a Internet ou upload para a nuvem, garantindo privacidade e segurança. O Klee oferece uma interface de usuário intuitiva para Windows, MacOS e Linux, facilitando a geração de texto, a análise de documentos e a organização do conhecimento, tanto para desenvolvedores técnicos quanto para usuários casuais. Atualmente, o Klee é de código aberto no GitHub e foi bem recebido pela comunidade, com usuários livres para fazer download, personalizar ou participar do desenvolvimento.

Lista de funções

- Baixe e execute modelos de linguagem grandes em um cliqueDownload e execução de LLM de código aberto diretamente do Ollama por meio da interface, sem a necessidade de configurar manualmente o ambiente.

- Gerenciamento da base de conhecimento localSuporte para upload de arquivos e pastas para criar um índice de conhecimento privado e disponibilizá-lo para consulta pela IA.

- Geração de notas markdownSalvar automaticamente o diálogo de IA ou os resultados da análise no formato Markdown para facilitar a documentação e a edição.

- Uso totalmente off-lineNão é necessária conexão com a Internet, todas as funções são executadas localmente e nenhum dado do usuário é coletado.

- Suporte a várias plataformasCompatível com os sistemas Windows, MacOS e Linux para uma experiência consistente.

- Código aberto e personalizávelCódigo-fonte: O código-fonte completo é fornecido para dar suporte à modificação de recursos pelo usuário ou à participação em contribuições da comunidade.

Usando a Ajuda

Processo de instalação

A instalação do Klee é dividida em duas partes: cliente (klee-client) e servidor (klee-service), e as etapas detalhadas são as seguintes:

1. requisitos do sistema

- sistema operacionalWindows 7+, macOS 15.0+ ou Linux.

- dependência de software::

- Node.js 20.x ou posterior.

- Yarn 1.22.19 ou posterior.

- Python 3.x (necessário no lado do servidor, 3.12+ recomendado).

- Git (para clonagem de repositórios).

- Requisitos de hardwareRAM: Pelo menos 8 GB de RAM, sendo recomendável 16 GB ou mais para executar modelos maiores.

2) Instale o cliente (klee-client)

- Clonar o repositório do cliente::

É executado no terminal:

git clone https://github.com/signerlabs/klee-client.git

cd klee-client

- Instalação de dependências::

yarn install

- Configuração de variáveis de ambiente::

- Copie o arquivo de exemplo:

cp .env.example .env - compilador

.enva configuração padrão é a seguinte:VITE_USE_SUPABASE=false VITE_OLLAMA_BASE_URL=http://localhost:11434 VITE_REQUEST_PREFIX_URL=http://localhost:6190Se a porta ou o endereço do servidor for diferente, ajuste a

VITE_REQUEST_PREFIX_URL.

- Operação no modo de desenvolvimento::

yarn dev

Isso iniciará o Vite Development Server e o aplicativo Electron.

5. Aplicação de embalagem (opcional)::

yarn build

O arquivo empacotado está localizado em dist Catálogo.

6. Assinatura do macOS (opcional)::

- compilador

.envAdicione um ID Apple e informações da equipe:APPLEID=your_apple_id@example.com APPLEIDPASS=your_password APPLETEAMID=your_team_id - estar em movimento

yarn buildDepois disso, você pode gerar um aplicativo assinado.

3. instalação do servidor (klee-service)

- Clonar o repositório no lado do servidor::

git clone https://github.com/signerlabs/klee-service.git

cd klee-service

- Criação de um ambiente virtual::

- Windows:

python -m venv venv venv\Scripts\activate - MacOS/Linux:

python3 -m venv venv source venv/bin/activate

- Instalação de dependências::

pip install -r requirements.txt

- Início dos serviços::

python main.py

A porta padrão é 6190, se você precisar alterá-la:

python main.py --port 自定义端口号

O serviço precisa ser mantido em execução após ser iniciado.

4. faça o download da versão pré-compilada (opcional)

- entrevistas Lançamentos do GitHubFaça o download do pacote de instalação para seu sistema.

- Descompacte-o e execute-o imediatamente, sem a necessidade de compilá-lo manualmente.

Funções principais

Execute modelos de linguagem grandes com um clique

- iniciar um aplicativo::

- Certifique-se de que o servidor esteja em execução e abra o aplicativo cliente.

- Modelos para download::

- Selecione um modelo compatível com Ollama (por exemplo, LLaMA, Mistral) na interface.

- Clique no botão "Download" e o Klee fará o download automático do modelo localmente.

- modelo operacional::

- Quando o download estiver concluído, clique em "Run" (Executar) para carregar o modelo na memória.

- Digite uma pergunta ou comando na caixa de diálogo e clique em "Send" (Enviar) para obter uma resposta.

- advertência::

- Carregar o modelo pela primeira vez pode levar alguns minutos, dependendo do tamanho do modelo e do desempenho do hardware.

- Se não houver resposta, verifique se o servidor está sendo executado no

http://localhost:6190.

Gerenciamento da base de conhecimento local

- Carregamento de arquivos::

- Clique na opção "Knowledge" (Conhecimento) na interface.

- Suporta arrastar e soltar ou seleção manual de arquivo/pasta (suporta PDF, TXT, etc.).

- Criação de um índice::

- Após o upload, o LlamaIndex gera automaticamente um índice para o arquivo.

- Quando a indexação estiver concluída, o conteúdo do documento poderá ser recuperado pela IA.

- Consulta à base de conhecimento::

- Marque "Use Knowledge Base" na tela de diálogo e digite sua pergunta.

- A IA gerará respostas em conjunto com o conteúdo da base de conhecimento.

- Gerenciar a base de conhecimento::

- É possível excluir ou atualizar arquivos na tela Conhecimento.

Geração de notas markdown

- Salvando notas::

- Quando a IA responder, clique no botão "Save as Note" (Salvar como nota).

- O sistema salva automaticamente o conteúdo no formato Markdown.

- Notas de gerenciamento::

- Visualize todas as notas na tela Notas.

- Oferece suporte à edição, exportação (salvar como arquivo .md) ou exclusão.

- Cenários de uso::

- Ideal para registrar resultados de análises de IA, notas de estudo ou resumos de trabalho.

Funções em destaque

Uso totalmente off-line

- método operacional::

- Depois de instaladas, todas as funções funcionarão sem a necessidade de uma rede.

- Faça o download do modelo e desconecte-se da Internet e ainda assim funciona bem.

- segurança de dados::

- A Klee não coleta nenhum dado do usuário e todos os arquivos e conversas são armazenados apenas localmente.

- Os registros são usados apenas para fins de depuração e não são carregados em servidores externos.

Código aberto e contribuições da comunidade

- Obtenção do código-fonte::

- entrevistas Repositórios do GitHub, faça o download do código.

- Modo de contribuição::

- Envie um Pull Request para adicionar um recurso ou corrigir um bug.

- Participe de discussões de problemas do GitHub para otimizar a documentação ou promover aplicativos.

- Métodos personalizados::

- Modificar o lado do servidor para oferecer suporte a outros modelos ou APIs.

- Ajuste da interface do cliente, precisa estar familiarizado com Reagir e elétron.

Recomendações de uso

- otimização do desempenhoQuando estiver executando modelos grandes (por exemplo, parâmetros 13B), recomenda-se mais de 16 GB de RAM ou aceleração de GPU.

- Seleção de modelosModelo menor: Um modelo menor (por exemplo, parâmetro 7B) pode ser selecionado para ser testado pela primeira vez.

- Feedback da pergunta: no GitHub ou Discórdia Procure ajuda.

Com essas etapas, os usuários podem instalar e usar o Klee rapidamente para aproveitar a conveniência da IA localizada.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...