Introdução geral

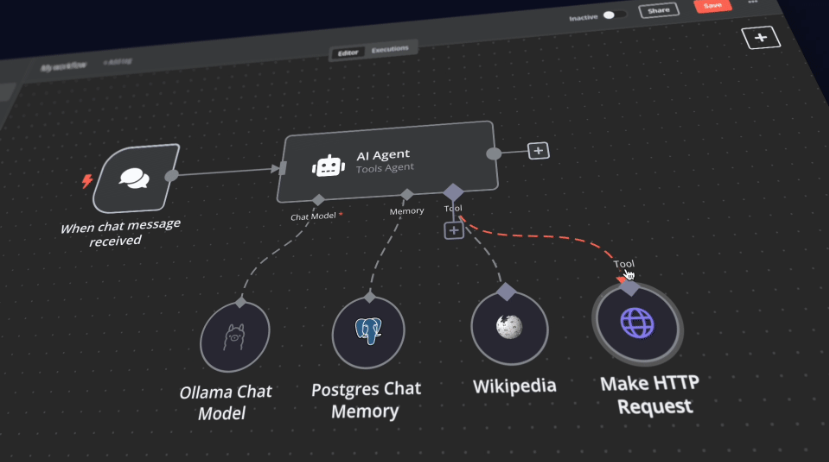

O n8n Self-Hosted AI Starter Kit é um modelo de código aberto do Docker Compose projetado para inicializar rapidamente um ambiente local abrangente de desenvolvimento de IA e de baixo código. Com curadoria da equipe da n8n, o pacote combina a plataforma n8n auto-hospedada com uma variedade de produtos e componentes de IA compatíveis para ajudar os usuários a criar rapidamente fluxos de trabalho de IA auto-hospedados. A suíte inclui a plataforma n8n low-code, a plataforma LLM multiplataforma Ollama, o armazenamento vetorial de alto desempenho Qdrant e um banco de dados PostgreSQL para uma variedade de cenários de aplicativos de IA, como agentes inteligentes, resumo de documentos, chatbots inteligentes e análise de documentos financeiros privados.

Lista de funções

- Plataforma de baixo código n8nIA: fornece mais de 400 componentes de IA integrados e avançados para dar suporte a fluxos de trabalho de construção rápida.

- Plataforma OllamaPlataforma LLM multiplataforma com suporte para instalação e execução do LLM nativo mais recente.

- Armazenamento vetorial QdrantArmazenamento vetorial de alto desempenho de código aberto com uma API abrangente.

- Banco de dados PostgreSQLBanco de dados confiável para lidar com grandes quantidades de dados.

- Agentes inteligentesAgentes de IA para agendamento de reuniões e tarefas.

- resumo do documentoResuma com segurança os documentos PDF da empresa e evite o vazamento de dados.

- Chatbots inteligentesBots inteligentes do Slack que aprimoram as comunicações da empresa e as operações de TI.

- Análise de documentos financeiros privados: Análise de documentos financeiros privados pelo menor custo possível.

Usando a Ajuda

Processo de instalação

- armazém de clones::

bash

git clone https://github.com/n8n-io/self-hosted-ai-starter-kit.git

cd self-hosted-ai-starter-kit

- Executando o n8n com o Docker Compose::

- Para usuários de GPU da Nvidia:

docker compose --profile gpu-nvidia upObservação: se você não tiver usado uma GPU da Nvidia com o Docker antes, siga as instruções do Ollama Docker.

- Para usuários de Mac/Apple Silicon:

- Opção 1: É executado inteiramente na CPU:

docker compose --profile cpu up - Opção 2: Execute o Ollama em seu Mac e conecte-se à instância do n8n:

docker compose upEm seguida, altere as credenciais do Ollama, usando

http://host.docker.internal:11434/Como anfitrião.

- Opção 1: É executado inteiramente na CPU:

- Para outros usuários:

docker compose --profile cpu up

- Para usuários de GPU da Nvidia:

Diretrizes para uso

- Iniciar n8n::

- entrevistas

http://localhost:5678, entre na interface n8n. - Faça login com sua conta padrão ou crie uma nova conta.

- entrevistas

- Criação de fluxos de trabalho::

- Na interface da n8n, clique em "New Workflow" (Novo fluxo de trabalho).

- Arraste o nó desejado do menu esquerdo para o espaço de trabalho.

- Configure parâmetros e conexões para cada nó.

- Execução de fluxos de trabalho::

- Quando a configuração estiver concluída, clique no botão Run (Executar) para executar o fluxo de trabalho.

- Visualize os resultados e os registros da execução do fluxo de trabalho.

Início e uso rápidos

No centro do Self-Hosted AI Starter Kit está um arquivo Docker Compose com configurações de rede e armazenamento pré-configuradas, reduzindo a necessidade de instalação adicional. Depois de concluir as etapas de instalação, basta seguir as etapas abaixo para começar:

- Abra o site http://localhost:5678/设置n8n. Essa operação só precisa ser realizada uma vez.

- Abra o fluxo de trabalho incluído: http://localhost:5678/workflow/srOnR8PAY3u4RSwb.

- opçãoFluxo de trabalho de testeComece a executar o fluxo de trabalho.

- Se esta for a primeira vez que você executa esse fluxo de trabalho, talvez seja necessário aguardar até que o download do Llama 3.2 do Ollama seja concluído. Você pode verificar o progresso nos logs do console do docker.

Fique à vontade para fazer isso acessando http://localhost:5678/来打开n8n.

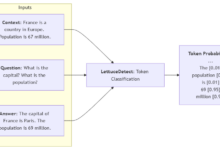

Com sua instância n8n, você terá acesso a mais de 400 integrações, bem como a um conjunto de nós de IA básicos e avançados, como os nós AI Agent, Text Classifier e Information Extractor. Certifique-se de que o tempo de execução local use o nó Ollama como seu modelo de linguagem e o Qdrant como um armazenamento de vetores.

"tomar nota deEste kit inicial foi projetado para ajudá-lo a começar a usar fluxos de trabalho de IA auto-hospedados. Embora não seja totalmente otimizado para ambientes de produção, ele combina componentes avançados que colaboram perfeitamente, tornando-o ideal para projetos de prova de conceito. Você pode personalizá-lo para atender às suas necessidades.

"

Instruções de upgrade

-

Para configurações de GPU da Nvidia:

docker compose --profile gpu-nvidia pull

docker compose create && docker compose --profile gpu-nvidia up

Para usuários de Mac / Apple Silicon

docker compose pull

docker compose create && docker compose up

-

Para configurações que não sejam de GPU:

docker compose --profile cpu pull

docker compose create && docker compose --profile cpu up